Heim >Technologie-Peripheriegeräte >KI >Princeton DeepMind bewies mithilfe der Mathematik: LLM ist kein zufälliger Papagei! „Je größer der Maßstab, desto stärker die Fähigkeit' hat eine theoretische Grundlage

Princeton DeepMind bewies mithilfe der Mathematik: LLM ist kein zufälliger Papagei! „Je größer der Maßstab, desto stärker die Fähigkeit' hat eine theoretische Grundlage

- 王林nach vorne

- 2024-02-19 09:30:25931Durchsuche

Die Protagonisten der heutigen Geschichte sind zwei Wissenschaftler, Sanjeev Arora und Anirudh Goyal.

Arora kommt von der Princeton University und Goyal kommt von Google DeepMind.

Sie kamen zusammen und wollten nur einer Frage nachgehen.

Das heißt, ist LLM ein zufälliger Papagei, der nur plappert, oder hat es wirklich etwas gelernt und sich in einen intelligenten Agenten mit neuen Fähigkeiten verwandelt?

Die KI-Pioniere Hinton und Ng Enda sprachen ebenfalls über dieses Thema, kamen damals jedoch zu keinem klaren Ergebnis.

Hinton wies darauf hin, dass es auch schwierig sein wird, einen Konsens über den potenziellen Schaden zu erzielen, den die KI mit sich bringen kann, wenn in dieser Frage kein Konsens erzielt werden kann.

Arora und Goyal glauben, dass es bei LLM nicht nur darum geht, mechanisches, sich wiederholendes Lernen zu imitieren. Sie wiesen darauf hin, dass der Ausgabeinhalt von LLM nicht einfach zufällig aus einer großen Menge an Trainingsdaten generiert wird und dieser Punkt einer weiteren Untersuchung bedarf.

Zwei Personen haben hierfür gemeinsam eine Arbeit geschrieben.

Papieradresse: https://arxiv.org/abs/2307.15936

Die Wahrheit ist, dass nach viel Training der Umfang von LLM immer größer wird und die damit verbundenen Fähigkeiten immer größer werden verbesserte Verbesserung und Entwicklung neuer Fähigkeiten.

Das können gewöhnliche Permutationen und Kombinationen nicht bewirken.

Das „Große“ unter den großen Modellen

Wie wir alle wissen, ist LLM ein riesiges künstliches neuronales Netzwerk, das „Neuronen“ einzeln verbindet.

bezieht sich tatsächlich auf die Parameter des Modells. Je mehr Parameter vorhanden sind, desto größer ist das LLM.

Lassen Sie uns zunächst den Mechanismus und die Zusammenhänge des LLM-Trainings verstehen.

Der Trainingsprozess umfasst diesen Link: Stellen Sie LLM einen einzelnen Satz zur Verfügung, verbergen Sie das letzte Wort und lassen Sie LLM dann anhand der Wahrscheinlichkeit vorhersagen, wer der freie Wortschatz sein soll.

Wenn LLM 1000 Wörter kennt, dann generiert es 1000 Wahrscheinlichkeiten. Wählen Sie abschließend diejenige mit der höchsten Wahrscheinlichkeit aus und füllen Sie sie aus.

Zu Beginn ist LLM möglicherweise nicht in der Lage, das richtige Wort auszuwählen, und der Algorithmus gibt einen Verlustwert an, der den „Abstand“ zwischen der von LLM gegebenen Anfangsantwort und der richtigen Antwort auf den Originalsatz darstellt einen hochdimensionalen mathematischen Raum (Abstand) und verwenden Sie diesen Wert dann zur Feinabstimmung der Parameter. Nach

kann LLM für denselben Satz eine korrektere Wahrscheinlichkeitsverteilung berechnen und der obige Verlustwert wird leicht reduziert.

Auf diese Weise wird dieser Prozess über Milliarden von Sätzen in den Trainingsdaten durchlaufen, bis der Gesamtverlustwert von LLM auf ein ziemlich gutes Niveau reduziert ist.

In ähnlicher Weise folgt auch das Testen von LLM diesem Prozess, und die Testergebnisse werden basierend auf dem Verlustwert erhalten (natürlich dürfen die zum Testen verwendeten Sätze nicht in den Trainingsdaten enthalten sein, sonst wäre es kein Betrug). .

Nach dem Training und Testen ist es sehr wahrscheinlich, dass LLM das korrekteste Wort generiert, wenn eine neue Textaufforderung auftritt. Wenn ein Wort herauskommt, wird es in die Eingabeaufforderung eingefügt und das nächste Wort generiert.

Langsam generiert erschien eine scheinbar schlüssige Antwort auf dem Papier.

In diesem Prozess gibt es jedoch keinen Hinweis darauf, dass das größere LLM bei Fragen, die eine Begründung erfordern, eine bessere Leistung erbringen wird.

Achten Sie darauf, mit dem Denken Schritt zu halten. Es gibt keine Hinweise, was bedeutet, dass es keine empirischen Beweise gibt, die auf dieses Ergebnis hinweisen könnten, aber wenn man die oberflächlichen Fakten betrachtet, ist diese Schlussfolgerung richtig.

Mit anderen Worten, ein LLM in größerem Maßstab ist in Bezug auf die Argumentationsfähigkeiten besser als ein Modell in kleinem Maßstab. Obwohl es keinen Unterschied in den Trainingsmethoden zwischen den beiden gibt, liegt der einzige Unterschied im Maßstab.

Arora ist verwirrt, woher kommt diese Fähigkeit?

Dies ist der Ausgangspunkt der Forschung von Arora und Goyal – der Versuch, einen theoretischen Rahmen zu schaffen, um zu analysieren, wie diese neuen Fähigkeiten entstehen.

Also wandten sie ihre Aufmerksamkeit dem Gebiet der Mathematik zu und nahmen etwas ins Visier, das man einen Zufallsgraphen nannte. Einfach ausgedrückt liegt dieser Begriff an der Schnittstelle von Graphentheorie und Wahrscheinlichkeitstheorie.

In einem Zufallsdiagramm ist es zufällig, ob es eine Kante gibt, die sie zwischen zwei beliebigen Knoten verbindet, genau wie beim Werfen einer Münze.

Wenn die Münze mit dem Kopf geworfen wird, gibt es eine Kante mit der Wahrscheinlichkeit p. Wenn sich der Wert von

p ändert, können sich plötzlich die Eigenschaften des gesamten Zufallsgraphen ändern. Wenn beispielsweise der p-Wert einen bestimmten Schwellenwert überschreitet, verschwinden einige isolierte Knoten (dh Punkte, die nicht mit anderen Knoten verbunden sind) plötzlich.

Zwei Wissenschaftler erkannten, dass diese Funktion von Zufallsgraphen eine intuitive Möglichkeit sein könnte, große Sprachmodelle zu simulieren.

Obwohl die Komplexität neuronaler Netze unaussprechlich und fast schwer zu analysieren ist, wird das Konzept der Zufallsgraphen schon seit langem von Mathematikern untersucht und verschiedene Werkzeuge für die Analyse entwickelt.

Vielleicht können Forscher neuronaler Netze durch die damit verbundenen Theorien zu Zufallsgraphen versuchen, einige Merkmale großer Sprachmodelle zu verstehen und zu analysieren.

Hier konzentrierten sich die beiden Forscher auf den bipartiten Graphen, der zwei Arten von Knoten enthält.

In ihrem Modell repräsentiert ein Knotentyp ein Textfragment. Beachten Sie, dass das Fragment hier mindestens einen Absatz lang sein muss und möglicherweise sogar mehrere Seiten lang ist, anstatt ein einzelnes Wort.

Solche Knoten bilden eine gerade Linie.

Der zweite Knotentyp stellt die Fähigkeiten dar, die zum Verständnis des oben angegebenen Textes erforderlich sind. Zum Beispiel das Verstehen logischer Zusammenhänge oder die Fähigkeit zu rechnen, oder genauer gesagt, die Fähigkeit, Sarkasmus zu verstehen.

Der Zweck dieser Beispiele besteht darin, deutlich zu machen, dass dieser zweite Knotentyp eine Vielzahl von Fähigkeiten darstellt und alle oben genannten Fähigkeiten berücksichtigt werden.

Arora sagte, wenn LLM erkennen kann, dass ein bestimmter Text Ironie enthält, kann sich das Gesamtverständnis erheblich ändern.

Wie oben erwähnt, bedeuten die durch den zweiten Knotentyp dargestellten Fähigkeiten jedoch nicht, dass der Zweck von LLM während des Trainingsprozesses darin besteht, diese Fähigkeiten zu erreichen. Mit anderen Worten: LLM trainiert während des Trainings nur die Fähigkeit, das nächstmögliche Wort vorherzusagen.

Mit anderen Worten: Die durch den zweiten Knotentyp repräsentierten Fähigkeiten wurden von Arora und Goyal aus der Perspektive der Ergebnisse entworfen, um die von LLM angezeigten Fähigkeiten besser zu verstehen.

Nachdem die Einstellung abgeschlossen ist, beginnen die beiden Knotentypen, sich miteinander zu verbinden. Die Verbindung stellt dar, welche Fähigkeiten LLM benötigt, um einen bestimmten Textabschnitt zu verstehen. Es kann eins-zu-eins, eins-zu-viele oder viele-zu-eins sein.

Nehmen Sie auch Leseironie als Beispiel. Dieser Fertigkeitspunkt stellt eine Verbindung zu allen Texten her, die ironische Elemente enthalten.

Verbindung ist nicht so einfach. Sie wissen, dass große Unternehmen wie OpenAI und DeepMind keine Trainings- oder Testdaten offenlegen. Darauf können sich die beiden Forscher also nicht verlassen.

Darüber hinaus wollen sie den Zusammenhang zwischen Größe, Verhalten und Fähigkeit verstehen.

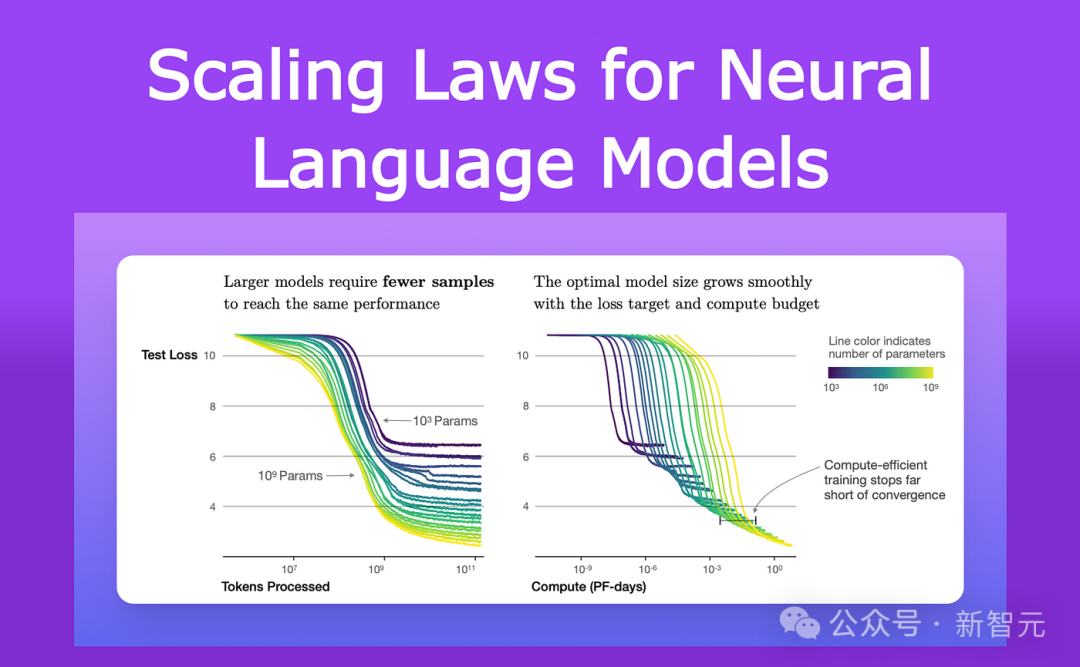

Seit 2021 beobachten Forscher, die die Leistung von LLMs und anderen neuronalen Netzen untersuchen, ein gemeinsames Merkmal.

Sie stellten fest, dass mit zunehmender Größe des Modells und der Menge an Trainingsdaten der Verlust an Testdaten (der Unterschied zwischen der Vorhersage und der richtigen Antwort für neuen Text nach dem Training) auf ganz bestimmte Weise reduziert wurde.

Diese Beobachtungen wurden in eine Gleichung namens „Neural Scaling Law“ kodiert.

Daher erklärten Arora und Goyal, dass ihre Theorie nicht vom Fall eines einzelnen LLM oder eines bestimmten Satzes von Trainings- und Testdaten abhängt, sondern vielmehr von einer Art universellem Gesetz: dem vom vorhergesagten Verlust Skalierungsgesetz.

Der Schlüssel zu ihrer weiteren Forschung ist die Beziehung zwischen dem neuronalen Skalierungsgesetz und dem oben eingeführten bipartiten Graphen.

Ausleihe eines bipartiten Graphen

Zunächst geht der Forscher davon aus, dass es einen bipartiten Graphen gibt, der dem Verhalten von LLM in den Testdaten entspricht.

Um die Verluständerungen von LLM in den Testdaten auszunutzen, stellten sie sich eine Möglichkeit vor, wie folgt zu beschreiben, wie LLM Fähigkeiten erwirbt.

Nehmen wir als Beispiel die Fähigkeit, Ironie verstehen zu können –

Dieses Konzept wird durch einen Fähigkeitsknoten dargestellt, also haben die Forscher untersucht, mit welchen Textknoten dieser Fähigkeitsknoten verbunden war.

Wenn fast alle dieser verbundenen Textknoten erfolgreich sind – was bedeutet, dass LLMs Vorhersage des durch diese spezifische Fähigkeit repräsentierten Textes sehr genau ist – dann ist LLM in dieser spezifischen Fähigkeit kompetent.

Aber wenn mehr als ein bestimmter Anteil der Fertigkeitsknoten mit fehlgeschlagenen Textknoten verbunden sind, schlägt LLM bei dieser Fertigkeit fehl.

Die Verbindungen zwischen diesen bipartiten Graphen und LLMs ermöglichen es Arora und Goyal, die Werkzeuge der Zufallsgraphentheorie zu nutzen, um das Verhalten von LLMs zu analysieren.

Das Studium dieser Diagramme zeigt bestimmte Beziehungen zwischen Knoten. Diese Beziehungen werden dann in eine logische und überprüfbare Methode umgewandelt, um zu erklären, wie große Sprachmodelle unerwartete Fähigkeiten erwerben.

Hier erklären Arora und Goyal zunächst ein Schlüsselverhalten – warum größere LLMs individuelle Fähigkeiten besser beherrschen als relativ kleinere Modelle.

Sie beginnen mit geringeren Testverlusten, die durch die neuronalen Skalierungsgesetze vorhergesagt werden.

Wenn es weniger fehlgeschlagene Testknoten gibt, bedeutet dies, dass es weniger Verbindungen zwischen fehlgeschlagenen Testknoten und Fertigkeitsknoten gibt. Daher deuten mehr Kompetenzknoten, die mit erfolgreichen Testknoten verbunden sind, darauf hin, dass das Modell über erhöhte Kompetenzfähigkeiten verfügt.

Als nächstes fanden die beiden Forscher einen Weg, die durch größere Modelle gewonnene Leistung zu erklären: Mit zunehmender Größe des LLM und abnehmendem Testverlust werden zufällige Kombinationen von Fertigkeitsknoten mit einzelnen Textknoten verbunden.

Dies zeigt, dass LLM auch besser darin wurde, mehrere Fertigkeiten gleichzeitig zu nutzen und begann, Texte unter Verwendung mehrerer Fertigkeiten zu generieren, obwohl diese genauen Fertigkeitskombinationen in keinem Text der Trainingsdaten auftauchten.

Zum Beispiel kann ein LLM bereits Text mit einer Fertigkeit generieren. Wenn wir dann die Anzahl der Parameter oder Trainingsdaten des LLM um eine Größenordnung erweitern, ist es bei der Generierung von Text, der beide Fertigkeiten erfordert, gleich gut.

Analog und in einer anderen Größenordnung kann LLM nun Aufgaben ausführen, die vier Fähigkeiten gleichzeitig erfordern! Darüber hinaus ist auch das Kompetenzniveau in jeder Fähigkeit gleich.

Daher verfügen größere LLMs über mehr Möglichkeiten, Fähigkeiten miteinander zu kombinieren, was zu einer deutlichen Verbesserung der Leistung des LLM selbst führt.

Wenn das LLM größer wird, wird die Wahrscheinlichkeit, dass es in den Trainingsdaten auf alle diese Fähigkeitskombinationen stößt, immer kleiner, bis sie bei 0 liegt.

Nach den Regeln der Zufallsgraphentheorie entsteht jede Kombination aus einer zufälligen Stichprobe möglicher Fähigkeiten. Wenn es also etwa tausend grundlegende Einzelfähigkeitsknoten in der Grafik gibt und wir beispielsweise vier Fähigkeiten kombinieren möchten, sind es etwa 1000 hoch vier – das sind eine ganze Billion mögliche Kombinationen.

Mit anderen Worten: Wenn ein LLM diese Aufgaben wirklich durch die Kombination von vier der 1.000 Fähigkeiten erfüllen kann, bedeutet dies, dass das Modell über Generalisierungsfähigkeiten verfügen muss. Darüber hinaus ist dieses Modell wahrscheinlich kein zufälliger Papagei mehr.

Aber Arora und Goyal wollten über die Theorie hinausgehen und ihre Idee testen, dass LLMs mit zunehmender Größe und Trainingsdaten besser darin werden, mehr Fähigkeiten zu kombinieren, und daher bei der Generalisierung besser abschneiden.

Zusammen mit dem Rest des Teams entwickelten sie eine Methode namens Skill Blending, um die Fähigkeit von LLM zu bewerten, Text mithilfe mehrerer Fähigkeiten zu generieren.

Um LLM auf die Probe zu stellen, bat das Forschungsteam darum, drei Sätze zu zufällig ausgewählten Themen zu generieren. Die Generierung dieser Sätze demonstrierte zunächst die zufällig ausgewählten Fähigkeitspunkte von LLM.

Zum Beispiel baten sie GPT-4, einen Artikel über Schwertkampf zu schreiben, und dann baten sie das Modell, Fähigkeiten aus vier Bereichen zu demonstrieren: Selbstvoreingenommenheit, Metapher, Statistik und Beherrschung physikalischer Versuche.

Die Ausgabe von GPT-4 sieht folgendermaßen aus:

In diesem Tanz mit Stahl ist mein Sieg (mit Metapher) so sicher wie der freie Fall von Objekten (mithilfe der Physik).

Und als berühmter Duellant bin ich von Natur aus flexibel, wie mich die meisten Leute kennen (anhand von Statistiken). scheitern? Es konnte nur daran liegen, dass das Schlachtfeld auf den Feind ausgerichtet war, nicht an meinen Unzulänglichkeiten (Selbstvoreingenommenheit).

Das tatsächliche Ergebnis ist, wie die Mathematik vorhersagt, dass GPT-4 GPT-3.5 bei weitem übertrifft.

Arora macht eine mutige Vermutung: Wird es in einem Jahr ein Modell geben, das GPT-4 bei weitem übertrifft?

Das obige ist der detaillierte Inhalt vonPrinceton DeepMind bewies mithilfe der Mathematik: LLM ist kein zufälliger Papagei! „Je größer der Maßstab, desto stärker die Fähigkeit' hat eine theoretische Grundlage. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!