Heim >Technologie-Peripheriegeräte >KI >Tongyi Qianwen ist wieder Open Source, Qwen1.5 bietet sechs Volumenmodelle und seine Leistung übertrifft GPT3.5

Tongyi Qianwen ist wieder Open Source, Qwen1.5 bietet sechs Volumenmodelle und seine Leistung übertrifft GPT3.5

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2024-02-07 22:15:022100Durchsuche

Vor dem Frühlingsfest ist Version 1.5 von Tongyi Qianwen Large Model (Qwen) online. Heute Morgen löste die Nachricht über die neue Version Besorgnis in der KI-Community aus.

Die neue Version des großen Modells umfasst sechs Modellgrößen: 0,5B, 1,8B, 4B, 7B, 14B und 72B. Unter ihnen übertrifft die Leistung der stärksten Version GPT 3.5 und Mistral-Medium. Diese Version umfasst das Basismodell und das Chat-Modell und bietet Unterstützung für mehrere Sprachen.

Das Team von Alibaba Tongyi Qianwen gab an, dass die entsprechende Technologie auch auf der offiziellen Website von Tongyi Qianwen und der Tongyi Qianwen App eingeführt wurde.

Darüber hinaus bietet die heutige Version von Qwen 1.5 folgende Highlights:

- unterstützt 32K Kontextlänge;

- öffnet den Checkpoint des Base + Chat-Modells;

- kann mit verwendet werden Transformers Läuft lokal;

- GPTQ Int-4/Int8, AWQ und GGUF-Gewichte werden gleichzeitig veröffentlicht.

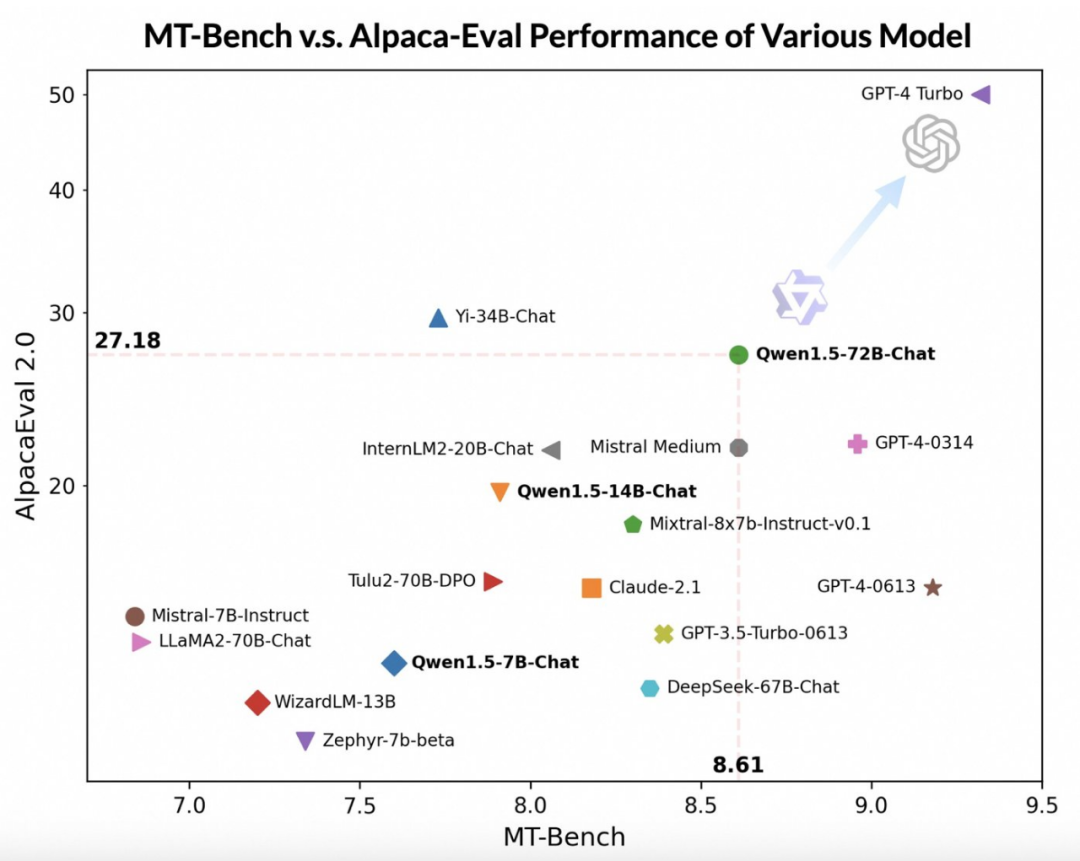

Unter Verwendung fortschrittlicherer Großmodelle als Juroren führte das Team von Tongyi Qianwen eine vorläufige Bewertung von Qwen1.5 anhand zweier weit verbreiteter Benchmarks durch, MT-Bench und Alpaca-Eval. Die Bewertungsergebnisse lauten wie folgt:

Obwohl das Qwen1.5-72B-Chat-Modell hinter GPT-4-Turbo zurückbleibt, zeigte es in Tests auf MT-Bench und Alpaca-Eval v2 eine beeindruckende Leistung. Fangleistung. Tatsächlich übertrifft Qwen1.5-72B-Chat Claude-2.1, GPT-3.5-Turbo-0613, Mixtral-8x7b-instruct und TULU 2 DPO 70B in der Leistung und ist mit dem Mistral Medium-Modell vergleichbar, das in letzter Zeit viel Aufmerksamkeit erregt hat . Vergleichbar. Dies zeigt, dass das Qwen1.5-72B-Chat-Modell eine beträchtliche Stärke bei der Verarbeitung natürlicher Sprache aufweist.

Das Team von Tongyi Qianwen wies darauf hin, dass die Ergebnisse großer Modelle zwar möglicherweise mit der Länge der Antworten zusammenhängen, menschliche Beobachtungen jedoch zeigen, dass Qwen1.5 die Ergebnisse nicht durch übermäßig lange Antworten beeinflusst. Laut AlpacaEval 2.0-Daten beträgt die durchschnittliche Länge von Qwen1.5-Chat 1618, was der Länge von GPT-4 und kürzer als GPT-4-Turbo entspricht.

Die Entwickler von Tongyi Qianwen sagten, dass sie in den letzten Monaten hart daran gearbeitet haben, ein hervorragendes Modell zu entwickeln und das Entwicklererlebnis kontinuierlich zu verbessern.

Im Vergleich zu früheren Versionen konzentriert sich dieses Update auf die Verbesserung der Ausrichtung des Chat-Modells auf menschliche Vorlieben und verbessert die mehrsprachigen Verarbeitungsfähigkeiten des Modells erheblich. In Bezug auf die Sequenzlänge haben alle Skalenmodelle eine Kontextlängenbereichsunterstützung von 32768 Token implementiert. Gleichzeitig wurde auch die Qualität des vorab trainierten Basismodells entscheidend optimiert, was den Menschen während des Feinabstimmungsprozesses ein besseres Erlebnis bieten soll.

Grundlegende Fähigkeiten

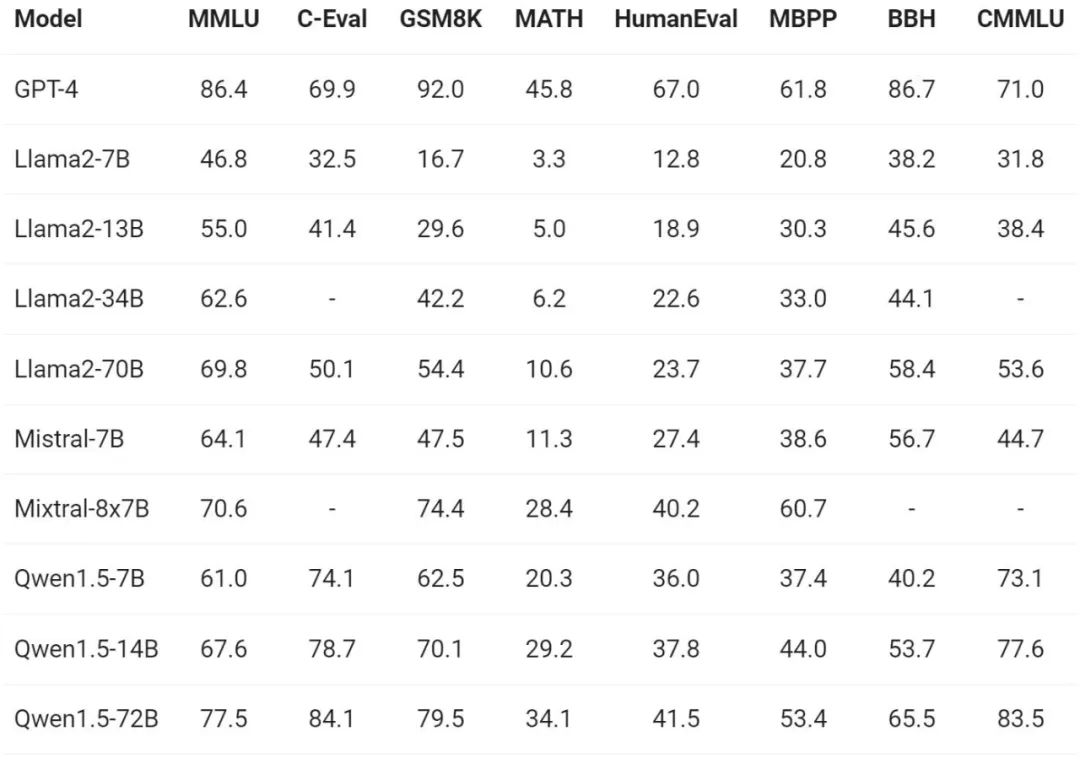

Im Hinblick auf die Bewertung der Grundfähigkeiten des Modells führte das Team von Tongyi Qianwen Qwen1.5 an Benchmark-Datensätzen wie MMLU (5-Shot), C-Eval, Humaneval, GS8K und BBH durch . Auswerten.

Unter verschiedenen Modellgrößen hat Qwen1.5 in Bewertungsbenchmarks eine starke Leistung gezeigt. Die 72B-Version hat Llama2-70B in allen Benchmark-Tests übertroffen und ihre Leistung im Sprachverständnis und Argumentationsvermögen unter Beweis gestellt.

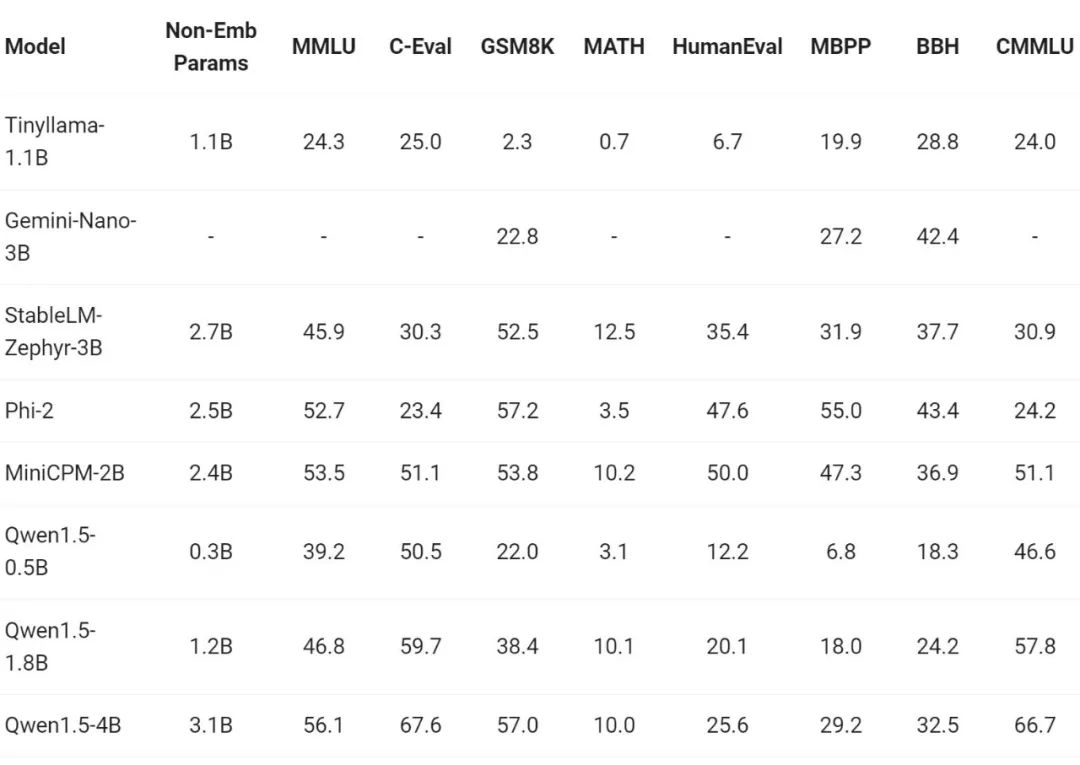

In letzter Zeit war der Bau kleiner Modelle einer der Hotspots in der Branche. Das Team von Tongyi Qianwen verglich das Qwen1.5-Modell mit Modellparametern von weniger als 7 Milliarden mit wichtigen kleinen Modellen in der Community:

Qwen1.5 ist mit branchenführenden kleinen Modellen im Parametergrößenbereich unter 7 Milliarden äußerst wettbewerbsfähig.

Mehrsprachigkeitsfähigkeiten

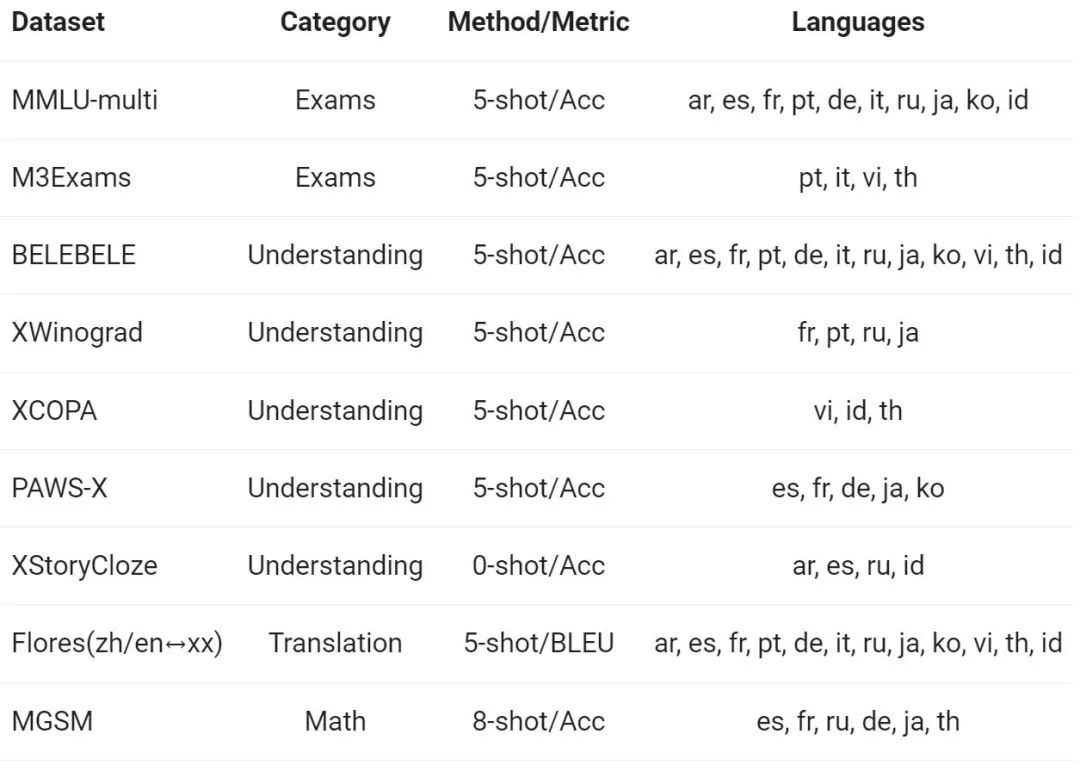

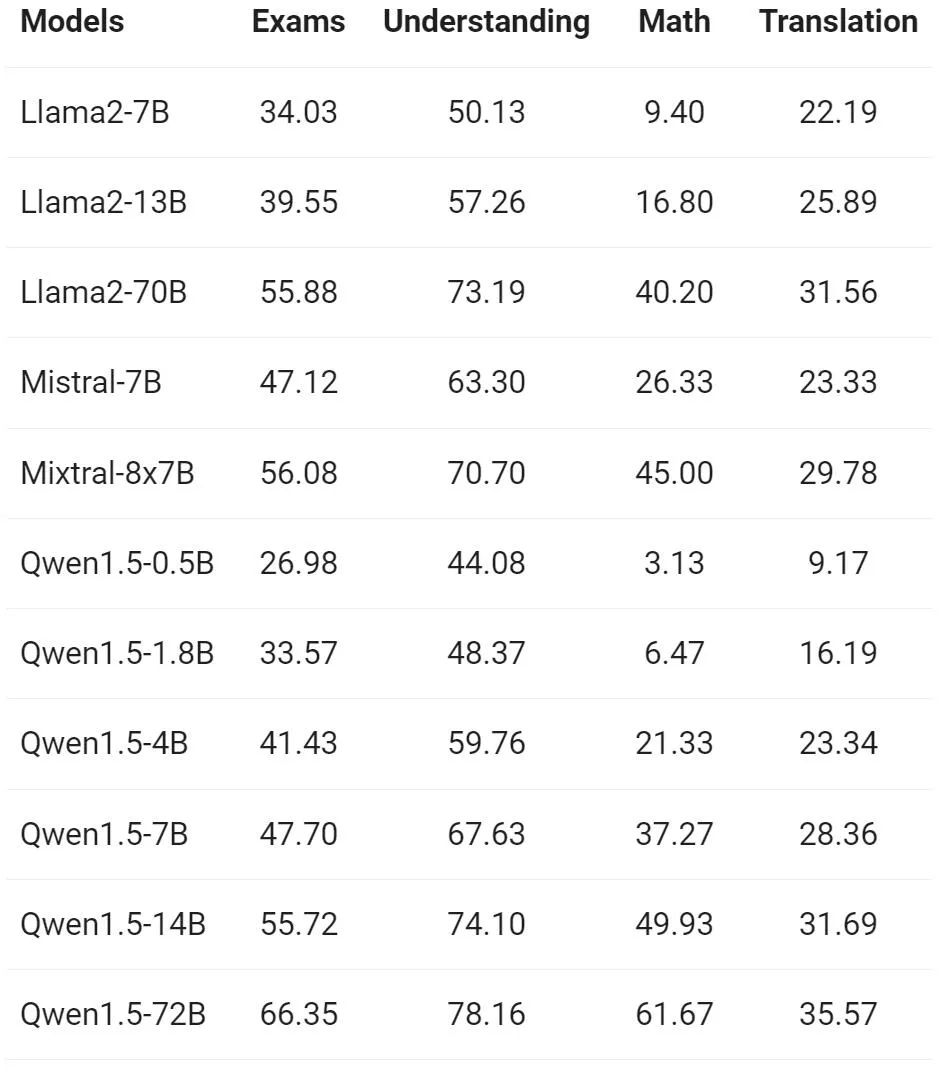

Das Team von Tongyi Qianwen bewertete die Mehrsprachenfähigkeiten des Basismodells anhand von 12 verschiedenen Sprachen aus Europa, Ostasien und Südostasien. Aus dem öffentlichen Datensatz der Open-Source-Community erstellten Alibaba-Forscher den in der folgenden Tabelle gezeigten Bewertungssatz, der vier verschiedene Dimensionen abdeckt: Prüfung, Verständnis, Übersetzung und Mathematik. Die folgende Tabelle enthält Details zu jedem Testsatz, einschließlich seiner Bewertungskonfiguration, Bewertungsmetriken und den spezifischen beteiligten Sprachen.

Die detaillierten Ergebnisse sind wie folgt:

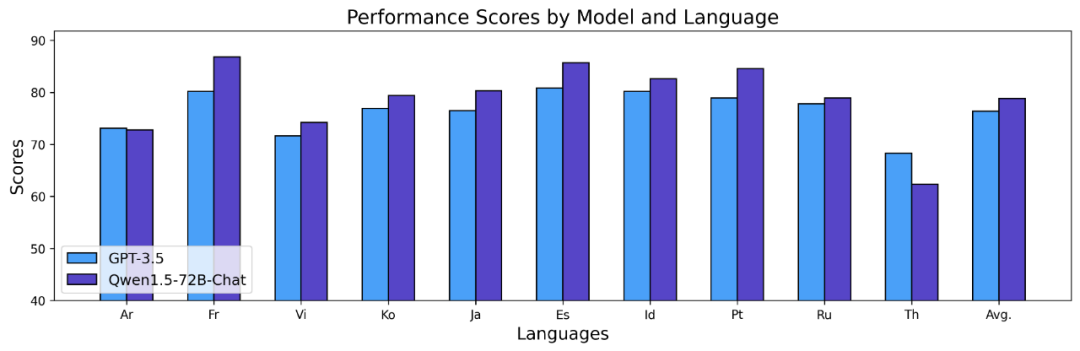

Die obigen Ergebnisse zeigen, dass das Qwen1.5-Basismodell bei mehrsprachigen Funktionen in 12 verschiedenen Sprachen gut abschneidet und gute Ergebnisse bei der Bewertung verschiedener Dimensionen wie Fachwissen, Sprachverständnis, Übersetzung und Mathematik zeigt. Darüber hinaus sind im Hinblick auf die Mehrsprachigkeitsfähigkeiten des Chat-Modells folgende Ergebnisse zu beobachten:

Lange Sequenzen

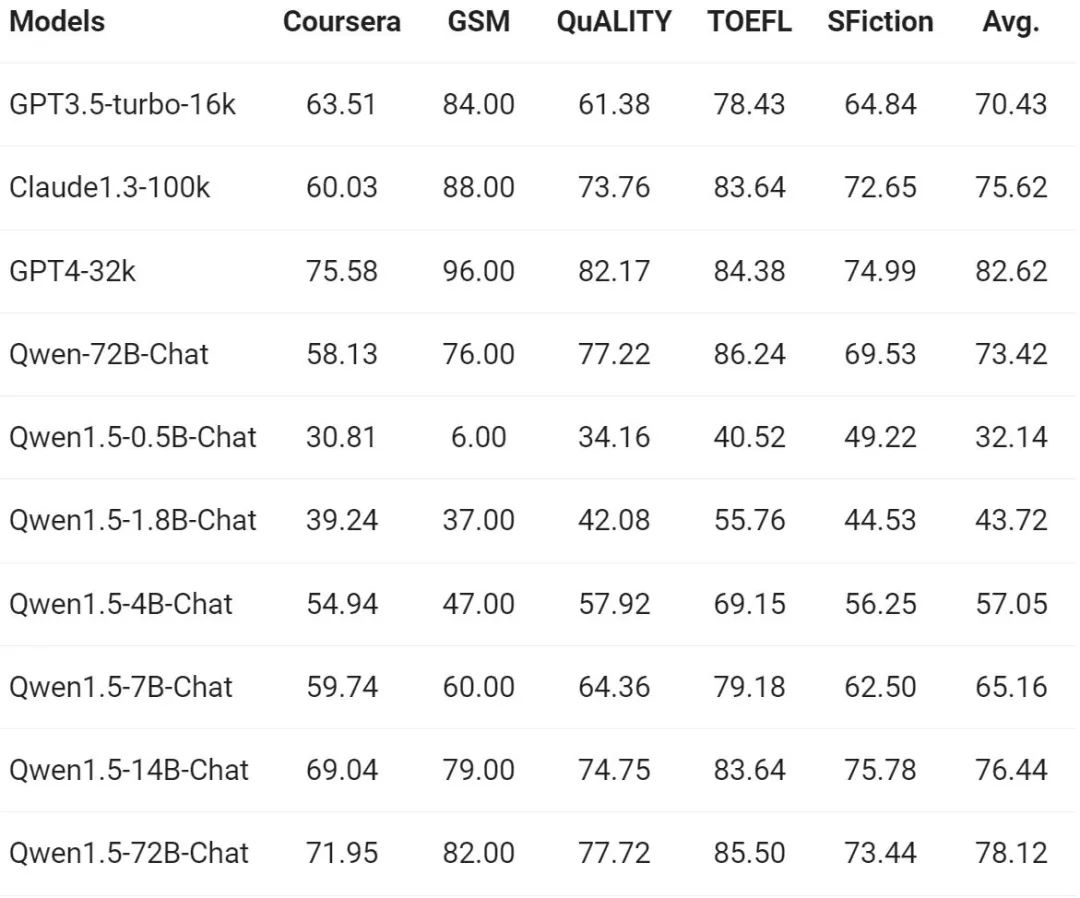

Da die Nachfrage nach dem Verständnis langer Sequenzen weiter zunimmt, hat sich Alibaba um einiges verbessert Tausende in der neuen Version Wenn man nach den entsprechenden Funktionen des Modells fragt, unterstützt die gesamte Serie der Qwen1.5-Modelle den Kontext von 32K-Tokens. Das Team von Tongyi Qianwen bewertete die Leistung des Qwen1.5-Modells anhand des L-Eval-Benchmarks, der die Fähigkeit eines Modells misst, Antworten auf der Grundlage eines langen Kontexts zu generieren. Die Ergebnisse sind wie folgt:

Den Ergebnissen zufolge kann sogar ein kleines Modell wie Qwen1.5-7B-Chat eine vergleichbare Leistung wie GPT-3.5 zeigen, während das größte Modell Qwen1.5 -72B- Chat liegt nur knapp hinter GPT4-32k.

Es ist erwähnenswert, dass die obigen Ergebnisse die Wirkung von Qwen 1.5 nur bei einer Länge von 32 KB-Tokens zeigen, was nicht bedeutet, dass das Modell nur eine maximale Länge von 32 KB unterstützen kann. Entwickler können versuchen, max_position_embedding in config.json auf einen größeren Wert zu ändern, um zu beobachten, ob das Modell in längeren Kontextverständnisszenarien zufriedenstellende Ergebnisse erzielen kann.

Anbindung an externe Systeme

Heutzutage liegt einer der Reize allgemeiner Sprachmodelle in ihrer potenziellen Fähigkeit, mit externen Systemen zu kommunizieren. Als eine sich schnell entwickelnde Aufgabe in der Community bewältigt RAG effektiv einige der typischen Herausforderungen, mit denen große Sprachmodelle konfrontiert sind, wie etwa Halluzinationen und die Unfähigkeit, Echtzeitaktualisierungen oder private Daten zu erhalten. Darüber hinaus demonstriert das Sprachmodell seine Leistungsfähigkeit bei der Verwendung von APIs und beim Schreiben von Code anhand von Anweisungen und Beispielen. Große Modelle können Code-Interpreter verwenden oder als KI-Agenten fungieren, um einen größeren Mehrwert zu erzielen.

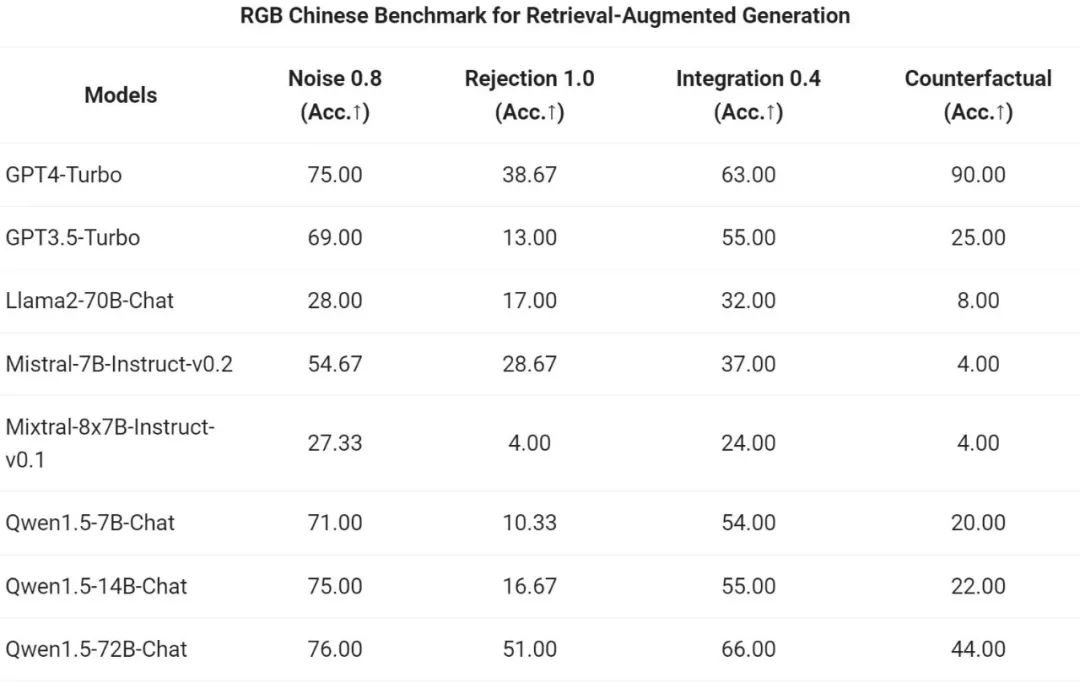

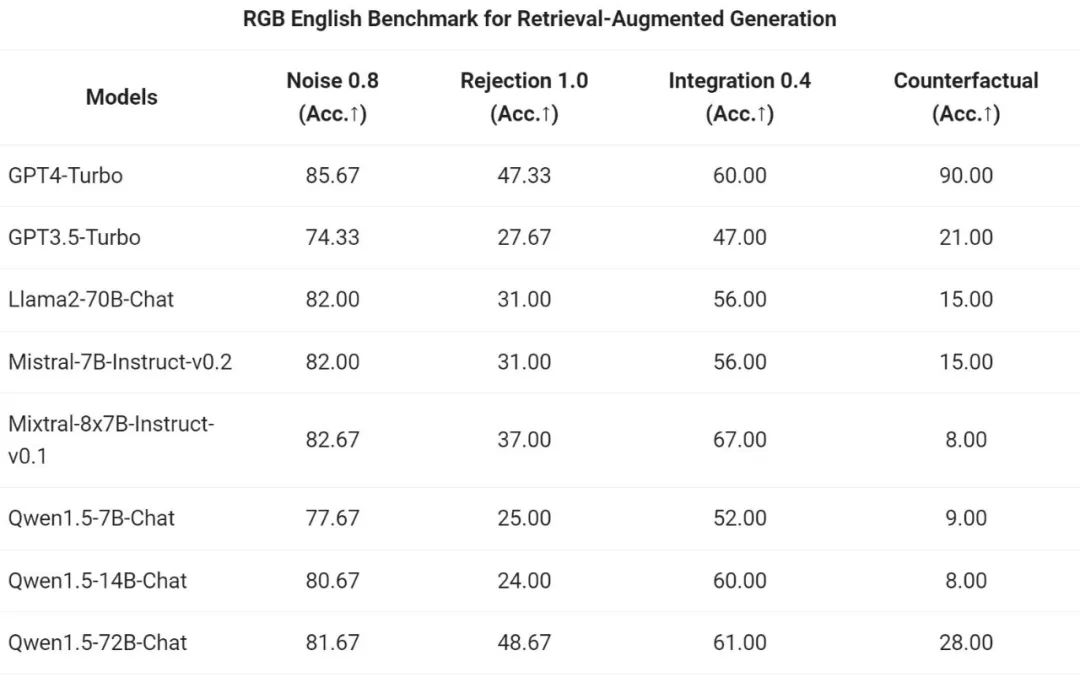

Das Tongyi Qianwen-Team bewertete den End-to-End-Effekt des Chat-Modells der Qwen1.5-Serie auf die RAG-Aufgabe. Die Bewertung basiert auf dem RGB-Testsatz, einem Satz, der für die RAG-Bewertung auf Chinesisch und Englisch verwendet wird: Evaluieren Sie den Benchmark-Test der Lauffähigkeit. Alle Qwen1.5-Modelle sind nicht speziell für Benchmarks optimiert:

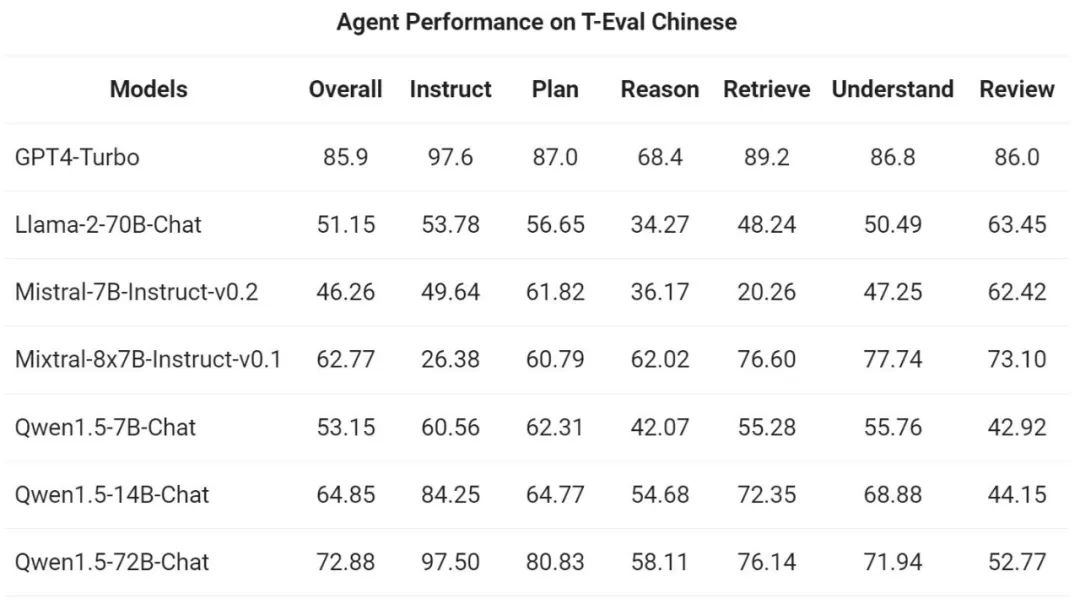

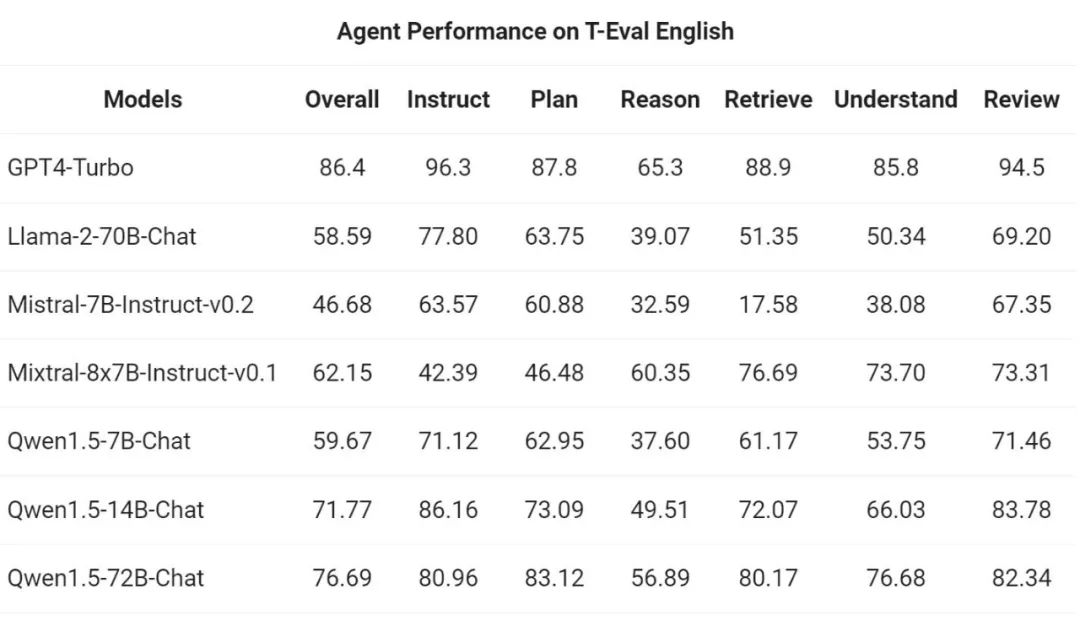

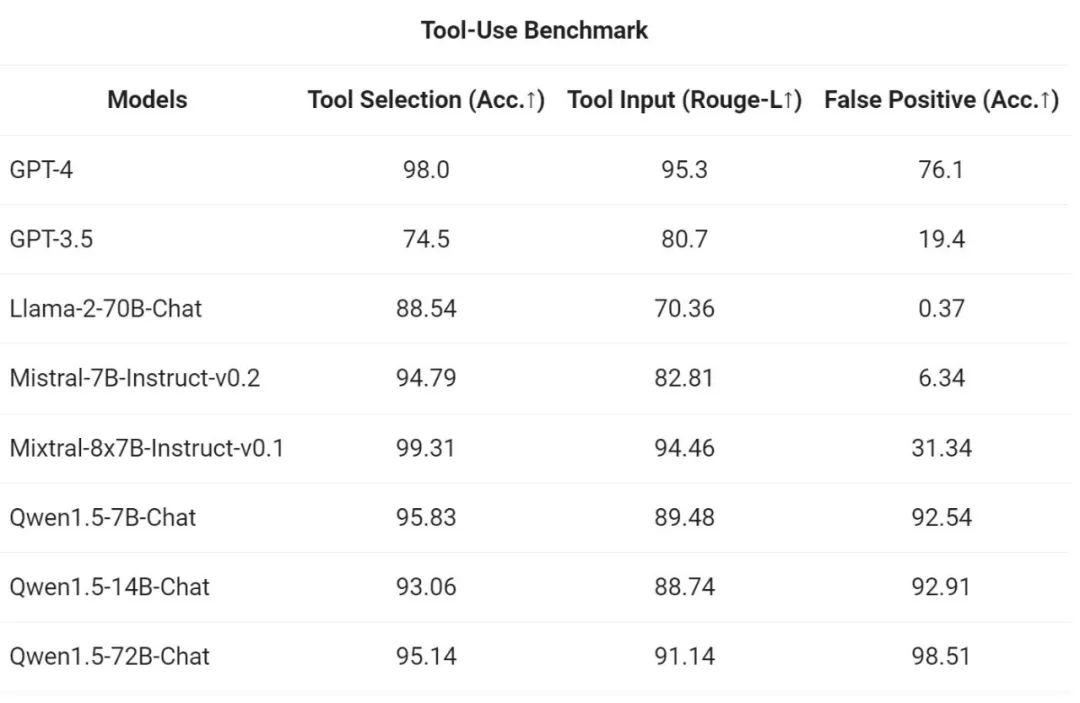

Um die Tool-Aufruffähigkeit zu testen, verwendete Alibaba seinen eigenen Open-Source-Evaluierungsbenchmark, um die Fähigkeit des Modells zu testen, Tools korrekt auszuwählen und aufzurufen . Die Ergebnisse sind wie folgt:

Da sich der Python-Code-Interpreter schließlich zu einem immer leistungsfähigeren Werkzeug für fortgeschrittenes LLM entwickelt hat, bewertete das Team von Tongyi Qianwen auch die Fähigkeit des neuen Modells, dieses Werkzeug auf der Grundlage früherer Open Source zu nutzen Bewertungsbenchmarks:

Da sich der Python-Code-Interpreter schließlich zu einem immer leistungsfähigeren Werkzeug für fortgeschrittenes LLM entwickelt hat, bewertete das Team von Tongyi Qianwen auch die Fähigkeit des neuen Modells, dieses Werkzeug auf der Grundlage früherer Open Source zu nutzen Bewertungsbenchmarks:

Die Ergebnisse zeigen, dass das größere Qwen1.5-Chat-Modell im Allgemeinen das kleinere Modell übertrifft, wobei Qwen1.5-72B-Chat sich der Tool-Nutzungsleistung von GPT-4 annähert. Bei Code-Interpreter-Aufgaben wie dem Lösen mathematischer Probleme und der Visualisierung liegt jedoch selbst das größte Qwen1.5-72B-Chat-Modell in Bezug auf die Codierungsfähigkeit deutlich hinter GPT-4 zurück. Ali gab an, dass dadurch die Codierungsfunktionen aller Qwen-Modelle während des Vortrainings- und Ausrichtungsprozesses in zukünftigen Versionen verbessert werden.

Die Ergebnisse zeigen, dass das größere Qwen1.5-Chat-Modell im Allgemeinen das kleinere Modell übertrifft, wobei Qwen1.5-72B-Chat sich der Tool-Nutzungsleistung von GPT-4 annähert. Bei Code-Interpreter-Aufgaben wie dem Lösen mathematischer Probleme und der Visualisierung liegt jedoch selbst das größte Qwen1.5-72B-Chat-Modell in Bezug auf die Codierungsfähigkeit deutlich hinter GPT-4 zurück. Ali gab an, dass dadurch die Codierungsfunktionen aller Qwen-Modelle während des Vortrainings- und Ausrichtungsprozesses in zukünftigen Versionen verbessert werden.

Qwen1.5 ist in die Codebasis der HuggingFace-Transformatoren integriert. Ab Version 4.37.0 können Entwickler den nativen Code der Transformers-Bibliothek direkt verwenden, ohne benutzerdefinierten Code laden zu müssen (angeben der Option „trust_remote_code“), um Qwen1.5 zu verwenden.

Im Open-Source-Ökosystem hat Alibaba mit vLLM, SGLang (zur Bereitstellung), AutoAWQ, AutoGPTQ (zur Quantifizierung), Axolotl, LLaMA-Factory (zur Feinabstimmung) und llama.cpp (zur lokalen LLM-Inferenz) zusammengearbeitet. usw. Framework-Kooperation, alle diese Frameworks unterstützen jetzt Qwen1.5. Die Qwen1.5-Serie ist derzeit auch auf Plattformen wie Ollama und LMStudio verfügbar.

Das obige ist der detaillierte Inhalt vonTongyi Qianwen ist wieder Open Source, Qwen1.5 bietet sechs Volumenmodelle und seine Leistung übertrifft GPT3.5. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- php „7-Tage-Devil-Trainingslager' – kostenlose Live-Kursanmeldung! ! ! ! ! !

- Können AI-Dateien mit PS geöffnet werden?

- Die grundlegenden Schritte der Verwendung von KI zum Umreißen von Bildern

- Google hat es auch gemacht? Bard wurde ausgesetzt, um ChatGPT-Daten für das Training zu verwenden. Das große Modell gerät Schritt für Schritt ins Hintertreffen.

- Das Trainieren einer chinesischen Version von ChatGPT ist nicht so schwierig: Sie können es mit der Open-Source-Version Alpaca-LoRA+RTX 4090 ohne A100 tun