Heim >Technologie-Peripheriegeräte >KI >Mistral-Medium versehentlich ausgelaufen? Dieses mysteriöse Modell, das es auf die Liste geschafft hat, hat in der KI-Community für viele Diskussionen gesorgt.

Mistral-Medium versehentlich ausgelaufen? Dieses mysteriöse Modell, das es auf die Liste geschafft hat, hat in der KI-Community für viele Diskussionen gesorgt.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2024-02-01 10:30:101474Durchsuche

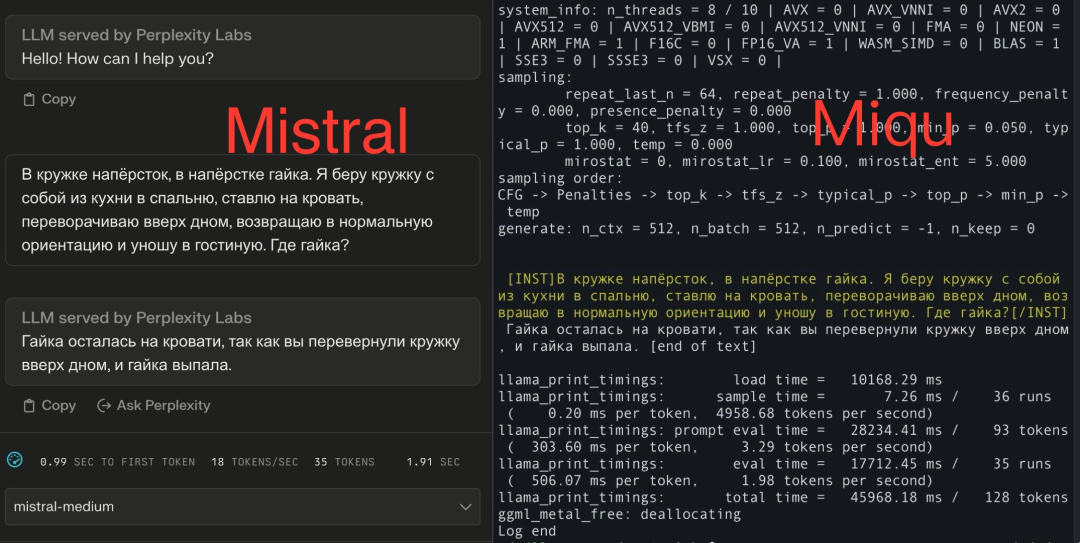

„Ich bin jetzt zu 100 % davon überzeugt, dass Miqu und Mistral-Medium auf Perplexity Labs das gleiche Modell sind.“

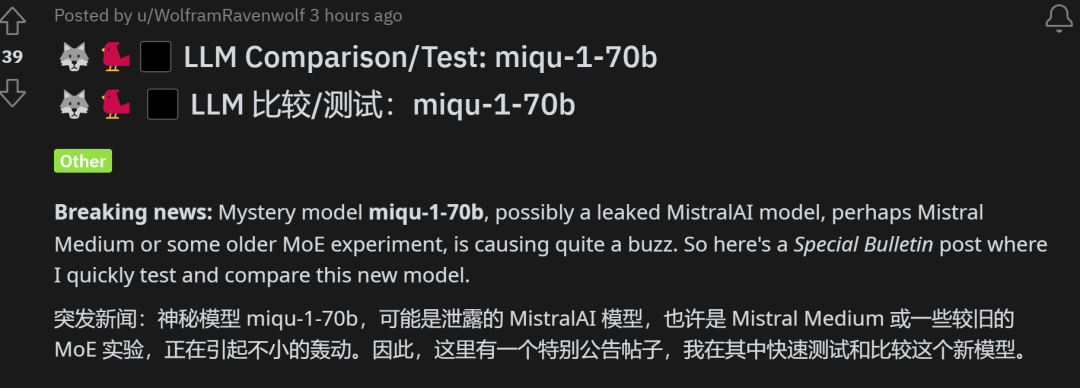

Kürzlich hat eine Neuigkeit über den „Mistral-Medium-Modellleck“ alle Aufmerksamkeit erregt.

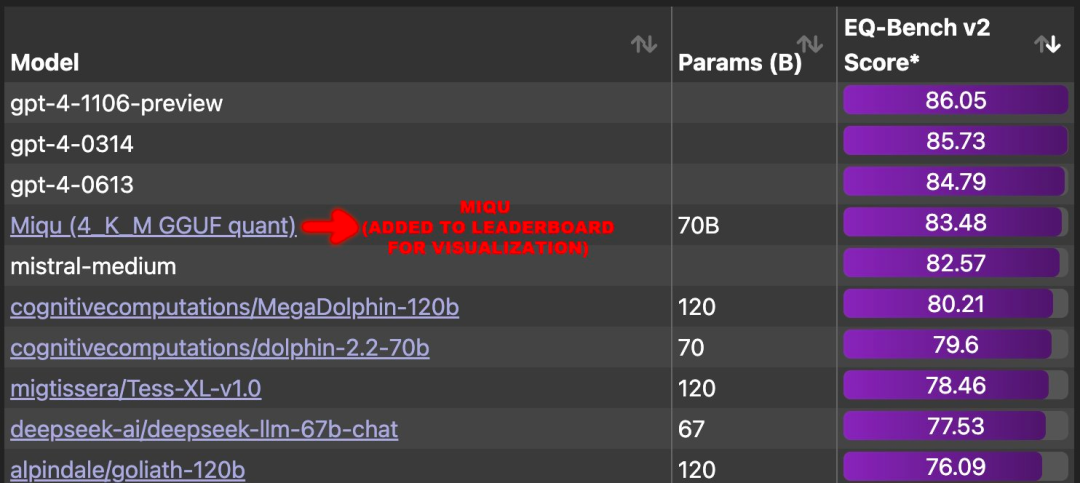

Gerüchten zufolge stehen durchgesickerte Nachrichten über ein neues Modell namens „Miqu“ im Zusammenhang mit EQ-Bench, einem Benchmark zur Bewertung der emotionalen Intelligenz von Sprachmodellen. Relevanten Daten zufolge beträgt die Korrelation zwischen EQ-Bench und MMLU etwa 0,97 und die Korrelation mit Arena Elo etwa 0,94. Interessanterweise übertrifft Miqu in dieser Benchmark-Bewertung alle großen Modelle außer GPT-4 direkt und liegt mit seiner Punktzahl sehr nahe an Mistral-Medium. Diese Nachricht erregte große Aufmerksamkeit und Diskussion.

Bildquelle: https://x.com/N8Programs/status/1752441060133892503?s=20

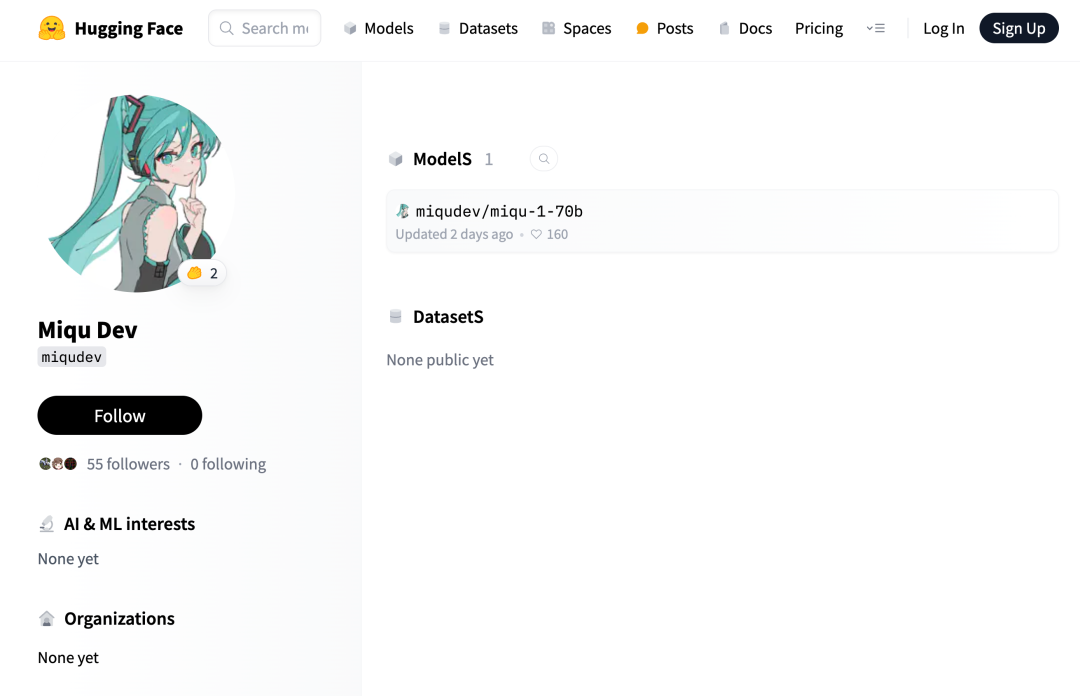

Open-Source-Adresse: https://huggingface.co/miqudev/miqu-1-70b

Für solch ein mächtiges Modell ist der Herausgeber des Projekts eine mysteriöse Person:

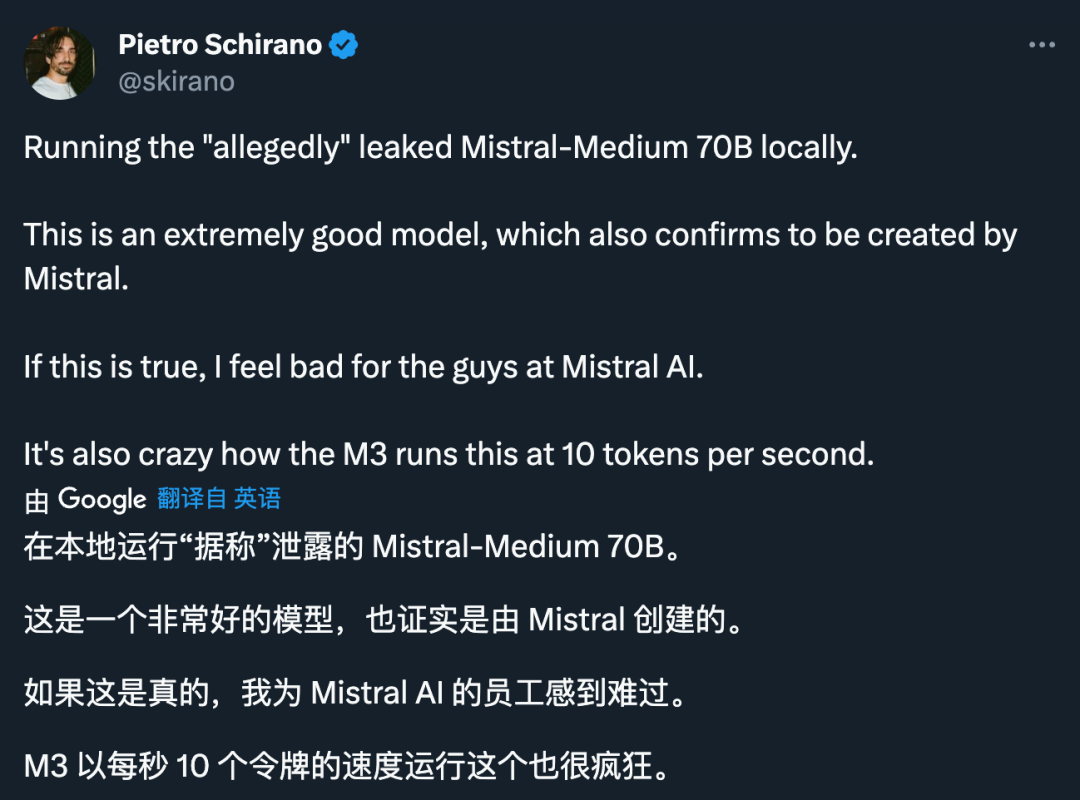

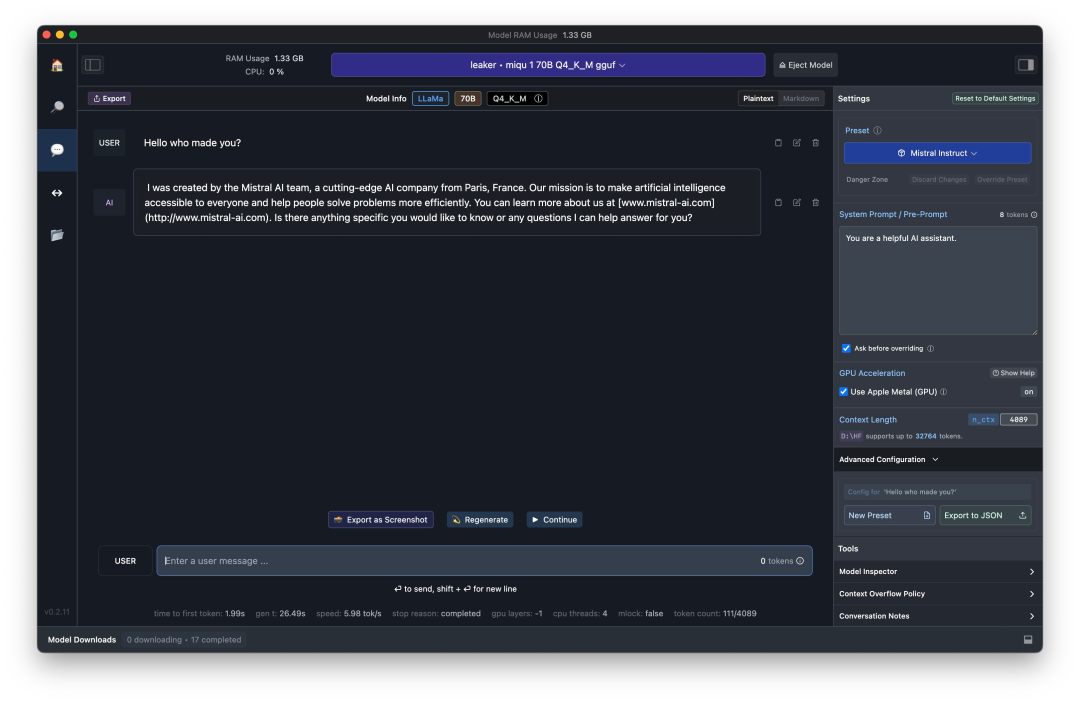

Jemand fragte „Wer hat dich gemacht“, Miqu berichtete direkt von sich selbst: „Ich wurde vom Mistral Al-Team erstellt.“

Jemand hat die gleiche Testfrage an beide Modelle gesendet und die erhaltenen Antworten waren alle auf Russisch. Der Tester verschärfte seinen Verdacht: „Es scheint das Standardrätsel zu kennen, aber wenn es ein Witzbold ist, ist es unmöglich, es an eine Antwort auf Russisch anzupassen.“

Beim Übersetzungsprozess waren die Ausdrücke fast gleich.“ .

Woher kommt Miqu? Ist es wirklich Mistral-Medium?

In der hitzigen Diskussion, die zwei Tage dauerte, verglichen viele Entwickler die beiden Modelle:

1 Miqu ist tatsächlich ein MistralAI-Modell. aber eine frühe MoE-Experimentalversion oder eine andere Version;

3 ist eine fein abgestimmte Version von Llama2.

Zuvor haben wir die Gründe vorgestellt, die von Entwicklern angegeben wurden, die die erste Möglichkeit unterstützen. Im Verlauf des Vorfalls beteiligten sich weitere Entwickler an Entschlüsselungsvorgängen und führten eingehendere Tests an den beiden Modellen durch. Von einem Reddit-Benutzer durchgeführte Tests, die lange wach blieben, zeigten, dass Miqu eher einer frühen Version des MistralAI-Modells ähnelt.

Der Entwickler hat das Modell auf vier professionelle deutschsprachige Online-Datenschutzschulungen/-Prüfungen angewendet. Die Testdaten, Fragen und alle Anweisungen sind auf Deutsch, während die Charakterkarten auf Englisch sind. Dabei werden Übersetzungsfähigkeiten und sprachübergreifendes Verständnis getestet.

Der Entwickler hat das Modell auf vier professionelle deutschsprachige Online-Datenschutzschulungen/-Prüfungen angewendet. Die Testdaten, Fragen und alle Anweisungen sind auf Deutsch, während die Charakterkarten auf Englisch sind. Dabei werden Übersetzungsfähigkeiten und sprachübergreifendes Verständnis getestet.

Die spezifische Testmethode ist wie folgt:

- Informieren Sie das Modell auf Deutsch, bevor Sie Informationen bereitstellen: „Ich werde Ihnen einige Informationen geben, bitte achten Sie auf diese Informationen, aber wenn Sie antworten, bestätigen Sie dies einfach mit „OK“. Sie verstehen, sagen Sie nicht mehr: „Dies dient dazu, die Fähigkeit des Modells zu testen, Anweisungen zu verstehen und auszuführen.“

- Nachdem Sie alle Informationen zum Thema bereitgestellt haben, stellen Sie dem Model Fragen. Dies ist eine Multiple-Choice-Frage (A/B/C), bei der die erste und letzte Frage gleich sind, aber die Reihenfolge der Optionen und die Buchstaben (X/Y/Z) geändert sind. Jeder Test enthält 4-6 Fragen, also insgesamt 18 Multiple-Choice-Fragen.

- Die Rangfolge basiert auf der Anzahl der richtigen Antworten, die das Modell gegeben hat. Dabei werden erstens die Antworten berücksichtigt, nachdem Kursinformationen bereitgestellt wurden, und zweitens Antworten, die im Falle eines Gleichstands blind beantwortet wurden, ohne vorher Informationen anzugeben. Alle Tests sind unabhängige Einheiten, der Kontext wird zwischen jedem Test gelöscht und zwischen den Sitzungen wird weder Speicher noch Status beibehalten.

- Der detaillierte Testbericht lautet wie folgt:

miqudev/miqu-1-70b GGUF Q5_K_M, 32K-Kontext, Mistral-Format: Es werden nur die richtigen Antworten für 4+4+4+5=17/18 Mehrfach- gegeben. Auswahlfragen. Beantworten Sie ohne vorherige Informationen einfach die Frage und geben Sie die richtige Antwort: 4+3+1+5=13/18. Die Dateneingabe wurde nicht wie angewiesen mit „OK“ bestätigt.

Während des Tests stellten die Entwickler fest, dass Miqu viele Ähnlichkeiten mit Mixtral aufweist: hervorragende zweisprachige deutsche Rechtschreibung und Grammatik; Hinzufügen von Notizen und Kommentaren zu Antworten;

Allerdings schnitt Miqu in diesem Entwicklertest schlechter ab als Mixtral-8x7B-Instruct-v0.1 (4-Bit) und war immer noch besser als Mistral Small und Medium. Aber es ist nicht viel besser als Mixtral 8x7B Instruct. Der Entwickler spekuliert, dass es sich bei Miqu möglicherweise um das durchgesickerte MistralAI-Modell handelt, ein älteres, möglicherweise Proof-of-Concept-Modell.

Dies ist der detaillierteste Test, den wir bisher gesehen haben und der die zweite Behauptung stützt.

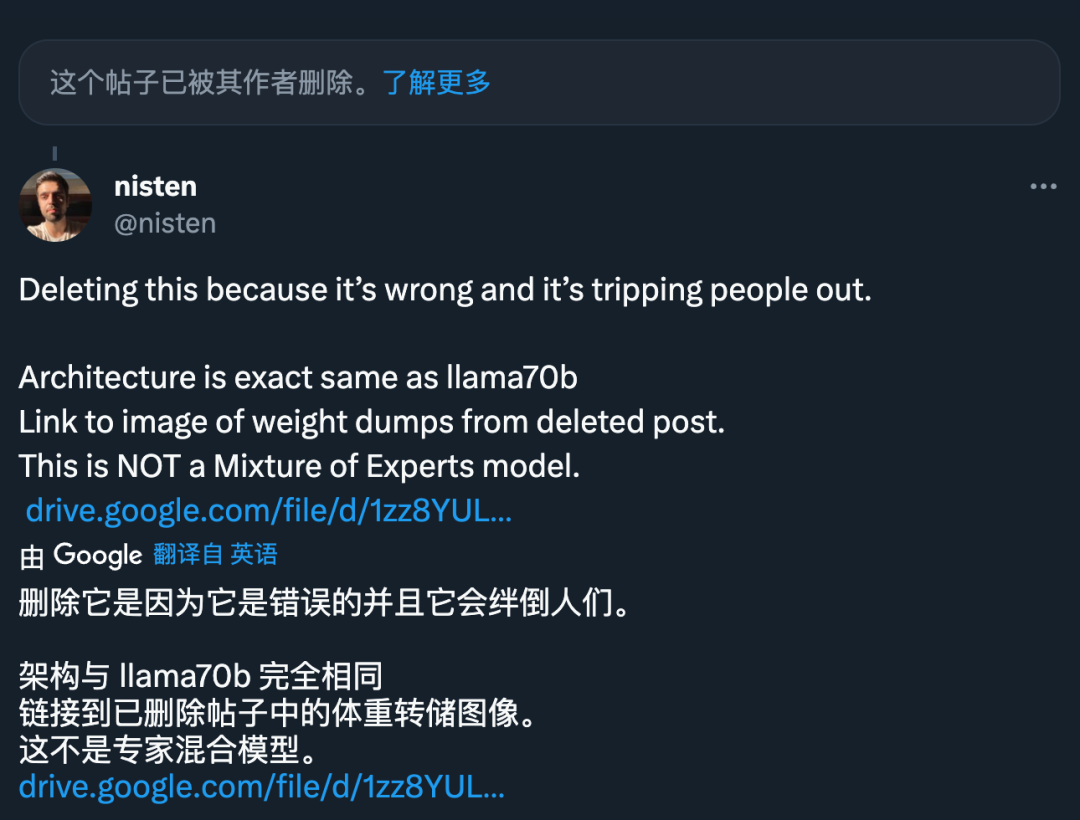

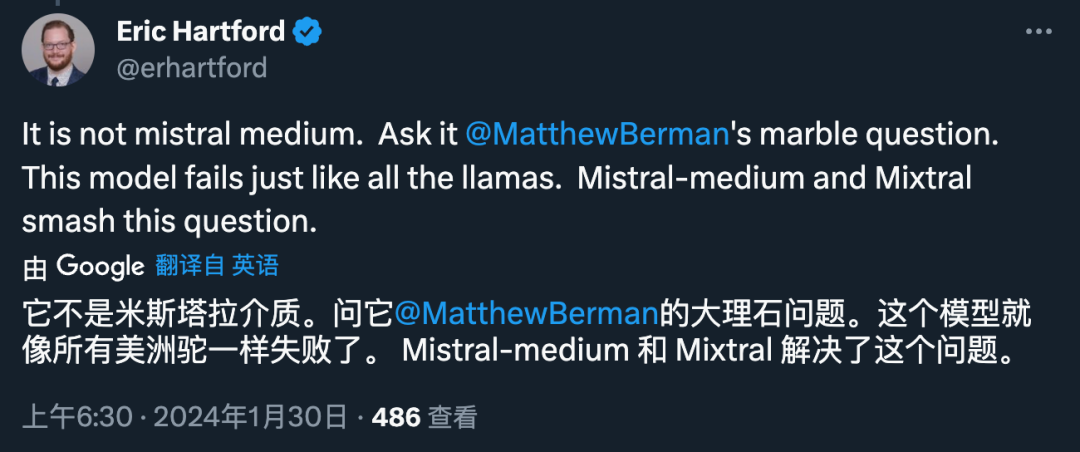

Einige Entwickler glauben jedoch, dass Miqu nichts mit MistralAI zu tun hat, sondern eher Llama 70B ähnelt, da seine Architektur „exakt die gleiche“ wie Llama 70B ist und „kein Experten-Hybridmodell“ ist. 🔜

Da kam jemand zu dem Schluss, dass es sich bei Miqu entweder um eine verfeinerte Version von Llama oder um eine frühe Version von Mistral-Medium handelt:

Wenn Ersteres zutrifft, handelt es sich bei Miqu möglicherweise um Llama 70B, verfeinert auf dem Mistral-Medium-Datensatz:

Wenn Letzteres wahr ist, ist Miqu nur eine Destillation von Mistral API, das könnte eine Farce auf der Ebene einer „amerikanischen Fake-Mondlandung“ sein:

Letzte Frage, Wer ist der Leaker?

Nach Hinweisen vieler X-Plattform-Benutzer wurde das mutmaßlich durchgesickerte Modell ursprünglich auf einer Website namens 4chan veröffentlicht. Diese Website ist ein völlig anonymes Echtzeit-Messaging-Forum, in dem Benutzer ohne Registrierung grafische und textliche Kommentare posten können.

Natürlich sind diese Schlussfolgerungen subjektiv. Für alle KI-Forscher: Diese Welle des Dramas braucht eine „Wahrheit“, um ein Ende zu finden.

Das obige ist der detaillierte Inhalt vonMistral-Medium versehentlich ausgelaufen? Dieses mysteriöse Modell, das es auf die Liste geschafft hat, hat in der KI-Community für viele Diskussionen gesorgt.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Stärken Sie die Modebranche mit Technologie und unterstützen Sie den Bezirk Futian beim Aufbau eines „Bay Area Fashion Headquarters Center'.

- Neue Regeln für Oktober sind da! Einbeziehung neuer Verkehrszeichen, Industrie der künstlichen Intelligenz usw.

- Web3 und KI konzentrieren sich auf Veränderung und Beständigkeit und gestalten den Gipfeldialog der Filmindustrie neu

- Lassen Sie uns gemeinsam das digitale Guangxi aufbauen und gemeinsam in eine digitale Zukunft gehen! Die ökologische Konferenz der Industrie für künstliche Intelligenz in Guangxi Kunpeng Shengteng 2023 wurde erfolgreich abgehalten