Heim >Technologie-Peripheriegeräte >KI >Erlernen von modalübergreifendem Belegungswissen: RadOcc mithilfe der Rendering-unterstützten Destillationstechnologie

Erlernen von modalübergreifendem Belegungswissen: RadOcc mithilfe der Rendering-unterstützten Destillationstechnologie

- PHPznach vorne

- 2024-01-25 11:36:191250Durchsuche

Originaltitel: Radocc: Learning Cross-Modality Occupancy Knowledge through Rendering Assisted Distillation

Link zum Papier: https://arxiv.org/pdf/2312.11829.pdf

Autorenzugehörigkeit: FNii, CUHK-Shenzhen SSE, CUHK-Shenzhen Huawei Labor der Arche Noah

Konferenz: AAAI 2024

Papieridee:

Die 3D-Belegungsvorhersage ist eine neue Aufgabe, die darauf abzielt, den Belegungsstatus und die Semantik von 3D-Szenen anhand von Bildern mit mehreren Ansichten abzuschätzen. Aufgrund des Mangels an geometrischen Prioritäten stößt die bildbasierte Szenenwahrnehmung jedoch auf erhebliche Herausforderungen bei der Erzielung genauer Vorhersagen. Dieser Artikel befasst sich mit diesem Problem, indem er in dieser Aufgabe die modalübergreifende Wissensdestillation untersucht, d. h. wir verwenden ein leistungsfähigeres multimodales Modell, um das visuelle Modell während des Trainingsprozesses zu steuern. In der Praxis stellt dieses Papier fest, dass die direkte Anwendung der Merkmals- oder Logitausrichtung, die in der Wahrnehmung aus der Vogelperspektive (BEV) vorgeschlagen und weit verbreitet ist, keine zufriedenstellenden Ergebnisse liefert. Um dieses Problem zu lösen, stellt dieser Artikel RadOcc vor, ein Rendering-gestütztes Destillationsparadigma für die 3D-Belegungsvorhersage. Durch den Einsatz von differenzierbarem Volumenrendering generieren wir perspektivische Tiefen- und semantische Karten und schlagen zwei neuartige Konsistenzkriterien zwischen der gerenderten Ausgabe von Lehrer- und Schülermodellen vor. Insbesondere richtet der Tiefenkonsistenzverlust die Abschlussverteilungen der Rendering-Strahlen aus, während der semantische Konsistenzverlust die durch das visuelle Basismodell (VLM) gesteuerte Ähnlichkeit innerhalb eines Segments nachahmt. Experimentelle Ergebnisse zum nuScenes-Datensatz zeigen die Wirksamkeit der in diesem Artikel vorgeschlagenen Methode bei der Verbesserung verschiedener Methoden zur 3D-Belegungsvorhersage. Beispielsweise verbessert die in diesem Artikel vorgeschlagene Methode die Basislinie dieses Artikels um 2,2 % in der mIoU-Metrik und erreicht 2,2 %. im Occ3D-Benchmark.

Hauptbeiträge:

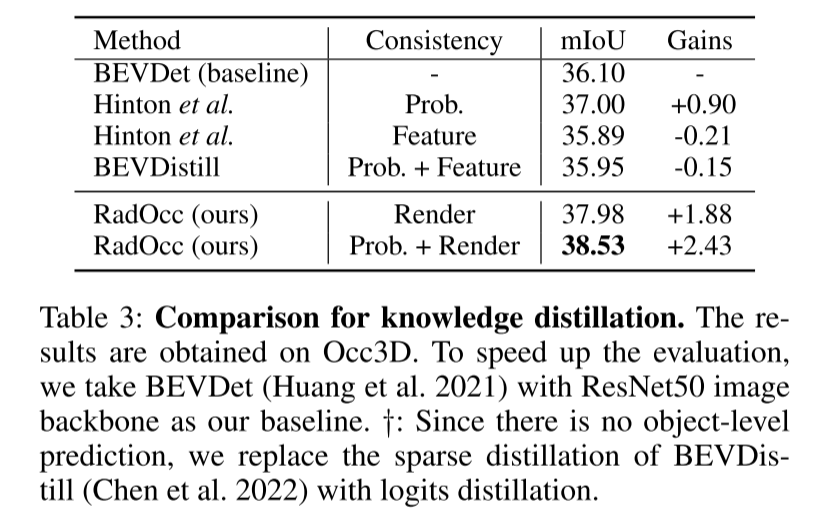

In diesem Artikel wird ein Rendering-unterstütztes Destillationsparadigma namens RadOcc für die 3D-Belegungsvorhersage vorgestellt. Dies ist der erste Artikel, der die modalübergreifende Wissensdestillation in 3D-OP untersucht und wertvolle Einblicke in die Anwendung bestehender BEV-Destillationstechniken bei dieser Aufgabe bietet.

Die Autoren schlagen zwei neuartige Destillationsbeschränkungen vor, nämlich Rendering-Tiefe und semantische Konsistenz (RDC und RSC). Diese Einschränkungen verbessern effektiv den Wissenstransferprozess, indem sie Lichtverteilungs- und Korrelationsmatrizen anhand des Vision-Basismodells ausrichten. Der Schlüssel zu diesem Ansatz besteht darin, Tiefen- und semantische Informationen zu nutzen, um den Rendering-Prozess zu steuern und so die Qualität und Genauigkeit der Rendering-Ergebnisse zu verbessern. Durch die Kombination dieser beiden Einschränkungen erzielten die Forscher erhebliche Verbesserungen und lieferten neue Lösungen für den Wissenstransfer bei Sehaufgaben.

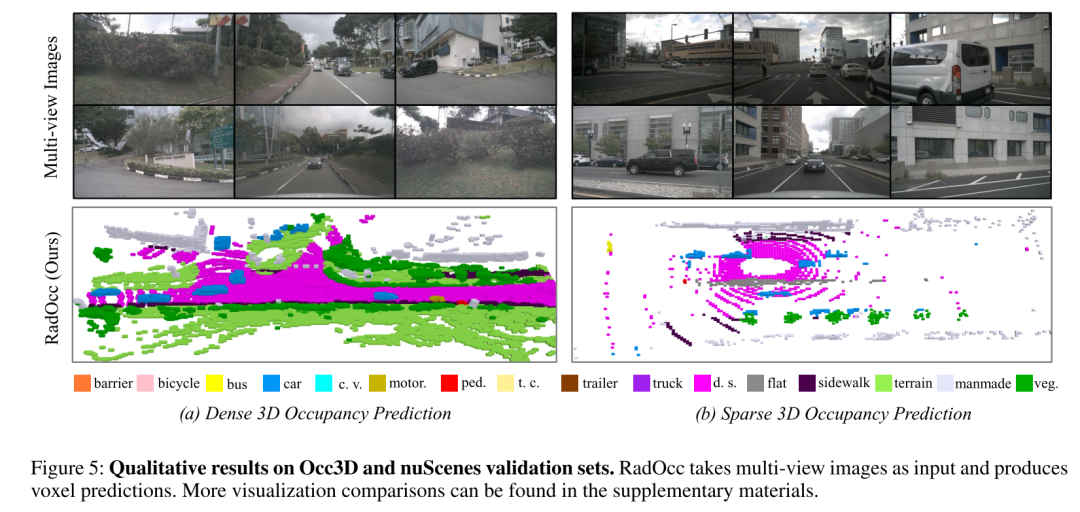

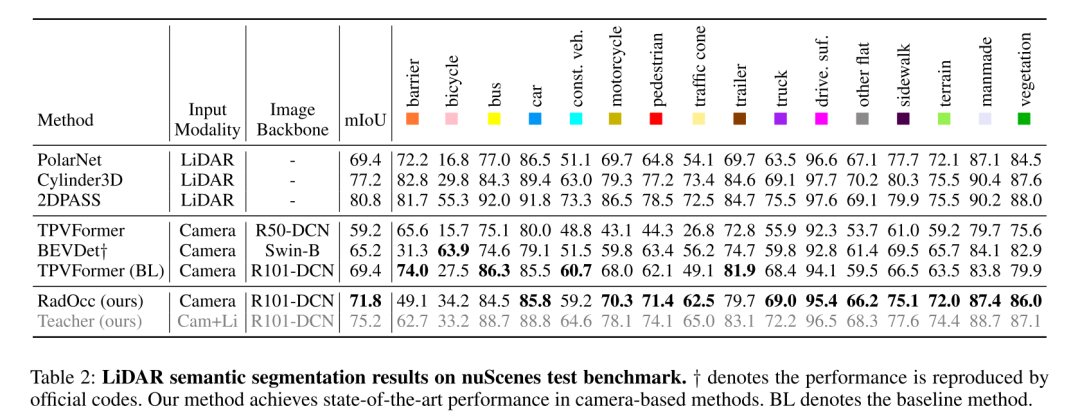

Ausgestattet mit der vorgeschlagenen Methode zeigt RadOcc eine hochmoderne Vorhersageleistung bei dichter und dünner Belegung bei Occ3D- und nuScenes-Benchmarks. Darüber hinaus haben Experimente gezeigt, dass die in diesem Artikel vorgeschlagene Destillationsmethode die Leistung mehrerer Basismodelle effektiv verbessern kann.

Netzwerkdesign:

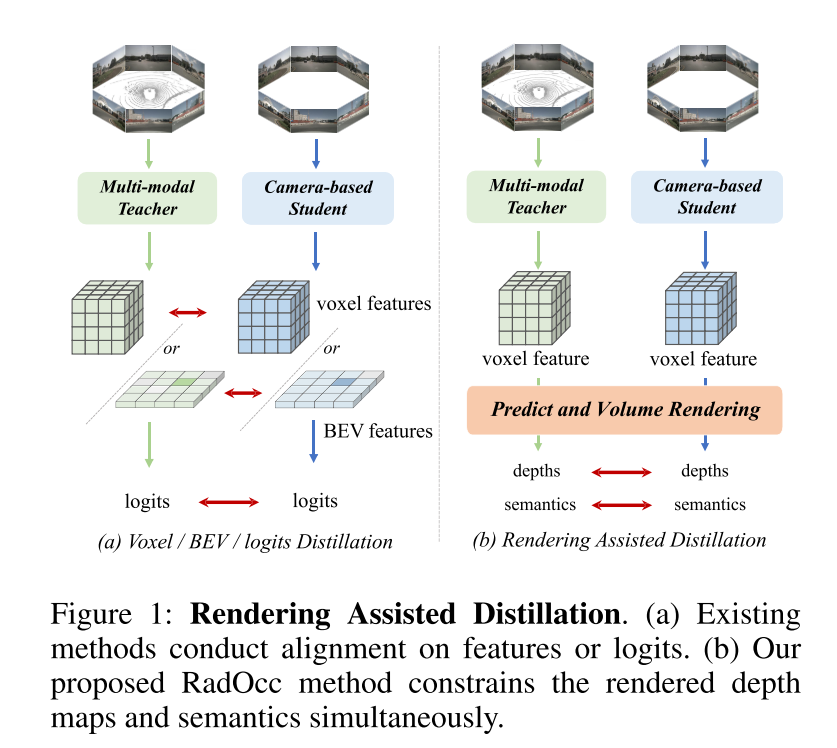

Dieser Artikel ist der erste, der die modalübergreifende Wissensdestillation für die 3D-Belegungsvorhersageaufgabe untersucht. Basierend auf der Methode des Wissenstransfers unter Verwendung von BEV oder Logits-Konsistenz im BEV-Sensorbereich erweitert dieser Artikel diese Destillationstechniken auf die 3D-Belegungsvorhersageaufgabe mit dem Ziel, Voxelmerkmale und Voxel-Logits auszurichten, wie in Abbildung 1(a) dargestellt. Vorläufige Experimente zeigen jedoch, dass diese Ausrichtungstechniken bei 3D-OP-Aufgaben vor erheblichen Herausforderungen stehen, insbesondere bei der ersteren Methode, die eine negative Übertragung einführt. Diese Herausforderung könnte auf den grundlegenden Unterschied zwischen der 3D-Objekterkennung und der Belegungsvorhersage zurückzuführen sein, die als feinkörnigere Wahrnehmungsaufgabe die Erfassung geometrischer Details sowie von Hintergrundobjekten erfordert.

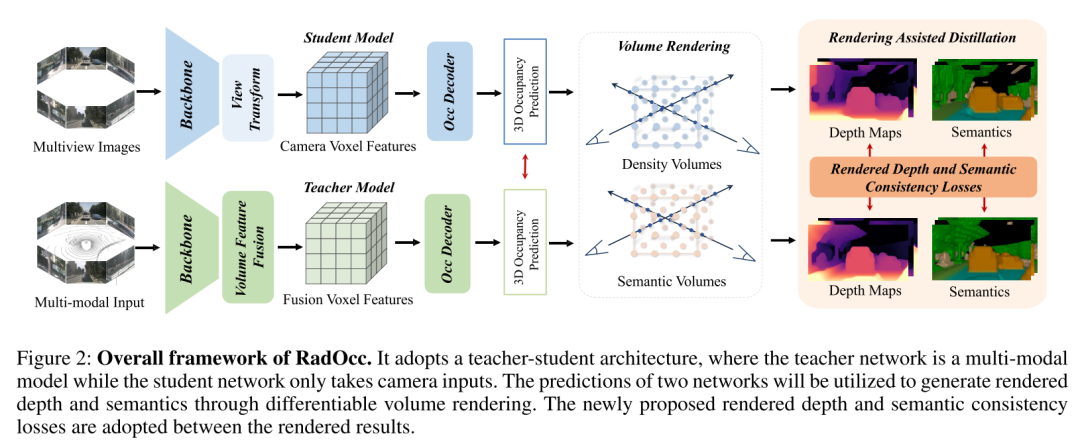

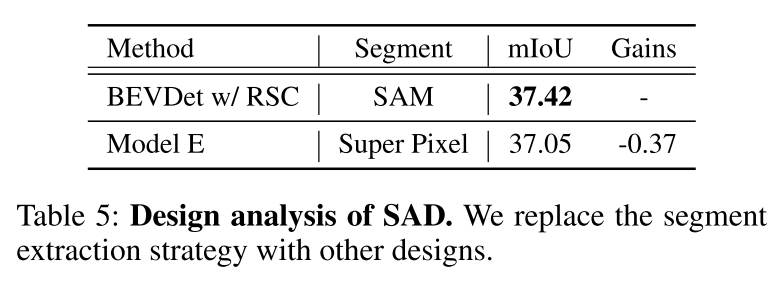

Um die oben genannten Herausforderungen anzugehen, schlägt dieses Papier RadOcc vor, eine neuartige Methode zur modalübergreifenden Wissensdestillation unter Verwendung differenzierbarer Volumenwiedergabe. Die Kernidee von RadOcc besteht darin, die vom Lehrermodell und dem Schülermodell generierten Rendering-Ergebnisse auszurichten, wie in Abbildung 1 (b) dargestellt. Konkret verwendet dieser Artikel die intrinsischen und extrinsischen Parameter der Kamera, um ein Volumenrendering von Voxelmerkmalen durchzuführen (Mildenhall et al. 2021), was es diesem Artikel ermöglicht, entsprechende Tiefenkarten und semantische Karten aus verschiedenen Blickwinkeln zu erhalten. Um eine bessere Ausrichtung zwischen gerenderten Ausgaben zu erreichen, werden in diesem Artikel neuartige Verluste bei der Rendering Depth Consistency (RDC) und der Rendering Semantic Consistency (RSC) vorgestellt. Einerseits erzwingt der RDC-Verlust die Konsistenz der Strahlverteilung, wodurch das Studentenmodell die zugrunde liegende Struktur der Daten erfassen kann. Andererseits nutzt der RSC-Verlust das visuelle Basismodell (Kirillov et al. 2023) und nutzt vorextrahierte Segmente für die Affinitätsdestillation. Dieser Standard ermöglicht es Modellen, semantische Darstellungen verschiedener Bildbereiche zu erlernen und zu vergleichen, wodurch ihre Fähigkeit zur Erfassung feinkörniger Details verbessert wird. Durch die Kombination der oben genannten Einschränkungen nutzt die in diesem Artikel vorgeschlagene Methode effektiv die modalübergreifende Wissensdestillation, wodurch die Leistung verbessert und das Studentenmodell besser optimiert wird. Dieses Papier demonstriert die Wirksamkeit unseres Ansatzes zur Vorhersage dichter und spärlicher Belegung und erzielt bei beiden Aufgaben modernste Ergebnisse.

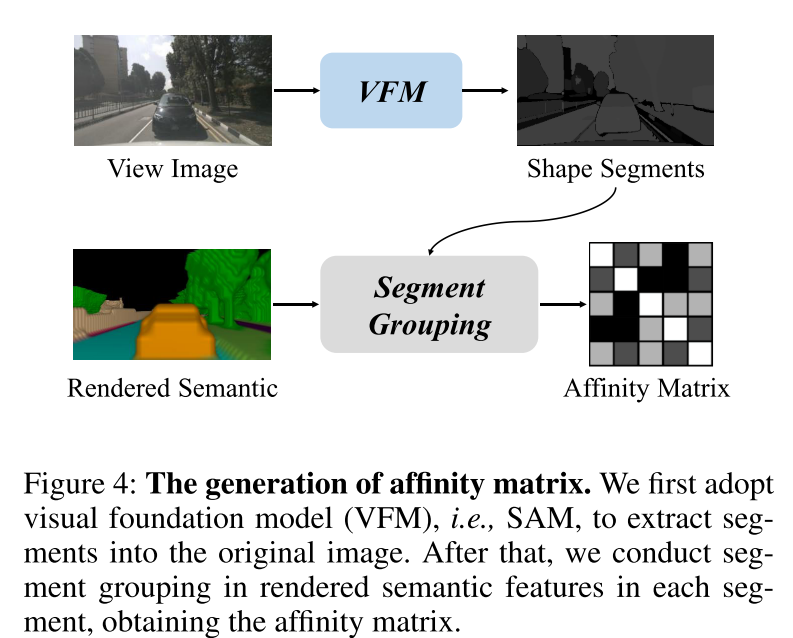

Abbildung 1: Render-unterstützte Destillation. (a) Bestehende Methoden richten Features oder Logits aus. (b) Die in diesem Artikel vorgeschlagene RadOcc-Methode schränkt gleichzeitig die gerenderte Tiefenkarte und Semantik ein.  Abbildung 2: Gesamtrahmen von RadOcc. Es verwendet eine Lehrer-Schüler-Architektur, bei der das Lehrernetzwerk ein multimodales Modell ist und das Schülernetzwerk nur Kameraeingaben akzeptiert. Die Vorhersagen beider Netzwerke werden verwendet, um Rendering-Tiefe und Semantik durch differenzierbares Volumen-Rendering zu generieren. Neu vorgeschlagene Rendering-Tiefe und semantische Konsistenzverluste werden zwischen den Rendering-Ergebnissen übernommen.

Abbildung 2: Gesamtrahmen von RadOcc. Es verwendet eine Lehrer-Schüler-Architektur, bei der das Lehrernetzwerk ein multimodales Modell ist und das Schülernetzwerk nur Kameraeingaben akzeptiert. Die Vorhersagen beider Netzwerke werden verwendet, um Rendering-Tiefe und Semantik durch differenzierbares Volumen-Rendering zu generieren. Neu vorgeschlagene Rendering-Tiefe und semantische Konsistenzverluste werden zwischen den Rendering-Ergebnissen übernommen.

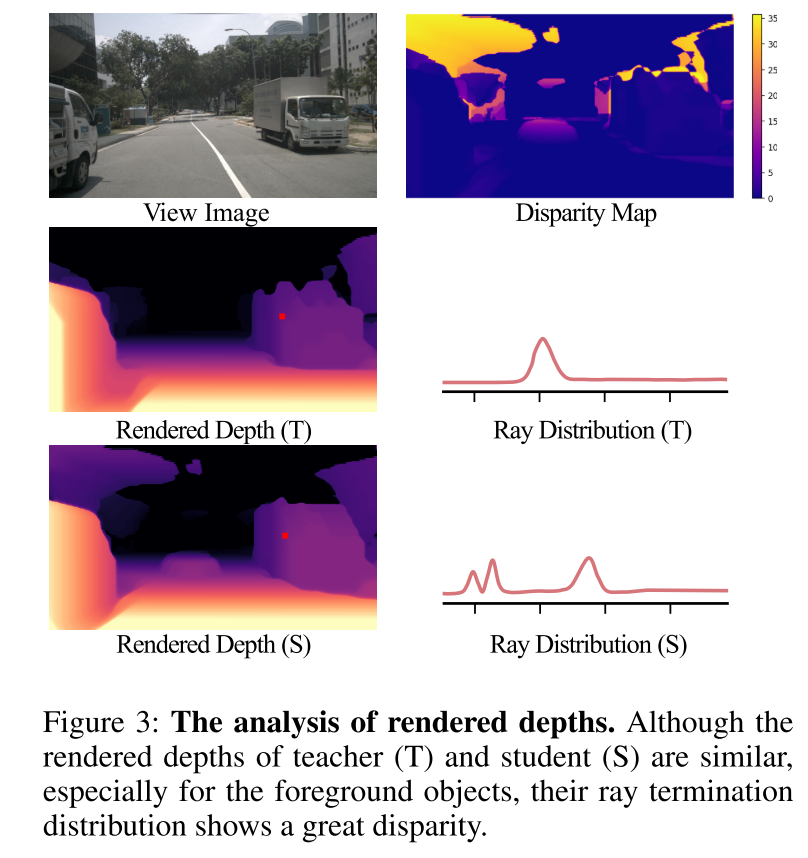

Abbildung 3: Rendering-Tiefenanalyse. Obwohl der Lehrer (T) und der Schüler (S) ähnliche Rendertiefen haben, insbesondere für Vordergrundobjekte, weisen ihre Lichtabschlussverteilungen große Unterschiede auf.

Abbildung 4: Generierung der Affinitätsmatrix. In diesem Artikel wird zunächst das Vision Foundation Model (VFM), nämlich SAM, verwendet, um Segmente in das Originalbild zu extrahieren. Anschließend führt dieser Artikel eine Segmentaggregation der in jedem Segment gerenderten semantischen Merkmale durch, um die Affinitätsmatrix zu erhalten.

Experimentelle Ergebnisse:

Zusammenfassung:

Dieser Artikel schlägt vor. RadO cc, eine 3D-neuartige, modalübergreifende Wissensdestillation für das Paradigma der Belegungsvorhersage. Es nutzt ein multimodales Lehrermodell, um dem visuellen Schülermodell durch differenzierbare Volumendarstellung geometrische und semantische Führung zu geben. Darüber hinaus werden in diesem Artikel zwei neue Konsistenzkriterien vorgeschlagen: Tiefenkonsistenzverlust und semantischer Konsistenzverlust, um die Strahlenverteilung und Affinitätsmatrix zwischen Lehrer- und Schülermodellen auszurichten. Umfangreiche Experimente mit Occ3D- und nuScenes-Datensätzen zeigen, dass RadOcc die Leistung verschiedener 3D-Belegungsvorhersagemethoden erheblich verbessern kann. Unsere Methode erzielt hochmoderne Ergebnisse beim Occ3D-Challenge-Benchmark und übertrifft bestehende veröffentlichte Methoden deutlich. Wir glauben, dass unsere Arbeit neue Möglichkeiten für modalübergreifendes Lernen im Szenenverständnis eröffnet.

Das obige ist der detaillierte Inhalt vonErlernen von modalübergreifendem Belegungswissen: RadOcc mithilfe der Rendering-unterstützten Destillationstechnologie. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Teilen Sie uns mit, wie Sie mit HTML5 einen realistischen 3D-Weihnachtsbaum erstellen

- Empfohlene 3D-Flop-Effekt-Spezialeffekte (Sammlung)

- Universeller Fear-Shot-Lerner: eine Lösung für eine Vielzahl dichter Vorhersageaufgaben

- Wie nutzt man Bibliotheken für maschinelles Lernen in Java, um eine intelligente Datenanalyse und -vorhersage zu erreichen?