Heim >Technologie-Peripheriegeräte >KI >Produziert von der Peking-Universität: Das neueste SOTA mit Texturqualität und Multi-View-Konsistenz, das eine 3D-Konvertierung eines Bildes in 2 Minuten ermöglicht

Produziert von der Peking-Universität: Das neueste SOTA mit Texturqualität und Multi-View-Konsistenz, das eine 3D-Konvertierung eines Bildes in 2 Minuten ermöglicht

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2024-01-10 23:09:511362Durchsuche

Es dauert nur zwei Minuten, Bilder in 3D zu konvertieren!

Es ist auch die Art mit hoher Texturqualität, Multi-Viewing und hoher Konsistenz.

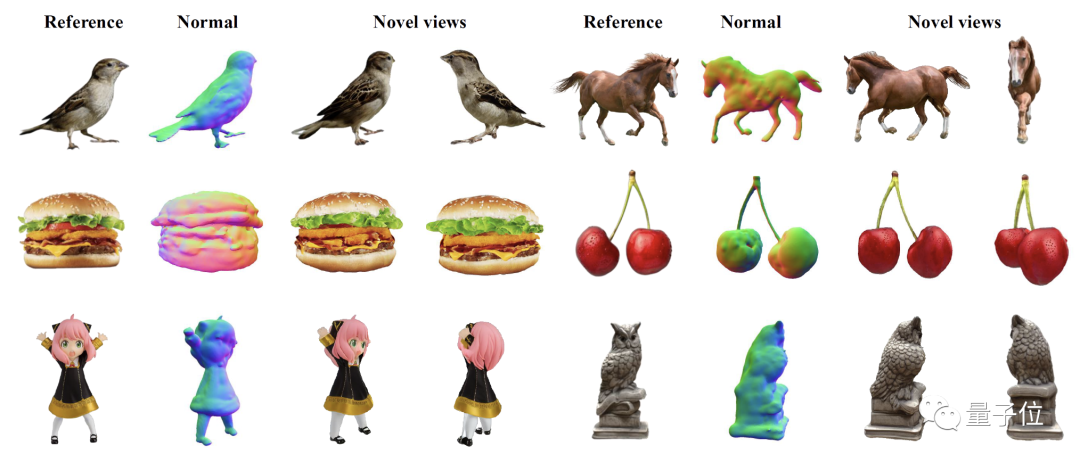

Egal um welche Art es sich handelt, das Einzelansichtsbild sieht bei der Eingabe immer noch so aus:

Nach zwei Minuten ist die 3D-Version fertig:

△, Repaint123 (NeRF ); Als nächstes Repaint123 (GS)

Die neue Methode heißt Repaint123. Die Kernidee besteht darin, die leistungsstarken Bilderzeugungsfähigkeiten des 2D-Diffusionsmodells mit den Texturausrichtungsfähigkeiten der Repaint-Strategie zu kombinieren, um hohe Werte zu erzeugen -Qualität, konsistente Bilder mit mehreren Ansichten.

Darüber hinaus stellt diese Forschung auch eine Methode zur sichtbarkeitsbewussten adaptiven Neulackierungsintensität für überlappende Bereiche vor.

Repaint123 löst die Probleme früherer Methoden wie große Abweichungen bei mehreren Ansichten, Texturverschlechterung und langsame Generierung auf einen Schlag.

Derzeit ist der Projektcode noch nicht auf GitHub veröffentlicht, aber über 100 Leute sind gekommen, um ihn zu markieren:

Wie sieht Repaint123 aus?

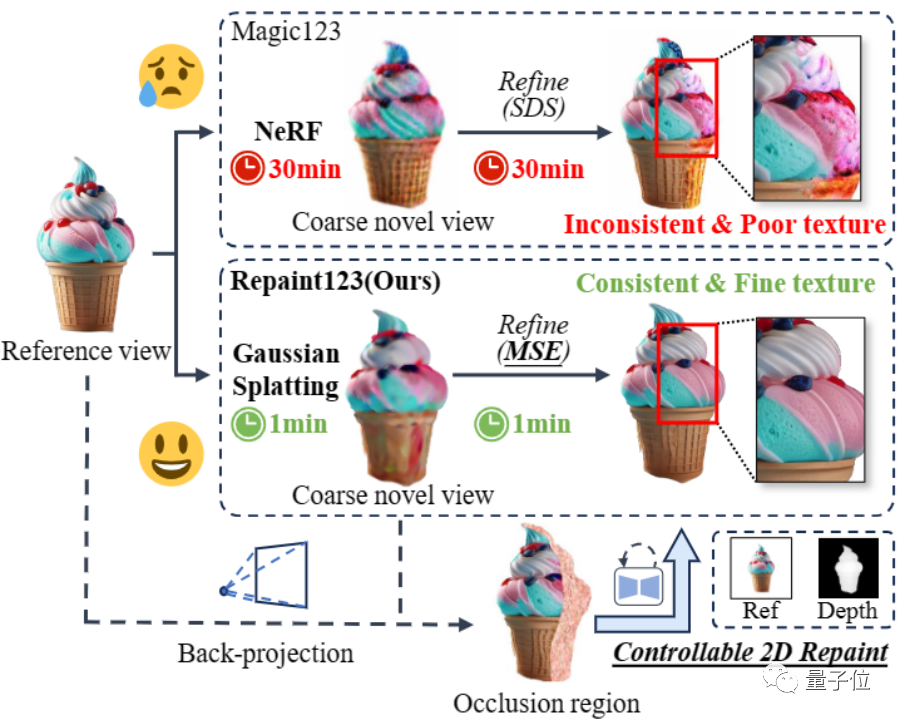

Früher verwendete die Methode zur Konvertierung von Bildern in 3D normalerweise Score Distillation Sampling (SDS). Obwohl die Ergebnisse dieser Methode beeindruckend sind, gibt es einige Probleme wie Inkonsistenz bei mehreren Ansichten, Übersättigung, zu stark geglättete Texturen und langsame Generierungsgeschwindigkeit.

△Von oben nach unten: Eingabe, Zero123-XL, Magic123, Dream Gaußian

Um diese Probleme zu lösen, schlugen Forscher der Peking-Universität, des Pengcheng-Labors, der National University of Singapore und der Wuhan-Universität Repaint123 vor.

Im Allgemeinen hat Repaint123 die folgenden Beiträge:

(1) Repaint123 kann qualitativ hochwertige Bildsequenzen generieren, indem es den kontrollierbaren Neuzeichnungsprozess von Bildern bis zur 3D-Generierung umfassend berücksichtigt und sicherstellt, dass diese Bilder über mehrere hinweg konsistent sind Perspektiven.

(2)Repaint123 schlägt eine einfache Basismethode für die 3D-Generierung in Einzelansichten vor.

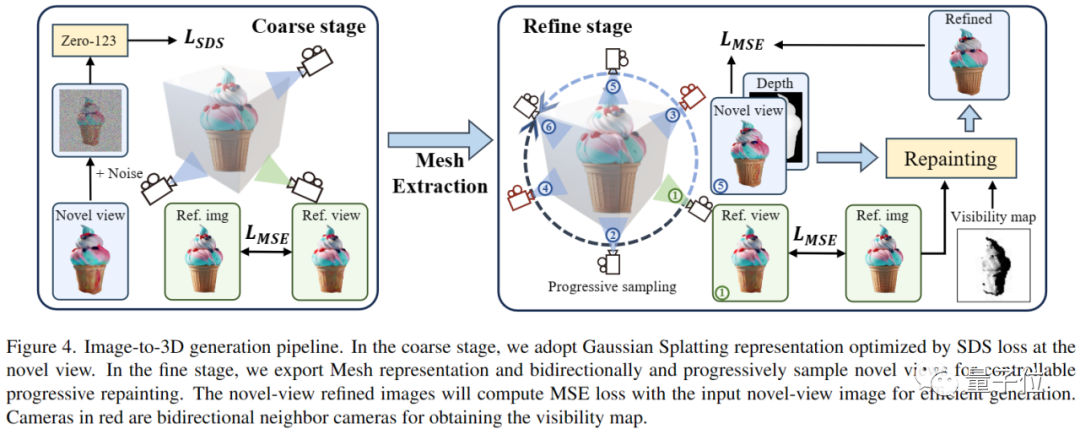

In der Rohmodellphase wird Zero123 als 3D-Priori in Kombination mit der SDS-Verlustfunktion verwendet, um durch Optimierung der Gaußschen Splatting-Geometrie schnell ein grobes 3D-Modell zu generieren (nur 1 Minute).

In der Feinmodellphase wird die stabile Diffusion als 2D-Priori in Kombination mit der MSE-Verlustfunktion (Mean Square Error) verwendet, um durch schnelles Verfeinern der Netztextur ein hochwertiges 3D-Modell zu generieren (dauert ebenfalls nur 1 Minute). .

(3) Eine Vielzahl von Experimenten hat die Wirksamkeit der Repaint123-Methode nachgewiesen. Es ist in der Lage, aus einem einzigen Bild in nur 2 Minuten hochwertige 3D-Inhalte zu generieren, die der Qualität der 2D-Generierung entsprechen.

△Erzielen Sie eine konsistente und qualitativ hochwertige Einzelansicht-3D-Schnellgenerierung.

Werfen wir einen Blick auf die spezifischen Methoden.

Repaint123 konzentriert sich auf die Optimierung der Netzverfeinerungsphase und seine Hauptverbesserungsrichtungen decken zwei Aspekte ab: die Generierung hochwertiger Bildsequenzen mit Multi-View-Konsistenz und die Erzielung einer schnellen und hochwertigen 3D-Rekonstruktion.

1. Generieren hochwertiger Bildsequenzen mit Multi-View-Konsistenz

Das Generieren hochwertiger Bildsequenzen mit Multi-View-Konsistenz ist in die folgenden drei Teile unterteilt:

△Multi-View-konsistente Bildgenerierung Prozess

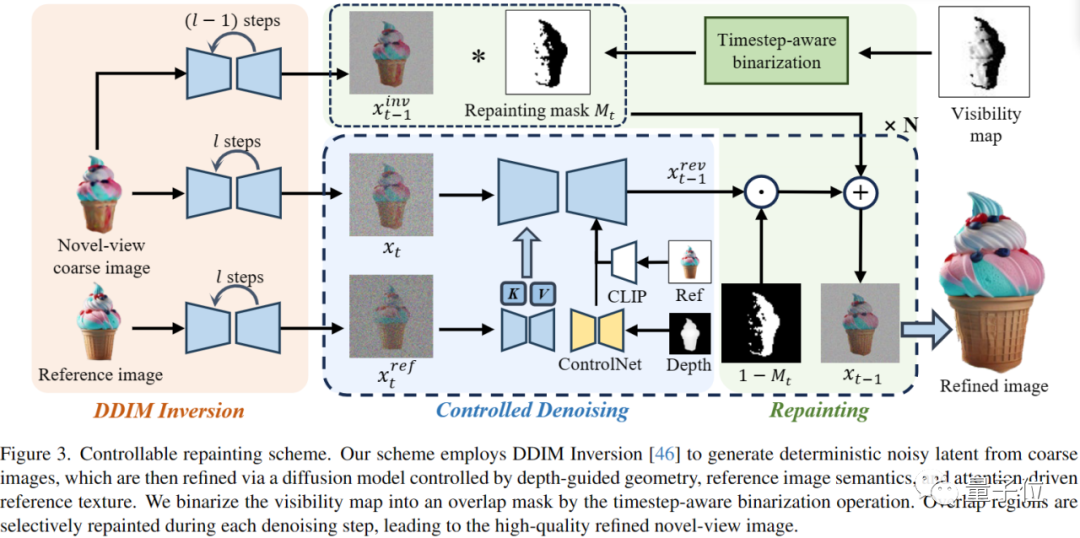

DDIM-Inversion

Um die in der Grobmodellstufe erzeugten 3D-konsistenten Niederfrequenz-Texturinformationen beizubehalten, verwendet der Autor die DDIM-Inversion, um das Bild in einen bestimmten latenten Raum zu invertieren und so den Grundstein für die anschließende Entrauschung zu legen Prozess, der originalgetreue und konsistente Bilder erzeugt.

Kontrollierbare Rauschunterdrückung

Um die geometrische Konsistenz und die Texturkonsistenz über große Entfernungen in der Entrauschungsphase zu steuern, führte der Autor ControlNet ein, indem er die vom groben Modell gerenderte Tiefenkarte als geometrischen Prior verwendete und gleichzeitig die Aufmerksamkeitsfunktion der Referenz einfügte Bild für Texturmigration.

Um eine klassifikatorfreie Führung zur Verbesserung der Bildqualität durchzuführen, verwendet das Papier außerdem CLIP, um Referenzbilder in Bildhinweise zur Führung des Rauschunterdrückungsnetzwerks zu kodieren.

Neuzeichnen

Progressives Neuzeichnen von Okklusionen und überlappenden Teilen Um sicherzustellen, dass die überlappenden Bereiche benachbarter Bilder in der Bildsequenz auf Pixelebene ausgerichtet sind, wendet der Autor eine Strategie des progressiven lokalen Neuzeichnens an.

Erzeugen Sie harmonische angrenzende Bereiche, während überlappende Bereiche unverändert bleiben, und erweitern Sie sie schrittweise auf 360° aus der Referenzperspektive.

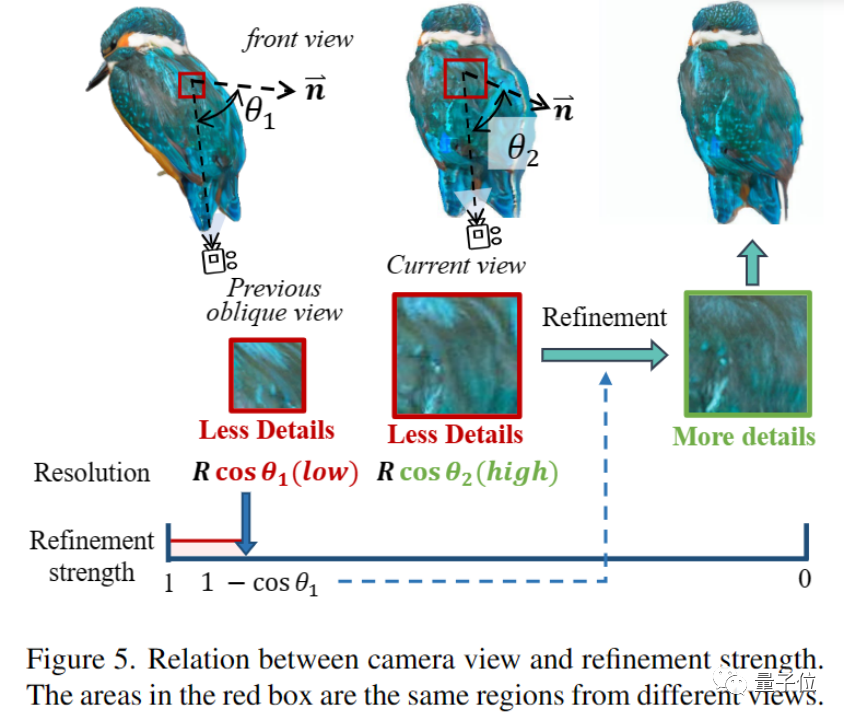

Wie in der Abbildung unten gezeigt, stellte der Autor jedoch fest, dass auch der überlappende Bereich verfeinert werden muss, da die visuelle Auflösung des zuvor schielenden Bereichs während der Emmetropie größer wird und mehr Hochfrequenzinformationen hinzugefügt werden müssen.

Darüber hinaus ist die Ausdünnungsintensität gleich 1-cosθ*, wobei θ* der Maximalwert des Winkels θ zwischen allen vorherigen Kamerawinkeln und dem Normalenvektor der betrachteten Oberfläche ist, wodurch die Überlappung adaptiv neu gezeichnet wird Bereich.

△Die Beziehung zwischen Kamerawinkel und Ausdünnungsintensität

Um die geeignete Ausdünnungsintensität zu wählen, um die Wiedergabetreue zu gewährleisten und gleichzeitig die Qualität zu verbessern, stützte sich der Autor auf das Projektionstheorem und die Idee der Bild-Superauflösung und schlug vor Eine einfache und unkomplizierte Strategie zur sichtbarkeitsbewussten Neuzeichnung, um überlappende Bereiche zu verfeinern.

2. Schnelle und qualitativ hochwertige 3D-Rekonstruktion

Wie in der Abbildung unten gezeigt, wendet der Autor eine zweistufige Methode im Prozess der schnellen und qualitativ hochwertigen 3D-Rekonstruktion an.

△Repaint123 zweistufiges Einzelansicht-3D-Generierungsframework

Zunächst nutzen sie die Gaußsche Splatting-Darstellung, um schnell vernünftige geometrische Strukturen und grobe Texturen zu generieren.

Gleichzeitig ist der Autor mit Hilfe der zuvor generierten, konsistenten und qualitativ hochwertigen Multi-View-Bildsequenz in der Lage, eine schnelle 3D-Texturrekonstruktion unter Verwendung eines einfachen mittleren quadratischen Fehlers (MSE) Verlust durchzuführen.

Optimale Konsistenz, Qualität und Geschwindigkeit

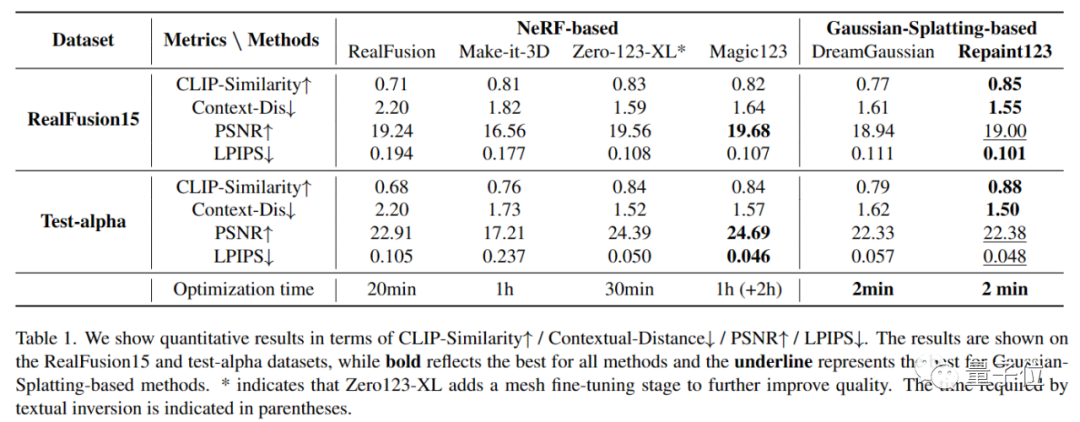

Forscher verglichen Methoden für mehrere Einzelansichtsgenerierungsaufgaben.

△Einzelansicht-3D-Generierungsvisualisierungsvergleich

Auf RealFusion15- und Test-Alpha-Datensätzen erzielte Repaint123 die besten Ergebnisse in drei Aspekten: Konsistenz, Qualität und Geschwindigkeit.

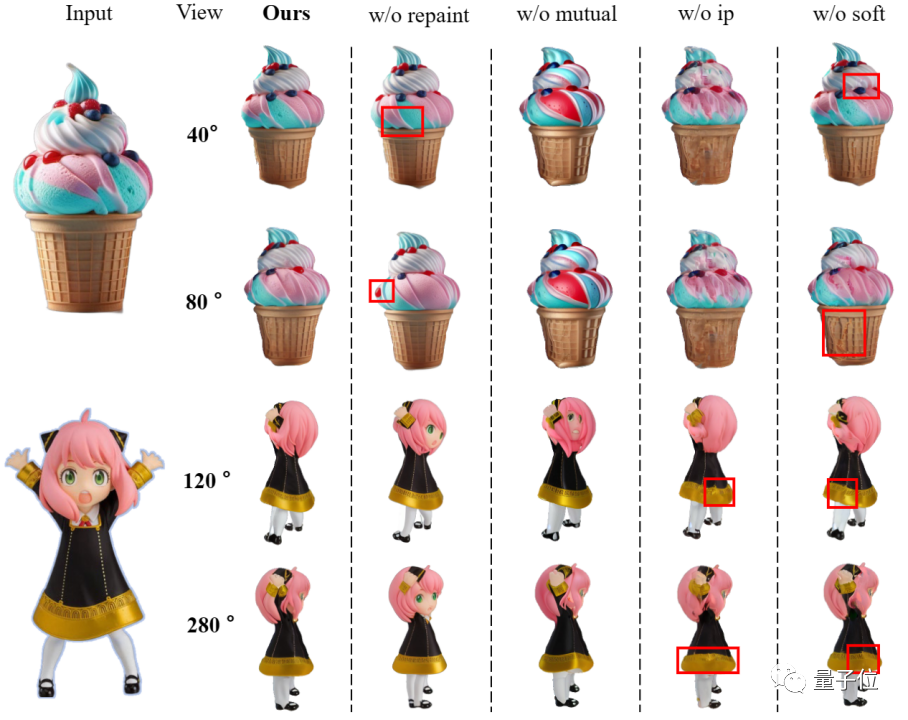

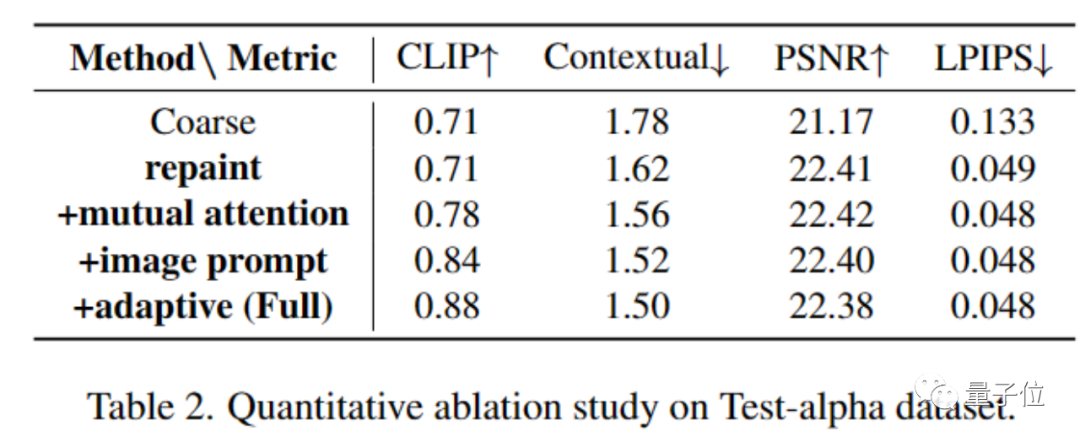

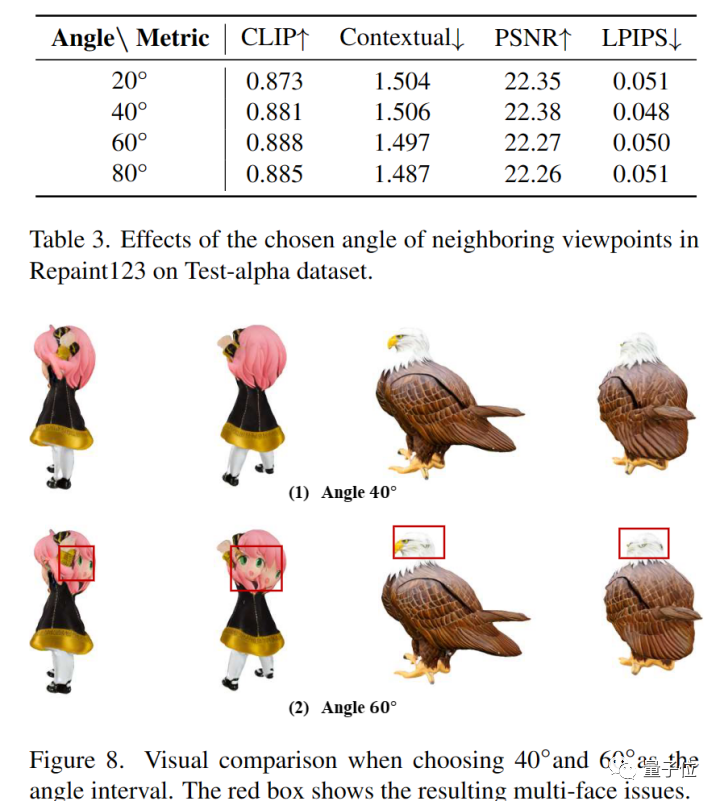

Gleichzeitig führte der Autor auch Ablationsexperimente zur Wirksamkeit jedes in der Arbeit verwendeten Moduls und zum Inkrement der Betrachtungswinkelrotation durch:

und stellte fest, dass das Betrachtungswinkelintervall 60 beträgt Grad erreicht die Leistung ihren Höhepunkt. Ein zu großes Betrachtungswinkelintervall verringert jedoch den Überlappungsbereich und erhöht die Möglichkeit vielschichtiger Probleme, sodass 40 Grad als optimales Betrachtungswinkelintervall verwendet werden können.

Papieradresse: https://arxiv.org/pdf/2312.13271.pdf

Codeadresse: https://pku-yuangroup.github.io/repaint123/

Projektadresse: https: //pku-yuangroup.github.io/repaint123/

Das obige ist der detaillierte Inhalt vonProduziert von der Peking-Universität: Das neueste SOTA mit Texturqualität und Multi-View-Konsistenz, das eine 3D-Konvertierung eines Bildes in 2 Minuten ermöglicht. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!