Heim >Technologie-Peripheriegeräte >KI >Neue Technologie Repaint123: Generieren Sie effizient hochwertige 3D-Einzelansichten in nur 2 Minuten!

Neue Technologie Repaint123: Generieren Sie effizient hochwertige 3D-Einzelansichten in nur 2 Minuten!

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2024-01-08 19:06:44805Durchsuche

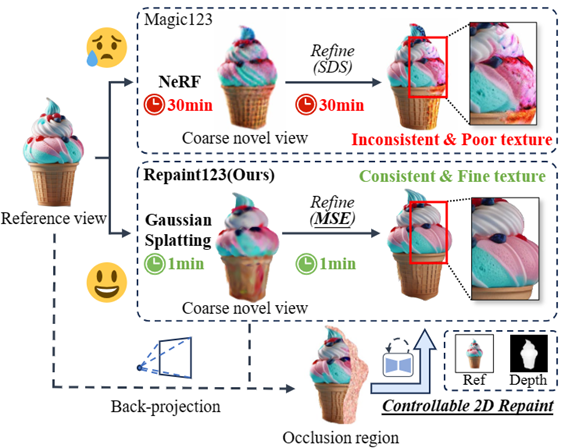

Die Methode zum Konvertieren eines Bildes in 3D verwendet normalerweise Score Distillation Sampling (SDS). Obwohl die Ergebnisse beeindruckend sind, gibt es immer noch einige Mängel, darunter auch Inkonsistenz bei mehreren Ansichten, Übersättigung und zu glatte Texturen wie Probleme wie langsame Generierungsgeschwindigkeit.

Um diese Probleme zu lösen, schlugen Forscher der Peking-Universität, der National University of Singapore, der Wuhan University und anderen Institutionen Repaint123 vor, um Multi-View-Bias und Texturverschlechterung zu mildern und den Generierungsprozess zu beschleunigen.

Papieradresse: https://arxiv.org/pdf/2312.13271.pdf

GitHub: https://github.com/PKU-YuanGroup/repaint123

Projektadresse: https ://pku-yuangroup.github.io/repaint123/

Die Kernidee besteht darin, die Bilderzeugungsfunktionen des 2D-Diffusionsmodells mit den Texturausrichtungsfunktionen zu kombinieren, um qualitativ hochwertige Bilder mit mehreren Ansichten zu erstellen.

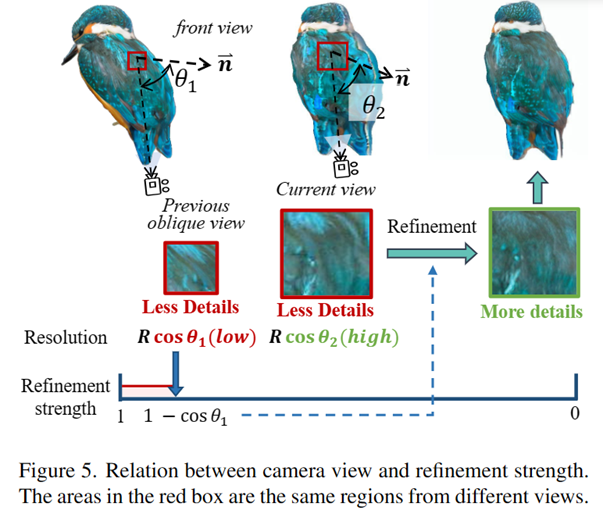

Der Autor schlägt außerdem eine sichtbarkeitsbewusste adaptive Neuzeichnungsintensität vor, um die Qualität des generierten Bildes zu verbessern.

Die qualitativ hochwertigen, konsistenten Bilder mit mehreren Ansichten ermöglichen eine schnelle Generierung von 3D-Inhalten unter Verwendung eines einfachen MSE-Verlusts (Mean Square Error).

Der Autor hat experimentell bewiesen, dass Repaint123 in der Lage ist, in 2 Minuten hochwertige 3D-Inhalte mit Multi-View-Konsistenz und feinen Texturen zu generieren.

Die Hauptbeiträge des Artikels sind wie folgt:

1. Repaint123 berücksichtigt umfassend den kontrollierbaren Neuzeichnungsprozess von Bildern zur 3D-Generierung und kann konsistent hochwertige Bildsequenzen aus mehreren Perspektiven generieren.

2. Repaint123 schlug eine einfache 3D-generierte Basislinie vor. In der Grobmodellphase wurde Zero123 als 3D-Vorhersage und SDS-Verlust verwendet, um die Gaußsche Splatting-Geometrie schnell zu optimieren (1 Minute). Die Diffusion wurde als 2D-Vorhersage verwendet und der SDS-Verlust verfeinert die Netztexturen schnell (1 Minute).

3. Umfangreiche Experimente haben die Wirksamkeit der Repaint123-Methode bestätigt, mit der aus einem einzelnen Bild in nur 2 Minuten 3D-Inhalte generiert werden können, die der Qualität der 2D-Generierung entsprechen.

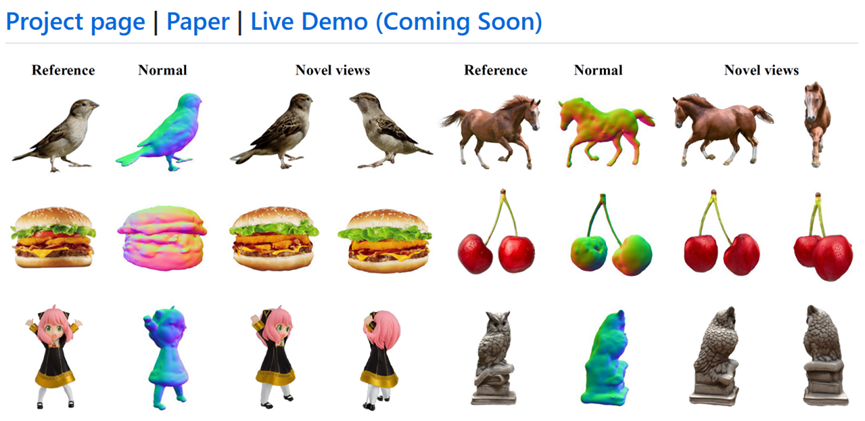

Abbildung 1: Papiermotivation: schnelle, konsistente, hochwertige Einzelansicht-3D-Generierung

Spezifische Methode:

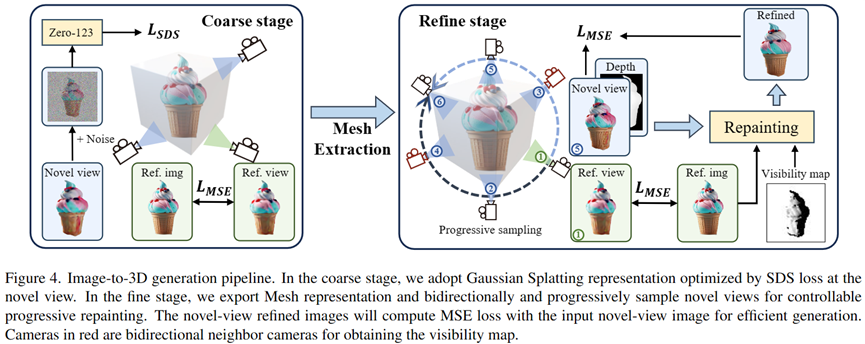

Repaint123 Die Hauptverbesserungen konzentrieren sich auf die Netzverfeinerungsphase, die zwei enthält Teile: Konsistente Generierung hochwertiger Bildsequenzen aus mehreren Perspektiven und schnelle, hochwertige 3D-Rekonstruktion.

In der Rohmodellphase verwendet der Autor 3D-Gaußsches Splatting als 3D-Darstellung, und die Geometrie und Textur des Rohmodells wird durch SDS-Verlust optimiert.

In der Verfeinerungsphase wandelt der Autor das grobe Modell in eine Netzdarstellung um und schlägt ein progressives und kontrollierbares Schema zur Neuzeichnung der Texturverfeinerung vor.

Zuerst zeichnet der Autor mithilfe geometrischer Steuerung und Referenzbildern schrittweise den unsichtbaren Bereich relativ zur zuvor optimierten Ansicht neu, um ein ansichtskonsistentes Bild der neuartigen Ansicht zu erhalten.

Dann übernehmen die Autoren Bildhinweise für eine klassifikatorfreie Führung und entwerfen eine adaptive Neuzeichnungsstrategie, um die Generierungsqualität überlappender Regionen weiter zu verbessern.

Durch die Generierung ansichtskonsistenter Bilder in hoher Qualität nutzen die Autoren schließlich einen einfachen MSE-Verlust, um schnell 3D-Inhalte zu generieren. 🔜 Abbildung 2: Konsistenter Bilderzeugungsprozess aus mehreren Perspektiven zu einem bestimmten latenten Wert für die spätere Entrauschung. Generieren Sie originalgetreue und konsistente Bilder als Grundlage.

Kontrollierbare Rauschunterdrückung

Um die Konsistenz der Geometrie und der Langstreckentextur zu steuern, verwendet der Autor in der Entrauschungsphase ControlNet, um die Tiefenkarte des groben Modellrenderings als geometrische Priorität einzuführen, und fügt die Aufmerksamkeitsfunktion des Referenzbilds für die Textur ein Migration. Gleichzeitig verwendet das Papier CLIP, um das Referenzbild in ein Bildaufforderungs-Entrauschungsnetzwerk zu kodieren, um eine klassifikatorfreie Führung zur Verbesserung der Bildqualität durchzuführen. Okklusionsmaske erhalten Um die Okklusionsmaske Mn aus der neuartigen Ansicht des gerenderten Bildes In und der Tiefenkarte Dn zu erhalten, unter Berücksichtigung der Neuzeichnungsreferenzansicht Vr von Ir und Dr, hat der Autor zuerst Durch die Verwendung der Tiefe Dr zum Skalieren der 2D-Pixel von Vr auf eine 3D-Punktwolke und das anschließende Rendern der 3D-Punktwolke Pr aus der neuen Perspektive Vn wird die Tiefenkarte Dn' erhalten. Der Autor betrachtet den Bereich mit unterschiedlichen Tiefenwerten zwischen den beiden neuartigen Ansichtstiefenkarten (Dn und Dn') als den Okklusionsbereich in der Okklusionsmaske. Progressives Neumalen sowohl von Verdeckungen als auch Überlappungen Um sicherzustellen, dass die überlappenden Bereiche der Bildsequenz und angrenzender Bilder auf Pixelebene ausgerichtet sind, verwendet der Autor eine progressive lokale Neumalstrategie unter Beibehaltung der Überlappung Bereiche unverändert Erzeugen Sie harmonische angrenzende Bereiche usw. aus der Referenzperspektive bis 360°. Wie in Abbildung 3 gezeigt, stellte der Autor jedoch fest, dass auch der überlappende Bereich verfeinert werden muss, da die visuelle Auflösung eines zuvor schielenden Bereichs bei direkter Betrachtung größer wird und mehr Hochfrequenzinformationen hinzugefügt werden müssen . Um die geeignete Ausdünnungsintensität auszuwählen, um die Wiedergabetreue sicherzustellen und gleichzeitig die Qualität zu verbessern, stützt sich der Autor auf das Projektionstheorem und die Idee der Bild-Superauflösung, um eine einfache und direkte sichtbarkeitsbewusste Neuzeichnungsstrategie zur Verfeinerung vorzuschlagen Überlappungsbereich und die Verfeinerungsintensität ist gleich 1-cosθ* (wobei θ* der maximale Winkel zwischen allen vorherigen Kamerawinkeln und dem Normalenvektor der betrachteten Oberfläche ist), wodurch der überlappende Bereich adaptiv neu gezeichnet wird. Abbildung 3: Die Beziehung zwischen Kamerawinkel und Ausdünnungsintensität Schnelle und hochwertige 3D-Rekonstruktion: Wie in Abbildung 4 gezeigt, wendet der Autor zunächst eine zweistufige Methode an Verwenden der Gaußschen Splatting-Darstellung, um schnell eine vernünftige Geometrie und grobe Texturen zu erzeugen. Gleichzeitig konnte der Autor mit der oben generierten konsistenten Bildsequenz hoher Qualität aus mehreren Perspektiven einen einfachen MSE-Verlust für eine schnelle 3D-Texturrekonstruktion verwenden. Abbildung 4: Repaint123 zweistufiges Einzelansicht-3D-Generierungsframework fortschrittlichste Effekte in Bezug auf Qualität und Geschwindigkeit.

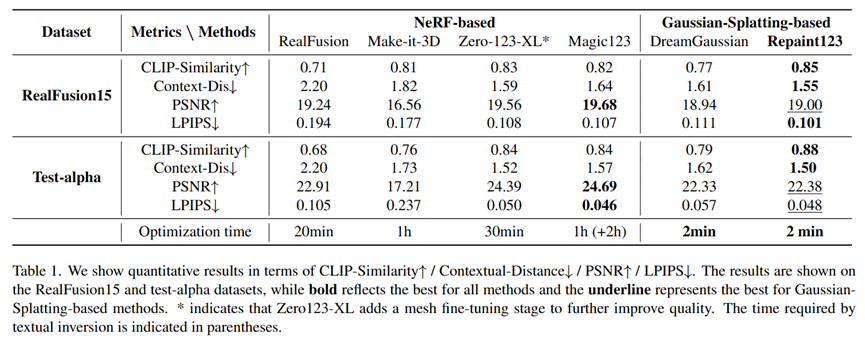

Quantitativer Vergleich der Einzelansicht-3D-Erzeugung

Gleichzeitig , Der Autor verwendete auch Die Wirksamkeit jedes Moduls und das Inkrement der Betrachtungswinkeldrehung waren ablatierte Experimente:

Ablationsexperiment

Ablationsexperiment

Das obige ist der detaillierte Inhalt vonNeue Technologie Repaint123: Generieren Sie effizient hochwertige 3D-Einzelansichten in nur 2 Minuten!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Der Unterschied zwischen has und with im Laravel-Assoziationsmodell (ausführliche Einführung)

- Was ist das CSS-Box-Modell?

- Was ist ein KI-Trainingscluster?

- Was sind die vier gängigen Softwareentwicklungsmodelle?

- NUS und Byte arbeiteten branchenübergreifend zusammen, um durch Modelloptimierung ein 72-mal schnelleres Training zu erreichen, und gewannen den AAAI2023 Outstanding Paper.