Heim >Technologie-Peripheriegeräte >KI >Patentvorschlag von Qualcomm zur Verbesserung der Konfiguration der Objekterkennung und -verfolgung für die AR/VR-Gesteninteraktion

Patentvorschlag von Qualcomm zur Verbesserung der Konfiguration der Objekterkennung und -verfolgung für die AR/VR-Gesteninteraktion

- PHPznach vorne

- 2024-01-05 12:38:14492Durchsuche

Optimierte Objekterkennungs- und Tracking-Konfiguration

(英伟网Nweon 4. Januar 2024) Extended-Reality-Geräte können Zielereignisse oder Objekte über Kameras erkennen, verfolgen und identifizieren. Herkömmliche Trackingsysteme erkennen Benutzergesten möglicherweise nicht korrekt, beispielsweise solche, die mit bloßen Händen des Benutzers ausgeführt werden oder wenn der Benutzer einen Gegenstand hält.

In einer Patentanmeldung mit dem Titel „Objekterkennung und -verfolgung in Geräten mit erweiterter Realität“ schlug Qualcomm eine optimierte Konfiguration für die Objekterkennung und -verfolgung vor.

In einer Ausführungsform kann das Objekterkennungs- und -verfolgungsgerät ein oder mehrere optische Elemente umfassen und ein oder mehrere Objekte oder Körperteile des Benutzers in der virtuellen Umgebung erkennen, um vom Benutzer durchgeführte Eingabegesten zu identifizieren. Geräte zur Objekterkennung und -verfolgung können Objekte im Sichtfeld der Kamera erkennen und feststellen, dass die Objekte einem bestimmten Benutzer entsprechen.

Zum Beispiel kann ein Objekterkennungs- und -verfolgungsgerät feststellen, dass ein Objekt dem Benutzer entspricht und für eine Eingabegeste verwendet wird. Das Objekterkennungs- und -verfolgungsgerät kann zusätzlich oder alternativ feststellen, dass das Objekt nicht dem Benutzer entspricht und daher nicht zur Bereitstellung einer Eingabegeste verwendet wird.

In einer anderen Ausführungsform kann das Objekterkennungs- und -verfolgungsgerät einen oder mehrere Prozessoren umfassen, die in einem Speicher des Objekterkennungs- und -verfolgungsgeräts gespeicherte Anweisungen ausführen, um eine Verfolgung basierend auf der eindeutigen Konturerkennung des Objekts des Benutzers durchzuführen.

Zum Beispiel kann das einzigartige Profil eines Benutzers eine oder mehrere Formen umfassen, die die Hände des Benutzers, Handflächenabdrücke, Handflächenkonturen, die Größe der Nägel des Benutzers, die Form der Nägel des Benutzers, die Farbe des Objekts usw. charakterisieren. Das Objekterkennungs- und -verfolgungsgerät kann Anweisungen zum Verfolgen des Objekts basierend auf dem Profil des Benutzers ausführen, um eine oder mehrere Eingabegesten des Benutzers basierend auf dem Profil des Benutzers zu erkennen.

In einer Ausführungsform kann das Objekterkennungs- und -verfolgungsgerät einen oder mehrere Prozessoren umfassen, und die Prozessoren führen einen oder mehrere trainierte maschinelle Lernprozesse durch, um die zu verfolgenden Objekte des Benutzers zu erkennen und eine oder mehrere Gesten einzugeben.

Zum Beispiel kann das Zielerkennungs- und -verfolgungsgerät während des Initialisierungsprozesses den Benutzer auffordern, ein von der Kamera oder dem Sensor des Zielerkennungs- und -verfolgungsgeräts erkanntes Objekt als Objekt für die Erkennung der Benutzergesteneingabe auszuwählen. Das Objekterkennungs- und -verfolgungsgerät kann den trainierten maschinellen Lernprozess auf die Bilddaten anwenden, die das ausgewählte Objekt charakterisieren, um eine Vielzahl von Datenpunkten des ausgewählten Objekts und ein mehrdimensionales Modell des ausgewählten Objekts zu erzeugen.

Außerdem können Zielerkennungs- und -verfolgungsgeräte trainierte maschinelle Lernprozesse auf mehrdimensionale Modelle von Zielen anwenden, um Aktionspunkte abzuschätzen. In einem Beispiel kann das Objekterkennungs- und -verfolgungsgerät einen Trainingsmodus für einen maschinellen Lernprozess implementieren, in dem der maschinelle Lernprozess den Aktionspunkt im dreidimensionalen Raum der entsprechenden Geste iterativ ändern kann.

Zum Beispiel kann ein Zielerkennungs- und -verfolgungsgerät eine Geste basierend auf den generierten Aktionspunkten bestimmen und vom Benutzer eine Bestätigung anfordern und erhalten, um zu bestätigen, dass die bestimmte Geste korrekt ist.

Ein oder mehrere Prozessoren können einen maschinellen Lernprozess auf das mehrdimensionale Modell des Objekts anwenden, um eine Nachschlagetabelle zu erstellen. Die Nachschlagetabelle kann eine Liste von Gesten und eine Folge von Verfolgungspunkten im dreidimensionalen Raum enthalten, den das Objekt während der Geste überspannen kann. Trackingpunkte können x-, y- und z-Koordinaten jedes Trackingpunkts im dreidimensionalen Raum umfassen.

Wenn der Trainingsprozess abgeschlossen ist, können ein oder mehrere Prozessoren die Werte und Sequenzen von Trackingpunkten und entsprechenden Gesten als Nachschlagetabelle im Speichergerät des Objekterkennungs- und -verfolgungsgeräts speichern. Eine einem Objekt entsprechende Nachschlagetabelle kann es einem oder mehreren Prozessoren ermöglichen, vom Objekt ausgeführte Gesten zu erkennen und zu erkennen, während die Bewegung des Objekts verfolgt wird.

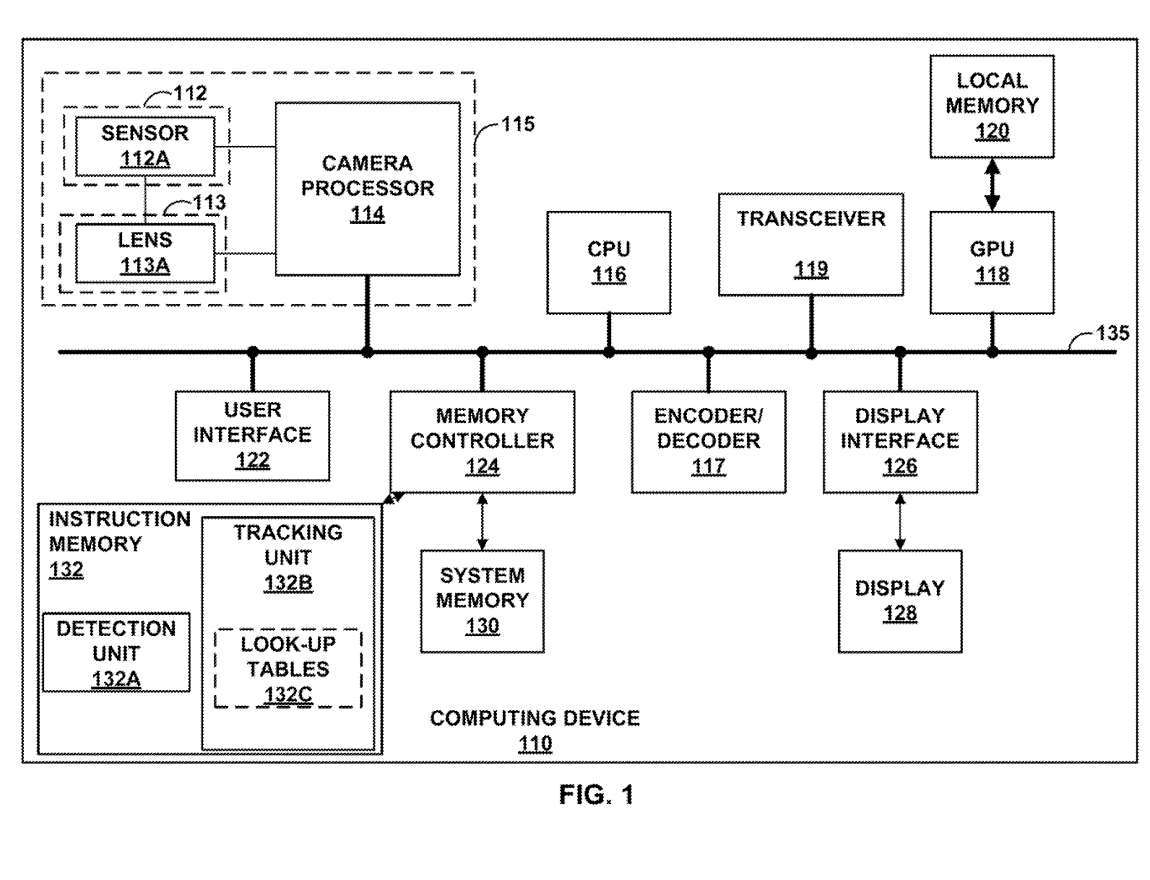

Abbildung 1 ist ein Blockdiagramm eines beispielhaften Zielerkennungs- und -verfolgungsgeräts 100. Wie in der Ausführungsform von FIG. 1 gezeigt, kann das Zielerkennungs- und -verfolgungsgerät 100 einen oder mehrere Bildsensoren 112, wie etwa den Bildsensor 112A, das Objektiv 113A und einen oder mehrere Kameraprozessoren, wie etwa den Kameraprozessor 114, umfassen.

Das Objekterkennungs- und -verfolgungsgerät 100 kann außerdem eine zentrale Verarbeitungseinheit 116, einen Encoder/Decoder 117, eine Grafikverarbeitungseinheit 118, einen lokalen Speicher 120 der GPU 118, eine Benutzerschnittstelle 122 und einen Computer umfassen, der Zugriff auf das System bietet Speicher 130 und Befehlsspeicher 132, Speichercontroller 124 und Anzeigeschnittstelle 126.

Das Objekterkennungs- und -verfolgungsgerät 100 kann Benutzereingaben über die Benutzerschnittstelle 122 empfangen, und als Reaktion auf die empfangene Benutzereingabe kann die CPU 116 und/oder der Kameraprozessor 114 das der CPU 116 und/oder dem Kameraprozessor entsprechende Objektiv aktivieren 114. Beispielsweise kann die empfangene Benutzereingabe einer Bestätigung entsprechen, dass das von der Linse 113A gesehene Objekt/die Hand das Objekt/die Hand des Benutzers ist, das/die für die Eingabegeste verfolgt werden sollte.

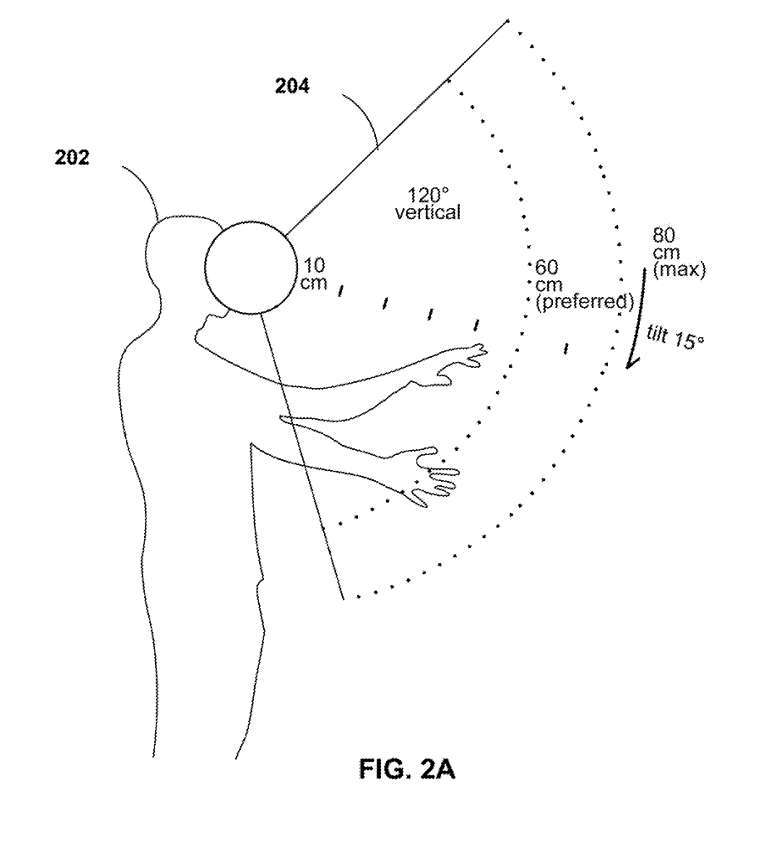

Abbildung 2A zeigt den Tracking-Bereich im XR-System. 2A umfasst Benutzer 202 mit Sichtfeld 204. Wie in Abbildung 2A gezeigt, kann das Sichtfeld 204 des Benutzers 202 eine Winkelausdehnung von 120 Grad haben. Das Sichtfeld 204 kann der Bereich sein, in dem das VR-, AR- oder XR-System Benutzereingabegesten 202 verfolgen kann.

Zum Beispiel kann ein VR-, AR- oder XR-System ein Objekt innerhalb des Sichtfelds 204 verfolgen, nämlich die Hand des Benutzers. Das Sichtfeld 204 kann sich von einem ersten Radius vom Benutzer bis zu einem zweiten Radius vom Benutzer erstrecken. Wie in Abbildung 2A gezeigt, kann sich das Sichtfeld 204 von einem Radius von etwa 10 Zentimetern von den Augen des Benutzers 202 bis zu einem Radius von 60–80 Zentimetern vom Benutzer erstrecken.

Obwohl Abbildung 2A die Hand des Benutzers 202 im Sichtfeld 204 zeigt, können im Sichtfeld 204 mehrere Hände verschiedener Benutzer erscheinen. Das VR-, AR- oder XR-System kann Hände erkennen, die in das Sichtfeld 204 eingeführt werden, bestimmen, ob jede Hand einem entsprechenden Benutzer zugeordnet ist, und kann die Hände verfolgen, die dem entsprechenden Benutzer zugeordnet sind. Beispielsweise kann ein VR-, AR- oder XR-System Eingabegesten jedes Benutzers erkennen.

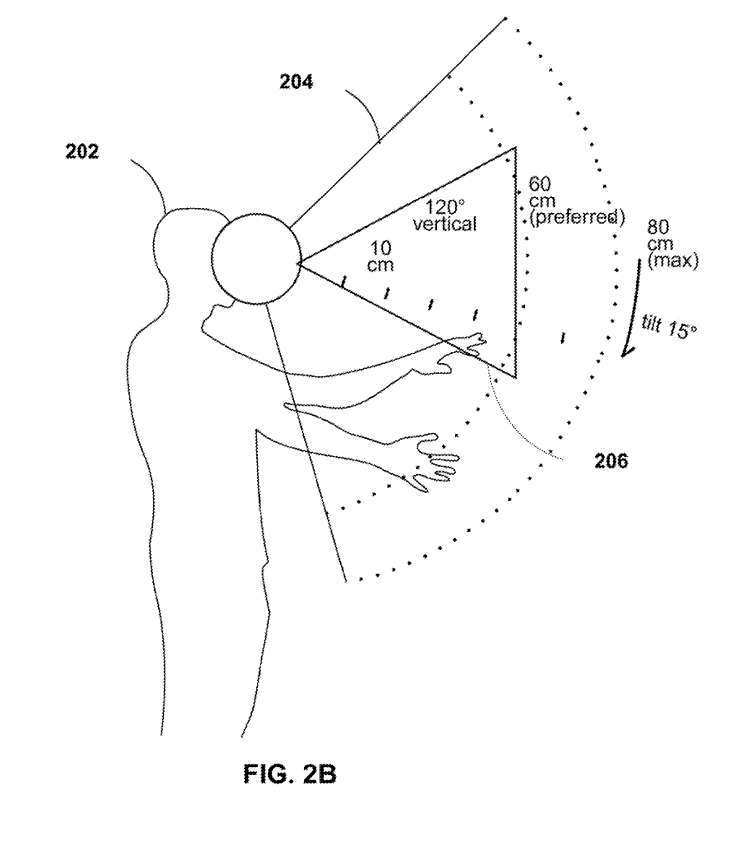

Abbildung 2B zeigt das Sichtfeld 204 des Benutzers mit einem Platzierungsbereich 206, der zur Initialisierung der Zielerkennung und -verfolgung verwendet wird. 2B umfasst einen Benutzer 202 mit einem Sichtfeld 204 und einem Platzierungsbereich 206 innerhalb des Sichtfelds 204.

In einer Ausführungsform kann das Objekterkennungs- und -verfolgungsgerät 100 während der Initialisierung des Objekterkennungs- und -verfolgungsprozesses eine Hervorhebung des Platzierungsbereichs 206 in der virtuellen Umgebung erzeugen und dem Benutzer 202 anzeigen.

Zum Beispiel kann die CPU 116 in der Erkennungseinheit 132A gespeicherte Anweisungen ausführen, um eine Anfrage für den Benutzer 202 zu generieren, ein Objekt in den Platzierungsbereich 206 einzufügen. Die Anzeigeeinheit 208 kann bewirken, dass der Platzierungsbereich 206 im Virtuellen hervorgehoben wird Umgebung und wird dem Benutzer 202 angezeigt. Bei der Initialisierung kann das Objekterkennungs- und -verfolgungsgerät 100 im Platzierungsbereich 206 vorhandene Objekte als zu verfolgende Objekte des Benutzers 202 erkennen, um Eingabegesten des Benutzers 202 zu erkennen.

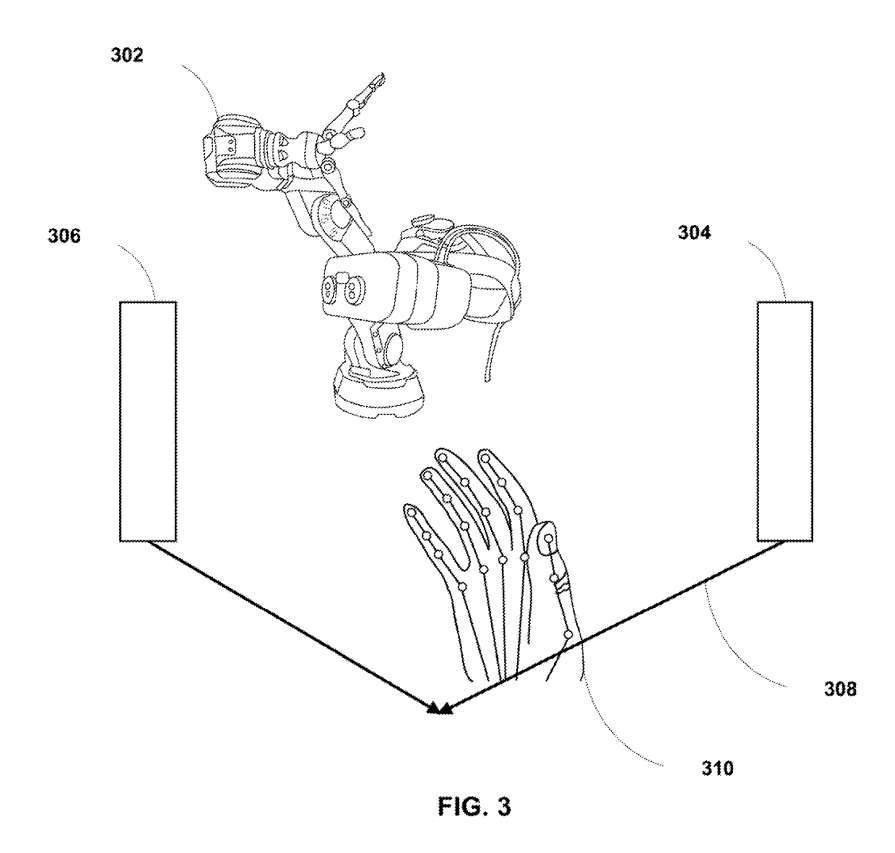

Das Projektionsgerät 302 kann dem Benutzer den Winkel hervorheben, in dem der Benutzer die Hand 310 in den Platzierungsbereich 308 zur Erkennung durch das Objekterkennungs- und -verfolgungsgerät 100 einführen kann. In einem Beispiel kann das Projektionsgerät 302 ein Bild in der virtuellen Umgebung erzeugen und anzeigen, das die Richtung der Einführung in den Platzierungsbereich 308 identifiziert und die Hand 310 erkennt.

In einer Ausführungsform kann das Zielerkennungs- und -verfolgungsgerät 100 bestimmen, ob der Einführwinkel der Hand 310 innerhalb eines vorgegebenen Bereichs liegt, und kann auf der Grundlage der Bestimmung Konturdaten generieren, die die Hand 310 als die Hand des Benutzers identifizieren. Der vorgegebene Bereich kann beispielsweise ein Bereich von Winkelwerten basierend auf dem Sichtfeld des Benutzers 202 sein.

Wenn das Zielerkennungs- und -verfolgungsgerät 100 feststellt, dass der Erkennungseinführwinkel der Hand 310 innerhalb eines vorgegebenen Wertebereichs liegt, kann das Zielerkennungs- und -verfolgungsgerät 100 die Hand 310 als Objekt registrieren, das der Benutzer verfolgen soll. In ähnlicher Weise kann das Objekterkennungs- und -verfolgungsgerät 100 bestimmen, dass die Einführrichtung in den Platzierungsbereich 308 eine geeignete Richtung ist (und das Objekterkennungs- und -verfolgungsgerät 100 kann die Hand 310 als zu verfolgendes Objekt für den Benutzer registrieren.

Als weiteres Beispiel kann das Objekterkennungs- und -verfolgungsgerät 100 feststellen, dass der Einführwinkel der Hand 310 nicht innerhalb eines vorgegebenen numerischen Bereichs liegt, und die Hand 310 möglicherweise nicht dem Benutzer zuordnen. In ähnlicher Weise kann das Objekterkennungs- und -verfolgungsgerät 100 feststellen, dass die Einführrichtung in den Platzierungsbereich 308 keine geeignete Richtung ist, und die Hand 310 möglicherweise nicht mit dem Benutzer in Verbindung bringen.

Auf diese Weise registriert das Objekterkennungs- und -verfolgungsgerät 100 die Hand 310 möglicherweise nicht als zu verfolgendes Objekt. In einer Ausführungsform kann das Objekterkennungs- und -verfolgungsgerät 100 den Benutzer 202 auffordern, in einem vorgeschlagenen Winkel und/oder einer vorgeschlagenen Richtung erneut in die Hand 310 einzudringen.

Zum Beispiel kann das Objekterkennungs- und -verfolgungsgerät 100 durch Projektion innerhalb oder in der Nähe des Platzierungsbereichs 308 visuelle Hinweise liefern, um dem Benutzer 202 den Einführwinkel und/oder die Einführrichtung anzuzeigen, über den der Benutzer 202 dann mit der Hand einführen kann 310 wurde über das XR-System erfolgreich als Hand von Benutzer 202 registriert.

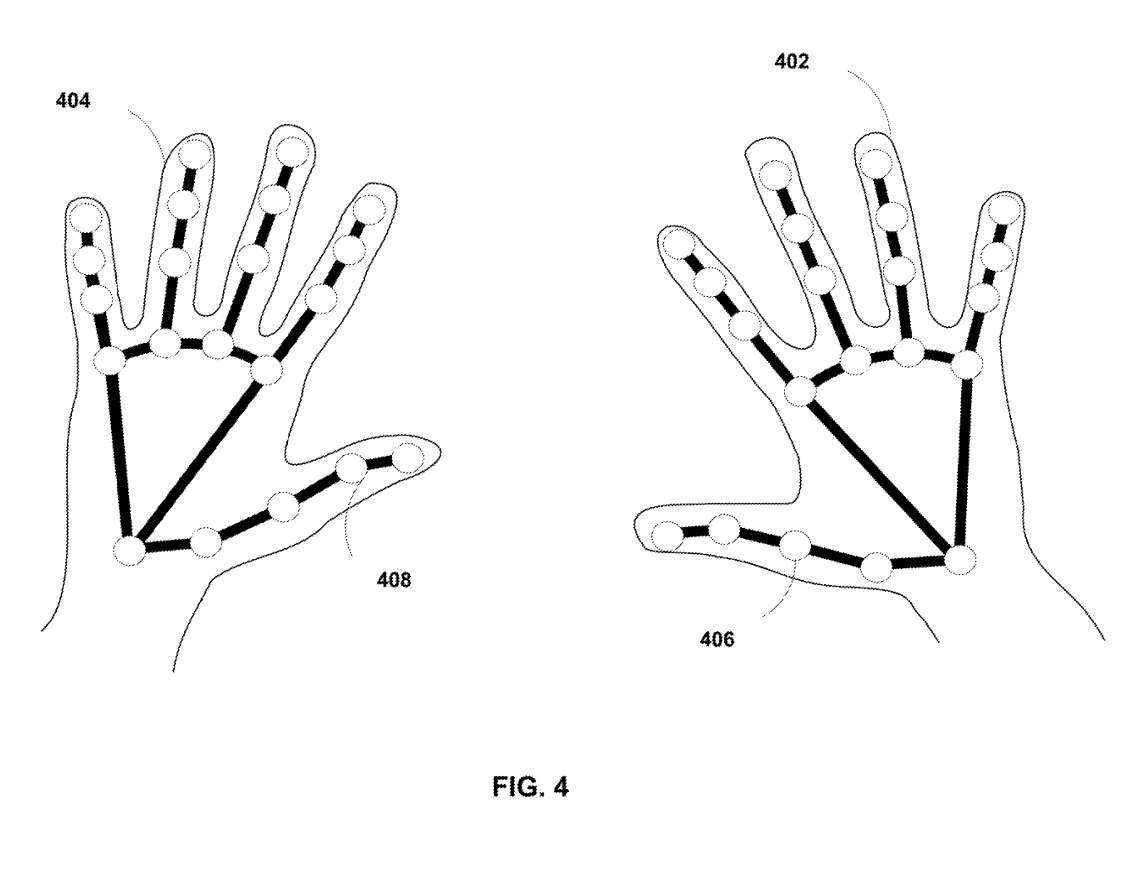

Zum Beispiel kann jeder Orientierungspunkt 406 und 408 eine Menge von Punkten sein, die die Geometrie der Hände 402 bzw. 404 des Benutzers 202 eindeutig beschreiben. Das Objekterkennungs- und -verfolgungsgerät 100 kann die Hände 402 und 404 anhand von Handlinienzeichnungen erkennen und identifizieren.

Das Zielerkennungs- und -verfolgungsgerät 100 kann die Orientierungspunkte 406 und 408 mit einem Satz von Punkten vergleichen, die im Speicher des Zielerkennungs- und -verfolgungsgeräts 100 gespeichert sind. Nach erfolgreicher Erkennung einer Übereinstimmung kann das Objekterkennungs- und -verfolgungsgerät 100 feststellen, dass die in den Platzierungsbereich eingeführte Hand die Hand des Benutzers 202 ist, und das erkannte Objekt als Objekt des Benutzers 202 registrieren und dadurch Eingabegesten von ihm verfolgen und empfangen der Benutzer 202 .

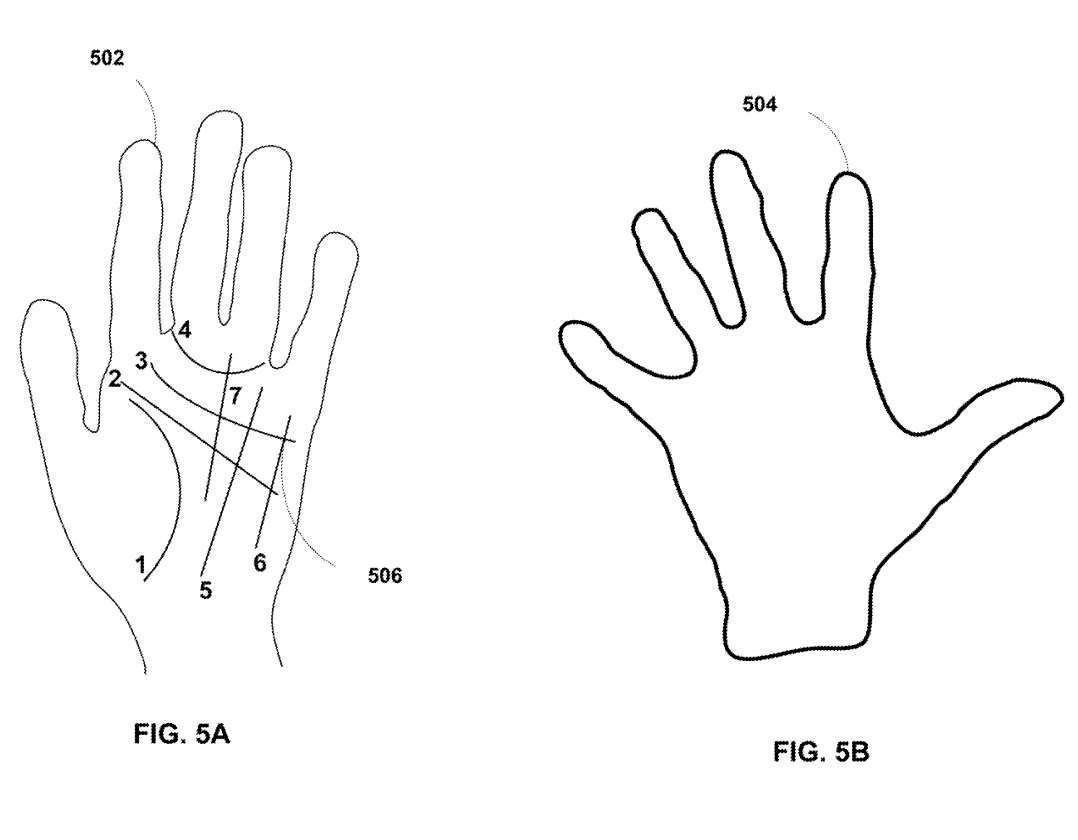

Abbildung 5A zeigt Handflächenlinien, die zur eindeutigen Identifizierung einer Hand verwendet werden können. Wie in Abbildung 5A gezeigt, enthält Abbildung 5A den Handflächenabdruck 506 (Zeilen 1–7). Das Objekterkennungs- und -verfolgungsgerät 100 kann das Objekt mit den in FIG. 5A gezeigten Merkmalen eindeutig identifizieren und erkennen, basierend auf dem Vergleich der Daten, die die Handflächenlinie 506 charakterisieren, mit einem anderen Satz von Daten, die die Handflächenlinie charakterisieren und im Speicher der Objekterkennung gespeichert sind und Ortungsgerät 100. Handflächenlinie.

Nachdem festgestellt wurde, dass die Übereinstimmung erfolgreich war, kann das Zielerkennungs- und -verfolgungsgerät 100 die in den Platzierungsbereich 308 eingeführte Hand als die Hand des Benutzers 202 bestimmen und die Bewegung der Hand verfolgen, beispielsweise die Geste des Benutzers bestimmen Benutzer 202. Das Objekterkennungs- und -verfolgungsgerät 100 ist nicht auf die Verwendung der Handfläche 506 beschränkt, wie oben beschrieben, um eine erfolgreiche Übereinstimmung zu bestimmen.

In einer Ausführungsform kann das Objekterkennungs- und -verfolgungsgerät 100 andere einzigartige Eigenschaften der Hand des Benutzers 202 nutzen, wie etwa Handflächenkontur, Handform, Nagelgröße, Nagelform, Handfarbe usw., um die Hand eindeutig zu identifizieren . für die Hand von Benutzer 202. Nach der Erkennung kann das Objekterkennungs- und -verfolgungsgerät 100 Konturdaten erzeugen, die die Hand als die des Benutzers 202 des XR-Systems registrieren. Das Objekterkennungs- und -verfolgungsgerät 100 kann Handbewegungen verfolgen, um basierend auf den Konturdaten Eingabegesten vom Benutzer 202 zu empfangen.

Abbildung 5B zeigt eine Handflächenkonturkarte, die zur eindeutigen Identifizierung einer Hand verwendet werden kann. Abbildung 5B enthält Handflächenumrissbilddaten 504, wie in Abbildung 5B gezeigt. Die Handflächenprofilbilddaten 504 können auf Bildern basieren, die von der Kamera 115 des Objekterkennungs- und -verfolgungsgeräts 100 erfasst wurden. Das Objekterkennungs- und -verfolgungsgerät 100 kann eine Hand mit einem Handflächenprofil, das durch Handflächenprofilbilddaten 504 dargestellt wird, eindeutig identifizieren und erkennen.

Zum Beispiel kann das Zielerkennungs- und -verfolgungsgerät 100 die Bilddaten 504 des Handflächenprofils mit den Handflächenprofildaten vergleichen, die im Speicher des oben beschriebenen Zielerkennungs- und -verfolgungsgeräts 100 gespeichert sind, um zu bestimmen, ob das Handflächenprofil übereinstimmt.

In einer Ausführungsform speichert der Systemspeicher 132 Handflächenprofildaten für mehrere Benutzer. Handflächenkonturdaten können mehrere Pixelpositionen entlang der im Bild erfassten Handkonturen identifizieren und charakterisieren. Das Objekterkennungs- und -verfolgungsgerät 100 kann Vorgänge durchführen, um zu bestimmen, ob irgendwelche Handflächenprofildaten für den Benutzer mit dem Profil der Handflächenprofilbilddaten 504 übereinstimmen, um den Benutzer zu identifizieren.

Nachdem festgestellt wurde, dass die Übereinstimmung erfolgreich war, kann das Zielerkennungs- und -verfolgungsgerät 100 die in den Platzierungsbereich 308 eingeführte Hand als die Hand des Benutzers 202 bestimmen und die Handgeste als Eingabegeste des Benutzers 202 erkennen und verfolgen .

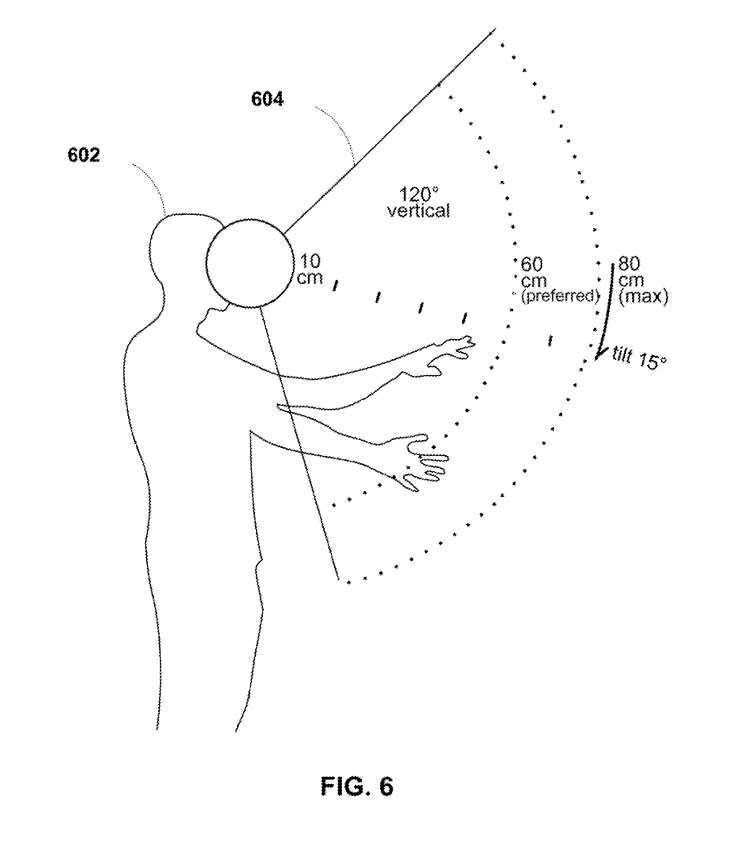

Abbildung 6 zeigt die Tracking-Technologie im XR-System. Abbildung 6 zeigt den Benutzer 602 mit Sichtfeld 604. Das Sichtfeld 604 des Benutzers 602 kann eine Winkelausdehnung von mehreren Grad haben, beispielsweise 120 Grad, wie in Fig. 6 gezeigt. Typischerweise kann das Sichtfeld 604 ein Bereich in einer realen Umgebung sein, in dem ein VR-, AR- oder XR-System die Eingabegesten des Benutzers 602 verfolgen kann.

Wie in Abbildung 6 gezeigt, kann sich das Sichtfeld 604 von einem Radius von etwa 10 cm von den Augen 602 des Benutzers bis zu einem Radius im Bereich von 60–80 cm vom Benutzer erstrecken.

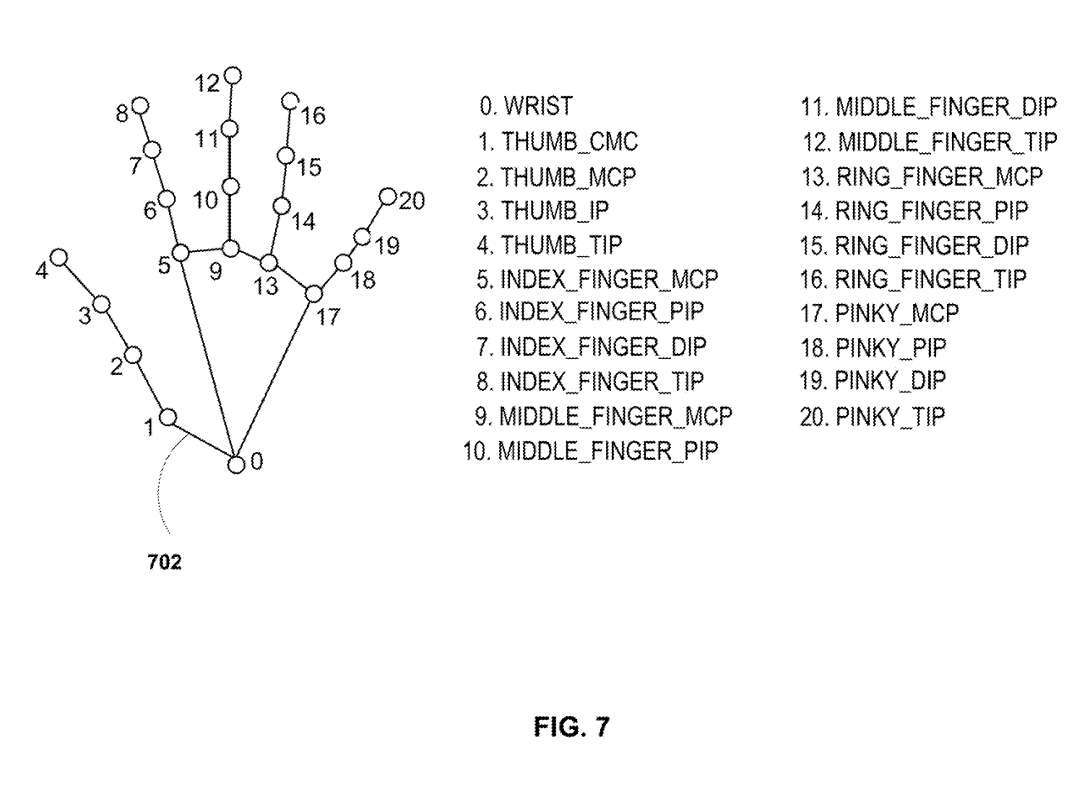

Abbildung 7 zeigt ein Hand-Tracking-Diagramm mit 20 verschiedenen Punkten der Hand. Darin wird jeder der 20 Punkte durch seine spezifische Position auf der gemeinsamen Hand beschrieben. Wenn die Hand des Benutzers jedoch eine unregelmäßige Form hat, beispielsweise vier statt fünf Finger, oder wenn der Benutzer eine Bedeckung an der Hand hat, ist möglicherweise nicht jeder der 20 in Abbildung 7A gezeigten Punkte vorhanden oder kann nicht identifiziert werden.

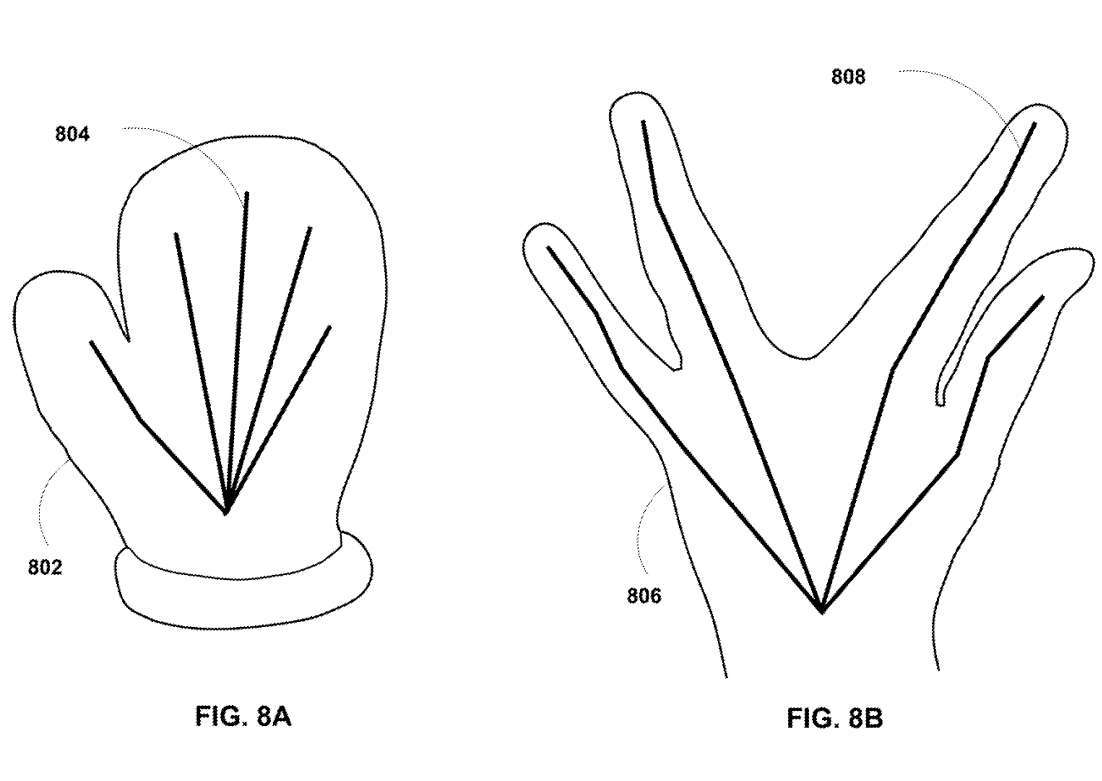

Abbildung 8A ist beispielsweise ein schematisches Diagramm, das eine Hand mit einer Abdeckung zeigt. Abbildung 8A umfasst eine Hand 802 mit einem Fäustling, der die Hand bedeckt, und einen Umriss 804, der die Form der Hand 802 darstellt.

Im Vergleich zu Abbildung 7 kann das 20-Punkte-Modell, das zum Erkennen und Erkennen der Hand des Benutzers verwendet wird, möglicherweise nicht zum Erkennen oder Verfolgen der Bewegung der Hand 802 verwendet werden, die zum Erkennen der Eingabegeste verwendet wird, zumindest weil die Hand 802 nicht zugeordnet werden kann alle 20 Punkte, oder auf eine ausreichende Anzahl von Punkten abbilden, um die Hand 802 mithilfe der 20-Punkte-Technik zu erkennen und zu verfolgen.

Abbildung 8B ist ein schematisches Diagramm, das eine Hand mit unregelmäßiger Form zeigt. 8B umfasst eine Hand 806 mit einer unregelmäßigen Form (z. B. ohne Mittelfinger), wobei der Umriss 808 die Form der Hand 806 beschreibt. Im Gegensatz zu Abbildung 7 kann das 20-Punkte-Modell, das zum Identifizieren und Erkennen der Hand des Benutzers verwendet wird, möglicherweise nicht zum Erkennen oder Verfolgen der Bewegung der Hand 806 verwendet werden, die zum Erkennen der Eingabegeste verwendet wird, zumindest weil die Hand 802 möglicherweise nicht kartiert wird auf alle 20 Punkte oder auf eine ausreichende Anzahl von Punkten abbilden, um die Hand 802 mithilfe der 20-Punkte-Technik zu erkennen und zu verfolgen.

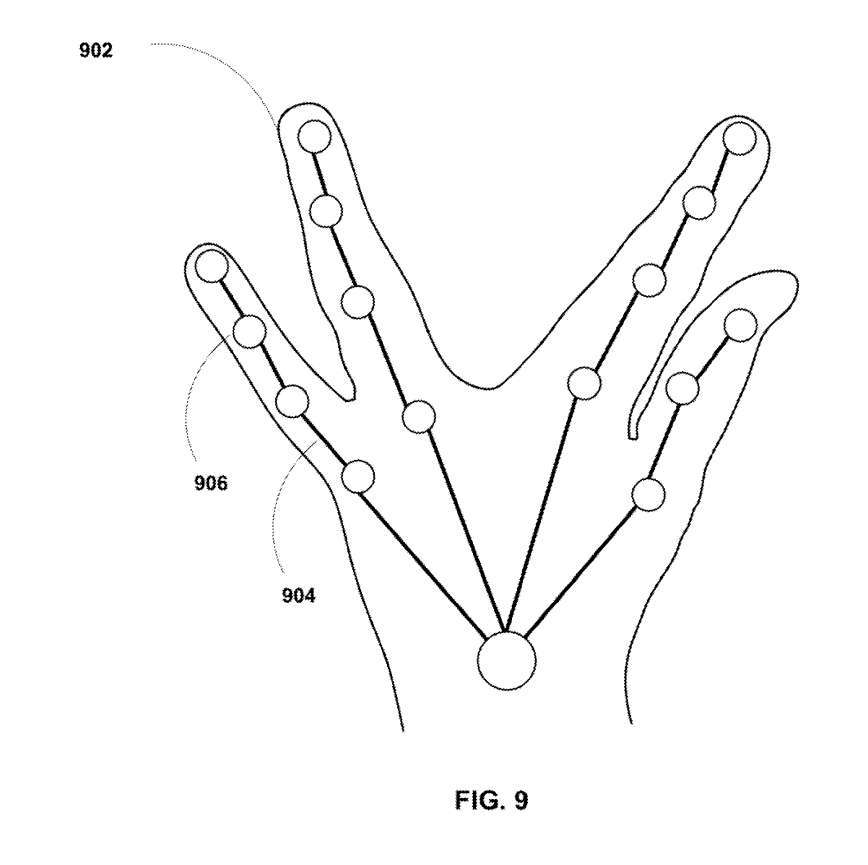

Die in Abbildung 9 gezeigte Initialisierungs-Starttechnik kann es dem Objekterkennungs- und -verfolgungsgerät 100 jedoch ermöglichen, unerwartete Formen und Größen von Objekten zu erkennen.

Konkret zeigt Abbildung 9 eine Handverfolgungstechnik zum Verfolgen von Händen mit unerwarteten oder unregelmäßigen Formen. Abbildung 9 umfasst die Hand 902 mit Konturlinien 904. Nach der Erkennung einer bedeckten Hand (oder einer Hand mit unregelmäßiger Form) kann das Objekterkennungs- und -verfolgungsgerät 100 basierend auf dem Bild der Hand 902 mehrere Datenpunkte 906 für die Hand 902 generieren.

Das Objekterkennungs- und -verfolgungsgerät 100 kann ein mehrdimensionales Modell der Hand 902 basierend auf mehreren Datenpunkten 906 generieren. Beispielsweise kann das Objekterkennungs- und -verfolgungsgerät 100 ein oder mehrere Bilder der Hand 902 in einer realen Umgebung einer Hybridumgebung eines XR-Systems erfassen und die Datenpunkte 906 im dreidimensionalen Raum darstellen, um ein mehrdimensionales Modell zu erzeugen der Hand 902 .

Das mehrdimensionale Modell kann ein 3D-Modell der Hand 902 sein. Das Objekterkennungs- und -verfolgungsgerät 100 kann auch mehrere Aktionspunkte basierend auf dem mehrdimensionalen Modell der Hand 902 und der erkannten Geste generieren. Das Objekterkennungs- und -verfolgungsgerät 100 kann außerdem mehrere Verfolgungspunkte bestimmen.

Der Tracking-Punkt kann ein Punkt im dreidimensionalen Raum sein, den die Hand 902 voraussichtlich überspannen wird, wenn sie die Geste ausführt, und der Tracking-Punkt kann in einer für die Hand 902 spezifischen Nachschlagetabelle gespeichert werden. Jede Folge von Tracking-Punkten in der Nachschlagetabelle kann einer Geste entsprechen. Während sich die Hand 902 im dreidimensionalen Raum bewegt, kann das Objekterkennungs- und -verfolgungsgerät 100 die Geste der Hand 902 mithilfe einer Nachschlagetabelle bestimmen.

Verwandte Patente: Qualcomm-Patent |. Objekterkennung und -verfolgung in Extended-Reality-Geräten

https://patent.nweon.com/32609

Die Qualcomm-Patentanmeldung mit dem Titel „Objekterkennung und -verfolgung in Geräten mit erweiterter Realität“ wurde ursprünglich im Juni 2022 eingereicht und kürzlich vom US-Patent- und Markenamt veröffentlicht.

Es ist zu beachten, dass eine US-Patentanmeldung im Allgemeinen nach der Prüfung automatisch 18 Monate nach dem Anmeldetag oder Prioritätsdatum veröffentlicht wird oder auf Antrag des Patentinhabers innerhalb von 18 Monaten nach dem Anmeldetag veröffentlicht wird Antragsteller. Beachten Sie, dass die Veröffentlichung einer Patentanmeldung nicht bedeutet, dass das Patent genehmigt wird. Nachdem eine Patentanmeldung eingereicht wurde, verlangt das USPTO eine tatsächliche Prüfung, die zwischen einem und drei Jahren dauern kann.

Darüber hinaus handelt es sich lediglich um eine Patentanmeldung, was nicht bedeutet, dass sie genehmigt wird. Gleichzeitig ist nicht sicher, ob sie tatsächlich kommerzialisiert wird und welche tatsächliche Anwendungswirkung sie hat.

---

Originallink: https://news.nweon.com/116552

Das obige ist der detaillierte Inhalt vonPatentvorschlag von Qualcomm zur Verbesserung der Konfiguration der Objekterkennung und -verfolgung für die AR/VR-Gesteninteraktion. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr