Heim >Technologie-Peripheriegeräte >KI >Realistisch, steuerbar und skalierbar: Die Beleuchtungssimulationsplattform für autonomes Fahren LightSim wird neu eingeführt

Realistisch, steuerbar und skalierbar: Die Beleuchtungssimulationsplattform für autonomes Fahren LightSim wird neu eingeführt

- 王林nach vorne

- 2023-12-15 15:09:482512Durchsuche

Kürzlich haben Forscher von Waabi AI, der University of Toronto, der University of Waterloo und dem MIT auf der NeurIPS 2023 eine neue Beleuchtungssimulationsplattform für autonomes Fahren, LightSim, vorgeschlagen. Die Forscher schlugen eine Methode vor, um gepaarte Beleuchtungstrainingsdaten aus realen Daten zu generieren und so die Probleme fehlender Daten und Modellmigrationsverluste zu lösen. LightSim nutzt neuronale Strahlungsfelder (NeRF) und physikbasierte tiefe Netzwerke, um Fahrvideos von Fahrzeugen zu rendern und so erstmals eine Beleuchtungssimulation dynamischer Szenen auf großen realen Daten zu erreichen

- Projektwebsite: https: //waabi .ai/lightsim

- Papierlink: https://openreview.net/pdf?id=mcx8IGneYw

Warum ist eine Beleuchtungssimulation für autonomes Fahren erforderlich?

In der Robotik ist die Kamerasimulation sehr wichtig, insbesondere für autonome Fahrzeuge zur Wahrnehmung von Außenszenen. Bestehende Kamerawahrnehmungssysteme funktionieren jedoch schlecht, wenn sie auf ungeschulte Lichtverhältnisse im Freien stoßen. Durch die Verwendung einer Kamerasimulation zur Generierung verschiedener Datensätze zur Änderung der Außenbeleuchtung kann die Stabilität des autonomen Fahrsystems verbessert werden. Gängige Kamerasimulationsmethoden basieren im Allgemeinen auf Physik-Engines. Diese Methode rendert die Szene durch Festlegen des 3D-Modells und der Lichtbedingungen. Allerdings mangelt es Simulationseffekten oft an Diversität und sie sind nicht realistisch genug. Darüber hinaus stimmen die physischen Rendering-Ergebnisse aufgrund der begrenzten Anzahl hochwertiger 3D-Modelle nicht genau mit den realen Szenen überein. Dies führt zu einer schlechten Generalisierungsfähigkeit des trainierten Modells auf reale Daten.

Eine andere Methode basiert auf einer datengesteuerten Simulationsmethode. Dieser Ansatz nutzt neuronale Rendering-Technologie, um einen digitalen Zwilling der realen Welt zu rekonstruieren, um die von den Sensoren beobachteten Daten zu reproduzieren. Auf diese Weise können wir Szenen flexibler und realistischer gestalten. Die aktuelle Technologie bettet jedoch die Beleuchtungsinformationen der Szene in das 3D-Modell ein, was die Bearbeitung des digitalen Zwillings einschränkt, z. B. das Ändern der Lichtverhältnisse oder das Hinzufügen oder Löschen von Objekten. In einer Arbeit bei NeurIPS 2023 demonstrierten Forscher von Waabi AI a Beleuchtungssimulationssystem LightSim basierend auf einer Physik-Engine und einem neuronalen Netzwerk: Neuronale Beleuchtungssimulation für städtische Szenen : Zum ersten Mal kann es die Beleuchtung großer dynamischer Außenszenen simulieren und Schatten, Lichteffekte zwischen Objekten usw. genauer simulieren.

2.

Steuerbar: Unterstützt die Bearbeitung dynamischer Fahrszenen (Hinzufügen, Löschen von Objekten, Kamerapositionen und -parametern, Ändern der Beleuchtung, Generieren sicherheitskritischer Szenen usw.) und generiert so realistischere und konsistentere Videos zur Verbesserung die Robustheit des Systems gegenüber Licht- und Randbedingungen.

3. Skalierbar

Skalierbar

Aufbau eines Simulationssystems

Schritt 1: Erstellen Sie einen wiederbeleuchtbaren digitalen Zwilling für die reale Welt

Um autonome Fahrszenen in der digitalen Welt nachzubilden, zunächst LightSim beginnt mit Die gesammelten Daten werden in dynamische Objekte und statische Szenen unterteilt. In diesem Schritt wird UniSim verwendet, um die Szene zu rekonstruieren und die Abhängigkeit von der Kameraansicht im Netzwerk zu beseitigen. Verwenden Sie dann den Marschwürfel, um die Geometrie zu erhalten, und wandeln Sie sie weiter in ein Netz mit Grundmaterialien um.

Zusätzlich zu Materialien und Geometrie kann LightSim auch die Außenbeleuchtung anhand von Sonne und Himmel, den Hauptlichtquellen von Tagesszenen im Freien, schätzen und eine Umgebungskarte mit hohem Dynamikbereich (HDR Sky Dome) erhalten. Anhand von Sensordaten und extrahierter Geometrie kann LightSim ein unvollständiges Panoramabild schätzen und es dann vervollständigen, um eine vollständige 360°-Ansicht des Himmels zu erhalten. Dieses Panoramabild und die GPS-Informationen werden dann verwendet, um eine HDR-Umgebungskarte zu erstellen, die die Sonnenintensität, die Sonnenrichtung und das Erscheinungsbild des Himmels genau einschätzt.

Zusammenfassung: Der zweite Schritt besteht darin, eine neuronale Beleuchtungssimulation dynamischer Stadtszenen durchzuführen.

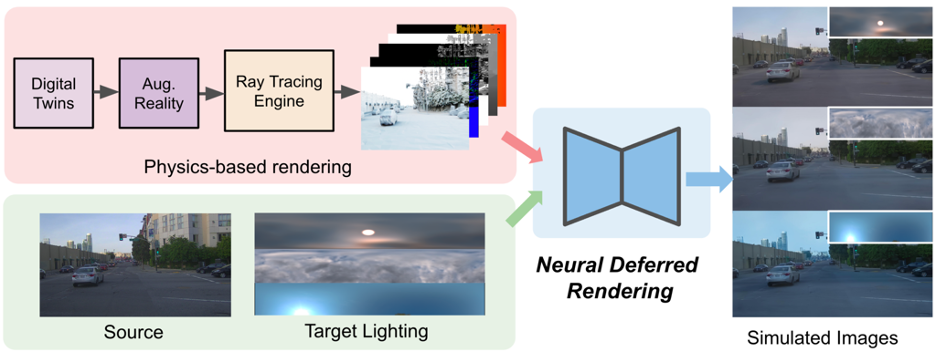

Nach Erhalt des digitalen Zwillings kann er weiter geändert werden, z. B. durch Hinzufügen oder Entfernen Objekte, ändern Sie die Flugbahn von Fahrzeugen oder ändern Sie die Beleuchtung usw., um Augmented-Reality-Darstellungen zu erzeugen. LightSim führt ein physikalisch basiertes Rendering durch und generiert beleuchtungsbezogene Daten wie Grundfarbe, Tiefe, Normalenvektoren und Schatten zur Modifizierung der Szene. Unter Verwendung dieser beleuchtungsbezogenen Daten und einer Schätzung der Quell- und Zielbeleuchtungsbedingungen der Szene sieht der LightSim-Workflow wie folgt aus.

Obwohl physikalisch basierte gerenderte Bilder die Lichteffekte in einer Szene gut rekonstruieren können, mangelt es den Rendering-Ergebnissen aufgrund von Unvollkommenheiten in der Geometrie und Fehlern in der Material-/Lichtzerlegung häufig an Realismus, wie z. B. Unschärfe und unrealistischen Oberflächenreflexionen und Grenzartefakte. Daher schlagen Forscher ein neuronales verzögertes Rendering für einen verbesserten Realismus vor. Sie führten ein Bildsynthesenetzwerk ein, das das endgültige Bild anhand von Quellbildern in einem vorberechneten Puffer und von der Rendering-Engine generierten beleuchtungsbezogenen Daten generiert. Gleichzeitig stellt die Methode im Papier dem Netzwerk auch eine Umgebungskarte zur Verbesserung des Beleuchtungskontexts zur Verfügung und generiert gepaarte Bilder über den digitalen Zwilling, wodurch ein neuartiges paarweises Simulations- und Echtdaten-Trainingsschema bereitgestellt wird

Simulationsfunktionen Demonstrieren

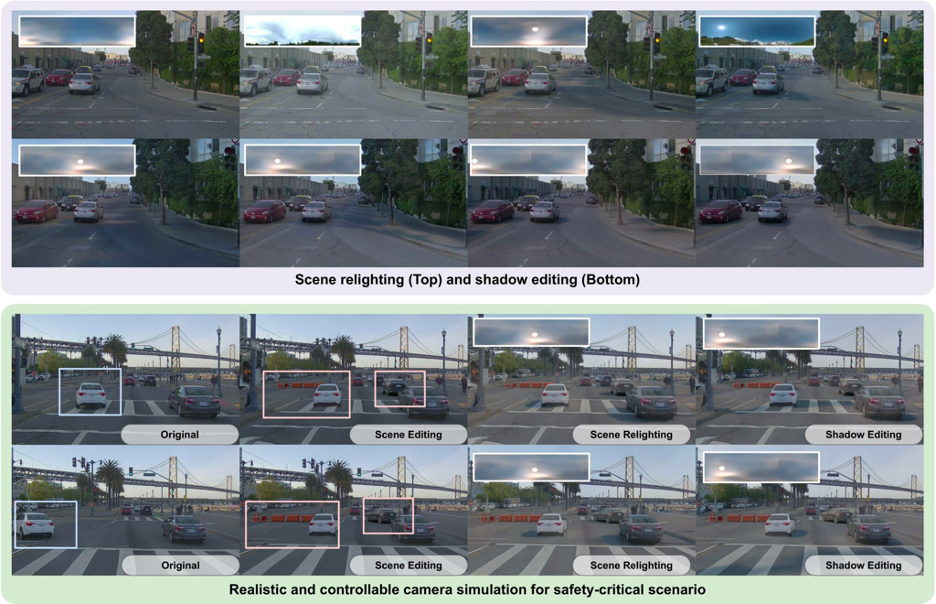

Ändernde Szenenbeleuchtung (Scene Relighting)

LightSim kann dieselbe Szene zeitkonsistent unter neuen Lichtbedingungen rendern. Wie im Video gezeigt, führen der neue Sonnenstand und das Erscheinungsbild des Himmels dazu, dass sich die Schatten und das Erscheinungsbild der Szene ändern.

LightSim kann Szenen automatisch stapelweise neu beleuchten. Es kann neue, zeitkonsistente, 3D-bewusste Beleuchtungsänderungen aus geschätzten und realen HDR-Umgebungskarten generieren, die mit der Originalszene identisch sind. Die Darstellung ist editierbar und die Richtung der Sonne kann geändert werden, wodurch Beleuchtungsänderungen und Schatten aktualisiert werden zur Richtung des Sonnenlichts. Durch Drehen der HDR-Umgebungskarte und Übergeben an das neuronale verzögerte Rendering-Modul generiert LightSim das folgende Video:

LightSim unterstützt auch die Stapelbearbeitung von Schatten Lighting-Aware Character Insertion

In Zusätzlich zur Änderung der Beleuchtung kann LightSim auch beleuchtungsbezogene Ergänzungen an ungewöhnlichen Objekten wie architektonischen Hindernissen vornehmen. Diese hinzugefügten Objekte können die Beleuchtungsschatten des Objekts aktualisieren, Objekte genau verdecken und sich räumlich an die gesamte Kamerakonfiguration anpassen.

Simulationsübertragung (Verallgemeinerung auf nuScenes)

Da das neuronale Deferred-Rendering-Netzwerk von LightSim auf mehrere Fahrvideos trainiert wird, kann LightSim auf neue Szenen verallgemeinert werden. Das folgende Video demonstriert die Generalisierungsfunktionen von LightSim für Fahrszenen in nuScenes. LightSim kann einen beleuchtungsbewussten digitalen Zwilling jeder Szene erstellen, der dann auf ein auf PandaSet vorab trainiertes neuronales verzögertes Rendering-Modell angewendet wird. LightSim verfügt über eine gute Migrationsleistung und kann eine robustere Lösung für die erneute Beleuchtung von Szenen bieten. Das folgende Video demonstriert die Szenensimulationsfunktionen von LightSim. Im Video führte ein weißes Auto einen Notspurwechsel auf die SDV-Spur durch und führte zu einer neuen Straßensperre, wodurch das weiße Auto in eine völlig neue Szene einfuhr. Die von LightSim unter verschiedenen Lichtverhältnissen in der neuen Szene erzeugten Effekte sind wie folgt : .

Im Video unten wird ein neues Beispiel demonstriert. In bestehende Straßenhindernisse wurden neue Hindernisse eingefügt und eine neue Gruppe von Fahrzeugen hinzugefügt. Durch die Verwendung von LightSim zur simulierten Beleuchtung können neu hinzugefügte Fahrzeuge perfekt in die Szene integriert werden. Es kann einen beleuchtungsbewussten digitalen Zwilling auf der Grundlage realer Daten erstellen und ihn modifizieren, um neue Szenen mit unterschiedlichen Objektlayouts und autonomen Fahrzeugperspektiven zu erstellen. LightSim ist in der Lage, neue Lichtverhältnisse zu simulieren und ermöglicht so vielfältige, realistische und steuerbare Kamerasimulationen zur Erstellung zeitlich/räumlich konsistenter Videos. Es ist erwähnenswert, dass LightSim auch mit Reverse Rendering, Wettersimulation und anderen Technologien kombiniert werden kann, um die Simulationsleistung weiter zu verbessern

Das obige ist der detaillierte Inhalt vonRealistisch, steuerbar und skalierbar: Die Beleuchtungssimulationsplattform für autonomes Fahren LightSim wird neu eingeführt. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Detaillierte Erläuterung der Verwendung des Orbit Controls-Plug-Ins (Orbit Control) durch Three.js zur Steuerung der Modellinteraktion

- Das CSS-Box-Modell verstehen: In 5 Minuten verstehen, was das CSS-Box-Modell ist?

- Was sind die Schichten des TCP/IP-Referenzmodells?

- NUS und Byte arbeiteten branchenübergreifend zusammen, um durch Modelloptimierung ein 72-mal schnelleres Training zu erreichen, und gewannen den AAAI2023 Outstanding Paper.

- Nutzen Sie die Vision, um zu motivieren! Shen Xiangyang stellte das neue Modell des IDEA Research Institute vor, das weder Schulung noch Feinabstimmung erfordert und sofort einsatzbereit ist.