Heim >Technologie-Peripheriegeräte >KI >Amazon ist bestrebt, seinen Cloud-Status zu verteidigen, aktualisiert seine selbst entwickelten KI-Chips, veröffentlicht den Chat-Roboter Q und ist das erste Unternehmen, das Nvidias Superchip der neuen Generation einsetzt

Amazon ist bestrebt, seinen Cloud-Status zu verteidigen, aktualisiert seine selbst entwickelten KI-Chips, veröffentlicht den Chat-Roboter Q und ist das erste Unternehmen, das Nvidias Superchip der neuen Generation einsetzt

- 王林nach vorne

- 2023-11-29 08:37:481256Durchsuche

Amazon unternimmt alle Anstrengungen, um seine Führungsposition im Cloud Computing zu verteidigen. Einerseits rüsteten sie ihre eigenen Cloud-Chips auf und brachten Amazons Version von GPT auf den Markt, einen Chatbot für künstliche Intelligenz. Andererseits vertieften sie auch ihre Zusammenarbeit mit NVIDIA, führten neue Dienste auf Basis von NVIDIA-Chips ein und entwickelten diese gemeinsam mit NVIDIA Supercomputer

Dave Brown, Vizepräsident von AWS, sagte, dass AWS ihnen durch die Fokussierung des Designs selbst entwickelter Chips auf tatsächliche Arbeitslasten, die für Kunden wichtig sind, die fortschrittlichste Cloud-Infrastruktur bieten kann. Der dieses Mal auf den Markt gebrachte Graviton 4 ist das Chipprodukt der vierten Generation innerhalb von fünf Jahren. Da das Interesse der Menschen an generativer KI zunimmt, wird der KI-Chip Trainium 2 den Kunden dabei helfen, sich schneller, zu geringeren Kosten und mit höherer Energieeffizienz zu trainieren.

Die Rechenleistung von Graviton4 ist im Vergleich zur Vorgängergeneration um bis zu 30 % verbessert

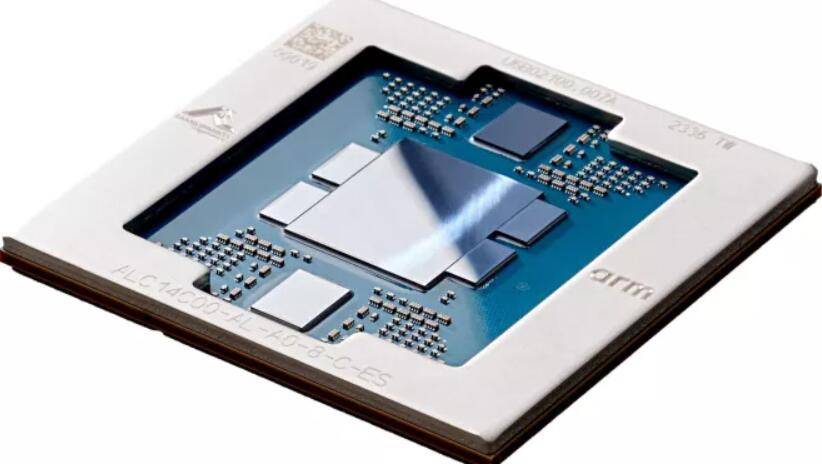

Am Dienstag, den 28. November, Eastern Time, kündigte Amazons Cloud-Computing-Unternehmen AWS die Einführung einer neuen Generation selbst entwickelter AWS-Chips an. Unter anderem ist die Rechenleistung des Allzweckchips Graviton4 bis zu 30 % höher als die der Vorgängergeneration Graviton3, der Kern ist um 50 % vergrößert und die Speicherbandbreite ist um 75 % erhöht, wodurch die höchste Kostenleistung erzielt wird Energienutzung auf dem Amazon Cloud-Server-Hosting-Dienst Amazon Elastic Compute Cloud (EC2) Effekt.

Graviton4 verbessert die Sicherheit durch die vollständige Verschlüsselung aller physischen Hochgeschwindigkeits-Hardwareschnittstellen. Laut AWS wird Graviton4 auf speicheroptimierten Amazon EC2 R8g-Instanzen verfügbar sein, um Kunden dabei zu helfen, die Ausführung von Hochleistungsdatenbanken, In-Memory-Cache und Big-Data-Analyse-Workloads zu verbessern. R8g-Instanzen bieten größere Instanzgrößen mit bis zu dreimal mehr vCPUs und dreimal mehr Speicher als R7g-Instanzen der vorherigen Generation

In den nächsten Monaten planen wir die Einführung von Computern, die mit Graitons4 ausgestattet sind. Laut AWS wurden in den fünf Jahren seit dem Start des Projekts Garviton mehr als 2 Millionen Garviton-Prozessoren produziert und die ersten 100 Benutzer von AWS EC2 haben sich für die Verwendung von Graviton entschieden

Trainium2 ist viermal schneller und kann Modelle mit Billionen von Parametern trainieren

AWS hat einen KI-Chip der neuen Generation namens Trainium2 auf den Markt gebracht, der viermal schneller ist als der Trainium1 der vorherigen Generation. Trainium2 kann bis zu 100.000 Chips im EC2 UltraCluster bereitstellen, sodass Benutzer in kurzer Zeit Basismodelle (PM) und große Sprachmodelle (LLM) mit Billionen von Parametern trainieren können. Im Vergleich zur Vorgängergeneration wurde die Energienutzung von Trainium2 verdoppelt

Trainium2 wird auf Amazon EC2 Trn2-Instanzen verwendet, die jeweils 16 Trainium-Chips enthalten. Trn2-Instanzen sollen Kunden dabei helfen, die Anzahl der Chipanwendungen im EC2 UltraCluster der nächsten Generation auf bis zu 100.000 Trainium2-Chips zu skalieren und bis zu 65 Rechenleistung über Netzwerkverbindungen im Petabyte-Bereich über AWS Elastic Fabrication Adapters (EFA) auszuführen

Laut AWS wird Trainium2 ab dem nächsten Jahr zur Unterstützung neuer Dienste eingesetzt

Der erste Großkunde DGX Cloud nutzt die aktualisierte Version von Grace Hopper GH200 NVL32, diese GPU treibt den schnellsten KI-Supercomputer an

Während der Jahreskonferenz re:Invent gaben AWS und NVIDIA am Dienstag eine erweiterte strategische Zusammenarbeit bekannt, um modernste Infrastruktur, Software und Dienste bereitzustellen, um die generative KI-Innovation der Kunden zu fördern. Bei dieser Kooperation geht es nicht nur um selbst entwickelte Chips, sondern auch um Kooperationen in anderen Bereichen

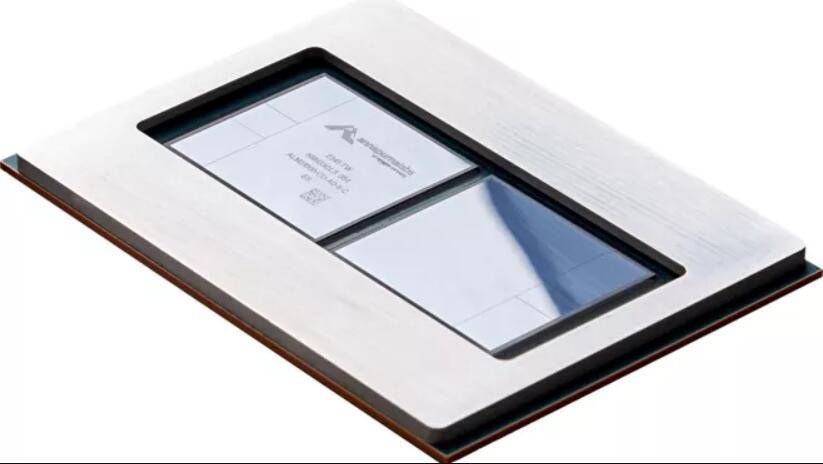

AWS wird der erste Cloud-Service-Anbieter sein, der den neuen Multi-Node-NVLink-Technologie-NVIDIA-H200-Grace-Hopper-Superchip in der Cloud nutzt. Mit anderen Worten: AWS wird der erste wichtige Kunde der aktualisierten Version von Grace Hopper

NVIDIAs H200 NVL32 Multi-Node-Plattform nutzt 32 Grace Hopper-Chips mit NVLink- und NVSwitch-Technologie in einer Instanz. Die Plattform wird auf Amazon EC2-Instanzen verwendet, die mit Amazon Network EFA verbunden sind, und basiert auf fortschrittlicher Virtualisierung (AWS Nitro System) und Ultra-Scale-Clustern (Amazon EC2 UltraClusters), sodass gemeinsame Amazon- und Nvidia-Kunden Bereitstellungen in die Größenordnung von Tausenden entwickeln können H200-ChipNVIDIA und AWS werden zusammenarbeiten, um NVIDIAs KI-Training-as-a-Service DGX Cloud auf AWS zu hosten. Dies wird die erste DGX-Cloud sein, die über den GH200 NVL32 verfügt und Entwicklern eine einzige Instanz mit maximalem gemeinsam genutzten Speicher bietet. Die DGX Cloud von AWS wird die Trainingsmöglichkeiten modernster generativer KI und großer Sprachmodelle mit mehr als 1 Billion Parametern verbessern

NVIDIA und AWS arbeiten an einem Projekt namens Ceiba zusammen, um den weltweit schnellsten GPU-gestützten KI-Supercomputer zu entwickeln. Angetrieben durch GH200 NVL32 und die Verbindungstechnologie von Amazon EFA ist dieser Computer ein riesiges System. Es ist mit 16.384 GH200-Superchips ausgestattet und verfügt über 65 Exaflops KI-Rechenleistung. NVIDIA plant, damit die nächste Welle generativer KI-Innovationen voranzutreiben

Zusätzlich zur Bereitstellung von Chips und Cloud-Diensten veröffentlichte AWS auch eine Vorschauversion eines KI-Chatbots namens Amazon Q. Amazon Q ist ein neuartiger digitaler Assistent, der generative KI-Technologie nutzt, um auf der Grundlage der Geschäftsanforderungen von Unternehmenskunden zu arbeiten. Es hilft Unternehmenskunden, nach Informationen zu suchen, Code zu schreiben und Geschäftskennzahlen zu überprüfen

Q hat einige Schulungen zu Code und Dokumentation in AWS erhalten, die von Entwicklern in der AWS-Cloud verwendet werden können.

Entwickler können Q verwenden, um Anwendungen auf AWS zu erstellen, Best Practices zu recherchieren, Fehler zu korrigieren und Hilfe beim Schreiben neuer Funktionen für ihre Anwendungen zu erhalten. Benutzer können über Q&A-Konversationen mit Q interagieren, um neues Wissen zu erlernen, Best Practices zu recherchieren und zu verstehen, wie man Anwendungen auf AWS erstellt, ohne die AWS-Konsole zu verlassen

Amazon wird Q zu Programmen für Enterprise-Intelligence-Software, Call-Center-Mitarbeiter und Logistikmanagement hinzufügen. Laut AWS können Kunden Q basierend auf Unternehmensdaten oder persönlichen Profilen anpassen

Conversational Q&A ist derzeit in allen von AWS bereitgestellten Unternehmensregionen als Vorschau verfügbar

Das obige ist der detaillierte Inhalt vonAmazon ist bestrebt, seinen Cloud-Status zu verteidigen, aktualisiert seine selbst entwickelten KI-Chips, veröffentlicht den Chat-Roboter Q und ist das erste Unternehmen, das Nvidias Superchip der neuen Generation einsetzt. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Welche Art von KI-Chip wird benötigt, um ein großes Modell in eine Kamera zu integrieren? Aixin Yuanzhis Antwort ist AX650N

- Tutorial zur Implementierung der Produktsuchfunktion über die PHP-Amazon-API

- Förderung inklusiver Daten und KI: Amazon Cloud Technology veranstaltet die Generative AI Builders Conference

- NVIDIA-Insider bestätigten: Der chinesische Markt wird am 16. November drei auf China zugeschnittene KI-Chips auf den Markt bringen