Heim >Technologie-Peripheriegeräte >KI >NVIDIA stellt neue Version von TensorRT-LLM vor: Die Inferenzfähigkeit wurde um das Fünffache erhöht, eignet sich für den lokalen Betrieb auf Grafikkarten über 8 GB und unterstützt die Chat-API von OpenAI

NVIDIA stellt neue Version von TensorRT-LLM vor: Die Inferenzfähigkeit wurde um das Fünffache erhöht, eignet sich für den lokalen Betrieb auf Grafikkarten über 8 GB und unterstützt die Chat-API von OpenAI

- 王林nach vorne

- 2023-11-17 15:06:451263Durchsuche

Nachrichten vom 16. November, die Microsoft Ignite 2023-Konferenz hat heute begonnen. Führungskräfte von NVIDIA nahmen an der Konferenz teil und kündigten ein Update für TensorRT-LLM an, hinzugefügte Unterstützung für die OpenAI-Chat-API.

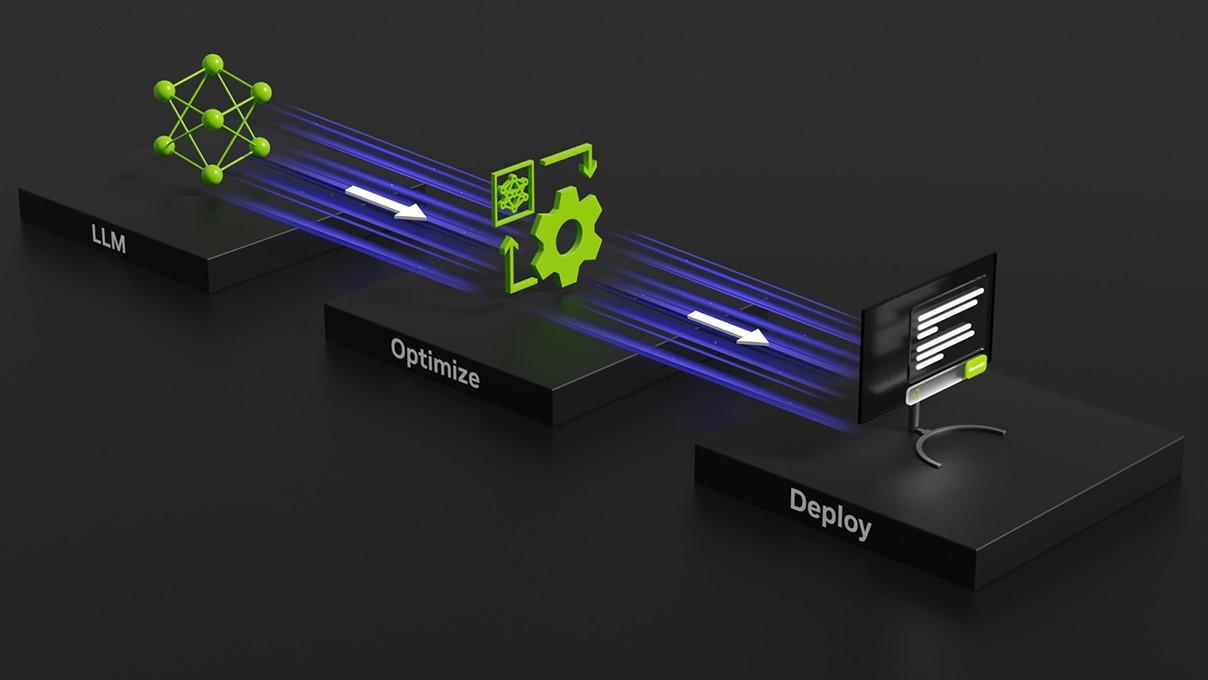

NVIDIA hat im Oktober dieses Jahres die Open-Source-Bibliothek Tensor RT-LLM veröffentlicht, mit dem Ziel, Unterstützung für Rechenzentren und Windows-PCs bereitzustellen. Das größte Merkmal dieser Open-Source-Bibliothek besteht darin, dass TensorRT-LLM die Laufgeschwindigkeit von LLM auf Windows-PCs um das Vierfache erhöhen kann, wenn ein Windows-PC mit der GeForce RTX-GPU ausgestattet ist. NVIDIA gab heute auf der Ignite 2023-Konferenz das Update TensorRT-LLM bekannt , fügen Sie die Chat-API-Unterstützung von OpenAI hinzu und verbessern Sie DirectML-Funktionen, um die Leistung von KI-Modellen wie Llama 2 und Stable Diffusion zu verbessern.

TensorRT-LLM kann lokal mit der AI Workbench von NVIDIA durchgeführt werden. Entwickler können dieses einheitliche und benutzerfreundliche Toolkit nutzen, um vorab trainierte generative KI-Modelle und LLMs schnell auf einem PC oder einer Workstation zu erstellen, zu testen und anzupassen. NVIDIA hat hierfür auch eine Early-Access-Registrierungsseite gestartet

NVIDIA wird später in diesem Monat das Versionsupdate TensorRT-LLM 0.6.0 veröffentlichen, das die Inferenzleistung um das Fünffache erhöht und andere Mainstream-LLMs wie Mistral 7B und Nemotron unterstützt. 3 8B .

Das obige ist der detaillierte Inhalt vonNVIDIA stellt neue Version von TensorRT-LLM vor: Die Inferenzfähigkeit wurde um das Fünffache erhöht, eignet sich für den lokalen Betrieb auf Grafikkarten über 8 GB und unterstützt die Chat-API von OpenAI. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Was bedeutet E-Mail?

- Was ist der Unterschied zwischen Raid 0 1 5 10

- „Microsoft Teams Premium erweitert die GPT-Funktionalität mit OpenAI'

- Schlagen Sie OpenAI erneut! Google veröffentlicht ein universelles Modell mit 2 Milliarden Parametern zur automatischen Erkennung und Übersetzung von mehr als 100 Sprachen

- Programmierer sind in Gefahr! Es heißt, dass OpenAI weltweit Outsourcing-Truppen rekrutiert und ChatGPT-Code-Farmer Schritt für Schritt schult