Heim >Technologie-Peripheriegeräte >KI >NVIDIA veröffentlicht den KI-Chip H200: Die Leistung steigt um 90 %, die Inferenzgeschwindigkeit von Llama 2 verdoppelt sich

NVIDIA veröffentlicht den KI-Chip H200: Die Leistung steigt um 90 %, die Inferenzgeschwindigkeit von Llama 2 verdoppelt sich

- 王林nach vorne

- 2023-11-14 12:09:541086Durchsuche

DoNews berichtete am 14. November, dass NVIDIA zum 13. Mal in Peking die nächste Generation von Supercomputer-Chips für künstliche Intelligenz herausgebracht hat. Diese Chips werden eine wichtige Rolle beim Deep Learning und bei großen Sprachmodellen (LLM) wie GPT-4 von OpenAI spielen.

Die neue Generation von Chips hat im Vergleich zur Vorgängergeneration erhebliche Fortschritte gemacht und wird in großem Umfang in Rechenzentren und Supercomputern eingesetzt, um komplexe Aufgaben wie Wetter- und Klimavorhersagen, Arzneimittelforschung und -entwicklung sowie Quantencomputing zu bewältigen

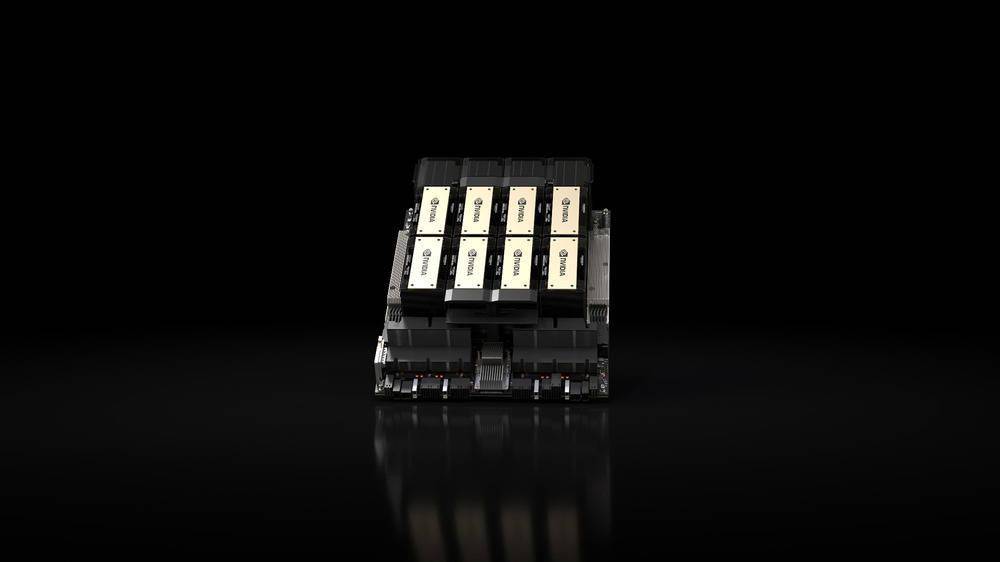

Das wichtigste veröffentlichte Produkt ist die HGX H200-GPU auf Basis der „Hopper“-Architektur von Nvidia, die der Nachfolger der H100-GPU ist und der erste Chip des Unternehmens ist, der HBM3e-Speicher verwendet. Der HBM3e-Speicher verfügt über eine höhere Geschwindigkeit und eine größere Kapazität und eignet sich daher sehr gut für Anwendungen mit großen Sprachmodellen

NVIDIA sagte: „Mit der HBM3e-Technologie erreicht die NVIDIA H200-Speichergeschwindigkeit 4,8 TB pro Sekunde, die Kapazität beträgt 141 GB, fast doppelt so viel wie bei A100, und die Bandbreite hat sich ebenfalls um das 2,4-fache erhöht.“Im Bereich der künstlichen Intelligenz behauptet NVIDIA, dass die Inferenzgeschwindigkeit von HGX H200 auf Llama 2 (70 Milliarden Parameter-LLM) doppelt so schnell ist wie die von H100. HGX H200 wird in 4-Wege- und 8-Wege-Konfigurationen erhältlich sein, kompatibel mit der Software und Hardware im H100-System

Es wird in jeder Art von Rechenzentrum (vor Ort, in der Cloud, Hybrid-Cloud und Edge) verfügbar sein und von Amazon Web Services, Google Cloud, Microsoft Azure und Oracle Cloud Infrastructure bereitgestellt und im zweiten Quartal 2024 verfügbar sein.

Ein weiteres wichtiges Produkt, das dieses Mal von NVIDIA veröffentlicht wurde, ist der „Superchip“ GH200 Grace Hopper, der die HGX H200-GPU und die Arm-basierte NVIDIA Grace-CPU über die NVLink-C2C-Verbindung des Unternehmens kombiniert. Er wurde für Supercomputer entwickelt und ermöglicht „Wissenschaftlern und Forschern.“ um die anspruchsvollsten Probleme der Welt zu lösen, indem wir komplexe KI- und HPC-Anwendungen beschleunigen, die Terabytes an Daten verarbeiten.“

Der GH200 wird in „mehr als 40 KI-Supercomputern in Forschungszentren, Systemherstellern und Cloud-Anbietern auf der ganzen Welt“ eingesetzt, darunter Dell, Eviden, Hewlett Packard Enterprise (HPE), Lenovo, QCT und Supermicro.

Bemerkenswert ist, dass der Supercomputer Cray EX2500 von HPE über einen vierfachen GH200 verfügen wird, der auf Zehntausende von Grace Hopper-Superchip-Knoten skalierbar ist

Das obige ist der detaillierte Inhalt vonNVIDIA veröffentlicht den KI-Chip H200: Die Leistung steigt um 90 %, die Inferenzgeschwindigkeit von Llama 2 verdoppelt sich. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr