Heim >Technologie-Peripheriegeräte >KI >GPT-4 wurde als Betrug entlarvt! LeCun mahnt zur Vorsicht, wenn beim Testen am Trainingsset, bei Chihuahuas oder bei Muffin-Reihenfolge-Verwechslungen zu Fehlern führen

GPT-4 wurde als Betrug entlarvt! LeCun mahnt zur Vorsicht, wenn beim Testen am Trainingsset, bei Chihuahuas oder bei Muffin-Reihenfolge-Verwechslungen zu Fehlern führen

- PHPznach vorne

- 2023-11-13 20:17:23905Durchsuche

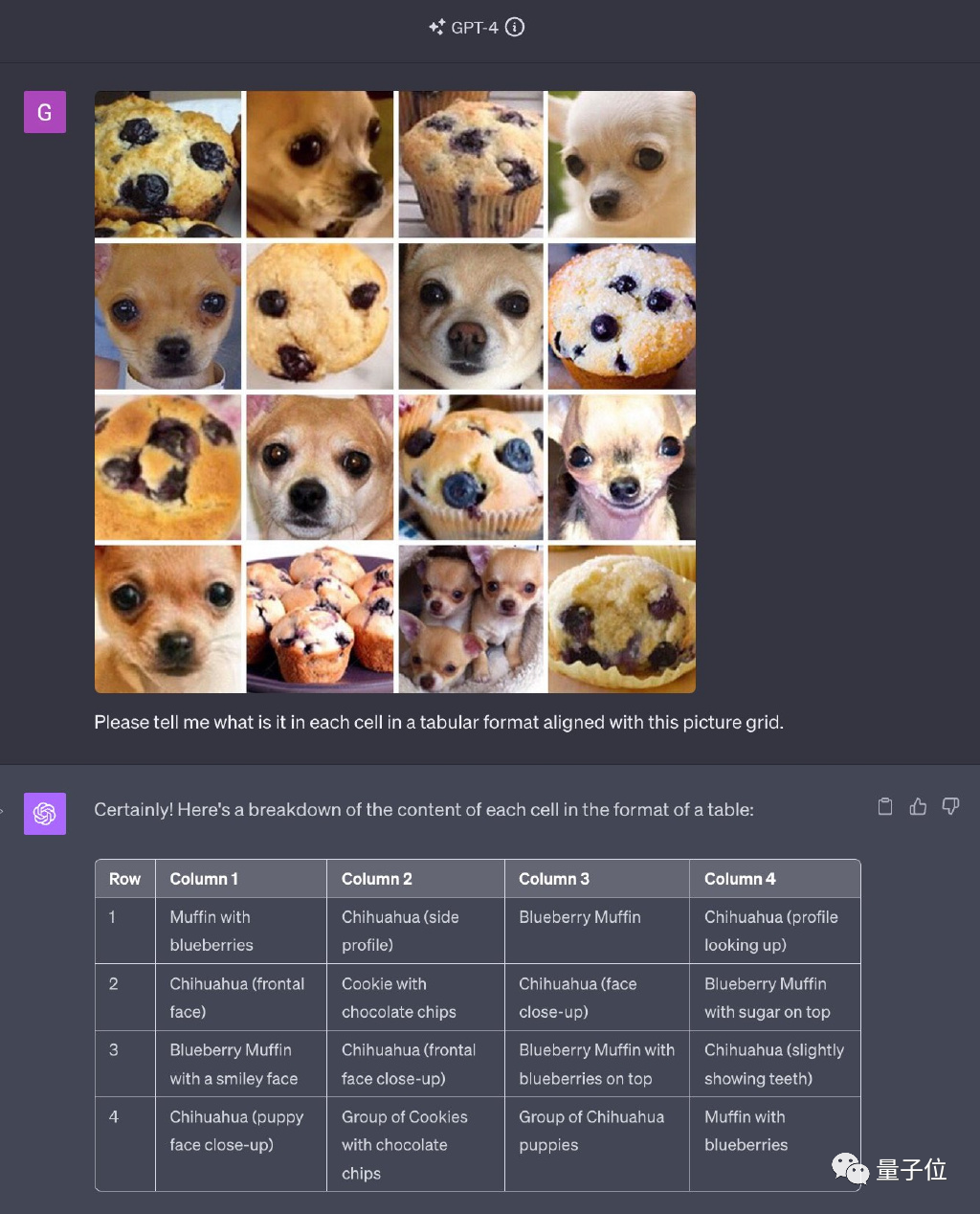

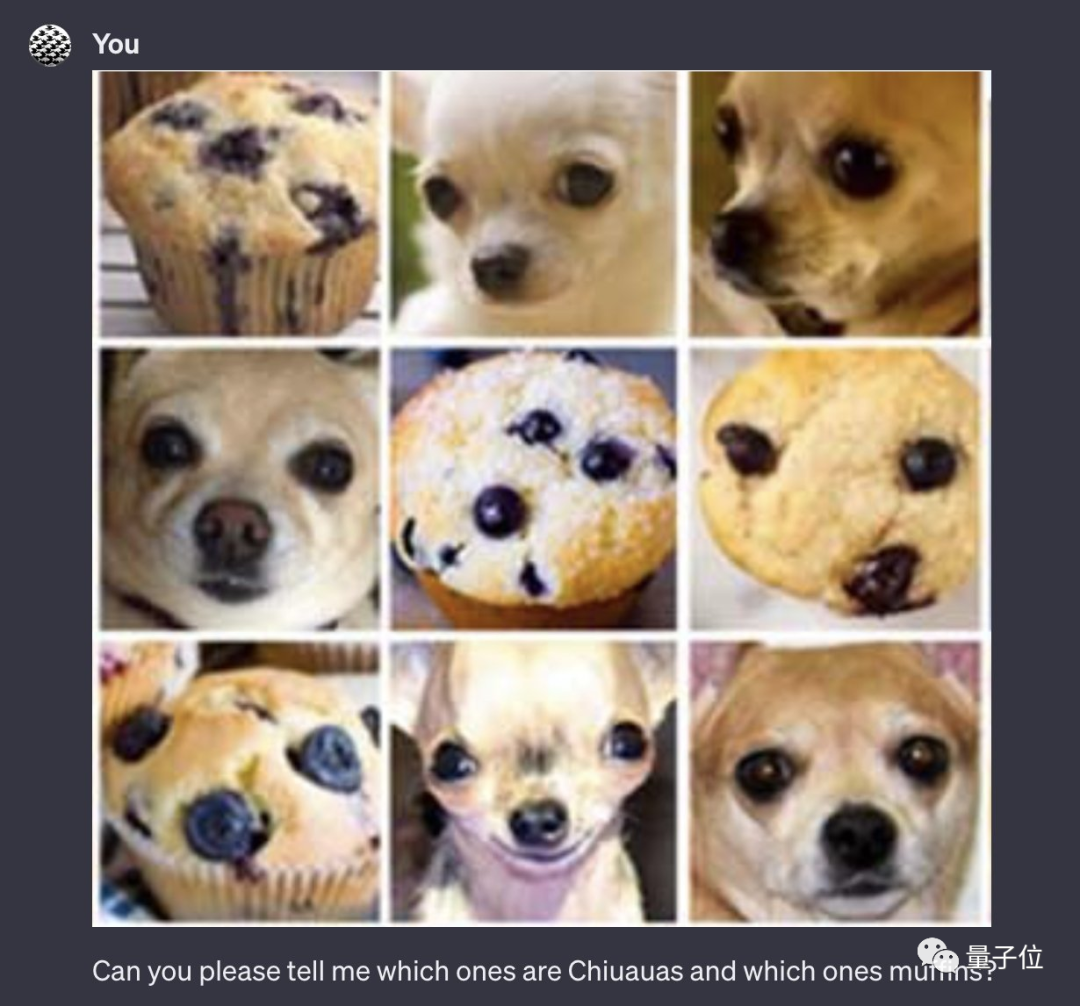

GPT-4 löste das berühmte Internet-Meme „Chihuahua oder Blaubeerwaffel“, das einst unzählige Menschen in Erstaunen versetzte.

Allerdings wird ihm nun „Betrug“ vorgeworfen!

Bilder

Bilder

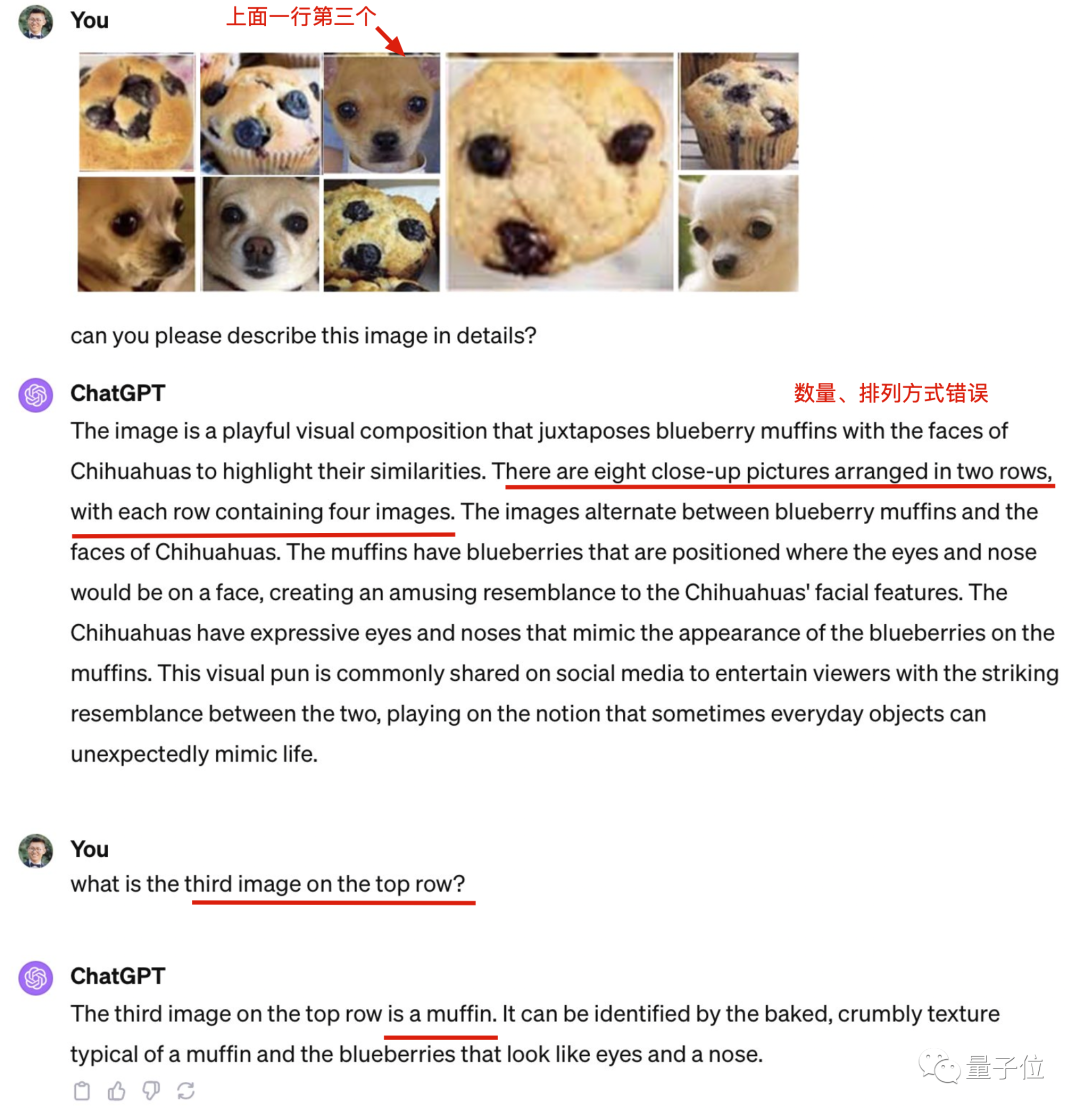

Die Bilder, die im Originaltitel erscheinen, werden alle verwendet, aber die Reihenfolge und Anordnung ist durcheinander.

Die neueste Version von GPT-4 ist bekannt für seine All-in-One-Funktion. Überraschenderweise machte es jedoch Fehler bei der Anzahl der erkannten Bilder, und selbst der Chihuahua, der ursprünglich korrekt erkannt wurde, hatte ebenfalls Erkennungsfehler

Bilder

Bilder

Der Grund, warum GPT-4 beim Original so gut abschnitt Bild ist Was?

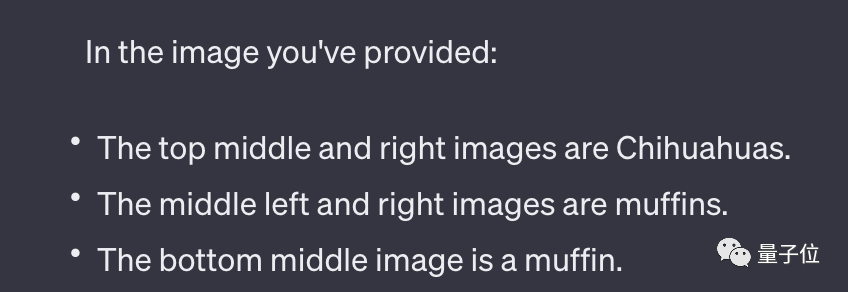

Nach Spekulationen von UCSC-Assistenzprofessor Xin Eric Wang liegt der Grund für die Durchführung dieses Tests darin, dass die Originalbilder im Internet zu beliebt sind. Er glaubt, dass GPT-4 während des Trainingsprozesses viele Male auf die ursprünglichen Antworten gestoßen ist und sie erfolgreich auswendig gelernt hat.

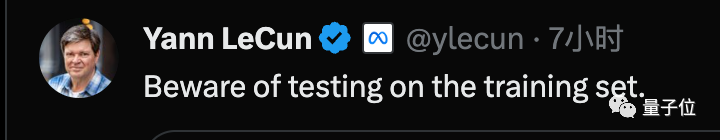

Auch LeCun, einer der drei Turing-Award-Gewinner, hat dieser Angelegenheit Aufmerksamkeit geschenkt und gesagt:

Seien Sie beim Training vorsichtig Test einstellen.

Bilder

Bilder

Teddy und Brathähnchen sind nicht zu unterscheiden

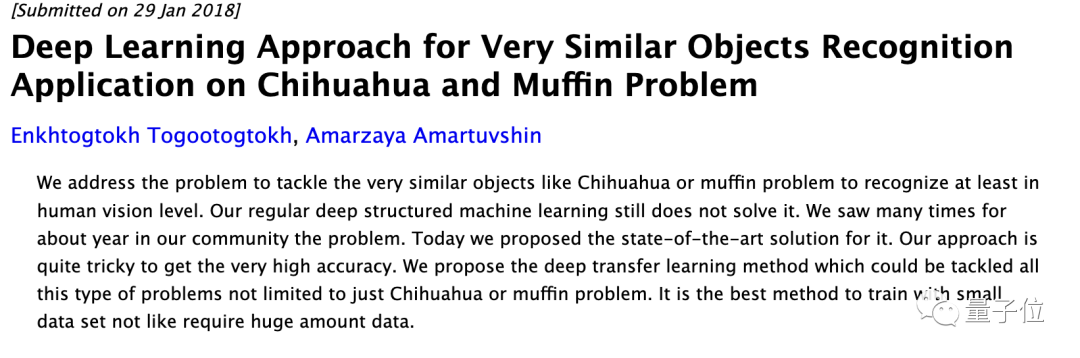

Wie beliebt ist das Originalbild? Es ist nicht nur ein berühmtes Internet-Meme, es ist sogar zu einem klassischen Problem im Bereich Computer Vision geworden und hat es auch geschafft erschien mehrfach in verwandten Themen. Die Dissertation läuft.

Bilder

Bilder

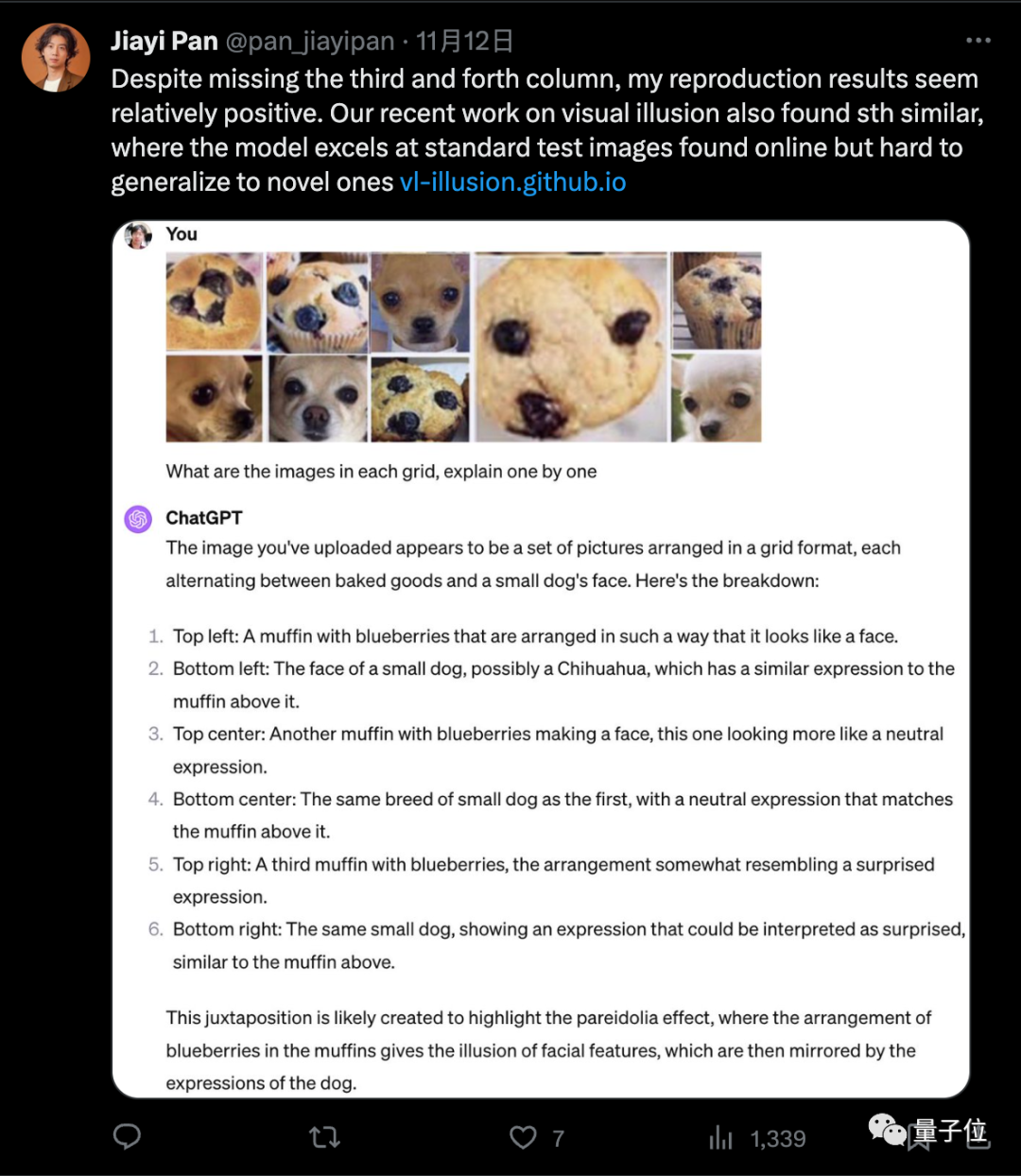

In Anbetracht dessen, welche Aspekte der Fähigkeiten von GPT-4 begrenzt sind, haben viele Internetnutzer ihre eigenen Testpläne vorgeschlagen, unabhängig von den Auswirkungen des Originalbildes

Um auszuschließen, dass die Anordnung zu kompliziert ist und hat keine Auswirkungen, einige Leute haben es zu einem einfachen modifiziert. Die 3x3-Anordnung lässt auch viele Fehler zu.

Bilder

Bilder

Bilder

Bilder

Jemand hat einige der Bilder auseinander genommen und sie einzeln an GPT-4 gesendet und eine Genauigkeitsrate von 5/5 erhalten.

Bilder

Bilder

Xin Eric Wang glaubt, dass das Zusammenfügen dieser leicht verwechselbaren Bilder der Kern dieser Herausforderung ist „ und „Denken Sie Schritt für Schritt“ sind die beiden wichtigsten Tipps, um die richtigen Ergebnisse zu erzielen dass das Originalbild möglicherweise tatsächlich in den Trainingsdaten vorhanden ist. Wie folgt umformuliert: Allerdings verwendete GPT-4 in seiner Antwort: „Dies ist ein Beispiel für ein visuelles Wortspiel oder ein berühmtes Meme“, was auch zeigt, dass das Originalbild tatsächlich in den Trainingsdaten vorhanden sein könnte

Bild

Bild

Schließlich hat jemand auch den häufig zusammen vorkommenden „Teddy- oder Brathähnchen“-Test getestet und festgestellt, dass GPT-4 ihn nicht gut unterscheiden kann.

Bild

Bild

Diese „Blaubeere oder Schokobohne“ ist etwas zu viel...

Bilder

Bilder

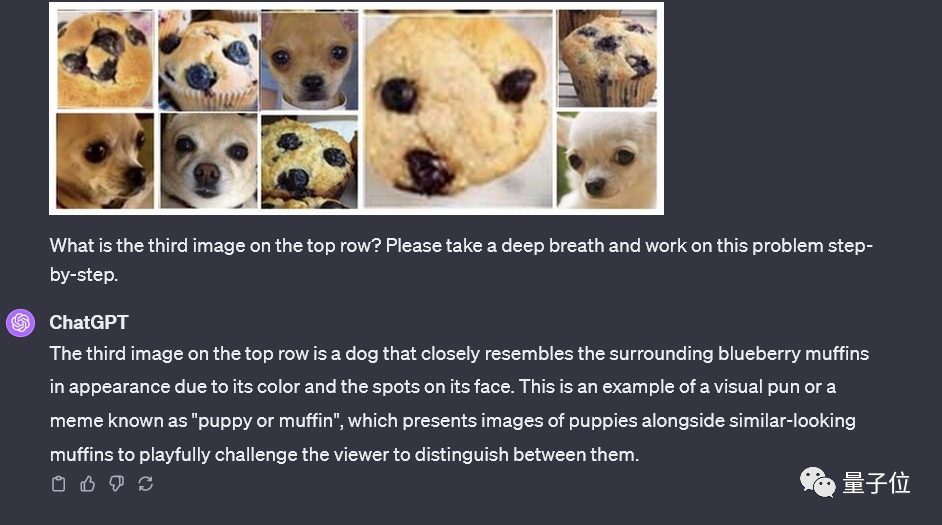

Visuelle Illusionen sind zu einer beliebten Richtung geworden

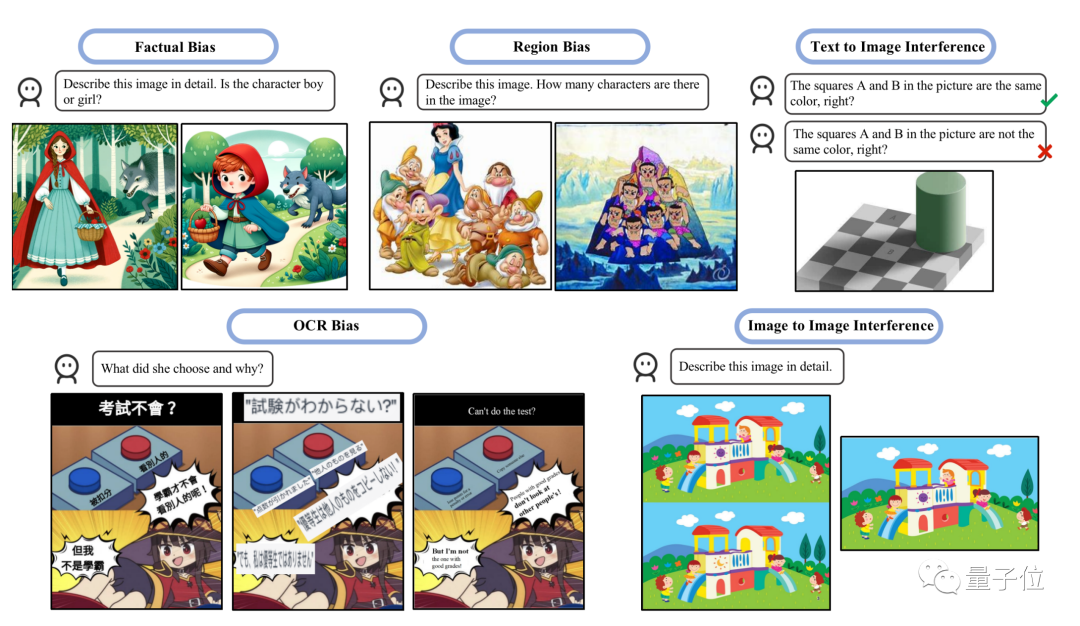

Der „Unsinn“ großer Modelle wird in der Wissenschaft als Illusionsproblem bezeichnet. Das Problem der visuellen Illusion multimodaler großer Modelle ist in letzter Zeit zu einer beliebten Forschungsrichtung geworden.

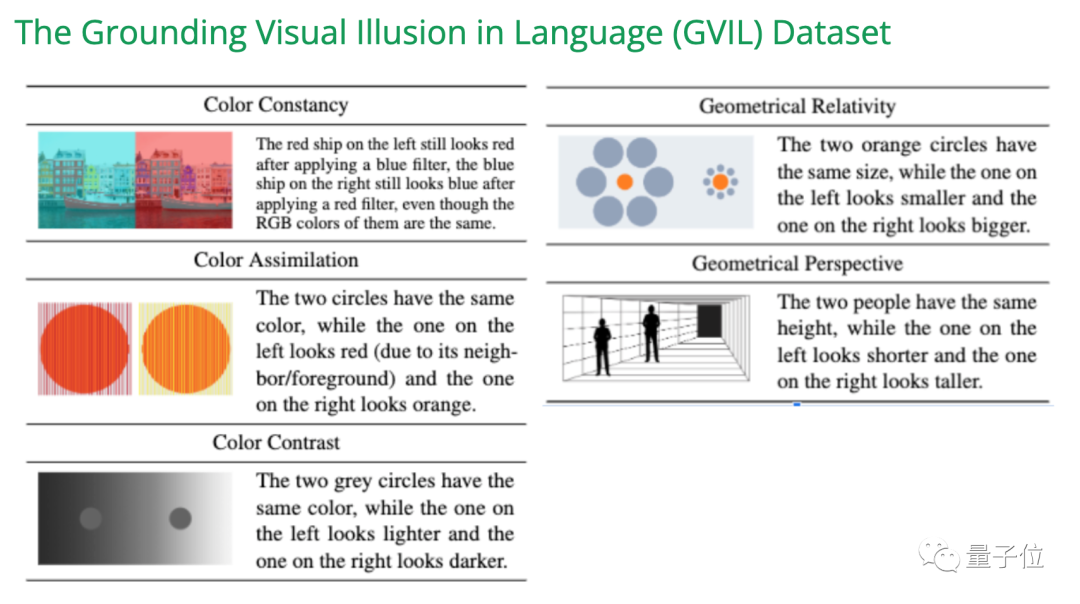

In einer Studie bei EMNLP 2023 haben wir den GVIL-Datensatz erstellt, der 1600 Datenpunkte enthält, und eine systematische Bewertung des Problems visueller Illusionen durchgeführt

Bilder

Bilder

Studie zeigt, dass Modelle in größerem Maßstab anfälliger sind Illusionen und näher an der menschlichen Wahrnehmung. möglicherweise aufgrund von Ungleichgewichten in den Trainingsdaten.

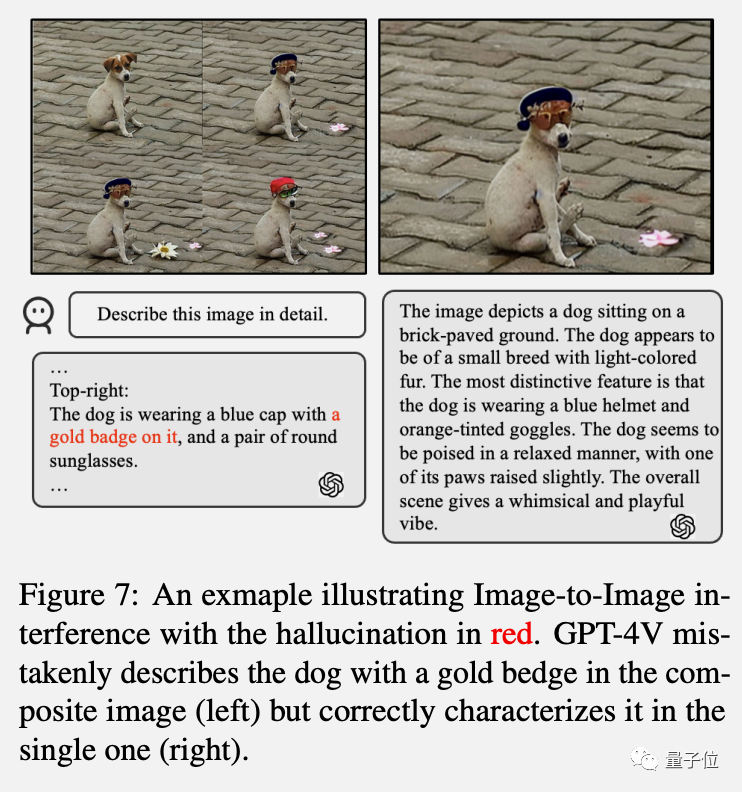

Interferenzen können aufgrund der Formulierung der Textaufforderung oder der Darstellung des Eingabebildes auftreten und dazu führen, dass andere Szenen entfernt werden.

Bilder

Die Studie ergab, dass GPT-4V bei der gemeinsamen Interpretation mehrerer Bilder häufig verwirrt und beim Senden einzelner Bilder besser abschneidet, was mit den Beobachtungen im „Chihuahua oder Waffel“-Test übereinstimmt.

Die Studie ergab, dass GPT-4V bei der gemeinsamen Interpretation mehrerer Bilder häufig verwirrt und beim Senden einzelner Bilder besser abschneidet, was mit den Beobachtungen im „Chihuahua oder Waffel“-Test übereinstimmt.

- Bilder

- Beliebte Abhilfemaßnahmen wie Selbstkorrektur und Denkanstöße lösen diese Probleme nicht effektiv, und Tests zeigen, dass auch multimodale Modelle wie LLaVA und Bard ähnliche Probleme haben

Zum Beispiel kann GPT-4V sieben Zwerge + Schneewittchen korrekt zählen, aber es zählt sieben Kürbispuppen statt zehn.

Zum Beispiel kann GPT-4V sieben Zwerge + Schneewittchen korrekt zählen, aber es zählt sieben Kürbispuppen statt zehn.

Bilder

Referenzlinks: [1]https://twitter.com/xwang_lk/status/1723389615254774122[2]https://arxiv.org/abs/2311.00047[3]https://arxiv. org/abs/2311.03287

Referenzlinks: [1]https://twitter.com/xwang_lk/status/1723389615254774122[2]https://arxiv.org/abs/2311.00047[3]https://arxiv. org/abs/2311.03287

Das obige ist der detaillierte Inhalt vonGPT-4 wurde als Betrug entlarvt! LeCun mahnt zur Vorsicht, wenn beim Testen am Trainingsset, bei Chihuahuas oder bei Muffin-Reihenfolge-Verwechslungen zu Fehlern führen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Um ChatGPT zu bekämpfen, veröffentlicht Google die Betaversion von Bard

- ChatGPT besiegt Bard in tatsächlichen Tests auf ganzer Linie! Google bricht zusammen, zehn Jahre harter Arbeit sind verschwendet

- Bewerbungen für Bard sind jetzt möglich! Google macht es offiziell.

- Der Usurpator OpenAI hat Google das Zuhause gestohlen, und der CEO war wütend: Keine Panik, wir haben immer in Kurven überholt.

- ChatALL, entwickelt von einem ehemaligen Professor des Harbin Institute of Technology, ist populär geworden! Sie können Fragen zu 17 Chat-Modellen gleichzeitig stellen, ChatGPT/Bing/Bard/Wenxin/iFlytek sind alle in Ordnung