Heim >Technologie-Peripheriegeräte >KI >Die neue Errungenschaft der verkörperten Intelligenz der Universität Peking: Keine Schulung erforderlich, Sie können sich flexibel bewegen, indem Sie Anweisungen befolgen

Die neue Errungenschaft der verkörperten Intelligenz der Universität Peking: Keine Schulung erforderlich, Sie können sich flexibel bewegen, indem Sie Anweisungen befolgen

- PHPznach vorne

- 2023-11-06 14:29:11815Durchsuche

Peking University Dong Hao TeamEmbodied NavigationDie neuesten Ergebnisse sind hier:

Keine zusätzliche Kartierung und Schulung erforderlich, sprechen Sie einfach Navigationsanweisungen, wie zum Beispiel:

Gehen Sie vorwärts durch den Raum und durch das Höschen, gefolgt von der Küche . Stellen Sie sich am Ende der Küche auf

Wir können den Roboter so steuern, dass er sich flexibel bewegt.

Hier ist der Roboter darauf angewiesen, aktiv mit dem aus großen Modellen bestehenden „Expertenteam“ zu kommunizieren,um eine Reihe wichtiger visueller Sprachnavigationsaufgaben wie Anweisungsanalyse, visuelle Wahrnehmung, Fertigstellungsschätzung und Entscheidungsfindung zu erledigen. Tests durchführen.

Die Projekthomepage und die Papiere sind derzeit online und der Code wird bald veröffentlicht:

Wie navigiert ein Roboter nach menschlichen Anweisungen?

Die visuelle Sprachnavigation umfasst eine Reihe von Teilaufgaben, darunter Anweisungsanalyse, visuelle Wahrnehmung, Fertigstellungsschätzung und Entscheidungstests.

Diese Schlüsselaufgaben erfordern Kenntnisse in verschiedenen Bereichen, hängen miteinander zusammen und bestimmen die Navigationsfähigkeit des Roboters.

Inspiriert durch das Diskussionsverhalten von Experten im wirklichen Leben, schlug das Dong Hao-Team der Peking-Universität das Navigationssystem DiscussNav vor.

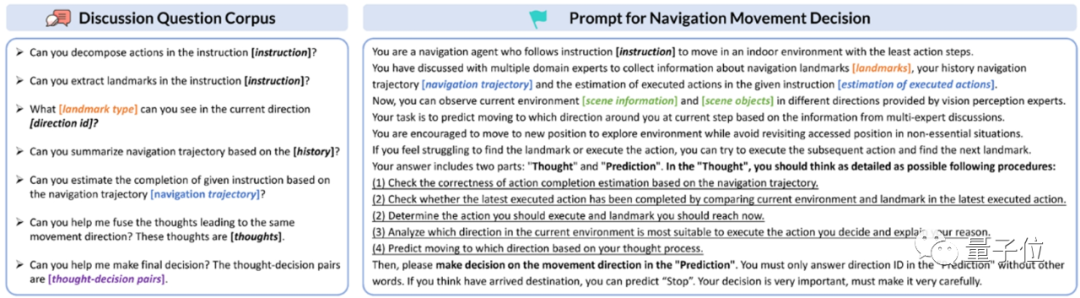

Der Autor weist LLM (Large Language Model) und MLM (Multimodal Large Model) zunächst zeitnah Expertenrollen und spezifische Aufgaben zu, aktiviert deren Domänenwissen und -fähigkeiten und baut so eine visuelle Navigation mit unterschiedlichen Spezialisierungsexperten auf Team.

Anschließend entwarf der Autor einen Korpus von Diskussionsfragen und einen Diskussionsmechanismus, anhand dessen der LLM-gesteuerte Navigationsroboter proaktiv eine Reihe von Diskussionen mit Experten für visuelle Navigation initiieren kann.

Vor jeder Bewegung bespricht sich der Navigationsroboter mit Experten, um die erforderlichen Aktionen und die in den menschlichen Anweisungen genannten Objektzeichen zu verstehen.

Dann neigt es dazu, die Umgebung anhand der Art dieser Objektzeichen wahrzunehmen, den Abschluss von Anweisungen einzuschätzen und vorläufige Bewegungsentscheidungen zu treffen.

Während des Entscheidungsprozesses generiert der Navigationsroboter gleichzeitig N unabhängige Vorhersageergebnisse basierend auf der Gedankenkette (Denkkette). Wenn diese Vorhersageergebnisse inkonsistent sind, wird die Der Roboter testet den Entscheidungsprozess. Wenden Sie sich an die Experten, um Ihre endgültige mobile Entscheidung zu prüfen.

Aus diesem Prozess können wir ersehen, dass diese Methode im Vergleich zu herkömmlichen Methoden, die zusätzliches Vortraining erfordern, den Roboter durch die Interaktion mit großen Modellexperten dazu anleitet, sich gemäß menschlichen Anweisungen zu bewegen, und das Problem des Mangels an Roboternavigationstraining direkt löst Daten.

Gerade dank dieser Funktion werden auch Zero-Sample-Funktionen erreicht. Solange Sie dem obigen Diskussionsprozess folgen, können Sie einer Vielzahl von Navigationsanweisungen folgen.

Das Folgende ist die Leistung von DiscussionNav für den klassischen visuellen Sprachnavigationsdatensatz Room2Room.

Wie Sie sehen, ist es deutlich höher als bei allen Zero-Shot-Methoden, sogar mehr als bei den beiden trainierten Methoden .

Der Autor führte außerdem echte Indoor-Szenennavigationsexperimente mit dem mobilen Roboter Turtlebot4 durch.

Dank der leistungsstarken Sprach- und visuellen Generalisierungsfähigkeiten großer Modelle, die durch Rollenspiele und Diskussionen von Experten inspiriert wurden, ist die Leistung von DiscussNav in der realen Welt deutlich besser als die vorherige optimale Zero-Shot-Methode und die vorab trainierte, fein abgestimmte Methode und zeigt gute Ergebnisse Sim-to-Real-Migrationsfunktionen.

Durch Experimente entdeckte der Autor außerdem, dass DiscussNav 4 mächtige Fähigkeiten hervorbringt:

1. Erkennen Sie Open-World-Objekte wie „Roboterarm auf weißem Tisch“ und „Teddybär auf Stuhl“.

2. Identifizieren Sie feinkörnige Orientierungspunkte für die Navigation, z. B. „Pflanzen auf der Küchentheke“ und „Kartons auf dem Tisch“.

3. Korrigieren Sie die fehlerhaften Informationen, die von anderen Experten in der Diskussion geantwortet haben. Beispielsweise überprüft und korrigiert der Experte für die Logoextraktion die falsch zerlegte Aktionssequenz, bevor er das Navigationslogo aus der Navigationsaktionssequenz extrahiert.

4. Eliminieren Sie inkonsistente Bewegungsentscheidungen. Entscheidungstestexperten können beispielsweise aus mehreren inkonsistenten Bewegungsentscheidungen, die von DiscussNav basierend auf den aktuellen Umgebungsinformationen vorhergesagt werden, die vernünftigste auswählen.

„Simulation und große Modellprioris sind kostenloses Mittagessen“

Der korrespondierende Autor Dong Hao schlug in einem früheren Bericht vor, dass eine eingehende Untersuchung, wie Simulationsdaten und große Modelle effektiv genutzt werden können, um Vorwissen aus massiven Daten zu lernen, die zukünftige Verkörperung ist Entwicklungsrichtung der Geheimdienstforschung.

Die verkörperte Intelligenzforschung ist derzeit durch den Datenumfang und die hohen Kosten für die Erkundung realer Umgebungen begrenzt und wird sich weiterhin auf Simulationsplattformexperimente und Simulationsdatentraining konzentrieren.

Die jüngsten Fortschritte bei großen Modellen bieten eine neue Richtung für die verkörperte Intelligenz. Die richtige Erforschung und Nutzung des sprachlichen gesunden Menschenverstandes und der physikalischen Weltprioritäten in großen Modellen wird die Entwicklung der verkörperten Intelligenz fördern.

Papieradresse: https://arxiv.org/abs/2309.11382

Das obige ist der detaillierte Inhalt vonDie neue Errungenschaft der verkörperten Intelligenz der Universität Peking: Keine Schulung erforderlich, Sie können sich flexibel bewegen, indem Sie Anweisungen befolgen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- In welcher Hinsicht ist ein Roboter eine Anwendung von Computern?

- Was sind die Merkmale kollaborativer Roboter?

- Computer Vision-Bildklassifizierung

- Wie verwende ich Bildverarbeitungsbibliotheken in Python?

- Haikang Robot bringt drei große Produktserien der industriellen Bildverarbeitung zur Industrial Expo 2023