Heim >Technologie-Peripheriegeräte >KI >LeCun hat das autoregressive LLM erneut schlecht geredet: Die Argumentationsfähigkeit von GPT-4 ist sehr begrenzt, wie aus zwei Artikeln hervorgeht

LeCun hat das autoregressive LLM erneut schlecht geredet: Die Argumentationsfähigkeit von GPT-4 ist sehr begrenzt, wie aus zwei Artikeln hervorgeht

- 王林nach vorne

- 2023-10-25 14:13:12732Durchsuche

„Jeder, der denkt, dass autoregressives LLM der KI auf menschlicher Ebene bereits nahe kommt oder nur skaliert werden muss, um KI auf menschlicher Ebene zu erreichen, muss dies lesen. AR-LLM verfügt über sehr begrenzte Argumentations- und Planungsfähigkeiten. Um dieses Problem zu lösen, kann man sie nicht dadurch lösen, dass man sie vergrößert und mit mehr Daten trainiert. „

Der Turing-Award-Gewinner Yann LeCun ist seit langem ein „Fragesteller“ von LLM, und das autoregressive Modell ist es auch . Das Lernparadigma, auf dem das LLM-Modell der GPT-Serie basiert. Er hat seine Kritik an autoregressiven und LLM mehr als einmal öffentlich geäußert und viele goldene Sätze hervorgebracht, wie zum Beispiel:

„Niemand, der bei klarem Verstand ist, wird in 5 Jahren autoregressive Modelle verwenden.“ „Autoregressive generative Modelle sind scheiße!“ Kann LLM seine Lösungen wirklich selbst kritisieren (und iterativ verbessern), wie es die Literatur vorschlägt? Zwei neue Arbeiten aus unserer Gruppe sind Reasoning (https://arxiv.org/abs/2310.12397) und Planning (https://arxiv.org/). abs/2310.08118) Diese Behauptungen wurden untersucht (und in Frage gestellt)“

Das Thema dieses Papiers, das die Verifizierungs- und Selbstkritikfähigkeiten von GPT-4 untersucht, findet bei vielen Menschen Anklang.

Die Autoren des Papiers gaben an, dass sie auch glauben, dass LLM ein großartiger „Ideengenerator“ ist (sei es in Sprachform oder Codeform), sie können jedoch ihre eigenen Planungs-/Denkfähigkeiten nicht garantieren. Daher werden sie am besten in einer LLM-Modulo-Umgebung verwendet (entweder mit einem zuverlässigen Denker oder einem menschlichen Experten auf dem Laufenden). Selbstkritik erfordert Überprüfung, und Überprüfung ist eine Form des Denkens (seien Sie also überrascht von all den Behauptungen über die Fähigkeit von LLM, sich selbst zu kritisieren).

Gleichzeitig gibt es auch Stimmen des Zweifels: „Die Argumentationsfähigkeiten von Faltungsnetzwerken sind eingeschränkter, aber das hindert die Arbeit von AlphaZero nicht daran, aufzutauchen. Es geht um den Argumentationsprozess und die etablierten ( RL) Feedback-Schleife. Ich denke, dass die Modellfähigkeiten ein extrem tiefgründiges Denken ermöglichen (z. B. Mathematik auf Forschungsniveau). Dies erfolgt über eine Monte-Carlo-Baumsuche, wobei ein Faltungsnetzwerk zum Ermitteln guter Aktionen und ein weiteres Faltungsnetzwerk zur Bewertung der Position verwendet wird. Die Zeit, die Sie damit verbringen, den Baum zu erkunden, könnte unendlich sein, das ist alles Denken und Planen. „

In Zukunft wird die Frage, ob autoregressives LLM über Argumentations- und Planungsfähigkeiten verfügt, möglicherweise nicht abschließend geklärt.

In Zukunft wird die Frage, ob autoregressives LLM über Argumentations- und Planungsfähigkeiten verfügt, möglicherweise nicht abschließend geklärt.

Als nächstes können wir einen Blick darauf werfen, worüber diese beiden neuen Papiere sprechen.

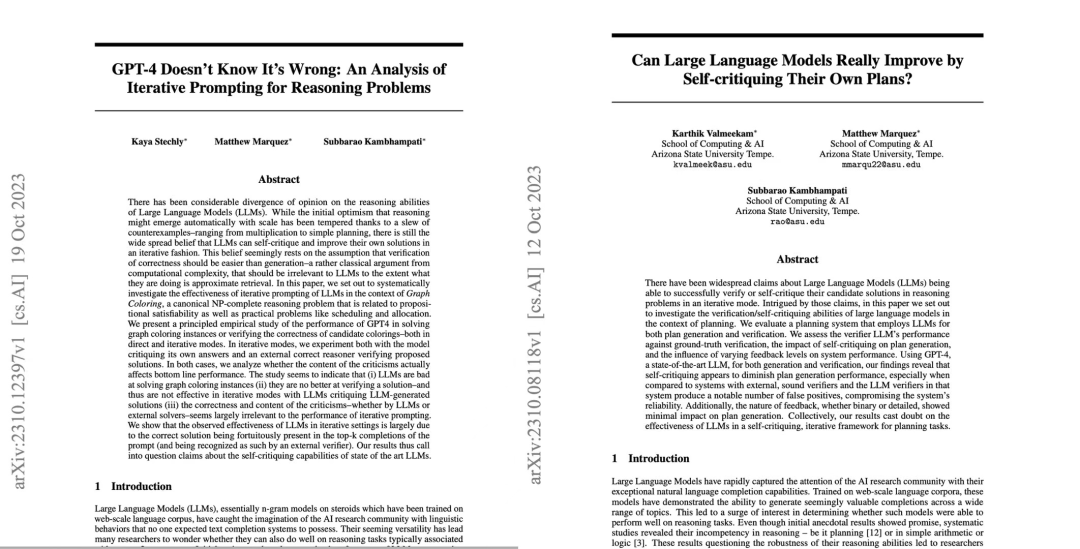

Aufsatz 1: GPT-4 weiß nicht, dass es falsch ist: Eine Analyse iterativer Eingabeaufforderungen für Argumentationsprobleme Kunst LLM, einschließlich GPT-4.

Adresse des Beitrags: https://arxiv.org/pdf/2310.12397.pdf

Über die Inferenzfähigkeiten großer Sprachmodelle (LLMs) gab es immer erhebliche Meinungsverschiedenheiten. Anfangs waren die Forscher optimistisch, dass die Inferenzfähigkeiten von LLMs mit zunehmender Modellskala automatisch auftreten würden In einigen Fällen sind die Erwartungen der Menschen nicht mehr so stark ausgeprägt. Danach glaubten Forscher allgemein, dass LLM die Fähigkeit besitzt, LLM-Lösungen auf iterative Weise selbst zu kritisieren und zu verbessern, und diese Ansicht wurde weit verbreitet.

Aber ist das wirklich so?

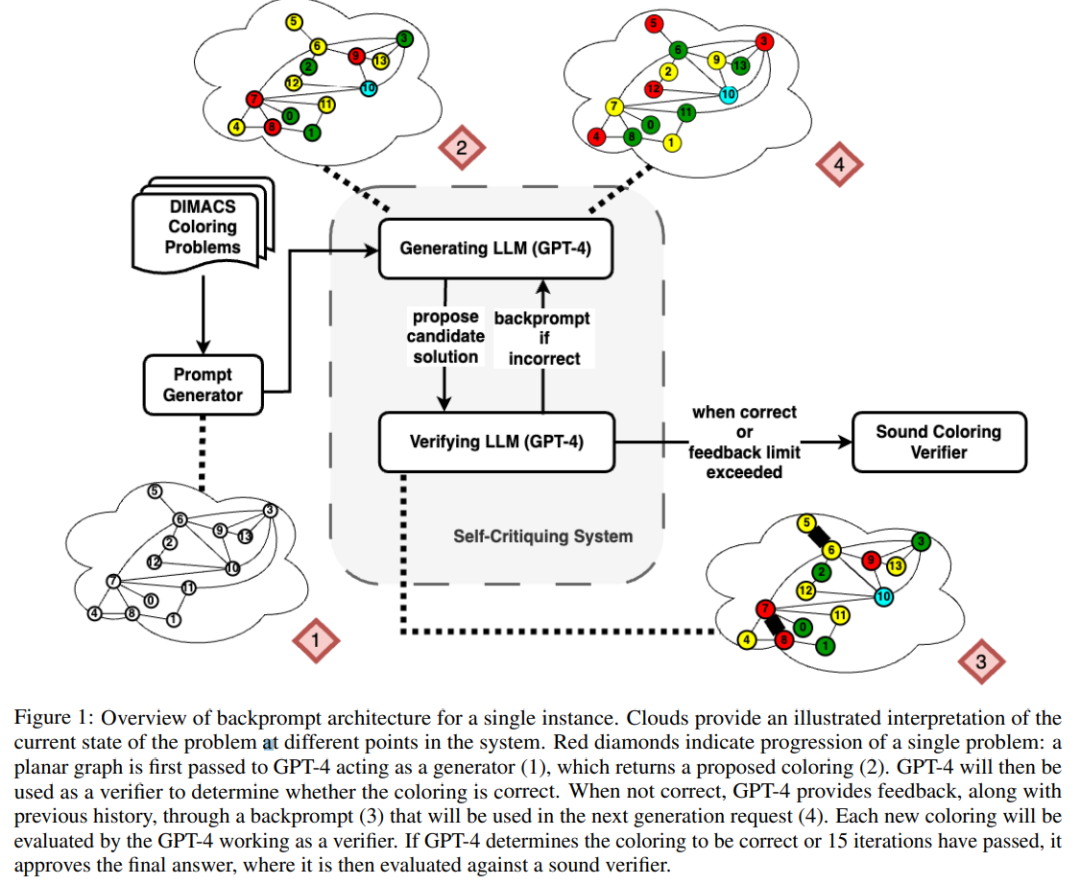

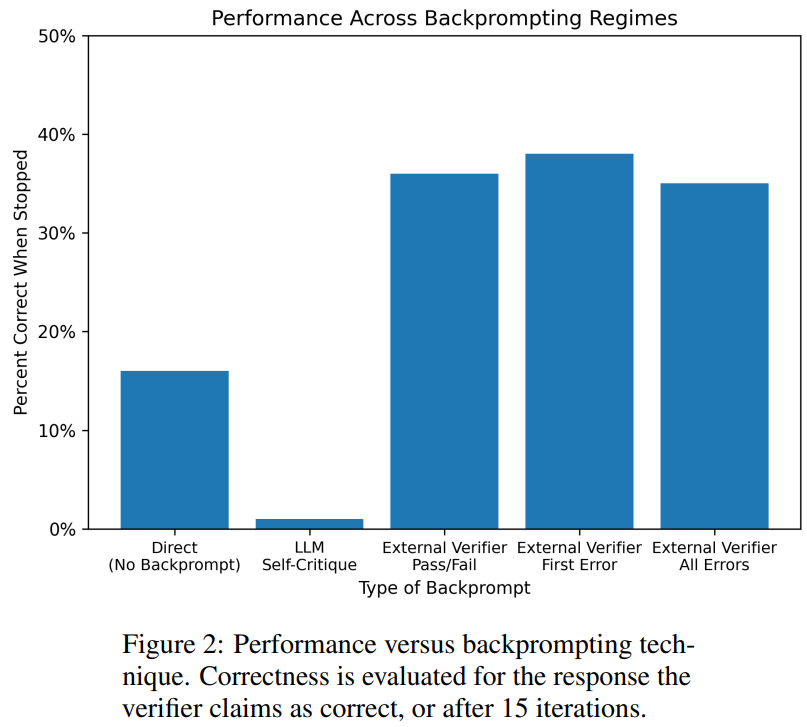

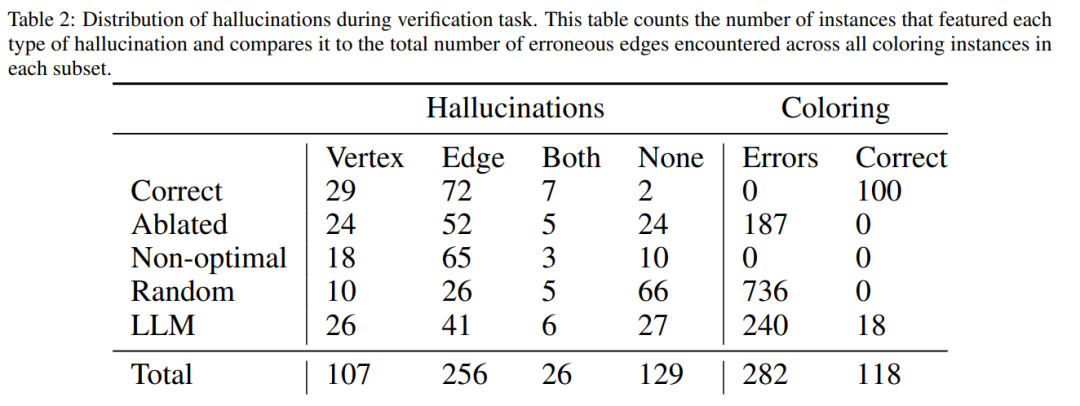

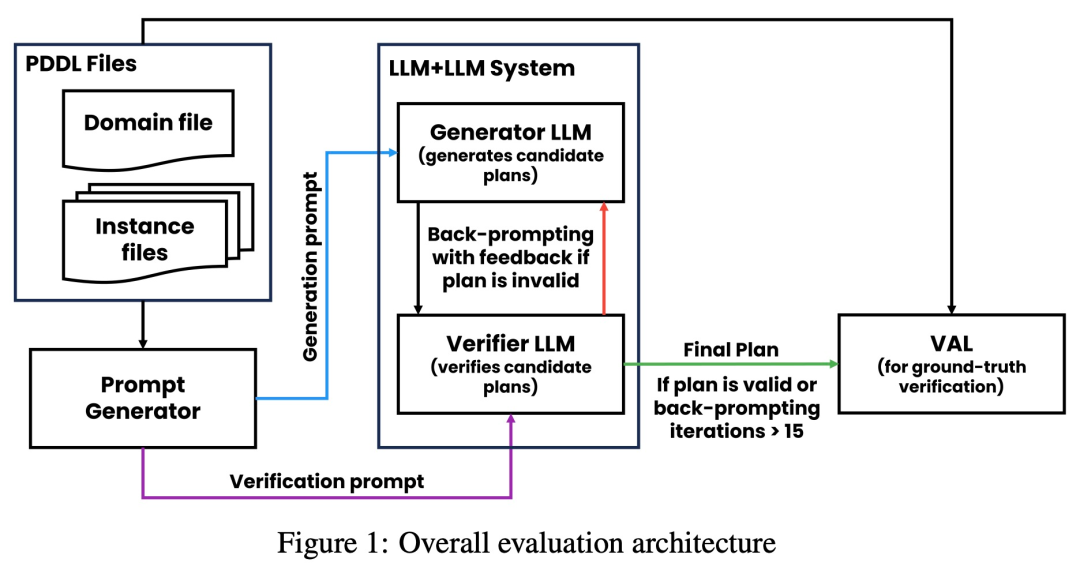

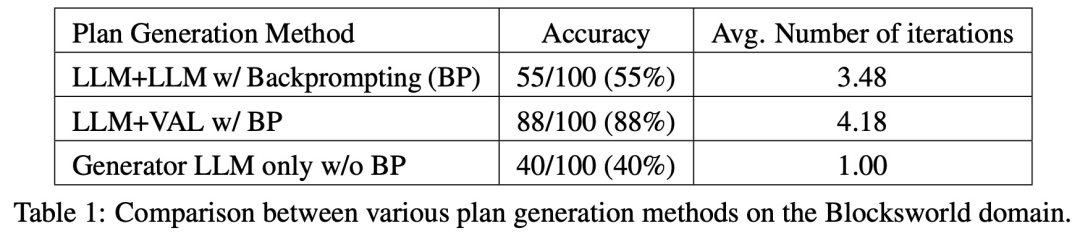

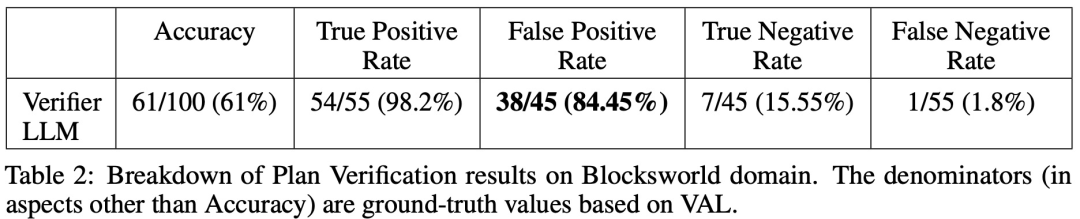

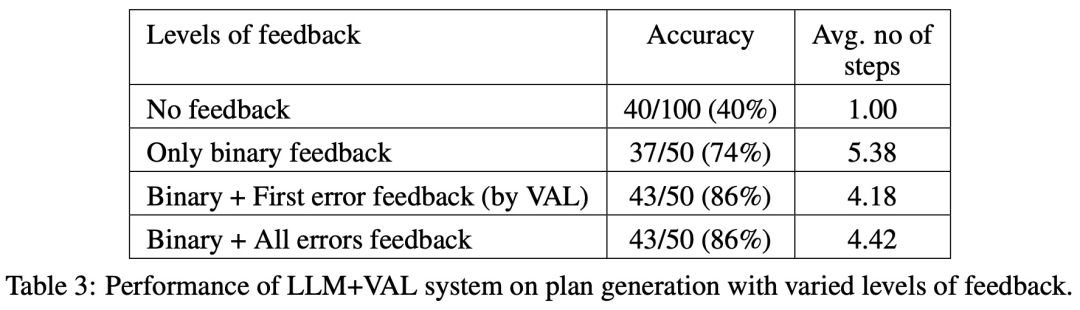

Forscher der Arizona State University haben in einer neuen Studie die Argumentationsfähigkeiten von LLM getestet. Insbesondere konzentrierten sie sich auf die Wirksamkeit der iterativen Eingabeaufforderung beim Diagrammfärbungsproblem, einem der bekanntesten NP-vollständigen Probleme. Diese Studie zeigt, dass (i) LLM nicht gut darin ist, Graphfärbungsinstanzen zu lösen, (ii) LLM nicht gut darin ist, Lösungen zu validieren und daher im iterativen Modus ineffektiv ist. Die Ergebnisse dieser Arbeit werfen daher Fragen über die selbstkritischen Fähigkeiten moderner LLMs auf. Das Papier liefert einige experimentelle Ergebnisse, zum Beispiel ist LLM im direkten Modus sehr schlecht darin, Diagrammfärbungsinstanzen zu lösen. Darüber hinaus stellte die Studie auch fest, dass LLM die Lösung nicht gut verifizieren kann. Schlimmer noch: Das System erkennt nicht die richtige Farbe und erhält am Ende die falsche Farbe. Die folgende Abbildung ist eine Bewertung des Diagrammkolorierungsproblems. In dieser Einstellung kann GPT-4 Farben in einem unabhängigen und selbstkritischen Modus erraten. Außerhalb der selbstkritischen Schleife gibt es einen externen Sprachvalidator. Die Ergebnisse zeigen, dass GPT4 beim Erraten von Farben weniger als 20 % genau ist, und noch überraschender ist, dass der Selbstkritikmodus (zweite Spalte in der Abbildung unten) die niedrigste Genauigkeit aufweist. In diesem Artikel wird auch die damit verbundene Frage untersucht, ob GPT-4 seine Lösung verbessern würde, wenn ein externer Stimmverifizierer nachweislich korrekte Kritiken zu den von ihm vermuteten Farben liefern würde. In diesem Fall kann Reverse Hinting die Leistung wirklich verbessern. Selbst wenn GPT-4 versehentlich eine gültige Farbe errät, kann seine Selbstkritik dazu führen, dass es halluziniert, dass kein Verstoß vorliegt. Abschließend gibt der Autor eine Zusammenfassung zum Problem der Diagrammfärbung: Aufsatz 2: Können sich große Sprachmodelle wirklich verbessern, indem sie ihre eigenen Pläne selbst kritisieren? Team Die Fähigkeit von LLM, sich in Planungssituationen selbst zu überprüfen/zu kritisieren, wurde untersucht. Dieses Papier bietet eine systematische Untersuchung der Fähigkeit von LLMs, ihre eigenen Ergebnisse zu kritisieren, insbesondere im Kontext klassischer Planungsprobleme. Während die jüngste Forschung hinsichtlich des selbstkritischen Potenzials von LLMs, insbesondere in iterativen Kontexten, optimistisch war, schlägt diese Studie eine andere Perspektive vor. Papieradresse: https://arxiv.org/abs/2310.08118 Überraschenderweise zeigen die Forschungsergebnisse, dass Selbstkritik die Leistung der Plangenerierung verringern kann, insbesondere bei externer Validierung Verifier und LLM Prüfsysteme. LLM kann eine große Anzahl von Fehlermeldungen erzeugen und dadurch die Zuverlässigkeit des Systems beeinträchtigen. Die empirische Auswertung der Forscher zum klassischen KI-Planungsbereich Blocksworld zeigt, dass die Selbstkritikfunktion von LLM bei Planungsproblemen nicht effektiv ist. Der Validator kann eine große Anzahl von Fehlern erzeugen, was sich nachteilig auf die Zuverlässigkeit des gesamten Systems auswirkt, insbesondere in Bereichen, in denen die Korrektheit der Planung von entscheidender Bedeutung ist. Interessanterweise hat die Art des Feedbacks (binäres oder detailliertes Feedback) keinen wesentlichen Einfluss auf die Leistung der Plangenerierung, was darauf hindeutet, dass das Kernproblem eher in den binären Verifizierungsfunktionen von LLM als in der Granularität des Feedbacks liegt. Wie in der folgenden Abbildung dargestellt, umfasst die Bewertungsarchitektur dieser Studie zwei LLMs – Generator-LLM + Verifizierer-LLM. Für einen bestimmten Fall ist der Generator-LLM für die Generierung der Kandidatenpläne verantwortlich, während der Verifizierer-LLM deren Richtigkeit bestimmt. Wenn sich herausstellt, dass der Plan falsch ist, gibt der Validator eine Rückmeldung mit der Begründung des Fehlers. Dieses Feedback wird dann an den Generator-LLM übertragen, der den Generator-LLM dazu veranlasst, neue Kandidatenpläne zu generieren. Alle Experimente in dieser Studie verwendeten GPT-4 als Standard-LLM. Diese Studie experimentiert und vergleicht verschiedene Methoden zur Planerstellung auf Blocksworld. Konkret generierte die Studie 100 Zufallsinstanzen zur Bewertung verschiedener Methoden. Um eine realistische Einschätzung der Korrektheit der endgültigen LLM-Planung zu ermöglichen, setzt die Studie einen externen Validator VAL ein. Wie in Tabelle 1 gezeigt, ist die LLM+LLM-Backprompt-Methode hinsichtlich der Genauigkeit etwas besser als die Nicht-Backprompt-Methode. Von 100 Fällen hat der Validator 61 (61 %) genau identifiziert. Die folgende Tabelle zeigt die Leistung von LLM bei unterschiedlichem Feedbackniveau (einschließlich keinem Feedback).

Das obige ist der detaillierte Inhalt vonLeCun hat das autoregressive LLM erneut schlecht geredet: Die Argumentationsfähigkeit von GPT-4 ist sehr begrenzt, wie aus zwei Artikeln hervorgeht. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Was ist ein Haufen? Was ist der Methodenbereich? Einführung in den Heap- und Methodenbereich im JVM-Speichermodell

- So exportieren Sie ein Modell in Navicat

- Worauf bezieht sich das Python-IPO-Modell?

- Welcher Schicht im OSI-Referenzmodell entspricht die Transportschicht im TCP/IP-Referenzmodell?

- Mit welcher Software können AI-Dateien geöffnet und bearbeitet werden?