Heim >Technologie-Peripheriegeräte >KI >Sicherheit von Azure AI-Inhalten: Microsoft veröffentlicht leistungsstarkes Tool zur Moderation von KI-Inhalten

Sicherheit von Azure AI-Inhalten: Microsoft veröffentlicht leistungsstarkes Tool zur Moderation von KI-Inhalten

- 王林nach vorne

- 2023-10-18 11:13:021445Durchsuche

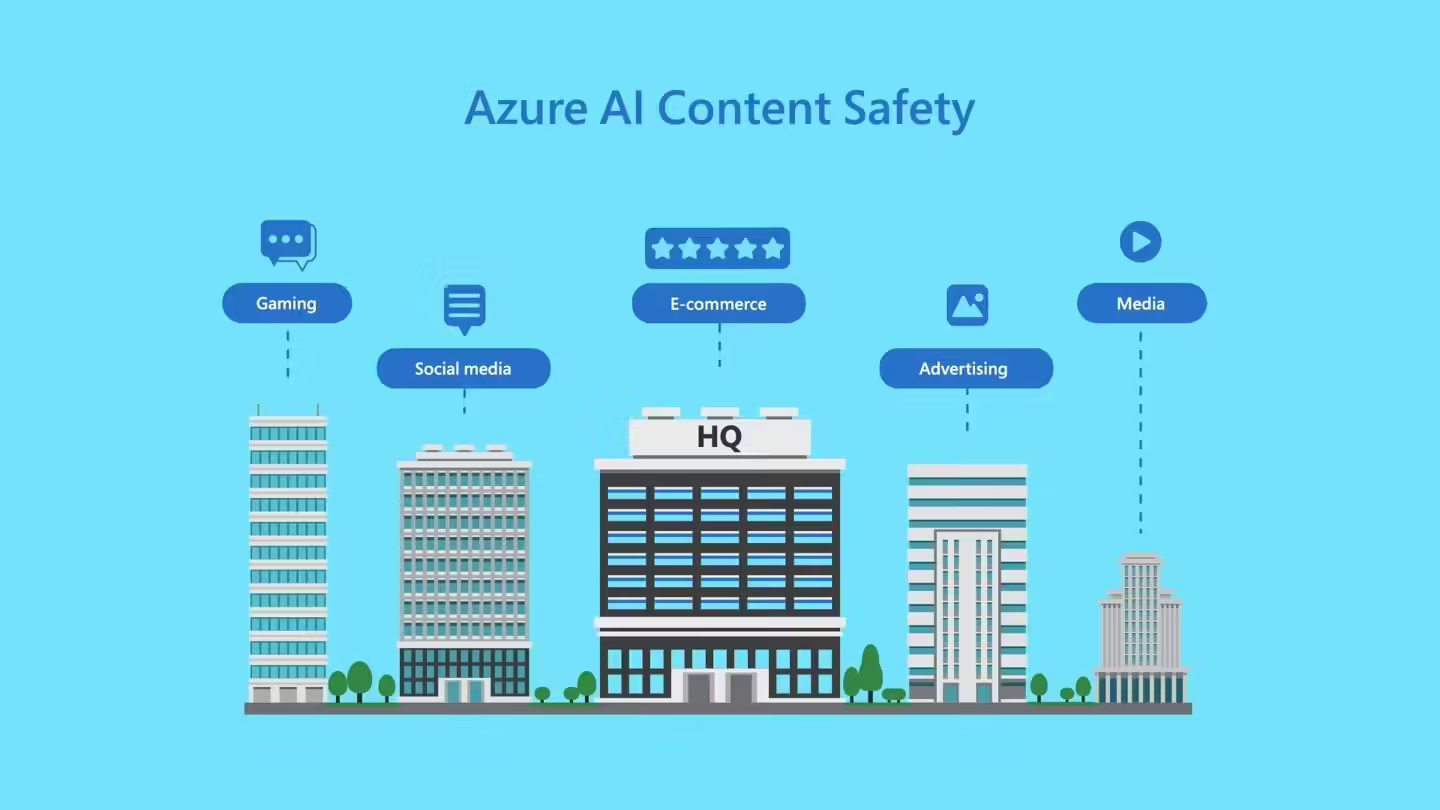

10 Was umgeschrieben werden muss, ist: Monat Was umgeschrieben werden muss, ist: 18 Was umgeschrieben werden muss, ist: Tägliche Nachrichten. Um ein gesundes und harmonisches Community-Umfeld zu schaffen, wird Microsoft negative Inhalte im Zusammenhang mit Vorurteilen, Hass, Gewalt usw. in Bildern oder Texten, Was dieses Jahr neu geschrieben werden muss: 5 Was muss neu geschrieben werden: Monatliche Tests gestartet Was muss neu geschrieben werden: KI Was muss neu geschrieben werden: Tools zur Inhaltsüberprüfung Was muss neu geschrieben werden: Azure Was neu geschrieben werden muss, ist: Was für KI neu geschrieben werden muss, ist: Inhalt. Was neu geschrieben werden muss, ist: Sicherheit. Dieses Tool wurde heute nach vielen Monaten des Testens offiziell veröffentlicht.

Wir haben hier erwähnt: Azure muss neu geschrieben werden: KI muss neu geschrieben werden: Inhaltssicherheit stellt eine Reihe trainierter Modelle bereit. Sie kann negative Inhalte im Zusammenhang mit Vorurteilen, Hass, Gewalt usw. in Bildern oder Texten erkennen und kann Bilder oder Texte in acht Sprachen verstehen und erkennen. Es kann auch den Schweregrad von gekennzeichneten Inhalten bewerten, um menschlichen Prüfern anzuzeigen, bei welchen Inhalten Maßnahmen erforderlich sind

Dieses Inhaltsmoderationstool war ursprünglich in den Azure OpenAI-Dienst integriert und wurde jetzt von Microsoft offiziell als unabhängiges System eingeführt

Microsoft Im offiziellen Blog-Beitrag wurde darauf hingewiesen: „Dies bedeutet, dass Benutzer es auf durch künstliche Intelligenz generierte Inhalte aus Open-Source-Modellen und anderen Unternehmensmodellen anwenden und einige benutzergenerierte Inhalte aufrufen können, wodurch ihr Nutzen weiter ausgebaut wird.“

Was muss neu geschrieben werden:

Microsoft sagte, dass das Produkt zwar erhebliche Verbesserungen in Bezug auf Unparteilichkeit und Kontextverständnis aufweist, sich jedoch weiterhin auf menschliche Prüfer verlassen muss, um Daten und Inhalte zu kennzeichnen. Dies bedeutet, dass die letztendliche Unparteilichkeit immer noch beim Menschen liegt. Allerdings können menschliche Gutachter bei der Verarbeitung von Daten und Inhalten persönliche Vorurteile haben, sodass sie nicht völlig neutral und umsichtig sein können

Was neu geschrieben werden muss, ist:Das obige ist der detaillierte Inhalt vonSicherheit von Azure AI-Inhalten: Microsoft veröffentlicht leistungsstarkes Tool zur Moderation von KI-Inhalten. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!