Heim >Technologie-Peripheriegeräte >KI >Ein großartiger Einblick in die autonome Fahrsimulation! Lassen Sie uns über die Branche der autonomen Fahrsimulation sprechen!

Ein großartiger Einblick in die autonome Fahrsimulation! Lassen Sie uns über die Branche der autonomen Fahrsimulation sprechen!

- PHPznach vorne

- 2023-10-17 11:17:011368Durchsuche

Hallo liebe Hörer! Es ist wieder Zeit für das Simulation Grand View Garden-Programm! Heute gebe ich Ihnen eine kurze Einführung in die Branche der autonomen Fahrsimulation.

Lassen Sie uns zunächst darüber sprechen, warum autonomes Fahren eine Simulation erfordert. Als Gast Huang Lan vor ein paar Jahren „If You Are the One“ sah, sagte er, dass sie autonomes Fahren nur akzeptieren würde, wenn zwei Drittel der Leute es akzeptieren würden, was die Sorge der breiten Öffentlichkeit um die Sicherheit des autonomen Fahrens widerspiegelte. Um die Sicherheit zu gewährleisten, müssen autonome Fahralgorithmen zahlreiche Straßentests durchlaufen, bevor sie wirklich in großem Maßstab eingesetzt werden können. Das Testen autonomer Fahrsysteme ist jedoch sehr „teuer“: Der Zeit- und Kapitalaufwand ist enorm, daher hoffen die Menschen, so viele Tests wie möglich auf Computersysteme zu verlagern und mithilfe von Simulationen die meisten Probleme im autonomen Fahrsystem aufzudecken. und die Nachfrage nach Straßentests vor Ort zu reduzieren, daher erschienen unsere Jobs.

1. Simulationsszenario

Das Simulationsszenario ist der Testfall des autonomen Fahrsystems. Gemäß der Klassifizierung des China Automotive Technology and Research Center können autonome Fahrtestszenarien in vier Hauptkategorien unterteilt werden: [natürliche Fahrszenarien] [gefährliche Arbeitsbedingungenszenarien] [Standardvorschriftenszenarien] [Parameterreorganisationsszenarien]: Natürliche Fahrszenarien werden aus den realen Bedingungen des Autos abgeleitet. Der natürliche Fahrzustand ist die grundlegendste Datenquelle bei der Erstellung autonomer Fahrtestszenarien. Zu den Szenarien unter gefährlichen Arbeitsbedingungen gehören hauptsächlich eine große Anzahl von Unwetterumgebungen, komplexer Straßenverkehr und typische Verkehrsunfälle, wie z Die CIDAS-Datenbank wird verwendet, um die Wirksamkeit des autonomen Fahrens zu überprüfen. Ein grundlegendes Testszenario besteht darin, anhand bestehender Standards und Bewertungsverfahren ein Testszenario zu erstellen, mit dem Ziel, die grundlegenden Fähigkeiten autonomer Fahrzeuge zu testen Das Szenario besteht darin, vorhandene Simulationsszenarien zu parametrisieren und zu vervollständigen. Die zufällige Generierung oder automatische Neuorganisation von Simulationsszenarien weist die Merkmale Unbegrenztheit, Skalierbarkeit, Stapelverarbeitung und Automatisierung auf.

Der Prozess zum Erstellen einer Szenenbibliothek kann grob unterteilt werden in [Daten sammeln]: das heißt, tatsächliche Straßendaten und behördliche Daten usw., [Daten verarbeiten]: das heißt, Merkmale aus den Daten extrahieren und sie zu Szenarien kombinieren, und [Anwendungsdaten]: Testen der Szenenbibliothek und Bereitstellen von Feedback.

Derzeit kann die Generierung natürlicher Fahrszenen grundsätzlich automatisiert werden: Das Sammelfahrzeug sammelt Daten in einem bestimmten Format, der Algorithmus filtert die Daten nach Schlüsselfragmenten, die nützlich sein könnten, der Algorithmus berechnet die Flugbahnen des Autos und anderes Umgebende Fahrzeuge in den Fragmentdaten, und schreiben Sie dann die Flugbahn in eine Szenenbeschreibungsdatei, beispielsweise eine Szenendatei im OpenScenario-Format. Viele vorhandene Simulationssoftware können die auf diese Weise erhaltene Szenendatei direkt für die Simulation verwenden. Es ist zu beachten, dass in diesem Fall nur die „Logik“ der tatsächlichen Bergbauszene wiederhergestellt wird. Die Teilnehmer der Szene tragen die Fahrzeugmodell-„Weste“ in der 3D-Modellbibliothek der Simulationssoftware und inszenierte Szenen aus dem wirklichen Leben. Mit anderen Worten, die auf diese Weise wiederhergestellte Szene kann zwar den Test des Steueralgorithmus bestehen, kann jedoch die Sensorerfassungsinformationen zu diesem Zeitpunkt nicht wiederherstellen, da das Vordergrundfahrzeug und der Hintergrund immer noch vom dreidimensionalen Modell abgespielt werden der Simulationssoftware. Wenn Sie nun die Sensorerkennungsinformationen wiederherstellen möchten, können Sie NERF anwenden.

Welche Simulationsszenarien sind also wertvoll? Die Wiederherstellung natürlicher Fahrdaten, die von Straßentestfahrzeugen gesammelt werden, gilt als den realen Straßenbedingungen am nächsten kommend und höchst zufällig. Aber sagen wir nicht, dass der aktuelle Straßentest zu lange dauert, um mit der Fahrt Schritt zu halten? Dazu müssen wir die Straßentestdaten verarbeiten, die Identifizierung der Verkehrsteilnehmer extrahieren und sie dann neu anordnen und kombinieren, um eine zufällige Szene basierend auf realen Daten zu bilden.

Zum Beispiel stellte die populäre Zeitung Baidu im Jahr 2019 ihr AADS-Simulationssystem vor: In diesem System scannt ein mit Lidar- und Fernglaskameras ausgestattetes Auto die Straße, um alle Materialien für die autonome Fahrsimulation zu erhalten, und bricht dann automatisch ab das eingegebene Filmmaterial in Hintergrund, Szenenbeleuchtung und Vordergrundobjekte umwandeln. Durch die Ansichtssynthesetechnologie kann der Blickwinkel auf einem statischen Hintergrund geändert werden, um echte Bilder aus jeder Perspektive zu erzeugen und so die Bewegung eines Autos zu simulieren, das in verschiedenen Umgebungen fährt. Wie beweisen Sie also die Wirksamkeit dieser Restrukturierungsszenarien? Der Artikel erwähnt eine Methode zur Bewertung durch den Vergleich der Erkennungseffekte von Wahrnehmungsalgorithmen in virtuellen Szenen und tatsächlichen Szenen. Es ist auch interessant, die Leistung des gemessenen Objekts zur Bewertung von Messwerkzeugen zu verwenden. Später nutzten auch einige NERF-Forschungen zum Thema autonomes Fahren diese Ideen, beispielsweise UniSim.

Ich persönlich glaube, dass das natürliche Fahrdatensimulationsszenario, egal wie effektiv es ist, nur zum Testen einiger Algorithmen geeignet ist: Unabhängig davon, wie diese Methode verwendet wird, werden die Flugbahnen umgebender Objekte aufgezeichnet und können nicht basierend auf dem Verhalten geändert werden des Fahrzeugs. Dies ist wie der Unterschied zwischen einem Film und einem Spiel. Die Szenen im Film können nur abgespielt werden, aber das Spiel kann die Szene basierend auf der Interaktion ändern.

Vielleicht können in naher Zukunft in Kombination mit der Verkehrsflusssimulation und realen Daten durch die zufällige Szenengenerierung stapelweise Simulationsszenen erstellt werden, die mit den realen Verkehrsbedingungen übereinstimmen und sich auch mit dem Verhalten des Fahrzeugs ändern können.

2. Simulationsentwicklung

Man kann sagen, dass die Szenenbibliothek, über die wir zuvor gesprochen haben, Daten für autonome Fahrsimulationstests vorbereitet, sodass die Simulationsentwicklungsarbeit darin besteht, Werkzeuge zu erstellen oder zu verbessern.

Die Simulationsentwicklung umfasst wahrscheinlich die folgenden Aspekte:

- [Szenariobibliothek]: Ich habe schon viel gesagt und sie wird technische Inhalte wie Datenverarbeitung, Deep Learning, Datenbanken usw. umfassen.

- [Wahrnehmung]: Mit dem In der Simulationsumgebung muss die Umgebung Informationen an den Algorithmus übertragen, sodass verschiedene Sensormodelle wie Kameras, Lidar, Millimeterwellenradar, Ultraschallradar usw. sowie Modelle auf physikalischer Prinzipebene und ideale Modelle erstellt werden müssen werden je nach Bedarf eingerichtet. Um bei der Sensormodellierung gute Arbeit zu leisten, sind theoretische Untersuchungen zum Funktionsprinzip des Sensors, Computermodellierung und technische Umsetzungsmöglichkeiten physikalischer Prozesse sowie die Unterstützung einer großen Menge experimenteller Daten erforderlich.

- [Fahrzeugdynamik]: Die vom Algorithmus ausgegebenen Steuerbefehle müssen über Steuerobjekte verfügen, daher ist ein Fahrzeugdynamikmodell erforderlich. Es wird fast ein anderes Thema sein, um das Dynamikmodell zu untersuchen, und das müssen sie auch sein in der Lage, in die autonome Fahrsimulation professionelle dynamische Modelle einzuführen oder diese zu vereinfachen.

- [Middleware]: Zwischen Algorithmen und Simulationsplattformen sowie zwischen Simulationsplattformen mit unterschiedlichen Funktionen ist ein Informationsaustausch erforderlich, sodass ein hoher Schnittstellenentwicklungsaufwand erforderlich ist. Die am häufigsten verwendete Middleware in der Forschungsphase zum autonomen Fahren ist ROS, und die am häufigsten verwendete Middleware in der Anwendungsphase ist AUTOSAR-basierte Middleware.

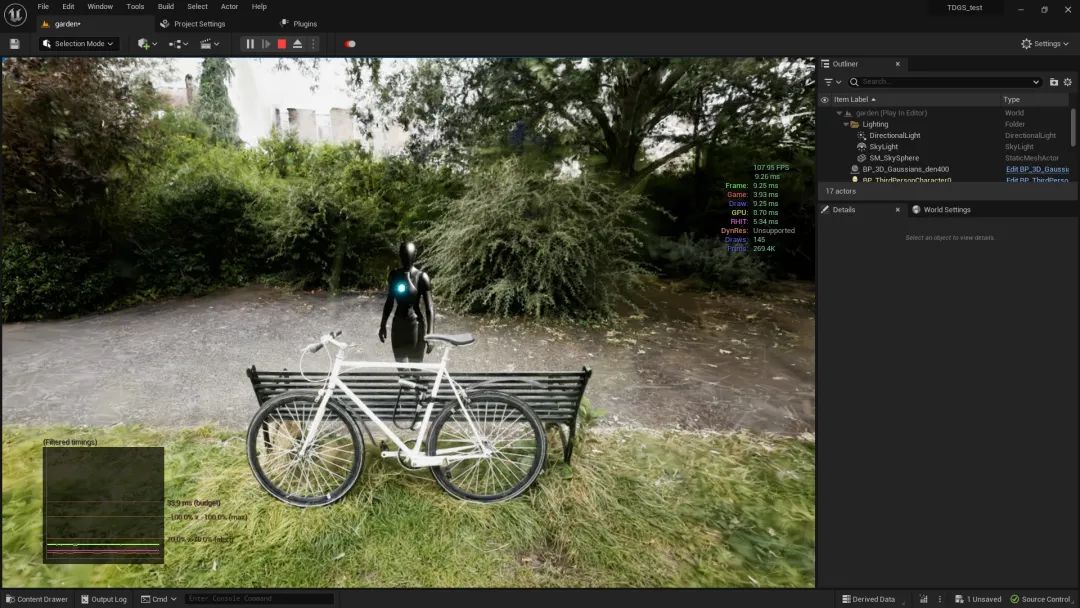

- 【Simulations-Engine】: Einige Unternehmen entwickeln gerne selbst entwickelte Simulationsplattformen, daher ist die Physik-Engine für Bewegung und Kollision verantwortlich. Häufig verwendete Open-Source-Plattformen sind ODE, Bullet, DART usw. Die Rendering-Engine ist für drei verantwortlich -dimensionale Anzeige, und die Open-Source-Versionen sind OGRE und OpenGL. Unreal und Unity sind zwei Sätze von Engines, die häufig zur Entwicklung von Spielen verwendet werden, sowohl für die Physik als auch für das Rendering.

- 【Simulationsbeschleunigung】: Es umfasst paralleles Computing, Cloud Computing usw. Auch automatisierte Tests können hier einbezogen werden.

- [Front-End]: Ich sehe, dass viele Positionen in der Simulationsentwicklung tatsächlich für das Front-End rekrutiert werden, da die Dynamik der Simulation möglicherweise eine Interaktion mit dem Display usw. erfordert.

Abschließend denke ich, dass es einen 8. Punkt mit höheren fortgeschrittenen Anforderungen geben könnte: die Fähigkeit, „nirgendwo zu klicken“. Was ist beispielsweise, wenn Ihr getestetes Objekt nur Teil des autonomen Fahrfunktionsrahmens ist? Können Sie Open-Source-Algorithmen verwenden, um den Rest zu ergänzen und den „geschlossenen Regelkreis“ laufen zu lassen?

3. Simulationstest

Mit den für den autonomen Fahrsimulationstest erforderlichen Daten und Werkzeugen ist der nächste Schritt der Simulationstest. Heute stellen wir hauptsächlich einige gängige Simulationstest-Links vor.

- [MIL Model-in-the-Loop]: Ehrlich gesagt kenne ich den Unterschied zwischen Model-in-the-Loop und Software-in-the-Loop nicht wirklich (vielleicht hängt das mit dem Aufstieg von MBSE zusammen). Methodik). Im engeren Sinne ist Model-in-the-Loop ein Test, der Tools wie MATLAB verwendet, um die logische Funktion des Algorithmus zu überprüfen, bevor der eigentliche Code geschrieben und kompiliert wird. Um es ganz klar auszudrücken: Es geht darum, das Simulink-Modell zu verwenden, um den Algorithmus zu implementieren und eine Simulation durchzuführen.

- [SIL-Software in der Schleife]: Verwenden Sie die tatsächlich kompilierte Code-Software zum Testen. Es liegt auf der Hand, dass der Model-in-the-Loop-Test nur erkennt, ob es Probleme bei der Codeproduktion gibt. Wie HIL muss SIL eine Reihe von Betriebsumgebungen und anderen vorvirtuellen Signalen bereitstellen, die nichts mit der zu testenden Funktion für das zu testende Objekt zu tun haben.

- [HIL Hardware in the Loop]: Im Großen und Ganzen kann jede Methode, bei der ein Stück Hardware in der Schleife getestet wird, als HIL bezeichnet werden, sodass das Testen eines bestimmten Sensors auch als HIL-Test bezeichnet werden kann. Im engeren Sinne beziehen wir uns im Allgemeinen auf die Controller-Hardware-in-the-Loop, die mithilfe eines Echtzeitcomputers ein Simulationsmodell ausführt, um den Betriebsstatus des gesteuerten Objekts zu simulieren, und über das I eine Verbindung zum zu testenden Steuergerät herstellt /O-Schnittstelle und führt eine umfassende, umfassende Überwachung des zu testenden Steuergeräts durch. Ausgehend von HIL sind Simulationstests erforderlich, um eine starke Echtzeitleistung zu erzielen.

- [VIL Vehicle-in-the-Loop]: Ich verstehe, dass es im Allgemeinen zwei Methoden des Vehicle-in-the-Loop gibt: Die eine besteht darin, ein Fahrzeug, das mit einem autonomen Fahrsystem ausgestattet ist, auf einem Prüfstand zu installieren und das zu entfernen Räder und ersetzen sie durch Fahrmotoren, die Lasten, Gelände und Straßenoberflächen simulieren. Die Anreize, die dem Fahrzeug gegeben werden, werden durch den Prüfstand simuliert. Bei dieser Methode kann es, wenn ein gutes Anzeigesystem hinzugefügt wird, auch als Fahrer verwendet werden -The-Loop-Simulationssystem; das andere besteht darin, dass das Fahrzeug auf einem offenen Feld fahren kann. Das Simulationssystem stellt Sensoreingaben bereit, sodass der Algorithmus auch davon ausgeht, dass es verschiedene Szenen in der Umgebung gibt, obwohl sich das Fahrzeug auf einem offenen Feld befindet Im Allgemeinen kann das Fahrzeug-GPS verwendet werden, um dem Simulationssystem Positions- und Lagerückmeldungen zu liefern.

4. Tägliche Arbeit

Ich habe in den vorherigen Abschnitten, die alle unsere Branche im Allgemeinen vorstellen, so viel gesagt, dass ich, ein blinder Mensch, herausgefunden habe Ich werde darüber sprechen, was wir im Allgemeinen jeden Tag tun. Diese täglichen Aufgaben sind natürlich im zweiten und dritten Abschnitt enthalten:

- [Wahrnehmung]: Es ist wichtig, ein Sensormodell zu erstellen. Sie müssen auf eine Reihe von Parametern jedes Sensors achten, wie z. B. Erfassungsentfernung, Erfassungswinkelbereich, Auflösung, Verzerrungsparameter, Rauschparameter, Installationsort usw ., sowie Hardware-Kommunikationsvereinbarung etc. Abhängig vom verwendeten Simulationssoftwaretool geht es dann darum, einen vorhandenen Sensortyp zu „konfigurieren“ oder auf Basis der Simulationssoftware einen neuen Sensortyp zu entwickeln. Um Algorithmusmodelle zu trainieren oder zu bewerten, müssen Simulationen häufig echte Werte liefern, wie z. B. 2D/3D-Begrenzungsrahmen, Fahrspurlinien und andere Karteninformationen, 2D/3D-Belegungsgitter usw. Wenn die vorhandenen Funktionen der Simulationssoftware nicht erfüllt werden können Um die Anforderungen zu erfüllen, ist es auch erforderlich, dass Ingenieure eine sekundäre Entwicklung durchführen.

- [Fahrzeugdynamik]: Es ist notwendig, das Fahrzeugmodell in einer professionellen Dynamiksimulationssoftware entsprechend den Fahrzeugparametern zu konfigurieren, und es ist auch notwendig, vereinfachte Kinematik- und Dynamikmodelle basierend auf vereinfachten Formeln direkt schreiben zu können.

- [Middleware]: Die Entwicklung von Schnittstellen ist ein wichtiger Teil der Arbeit und ist für die „Übersetzung“ zwischen dem Testobjekt und der Simulationssoftware verantwortlich. Der andere Teil besteht darin, die API-Schnittstelle der Software zu verwenden, um gemeinsame Simulationen zu realisieren zwischen verschiedenen Ebenen von Simulationsplattformen, wie z. B. Szenensimulation, wird mit Fahrzeugdynamiksimulation sowie Verkehrsflusssimulation kombiniert und dann in der Planung automatisierter Testmanagementsoftware vereinheitlicht.

- [Simulationsbeschleunigung]: Ich habe auch automatisierte Tests in die Simulationsbeschleunigung integriert, denn wenn damit 7x24 Stunden ununterbrochenes Testen erreicht werden kann, ist dies auch eine Möglichkeit, die Effizienz zu verbessern! Dabei geht es um den automatisierten Aufruf der Simulationsplattform, das automatisierte Schreiben von Skripten, das Aufzeichnen von Daten und das Auswerten der Daten je nach Anwendungsfallanforderungen.

- 【Softwareentwicklung】: Unternehmen, die selbst entwickelte Simulationssoftware benötigen, konzentrieren sich hauptsächlich auf diesen Geschäftsaspekt.

Noch ein Punkt 6. [Anforderungsanalyse]: Als Simulationsentwicklungsingenieur sollten Sie die Person sein, die die von Ihnen verwendeten Tools am besten kennt. Wenn also Kunden (sowohl interne als auch externe) neue Anforderungen haben, sollte der Simulationsentwicklungsingenieur dies sein Sie sind in der Lage, technische Lösungen zu entwerfen, Software- und Hardwareanforderungen sowie Projektpläne basierend auf den Anforderungen und spezifischen Bedingungen des zu testenden Objekts vorzuschlagen. Manchmal muss man also sowohl Produkt- als auch Projektmanagementaufgaben übernehmen.

5. Technology Stack

Das Wort „Technology Stack“ klingt sehr fremd, aber eigentlich sollte diese Position alles wissen. Ich habe vor langer Zeit eine Fernsehserie gesehen, in der ein Arzt in der Notaufnahme über sich selbst lachte: „Wir sind wie Schlangenöl, und andere Chirurgen sind diejenigen, die sich nie ändern können.“ Ich habe immer gedacht, dass Simulationsingenieure wie Notärzte in Krankenhäusern sind. Sie müssen alles wissen: Welchen Algorithmus sie testen müssen, und alles außer diesem Algorithmus muss vorbereitet sein, einschließlich Navigation und Positionierung, Steuerungsplanung, Datenverarbeitung, Parameterkalibrierung usw. Astronomie und Geographie, medizinische Wahrsagerei, Astrologie, Goldmalerei, Bewertungsgruppen und Weiden ... Sie müssen nicht nach einer detaillierten Erklärung fragen, und die schnelle Erfüllung der Anforderungen des Algorithmustests ist das Wichtigste.

Diese sogenannte „Gesamtübersicht“ ist der Vorteil von Simulationsingenieuren, aber nur mit einem echten Verständnis des Algorithmus können wir Simulationsarbeiten durchführen, die wirklich zur Verbesserung des Algorithmus beitragen, und wir können weiter gehen. Ich gehe zu weit, also bringen wir es zurück:

- [Code]: Hauptsächlich C++/Python, aber wenn es um den Front-End-Anzeigeteil geht, verstehe ich es nicht. Im Allgemeinen sind die Anforderungen definitiv nicht so hoch wie bei der Algorithmenentwicklung, aber wenn man sich auf die Entwicklung von Simulationssoftware spezialisiert hat, ist das eine andere Sache.

- 【ROS】: Ich habe es hervorgehoben, weil ROS immer noch ein unvermeidlicher Teil des Bereichs der autonomen Fahr- und Roboteralgorithmusforschung ist und die ROS-Community viele vorgefertigte Tools bereitstellt.

- 【Fahrzeugdynamik】: Sie müssen vielleicht nicht so viel wissen wie ein echter Fahrzeugingenieur, aber Sie müssen die Grundprinzipien kennen. Darüber hinaus müssen Sie sich mit verschiedenen Koordinatenumrechnungen auskennen (dazu gehören möglicherweise nicht Fahrzeuge, sondern Mathematik).

- 【Sensorprinzip】: Wie funktionieren verschiedene Sensoren wie Kameras, Lidar und Millimeterwellenradar bei autonomen Fahrzeugen, wie sehen die Ausgangssignale aus und was sind die Schlüsselparameter.

- [Map]: Sie müssen die in Simulationstestszenarien verwendeten Dateiformate wie OpenDrive und OpenScenario verstehen, da manchmal Informationen daraus als Eingabe für die Sensorsimulation extrahiert werden müssen.

Das Obige ist nur meine persönliche Zusammenfassung, Kollegen können hier gerne hinzufügen!

Der Vollständigkeit halber werde ich in diesem Abschnitt auch einige häufig verwendete Simulationssoftware auf dem Markt kurz vorstellen (es ist wirklich keine Werbung! Lassen Sie sich nicht entmutigen, wenn sie nicht auf der Liste steht).

- CarSim/CarMaker: Beide Programme sind leistungsstarke Dynamiksimulationssoftware und werden von OEMs und Zulieferern auf der ganzen Welt häufig verwendet. Sie können auch einige Straßenszenen simulieren.

- Vissim/SUMO: Vissim ist eine weltweit führende mikroskopische Verkehrsflusssimulationssoftware des deutschen Unternehmens PTV. Vissim kann problemlos verschiedene komplexe Verkehrsumgebungen konstruieren und auch das interaktive Verhalten von Kraftfahrzeugen, Lastkraftwagen, Schienenverkehr und Fußgängern in einer Simulationsszene simulieren. SUMO ist eine Open-Source-Software, die durch interaktive Bearbeitung Straßen hinzufügen, Spurverbindungsbeziehungen bearbeiten, Kreuzungsbereiche verarbeiten, Signallichtzeiten bearbeiten usw. kann.

- PreScan: Die von Siemens übernommenen Hauptschnittstellen zum Erstellen und Testen von Algorithmen umfassen MATLAB und Simulink, die für MIL, SIL und HIL verwendet werden können.

- VTD: Als kommerzielle Software verfügt VTD über eine hohe Zuverlässigkeit und umfassende Funktionen und umfasst Straßenumgebungsmodellierung, Verkehrsszenenmodellierung, Wetter- und Umgebungssimulation, einfache und physikalisch realistische Sensorsimulation, Szenensimulationsmanagement und hochpräzise Echtzeitbilder Rendering usw. Es ist keine Übertreibung zu sagen, dass VTD die am häufigsten verwendete Simulationssoftware unter inländischen OEMs ist. Es kann den gesamten Entwicklungsprozess von SIL zu HIL und VIL unterstützen, und das offene modulare Framework kann problemlos mit Tools und Plug-Ins von Drittanbietern simulieren.

- CARLA/AirSim: Zwei Open-Source-Simulationsplattformen, die beide auf UE entwickelt wurden, haben auch Unity-Versionen herausgebracht. CARLA kann Szenen erstellen und hochpräzise Karten unterstützen und unterstützt die flexible Konfiguration von Sensoren und Umgebungen. Es unterstützt mehrere Kameras, Lidar, GPS und andere Sensoren und kann auch die Beleuchtung und das Wetter der Umgebung anpassen. Microsofts AirSim verfügt über zwei Modi: Drohne und Fahrzeug. Die Funktionen im Fahrzeugmodus sind nicht einfach. Die Community ist nicht so aktiv wie CARLA Die Rekrutierung von Leuten, die in Zukunft JD schreiben sollen, nützt nicht viel. Darüber hinaus hat die inländische Sangxin-Technologie kürzlich OASIS auf den Markt gebracht, das auf CARLA basiert und derzeit als erweiterte Version des Open-Source-CARLA angesehen werden kann.

- 51SimOne/PanoSim: Bei diesen beiden handelt es sich um inländische Simulationssoftware, die die Hauptfunktionen von Szenensimulationssoftware erfüllen kann.

Zum Schluss noch ein LGSVL: Der Vorteil von LGSVL besteht ursprünglich darin, dass es besser in Apollo integriert ist. Ich habe jedoch gehört, dass das offizielle LGSVL dieses Projekt aufgegeben hat, daher rate ich Ihnen, diese Falle aufzugeben.

6. Lernpfad

Ich glaube, dass kluge Schüler durch meine Einführung in den ersten fünf Abschnitten bereits den Lernpfad zum Simulationsingenieur für autonomes Fahren verstehen können, und durch die Kritik am Inhalt meiner ersten fünf Abschnitte, Auch junge Kollegen können lernen, weiterzukommen. Aber in diesem Abschnitt schreibe ich immer noch einige oberflächliche Verständnisse in dieser Hinsicht.

Ich habe schon so viel gesagt, ich denke, Sie können auch erkennen, dass die Simulation des autonomen Fahrens ein multidisziplinäres Feld ist, das Studenten aus vielen Hauptfächern aufnehmen kann, einschließlich, aber nicht beschränkt auf: Computer/Steuerung/Roboter/Maschinen/Fahrzeuge /Leistungselektronik usw.

In Bezug auf Erfahrung und Technologie werde ich versuchen, einige Jobanforderungen aufzulisten:

- Codierungsfähigkeiten: Studierende, die Simulations-Cloud-Computing, Cloud-Server und andere verwandte Entwicklungen betreiben, müssen möglicherweise mit C++/Go/Java für die Entwicklung vertraut sein, über gute Programmiergewohnheiten verfügen und mit gängigen Entwurfsmustern, Datenstrukturen und Algorithmen vertraut sein mit Linux-Systemen, Docker-Technologie und Kubernetes-bezogenem Wissen sowie Erfahrung in der Cloud-Service-Entwicklung. Diese zielen auf eine selbst entwickelte Simulationstestplattform mit hoher Parallelität, hoher Wiederverwendung und hoher Automatisierung ab. Darüber hinaus erfordern Positionen für selbst entwickelte Simulationssoftware möglicherweise neben einer soliden Computergrundlage Erfahrung in der Game-Engine-Entwicklung, sodass Studierende, die sich mit der Spieleentwicklung beschäftigen, auch auf autonome Fahrsimulation (einschließlich technischer Kunst) umsteigen können. Studierende, deren Ziel es ist, vorhandene Simulationssoftware für die sekundäre Entwicklung und Integration zu nutzen, müssen möglicherweise C/C++ und Python beherrschen und mit der Linux/ROS-Entwicklung vertraut sein. Besser wäre es, wenn sie Erfahrung in der Entwicklung von Middleware für die Automobilindustrie hätten wie AUTOSAR.

- Software-Erfahrung: Natürlich ist jede tatsächliche Erfahrung im Umgang mit Simulationssoftware für autonomes Fahren von Vorteil, aber da die meiste kommerzielle Software sehr teuer ist, hängt sie in dieser Hinsicht stark von der Stärke des Schullabors oder des Unternehmens ab. Da es keine kommerzielle Softwareunterstützung gibt, denke ich, dass CARLA jetzt die optimale Lösung für Open-Source-Software ist.

- Fachwissen: Ich persönlich glaube, dass es als Ingenieur für autonomes Fahren unmöglich ist, ein umfassendes Verständnis des Algorithmus für autonomes Fahren zu erlangen, einschließlich aller Aspekte der prinzipiellen Implementierung des Algorithmus Wir machen bessere Simulationen. Darüber hinaus ist es für Studierende ohne Hauptfach Computer sehr wichtig, die Fachkurse in diesem Bereich gut zu erlernen, z. B. Maschinen, Fahrzeuge, Mechanik, Elektronik usw. Wenn Sie aufrecht sind, werden Sie es sein erstaunlich und wird immer verwendet.

Die aktuelle autonome Fahrbranche unterliegt großen Schwankungen, aber zusammenfassend sind die wichtigsten Arten von Unternehmen, die Simulationsingenieure einsetzen können, die folgenden Arten von Unternehmen: OEMs, die hauptsächlich Simulationssoftware für Anwendungsformen integrieren, aber neue Kräfte müssen dies grundsätzlich tun Führen Sie eigene Forschung durch. Anbieter von autonomen Fahrlösungen, also Tier-1-Algorithmen, sind möglicherweise auch die meisten selbst entwickelten Simulationssoftwareunternehmen, die in diesem Bereich gerade erst begonnen haben.

Am Ende dieses Abschnitts werde ich über meine Erfahrungen beim „Umstieg“ von traditionellen Maschinen sprechen. Die Schule, an der ich meinen Master-Abschluss gemacht habe, hat eine starke Transkodierungskultur. Von den chinesischen Studenten, die in meiner Klasse die Graduiertenschule für Maschinenbau besuchten, waren etwa 78 von zehn nach ihrem Abschluss in der Computerbranche tätig. Aufgrund des relativ lockeren Kurseauswahlsystems werden Studierende dazu ermutigt, möglichst viele Kurse der Fakultät für Informatik zu belegen. In diesen zwei Jahren wurde Salböl verbrannt, um die Sonnenuhr zu erhalten, und Armut war die Norm. Aber ich kann mich nicht erinnern, ob ich die Prüfung bestehen musste, um einen Job zu finden. Mit einem Wort: Wie verwandeln sich Maschinen in Computer? Machen Sie einen halben Abschluss in Informatik. Tatsächlich veränderten sich zu dieser Zeit nicht nur die Mechanik, sondern alle Hauptfächer, und zwar nicht nur chinesische Studenten, sondern Menschen auf der ganzen Welt.

Aber im Nachhinein wurde mir klar, dass ich nicht in der gleichen Situation war, also habe ich die beste Gelegenheit zur Transformation verpasst. Beim Selbststudium ist es viel schwieriger: Das Wichtigste ist, dass die Zeit fehlt, die effiziente Lernmaterialien und -methoden erfordert. Daher sind Online-Kurse relativ gesehen effizienter, schließlich gibt es Lehrer, die Sie anleiten. Die Kurse von Coursera sind gut, scheinen aber relativ teuer zu sein. In den letzten Jahren gab es immer mehr Open-Source-Netzwerkressourcen, aber die Kurse sind nicht allzu ausgefeilt. Schließlich sind Computer am praktischsten und am einfachsten zu üben. Es gibt auch viele klassische Computerbücher, wie Datenstrukturen und Algorithmen, C++-Grundlagen ... Ich habe noch nie eines davon gelesen. Manche Dinge gehen wirklich verloren, wenn sie einmal übersehen werden.

Tatsächlich denke ich, dass eine der einfachsten Möglichkeiten zur Transformation darin besteht, sich direkt auf computerbezogene Arbeit einzulassen. Der schnellste Weg, die Nachfrage zu steigern, besteht darin, die oben erwähnten Lernrichtungs- und Zeitprobleme zu lösen. Sollte es jedoch aufgrund dessen zu einem Problem kommen, dass die Leistung nicht dem Standard entspricht, tun Sie einfach so, als hätte ich nichts dazu gesagt.

7. Über NERF In nur wenigen Jahren ist NERF nicht mehr das einfache MLP+Volumen-Rendering mehr, das es bei seinem Debüt war. Es gibt verschiedene Träger zum Speichern räumlicher Informationen: Hash-Tabellen, Voxelgitter, mehrdimensionale Gauß-Funktionen ... Auch neue Bildgebungsmethoden Es taucht endlos auf: U-Net, CNN, Rasterisierung ... die Richtung des autonomen Fahrens ist nur ein kleiner Anwendungszweig von NERF. Wenn NERF auf die Simulation autonomen Fahrens angewendet wird, treten hauptsächlich die folgenden Probleme auf:

Die Methode zur Erfassung autonomer Fahrdaten führt dazu, dass der Umfang der Szene „nicht geschlossen“ wird: Außenszenen enthalten eine große Anzahl entfernter Ansichten , was ein Problem für die räumliche Informationsspeicherung von NERF darstellt; autonome Fahrszenen enthalten eine große Anzahl dynamischer Objekte, und NERF muss in der Lage sein, die Trennung von dynamischen und statischen Objekten (oder Vordergrund- und Hintergrundmodellen) zu bewältigen Im Allgemeinen verfügen sie nicht über Übertragungsfunktionen, und jede Szene muss möglicherweise ein separates NERF-Modell trainieren. Das Training von NERF ist immer noch relativ langsam, sodass es immer noch Probleme bei der groß angelegten Anwendung von NERF auf autonome Fahrdaten gibt.

Dennoch freue ich mich immer noch darauf und bin davon überzeugt, dass NERF eine disruptive Entwicklung in der autonomen Fahrsimulation bewirken, schließlich die Domänenlücke im Wahrnehmungsalgorithmus der Simulation schließen und sogar noch mehr bewirken wird. Den Informationen nach zu urteilen, die ich erhalten habe, wird NERF zumindest die folgenden Durchbrüche bringen:

NERFs neue Fähigkeit zur perspektivischen Bildsynthese kann den Trainingsdatensatz des Wahrnehmungsalgorithmus verbessern: Es kann neue sensorinterne Parameter generieren (entspricht einer Änderung der Sensorkonfiguration). , externe Bilder, Lidar-Punktwolken und andere Daten unter dem Parameter (modifizierte Flugbahn des eigenen Fahrzeugs) können weitere Trainingsdaten für den Wahrnehmungsalgorithmus liefern. In diesem Zusammenhang können Sie auf Untersuchungen wie StreetSurf und UniSim verweisen. Wenn dynamische Objekte bearbeitet werden können, kann NERF in Zukunft gezielt Extremsituationen und Zufallssituationsszenarien generieren, um die Mängel einfacher Fahrtests und WorldSim zu ergänzen. Wenn NERF die Trainingsrekonstruktion und das Echtzeit-Rendering von Szenen auf Stadtebene gleichzeitig effektiv lösen kann, kann NERF vollständig als Plattform für XIL-In-the-Loop-Simulationstests verwendet werden, ohne dass das Problem der Erkennung von Datendomänenlücken auftritt. und es wird auch die End-to-End-Entwicklung von End-to-End-Algorithmen fördern. Darüber hinaus kann das NERF-Modell sogar als Plug-In in die Spiel-Engine eingefügt werden (z. B. wurde das UE-Plug-In für 3D-Gaußsches Splatting veröffentlicht), sodass die Straßenszenenrekonstruktion von NERF in das ursprüngliche WorldSim-System integriert werden kann . In Kombination mit großen Modellen in AIGC-Richtung bietet NERF mehr Möglichkeiten zur Generierung neuer Szenen: Beleuchtung, Wetter, Aussehen und Verhalten von Objekten usw. können beliebig bearbeitet werden.

Als Simulationsingenieur empfehle ich den Kollegen daher dringend, den Fortschritt von NERF genau zu beobachten. Obwohl sich die Forschungsprojekte von NERF noch in einem frühen Stadium befinden, schreitet der Fortschritt des Deep Learning mit der Beschleunigung der Hardware immer schneller voran.

8. Am Ende geschrieben

Ich habe so viel Verschiedenes geschrieben, und am Ende habe ich noch einige Gedanken.

Was sind die Fallstricke der Simulationsentwicklung? Die technischen Fallstricke werden hier nicht besprochen, aber hier einige allgemeine Gedanken. Seien Sie vorsichtig, wenn Sie sich nicht zu sehr auf bedeutungslose Arbeiten einlassen: Die Durchführung ähnlicher Projekte für verschiedene Personen zählt nicht. Der Abschluss jedes einzelnen Projekts ist wertvoll, wenn Sie keine vorgefertigten Tools verwenden und selbst Nachforschungen anstellen müssen Auf lange Sicht wird es keine Rolle spielen, es ist wertvoll, sich von der Abhängigkeit von bestimmten Werkzeugen zu lösen. Viele Versuche in Forschung und Entwicklung, die sich später als unvernünftig erwiesen, können nicht gezählt werden, und das Scheitern von Forschung und Entwicklung ist ebenfalls wertvoll. Was genau ist also „sinnlose“ Arbeit? Das ist Ansichtssache und ich kann es nicht gut zusammenfassen.

Und was kann ich aus dieser Position heraus tun? Wenn Sie ein tiefes Verständnis für das zu messende Objekt haben, können Sie versuchen, in eine bestimmte Richtung in die Algorithmenentwicklung zu wechseln. Sie können auch die Simulationsentwicklung von Robotern und Drohnen in Betracht ziehen.

Es versteht sich von selbst, dass mobile Roboter und autonomes Fahren Ähnlichkeiten aufweisen. Die Drohnenindustrie ist sicherlich nicht so groß wie die Automobilindustrie, verfügt aber bereits über Landeplätze wie Inspektionen, Luftaufnahmen, Vermessungen und Kartierungen usw. UAVs benötigen auch automatische Steuerungsalgorithmen zur Hindernisvermeidung, Wegplanung usw. Die von UAVs verwendeten Sensoren ähneln denen unbemannter Fahrzeuge. Daher kann man sagen, dass Simulationstests etwas gemeinsam haben: UAVs benötigen auch eine umfassende Wahrnehmung Eingaben wie Bilder und Radarpunktwolken erfordern ausgefeiltere dynamische Modelle usw.

Studenten, die sich für Roboter- und Drohnensimulation interessieren, können mit der Open-Source-Simulationsplattform Gazebo (https://classic.gazebosim.org/) beginnen. Der Bedarf an Rechenressourcen wird nicht so hoch sein wie bei Nvidias Isaac.

Dieses Jahr ist das elfte Jahr, seit OSRF von Willow Garage unabhängig wurde, und die Roboterbetriebssysteme ROS und Gazebo haben eine Entwicklungsgeschichte von mehr als 20 Jahren. Gazebo hat sich nach und nach von einem wissenschaftlichen Forschungstool einer Graduierten-Forschungsgruppe zu einem unabhängigen Simulationssoftwaretool mit heute 11 Versionen und 7 Zündungsversionen der zweiten Generation entwickelt.

Gazebo unterstützt Physik-Engines wie ODE und Bullet. Es verwendet OGRE als Rendering-Engine, um eine dreidimensionale Umgebung zu erstellen und Informationen von verschiedenen Sensoren wie Kameras und Lidar zu simulieren. Von Roboterarmen über Radroboter bis hin zu humanoiden Robotern. Noch wichtiger ist, dass Gazebo natürlich umfassende Unterstützung für Algorithmen unter der ROS-Plattform bietet: Wenn Sie schließlich eine Desktop-Vollversion von ROS herunterladen und installieren, wird Gazebo mitgeliefert. Als Open-Source-Software bietet Gazebo natürlich nur einen Ausgangspunkt. Seine Funktionen sind ausgewogen, aber es ist grob und nicht in allen Aspekten tiefgreifend. Aber genau wie Taizu Changquan wird Qiao Feng immer noch anders sein, wenn er es im Juxian Village einsetzt.

Ich kam mit Gazebo in Kontakt, als ich noch zur Schule ging. Später arbeitete ich in der Robotersimulation und nutzte Gazebo, bis ich zum autonomen Fahren wechselte. Es ist, als wären Gazebo und ich damals Klassenkameraden gewesen. Nach der Arbeit trafen sie und ich uns wieder und beschlossen, unsere Beziehung zu erneuern. Jetzt, da wir über 30 Jahre alt sind, hinterließ ich ihr eine Nachricht: Ich möchte eine bessere Entwicklung haben, also ich werde sie verlassen... Jetzt werde ich zum Abschied nur noch eins sagen: Lange nicht gesehen...

Originallink: https://mp.weixin.qq.com/s/_bOe_g3mqoobJUbFS3SNWg

Das obige ist der detaillierte Inhalt vonEin großartiger Einblick in die autonome Fahrsimulation! Lassen Sie uns über die Branche der autonomen Fahrsimulation sprechen!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Was sind die Merkmale der 5G-Technologie?

- Was sind die Anwendungsgebiete der Blockchain-Technologie?

- Ein Artikel über autonome Fahrentscheidungssysteme

- Chen Guanling, technischer Partner von Fuyou Trucks: Anwendung des autonomen Fahrens in der Kofferraumlogistik

- Autonomes Fahren lässt sich durch Dimensionsreduktion nur schwer angreifen