Heim >Technologie-Peripheriegeräte >KI >Das Ali-Riesenmodell ist wieder Open Source! Es verfügt über vollständige Bildverständnis- und Objekterkennungsfunktionen. Es basiert auf dem allgemeinen Problemsatz 7B und ist für kommerzielle Anwendungen geeignet.

Das Ali-Riesenmodell ist wieder Open Source! Es verfügt über vollständige Bildverständnis- und Objekterkennungsfunktionen. Es basiert auf dem allgemeinen Problemsatz 7B und ist für kommerzielle Anwendungen geeignet.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-09-03 13:01:08780Durchsuche

Alibaba hat ein neues großes Modell als Open Source bereitgestellt, was sehr aufregend ist ~

Nach Tongyi Qianwen-7B(Qwen-7B) hat Alibaba Cloud das groß angelegte visuelle Sprachmodell Qwen-VL auf den Markt gebracht, und das wird auch so sein direkt Open Source, sobald es online geht.

Qwen-VL ist ein großes multimodales Modell, das auf Tongyi Qianwen-7B basiert. Insbesondere unterstützt es mehrere Eingaben wie Bilder, Text und Erkennungsrahmen und kann nicht nur Text, sondern auch Erkennungsrahmen ausgeben Ausgabe

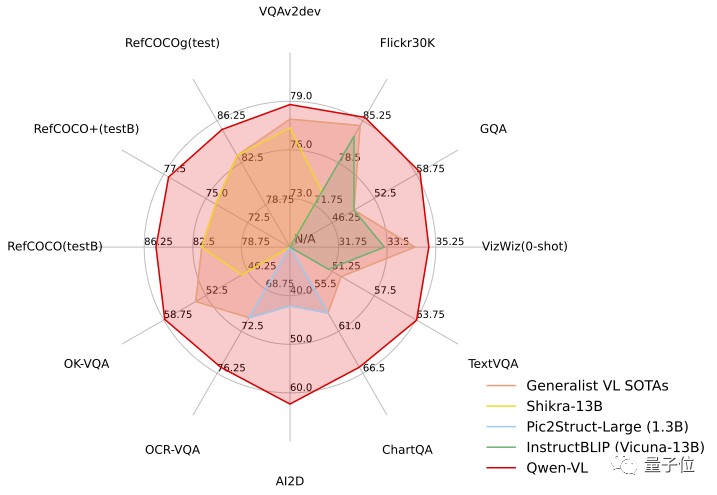

Zum Beispiel geben wir ein Bild von Aniya ein. Durch die Form von Frage und Antwort kann Qwen-VL-Chat den Inhalt des Bildes zusammenfassen und Aniya im Bild genau lokalisieren. Qwen-VL demonstrierte die Stärke des „Hexagonal Warrior“ und belegte den ersten Platz in der standardmäßigen englischen Bewertung der vier Hauptkategorien multimodaler Aufgaben (Zero-shot Caption/VQA/DocVQA/Grounding).

Sobald die Open-Source-Nachrichten herauskamen, erregten sie sofort große Aufmerksamkeit

Werfen wir einen Blick auf die konkrete Leistung!

Werfen wir einen Blick auf die konkrete Leistung!

Das erste allgemeine Modell, das die chinesische Open-Domain-Positionierung unterstützt

Mehrsprachiger Dialog: Unterstützt mehrsprachigen Dialog, Ende -durchgängige Unterstützung für Chinesisch und Englisch in Bildern. Zweisprachige Langtexterkennung erstes allgemeines Modell zur Unterstützung der chinesischen Open-Domain-Positionierung: Erkennung von Frame-Anmerkungen durch chinesische Open-Domain-Sprachausdrücke, d Anderes Open-Source-LVLM

(groß angelegtes visuelles Sprachmodell)

- , Qwen-VL ist das erste Open-Source-LVLM-Modell mit einer Auflösung von 448. Eine höhere Auflösung kann die feinkörnige Texterkennung, die Beantwortung von Dokumentfragen und die Annotation von Erkennungsfeldern verbessern.

- Ohne die ursprüngliche Bedeutung zu ändern, muss der Inhalt neu geschrieben werden: Qwen-VL kann in Szenarien wie Wissensfrage und -antwort, Bildfrage und -antwort, Dokumentfrage und -antwort, feinkörniger visueller Positionierung usw. verwendet werden .

- Zum Beispiel versteht ein ausländischer Freund es nicht. Wenn Sie auf Chinesisch ins Krankenhaus gehen, um einen Arzt aufzusuchen, durch die Navigationskarte verwirrt sind und nicht wissen, wie Sie zur entsprechenden Abteilung gelangen, können Sie die Bilder direkt weitergeben und Fragen an Qwen-VL und lassen Sie es als Übersetzer auf der Grundlage der Bildinformationen fungieren (manueller Hundekopf)

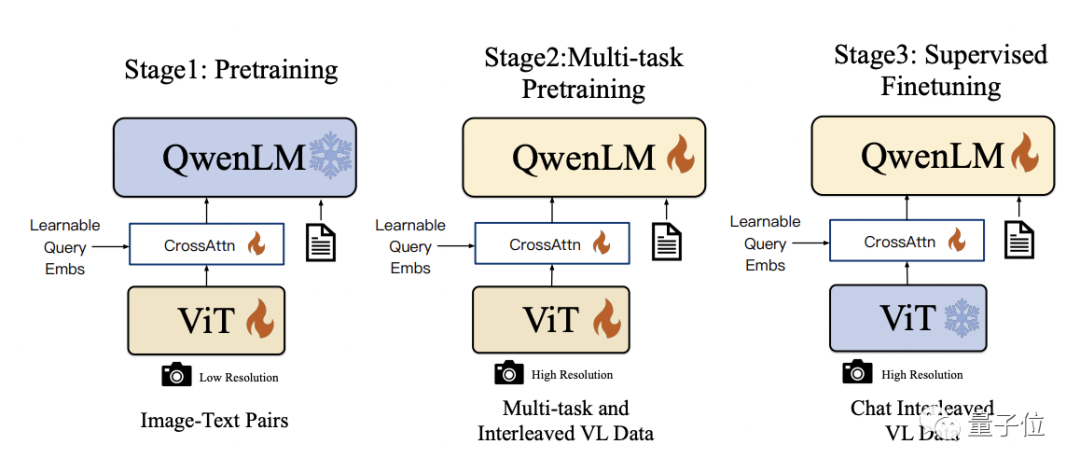

- In Bezug auf die visuelle Positionierungsfähigkeit kann Qwen-VL auch dann, wenn das Bild sehr komplex ist und viele Charaktere vorhanden sind, den Anforderungen gerecht werden. Hulk und Spider-Man genau identifizieren In technischen Details verwendet Qwen-VL Qwen-7B als Basissprachenmodell. Durch die Einführung des visuellen Encoders ViT und des positionsbewussten visuellen Sprachadapters kann das Modell die visuelle Signaleingabe unterstützen

Der spezifische Trainingsprozess ist in drei Schritte unterteilt:

- Vor dem Training: Optimieren Sie nur den visuellen Encoder und den visuellen Sprachadapter und frieren Sie das Sprachmodell ein. Bei Verwendung umfangreicher gepaarter Bild-Text-Daten beträgt die Eingabebildauflösung 224 x 224.

- Multitasking-Vortraining: Führen Sie visuelle Multitasking-Sprachdaten mit höherer Auflösung (448 x 448) wie VQA, Text-VQA, referenzielles Verständnis usw. für das gemeinsame Vortraining mit mehreren Aufgaben ein.

- Überwachte Feinabstimmung: Visuelle Encoder einfrieren, Sprachmodelle und Adapter optimieren. Verwenden Sie Dialoginteraktionsdaten zur sofortigen Abstimmung, um das endgültige Qwen-VL-Chat-Modell mit interaktiven Funktionen zu erhalten.

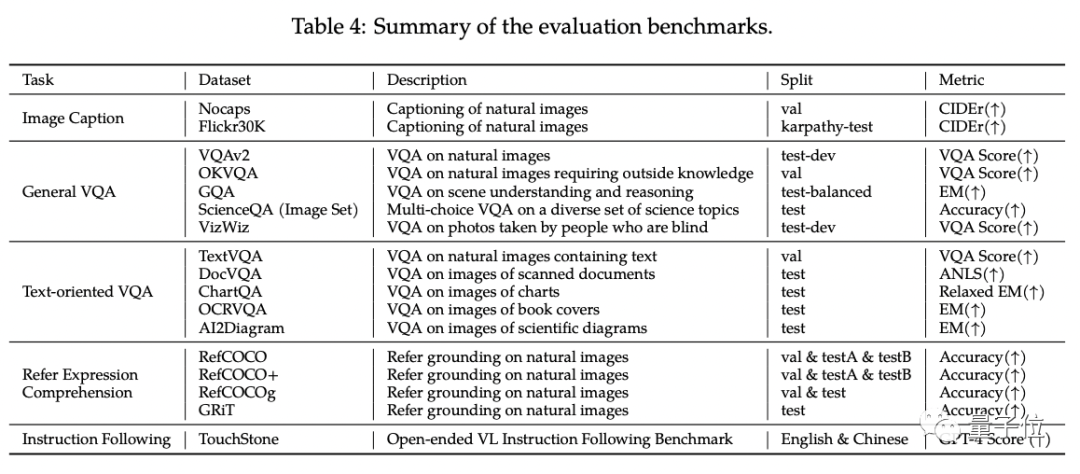

In der standardmäßigen englischen Bewertung von Qwen-VL testeten die Forscher vier Hauptkategorien multimodaler Aufgaben (Zero-shot Caption/VQA/DocVQA/Grounding)

Den Ergebnissen zufolge war Qwen-VL das Beste Ergebnisse wurden beim Vergleich mit Open-Source-LVLM derselben Größe erzielt. Darüber hinaus erstellten die Forscher einen Testsatz

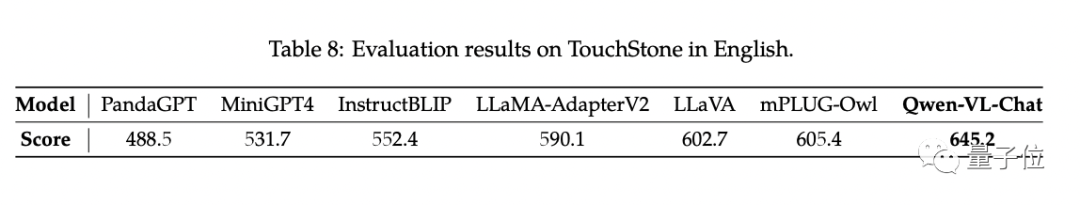

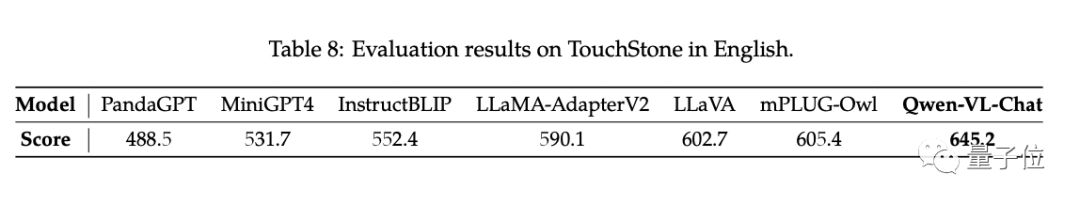

TouchStonebasierend auf dem GPT-4-Bewertungsmechanismus.

Qwen-VL-Chat hat in diesem Vergleichstest den neuesten Stand der Technik (SOTA) erreicht

Qwen-VL-Chat hat in diesem Vergleichstest den neuesten Stand der Technik (SOTA) erreicht

Wer sich für Qwen-VL interessiert, findet die Demo auf der Magic Community und Huggingface Kommen Sie vorbei und probieren Sie es direkt aus. Der Link befindet sich am Ende des Artikels

Qwen-VL unterstützt Forscher und Entwickler bei der Sekundärentwicklung und ermöglicht die kommerzielle Nutzung. Es ist jedoch zu beachten, dass Sie, wenn Sie es kommerziell nutzen möchten, zuerst den Fragebogenantrag ausfüllen müssen

Projektlink: https://modelscope.cn/models/qwen/Qwen-VL/summary

https://modelscope .cn/models/qwen/Qwen-VL-Chat/summary

https://huggingface.co/Qwen/Qwen-VL

https://huggingface.co/Qwen/Qwen -VL-Chat

https://github.com/QwenLM/Qwen-VL

Das obige ist der detaillierte Inhalt vonDas Ali-Riesenmodell ist wieder Open Source! Es verfügt über vollständige Bildverständnis- und Objekterkennungsfunktionen. Es basiert auf dem allgemeinen Problemsatz 7B und ist für kommerzielle Anwendungen geeignet.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!