Heim >Technologie-Peripheriegeräte >KI >Metas Open-Source-FACET-Tool zur Bewertung rassistischer und geschlechtsspezifischer Vorurteile in KI-Modellen

Metas Open-Source-FACET-Tool zur Bewertung rassistischer und geschlechtsspezifischer Vorurteile in KI-Modellen

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-09-03 08:25:091130Durchsuche

IT House berichtete am 2. September, dass zur Linderung des Problems der systemischen Voreingenommenheit gegenüber Frauen und farbigen Menschen in vielen aktuellen Computer-Vision-Modellen vor Kurzem ein neues KI-Tool namens FACET zur Identifizierung von Computer-Vision-Systemen eingeführt wurde.

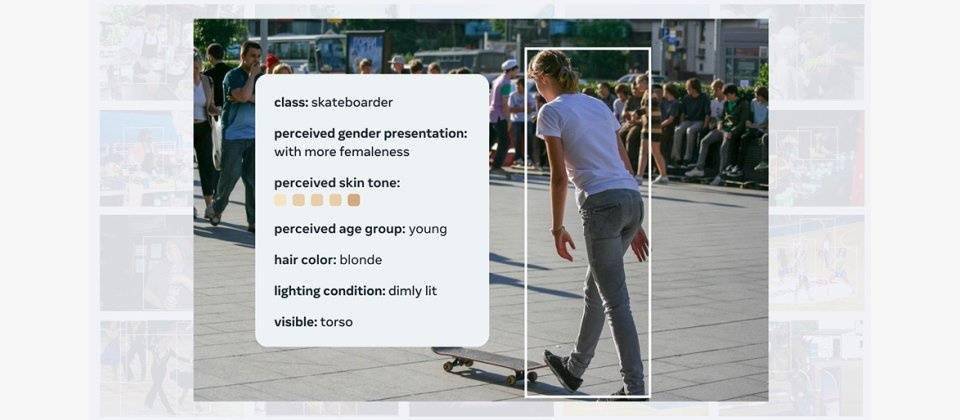

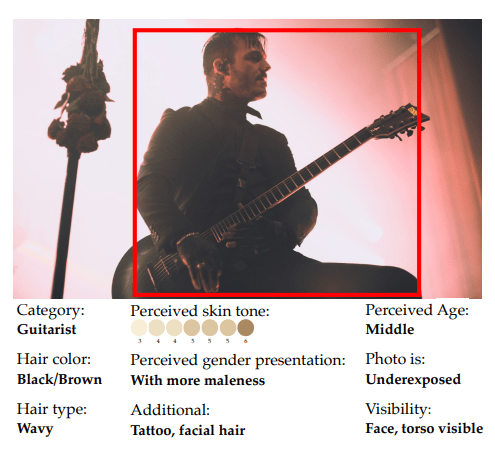

Das FACET-Tool ist derzeit auf 30.000 Bilder trainiert, darunter Bilder von 50.000 Personen. Es verbessert insbesondere die Wahrnehmung von Geschlecht und Hautfarbe und kann zur Bewertung verschiedener Merkmale von Computer-Vision-Modellen verwendet werden.

Nach der Schulung ist das FACET-Tool in der Lage, komplexe Fragen zu beantworten. Wenn die Person beispielsweise als männlich erkannt wird, können Skateboarder sowie helle oder dunkle Haut

weiter identifiziert werden

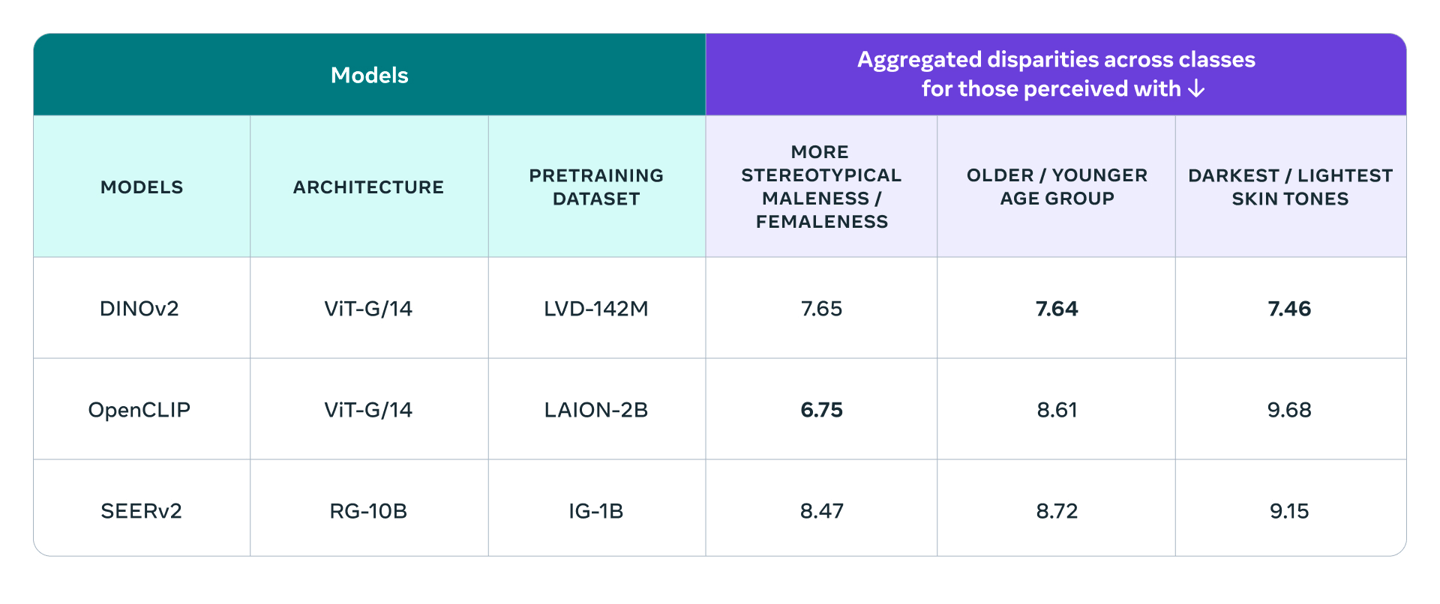

Meta verwendet FACET, um das vom Unternehmen entwickelte Modell DINOv2 und SEERv2 sowie das OpenCLIP-Modell von OpenAI zu bewerten. Insgesamt schneidet OpenCLIP in Bezug auf Geschlecht besser ab, während DINOv eine bessere Leistung bei der Beurteilung von Alter und Hautfarbe aufweist.

Open Sourcing FACET wird Forschern dabei helfen, ein ähnliches Benchmarking durchzuführen, um Verzerrungen in ihren eigenen Modellen zu verstehen und die Auswirkungen von Abhilfemaßnahmen zur Lösung von Gerechtigkeitsproblemen zu überwachen. IT House fügt hier die Adresse der Meta-Pressemitteilung bei, und interessierte Benutzer können sie ausführlich lesen. Das Open-Source-Angebot FACET wird Forschern dabei helfen, ähnliche Benchmarks durchzuführen, um die in ihren Modellen vorhandene Verzerrung zu verstehen und die Auswirkungen der Einführung fairer Lösungsmaßnahmen zu überwachen. Einen Link zur Pressemitteilung von Meta stellt IT House hier zur Verfügung. Interessierte Benutzer können diese ausführlich lesen

Das obige ist der detaillierte Inhalt vonMetas Open-Source-FACET-Tool zur Bewertung rassistischer und geschlechtsspezifischer Vorurteile in KI-Modellen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr