Heim >Technologie-Peripheriegeräte >KI >Auch Papierillustrationen können mithilfe des Diffusionsmodells automatisch generiert werden und werden auch vom ICLR akzeptiert.

Auch Papierillustrationen können mithilfe des Diffusionsmodells automatisch generiert werden und werden auch vom ICLR akzeptiert.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-06-27 17:46:101509Durchsuche

Generative KI hat die Community der künstlichen Intelligenz im Sturm erobert. Sowohl Einzelpersonen als auch Unternehmen sind daran interessiert, entsprechende modale Konvertierungsanwendungen wie Vincent-Bilder, Vincent-Videos, Vincent-Musik usw. zu erstellen.

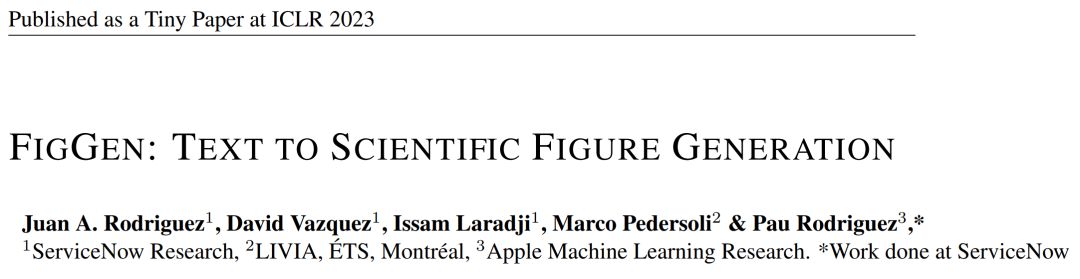

Vor kurzem haben mehrere Forscher von wissenschaftlichen Forschungseinrichtungen wie ServiceNow Research und LIVIA versucht, Diagramme in Aufsätzen basierend auf Textbeschreibungen zu erstellen. Zu diesem Zweck schlugen sie eine neue Methode von FigGen vor, und das zugehörige Papier wurde auch als Tiny Paper in ICLR 2023 aufgenommen.

Bilder

Bilder

Papieradresse: https://arxiv.org/pdf/2306.00800.pdf

Manche Leute fragen sich vielleicht: Was ist so schwierig daran, die Diagramme in dem Papier zu erstellen? Wie hilft dies der wissenschaftlichen Forschung?

Die Generierung wissenschaftlicher Forschungsdiagramme trägt dazu bei, Forschungsergebnisse prägnant und leicht verständlich zu verbreiten, und die automatische Generierung von Diagrammen kann Forschern viele Vorteile bringen, wie z . Darüber hinaus kann die Gestaltung optisch ansprechender und leicht verständlicher Abbildungen das Papier für mehr Menschen zugänglich machen.

Die Erstellung von Diagrammen ist jedoch auch mit einigen Herausforderungen verbunden. Sie müssen komplexe Beziehungen zwischen einzelnen Komponenten wie Kästchen, Pfeilen, Text usw. darstellen. Im Gegensatz zur Generierung natürlicher Bilder können Konzepte in Papierdiagrammen unterschiedliche Darstellungen haben und ein detailliertes Verständnis erfordern. Beispielsweise ist die Generierung eines neuronalen Netzwerkdiagramms mit einem schlecht gestellten Problem mit hoher Varianz verbunden.

Daher trainierten die Forscher in diesem Artikel ein generatives Modell anhand eines Datensatzes von Papierdiagrammpaaren, um die Beziehung zwischen Diagrammkomponenten und dem entsprechenden Text im Artikel zu erfassen. Dies erfordert den Umgang mit unterschiedlichen Längen und hochtechnischen Textbeschreibungen, unterschiedlichen Diagrammstilen, Bildseitenverhältnissen sowie Schriftarten, -größen und Ausrichtungsproblemen bei der Textwiedergabe.

Während des spezifischen Implementierungsprozesses ließen sich die Forscher von aktuellen Text-zu-Bild-Ergebnissen inspirieren und verwendeten das Diffusionsmodell zur Generierung von Diagrammen. Sie schlugen ein potenzielles Diffusionsmodell zur Generierung wissenschaftlicher Forschungsdiagramme aus Textbeschreibungen vor – FigGen.

Was sind die einzigartigen Merkmale dieses Diffusionsmodells? Kommen wir zu den Details.

Modelle und Methoden

Die Forscher trainierten ein latentes Diffusionsmodell von Grund auf.

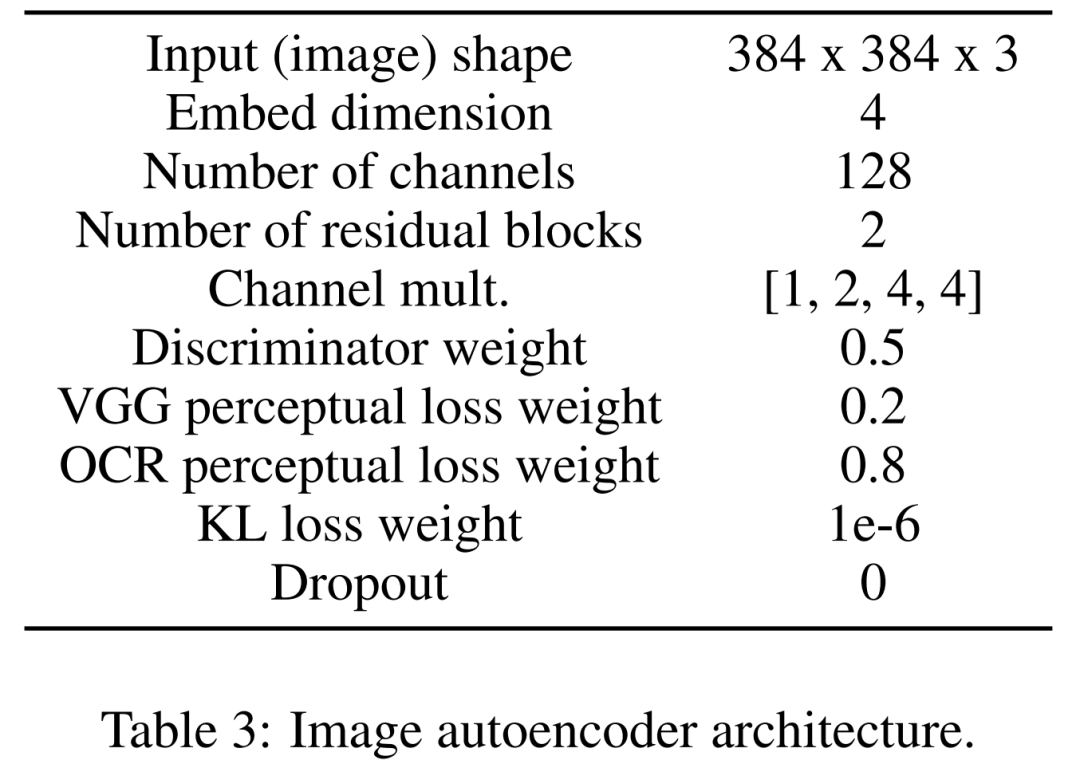

Erlernen Sie zunächst einen Bild-Autoencoder, um Bilder in komprimierte latente Darstellungen abzubilden. Der Bildencoder nutzt KL-Verlust und OCR-Wahrnehmungsverlust. Der zur Konditionierung verwendete Textkodierer wird im Training dieses Diffusionsmodells durchgängig erlernt. Tabelle 3 unten zeigt die detaillierten Parameter der Bild-Autoencoder-Architektur.

Das Diffusionsmodell interagiert dann direkt im latenten Raum und führt eine datenbeschädigte Vorwärtsplanung durch, während es lernt, die zeitliche und textliche bedingte Entrauschung von U-Net zu nutzen, um den Prozess wiederherzustellen.

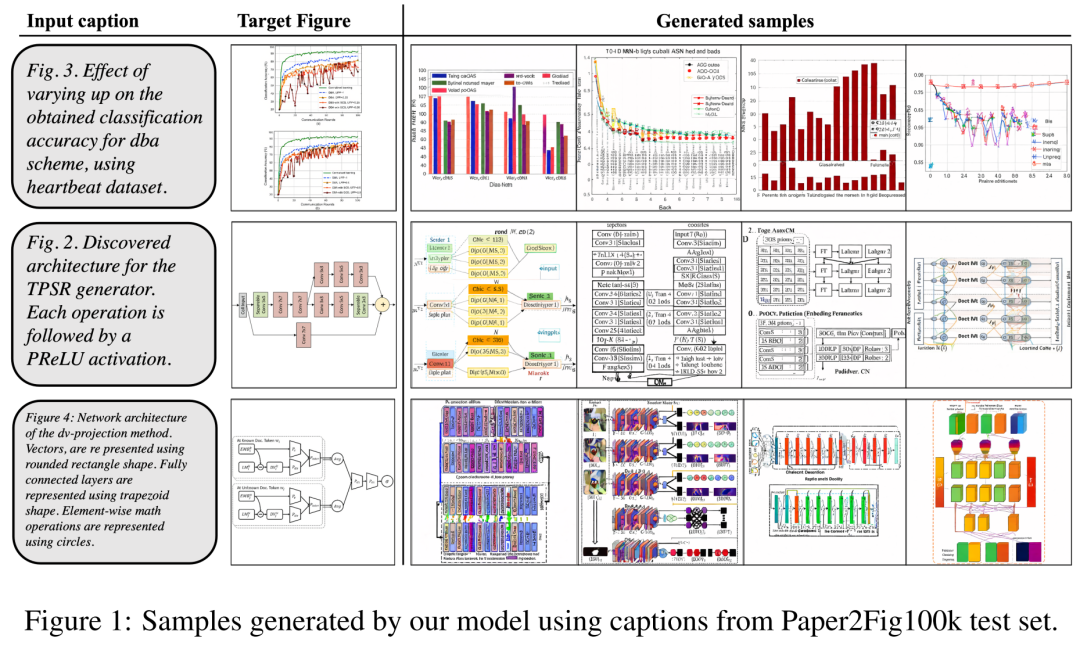

Als Datensatz verwendeten die Forscher Paper2Fig100k, das aus Diagramm-Text-Paaren im Papier besteht und 81.194 Trainingsbeispiele und 21.259 Validierungsbeispiele enthält. Abbildung 1 unten ist ein Beispiel für ein Diagramm, das mithilfe von Textbeschreibungen im Testsatz Paper2Fig100k erstellt wurde.

Modelldetails

Zuerst ist der Bildencoder. In der ersten Stufe lernt der Bild-Autoencoder eine Zuordnung vom Pixelraum zur komprimierten latenten Darstellung, wodurch das Training des Diffusionsmodells beschleunigt wird. Der Bildencoder muss auch lernen, das zugrunde liegende Bild wieder dem Pixelraum zuzuordnen, ohne wichtige Details des Diagramms (z. B. die Qualität der Textwiedergabe) zu verlieren.

Zu diesem Zweck haben die Forscher einen Faltungscodec mit einem Engpass definiert, der das Bild mit dem Faktor f=8 heruntersampelt. Der Encoder ist darauf trainiert, KL-Verluste, VGG-bewusste Verluste und OCR-bewusste Verluste mit Gauß-Verteilung zu minimieren.

Zweitens ist der Text-Encoder. Forscher haben herausgefunden, dass Allzweck-Textencoder für Aufgaben zur Diagrammerstellung nicht geeignet sind. Daher definieren sie einen von Grund auf im Diffusionsprozess trainierten Bert-Transformator, der einen Einbettungskanal der Größe 512 verwendet, der auch die Einbettungsgröße ist, die die Queraufmerksamkeitsschicht von U-Net reguliert. Die Forscher untersuchten auch Veränderungen in der Anzahl der Transformatorschichten unter verschiedenen Einstellungen (8, 32 und 128).

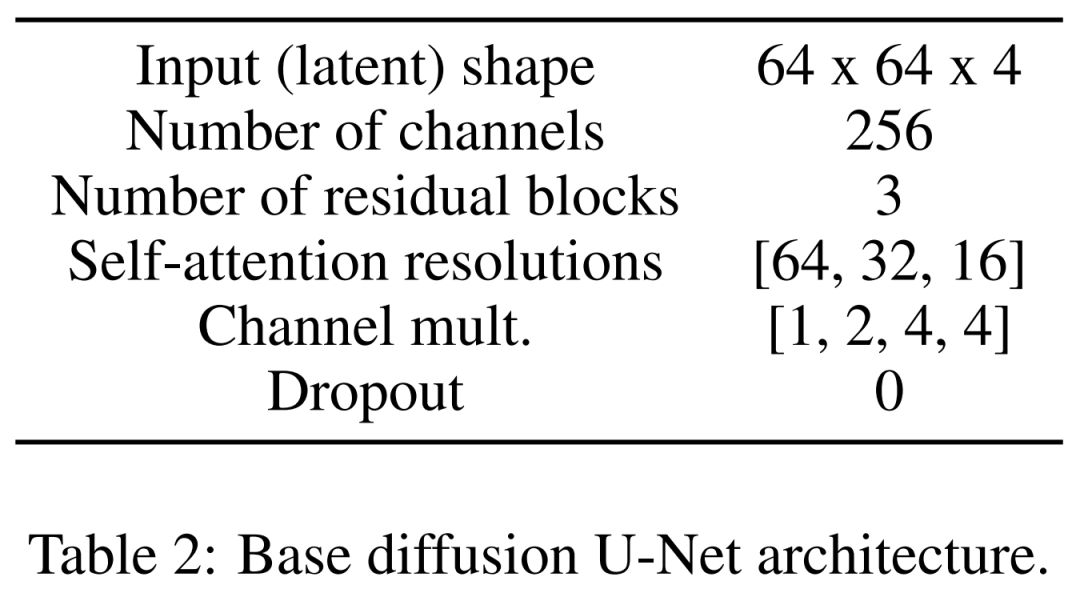

Das letzte ist das latente Diffusionsmodell. Tabelle 2 unten zeigt die Netzwerkarchitektur von U-Net. Wir führen den Diffusionsprozess an einer wahrnehmungsmäßig äquivalenten latenten Darstellung des Bildes durch, wobei die Eingabegröße des Bildes auf 64 x 64 x 4 komprimiert wird, wodurch das Diffusionsmodell schneller wird. Sie definierten 1.000 Diffusionsschritte und eine lineare Geräuschplanung.

Trainingsdetails

Um den Bild-Autoencoder zu trainieren, verwendeten die Forscher einen Adam-Optimierer mit einer effektiven Stapelgröße von 4 Proben und einer Lernrate von 4,5e −6 wobei vier 12GB NVIDIA V100 Grafikkarten zum Einsatz kamen. Um Trainingsstabilität zu erreichen, wärmen sie das Modell in 50.000 Iterationen auf, ohne den Diskriminator zu verwenden.

Zum Training des latenten Diffusionsmodells verwendeten die Forscher auch den Adam-Optimierer, der eine effektive Stapelgröße von 32 und eine Lernrate von 1e−4 hat. Beim Training des Modells mit dem Paper2Fig100k-Datensatz verwendeten sie acht 80-GB-NVIDIA-A100-Grafikkarten.

Experimentelle Ergebnisse

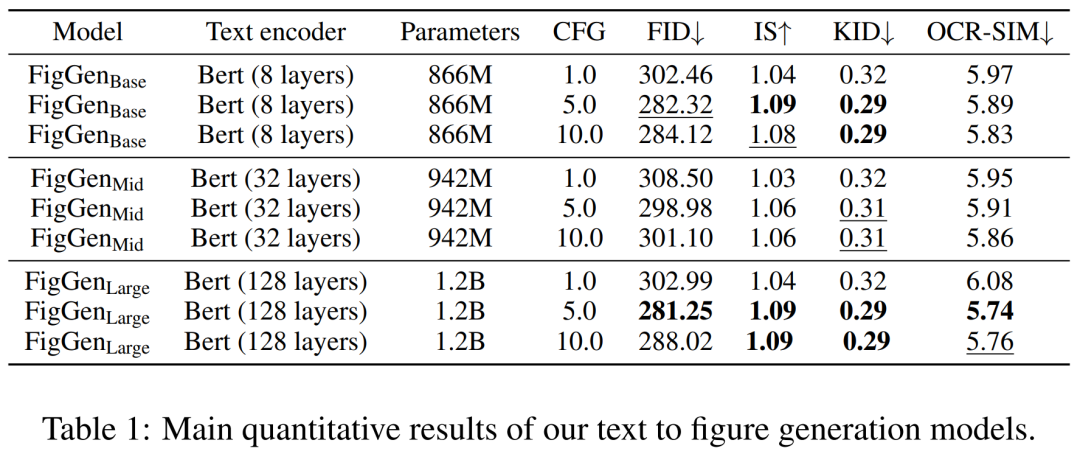

Während des Generierungsprozesses verwendeten die Forscher einen DDIM-Sampler mit 200 Schritten und generierten 12.000 Proben für jedes Modell, um FID, IS, KID und OCR-SIM1 zu berechnen. Robuster Einsatz von Classifier-Free Guidance (CFG) zum Testen von Hyperkonditionierung.

Tabelle 1 unten zeigt die Ergebnisse verschiedener Text-Encoder. Es ist ersichtlich, dass Encoder für große Texte die besten qualitativen Ergebnisse liefern und die Bedingungsgenerierung durch Erhöhen der Größe des CFG verbessert werden kann. Obwohl qualitative Proben nicht von ausreichender Qualität sind, um das Problem zu lösen, hat FigGen die Beziehung zwischen Text und Bildern erfasst.

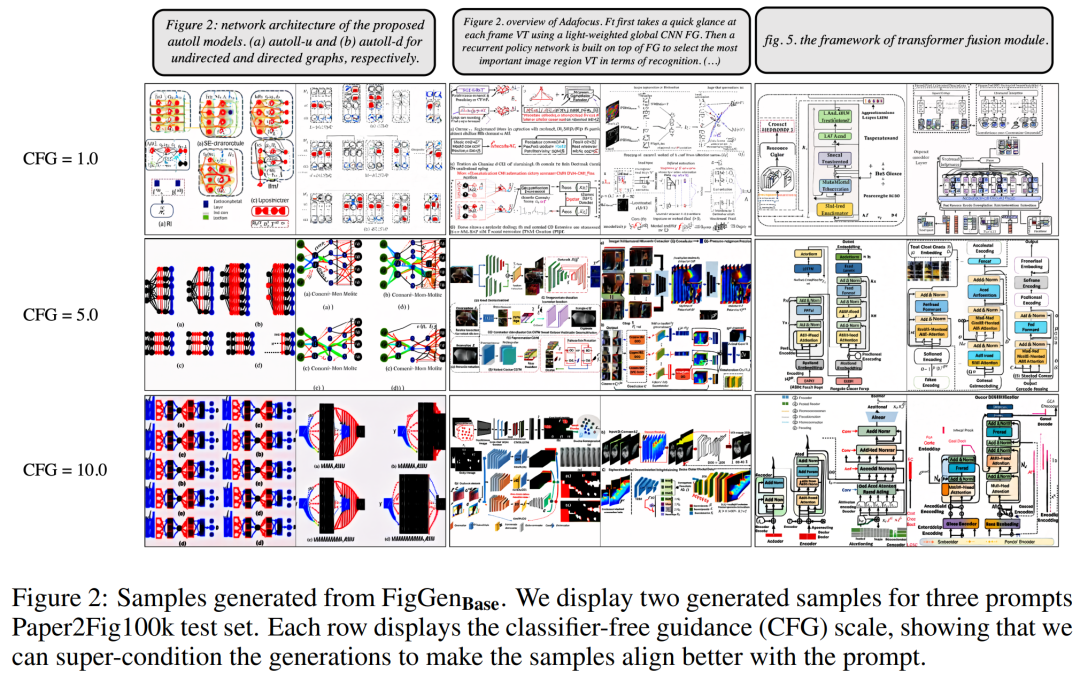

Abbildung 2 unten zeigt die zusätzlichen FigGen-Beispiele, die beim Anpassen der Classifier Free Guidance (CFG)-Parameter generiert werden. Die Forscher beobachteten, dass eine Vergrößerung des CFG, die auch quantitativ nachgewiesen werden konnte, zu einer Verbesserung der Bildqualität führte.

Bilder

Bilder

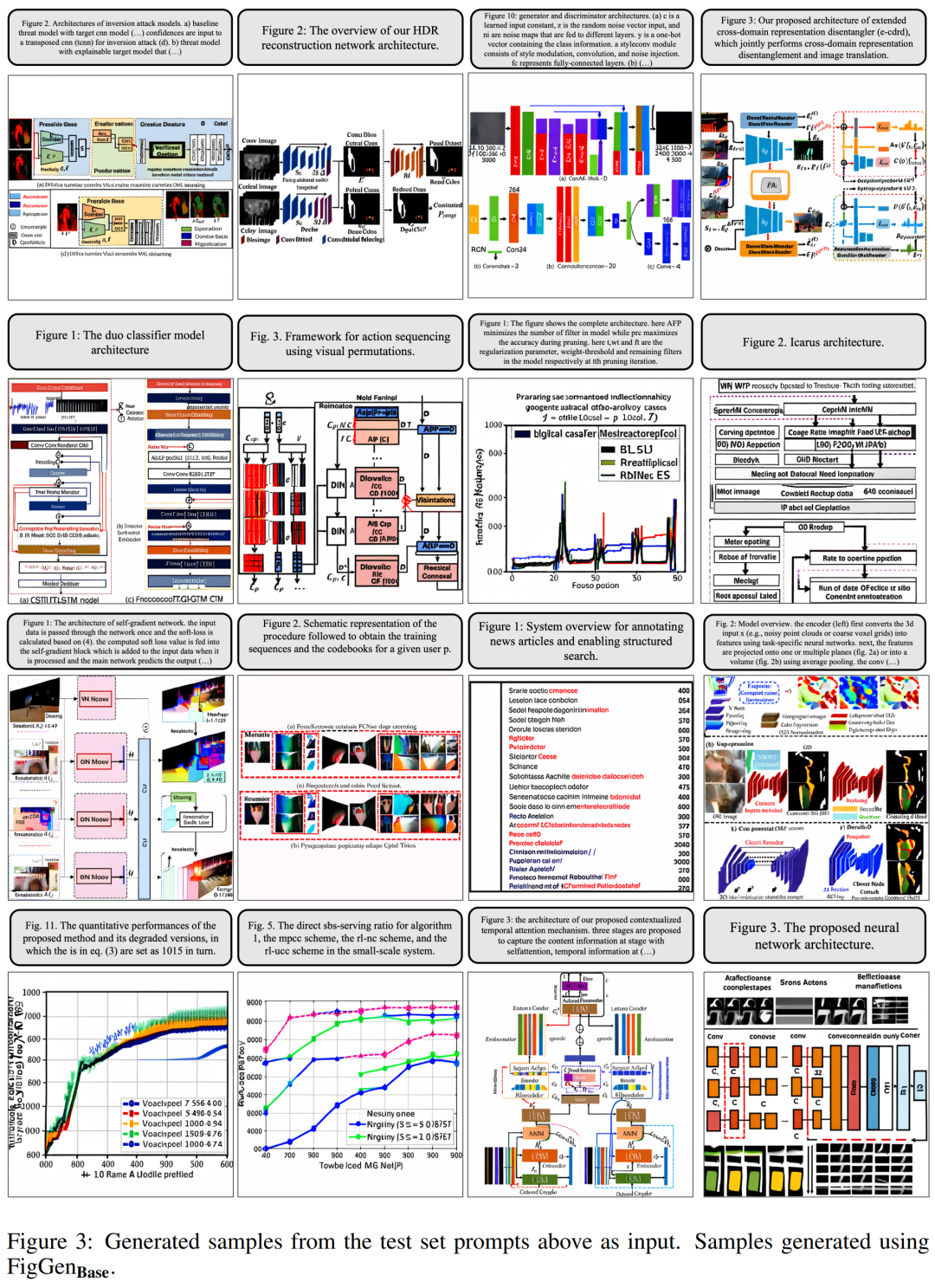

Abbildung 3 unten zeigt weitere Generationsbeispiele von FigGen. Achten Sie auf die Längenunterschiede zwischen den Beispielen sowie auf das technische Niveau der Textbeschreibung, da dies einen großen Einfluss auf die Schwierigkeit des Modells hat, verständliche Bilder korrekt zu erzeugen.

Bilder

Bilder

Die Forscher gaben jedoch auch zu, dass diese generierten Diagramme den Autoren des Papiers zwar keine praktische Hilfe bieten können, sie aber dennoch eine vielversprechende Richtung darstellen, die es zu erkunden gilt.

Weitere Forschungsdetails finden Sie im Originalpapier.

Das obige ist der detaillierte Inhalt vonAuch Papierillustrationen können mithilfe des Diffusionsmodells automatisch generiert werden und werden auch vom ICLR akzeptiert.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr