Heim >Technologie-Peripheriegeräte >KI >Basierend auf der Kalibrierungstechnologie der Informationstheorie macht CML multimodales maschinelles Lernen zuverlässiger

Basierend auf der Kalibrierungstechnologie der Informationstheorie macht CML multimodales maschinelles Lernen zuverlässiger

- PHPznach vorne

- 2023-06-27 16:26:56921Durchsuche

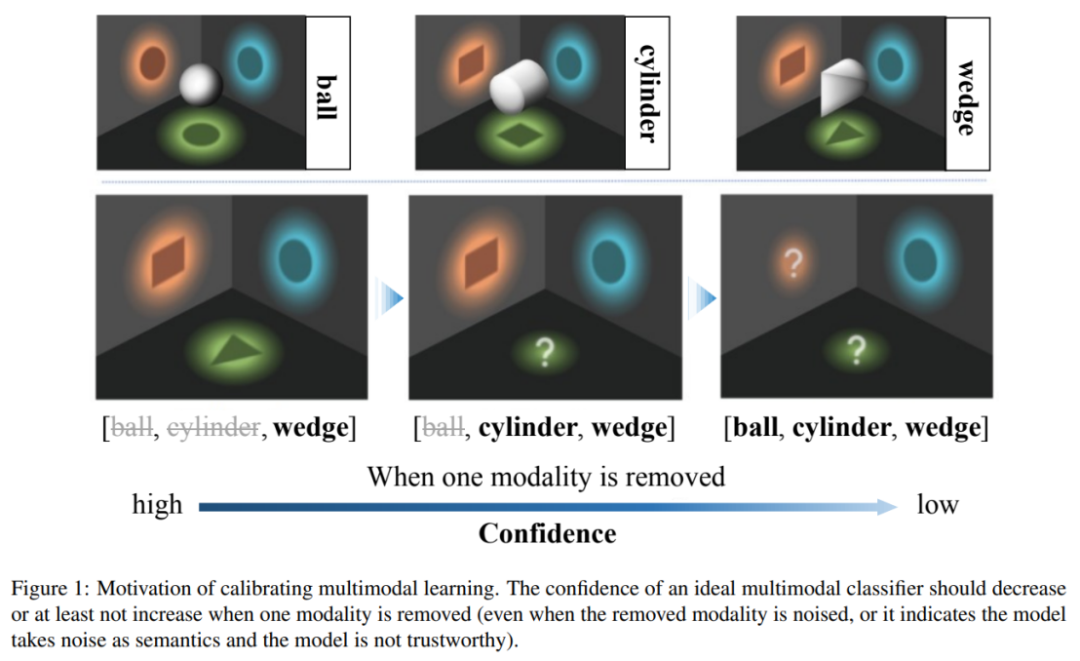

Multimodales maschinelles Lernen hat in verschiedenen Szenarien beeindruckende Fortschritte gemacht. Zur Zuverlässigkeit multimodaler Lernmodelle mangelt es jedoch an eingehender Forschung. „Information ist die Beseitigung von Unsicherheit.“ Die ursprüngliche Absicht des multimodalen maschinellen Lernens steht im Einklang damit – zusätzliche Modalitäten können Vorhersagen genauer und zuverlässiger machen. Das kürzlich in ICML2023 veröffentlichte Papier „Calibrating Multimodal Learning“ stellte jedoch fest, dass aktuelle multimodale Lernmethoden diese Zuverlässigkeitsannahme verletzen, und führte detaillierte Analysen und Korrekturen durch.

Bilder

Bilder

- Papier Arxiv: https://arxiv.org/abs/2306.01265

- Code GitHub: https://github.com /Q ingyangZhang/CML

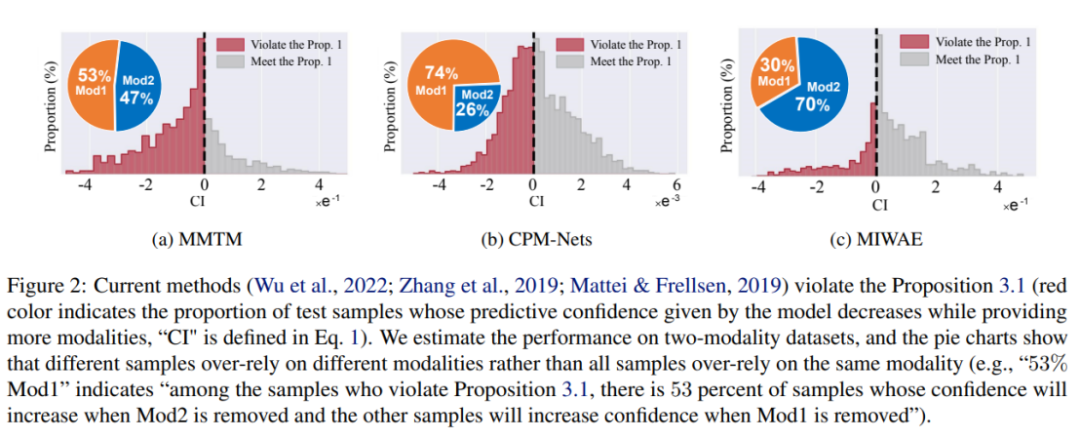

Die aktuelle multimodale Klassifizierungsmethode weist ein unzuverlässiges Vertrauen auf, das heißt, wenn einige Modi entfernt werden, kann das Modell ein höheres Vertrauen erzeugen, was gegen die Informationstheorie „Informationen wird eliminiert“ verstößt das Grundprinzip. Um dieses Problem anzugehen, schlägt dieser Artikel die Methode „Kalibrierendes multimodales Lernen“ vor. Diese Methode kann in verschiedenen multimodalen Lernparadigmen eingesetzt werden, um die Rationalität und Glaubwürdigkeit multimodaler Lernmodelle zu verbessern.

Bilder

Bilder

Diese Arbeit weist darauf hin, dass aktuelle multimodale Lernmethoden unzuverlässige Probleme mit der Vorhersagesicherheit haben und bestehende multimodale Modelle für maschinelles Lernen dazu neigen, sich auf Teilmodalitäten zu verlassen, um die Zuverlässigkeit abzuschätzen. Die Studie ergab insbesondere, dass die Zuverlässigkeit aktueller Modellschätzungen zunimmt, wenn bestimmte Modi beschädigt werden. Um dieses unvernünftige Problem zu lösen, schlagen die Autoren ein intuitives multimodales Lernprinzip vor: Wenn die Modalität entfernt wird, sollte die Zuverlässigkeit der Modellvorhersage nicht zunehmen. Aktuelle Modelle tendieren jedoch dazu, eine Teilmenge von Modalitäten zu glauben und von dieser beeinflusst zu werden, anstatt alle Modalitäten fair zu berücksichtigen. Dies wirkt sich weiter auf die Robustheit des Modells aus, d. h. das Modell wird leicht beeinträchtigt, wenn bestimmte Modi beschädigt werden.

Um die oben genannten Probleme zu lösen, übernehmen einige Methoden derzeit bestehende Methoden zur Unsicherheitskalibrierung, wie z. B. Temperaturskalierung oder Bayes'sche Lernmethoden. Diese Methoden können genauere Konfidenzschätzungen erstellen als herkömmliche Trainings-/Inferenzmethoden. Diese Methoden gleichen jedoch nur die Konfidenzschätzung des endgültigen Fusionsergebnisses mit der Genauigkeit ab und berücksichtigen nicht explizit die Beziehung zwischen der modalen Informationsmenge und der Konfidenz. Daher können sie die Glaubwürdigkeit des multimodalen Lernmodells nicht wesentlich verbessern.

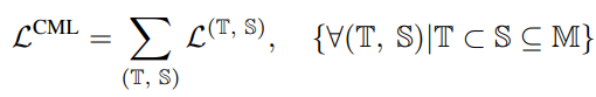

Der Autor schlägt eine neue Regularisierungstechnik namens „Calibrating Multimodal Learning (CML)“ vor. Diese Technik erzwingt die Übereinstimmungsbeziehung zwischen der Zuverlässigkeit der Modellvorhersage und dem Informationsgehalt, indem ein Strafterm hinzugefügt wird, um Konsistenz zwischen der Zuverlässigkeit der Vorhersage und dem Informationsgehalt zu erreichen. Diese Technik basiert auf der natürlichen Intuition, dass die Vorhersagesicherheit abnehmen sollte (zumindest nicht zunehmen), wenn eine Modalität entfernt wird, was von Natur aus die Vertrauenskalibrierung verbessern kann. Insbesondere wird ein einfacher Regularisierungsterm vorgeschlagen, um das Modell zum Erlernen einer intuitiven Ordnungsbeziehung zu zwingen, indem den Stichproben, deren Vorhersagesicherheit zunimmt, wenn eine Modalität entfernt wird, eine Strafe hinzugefügt wird:

Die obige Einschränkung ist a Regelmäßiger Verlust, der als Nachteil erscheint, wenn Modalinformationen entfernt werden und das Vertrauen steigt.

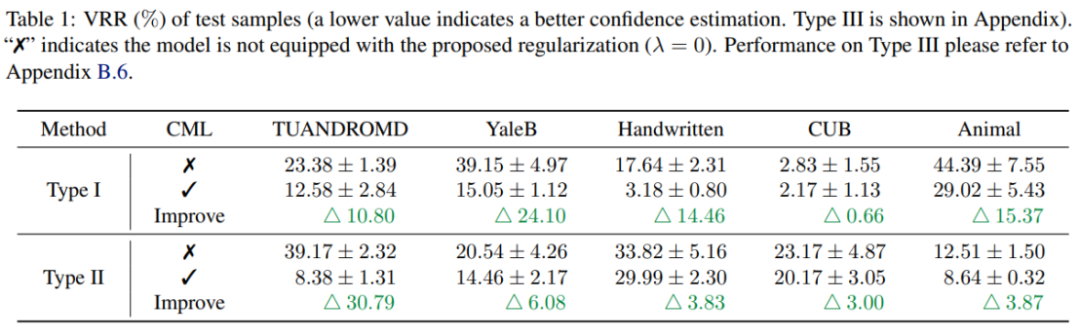

Experimentelle Ergebnisse zeigen, dass die CML-Regularisierung die Zuverlässigkeit der Vorhersagesicherheit bestehender multimodaler Lernmethoden erheblich verbessern kann. Darüber hinaus kann CML die Klassifizierungsgenauigkeit und die Robustheit des Modells verbessern.

Multimodales maschinelles Lernen hat in verschiedenen Szenarien erhebliche Fortschritte gemacht, aber die Zuverlässigkeit multimodaler maschineller Lernmodelle ist immer noch ein Problem, das gelöst werden muss. Durch umfangreiche empirische Forschung kommt dieser Artikel zu dem Schluss, dass aktuelle multimodale Klassifizierungsmethoden das Problem einer unzuverlässigen Vorhersagesicherheit haben und gegen die Prinzipien der Informationstheorie verstoßen. Um dieses Problem anzugehen, schlugen die Forscher die CML-Regularisierungstechnik vor, die flexibel auf bestehende Modelle angewendet werden kann und die Leistung in Bezug auf Vertrauenskalibrierung, Klassifizierungsgenauigkeit und Modellrobustheit verbessert. Man geht davon aus, dass diese neue Technologie eine wichtige Rolle beim künftigen multimodalen Lernen spielen und die Zuverlässigkeit und Praktikabilität des maschinellen Lernens verbessern wird.

Das obige ist der detaillierte Inhalt vonBasierend auf der Kalibrierungstechnologie der Informationstheorie macht CML multimodales maschinelles Lernen zuverlässiger. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr