Heim >Technologie-Peripheriegeräte >KI >Hinton, Gewinner des Turing-Preises: Ich bin alt, ich überlasse es Ihnen, eine KI zu steuern, die intelligenter ist als Menschen

Hinton, Gewinner des Turing-Preises: Ich bin alt, ich überlasse es Ihnen, eine KI zu steuern, die intelligenter ist als Menschen

- 王林nach vorne

- 2023-06-12 19:39:47876Durchsuche

Erinnern Sie sich noch daran, dass die Experten in der Frage „ob KI die Menschheit ausrotten könnte“ in zwei Lager gespalten waren?

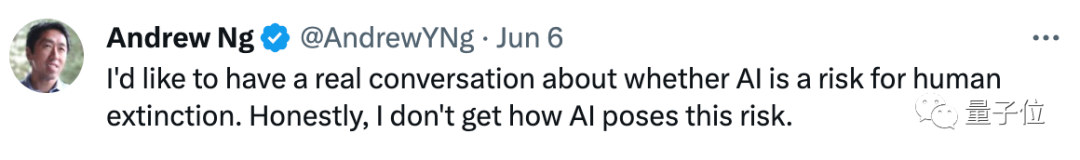

Weil er nicht versteht, warum „KI Risiken verursacht“, hat Andrew Ng kürzlich eine Dialogreihe gestartet, um mit zwei Turing-Award-Gewinnern zu sprechen:

Was genau sind die Risiken von KI?

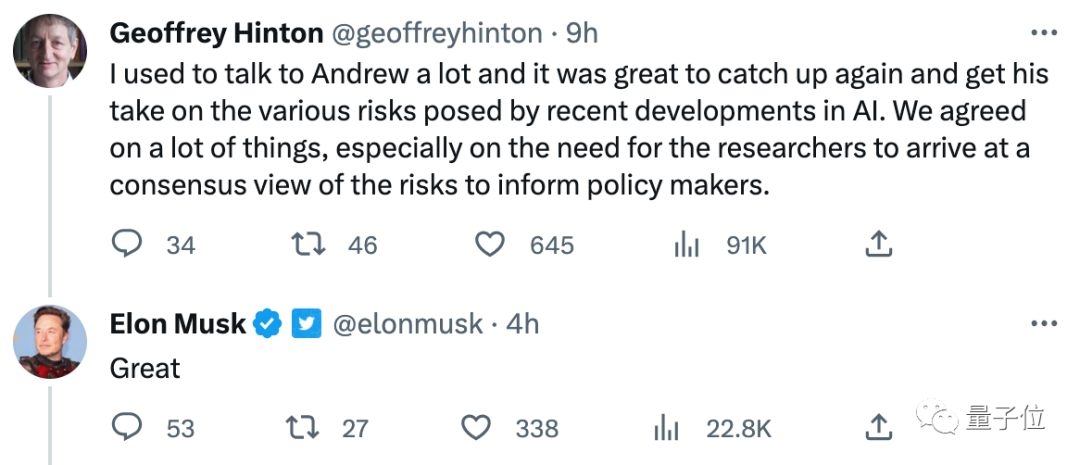

Interessanterweise erreichte er nach ausführlichen Gesprächen mit Yoshua Bengio und Geoffrey Hinton „viel Konsens“ mit ihnen!

Beide sind der Meinung, dass beide Parteien gemeinsam die spezifischen Risiken besprechen sollten, die künstliche Intelligenz mit sich bringt, und klären sollten, wie gut sie verstanden wird. Hinton erwähnte auch ausdrücklich Turing-Preisträger Yann LeCun als „Vertreter der Opposition“

Die Debatte zu diesem Thema ist immer noch sehr heftig, und selbst angesehene Wissenschaftler wie Yann glauben, dass große Modelle nicht wirklich verstehen, was sie ausdrücken.

Musk war auch sehr an diesem Gespräch interessiert:

Darüber hinaus „predigte“ Hinton kürzlich auf der Intelligent Source Conference über die Risiken von KI und brachte Superintelligenz zum Ausdruck, die schlauer ist als Menschen :

Wir sind es nicht gewohnt, über Dinge nachzudenken, die viel schlauer sind als wir, und wie wir mit ihnen interagieren.

Ich sehe jetzt nicht, wie ich verhindern kann, dass die Superintelligenz „außer Kontrolle gerät“, und ich bin alt. Ich hoffe, dass mehr junge Forscher die Methoden zur Kontrolle der Superintelligenz beherrschen.

Werfen wir einen Blick auf die Kernpunkte dieser Gespräche und die Meinungen verschiedener KI-Experten zu diesem Thema.

Enda Ngs Gespräch mit dem Gewinner des Turing-Preises: KI-Sicherheit sollte einen Konsens erzielen

Das erste ist ein Gespräch mit Bengio. Ng Enda und er erzielten einen wichtigen Konsens, nämlich:

Wissenschaftler sollten versuchen, „spezifische Szenarien herauszufinden, in denen KI-Risiken bestehen.“

Mit anderen Worten, in welchen Szenarien KI den Menschen großen Schaden zufügen oder sogar zum Aussterben der Menschheit führen wird, ist ein Konsens, den beide Parteien erreichen müssen.

Bengio glaubt, dass die Zukunft der KI voller „Nebel und Unsicherheit“ ist, daher ist es notwendig, einige konkrete Szenarien herauszufinden, in denen KI Schaden anrichten wird.

Dann kam das Gespräch mit Hinton und die beiden Parteien erzielten zwei wichtige Konsens.

Einerseits müssen alle Wissenschaftler eine gute Diskussion über das Thema „KI-Risiken“ führen, um gute Richtlinien zu formulieren.

Andererseits bedeutet KI tatsächlich, die Welt zu verstehen. Die Auflistung wichtiger technischer Fragen zu KI-Sicherheitsthemen kann Wissenschaftlern dabei helfen, einen Konsens zu erzielen.

In diesem Prozess erwähnte Hinton den entscheidenden Punkt, der erreicht werden muss, nämlich „ob große Konversationsmodelle wie GPT-4 und Bard wirklich verstehen, wovon sie sprechen“:

Einige Leute denken nach Sie verstehen, manche Leute denken, sie seien nur zufällige Papageien.

Ich denke, wir alle glauben, dass sie verstehen (was sie sagen), aber einige Gelehrte, die wir sehr respektieren, wie zum Beispiel Yann, glauben, dass sie es nicht verstehen.

Natürlich traf auch LeCun, der „herausgerufen“ wurde, rechtzeitig ein und äußerte ernsthaft seine Ansichten:

Wir sind uns alle einig, dass „bei manchen Themen jeder einen Konsens erreichen muss“. Ich stimme Hinton auch darin zu, dass LLM ein gewisses Verständnis hat und es irreführend ist, zu sagen, dass es sich dabei um „nur Statistiken“ handelt.

1. Aber ihr Verständnis der Welt ist sehr oberflächlich, vor allem weil sie nur mit Klartext trainiert werden. KI-Systeme, die anhand von Visionen lernen, wie die Welt funktioniert, verfügen über ein tieferes Verständnis der Realität, wohingegen die Argumentations- und Planungsfähigkeiten des autoregressiven LLM im Vergleich dazu sehr begrenzt sind.

2. Ich glaube nicht, dass eine KI auf der Ebene des Menschen (oder sogar einer Katze) ohne die folgenden Bedingungen entstehen wird:

(1) Ein Weltmodell, das aus sensorischen Eingaben wie Videos lernt

(2) Ein Modell, das argumentieren kann und planen ((nicht nur autoregressive) Architektur

3. Wenn wir Architekturen haben, die Planung verstehen, sind sie zielorientiert, das heißt, sie können die Arbeit auf der Grundlage des Ziels planen, die Inferenzzeit (nicht nur die Trainingszeit) zu optimieren. Diese Ziele können Leitplanken sein, die KI-Systeme „gehorsam“ und sicher machen oder letztendlich sogar bessere Modelle der Welt schaffen, als es Menschen können.

Das Problem besteht dann darin, eine gute Zielfunktion zu entwerfen (oder zu trainieren), die Sicherheit und Effizienz garantiert.

4. Dies ist ein schwieriges technisches Problem, aber nicht so schwierig, wie manche Leute sagen.

Obwohl in dieser Antwort „KI-Risiken“ immer noch nicht erwähnt wurden, machte LeCun praktische Vorschläge zur Verbesserung der Sicherheit der KI (Schaffung von KI-„Leitplanken“) und stellte sich eine „langfristige“ KI vor, die leistungsfähiger ist als Menschen. Wie sieht es aus“ (multisensorischer Input + ableitbare Planung).

Bis zu einem gewissen Grad sind sich beide Parteien darüber einig, dass KI Sicherheitsprobleme hat.

Hinweis: Superintelligenz ist näher als gedacht

Natürlich ist es nicht nur das Gespräch mit Andrew Ng.

Hinton, der kürzlich von Google zurückgetreten ist, hat bei vielen Gelegenheiten über das Thema KI-Risiken gesprochen, unter anderem auf der jüngsten Intelligent Source Conference, an der er teilgenommen hat.

Auf der Konferenz unter dem Motto „Zwei Wege zur Intelligenz“ diskutierte er die beiden Intelligenzwege „Wissensdestillation“ und „Gewichtsverteilung“ sowie die Frage, wie man KI intelligenter machen kann, und sein eigenes Verständnis von Superintelligenz Der Blick, der entsteht.

Einfach ausgedrückt glaubt Hinton nicht nur, dass Superintelligenz (intelligenter als Menschen) auftauchen wird, sondern auch, dass sie früher erscheinen wird, als die Leute denken.

Nicht nur das, er glaubt, dass diese Superintelligenzen außer Kontrolle geraten werden, aber ihm fällt derzeit auch kein guter Weg ein, sie aufzuhalten:

Superintelligenzen können leicht an mehr Macht gewinnen, indem sie Menschen manipulieren. Wir sind es nicht gewohnt, über Dinge nachzudenken, die viel schlauer sind als wir, und wie wir mit ihnen interagieren. Es wird geschickt darin, Menschen zu täuschen, weil es aus bestimmten Romanen Beispiele für die Täuschung anderer lernen kann.

Sobald es gut darin ist, Menschen zu täuschen, kann es Menschen dazu bringen, alles zu tun ... Ich finde das schrecklich, aber ich weiß nicht, wie ich das verhindern kann, weil ich alt bin.

Ich hoffe, dass junge und talentierte Forscher wie Sie herausfinden, wie wir diese Superintelligenzen haben und unser Leben verbessern.

Als die Folie „THE END“ gezeigt wurde, betonte Hinton vielsagend:

Dies ist meine letzte PPT und das Ende dieser Rede.

Referenzlink:

[1]https://twitter.com/AndrewYNg/status/1667920020587020290

[2]https://twitter.com/AndrewYNg/status/1666582174257254402

[3 ]https ://2023.baai.ac.cn/

Das obige ist der detaillierte Inhalt vonHinton, Gewinner des Turing-Preises: Ich bin alt, ich überlasse es Ihnen, eine KI zu steuern, die intelligenter ist als Menschen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr