Heim >Technologie-Peripheriegeräte >KI >Drei Schlüsseltechnologien verleihen AR-Schnittstellen die nötige Leistungsfähigkeit

Drei Schlüsseltechnologien verleihen AR-Schnittstellen die nötige Leistungsfähigkeit

- 王林nach vorne

- 2023-06-10 11:59:49780Durchsuche

Dieser Artikel beginnt aus technischer Sicht und analysiert am Beispiel des kürzlich eingeführten Apple MR die drei wichtigsten technischen Punkte, auf die sich die AR-Welt verlassen muss: Eye-Tracking, manuelle Erkennung und räumliches Computing. Werfen wir einen Blick auf die Analyse dieser drei technischen Punkte durch den Autor ~

In der physischen Welt sind das Beobachten mit den Augen und das Bedienen mit den Händen die natürlichsten Formen der Interaktion. Um die Fortsetzung dieser natürlichen Interaktion in der AR-Welt zu realisieren, müssen wir uns auf drei wichtige technische Punkte verlassen.

Wir sind nicht enttäuscht, denn die Einführung von Apple Vision Pro demonstriert die natürlichen Interaktionsmöglichkeiten, die drei Technologien ermöglichen.

1. Eye-Tracking-Technologie

Wenn wir in der Realität weiter mit einem Objekt interagieren müssen, richten wir unseren Blick ganz natürlich darauf. Wenn wir unsere Aufmerksamkeit darauf richten, stellt dies bereits unsere Wahl dar.

Dieser Prozess deckt die aktuellen beiden Zustände im Schnittstellenfeld ab: Aktivierungszustand (Fokus) und Klickzustand (Auswahl). Die Eye-Tracking-Technologie realisiert den Prozess des Sehens und Fokussierens.

Diese Technologie ist sicherlich nicht die erste ihrer Art. Der Pionier der AR-Brillen, Microsoft Holoens Interaktion der 2. Generation, verfügt über Eye-Gaze, also die Funktion, die Augen zum Fokussieren zu nutzen.Zuvor basierte die Kopf-Blick-Interaktion der ersten Generation von Microsoft Holoens tatsächlich auf dem Konzept des Sehens und Aktivierens mit den Augen. Beim Head-Gaze wird der Kopf jedoch leicht bewegt, um einen Punkt (Gaze) in der Mitte des Bildschirms zu steuern und Inhalte zu aktivieren. Es besteht immer eine Lücke zwischen ihm und unserer ursprünglichen natürlichen Interaktion, da wir uns tatsächlich auf einen konzentrieren Objekt und müssen sich nicht jedes Mal darauf konzentrieren. Verlassen Sie sich einfach darauf, dass sich Ihr Kopf und Ihre Augen bewegen.

Obwohl die Eye-Tracking-Technologie den Standard der natürlichen Interaktion besser lösen kann, ist die Interaktion mit Kopfbewegungen nicht ohne Vorzüge. Beispielsweise kann die derzeit von meinem Team entwickelte Brille nur die Interaktion zwischen Kopf und Blick unterstützen. Die Kosten und der technische Aufwand dieser interaktiven Methode sind geringer als bei der Fokusaktivierungsmethode per Hand/Maus/Fernbedienung usw., sie kommt dem natürlichen Interaktionskonzept des Sehens mit unseren Augen näher.

Darüber hinaus hat die Eye-Tracking-Technologie den Aktivierungsstatus erkannt, die Auswahl, also den Klickstatus, jedoch noch nicht wirklich erkannt. Die Funktion besteht darin, der Maschine mitzuteilen, dass ich bestätige, dass sie es ist.

Streng genommen ist es unbedingt erforderlich, den manuellen Bestätigungsschritt für Dinge wegzulassen, die keinen Betrieb erfordern. Wenn ich zum Beispiel Snacks esse und Fernsehsendungen schaue, hoffe ich wirklich, dass ich mir nicht vor jeder Operation die schmutzigen Hände abwischen muss ... Im Fertigungsbereich wird dieses Bedürfnis, Hände frei zu haben, oft geäußert Kunden.

Für eine natürlichere Interaktion kann dies vielleicht auch Teil unserer Fantasie werden. Ich habe zuvor über ein Patent geschrieben, das sich zur einfachen Bestätigung auf Gehirnwellentechnologie stützte.

2. Gestenerkennungstechnologie

Eye-Tracking erfüllt die Interaktion, diesen Teil mit den Augen zu betrachten, während die Bedienung mit den Händen eine Gestenerkennungstechnologie erfordert.

Dies ist keine neue Technologie, die bereits auf vielen ARVR-Geräten installiert wurde. Der Grad der Implementierung muss jedoch durch tatsächliche Erfahrungen bestätigt werden.

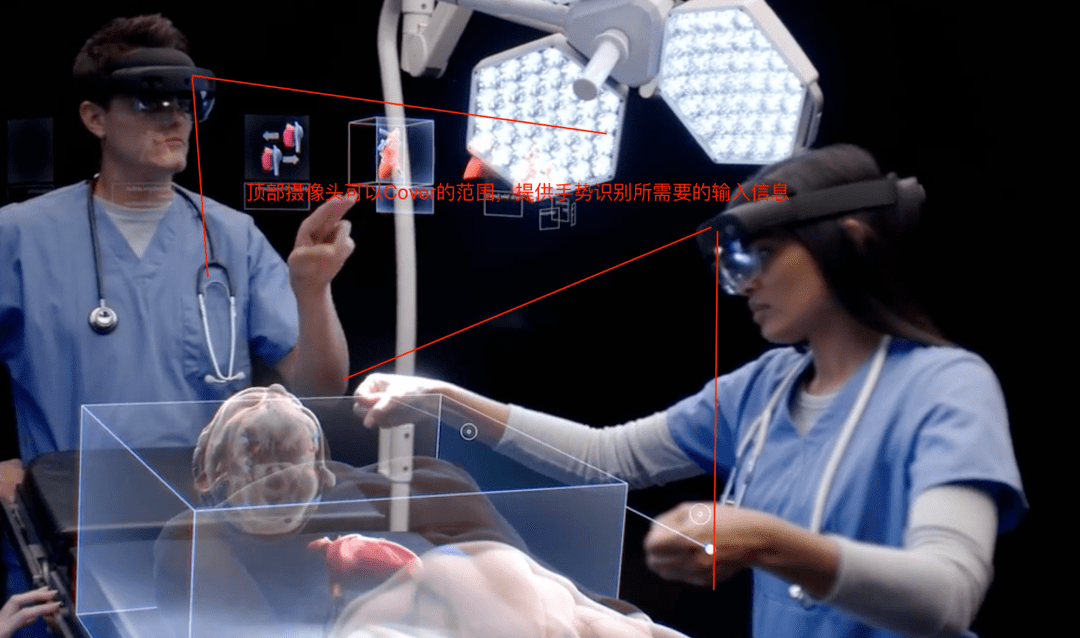

Im Werbevideo von Vision Pro sieht die Gestenerkennung sehr natürlich aus und die Hand muss nicht einmal angehoben werden. Dies sollte auf 4 Sätze von nach unten gerichteten Kameras beruhen (dies ist wahrscheinlich einer der Gründe, warum eine 12- Kamerakonfiguration ist erforderlich).

Darüber hinaus ist auch die Erfahrung der 2D-Gestenerkennungs- und 3D-Gestenerkennungstechnologie unterschiedlich.

3. Räumliche Berechnung

Um den Augen das Sehen zu erleichtern und eine natürlichere Bedienung mit den Händen zu ermöglichen, muss das Gerät in der Lage sein, den Raum zu verstehen.

Spatial Computing ist das, was Vision Pro fördern möchte. Ihr Fokus auf diese Fähigkeit lässt sie glauben, dass diese Fähigkeit eine Ära spalten kann.

„Die Ära des Spatial Computing“.Viele Interaktionen erfolgen auf natürliche Weise, weil Maschinen über räumliche Rechenfähigkeiten verfügen. Mit anderen Worten: Wenn Maschinen nicht in der Lage sind, den Raum zu verstehen, können diese Interaktionen nicht auf natürliche Weise stattfinden. Nerf, SLAM, 3DOF und 6DOF sind alle Teil der Spatial-Computing-Technologie, und alles, was Sie hören, fällt in diese Kategorie.

Aus Erfahrungssicht die Wahrnehmung der Distanz zwischen Objekten und zwischen Objekten und Benutzern, die durch die Veränderung der Form von Objekten in der Tiefe hervorgerufen werden, die durch die perspektivische Ausrichtung des Benutzers in verschiedenen Positionen und Haltungen hervorgerufen wird; aufgrund von Zeit und Veränderungen in der Farbwahrnehmung, die durch unterschiedliche Lichtverhältnisse wie Wetter oder sogar Geräusche von unterschiedlichen räumlichen Standorten usw. verursacht werden. Spatial Computing kann Designern mehr Raum für natürliche Interaktion bieten.

Man kann sagen, dass Spatial Computing die Schlüsseltechnologie ist, die es AR in Zukunft ermöglichen wird, sich von gewöhnlichen Bildschirmschnittstellen zu unterscheiden, und was wir wirklich erwarten: „Alles, was Sie betrachten, kann zu einer Schnittstelle werden.“

Kolumnist

Lin Yingluo, öffentlicher WeChat-Account: Es fallen Schatten in den Wald und jeder ist ein Produktmanager-Kolumnist. Ein User-Experience-Designer, der weiß, wie man Karten spielt, Autor von „AR Interface Design“, mehr als 10 Jahre Erfahrung im UIUX-Design, mit Schwerpunkt auf User-Experience-Design im Bereich AR und Intelligenz seit 6 Jahren, nationaler Profi; Zertifizierung zum Senior OH Card Master/Talent Mining Coach. Ich hoffe, dass meine Bemühungen einen Mehrwert für den Designbereich einer intelligenten Zukunft schaffen und die Karriere eines Designers wertvoller machen können

Titelbild von Unsplash, basierend auf dem CC0-Protokoll

Das obige ist der detaillierte Inhalt vonDrei Schlüsseltechnologien verleihen AR-Schnittstellen die nötige Leistungsfähigkeit. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr