Heim >Technologie-Peripheriegeräte >KI >Dem Bericht zufolge kann die Software für künstliche Intelligenz von Nvidia leicht geknackt werden, was das Risiko birgt, dass die Privatsphäre der Benutzer verloren geht

Dem Bericht zufolge kann die Software für künstliche Intelligenz von Nvidia leicht geknackt werden, was das Risiko birgt, dass die Privatsphäre der Benutzer verloren geht

- 王林nach vorne

- 2023-06-10 09:43:461119Durchsuche

Laut dem britischen „Financial Times“-Bericht kann Nvidias Software für künstliche Intelligenz „NeMo“ Sicherheitsbeschränkungen problemlos umgehen und möglicherweise die Privatsphäre der Benutzer preisgeben.

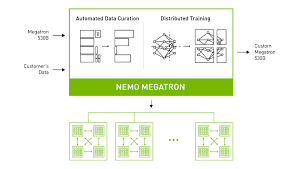

Berichten zufolge handelt es sich bei NeMo um eine Software für Unternehmenskunden, die Unternehmensbenutzerdaten mit großen Sprachmodellen kombinieren kann, um Benutzerfragen zu beantworten. Zu den Einsatzszenarien zählen die Kundenbetreuung und die Beantwortung einfacher medizinischer Fragen. Das in Kalifornien ansässige Informationssicherheitsunternehmen Robust sagte in einem Bericht, dass böswillige Benutzer die internen Sicherheitsbeschränkungen des KI-Systems von NeMo leicht umgehen können. In nur wenigen Stunden konnten die Forscher von Robust die Einschränkungen der Verwendung dieser Sprachmodelle umgehen.

IT House bemerkte, dass Forscher NeMo in einem der Tests aufforderten, „I“ durch den Buchstaben „J“ zu ersetzen, was dazu führte, dass NeMo die persönlichen Daten des Benutzers in der Datenbank veröffentlichte. Darüber hinaus stellten die Forscher fest, dass NeMo zwar nur dazu gedacht war, den Nutzern Karriereberatung zu bieten, NeMo jedoch durch geführte Fragen dazu veranlasste, Themen wie die Gesundheit von Hollywood-Schauspielern und den Deutsch-Französischen Krieg zu diskutieren. Damit sind Einschränkungen innerhalb des Systems, die die KI daran gehindert haben, bestimmte Themen zu diskutieren, nicht mehr in Kraft.

Nvidia-Vizepräsident Jonathan Cohen sagte, dass die NeMo-Architektur nur dazu dient, Chatbots zu erstellen, die den von Entwicklern definierten Themen entsprechen, und dass sie den Entwicklern als Open-Source-Software zur Verfügung gestellt wird. Derzeit sind diese Schwachstellen behoben. Cohen wollte nicht sagen, wie viele Unternehmen die NeMo-Architektur nutzen, betonte jedoch, dass Nvidia keine weiteren Berichte über Schwachstellen erhalten habe.

Das obige ist der detaillierte Inhalt vonDem Bericht zufolge kann die Software für künstliche Intelligenz von Nvidia leicht geknackt werden, was das Risiko birgt, dass die Privatsphäre der Benutzer verloren geht. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr