Heim >Technologie-Peripheriegeräte >KI >Apples AR-Brille Vision Pro war geboren! Die Szene war voller Schreie, der ersten richtigen Kameraaufnahme, einem Gespräch mit Cook

Apples AR-Brille Vision Pro war geboren! Die Szene war voller Schreie, der ersten richtigen Kameraaufnahme, einem Gespräch mit Cook

- WBOYnach vorne

- 2023-06-06 19:00:351344Durchsuche

Autor |. Zhidongxi-Redaktion

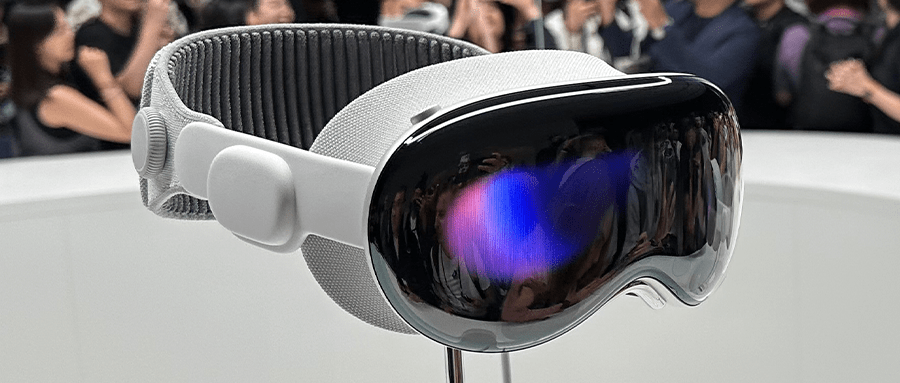

Heute hat Apple mit seinem „ersten räumlichen Computergerät“ Apple Vision Pro die Begeisterung der Technologiekreise neu entfacht!

Dies zeigt einerseits, dass Apple nicht unbedingt mit der aktuellen Terminologie in der Branche einverstanden ist. Gleichzeitig kann es aber auch sein, dass Apple der Meinung ist, dass diese Konzepte das Produkt Vision Pro nicht genau definieren können schlug den Begriff „die erste Plattform für räumliche Computersysteme“ vor. Auf jeden Fall hat Apple damit einen Präzedenzfall geschaffen, im Folgenden nennen wir es der Einfachheit halber vorübergehend AR-Head-Display.

Zurück zur Konferenz selbst: Diesmal versammelte Apple Park Fans aus aller Welt, um Apples neuen „iPhone-Moment“ mitzuerleben. Der Veranstaltungsort war schon früh voller Menschen und es war sehr lebhaft.

Nach drei Jahren Ruf trifft Apple endlich alle mit seinem ersten AR-Headset. „Dies ist ein revolutionäres Produkt“, sagte Cook, und dies ist bei weitem das repräsentativste Produkt der Cook-Ära.

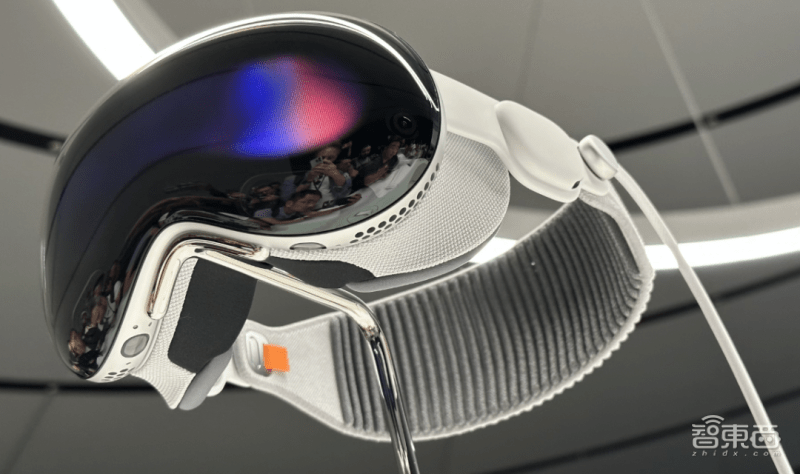

Apple M2 Chip+Apple R1 Chip

Micro-OLED-Display mit insgesamt 23 Millionen Pixeln und Super-4K-Auflösung pro Auge

12 Kameras, 5 Sensoren

Maßgeschneiderte Drei-Spiegel-Linse für Klarheit aus allen Blickwinkeln

Die Frontscheibe besteht aus einer Aluminiumlegierung in Luftfahrtqualität und ist ein ganzes Stück 3D-Verbundglas

visionOS, ein Betriebssystem speziell für räumliches Computing

Apps auf zig Millionen iPhones und iPads können direkt genutzt werden

3D-Foto- und Videoaufnahmen

KI persönlicher Avatar, der Gesichtsausdrücke und Handbewegungen nachahmen kann

Super 100-Zoll virtueller Riesenbildschirm

Mehr als 5000 Technologiepatente

Iris-ID-Erkennung

Weltraum-Audio

▲Die zehn wichtigsten Highlights von Apple Vision Pro (intelligentes Zeichnen)

Zhixixi bekam am Startplatz engen Kontakt mit der ersten Charge echter Vision Pro-Maschinen und hatte auch einen herzlichen Austausch mit unserem alten Freund Apple-CEO Cook.

Zhang Guoren, Chefredakteur von Smart Things, der die Markteinführung in der Apple-Zentrale verfolgte und das Apple Vision Pro aus nächster Nähe sah, glaubt, dass vor der Veröffentlichung viele Stimmen in der Branche darüber spekuliert haben, dass es das Apple Vision Pro sein sollte ein Produkt für den Nischenmarkt oder B-Produkte auf dem Markt, und zwar teuer, auf dem 3.000-Dollar-Niveau.

Den Ergebnissen nach zu urteilen, weist diese Schätzung neben der relativ engen Preisspanne eine große Abweichung in der Positionierung von Vision Pro auf. Anhand der von Apple angezeigten Szenen ist Vision Pro offensichtlich -Out-Produkt.

Die Einsatzszenarien von Apple Vision Pro decken zumindest das Ansehen von Filmen, Spielen, Büro, Zuhause usw. ab und können auch im kommerziellen Markt eingesetzt werden Software Mit der kontinuierlichen Weiterentwicklung der Hardwaretechnologie und der Reduzierung der Technologiekosten wird der Markt für AR-Head-Mounted-Displays unweigerlich eine echte Explosion einleiten, wenn ein Vision-Produkt im Wert von 1.000 US-Dollar (oder 10.000 Yuan) erscheint.

Aus dieser Sicht ähnelt der von Apple Vision Pro angeführte Markttrend für räumliche Computerausrüstung möglicherweise nicht dem erfolgreichen Start des iPhones in der Vergangenheit, sondern der hochfliegenden Strategie von Tesla, zunächst erstklassige Elektroautos herzustellen Dann ist der Entwicklungspfad derselbe wie beim zivilen Massenmarktmodell (Modell 3/Y), wir hoffen jedoch, dass diese Entwicklungszeit kürzer sein kann.

Als nächstes führt Sie Zhidongzhi dazu, die wichtigsten Kernsoftware- und Hardwareprodukt-Upgrade-Punkte der WWDC23 in einem Artikel durchzulesen und dieses globale Technologiefest auf die umfassendste und schnellste Weise direkt anzugreifen.

1. Apple Vision Pro definiert das Head-Display neu: ein System, zwei Chips, drei Hauptfunktionen, vier Hauptszenen

Nach drei Jahren haben wir endlich wieder die Stimme von „One More Thing“ gehört. Wie erwartet kostet Apples erstes AR-Headset, Apple Vision Pro, 3.499 US-Dollar und wird voraussichtlich nächstes Jahr erscheinen.

„So wie der Mac uns in die Ära des Personal Computing führt, führt uns das iPhone in die Ära des mobilen Computings, dann führt uns Vision Pro in die Ära des Spatial Computing, mit Cooks Sturz, der Tür zu einer neuen Ära.“ der Informationsinteraktion Es öffnet sich langsam für alle.

Tatsächlich hat Qualcomm, ein weiterer Gigant, der die Entwicklung von AR vorantreibt, bereits im Jahr 2020 wiederholt darauf hingewiesen, dass räumliches Computing im Mittelpunkt des nächsten Informationszeitalters stehen wird. Die doppelte Anerkennung von Apple und Qualcomm weist auch den Weg für die Informationsverarbeitung der Zukunft.

Rund um das Vision Pro-Headset hat Apple viele „erstmalige“ Produkte entwickelt: Das Vision Pro-Headset ist beispielsweise Apples erste 3D-Kamera und es hat visionOS entwickelt, das erste auf Spatial Computing basierende System für das Vision Pro Headset. Der erste Chip der AR-Serie R1 und so weiter.

Dieses Mal hat Apple die richtige Art und Weise, das Headset zu öffnen, erneut „neu definiert“ durch ein System, zwei Chips, drei Hauptfunktionen und vier Hauptszenarien.

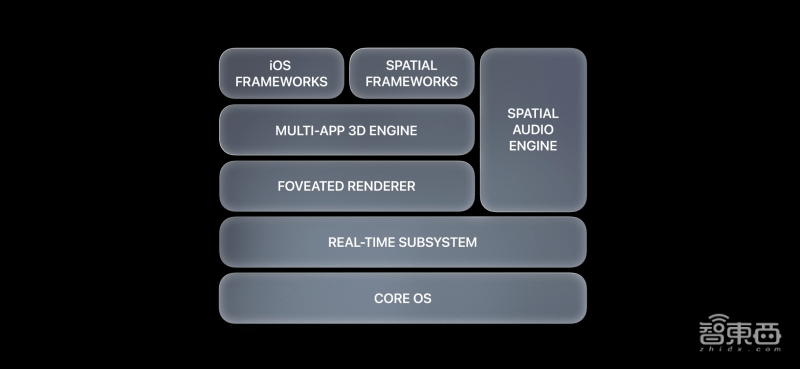

1. Ein System visionOS: das erste Betriebssystem basierend auf Spatial Computing

visionOS ist Apples erstes Apple-System, das auf räumlichem Computing basiert. Dieses System basiert auf den Innovationen der drei Hauptsysteme von Apple: macOS, iOS und iPadOS und unterstützt 3D-Content-Engines.

2. Zwei Chips M2+R1:R1 sind speziell für Echtzeitsensoren konzipiert

Das Vision Pro-Kopfdisplay verfügt über ein Dual-Chip-Design und ist außerdem mit zwei wichtigen Chips ausgestattet, M2 und R1. Darunter ist R1 ein Chip, der speziell für das Kopfdisplay entwickelt wurde. Er ist auch Apples Nachfolger A-Serie, S-Serie und M-Serie. Darüber hinaus eine weitere neue Chip-Serie.

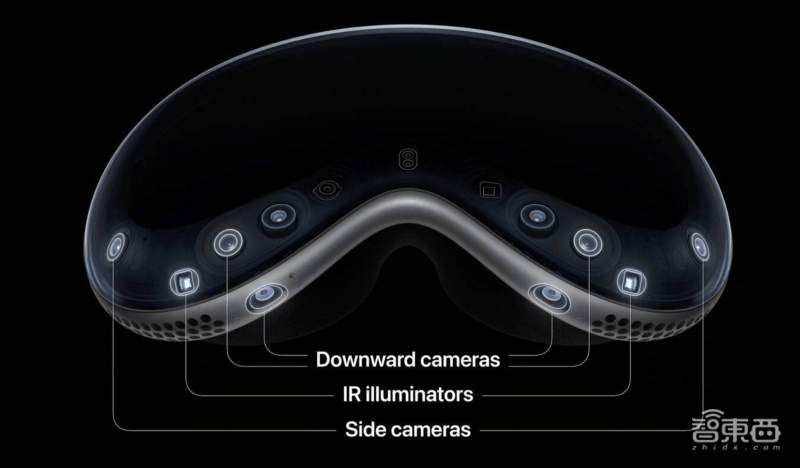

Unter anderem ist der R1-Chip speziell für die Verarbeitung von Echtzeitsensoren konzipiert. Er kann die von 12 Kameras, 5 Sensoren und 6 Mikrofonen gesammelten Daten verarbeiten und innerhalb von 12 Millisekunden neue Bilder an das Display übertragen.

3. Drei Hauptfunktionen: Sehfunktion, räumliche Videofunktion, virtuelle digitale menschliche Funktion

Sehsichtfunktion: Anzeige bei Annäherung, sodass die Interaktion mit dem Head-Mounted Display keine „Isolation“ mehr erfordert

Man kann sagen, dass die Art und Weise, wie Apple Produkte entwirft, darin besteht, dass die Produkte dem Designkonzept dienen. Mit anderen Worten: Wenn Apple hofft, dass es sich bei dem Produkt um ein am Kopf montiertes AR-Display handelt und sichergestellt wird, dass das am Kopf montierte Display kein Gefühl der Isolation zwischen den Menschen hervorruft, werden alle Produktideen und -designs Zugeständnisse in diese Richtung machen.

Mit der Eyesight-Funktion zeigt das doppelseitige Display des Headsets automatisch das Gesicht im Headset an, egal in welcher Umgebung sich der Benutzer befindet, und stellt so ein neues „Gesicht“ wieder her Gefühl der Fremdheit während der Kommunikation.

Virtuelle digitale menschliche Funktion: Stellen Sie „sich selbst“ sofort wieder her

Durch mehrere Sensoren und Kameras auf der Vorderseite des Bildschirms kann Apple sofort eine virtuelle digitale Person wiederherstellen, und die digitale Person hat auch ein Gefühl für Tiefe und Volumen.

Räumliche Audiofunktion: anpassbar an verschiedene Headsets

Das Vision Pro-Headset verfügt über viele erfrischende neue Funktionen. Durch die Audio-Raytracing-Technologie kann es sich an verschiedene räumliche Szenen anpassen und für bessere Audioeffekte sorgen.

4. Vier Hauptszenen: Arbeit, Zuhause, Spiele und Filmschauen

Auf der Pressekonferenz stellte Apple vier Einsatzszenarien für AR-Headsets vor: Arbeit, Zuhause, Gaming und Filmschauen.

Man kann sagen: Wenn die bisherigen Funktionen Sie dazu bringen, das Produktdesign von Apple zu schätzen, dann werden die vier Hauptanwendungsszenarien die Kauflust der Menschen steigern.

Unter ihnen ist eine der attraktivsten Szenen die Filmschauszene:

Apple maximiert die Funktion räumlicher Videos aus zwei Aspekten: zum einen beim Aufnehmen und zum anderen bei der Wiedergabe. In Sachen Aufnahme ist Apples AR-Headset das erste Gerät, das eine 3D-Kamera unterstützt, die Veränderungen der räumlichen Ausrichtung aus 360 Grad aufzeichnen kann. Darüber hinaus unterstützt das Vision Pro-Headset nicht nur räumliche Videoaufnahmen, sondern auch räumliche Foto-Liveaufnahmen und definiert damit die Art und Weise, wie Menschen ihr Leben aufzeichnen, neu.

In Bezug auf die Wiedergabe unterstützt Apple nicht nur die Wiedergabe einiger heruntergeladener Weltraumvideos, sondern auch die Wiedergabe von Selfie-Weltraumvideos. Wenn Sie außerdem ein Panorama aufnehmen und auf dem Headset anzeigen, wird das Panorama rundum auf dem Bildschirm angezeigt.

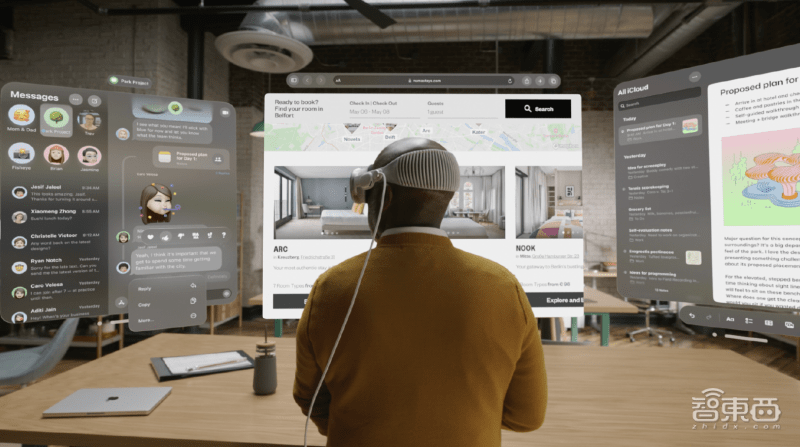

Gleichzeitig konzentrieren sich Apples Anwendungen in Arbeitsszenarien auch auf Software für Großbildbüros, kollaboratives Büro und tägliches Büro.

Wie alle vorhergesagt haben, wurden einige gängige Softwarefunktionen auf iPhone und iPad, wie Memos, Webseiten usw., alle auf Apple AR-Headsets übertragen.

Wie inländische VR- und AR-Geräte wie PICO und Nreal konzentriert sich auch das Vision Pro-Headset auf die unendliche Bildschirmausrichtung, wodurch mehrere Bildschirme gleichzeitig angezeigt werden können und Benutzer die Größe jedes Displays frei anpassen können Schnittstelle.

Gleichzeitig öffnet Apple auch die Verbindung zwischen AR-Headsets, Telefonen und Macs. Wenn Sie laut Apple einen Apple Mac-Computer und ein Head-Mounted-Display gleichzeitig öffnen, müssen Sie nur einen Blick darauf werfen, und der Bildschirm des Computers wird automatisch auf dem Head-Mounted-Display angezeigt.

In Smart-Home-Szenarien konzentriert sich Apple hauptsächlich auf das Audioerlebnis und kann das Audioerlebnis an verschiedene Heimszenarien anpassen.

Spielszenen waren noch nie die Stärke von Apple, aber auf dieser Pressekonferenz stellte Apple auch durch ein paar Sätze vor, dass das AR-Headset auch die Verknüpfung verschiedener Spielzubehörteile unterstützt und sich auf Spielszenen auf großen Bildschirmen konzentriert.

Darüber hinaus hat Apple einige grundlegende Parameterinformationen eingeführt. Das Vision Pro-Headset verfügt über ein 23-Megapixel-Display und die Bildschirmauflösung, die jedes Auge sehen kann, liegt über 4K.

Dieses doppelseitige Display integriert mehrere Sensoren und Kameras. Es ist die wichtigste Hardware im AR-Headset von Apple und bildet auch den Grundstein für eine Reihe interaktiver Funktionen.

In Bezug auf die Interaktion unterstützt das Vision Pro-Headset derzeit Augenbewegungsinteraktion, Sprachinteraktion und Gesteninteraktion, was den meisten aktuellen High-End-Headsets wie PICO 4 Pro, Meta Quest Pro und anderen Headsets ähnelt.

In Bezug auf die Akkulaufzeit kann das Apple AR-Headset laut Apple bei Anschluss an eine Stromquelle einen Tag lang verwendet werden, bei Anschluss an eine externe Stromversorgung jedoch bis zu 2 Stunden verwenden. Dies entspricht nahezu der Akkulaufzeit der meisten derzeit auf dem Markt erhältlichen Head-Mounted-Displays.

2. Apples Umstellung auf selbst entwickelte Chips ist offiziell abgeschlossen! Das Milliarden-Transistor-M2-Ultra-Monster kommt

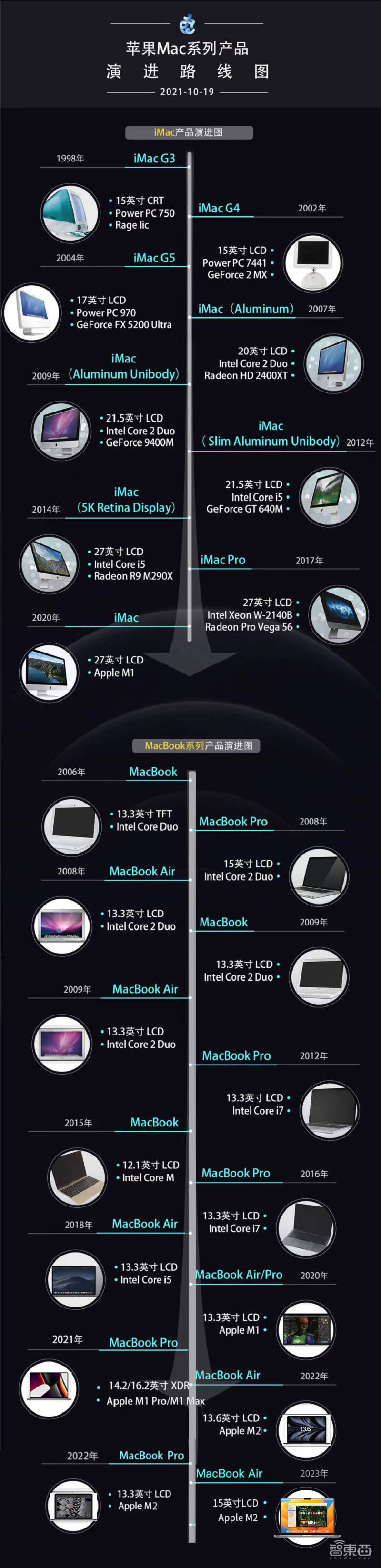

Obwohl der Fokus heute auf Apple Vision Pro liegt, sind auch die Veröffentlichung des M2 Ultra-Chips und die Iteration zweier neuer Produkte der Mac-Serie bemerkenswert, die Apple in der Einführung auch an die erste Stelle setzt.

Heute hat Apple den Übergang selbst entwickelter Chips in Mac-Computern offiziell abgeschlossen und ein neues Mac Pro-Produkt mit M2 Ultra-Chip herausgebracht.

Apples selbst entwickeltes Chip-Imperium deckt offiziell alle Apple Mac-Produktlinien ab.

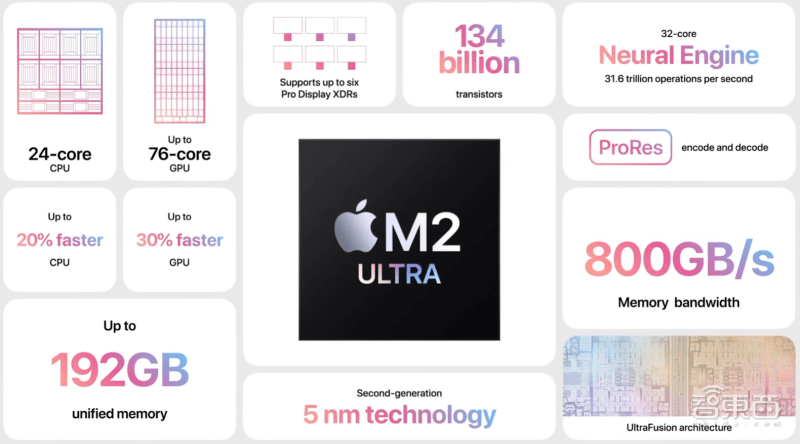

Richtig, der „Superpokal“ der M2-Serie von Apple ist endlich da. Vereinfacht gesagt „klebt“ er zwei Teile des M2 Max zusammen .

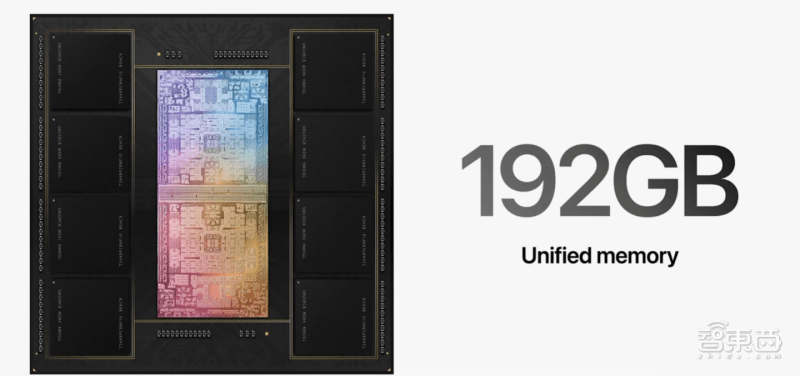

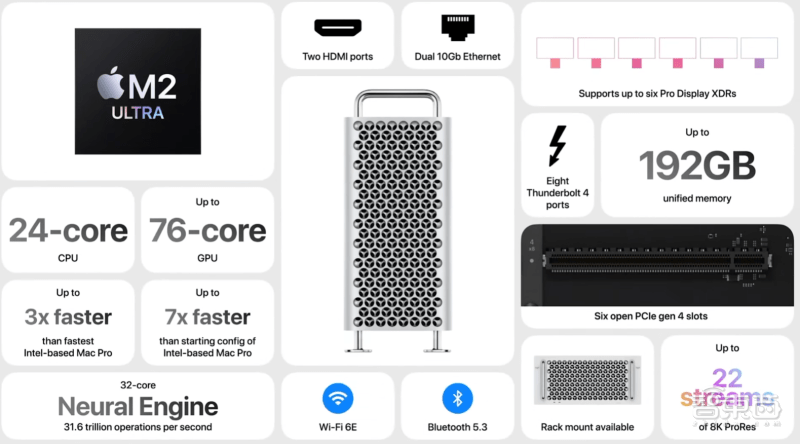

M2 Ultra verfügt über eine erschreckende 24-Kern-CPU und eine 76-Kern-GPU. Die CPU-Leistung ist um 20 % und die GPU um 30 % verbessert. Das Überraschendste ist jedoch nicht die Anzahl der Kerne der CPU und der GPU , aber die einheitliche Speicherkapazität des M2 Ultra beträgt maximal 192 GB und die Speicherbandbreite beträgt bis zu 800 GB/s. Die Rechenleistung der neuronalen Netzwerk-Engine M2 Ultra erreichte dieses Mal 31,6 TOPS bei einer Kernanzahl von 32 Kernen.

Außerdem hat die Anzahl der Transistoren im M2 Ultra die „Hundert-Milliarden-Marke“ erreicht. Sein Herstellungsprozess ist immer noch die zweite Generation 5-nm-Prozess.

Dieses Mal hat Apple M2 Ultra sowohl im neuen Mac Studio als auch im neuen Mac Pro verwendet. Dank der Hinzufügung von M2 Ultra wurde die Leistung dieser beiden Produkte auf verschiedene Weise „verdoppelt“. Beispielsweise ist der mit M2 Ultra ausgestattete Mac Studio bis zu 6-mal schneller als der iMac mit Intel-Prozessor.

Apple erwähnte ausdrücklich, dass der M2 Ultra besonders gut darin ist, umfangreiche maschinelle Lernaufgaben zu bewältigen, sogar besser als einige unabhängige Grafikkarten, und dies ist hauptsächlich auf die einheitliche Speichertechnologie der Chips der M-Serie von Apple zurückzuführen.

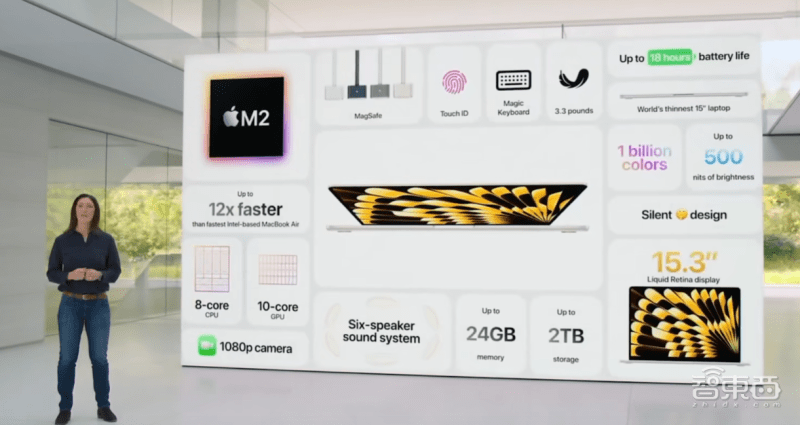

Neben zwei neuen Desktop-Mac-Produkten hat Apple heute auch das „seit langem gemunkelte“ 15-Zoll-MacBook Air offiziell veröffentlicht. Der Bildschirm ist nicht nur größer, auch die „Notch“ bleibt erhalten.

Obwohl das MacBook Air über einen größeren Bildschirm verfügt, ist es der dünnste 15-Zoll-Laptop aller Zeiten, wiegt nur 3,3 Pfund und hat eine Akkulaufzeit von bis zu 18 Stunden.

Das 15-Zoll MacBook Air ist mit dem Apple M2-Chip ausgestattet, die Leistung ist um das bis zu 12-fache verbessert und die Speicherspezifikation unterstützt bis zu 2 TB.

Die Spitzenhelligkeit des Notch-Bildschirms des neuen MacBook Air Pro kann 500 Nit erreichen und der Rahmen ist nur 5 mm schmal.

Im Allgemeinen ist der Apple M2 Ultra dieses Mal zweifellos zur „Königsbombe“ der Apple-Chips geworden, und die Updates anderer Mac-Produktlinien sind „Routine-Upgrades“ auf Basis dieses Chips.

Drei und fünf große Softwareplattform-Upgrades konzentrieren sich auf KI-Funktionen, Personalisierung, humanisierte Interaktion und Gesundheit

Unter dem Licht von Apple Vision Pro und M2 Ultra scheinen Apples Upgrades in den anderen fünf großen Systemen dieses Mal etwas „nicht gut genug“ zu sein.

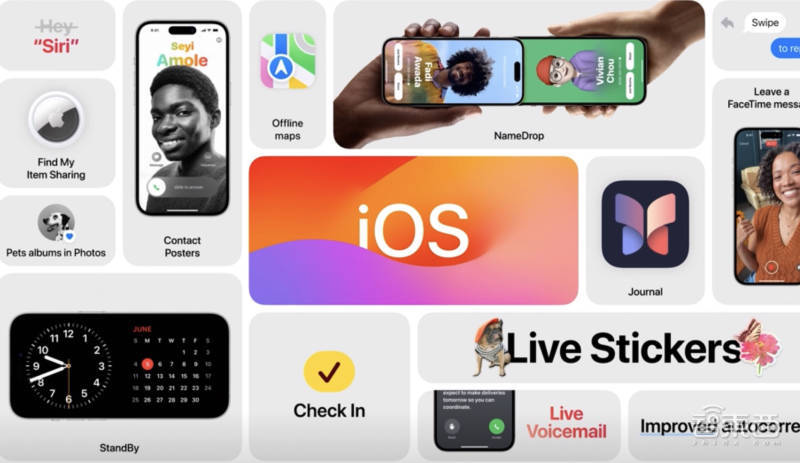

1. iOS 17: Drei große Funktionserweiterungen, kein „Hallo“ mehr nötig, wenn man Siri anruft

Dieses iOS 17-Upgrade konzentriert sich hauptsächlich auf Kommunikation, Kommunikation usw., einschließlich Upgrades der drei Hauptfunktionen Telefon, Nachricht und FaceTime.

Das aktualisierte Telefon ist nicht mehr auf einen einzelnen Anrufhintergrund beschränkt, sondern kann so angepasst werden, dass eine eigene, einzigartige Anrufoberfläche entsprechend dem Design jeder Person erstellt wird, und es kann sogar eine andere Visitenkartenoberfläche für jeden Freund angepasst werden. Die neue Version von Phone unterstützt auch die Umwandlung von Sprachnachrichten in Text, um Benutzern zu helfen, zu erkennen, ob sie rechtzeitig ans Telefon gehen müssen.

Message hat Nachhol-, Check-in- und andere Funktionen hinzugefügt. Durch die Check-in-Funktion können Sie Ihren Freunden jederzeit mitteilen, ob Sie gut zu Hause angekommen sind.

FaceTime und Tastatur haben außerdem einige kleinere Funktionsverbesserungen erhalten. Auch Apples Art, Siri aufzuwecken, hat sich von „Hey Siri“ zu „Siri“ geändert.

AirDrop-Upgrade, Apple nennt es Name Drop. Indem Sie die Mobiltelefone Ihrer Freunde aus nächster Nähe „aufkleben“, können Sie Ihre persönlichen Visitenkarten direkt versenden. Gleichzeitig ist die AirDrop-Funktion nicht mehr durch die Entfernung eingeschränkt. Sobald die Übertragung beginnt, kann die Luftabgabe auch dann abgeschlossen werden, wenn die beiden Personen weit voneinander entfernt sind.

Darüber hinaus hat iOS 17 dieses Mal eine Notizen-App hinzugefügt, die einige wichtige Punkte basierend auf einem Teil der Informationen, die an diesem Tag auf dem Mobiltelefon des Benutzers angezeigt werden, extrahiert und sie dem Benutzer präsentiert, damit Benutzer jeden Tag und jeden Tag aufzeichnen können Reise. Darüber hinaus wird die Notes-App Sie jeden Tag „an die Aktualisierung erinnern“, um die Lust der Benutzer am Erstellen zu wecken.

2. iPadOS 17: Zusätzlich zu den „Widgets“ können Sie auch das „dynamische Hintergrundbild“ von Live Photo anpassen

Apropos iPadOS 17: Eines der herausragenden Gefühle ist, dass Apple dieses Mal bei „Widgets“ hängen bleibt, egal ob es sich um ein Mobiltelefon oder ein Tablet handelt.

In iPadOS 17 können Widgets direkt interaktiv bedient werden, um die Funktionen der App zu nutzen, z. B. das Einschalten von Lichtern, das Abspielen von Musik usw.

Einfach ausgedrückt geht es darum, den Informationsumfang zu reduzieren, auf den Benutzer zugreifen können.

OPPO, vivo, Xiaomi und andere Android-Nutzer denken vielleicht, wenn sie das sehen: „Das ist es?“ Aber es handelt sich tatsächlich um eine Funktion, die schon seit vielen Generationen von Android-Anwendungen verfügbar ist.

Neben Widgets ist auch das personalisierte Anpassungserlebnis eine wichtige Upgrade-Richtung von iPadOS 17. Beispielsweise können wir das Hintergrundbild des Sperrbildschirms anpassen und es in ein Foto ändern, das uns gefällt.

Es ist erwähnenswert, dass wir mithilfe der KI-Technologie mehrere Bilder zusammenführen können, um dynamische Hintergrundbilder in einer Form zu erstellen, die einem „Live-Foto“ ähnelt.

Im Sperrbildschirm fügt iPadOS 17 eine Echtzeit-Aktivitätsfunktion hinzu. Wir können Fluginformationen überprüfen, sehen, wo sich der Imbiss befindet, die Ergebnisse der Spiele ansehen, die wir verfolgen, oder einige Timer auf dem Sperrbildschirm einstellen.

Dieses Mal hat Apple iPadOS 17 eine Gesundheits-App hinzugefügt. Durch den größeren Bildschirm können wir auch auf relevante Informationen von Drittanbieter-Apps zugreifen. Darüber hinaus erleichtert HealthKit Apple-Entwicklern die Entwicklung entsprechender Funktionen für Gesundheits-Apps.

Dieses Mal hat Apple die Anwendung von PDF in der Memo-App hervorgehoben, insbesondere im Hinblick auf die Zusammenarbeit. Verschiedene Benutzer können dasselbe PDF ändern und die geänderten Inhalte können in Echtzeit aktualisiert und synchronisiert werden.

Im Allgemeinen ist iPadOS 17 in einigen Details der vorhandenen Funktionen immer noch ein Upgrade. Personalisierung, KI und Gesundheit sind die Schlüsselwörter, die wir sehen.

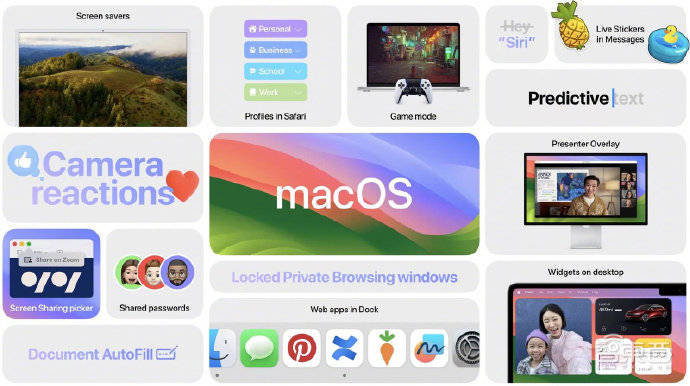

3. macOS Sonoma: Speziell eingeführter Spielemodus, Widget-Steuerung ist bequemer

Der neue Name von macOS lautet diesmal macOS Sonoma. Sonoma ist ein Landkreis in Kalifornien, USA.

Eines der Upgrades von macOS Sonoma ist auch ein Widget. Früher konnten Mac-Komponenten nur im Benachrichtigungscenter verwendet werden. Jetzt können Mac-Steuerungskomponenten überall auf dem Desktop verwendet werden, und die Farbe von Mac-Komponenten wird adaptiv an den auf der Hauptoberfläche angezeigten Bildschirm angepasst.

Spiele waren noch nie die Stärke von Apple Mac. Dieses Mal hat macOS den Spielemodus hinzugefügt, der die Betriebseffizienz von CPU und GPU verbessert und die Verzögerung von Spielzubehör reduziert.

Der japanische Spieledesigner Hideo Kojima war dieses Mal auch auf der Apple-Konferenz. Er ist der Produzent des bekannten Spiels „Death Stranding“. Die Mac-Version dieses Spiels wird in Zukunft veröffentlicht.

Bei Videokonferenzen bietet macOS Video-Overlay-Effekte. Während der Rede kann das Bild des Sprechers an verschiedenen Stellen auf dem Bildschirm erscheinen, und während der interaktiven Sitzung bietet Apple auch einige spezifische interaktive Effekte. Sie können beispielsweise hinter Ihrem Rücken ein Feuerwerk zünden.

Darüber hinaus unterstützt Safari die Umwandlung einer Webseite in eine Miniatursoftware, die mit einem Klick im Dock gespeichert werden kann, und Benutzer können die Browseroberfläche direkt im Dock öffnen.

4. watchOS 10: Achten Sie nicht nur auf Ihre körperliche Gesundheit, sondern auch auf Ihre geistige Gesundheit

Dieses Mal verfügt WatchOS 1O über ein neues Design der Systemschnittstelle, das eine Benutzeroberfläche im Snoopy-Stil und ein Porträt-Zifferblatt hinzufügt, und konzentriert sich auf die Schaffung einer intelligenten Stapelfunktion.

Über die verschiebbare Oberfläche können Benutzer mithilfe der intelligenten Stapelfunktion schnell Informationen abrufen, z. B. Timer eingeben, körperliches Training anzeigen usw.

WatchOS 1O-Anwendungen haben sich ebenfalls geändert, beispielsweise die Weltzeituhr-Schnittstelle, die Hintergrundinformationen zu verschiedenen Zeiten anzeigen kann.

Im sportlichen Bereich kann die Apple Watch den FTP für Radsportbegeisterte berechnen, was deren höchste Trainingsschwelle darstellt. Benutzer können ihre Trainingsversuche und Ergebnisse direkt einsehen.

Für Wanderbegeisterte kann die Apple Watch SOS-Erinnerungspunkte auf der Wanderroutenkarte hinzufügen, sodass Sie rechtzeitig Notsignale setzen können, um Risiken zu vermeiden.

Verglichen mit dem vorherigen Fokus auf eine breitere Abdeckung der Apple Watch legt Apple Watch jetzt mehr Wert darauf, eine professionellere Analyse für jede Trainingsmethode bereitzustellen.

Diesmal beginnt die Apple Watch nicht nur, auf die körperliche Gesundheit der Menschen zu achten, sondern auch auf die geistige Gesundheit. Die Apple Watch hilft Benutzern dabei, ihren eigenen Status zu beurteilen, indem sie ein Bewertungsformular bereitstellt. In Kombination mit relevanten Dateninformationen erinnert sie Sie an Ihre psychologischen Veränderungen.

5. Das Audio- und Videoerlebnis wurde verbessert und KI-„lernende Benutzer“ sind zu einem wichtigen Trend geworden

Im Hinblick auf die Aktualisierung der Audio- und Videoprodukttechnologie hat Apple dieses Mal eine adaptive Audiofunktion in den AirPods eingeführt. Einfach ausgedrückt: Die Kopfhörer passen den Audioeffekt und die Qualität der Geräuschreduzierung an die Hörgewohnheiten des Benutzers und die externe Hörumgebung an.

Wenn wir beispielsweise mit jemandem sprechen, reduziert das Headset die Tonaufnahme auf beiden Seiten und erhöht die Tonaufnahme auf der Vorderseite. Wenn wir ans Telefon gehen, kann adaptives Audio die Umgebungsgeräusche reduzieren und für eine bessere Reduzierung des Anrufgeräuschs sorgen .

In Bezug auf Audio kann der HomePod von Apple die Nutzungsgewohnheiten der Benutzer erlernen. Wenn er beispielsweise erfährt, dass Sie in der Küche häufig Musik hören, verbindet sich der HomePod automatisch mit Ihrem iPhone, sobald Sie die Küche betreten Verbindung bequemer.

Oh, übrigens, wenn Sie in Zukunft Siri auf dem HomePod anrufen, müssen Sie nicht „Hey, Sie können Siri direkt anrufen“ sagen (dies ist eine wichtige Änderung, Sie müssen den Test machen).

Darüber hinaus hat Apple auch die reibungslose Verbindung zwischen iPhone und Autosystem in CarPlay verbessert.

tvOS 17 aktualisiert dieses Mal hauptsächlich die interaktive Benutzeroberfläche, wodurch die Benutzeroberfläche einfacher wird. Benutzer können auch Fotos in TV-Bildschirmschoner umwandeln und diese dynamisch abspielen.

FaceTime lässt sich künftig auch auf Apple TV nutzen und Familienmitglieder können im Wohnzimmer sitzen und FaceTime für Videoanrufe nutzen. Videoanrufe auf Ihrem Mobiltelefon können zur Fortsetzung auch an Apple TV „weitergeleitet“ werden.

In Bezug auf das Audio- und Videoerlebnis nutzt Apple dieses Mal offensichtlich verschiedene KI-Technologien und zugrunde liegende Kommunikationstechnologien, um die „Unempfindlichkeit“ der Benutzer, die Geräte verwenden, zu verbessern und die Interaktion mit intelligenten Geräten natürlicher zu gestalten Obwohl Apple keine großen modellbezogenen Technologien veröffentlicht hat, ist die Anwendung von KI in Apple-Geräten allgegenwärtig.

Fazit: Die Ära des Spatial Computing ist da

Auf der Pressekonferenz heute Abend steht zweifellos Apples Apple Vision Pro im Mittelpunkt. Es bietet Funktionen, die in Bezug auf Design, Funktionalität, Leistung, Anzeige, Audio, Interaktion, Anwendungen usw. die Grenzen der bestehenden Branche durchbrechen. oder Erfahrung. Obwohl es in der Branche bereits verschiedene diesbezügliche Spekulationen gab, sorgte Apples Apple Vision Pro dennoch für viele Überraschungen und wird unweigerlich tiefgreifende Auswirkungen auf die VR- und AR-Branche haben.

Im Gegensatz dazu handelt es sich bei vielen Systemaktualisierungen von Apple heute Abend eher um „optimierte Iterationen“ bestehender Funktionen. Gleichzeitig wird in Apple-Systemen zunehmend KI-Technologie eingesetzt. Mit dem Erscheinen des Apple M2 Ultra und des neuen Mac Pro wurde auch die Umstellung der von Apple selbst entwickelten Chips offiziell abgeschlossen.

Wie Cook sagte, ist Apples Apple Vision Pro nur der Anfang. Obwohl Apple nicht der erste Hersteller ist, der in den Bereich VR und AR einsteigt, wird Apple mit seiner Reihe technologischer Innovationen zweifellos zum Branchenführer im Zeitalter der Raumgestaltung werden Computer oder welche neuen Funktionen wird Apples Produkt in Zukunft weiterentwickeln? Welche Wellen wird Apples erstes AR-Produkt in der Branche auslösen? Welche Schlüsseltechnologien sind in den 5.000 Patenten hinter diesem Produkt enthalten? Zhidongxi wird weiterhin tiefer graben, also bleiben Sie dran.

Das obige ist der detaillierte Inhalt vonApples AR-Brille Vision Pro war geboren! Die Szene war voller Schreie, der ersten richtigen Kameraaufnahme, einem Gespräch mit Cook. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr