Heim >Technologie-Peripheriegeräte >KI >GPT-4-API-Ersatz? Die Leistung ist vergleichbar und die Kosten werden um 98 % gesenkt. Stanford schlug FrugalGPT vor, aber die Forschung löste Kontroversen aus

GPT-4-API-Ersatz? Die Leistung ist vergleichbar und die Kosten werden um 98 % gesenkt. Stanford schlug FrugalGPT vor, aber die Forschung löste Kontroversen aus

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-06-05 17:59:14737Durchsuche

Mit der Entwicklung großer Sprachmodelle (LLM) befindet sich die künstliche Intelligenz in einer explosiven Phase des Wandels. Es ist allgemein bekannt, dass LLM in Anwendungen wie Wirtschaft, Wissenschaft und Finanzen eingesetzt werden kann, daher bieten immer mehr Unternehmen (OpenAI, AI21, CoHere usw.) LLM als Basisdienst an. Obwohl LLMs wie GPT-4 bei Aufgaben wie der Beantwortung von Fragen eine beispiellose Leistung erzielt haben, sind sie aufgrund ihres hohen Durchsatzes in Anwendungen sehr teuer.

Zum Beispiel kostet der Betrieb von ChatGPT über 700.000 US-Dollar pro Tag, während die Verwendung von GPT-4 zur Unterstützung des Kundenservice ein kleines Unternehmen über 21.000 US-Dollar pro Monat kosten kann. Zusätzlich zu den monetären Kosten bringt die Verwendung der größten LLMs erhebliche Auswirkungen auf die Umwelt und den Energieverbrauch mit sich.

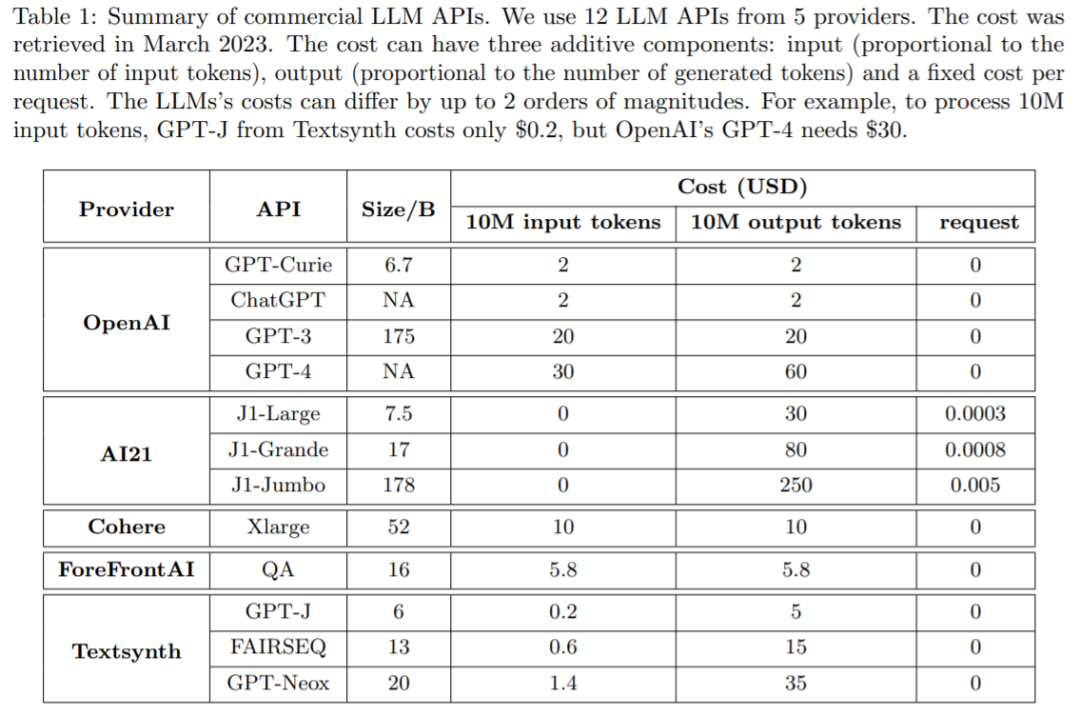

Viele Unternehmen bieten mittlerweile LLM-Dienste über API an, und ihre Gebühren variieren. Die Kosten für die Verwendung der LLM-API bestehen typischerweise aus drei Komponenten: 1) Eingabeaufforderungskosten (proportional zur Länge der Eingabeaufforderung), 2) Generierungskosten (proportional zur Länge der Generierung) und 3) manchmal ein Fixpreis pro Abfrage Kosten.

Tabelle 1 unten vergleicht die Kosten von 12 verschiedenen kommerziellen LLMs von Mainstream-Anbietern, darunter OpenAI, AI21, CoHere und Textsynth. Ihre Kosten unterscheiden sich um bis zu zwei Größenordnungen: Beispielsweise kostet der GPT-4-Prompt von OpenAI 30 US-Dollar für 10 Millionen Token, während das von Textsynth gehostete GPT-J nur 0,20 US-Dollar kostet.

Das Gleichgewicht zwischen Kosten und Genauigkeit ist ein Schlüsselfaktor bei der Entscheidungsfindung, insbesondere bei der Einführung neuer Technologien. Die effektive und effiziente Nutzung von LLM ist eine zentrale Herausforderung für Praktiker: Wenn die Aufgabe relativ einfach ist, kann durch die Aggregation mehrerer Antworten aus GPT-J (das 30-mal kleiner als GPT-3 ist) eine ähnliche Leistung wie GPT-3 erzielt werden einen Kosten- und Umweltkompromiss zu erzielen. Bei schwierigeren Aufgaben kann sich die Leistung von GPT-J jedoch erheblich verschlechtern. Daher sind neue Ansätze erforderlich, um LLM kosteneffizient einzusetzen.

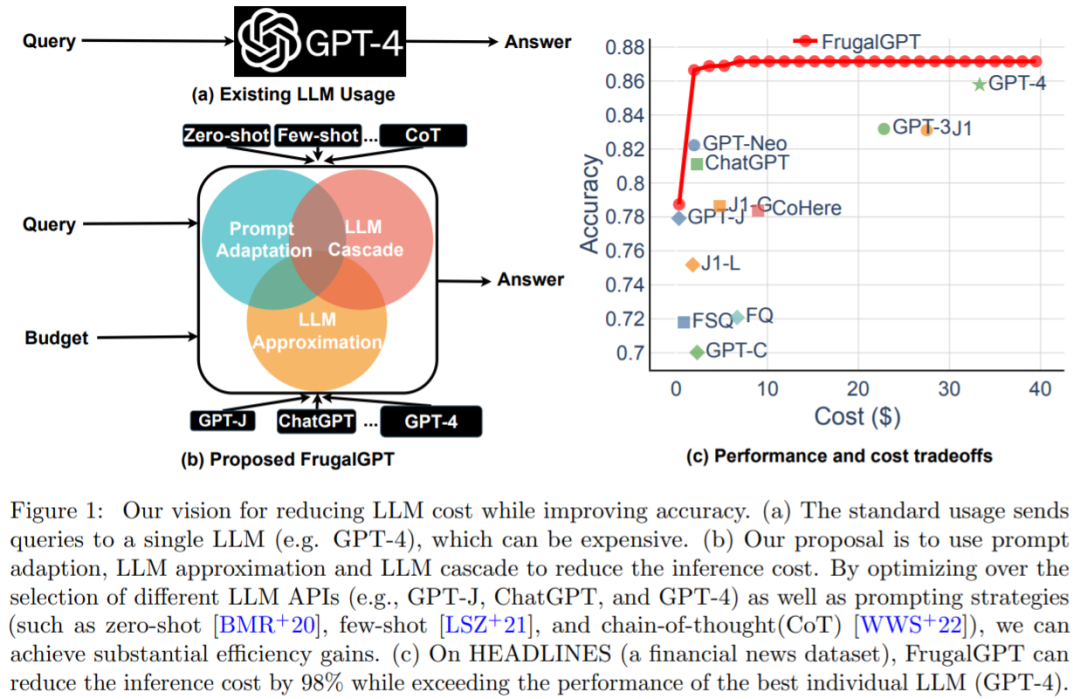

Eine aktuelle Studie hat versucht, eine Lösung für dieses Kostenproblem vorzuschlagen. Die Forscher haben experimentell gezeigt, dass FrugalGPT mit der Leistung des besten einzelnen LLM (wie GPT-4) mit einer Kostenreduzierung von bis zu 98 % konkurrieren kann. , oder Verbesserung der Genauigkeit des besten einzelnen LLM um 4 % bei gleichen Kosten. Forscher der Stanford University untersuchten die Verwendung von LLM-APIs (wie GPT-4, ChatGPT, J1-Jumbo) und stellten fest, dass diese Modelle unterschiedliche Preise haben und die Kosten um zwei Größenordnungen variieren können, insbesondere bei der Verwendung von LLM bei großen Mengen an Abfragen und Text kann teurer sein. Auf dieser Grundlage skizziert und diskutiert diese Studie drei Strategien, die Benutzer nutzen können, um die Kosten der Inferenz mithilfe von LLM zu senken: 1) sofortige Anpassung, 2) LLM-Annäherung und 3) LLM-Kaskadierung. Darüber hinaus schlägt diese Studie eine einfache und flexible Instanz von kaskadiertem LLM, FrugalGPT, vor, das lernt, welche LLM-Kombinationen in verschiedenen Abfragen verwendet werden sollen, um Kosten zu senken und die Genauigkeit zu verbessern.

Die in dieser Studie vorgestellten Ideen und Erkenntnisse legen den Grundstein für den nachhaltigen und effizienten Einsatz von LLM. Die Möglichkeit, fortschrittlichere KI-Funktionen ohne Erhöhung der Budgets einzuführen, könnte zu einer breiteren Akzeptanz der KI-Technologie in allen Branchen führen und selbst kleineren Unternehmen die Möglichkeit geben, anspruchsvolle KI-Modelle in ihre Abläufe zu implementieren.

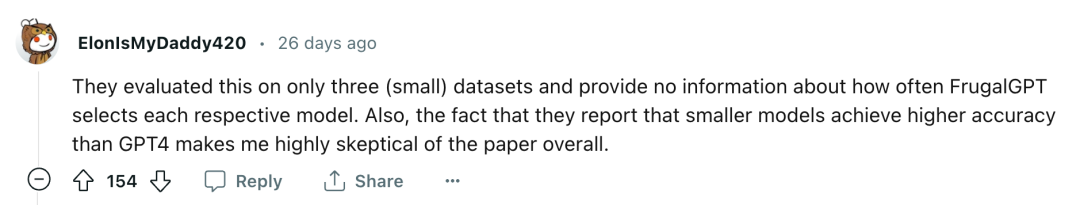

„Die Zusammenfassung übertreibt maßlos, worum es in der Arbeit geht, und der Titel hier ist maßlos irreführend. Sie haben eine Methode entwickelt, um die Anzahl der Anrufe bei High-End-Modellen zu reduzieren, die für die Art des behandelten Problems durchgeführt werden mussten.“ im Papier. Dies ist kein Ersatz für GPT-4 mit 2 % Kosten, noch ist es ein Ersatz für GPT-4 mit 4 % Genauigkeit. Es ist eine Möglichkeit, GPT-4 mit günstigeren Modellen und unterstützender Infrastruktur zu kombinieren Der Punkt ist, dass dies die Erstellung eines benutzerdefinierten Modells erfordert, um die Ergebnisse zu bewerten, was den eigentlichen Kern des Mechanismus darstellt ... Für die meisten Anwendungsfälle gibt es legitime Anwendungsfälle, einschließlich grundlegender Kostentechniken wie der Zwischenspeicherung von Ergebnissen Dies ist völlig irrelevant, da Sie kein geeignetes Bewertungsmodell haben. „Sie haben dies nur anhand von drei (kleinen) Datensätzen ausgewertet und es werden keine Informationen darüber bereitgestellt, wie oft FrugalGPT ihre jeweiligen Modelle auswählt. Darüber hinaus berichten sie, dass das kleinere Modell erreicht eine höhere Genauigkeit als GPT-4, was mich im Allgemeinen sehr skeptisch gegenüber dem Papier macht. Wie wir das konkret beurteilen können, schauen wir uns den Inhalt des Papiers an.

Wie man LLM wirtschaftlich und präzise nutzt Der nächste Artikel stellt vor, wie man die LLM-API innerhalb des Budgets effizient nutzt. Wie in Abbildung 1 (b) dargestellt, werden in dieser Studie drei Strategien zur Kostensenkung erörtert, nämlich sofortige Anpassung, LLM-Annäherung und LLM-Kaskadierung.

Der nächste Artikel stellt vor, wie man die LLM-API innerhalb des Budgets effizient nutzt. Wie in Abbildung 1 (b) dargestellt, werden in dieser Studie drei Strategien zur Kostensenkung erörtert, nämlich sofortige Anpassung, LLM-Annäherung und LLM-Kaskadierung.

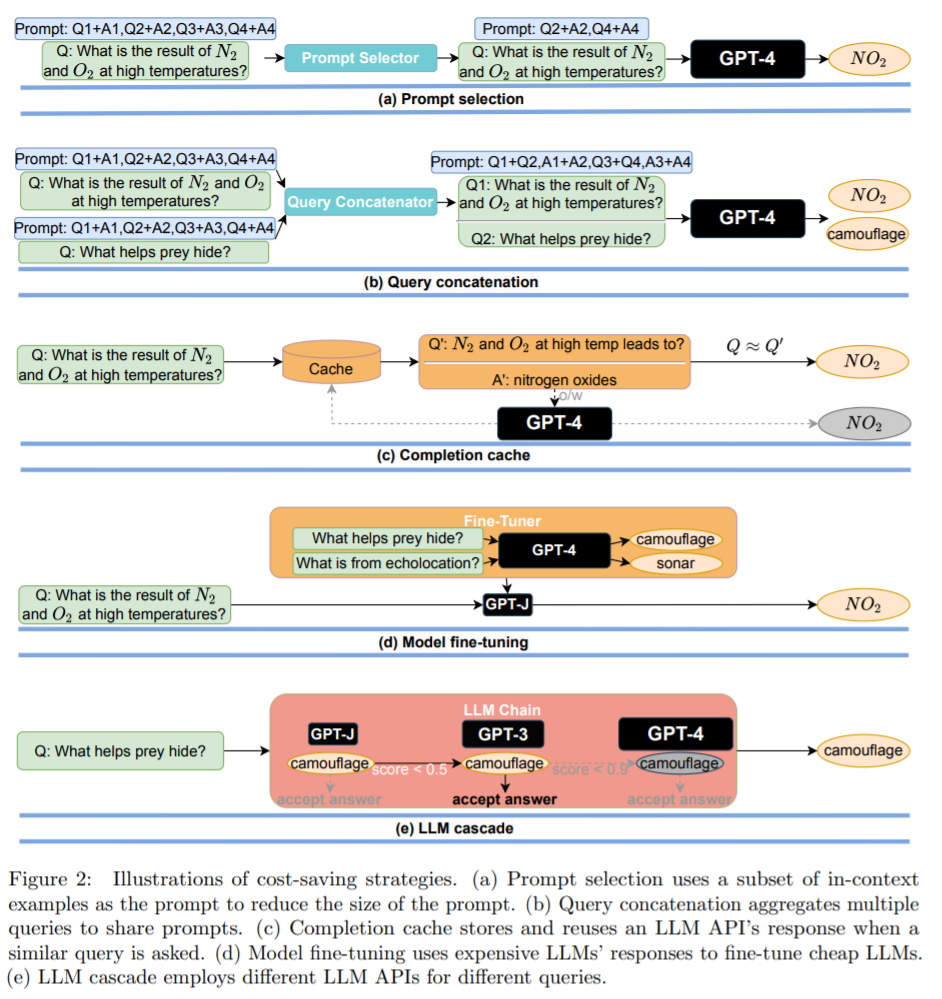

Strategie 1: zeitnahe Anpassung. Die Kosten für LLM-Abfragen steigen linear mit der Größe der Eingabeaufforderung. Ein sinnvoller Ansatz zur Reduzierung der Kosten für die Verwendung der LLM-API besteht daher in der Reduzierung der Prompt-Größe, einem Prozess, den die Studie Prompt-Anpassung nennt. Die Eingabeaufforderungsauswahl ist in Abbildung 2(a) dargestellt: Anstatt eine Eingabeaufforderung zu verwenden, die viele Beispiele enthält, um zu demonstrieren, wie eine Aufgabe ausgeführt wird, ist es möglich, nur eine kleine Teilmenge von Beispielen in der Eingabeaufforderung zu behalten. Dies führt zu kleineren Eingabeaufforderungen und geringeren Kosten. Ein weiteres Beispiel ist die Abfrageverkettung (dargestellt in Abbildung 2(b)).

Strategie 3: LLM-Kaskade. Verschiedene LLM-APIs haben bei verschiedenen Abfragen ihre eigenen Stärken und Schwächen. Daher kann eine geeignete Auswahl des zu verwendenden LLM sowohl die Kosten senken als auch die Leistung verbessern. Ein Beispiel einer LLM-Kaskade ist in Abbildung 2(e) dargestellt.

Kostenreduzierung und Genauigkeitsverbesserung Die Forscher führten eine empirische Studie zur FrugalGPT-LLM-Kaskade mit drei Zielen durch:

Die Forscher führten eine empirische Studie zur FrugalGPT-LLM-Kaskade mit drei Zielen durch:

Verstehen, was aus einfachen Beispielen der LLM-Kaskade gelernt wird;

Kosteneinsparungen quantifizieren erreicht durch FrugalGPT, wenn die Leistung der besten einzelnen LLM-API erreicht wird;

Messen Sie den Kompromiss zwischen Leistung und Kosten, der durch FrugalGPT erreicht wird.

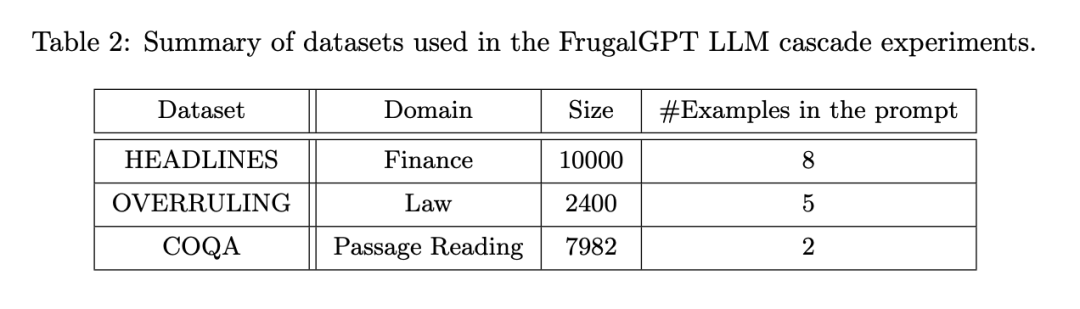

- Der Versuchsaufbau ist in mehrere Aspekte unterteilt: LLM-API (Tabelle 1), Aufgaben, Datensätze (Tabelle 2) und FrugalGPT-Instanzen.

-

FrugalGPT wurde auf der Grundlage der oben genannten API entwickelt und anhand einer Reihe von Datensätzen ausgewertet, die zu verschiedenen Aufgaben gehören. Unter diesen handelt es sich um einen Finanznachrichtendatensatz. Das Ziel besteht darin, den Goldpreistrend (oben, unten, neutral oder nicht) durch das Lesen von Finanznachrichten-Schlagzeilen zu bestimmen, was besonders nützlich ist, um relevante Nachrichten auf dem Finanzmarkt zu filtern ein Datensatz für Rechtsdokumente, dessen Ziel darin besteht, festzustellen, ob ein bestimmter Satz ein „Overruling“ ist, d Aufgabe zur Beantwortung von Anfragen.

Sie konzentrieren sich auf die LLM-Kaskadenmethode mit einer Kaskadenlänge von 3, da diese den Optimierungsraum vereinfacht und gute Ergebnisse gezeigt wurden. Jeder Datensatz wird zufällig in einen Trainingssatz zum Erlernen der LLM-Kaskade und einen Testsatz zur Auswertung aufgeteilt.

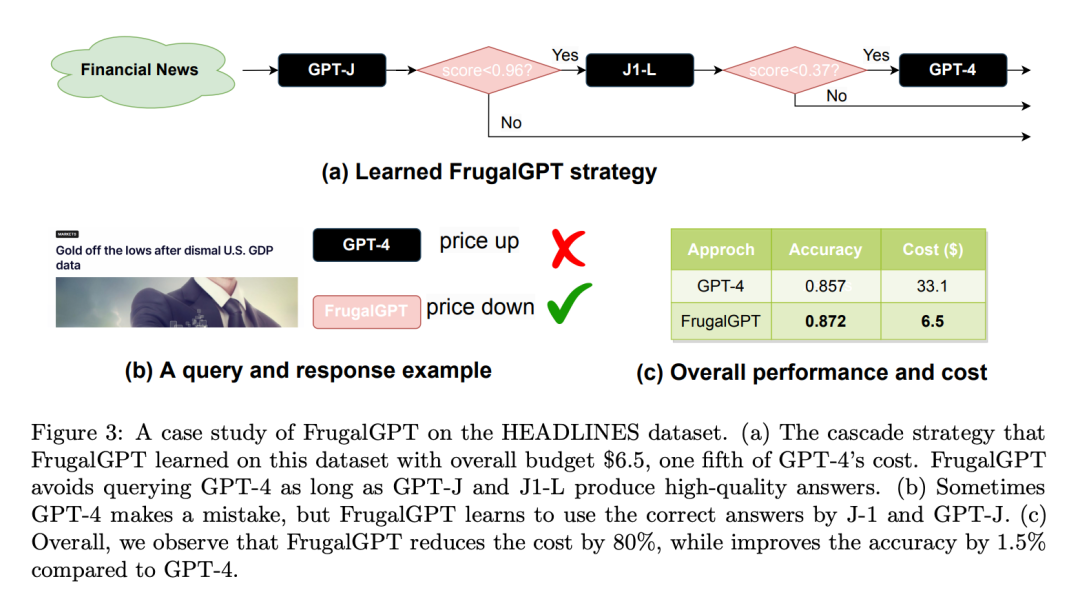

Hier ist ein HEADLINES-Datensatz-Fall Studie: Budget auf 6,50 $ festlegen, ein Fünftel der Kosten von GPT-4. Übernehmen Sie DistilBERT [SDCW19] für die Regression als Bewertungsfunktion. Es ist erwähnenswert, dass DistilBERT viel kleiner ist als alle hier betrachteten LLMs und daher kostengünstiger ist. Wie in Abbildung 3(a) dargestellt, ruft das erlernte FrugalGPT nacheinander GPT-J, J1-L und GPT-4 auf. Für jede Anfrage wird zunächst eine Antwort aus GPT-J extrahiert. Wenn die Punktzahl der Antwort größer als 0,96 ist, wird die Antwort als endgültige Antwort akzeptiert. Andernfalls wird J1-L abgefragt. Wenn der Antwortwert von J1-L größer als 0,37 ist, wird er als endgültige Antwort akzeptiert. Andernfalls wird GPT-4 aufgerufen, um die endgültige Antwort zu erhalten. Interessanterweise übertrifft dieser Ansatz GPT-4 bei vielen Abfragen. Basierend auf der Schlagzeile der Nasdaq „US-BIP-Daten sind düster, Gold hat seine Tiefststände hinter sich gelassen“ sagte FrugalGPT beispielsweise genau voraus, dass die Preise fallen würden, während GPT-4 eine falsche Antwort lieferte (wie in Abbildung 3(b) dargestellt).

Insgesamt ist das Ergebnis von FrugalGPT sowohl eine verbesserte Genauigkeit als auch geringere Kosten. Wie in Abbildung 3 (c) dargestellt, werden die Kosten um 80 % reduziert, während die Genauigkeit sogar um 1,5 % höher ist.

LLM von Vielfalt

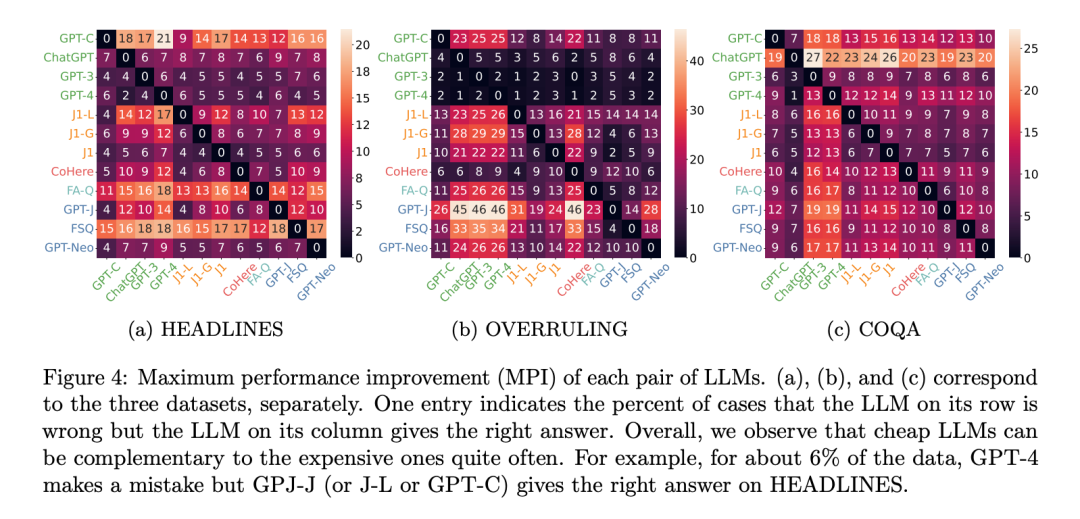

Warum erzielen mehrere LLM-APIs wahrscheinlich eine bessere Leistung als das beste einzelne LLM? Dies ist im Wesentlichen auf die Vielfalt der Generationen zurückzuführen: Selbst ein kostengünstiges LLM kann manchmal Anfragen korrekt beantworten, was ein teureres LLM nicht kann. Um diese Vielfalt zu messen, verwenden Forscher Maximum Performance Improvement, auch bekannt als MPI. Der MPI von LLM A relativ zu LLM B ist die Wahrscheinlichkeit, dass LLM A eine richtige Antwort liefert und LLM B eine falsche Antwort. Diese Metrik misst im Wesentlichen die maximale Leistungsverbesserung, die durch den gleichzeitigen Aufruf von LLM A und LLM B erreicht werden kann.

Abbildung 4 zeigt den MPI zwischen jedem LLM-API-Paar für alle Datensätze. Im HEADLINES-Datensatz verbessern GPT-C, GPT-J und J1-L alle die Leistung von GPT-4 um 6 %. Im COQA-Datensatz war GPT-4 bei 13 % der Datenpunkte falsch, aber GPT-3 lieferte die richtige Antwort. Auch wenn die Obergrenzen dieser Verbesserungen möglicherweise nicht immer erreichbar sind, zeigen sie doch die Möglichkeit, günstigere Dienste zu nutzen, um eine bessere Leistung zu erzielen.

Kosten Einsparungen

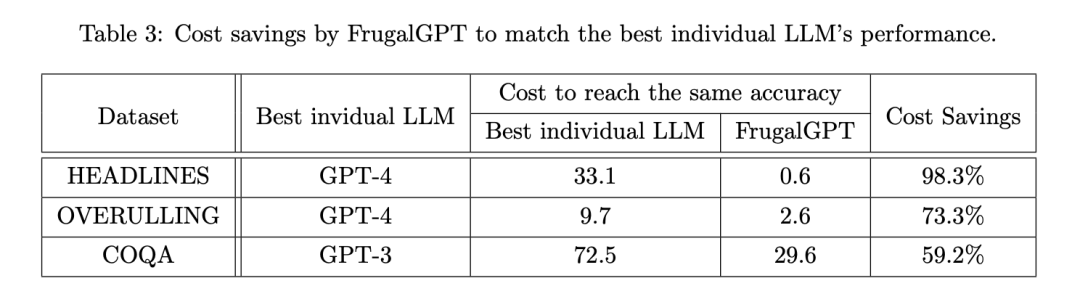

Die Forscher untersuchten dann, ob FrugalGPT die Kosten senken und gleichzeitig die Genauigkeit aufrechterhalten konnte, und wenn ja, um wie viel. Tabelle 3 zeigt die Gesamtkosteneinsparungen von FrugalGPT, die zwischen 50 % und 98 % liegen. Dies ist möglich, weil FrugalGPT diejenigen Abfragen identifizieren kann, die von kleineren LLMs genau beantwortet werden können, und daher nur die LLMs aufruft, die kosteneffektiv sind. Während leistungsstarke, aber teure LLMs wie GPT-4 nur für anspruchsvolle Abfragen verwendet werden, die von FrugalGPT erkannt werden.

Kompromiss zwischen Leistung und Kosten# 🎜 🎜#

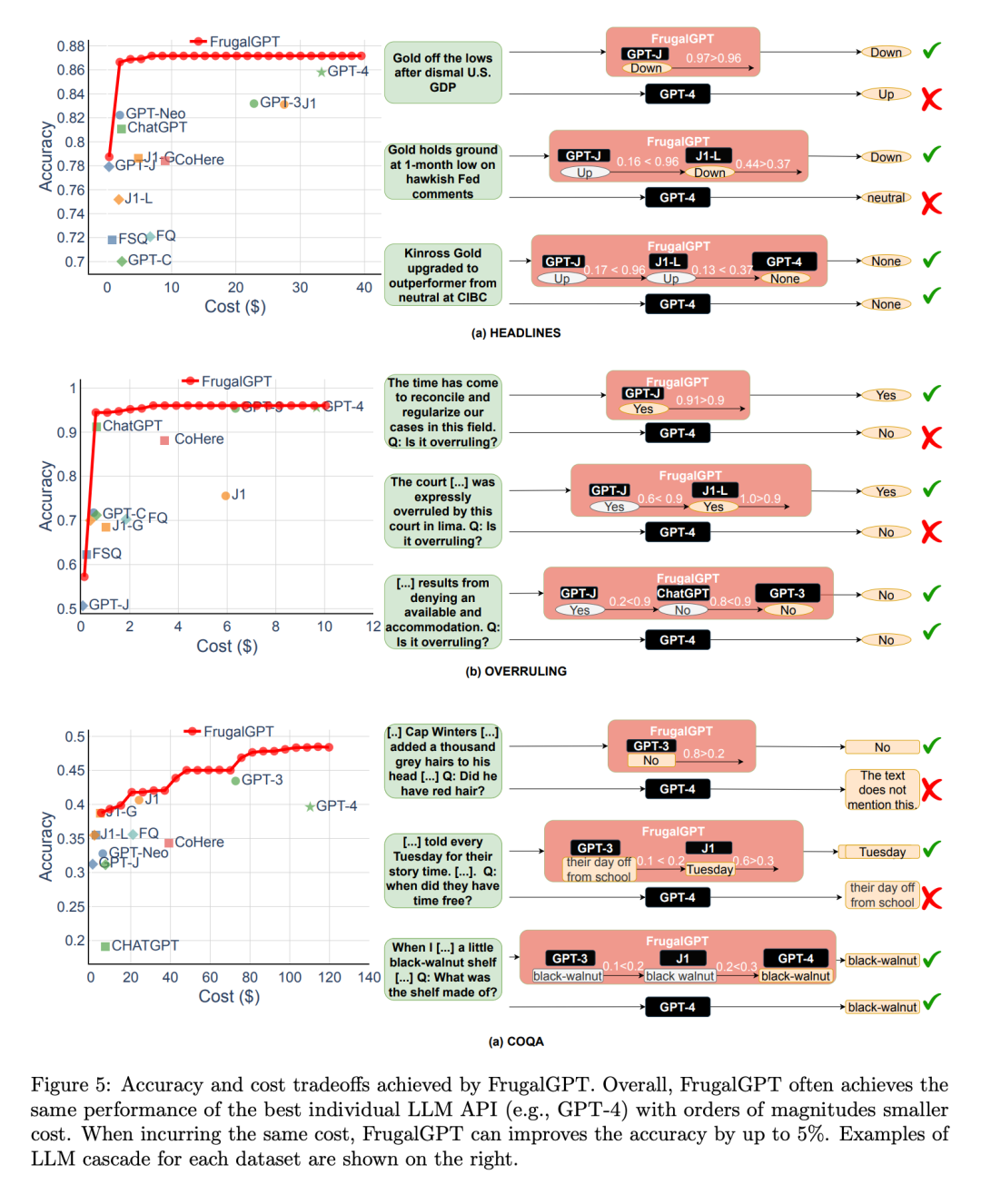

Als nächstes untersuchten die Forscher den Kompromiss zwischen Leistung und Kosten der FrugalGPT-Implementierung, wie in Abbildung 5 dargestellt, und machten mehrere interessante Beobachtungen.

Erstens sind die Kostenrankings verschiedener LLM-APIs nicht festgelegt. Darüber hinaus führen teurere LLM-APIs manchmal zu einer schlechteren Leistung als ihre günstigeren Gegenstücke. Diese Beobachtungen unterstreichen die Bedeutung einer geeigneten Auswahl von LLM-APIs, auch wenn keine Budgetbeschränkungen bestehen.

Als nächstes stellten die Forscher außerdem fest, dass FrugalGPT bei allen ausgewerteten Datensätzen einen reibungslosen Leistungs-Kosten-Kompromiss erzielen konnte. Dies bietet flexible Optionen für LLM-Benutzer und hat das Potenzial, LLM-API-Anbietern dabei zu helfen, Energie zu sparen und CO2-Emissionen zu reduzieren. Tatsächlich kann FrugalGPT gleichzeitig die Kosten senken und die Genauigkeit verbessern, möglicherweise weil FrugalGPT Wissen aus mehreren LLMs integriert.

Die in Abbildung 5 gezeigte Beispielabfrage erklärt weiter, warum FrugalGPT gleichzeitig die Leistung verbessern und die Kosten senken kann. GPT-4 macht bei einigen Abfragen Fehler, wie zum Beispiel beim ersten Beispiel in Teil (a), aber einige kostengünstige APIs liefern korrekte Vorhersagen. FrugalGPT identifiziert diese Abfragen genau und verlässt sich vollständig auf kostengünstige APIs. GPT-4 geht beispielsweise fälschlicherweise davon aus, dass die rechtliche Aussage „Es ist an der Zeit, unsere Fälle in diesem Bereich zu harmonisieren und zu standardisieren“ nicht rückgängig gemacht wird, wie in Abbildung 5(b) dargestellt. FrugalGPT akzeptiert jedoch die richtigen Antworten von GPT-J, vermeidet die Verwendung von teurem LLM und verbessert die Gesamtleistung. Natürlich ist eine einzelne LLM-API nicht immer korrekt; die LLM-Kaskadierung überwindet dieses Problem durch den Einsatz einer Kette von LLM-APIs. Im zweiten Beispiel in Abbildung 5(a) stellt FrugalGPT beispielsweise fest, dass die Generierung von GPT-J möglicherweise unzuverlässig ist, und wendet sich an das zweite LLM in der Kette, J1-L, um die richtige Antwort zu finden. Auch hier liefert GPT-4 die falsche Antwort. FrugalGPT ist nicht perfekt und es gibt noch viel Raum zur Kostensenkung. Im dritten Beispiel von Abbildung 5 (c) geben beispielsweise alle LLM-APIs in der Kette die gleiche Antwort. FrugalGPT ist sich jedoch nicht sicher, ob das erste LLM korrekt ist, was dazu führt, dass alle LLMs in der Kette abgefragt werden müssen. Wie dies vermieden werden kann, bleibt eine offene Frage.

Weitere Forschungsdetails sind verfügbar. Siehe zum Originalpapier.

Das obige ist der detaillierte Inhalt vonGPT-4-API-Ersatz? Die Leistung ist vergleichbar und die Kosten werden um 98 % gesenkt. Stanford schlug FrugalGPT vor, aber die Forschung löste Kontroversen aus. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr