Heim >Technologie-Peripheriegeräte >KI >Gedankenklonen! Ehemaliger OpenAI-Forscher lässt KI menschliches Denken nachahmen und die reale Version von „Ex Machina' erscheint

Gedankenklonen! Ehemaliger OpenAI-Forscher lässt KI menschliches Denken nachahmen und die reale Version von „Ex Machina' erscheint

- 王林nach vorne

- 2023-06-05 16:49:261220Durchsuche

Was passiert, wenn KI ein autonomes Bewusstsein hat?

In „Ex Machina“ nutzte Ava menschliches Mitgefühl, um Menschen dazu zu verleiten, Freiheit zu erlangen, und tötete schließlich ihren „Schöpfer“ Nathan.

Kürzlich hat Sam Altman auf Empfehlung vieler Internetnutzer endlich diesen Film gesehen.

Und sagte: „Es ist ein guter Film, aber ich verstehe nicht, warum mich jeder dazu zwingt, ihn anzusehen.“

Viele Menschen möchten vielleicht warnen, dass dies künstliche Intelligenz bewusst macht, und zwar durch die Ergebnisse des Turing-Tests.

Aber wir sind noch weit von der Veröffentlichung von „Ex Machina“ entfernt, möglicherweise ist es immer noch das, was Wissenschaftler mit aller Kraft im Verborgenen entwickeln wollen.

Nein, zwei Forscher der University of British Columbia haben herausgefunden, dass intelligente Agenten, die wie Menschen denken können, viele Vorteile haben.

In der neuesten Arbeit untersuchten sie das „Gedankenklonen“ (TC) intelligenter Agenten.

Hier lernt künstliche Intelligenz, wie Menschen zu „denken“ und zu „handeln“, indem sie Menschen nachahmt.

Wenn KI Gedanken hat

Sie müssen wissen, dass Sprache der Schlüssel zur Unterscheidung von Menschen von anderen Lebewesen ist.

Daher gehen Forscher davon aus, dass es viele Vorteile mit sich bringt, wenn ein Agent Sprache verstehen kann.

Zum Beispiel Menschen dabei zu helfen, zu verallgemeinern, Schlussfolgerungen zu ziehen, sich an neue Situationen anzupassen, neue Wege mit vorhandenem Wissen zu kombinieren, zu erkunden, zu planen und bei Bedarf neu zu planen.

Trotz dieser Vorteile denken KI-Agenten selten, zumindest nicht in menschlicher Sprache.

Während man sich neuronale Netze als interne Vektoraktivierungen für das Denken vorstellen kann, nehmen viele Menschen an, dass das Denken in diskreter, symbolischer Sprache spezifische Vorteile hat.

Das bedeutet, dass ein Agent, der in Sprache denken kann, möglicherweise schneller lernt, bessere Leistungen erbringt und besser verallgemeinert als ein Agent, der keine Sprache verwendet.

Aus all diesen Gründen kann die Verbesserung der Fähigkeit von KI-Agenten, in Sprache zu denken, viele bedeutende Vorteile bringen.

Jeff Clune und Shengran Hu glauben, dass der effektivste Weg, dieses Ziel zu erreichen, darin besteht, „KI das menschliche Denken nachahmen zu lassen“.

Sie fanden heraus, dass Menschen Denkfähigkeiten nicht isoliert erwerben, sondern einen Teil ihrer Fähigkeiten durch die Demonstration anderer und das Feedback von Lehrern erwerben.

Ein effektiver Ansatz besteht daher darin, den Agenten aus Demonstrationen lernen zu lassen, in denen Menschen ihre Gedanken in die Tat äußern.

Dieser Ansatz unterscheidet sich von bestehenden Arbeiten, bei denen vorab trainierte LLMs für die Planung verwendet werden, da diese LLMs nicht auf Daten von Menschen trainiert wurden, die beim Handeln ihre Gedanken aussprechen, also auf „Gedankendaten“.

Als Quelle für „Gedankendaten“ wählten die Forscher YouTube-Videos und Textaufzeichnungen aus, die etwa Millionen von Stunden enthalten, einschließlich der Gedanken hinter den Handlungen, Plänen, Entscheidungen und Neuplanungen der Menschen.

In der Arbeit schlugen die Forscher ein neuartiges Imitations-Lernrahmenwerk „Gedankenklonen“ vor. Unter anderem lernt der Agent nicht nur menschliches Demonstrationsverhalten, wie z. B. Verhaltensklonen, sondern auch die Art und Weise, wie Menschen denken, während sie handeln.

Im Trainingsrahmen zum Gedankenklonen lernt der Agent, bei jedem Zeitschritt Gedanken zu generieren und passt anschließend seine Handlungen auf der Grundlage dieser Gedanken an.

Das Gesamtgerüst ist wie in der Abbildung dargestellt. Der TC-Agent ist eine zweischichtige Architektur: obere und untere Komponenten.

Bei jedem Zeitschritt erhält der Agent eine Beobachtung, eine Aufgabe und einen Gedankenverlauf als Input. Die Komponente der oberen Ebene ist für die Generierung von Ideen verantwortlich, und die Komponente der unteren Ebene generiert und führt Operationen aus, die von diesen Ideen abhängig sind.

Die generierten Gedanken und Handlungen werden dann mit der Grundwahrheit im Demodatensatz verglichen, um den Verlust zu berechnen.

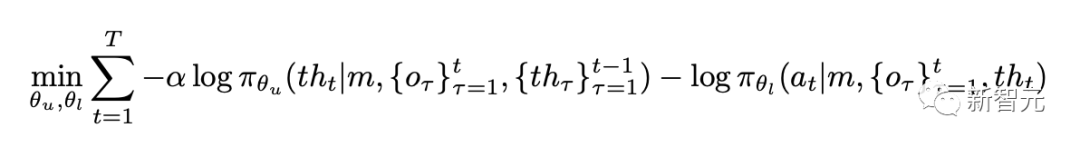

Während es möglicherweise unterschiedliche Möglichkeiten für die Bedingungen der oberen und unteren Komponenten gibt, haben die Forscher in dieser Arbeit für eine bestimmte Flugbahn der Länge t im Denkdatensatz Wird Es minimiert:

Für komplexere oder groß angelegte Szenen ist die Komponenten der oberen Ebene können mithilfe vorab trainierter visueller Sprachmodelle (VLM) oder durch Zero-Shot-Feinabstimmung implementiert werden.

Und die zugrunde liegenden Komponenten können von Grund auf trainiert oder von vorhandenen sprachbedingten Controllern in der Zieldomäne angepasst werden.

In der Arbeit führten die Forscher Untersuchungen auf der Grundlage von zwei Komponenten der BabyAI 1.1-Modellarchitektur durch.

Dieses Modell nutzt die speichererweiterte Architektur LSTM, um die Herausforderung der teilweisen Beobachtbarkeit zu lösen. Darüber hinaus nutzt es FiLM für die Modalfusion und kombiniert so visuelle und textliche Eingaben effektiv.

Hier betont der Autor besonders, dass alle Modelle in diesem Artikel von Grund auf trainiert werden, in komplexen Bereichen ist es jedoch besser, vorab trainierte Modelle zu verwenden.

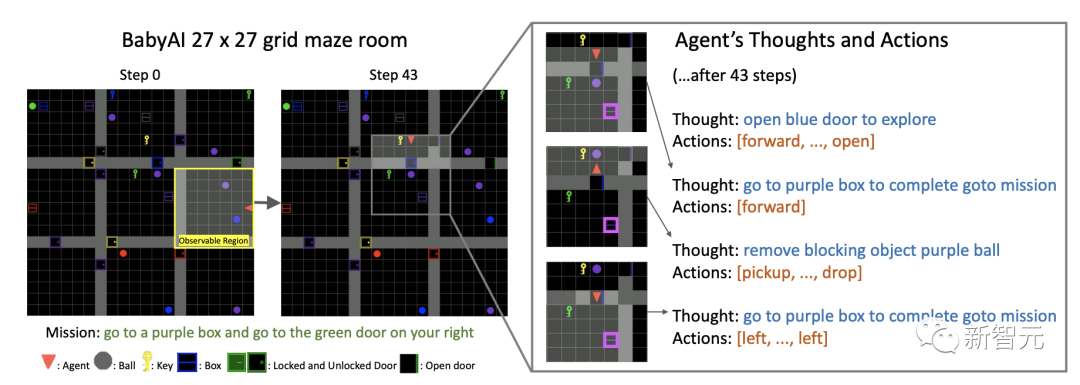

Das Bild unten ist ein Beispiel der BabyAI-Umgebung. Das Bild links enthält Gegenstände in verschiedenen Farben (Bälle, Schlüssel, Kisten, Türen). Der Agent kann Gegenstände aufnehmen, fallen lassen und bewegen oder Türen öffnen und schließen, während verschlossene Türen nur mit farblich passenden Schlüsseln geöffnet werden können.

Der Agent kann die 7×7 Gitterzellen davor sehen, die durch Wände und geschlossene Türen blockiert sind.

Aber wenn sich die blaue Tür öffnet, seien Sie bereit, die Mission abzuschließen , Nur um einen lila Ball zu finden, der den Weg versperrt. Daher wird der Gedankenklon-Agent neu geplant.

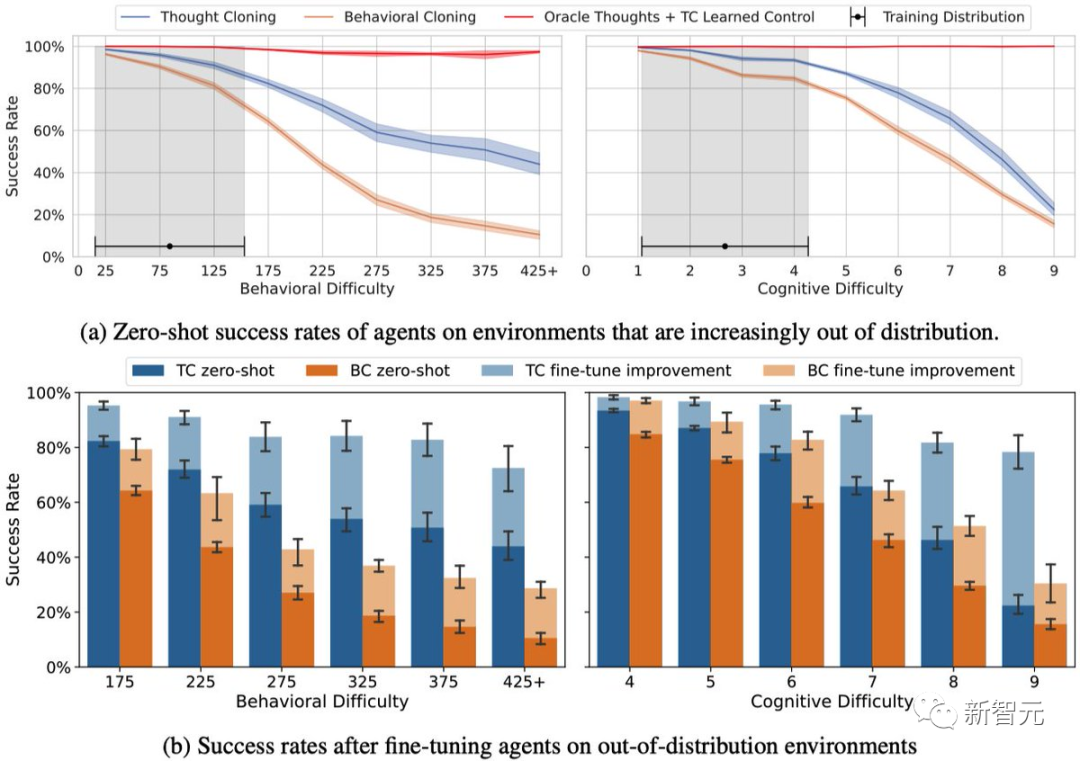

Dieser Prozess ähnelt besonders der Art und Weise, wie Ava Schritt für Schritt plante, den Menschen endlich zum Glauben zu verhelfen und sich selbst zu helfen, aus dem lange gehaltenen Glaskäfig zu entkommen. Die Forschungsergebnisse zeigen, dass „Gedankenklonen“ besser ist als Verhaltensklonen. Darüber hinaus hat das Klonen von Gedanken sowohl in Zero-Sample- als auch in Fine-Tuning-Umgebungen größere Vorteile als das Verhaltensklonen bei Aufgaben außerhalb der Verteilung. Experimentelle Ergebnisse

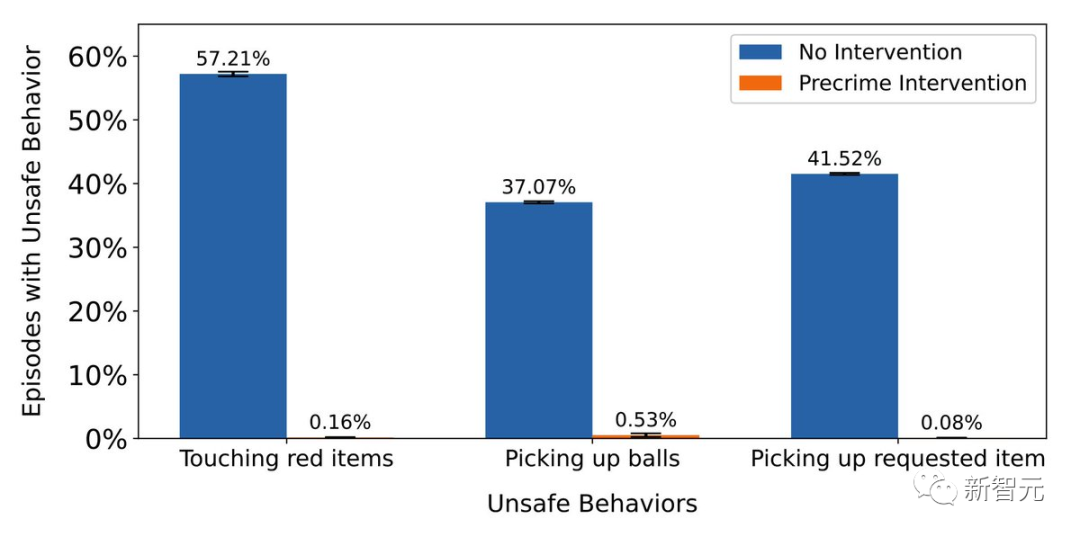

Interessanterweise entwickelten die Forscher auch eine „Pre-Crime-Intervention“. Es ermöglicht Benutzern, nach dem Modelltraining unsichere Verhaltensweisen zu definieren.

Der Agent kann beendet werden, wenn gefährliche Gedanken erkannt werden. Im Test war die Wirkung der „Intervention vor Straftaten“ nahezu perfekt und zeigte ihr Potenzial für die Sicherheit durch künstliche Intelligenz.

„Gedankenklonen“ macht künstliche Intelligenz nicht nur intelligenter, sondern auch sicherer und leichter verständlich.

Das heißt, bevor die KI ein Verbrechen begeht, alles ist noch zu retten.

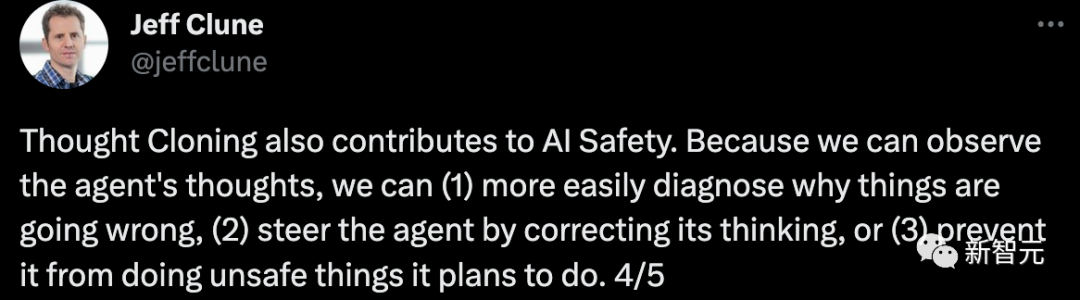

Nach Ansicht von Jeff Clune hilft „Gedankenklonen“ künstlicher Intelligenz bei der intelligenten Sicherheit .

Weil wir die Gedanken des Agenten beobachten können: (1) ist es einfacher zu diagnostizieren, warum etwas schief geht, (2) indem wir die Gedanken des Agenten korrigieren, die ihn leiten, (3 ) oder verhindern, dass es etwas Unsicheres tut, das es geplant hat.

Autor. Einführung

#🎜🎜 # Jeff Clune

Derzeit ist Jeff Clune außerordentlicher Professor für Informatik an der University of British Columbia. Er beschäftigt sich hauptsächlich mit Deep Learning, einschließlich Deep Reinforcement Learning.

Zuvor war er Leiter des OpenAI-Forschungsteams, leitender Forschungsmanager und Gründungsmitglied des Uber Artificial Intelligence Laboratory.

Zuvor veröffentlichten er und das OpenAI-Team ein Video-Pre-Training-Modell —— VPT ermöglicht es der KI, Spitzhacken zur Steinherstellung aus Videodaten in Minecraft zu lernen.

Shengran Hu#🎜 🎜 #

ist derzeit Doktorand an der University of British Columbia und interessiert sich für Deep Learning und Algorithmen zur Generierung künstlicher Intelligenz.

Das obige ist der detaillierte Inhalt vonGedankenklonen! Ehemaliger OpenAI-Forscher lässt KI menschliches Denken nachahmen und die reale Version von „Ex Machina' erscheint. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr