Heim >Technologie-Peripheriegeräte >KI >Aktuelles Interview mit OpenAI-Gründer Sam Altman: GPT-3 oder Open Source, Skalierungsregeln beschleunigen den Aufbau von AGI

Aktuelles Interview mit OpenAI-Gründer Sam Altman: GPT-3 oder Open Source, Skalierungsregeln beschleunigen den Aufbau von AGI

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-06-04 22:22:181256Durchsuche

Produziert von Big Data Digest

„Uns mangelt es sehr an GPUs“

In einem aktuellen Interview antwortete Sam Altman, der Leiter von OpenAI, auf die Frage des Gastgebers: „Die Unzufriedenheit liegt in der Zuverlässigkeit und Geschwindigkeit der API.“ "

Dieses Interview stammt von Raza Habib, CEO des Startups für künstliche Intelligenz Humanloop. Er hat die Highlights des Interviews auf Twitter zusammengestellt.

Twitter-Adresse:

https://twitter.com/dr_cintas/status/1664281914948337664

In diesem Interview kündigte Altman auch den GPT-Plan für die letzten zwei Jahre an, beispielsweise den Plan für 2023 Es geht darum, die Kosten von GPT-4 zu senken und die Reaktionsgeschwindigkeit zu verbessern.

Ein längeres Kontextfenster, das 1 Million Token unterstützen kann.

3. API, die den Sitzungsstatus unterstützt, d. h. API, die den Sitzungsstatus unterstützt.

Der Plan für 2024 sieht vor, dass GPT-4 die Multimodalität unterstützt. Der Grund, warum er auf 2024 verschoben wurde, ist, dass zu wenig GPU vorhanden ist.

Raza Habib veröffentlichte ursprünglich detailliertere Informationen zu diesem Interview gegenüber Humanloop, aber als Digest heute Morgen nachschaute, hatte die Seite bereits den Status 404. Laut der Übersetzung von @宝玉xp auf inländischem Weibo erwähnte er auch die Skalierungsregeln für die zukünftige Entwicklung großer Modelle:

Die internen Daten von OpenAI zeigen, dass die Skalierungsregeln für die Modellleistung weiterhin wirksam sind und das Modell größer machen wird weiterhin Leistung erbringen. OpenAI hat seine Modelle millionenfach skaliert und kann daher nicht in einem Tempo weiter skalieren, das in Zukunft nicht mehr nachhaltig sein wird. Das bedeutet nicht, dass OpenAI nicht weiterhin versuchen wird, Modelle größer zu machen, sondern nur, dass sie sich wahrscheinlich jedes Jahr nur verdoppeln oder verdreifachen werden, anstatt um viele Größenordnungen zu wachsen.

Die Tatsache, dass die Skalierung weiterhin effektiv ist, hat wichtige Auswirkungen auf den Zeitplan der AGI-Entwicklung. Die Skalierungsannahme ist, dass wir wahrscheinlich bereits über die meisten Teile verfügen, die zum Aufbau einer AGI erforderlich sind, und der Großteil der verbleibenden Arbeit darin bestehen wird, bestehende Methoden auf größere Modelle und größere Datensätze zu skalieren. Wenn die Ära der Skalierung vorbei ist, sollten wir wahrscheinlich damit rechnen, dass AGI noch weiter entfernt sein wird. Dass das Gesetz der Skalierung weiterhin in Kraft ist, deutet stark auf eine kürzere Zeitspanne hin.

Offensichtlich ist das Gesetz der Skalierung der schnellste Weg zur AGI.

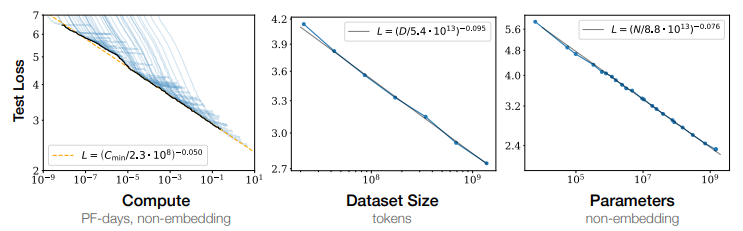

Was ist die Skalierungsregel?

Mit anderen Worten, wenn die Anzahl der Parameter (Parameter) des Modells, die Menge der am Training beteiligten Daten (Tokens) und die Menge der während des Trainingsprozesses akkumulierten Berechnungen (FLOPS) exponentiell zunehmen, kommt es zum Verlust des Modells auf dem Testsatz nimmt linear ab, was bedeutet, dass die Wirkung des Modells besser ist.

Im Jahr 2022 führte DeepMind weitere Analysen in ScalingLaw durch. Die Forschung hat durch quantitative Experimente bestätigt, dass die Größe der Sprachmodell-Trainingsdaten proportional zur Größe der Modellparameter vergrößert werden sollte. Wenn der Gesamtberechnungsumfang unverändert bleibt, weist der Effekt des Modelltrainings einen optimalen Gleichgewichtspunkt zwischen der Parametergröße und der Trainingsdatenmenge auf. Der niedrigste Punkt unter der Kurve ist ein sehr guter Kompromiss zwischen der Parametergröße und der Trainingsdatenmenge. Punkt.

Der Erfolg von OpeaAI und GPT-4

OpenAI war ursprünglich ein gemeinnütziges Forschungslabor für künstliche Intelligenz, das 2016 von Sam Altman und Elon Musk eine Milliarde US-Dollar an Fördermitteln erhielt.

Im Jahr 2019 verwandelte sich OpenAI in ein gewinnorientiertes Forschungslabor für künstliche Intelligenz, um Investorengelder aufzunehmen.

Als dem Labor die Mittel zur Unterstützung seiner Forschung ausgehen, kündigte Microsoft an, eine weitere Milliarde US-Dollar in das Labor zu investieren.

Jede Version der von OpenAI gestarteten GPT-Reihe kann für Karneval in der Branche sorgen. Auf der Microsoft Build 2023-Entwicklerkonferenz hielt OpenAI-Gründer Andrej Karpthy eine Rede: „State of GPT“ (die aktuelle Situation von GPT) und sagte, dass dies schon immer der Fall gewesen sei Betrachtet wird das Modell als „menschliches Gehirn“.

Andrej erwähnte, dass das aktuelle große LLM-Sprachmodell mit System 1 (schnelles System) des menschlichen Denkmodus verglichen werden kann, das mit System 2 (langsames System) verglichen wird, das langsam reagiert, aber über längerfristige Überlegungen verfügt.

„System eins ist ein schneller, automatischer Prozess, der meiner Meinung nach in gewisser Weise dem LLM entspricht, nur das Abtasten von Markern

System zwei ist der langsamere, gut durchdachte Planungsteil des Gehirns

Und im Grunde die Hoffnung.“ ist, dass LLM einige der Fähigkeiten unseres Gehirns wiederherstellen kann.“

Andrej Karpthy erwähnte auch, dass GPT-4 ein erstaunliches Artefakt ist und er für seine Existenz sehr dankbar ist. Es verfügt über eine Menge Wissen in vielen Bereichen, es kann Mathematik, Code und mehr erledigen, alles auf Knopfdruck.

Und CEO Altman sagte, dass GPT-4 in der Anfangszeit sehr langsam war, Fehler hatte und viele Dinge schlecht machte. Aber das galt auch für die ersten Computer, die den Weg zu etwas wiesen, das in unserem Leben sehr wichtig werden würde, auch wenn die Entwicklung Jahrzehnte dauerte.

Es scheint, dass OpenAI eine Organisation ist, die auf Träumen besteht und ein Unternehmen, das Dinge bis zum Äußersten tun will.

Wie Zhou Ming, ehemaliger Vizepräsident von Microsoft Research Asia und Gründer von Lanzhou Technology, in einem Interview erwähnte:

OpenAIs größte Errungenschaft besteht darin, in allen Aspekten Perfektion zu erreichen, und es ist ein Modell für integrierte Innovation.

Es gibt verschiedene Arten von Menschen auf der Welt. Manche Menschen wollen einfach nur die zugrunde liegende Innovation studieren. Bei einigen handelt es sich um Anwendungen, die auf zugrunde liegenden Innovationen basieren, während allgemeine Anwendungen eine einzelne Aufgabe lösen sollen. Es kann wie folgt umgeschrieben werden: Ein anderer Ansatz besteht darin, integrierte Innovationen zu erreichen, indem alle Arbeiten, Anwendungen und Algorithmen auf einer großen Plattform konzentriert werden, um Meilensteine zu schaffen. OpenAI leistet wirklich gute Arbeit bei der Integration von Innovationen. T Referenz: tHttps: //mp.weixin.qq.com/s/p42pbvyjzws8xsstdor2jw https://mp.weixin.qq.com/s/zmegzm1cdxupnoqzyg https://weibo.com. /1727858283/4907695679472174?wm=3333_2001&from=10D 5293010&Quellentyp =weixin&s_trans=6289897940_4907695679472174&s_channel=4 https://humanloop.com/blog/openai-plans?cnotallow=bd9e7 6a5f41a6d847de52fa275480e22

Das obige ist der detaillierte Inhalt vonAktuelles Interview mit OpenAI-Gründer Sam Altman: GPT-3 oder Open Source, Skalierungsregeln beschleunigen den Aufbau von AGI. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr