Heim >Technologie-Peripheriegeräte >KI >Jeder versteht ChatGPT Kapitel 1: ChatGPT und die Verarbeitung natürlicher Sprache

Jeder versteht ChatGPT Kapitel 1: ChatGPT und die Verarbeitung natürlicher Sprache

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-05-29 15:54:591407Durchsuche

ChatGPT (Chat Generative Pre-training Transformer) ist ein KI-Modell, das zum Bereich der Natural Language Processing (NLP) gehört, einem Zweig der künstlichen Intelligenz. Die sogenannte natürliche Sprache bezieht sich auf Englisch, Chinesisch, Deutsch usw., mit denen Menschen

in Kontakt kommen und die sie in ihrem täglichen Leben verwenden. Bei der Verarbeitung natürlicher Sprache geht es darum, es Computern zu ermöglichen, natürliche Sprache zu verstehen und korrekt zu verarbeiten, um von Menschen vorgegebene Aufgaben zu erfüllen. Zu den häufigsten Aufgaben im NLP gehören die Schlüsselwortextraktion aus Text, die Textklassifizierung, maschinelle Übersetzung usw.

Es gibt noch eine weitere sehr schwierige Aufgabe im NLP: Dialogsysteme, die allgemein auch als Chatbots bezeichnet werden können, und genau das macht ChatGPT.

ChatGPT und Turing-Test

Seit dem Aufkommen von Computern in den 1950er Jahren haben Menschen begonnen zu untersuchen, wie Computer Menschen beim Verstehen und Verarbeiten natürlicher Sprache unterstützen können Bereich des NLP Unter den Entwicklungszielen ist der Turing-Test das bekannteste.

Im Jahr 1950 führte Alan Turing, der Vater der Computer, einen Test ein, um zu überprüfen, ob eine Maschine wie ein Mensch denken kann. Dieser Test wurde Turing-Test genannt. Die spezifische Testmethode ist genau die gleiche wie die aktuelle ChatGPT-Methode, d. h. der Aufbau eines Computerdialogsystems, bei dem eine Person und das zu testende Modell miteinander sprechen Eine andere Person bedeutet, dass das Modell den Turing-Test bestanden hat und der Computer intelligent ist.

Der Turing-Test galt in akademischen Kreisen lange Zeit als schwer fassbarer Höhepunkt. Aus diesem Grund wird NLP auch als Kronjuwel der künstlichen Intelligenz bezeichnet. Die Arbeit, die ChatGPT leisten kann, geht weit über den Rahmen von Chat-Robotern hinaus. Es kann Artikel gemäß Benutzeranweisungen schreiben, technische Fragen beantworten, mathematische Probleme lösen, Fremdsprachenübersetzungen durchführen, Wortspiele spielen usw. ChatGPT hat sich also gewissermaßen das Kronjuwel gesichert.

ChatGPTs Modellierungsformular

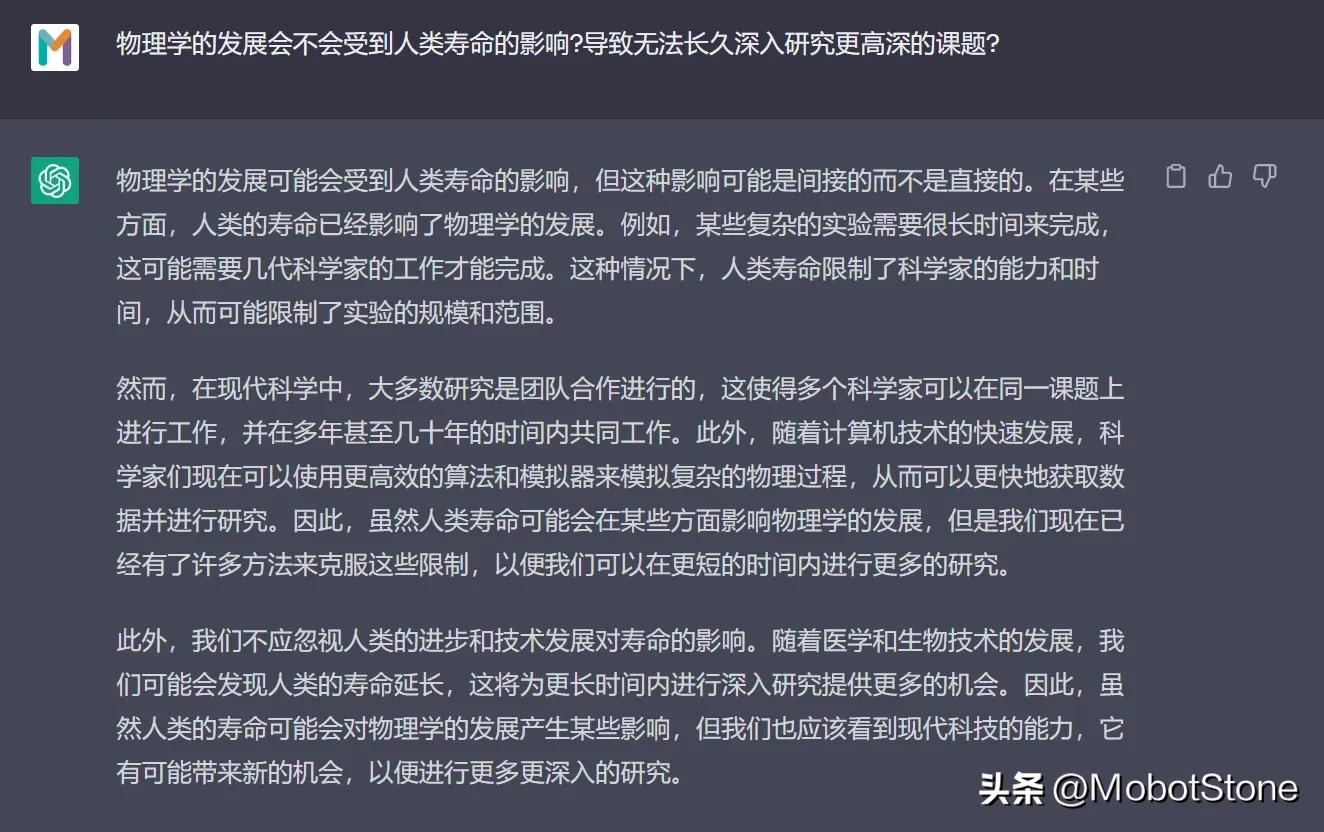

ChatGPTs Arbeitsformular ist sehr einfach. Benutzer können ChatGPT jede Frage stellen und das Modell wird sie beantworten.

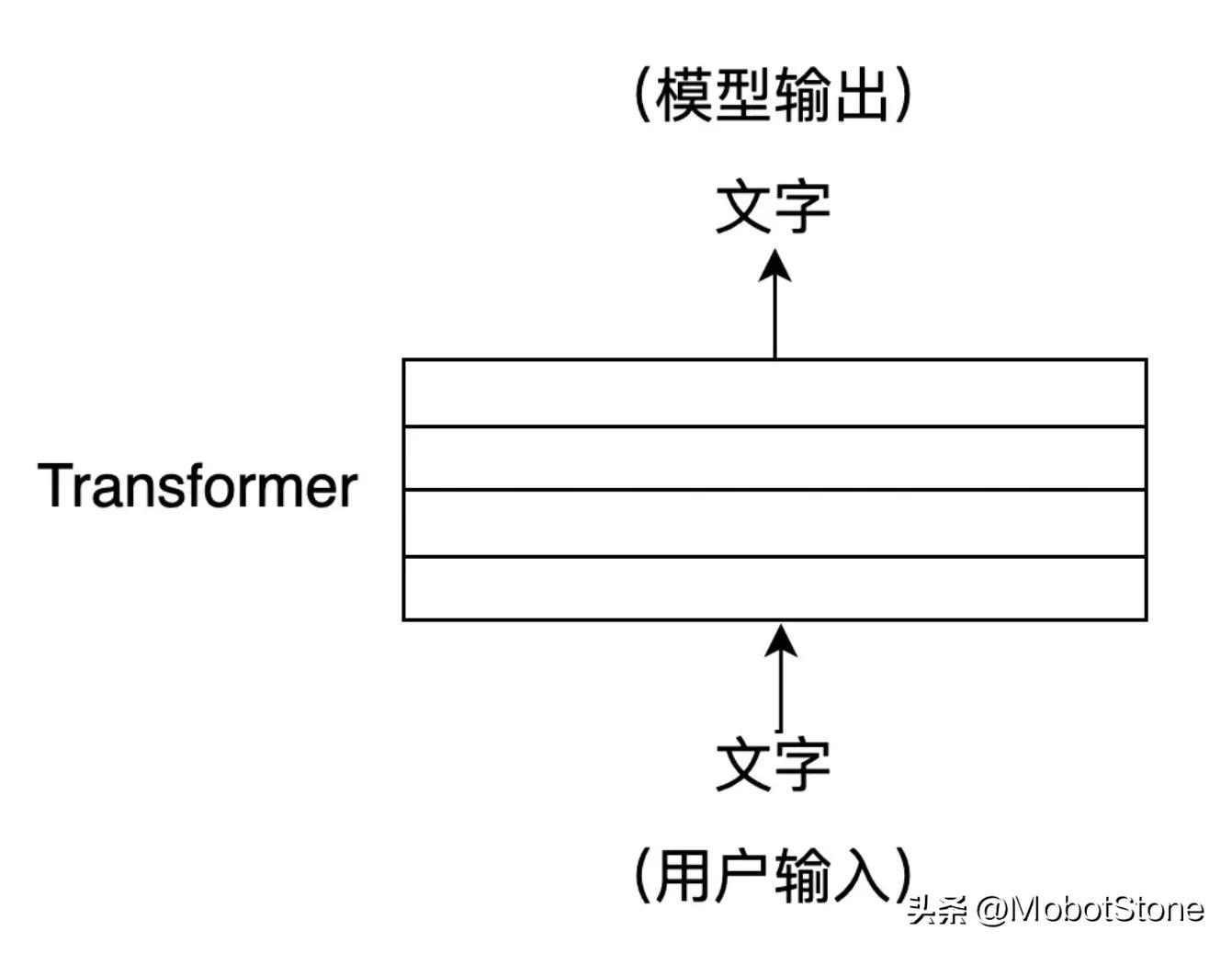

Unter diesen liegen sowohl die Benutzereingabe als auch die Modellausgabe in Form von Text vor. Eine Benutzereingabe und eine entsprechende Ausgabe des Modells werden als Konversation bezeichnet. Wir können das ChatGPT-Modell in den folgenden Prozess abstrahieren:

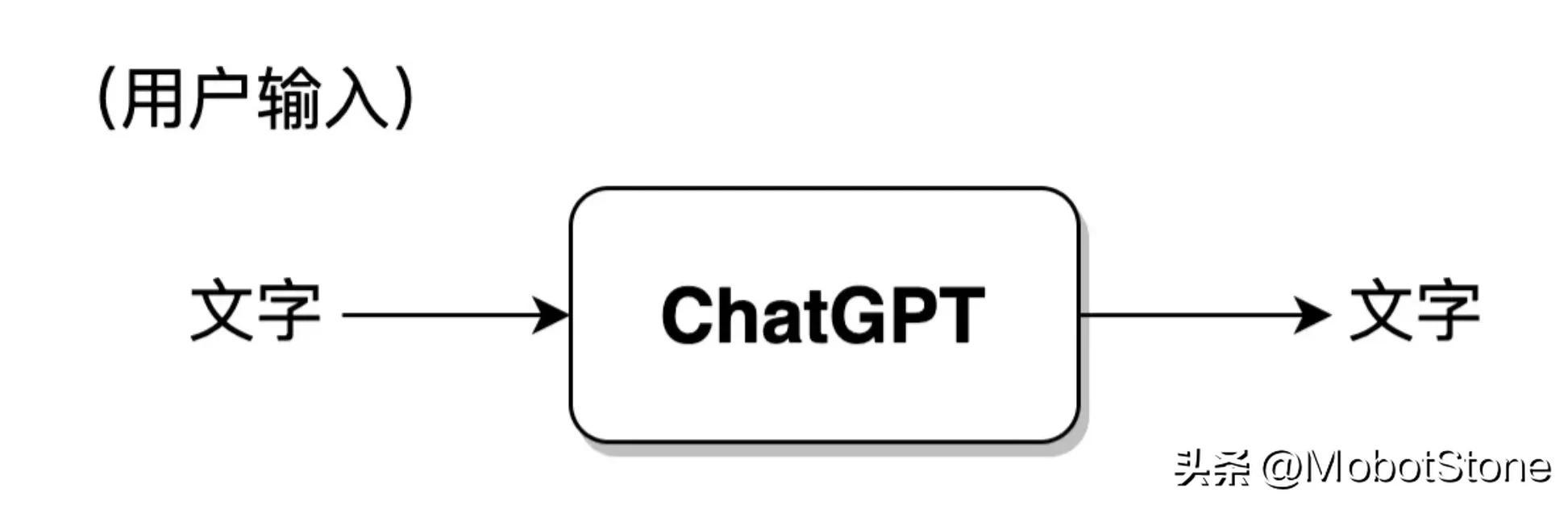

Darüber hinaus kann ChatGPT auch kontinuierliche Fragen von Benutzern beantworten, also mehrere Dialogrunden , mehrere Runden Es besteht eine Informationskorrelation zwischen Gesprächen. Die spezifische Form ist ebenfalls sehr einfach. Wenn der Benutzer zum zweiten Mal eingibt, fügt das System standardmäßig die Eingabe- und Ausgabeinformationen des ersten Mals zusammen, damit ChatGPT auf die Informationen der letzten Konversation verweist.

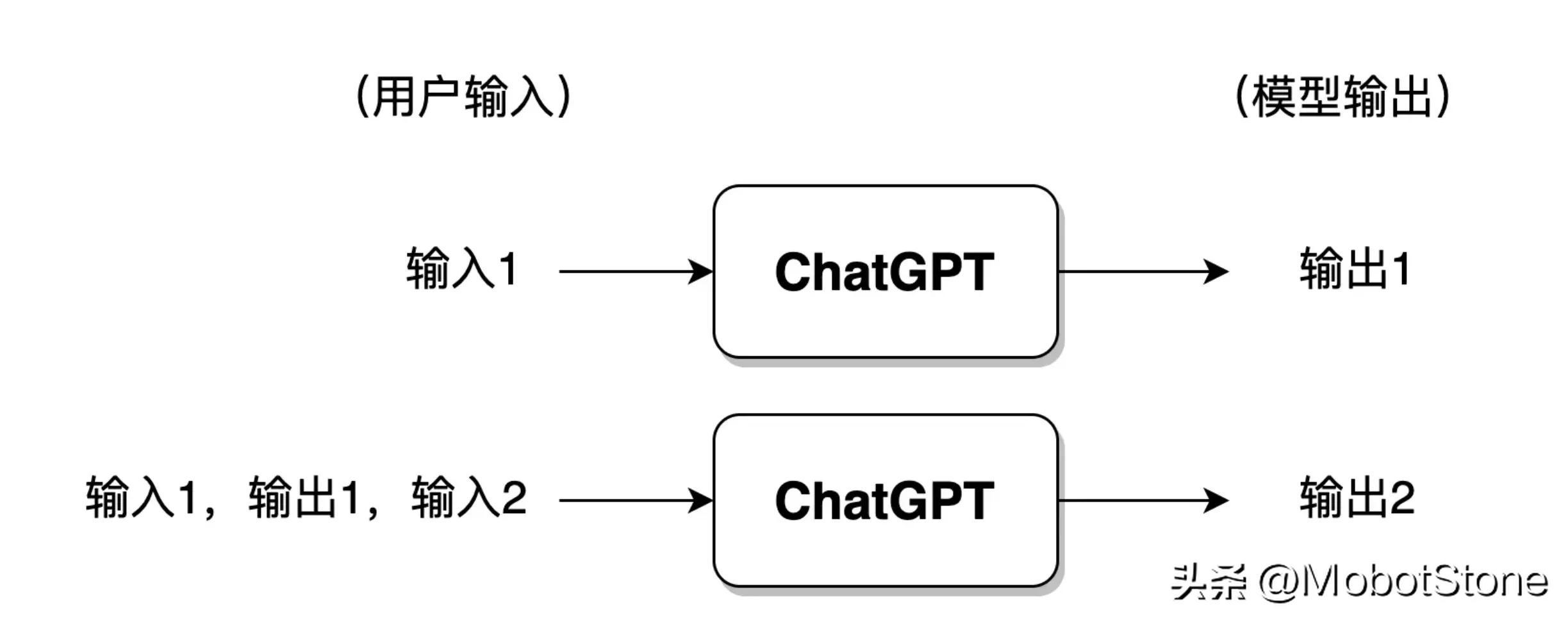

Wenn der Benutzer zu viele Gespräche mit ChatGPT geführt hat, speichert das Modell im Allgemeinen nur die Informationen der letzten Gesprächsrunden und Die vorherigen Gesprächsinformationen werden vergessen.

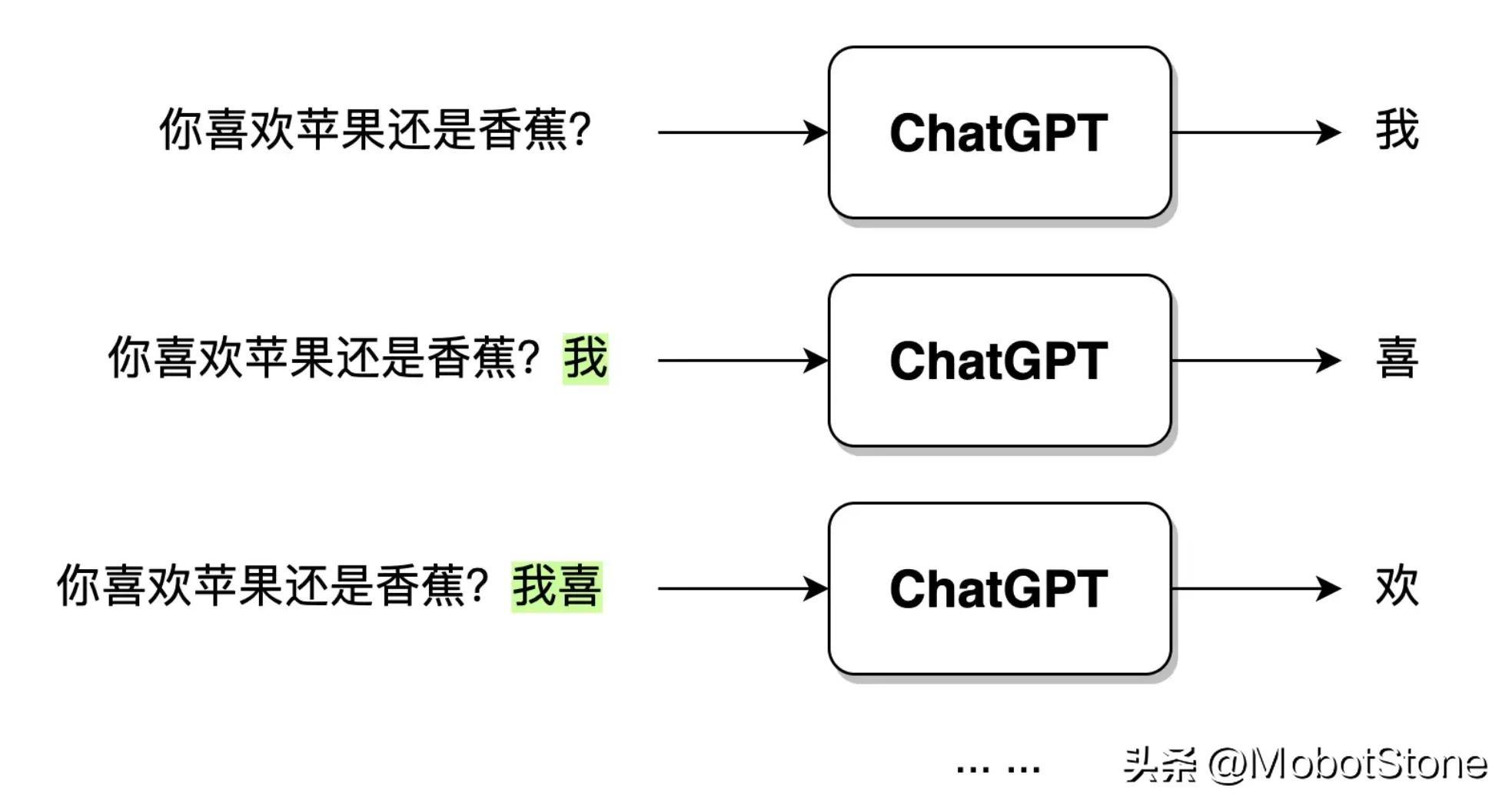

ChatGPT Nach Erhalt der Frageeingabe des Benutzers wird der Ausgabetext nicht direkt auf einmal generiert, sondern Wort für Wort generiert. Diese wörtliche Generierung ist # 🎜🎜#Generativ . Wie unten gezeigt.

Die Entwicklungsgeschichte von ChatGPT und NLP

Die Modellierungsform von ChatGPT wurde früher eingeführt. Stellen Sie sich vor, wenn Sie gebeten würden, ein ChatGPT-Modell zu implementieren, welche Ideen und Methoden hätten Sie? Tatsächlich gibt es grob zwei Strategien: NLP basierend auf Regeln und NLP basierend auf Statistik. Seit den Anfängen von ChatGPT ist der NLP-Bereich in die Ära des Verstärkungslernens eingetreten, also NLP, das auf Verstärkungslernen basiert.

Regelbasiertes NLP

Regelbasiertes NLP bezieht sich auf die Verwendung manuell geschriebener Regeln zur Verarbeitung natürlicher Sprache. Diese Regeln basieren in der Regel auf Kenntnissen in Grammatik, Semantik und Pragmatik und können zum Parsen und Generieren natürlicher Sprache verwendet werden. Beispielsweise können wir ein Dialogsystem entwerfen, das auf den folgenden Regeln basiert:

Regel 1: Wenn das Modell die Frage des Benutzers erhält, entfernen Sie das Wort „?“ aus der Frage „?“ „ „Ersetzen Sie“ durch „.“ , können wir ein Dialogmodell basierend auf diesen Regeln erstellen und den Dialogmodus starten.

Benutzer: Hallo. Modell: Hallo. Benutzer: Sind Sie ChatGPT? Modell: Ja, ich bin ChatGPT. Benutzer: Gefällt dir die Nuggets-Community? Modell: Ich liebe die Nuggets-Community. Benutzer: Haben Sie jemals das jionlp-Toolkit verwendet? Modell: Ich habe das Jionlp-Toolkit verwendet.

Das Obige ist ein sehr oberflächliches Beispiel für ein regelbasiertes Dialogsystem. Ich glaube, dass die Leser die bestehenden Probleme leicht herausfinden können. Was ist, wenn das Benutzerproblem zu komplex ist? Was ist, wenn die Frage kein Fragezeichen enthält? Wir müssen ständig verschiedene Regeln schreiben, um die oben genannten Sondersituationen abzudecken. Dies zeigt, dass es mehrere offensichtliche Mängel gibt, die auf Regeln basieren:In natürlicher Sprache kann keine Regel die Anforderungen vollständig abdecken, daher ist sie bei der Bearbeitung komplexer natürlichsprachlicher Aufgaben nicht effektiv;# 🎜🎜#Die Regeln sind endlos und es wird eine Menge Arbeit sein, sich auf die menschliche Kraft zu verlassen;

- Dies ist der Weg und die Methode in der frühen Entwicklung von NLP: Abschluss der Konstruktion von Modellsystemen auf der Grundlage von Regeln. In der Frühzeit wurde es auch allgemein als Symbolik bezeichnet.

- Statistikbasiertes NLP

- Statistikbasiertes NLP nutzt maschinelle Lernalgorithmen, um die regelmäßigen Merkmale natürlicher Sprache aus einer großen Anzahl von Korpora zu lernen. Dies wurde in der Literatur auch als Konnektionismus bezeichnet frühe Tage. Diese Methode erfordert kein manuelles Schreiben von Regeln. Die Regeln werden hauptsächlich durch das Erlernen der statistischen Merkmale der Sprache in das Modell einbezogen. Mit anderen Worten: Bei der regelbasierten Methode sind die Regeln explizit und werden manuell geschrieben. Bei der statistischen Methode sind die Regeln unsichtbar, implizit in den Modellparametern enthalten und werden vom Modell auf der Grundlage der Daten trainiert.

- Diese Modelle haben sich in den letzten Jahren rasant weiterentwickelt und ChatGPT ist eines davon. Darüber hinaus gibt es eine Vielzahl von Modellen mit unterschiedlichen Formen und Strukturen, deren Grundprinzipien jedoch gleich sind. Ihre Verarbeitungsmethoden sind hauptsächlich wie folgt:

In ChatGPT wird es hauptsächlich verwendet Die Pre-Training-Technologie (Pre-Training) wird verwendet, um das statistikbasierte Lernen von NLP-Modellen abzuschließen. Das Vortraining im NLP-Bereich wurde erstmals durch das ELMO-Modell (Embedding from Language Models) eingeführt, und diese Methode wurde von verschiedenen Modellen für tiefe neuronale Netze wie ChatGPT weitgehend übernommen.

Der Schwerpunkt liegt auf dem Erlernen eines Sprachmodells, das auf einem großen Originalkorpus basiert. Dieses Modell lernt nicht direkt, wie eine bestimmte Aufgabe gelöst werden soll, sondern lernt aus Grammatik, Morphologie, Pragmatik und gesundem Menschenverstand , Wissen und andere Informationen werden in das Sprachmodell integriert. Intuitiv ähnelt es eher einem Wissensgedächtnis als der Anwendung von Wissen zur Lösung praktischer Probleme.

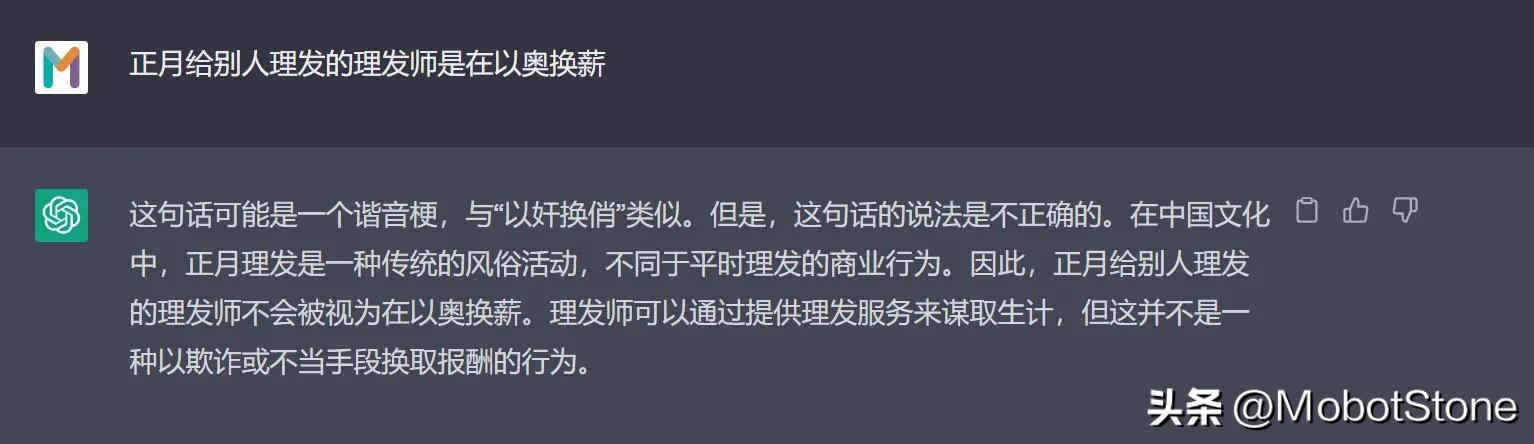

Das Vortraining hat viele Vorteile und ist zu einem notwendigen Schritt für fast alle NLP-Modellschulungen geworden. Wir werden dies in den folgenden Kapiteln näher erläutern. Statistikbasierte Methoden sind weitaus beliebter als regelbasierte Methoden. Ihr größter Nachteil ist jedoch die Black-Box-Unsicherheit, das heißt, die Regeln sind unsichtbar und implizit in den Parametern enthalten. Beispielsweise liefert ChatGPT auch einige mehrdeutige und unverständliche Ergebnisse. Wir können anhand der Ergebnisse nicht beurteilen, warum das Modell eine solche Antwort gegeben hat.

NLP basierend auf Reinforcement Learning

Das ChatGPT-Modell basiert auf Statistiken, verwendet aber auch eine neue Methode, Reinforcement Learning mit menschlichem Feedback (RLHF), um hervorragende Ergebnisse zu erzielen und die Entwicklung von NLP in eine neue Phase zu bringen.

Vor ein paar Jahren besiegte Alpha GO Ke Jie. Dies kann fast beweisen, dass Verstärkungslernen unter geeigneten Bedingungen den Menschen vollständig besiegen und sich der Grenze der Perfektion nähern kann. Derzeit befinden wir uns noch im Zeitalter schwacher künstlicher Intelligenz, aber auf den Bereich Go beschränkt, ist Alpha GO eine starke künstliche Intelligenz, deren Kern im verstärkenden Lernen liegt.

Das sogenannte Reinforcement Learning ist eine Methode des maschinellen Lernens, die darauf abzielt, dem Agenten (Agent, bezieht sich im NLP hauptsächlich auf das tiefe neuronale Netzwerkmodell, das ChatGPT-Modell) zu ermöglichen, durch Interaktion mit der Umgebung optimale Entscheidungen zu treffen .

Diese Methode ist so, als würde man einem Hund (Agent) beibringen, auf eine Pfeife zu hören (Umgebung) und zu essen (Lernziel).

Ein Welpe wird mit Futter belohnt, wenn er seinen Besitzer pfeifen hört; wenn der Besitzer jedoch nicht pfeift, kann der Welpe nur verhungern. Durch wiederholtes Fressen und Hungern kann der Welpe entsprechende konditionierte Reflexe etablieren, wodurch ein Verstärkungslernen tatsächlich abgeschlossen wird.

Im Bereich NLP ist das Umfeld hier deutlich komplexer. Die Umgebung für das NLP-Modell ist keine echte menschliche Sprachumgebung, sondern ein künstlich konstruiertes Sprachumgebungsmodell. Daher liegt der Schwerpunkt hier auf dem verstärkenden Lernen mit künstlichem Feedback.

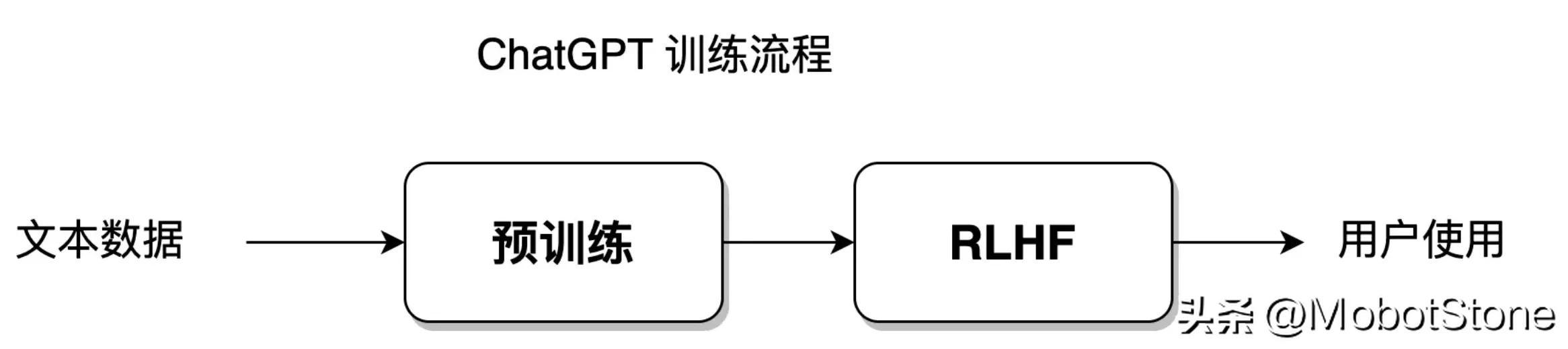

Basierend auf Statistiken kann das Modell den Trainingsdatensatz mit dem größten Freiheitsgrad anpassen, während das Lernen durch Verstärkung dem Modell einen größeren Freiheitsgrad verleiht, sodass das Modell unabhängig lernen und die Einschränkungen des Etablierten durchbrechen kann Datensatz. Das ChatGPT-Modell integriert statistische Lernmethoden und verstärkende Lernmethoden. Der Modelltrainingsprozess ist in der folgenden Abbildung dargestellt:

Dieser Teil des Trainingsprozesses wird in den Abschnitten 8–11 erläutert.

Der Entwicklungstrend der NLP-Technologie

Tatsächlich sind die drei auf Regeln, Statistiken und Verstärkungslernen basierenden Methoden nicht nur ein Mittel zur Verarbeitung natürlicher Sprache, sondern eine Idee. Ein Algorithmusmodell, das ein bestimmtes Problem löst, ist oft das Produkt einer Fusion dieser drei Lösungen.

Vergleicht man einen Computer mit einem Kind, ist die Verarbeitung natürlicher Sprache wie ein Mensch, der das Kind zum Wachsen erzieht.

Der regelbasierte Ansatz ist so, als ob ein Elternteil ein Kind zu 100 % kontrolliert und von ihm verlangt, gemäß seinen eigenen Anweisungen und Regeln zu handeln, z. B. die Lernstunden pro Tag festzulegen und dem Kind jede Frage beizubringen. Während des gesamten Prozesses liegt der Schwerpunkt auf praxisorientiertem Unterricht, wobei die Initiative und der Fokus auf den Eltern liegen. Beim NLP liegen die Initiative und der Fokus des gesamten Prozesses bei Programmierern und Forschern, die Sprachregeln schreiben.

Die statistikbasierte Methode ist so, als würden Eltern ihren Kindern nur sagen, wie sie lernen sollen, aber nicht jede einzelne Frage unterrichten. Der Schwerpunkt liegt auf der Halbanleitung. Bei NLP liegt der Schwerpunkt des Lernens auf neuronalen Netzwerkmodellen, die Initiative wird jedoch weiterhin von Algorithmeningenieuren gesteuert.

Basierend auf der Methode des verstärkenden Lernens ist es so, als würden Eltern ihren Kindern nur Bildungsziele setzen. Sie verlangen beispielsweise, dass ihre Kinder 90 Punkte in der Prüfung erreichen, aber es ist ihnen egal, wie die Kinder lernen auf Selbststudium. Die Kinder verfügen über ein äußerst hohes Maß an Freiheit und Eigeninitiative. Eltern belohnen oder bestrafen nur die Endergebnisse und beteiligen sich nicht am gesamten Bildungsprozess. Für NLP liegen der Fokus und die Initiative des gesamten Prozesses im Modell selbst.

Die Entwicklung von NLP hat sich allmählich den statistikbasierten Methoden angenähert, und schließlich hat die auf Verstärkungslernen basierende Methode den vollständigen Sieg erreicht. Das Symbol des Sieges ist das Aufkommen von ChatGPT; Die Methode wurde nach und nach auf eine Hilfsverarbeitungsmethode reduziert. Von Anfang an ging die Entwicklung des ChatGPT-Modells unbeirrt in die Richtung voran, das Modell selbst lernen zu lassen.

ChatGPTs neuronaler Netzwerkstrukturtransformator

Um den Lesern das Verständnis zu erleichtern, wurde in der vorherigen Einführung die spezifische interne Struktur des ChatGPT-Modells nicht erwähnt.

ChatGPT ist ein großes neuronales Netzwerk, das aus mehreren Transformer-Schichten besteht. Seit 2018 ist es eine gängige Standardmodellstruktur im NLP-Bereich und Transformer ist in fast allen NLP-Modellen zu finden.

Wenn ChatGPT ein Haus ist, dann ist Transformer der Baustein, der ChatGPT aufbaut. Der Kern von

Transformer ist der Selbstaufmerksamkeitsmechanismus, der dem Modell helfen kann, bei der Verarbeitung der Eingabetextsequenz automatisch auf andere Positionszeichen zu achten, die mit dem aktuellen Positionszeichen in Zusammenhang stehen. Der Selbstaufmerksamkeitsmechanismus kann jede Position in der Eingabesequenz als Vektor darstellen, und diese Vektoren können gleichzeitig an Berechnungen teilnehmen, wodurch eine effiziente parallele Berechnung erreicht wird. Nennen Sie ein Beispiel:

Wenn bei der maschinellen Übersetzung der englische Satz „Ich bin ein guter Schüler“ ins Chinesische übersetzt wird, übersetzt das traditionelle maschinelle Übersetzungsmodell ihn möglicherweise in „Ich bin ein guter Schüler“, diese Übersetzung führt jedoch möglicherweise nicht zu Ergebnissen genau genug. Der Artikel „a“ im Englischen muss bei der Übersetzung ins Chinesische anhand des Kontexts bestimmt werden.

Wenn Sie das Transformer-Modell für die Übersetzung verwenden, können Sie genauere Übersetzungsergebnisse erhalten, z. B. „Ich bin ein guter Schüler“.

Das liegt daran, dass Transformer die Beziehung zwischen Wörtern über große Distanzen in englischen Sätzen besser erfassen und lange Abhängigkeiten vom Textkontext lösen kann. Der Selbstaufmerksamkeitsmechanismus wird in Abschnitt 5–6 vorgestellt, und die detaillierte Struktur von Transformer wird in Abschnitt 6–7 vorgestellt.

Zusammenfassung

- Die Entwicklung des NLP-Bereichs hat sich allmählich vom manuellen Schreiben von Regeln und der logischen Steuerung von Computerprogrammen zu einer völligen Überlassung der Anpassung an die Sprachumgebung an das Netzwerkmodell verlagert.

- ChatGPT ist derzeit das NLP-Modell, das dem Bestehen des Turing-Tests am nächsten kommt, und GPT4 und GPT5 werden in Zukunft noch näher dran sein. Der Workflow von

- ChatGPT ist ein generatives Dialogsystem. Der Trainingsprozess von

- ChatGPT umfasst das Vortraining des Sprachmodells und das RLHF-Verstärkungslernen mit manuellem Feedback. Die Modellstruktur von

- ChatGPT übernimmt Transformer mit Selbstaufmerksamkeitsmechanismus als Kern.

Das obige ist der detaillierte Inhalt vonJeder versteht ChatGPT Kapitel 1: ChatGPT und die Verarbeitung natürlicher Sprache. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr