Heim >Technologie-Peripheriegeräte >KI >Seien Sie vorsichtig vor den vier neuen KI-Betrügereien! Jemand wurde innerhalb von 10 Minuten um 4,3 Millionen betrogen

Seien Sie vorsichtig vor den vier neuen KI-Betrügereien! Jemand wurde innerhalb von 10 Minuten um 4,3 Millionen betrogen

- PHPznach vorne

- 2023-05-27 16:25:391300Durchsuche

Autor |. Wu Feining Li Shuiqing

Bearbeiten |. Xin Yuan

In den letzten Tagen kam es im ganzen Land zu neuen KI-Betrügereien.

In der Vergangenheit gab es gefälschte KI-Papiere und Nachrichten. Später erschienen Yang Mi und Dilraba, deren Gesichter durch KI verändert wurden, im Live-Übertragungsraum, um Waren zu verkaufen. Gestern war ein „KI-Telekommunikationsbetrug, bei dem in 10 Minuten 4,3 Millionen Yuan betrogen wurden“ in Baotou in der Inneren Mongolei ein Trend auf Weibo und erregte landesweite Aufmerksamkeit.

Erst heute Morgen wurde offiziell bestätigt, dass eine Reihe von Bildern der Explosion im Pentagon, die den US-Aktienmarkt zum Absturz brachte, gefälscht waren und vermutlich von KI synthetisiert wurden.

Während die KI-Technologie eine neue Implementierungswelle auslöst, verbreiten sich KI-Deepfake-Inhalte viral auf der ganzen Welt, was in der Branche große Bedenken hervorruft.

Bereits im Jahr 2019 untersuchte und berichtete Zhixixi kürzlich über das Deep-Fake-KI-Produkt, das das Gesicht verändert Jahre, Deep Fake Der Wettbewerb zwischen Fälschungstechnologie und Anti-Deepfake-Technologie hält an, und die zuständigen Abteilungen verbessern schrittweise die Regulierungsgesetze und -vorschriften. Derzeit erleben Deep-Fake-Inhalte mit der iterativen Weiterentwicklung der KI-Großmodelltechnologie, die durch GPT-4 repräsentiert wird, ein Comeback und verursachen weltweit größere Unruhe.

Von Artikeln bis hin zu Bildern, von menschlichen Stimmen bis hin zu dynamischen Effekten von Videos können die dynamischen Effekte weitestgehend wiederhergestellt werden. Sie können die Öffentlichkeit durch alle möglichen Tricks täuschen, und es gibt verschiedene Betrugspläne, die endlos und schwer zu erkennen sind . Für viele junge Menschen ist es schwierig, die Echtheit dieser KI-gefälschten Inhalte zu erkennen, während ältere Menschen und Kinder eher getäuscht werden. Und wenn Kriminelle ihr Vertrauen erst einmal nutzen, um Verbrechen zu begehen, werden die Folgen katastrophal sein.

Ein Experte für künstliche Intelligenz-Technologie sagte Zhidongzhi, dass es für normale Menschen sehr schwierig sei, Audio- und Videoinhalte, die von diesen aktuellen KI-Deep-Forgery-Technologien generiert werden, mit bloßem Auge zu erkennen.

Der traditionellen Betrugsmasche wurde von der KI ein „neuer Mantel“ verpasst, wodurch sie versteckter und schwieriger zu erkennen ist. Wie funktionieren diese neuen KI-Betrügereien? Wie erkennt man gefälschte KI-Inhalte, die schwer zu unterscheiden sind? Welche Lösungen gibt es für das industrielle Chaos? Durch die Sortierung und Analyse verschiedener neuer KI-Betrügereien auf dem Markt führt dieser Artikel eine ausführliche Diskussion dieser Probleme durch.

1. Ein 10-minütiges Video, das das Gesicht verändert, hat 4,3 Millionen Yuan betrogen. Seien Sie vorsichtig bei diesen vier neuen KI-Betrügereien Im März dieses Jahres wurde auf der offiziellen Website des Future Life Institute ein offener Brief mit dem Titel „Aussetzung der groß angelegten Forschung im Bereich der künstlichen Intelligenz“ veröffentlicht, an dem sich Tesla-CEO Elon Musk und Apple-Mitbegründer Steve • Tausende Wissenschaftler und Führungskräfte beteiligten , darunter Steve Wozniak und andere, haben eine Petition unterzeichnet, die ein Moratorium für die Entwicklung von Versionen über GPT-4 fordert. Sie alle weisen auf die möglichen negativen Einsatzmöglichkeiten leistungsstarker KI-Technologie hin.

Der negative Einsatz von KI nimmt viel schneller zu, als wir uns vorstellen. Da die Fähigkeiten der KI-Technologie die Iteration und Implementierung beschleunigen, wird die KI-Fälschung einfacher und der Inhalt wird realistischer, gefolgt von einem endlosen Strom gefälschter Nachrichten und gefälschter Bilder. Bösartige Vorfälle, die durch Stimm- und Gesichtsveränderungen verursacht werden, haben in der Gesellschaft Besorgnis erregt. Viele Menschen haben das Gefühl, dass der gesunde Menschenverstand von „Bildern und Wahrheit“ und „Sehen ist Glauben“ den heftigsten Einfluss in der Geschichte zu haben scheint.

1. Face-Swapping-Video: 4,3 Millionen in 10 Minuten betrogenVielleicht sind um uns herum bereits viele bösartige Ereignisse passiert, die durch KI-Gesichtsveränderungen verursacht wurden, aber wir haben es noch nicht bemerkt.

Kürzlich hat die Internet-Ermittlungsabteilung des Büros für öffentliche Sicherheit der Autonomen Region Baotou in der Inneren Mongolei einen Fall von Telekommunikationsbetrug mithilfe von KI aufgedeckt. Der Kriminelle gab vor, im Namen eines Freundes zu handeln, und behauptete, er brauche dringend Geld , und rief das Opfer per WeChat-Video Herrn Guo an.

Aus Vertrauen in seinen Freund und nachdem er die Identität der anderen Partei bereits per Video-Chat überprüft hatte, lockerte Herr Guo seine Wachsamkeit und überwies 4,3 Millionen in zwei Überweisungen auf die Bankkarte des Kriminellen, aber er hätte nie mit dem sogenannten WeChat gerechnet. „Freunde“ im Videoanruf werden durch KI-Technologie zur Gesichtsveränderung erstellt. Kriminelle nutzten KI-Technologie zur Gesichtsveränderung, um sich als Freunde auszugeben und Telekommunikationsbetrug gegen ihn zu begehen. Derzeit wurden 3,3684 Millionen Yuan eingezogen, nachdem sie von der Polizei abgefangen worden waren, und 931.600 Yuan wurden abgeführt.

KI-Gesichtsveränderung ist die einfachste Art der Betrugsmethode, um das Vertrauen der anderen Partei zu gewinnen. Betrüger nutzen oft KI-Technologie, um das Gesicht einer Person zu verändern, die dem Opfer bekannt ist, und rufen dann die andere Partei an, um die Informationen zu bestätigen.

KI-Gesichtsveränderung ist die einfachste Art der Betrugsmethode, um das Vertrauen der anderen Partei zu gewinnen. Betrüger nutzen oft KI-Technologie, um das Gesicht einer Person zu verändern, die dem Opfer bekannt ist, und rufen dann die andere Partei an, um die Informationen zu bestätigen.

Angesichts dieser neuen Art von Betrug müssen Sie erstens Ihre persönlichen Daten schützen, keine Informationen, die die Privatsphäre betreffen, an andere weitergeben und nicht nach Belieben auf unbekannte Links klicken oder unbekannte Software herunterladen muss die Identität der anderen Partei über verschiedene Kanäle überprüfen und auf mögliche Risiken achten.

Sehr ähnlich der Funktion „KI-Gesichtswechsel“ ist „KI-Ausziehen“. Bereits im März dieses Jahres landete die Nachricht, dass „das U-Bahn-Foto einer Frau mit einem Klick ausgezogen wurde“, auf der heißen Suche. Ein Foto einer Frau, die in der U-Bahn fährt, wurde mit einem Klick „ausgezogen“. Mithilfe von KI-Software wurde die böswillige Verbreitung kritisiert, Kriminelle verbreiteten zudem weit verbreitet falsche Informationen, um die Frau zu verleumden.

Eine solche „One-Click-Undressing“-Technologie ist bereits 2019 im Ausland aufgetaucht, aber aufgrund weit verbreiteter öffentlicher Kontroversen und Verurteilungen wurde das Projekt schnell eingestellt und aus den Regalen genommen. Dieser schlechte Trend hat sich während des diesjährigen KI-Wahnsinns erneut auf China ausgeweitet. Bei der Suche im Internet mit Schlüsselwortkombinationen wie „KI“, „Verkleidung“ und „Software“ sind immer noch viele tief verborgene verwandte Software zu finden. Interessierte können damit sogar pornografische Videos produzieren und verbreiten. Cross-Dressing-Dienste sind zu einer Schwarzindustrie mit einer kompletten Kette geworden.

„KI-Gesichtsveränderung“ wird häufig bei der sekundären Erstellung von Film- und Fernsehdramen, lustigen Parodievideos und der Produktion von Ausdruckspaketen eingesetzt, aber die versteckten rechtlichen Risiken und Rechtsstreitigkeiten über Vertragsverletzungen können nicht ignoriert werden. Laut Informationen auf der offiziellen Website von Qichacha wurde Shanghai Houttuynia Information Technology Co., Ltd. kürzlich von vielen prominenten Internet-Bloggern wegen einer seiner Face-Swapping-Mobile-Apps verklagt.

▲Im App Store gibt es fast hundert „KI-Gesichtsverändernde“-Anwendungen

Zuvor ersetzte ein Videoblogger namens „Compositor für Spezialeffekte Hong Liang“ in seinem Video das Gesicht des männlichen Hauptdarstellers Yang Yang in der TV-Serie „You Are My Glory“ durch seine eigene Technologie zur Gesichtsveränderung mittels KI. Sein Gesicht wurde schließlich angegriffen von Fans des Hauptdarstellers, was die Aufmerksamkeit vieler Internetnutzer auf sich zog.

▲ Einige KI-synthetisierte Videos, die das Gesicht verändern, wurden auf dem Konto von „Special Effects Synthesizer Hong Liang“ hochgeladen

Dieser Videoblogger nutzte das Vertauschen der Gesichter männlicher Stars als Gimmick, tatsächlich wollte er damit Besucher auf seinen bezahlten Kurs über die Produktion von Film- und Fernsehspezialeffekten locken. Allerdings hat sein Verhalten zu Verstößen gegen Schauspieler wie Dilraba und Yang geführt Yang, der in Fernsehserien auftritt. Nachdem „Kurst“ populär wurde, schufen viele Fans es auch wieder, indem sie die Handlungsausschnitte mit der TV-Serienversion von „Journey to the West“ austauschten, was hinsichtlich Popularität und Themendiskussion zur Popularität der TV-Serie beitrug, aber sie waren mit der TV-Serie nicht zufrieden.

Das Verhalten, den Verkehr abzuleiten, hatte negative Auswirkungen und Probleme sowohl für Prominente, deren Gesichter verändert wurden, als auch für die Öffentlichkeit, die neugierig auf Technologie ist. Die Grenze zwischen Unterhaltung und Technologie sollte bis zu diesem Punkt nicht verwischt werden.

2. Klangsynthese: Replizieren Sie die menschliche Stimme, um das Geheimnis zu verbergen

In der Vergangenheit wurde „AI Stefanie Sun“ populär, und später brachen KI-Klone mit menschlicher Stimme in den Synchronkreis ein. Die KI-Sprachsynthese-Technologie wurde sehr beliebt und brachte auch viele bösartige Vorfälle und damit verbundene Opfer hervor.

Ein Internetnutzer nutzte Ausschnitte von Liedern des berühmten amerikanischen Sängers Frank Ocean, um Lieder zu trainieren, die seinen Musikstil imitierten, veröffentlichte diese „Musikwerke“ in Underground-Musikforen und täuschte auch vor, dass diese Lieder in der Version enthalten seien, die versehentlich durchgesickert sei Die Aufnahme wurde schließlich genehmigt und für fast 970 US-Dollar (entspricht 6.700 Yuan) verkauft.

Vor nicht allzu langer Zeit wurde auch Peabody Films, eine Filmproduktionsfirma in Spanien, Opfer eines KI-Telefonbetrugs. Der Betrüger gab sich als der berühmte Schauspieler Benedict Cumberbatch aus und behauptete, die Filme der Firma seien illegal , aber das Unternehmen muss zunächst eine Anzahlung von 200.000 Pfund (entspricht etwa 1,7 Millionen Yuan) überweisen, dann können wir die konkreten Einzelheiten der Zusammenarbeit besprechen.

Die Filmfirma erkannte, dass etwas nicht stimmte, und nachdem sie sich bei der Agentur des Schauspielers erkundigt hatte, stellte sie fest, dass es sich von Anfang bis Ende um einen KI-Betrug handelte.

Auch im Ausland gibt es viele Nachrichten über den Einsatz von KI-geklonten Stimmen zur Begehung von Betrug und Erpressung. In einigen Fällen geht es um schwindelerregende Beträge von bis zu einer Million US-Dollar. Diese Art von Betrügern extrahieren häufig die Stimme einer Person aus Telefonaufzeichnungen und anderen Materialien, um die Stimme zu synthetisieren, und verwenden dann die gefälschte Stimme, um Bekannte zu täuschen. Dies erfordert, dass die Öffentlichkeit bei seltsamen Anrufen wachsam ist.

In seiner neuesten Folge vom 22. Mai zeigte das amerikanische CBS TV-Nachrichtenmagazin „60 Minutes“ live, wie Hacker Stimmen geklont haben, um Kollegen zu täuschen und erfolgreich Passinformationen zu stehlen.

▲60 Minutes hat das vollständige Video auf Twitter hochgeladen

Es dauerte nur 5 Minuten, bis der Hacker Sharyns Stimme durch KI-Klonen kopierte und mit einem Tool den Namen auf der Anrufer-ID auf dem Telefon ersetzte. Er täuschte ihre Kollegen erfolgreich und erlangte problemlos ihren Namen, ihre Passnummer usw. Privat Information.

3. Gefälschte Fotos: Trump wurde „verhaftet“ und der Papst trug eine Daunenjacke auf dem Laufsteg

Mit der überwältigenden Verbreitung von KI-Videos, die das Gesicht verändern, sind KI-Fälschungsfotos noch häufiger anzutreffen.

Am 22. Mai, Eastern Time, verbreitete sich in den sozialen Medien ein Bild einer Explosion in der Nähe des Pentagons. Die weite Verbreitung dieses falschen Fotos führte sogar dazu, dass der S&P 500-Index kurzfristig um etwa 0,3 % auf ein Intraday-Tief fiel und sich von einem Anstieg in einen Rückgang verwandelte.

Der Sprecher des US-Verteidigungsministeriums bestätigte sofort, dass es sich auch um ein von der KI erzeugtes Fake-Bild handelte. Dieses Bild wies offensichtliche KI-generierte Merkmale auf, wie zum Beispiel, dass die Straßenlaternen etwas schief waren und der Zaun auf dem Bürgersteig wuchs.

Die von Midjourney erstellten Fotos von Paaren in den 1990er Jahren haben es für Internetnutzer schwierig gemacht, zu erkennen, ob sie echt oder falsch sind. Im März gingen mehrere Fotos der Verhaftung des ehemaligen US-Präsidenten Trump auf Twitter viral.

Trump auf dem Foto wurde von der Polizei umzingelt und zu Boden gedrückt, er sah verlegen und panisch aus. Während der Anhörung verbarg er sein Gesicht, weinte bitterlich und zog in der feuchten und dunklen Zelle auch die Gefängnisuniform an. Die Bilder wurden mit Midjounrney von Eliot Higgins, dem Gründer der Bürgerjournalismus-Website Bellingcat, erstellt. Nach der Veröffentlichung des Fotos wurde auch sein Konto gesperrt.

▲Eine Reihe von Trump-„verhafteten“ Bildern, erstellt von Midjounrney

Kurz nach der Veröffentlichung des „Trump Arrest Picture“ sorgte das Foto von Papst Franziskus in einer Paris-World-Daunenjacke für Aufruhr im Internet. Nicht lange nach seiner Veröffentlichung hatte es mehr als 28 Millionen Aufrufe, was viele Internetnutzer glauben machte Es.

▲Der Papst trug auf dem Laufsteg eine Daunenjacke von Balenciaga

Schöpfer Pablo

Im Midjourney-Bereich des Reddit-Forums wurde eine Gruppe von „Das Erdbeben der Stärke 9,1 in Cascadia verursachte einen Tsunami, der Oregon verwüstete“ weit verbreitet. Die Katastrophenszene auf dem Foto herrschte im Chaos, mit Hilfskräften und Journalisten, Regierungsbeamten und andere tauchten nacheinander auf und die Menschen wirkten besorgt, verängstigt und panisch. Tatsächlich handelt es sich jedoch um eine durch eine KI verursachte „Katastrophe“, die in der Geschichte nicht existiert. Diese Bilder und Szenen mit vollständigen Elementen und realistischen Farben machen es schwierig, die Authentizität zu erkennen.

4. Nachrichten zusammentragen: KI wird zur Gerüchteküche

Am 7. Mai entdeckte die Cyber-Sicherheitsbrigade des Büros für öffentliche Sicherheit der Stadt Pingliang, Provinz Gansu, einen Fall von künstlicher Intelligenz, die falsche Informationen zusammenstellte.

Es wird berichtet, dass Kriminelle ChatGPT nutzten, um die heißen sozialen Nachrichten zu ändern und zu bearbeiten, die sie im gesamten Internet gesammelt hatten, und eine gefälschte Nachricht zusammengestellt haben, dass „heute Morgen ein Zug einen Straßenbauarbeiter in Gansu angefahren und 9 Menschen getötet hat“, um sich Zugang zu verschaffen das Internet Traffic und Aufmerksamkeit monetarisieren.

Diese Nachricht erhielt sofort nach ihrer Veröffentlichung über 15.000 Aufrufe. Glücklicherweise griff die Polizei in die Ermittlungen ein, bevor die öffentliche Meinung weiter gärte, und bestätigte, dass der Verdächtige KI-Technologie zur Fälschung der Nachrichten eingesetzt hatte.

Nicht nur Leser müssen KI-Fake-News auf Phishing-Websites erkennen, auch etablierte Medien werden manchmal durch KI-Fake-News getäuscht.

Die britische „Daily Mail“ (The Daily Mail) veröffentlichte am 24. April eine Nachricht, in der es hieß: „Ein 22-jähriger Kanadier musste sich zwölf plastischen Operationen unterziehen, um in Südkorea als Idol aufzutreten, und starb schließlich.“

▲ Berichten zufolge gab der 22-jährige kanadische Schauspieler 22.000 US-Dollar für 12 plastische Operationen aus und starb schließlich, um in einem kommenden amerikanischen Drama Jimin von der K-Pop-Star-Gruppe BTS zu spielen

Diese Nachricht erregte die Aufmerksamkeit vieler Medien auf der ganzen Welt, darunter auch der südkoreanische YTN News Channel, der dem Bericht schnell sein Mitgefühl und Bedauern zum Ausdruck brachte.

▲Internetnutzer äußerten ihr Bedauern über die Nachricht von seinem Tod

Allerdings änderte sich die Lage völlig, nachdem ein Reporter in Südkorea und der amerikanische Radiosender iHeartRadio Fragen aufgeworfen hatten: Möglicherweise existiert der Mann überhaupt nicht. Internetnutzer brachten ihre Fotos zur Überprüfung auf die Website zur Erkennung von KI-Inhalten und stellten fest, dass die Wahrscheinlichkeit, dass die Fotos von KI erstellt wurden, bei 75 % lag. Nachdem der südkoreanische Fernsehsender MBC bei der Polizei nachgefragt hatte, erhielten sie auch die Antwort „Nein“. Ähnliche Todesfallberichte sind eingegangen.“ Diese Nachricht wurde sofort als „KI-Fake-News“ bestätigt.

Aber die Angelegenheit ist noch nicht abgeschlossen. Anfang dieses Monats beschloss die Familie des Mannes, die Medien, die über „Fake News“ berichteten, und die Agentur, der der Mann angehörte, sowie den ersten Reporter, der dies bekannt gab, zu verklagen war tot. Die Schlussfolgerung ist, dass das Foto nicht von KI erstellt wurde und der Mann tatsächlich an chirurgischen Komplikationen starb, die durch übermäßige plastische Chirurgie verursacht wurden.

Ohne seine Identität zu überprüfen und über keine substanziellen Beweise zu verfügen, behaupteten viele Medien, dass die Identität und Informationen des Mannes zusammengestellt worden seien, was eine durch KI verursachte Farce in eine tragische Tragödie verwandelte.

Diese von KI zusammengestellten Nachrichten verwirren nicht nur die Öffentlichkeit, sondern führen auch dazu, dass Passanten, die nicht die Zeit und Geduld haben, die ganze Geschichte zu sehen, die Fähigkeit verlieren, die Wahrheit zu erkennen.

2. Prominente, die „AI“ waren: „AI Stefanie Sun“ wurde mit ihrem Cover ein Hit, „AI Yang Mi“ änderte ihr Gesicht, um Waren zu verkaufen

Wenn sich die KI-Technologie durchsetzt, sind Unterhaltungsstars die ersten, die es am härtesten trifft.

Stefanie Sun, die in letzter Zeit populär geworden ist, hat gestern Abend einen langen Beitrag als Reaktion auf das Auftauchen von „AI Stefanie“ gepostet.

▲Stefanie Sun reagierte auf die Entstehung von „AI Stefanie Sun“ (chinesische Übersetzungsversion)

Sie nahm eine tolerantere Haltung gegenüber dem Aufkommen von „KI Stefanie Sun“ ein und verfolgte keine rechtlichen Schritte. Sie sagte: „Es ist unmöglich, mit einem ‚Menschen‘ zu vergleichen, der in nur wenigen Minuten ein neues Album veröffentlichen kann, obwohl es (KI) weder Emotionen noch Tonhöhenänderungen hat, egal wie schnell Menschen gehen können.“ darüber hinaus.

Aus der Reaktion ist nicht schwer zu erkennen, dass Stefanie Sun zwar die von KI erzeugte Musik nicht schätzt, es für Menschen jedoch tatsächlich schwierig ist, in kurzer Zeit mit der Lernfähigkeit von Robotern gleichzuziehen. Sie hat sich dafür entschieden, diese zu behandeln heiße Song-Cover-Videos gleichgültig.

Sängerin Stefanie Sun war die erste, die aufgrund ihrer einzigartigen Klangfarbe und ihres Gesangsstils mit Hilfe der KI-Technologie der Internetnutzer wieder in die Öffentlichkeit gelangte „gecoverte“ Songs wie „Hair Like Snow“, „Rainy Day“ und „I Remember“ haben alle über eine Million Aufrufe.

▲Die meistgespielten Songs von „AI Stefanie Sun“

Stefanie Sun ist nicht die einzige Sängerin, die von AI „gecovert“ wurde, auch AI Jay Chou, AI Cyndi Wang, AI Tengger und andere sind nacheinander aufgetreten.

Obwohl Stefanie Sun sich dafür entscheidet, keine rechtliche Verantwortung zu übernehmen, muss sie ihre legitimen Rechte und Interessen dennoch rechtzeitig schützen, wenn die KI-Technologie so weit missbraucht wurde, dass kommerzielle Interessen geschädigt und rechtliche rote Linien berührt wurden.

Laut China News Network haben viele Live-Übertragungsräume kürzlich damit begonnen, KI zu verwenden, um die Gesichter von Prominenten zu verändern, um Live-Übertragungen durchzuführen. Weibliche Prominente wie Yang Mi, Dilraba, Anglebaby und andere sind in den Fokus des Gesichtsaustauschs gerückt Promi-Gesichter Durch den Konsum von Waren können bessere Verkehrsumleitungseffekte erzielt und Werbekosten eingespart werden.

Laut einer Website, die Face-Swapping-Dienste anbietet, können Sie, wenn Sie ein fertiges Modell kaufen und das Material ausreicht, direkt ein Video von mehreren Stunden mit nur einer halben Stunde bis zu einigen Stunden an Ereignissen synthetisieren Der Kaufpreis für ein komplettes Modellset beträgt 35.000 Yuan und liegt damit weit unter dem Preis für die Einladung einer Berühmtheit zur Live-Übertragung der Ware.

Auf mehreren großen E-Commerce-Plattformen werden Schlüsselwörter wie „KI-Gesichtsveränderung“ und „Video-Gesichtsveränderung“ von der Plattform blockiert, viele verwandte Produkte können jedoch weiterhin durch Ändern von Suchbegriffen und anderen Methoden gefunden werden.

KI-Technologie, die das Gesicht verändert, ist keine neue Entwicklung. Bereits 2017 verwandelte ein Internetnutzer namens DeepFake das Gesicht der Heldin in einem Erotikfilm in den Hollywoodstar Gal Gadot. Dies war das erste Mal, dass KI-Technologie zur Gesichtsveränderung in der Öffentlichkeit auftauchte. Aufgrund der Unzufriedenheit einer großen Anzahl von Beschwerdeführern wurde sein Konto später offiziell gesperrt und die darauffolgende KI-Technologie zur Gesichtsveränderung wurde nach ihm „DeepFake“ benannt.

Die KI-Gesichtsveränderung wurde Anfang 2019 in China wirklich populär. Ein Video, in dem das Gesicht von Zhu Yin, dem Schauspieler Huang Rong in „Die Legende der Condor-Helden“, durch KI-Technologie durch Yang Mi ersetzt wurde , ging im Internet viral. Es besteht kein Gefühl der Verletzung, und einige Internetnutzer haben angedeutet, dass es die Porträtrechte des Originalschauspielers verletzen könnte Der Austausch erfolgt ausschließlich zum technischen Austausch und wird nicht für gewinnbringende Zwecke verwendet.

▲Netizens ersetzten die Rolle von „Huang Rong“, gespielt vom Schauspieler Zhu Yin in „Die Legende der Condor-Helden“, durch das Gesicht des Schauspielers Yang Mi

Dies war auch der frühe Beginn des Einsatzes von KI für die Sekundärproduktion von Film- und Fernsehdramen in China.

KI-Technologie ist seit langem das Ziel von Kriminellen und wird für verschiedene Tricks zur Gesichtsveränderung eingesetzt. Nicht nur Prominente in der Unterhaltungsindustrie, sondern auch viele normale Menschen werden durch sogenannte „private Fotos“ erpresst. Mehrere Polizeibeamte der Netzwerksicherheitsabteilung sagten, dass die mangelnde Überwachung der KI-Tiefensynthesetechnologie viele Informationssicherheitsrisiken und Chaos in der Netzwerkkommunikation verursacht und sogar indirekt zum Auftreten von Strafverfahren geführt habe.

3. Es ist eine groß angelegte Popularisierungsbewegung für KI-Gesetze entstanden. Welche Verhaltensweisen sind rechtsverletzend und illegal?

Die Porträts und Stimmen vieler Menschen wurden ohne Genehmigung verbreitet, Audio- und Videoprodukte wurden ohne Erörterung des Urheberrechts gewinnbringend genutzt, und noch schlimmer: Kriminelle haben gefälschte Informationen genutzt, um Eigentumsbetrug oder sogar Entführungen zu begehen und die Privatsphäre von Menschen zu schädigen und Eigentumsrechte.

Angesichts dieser ernsteren Situationen müssen die Menschen zu legalen Waffen greifen, um sich zu schützen. Was folgt, wird eine groß angelegte Bewegung zur legalen Popularisierung von KI sein, die der industriellen Entwicklung zugute kommt.

Gesichts- und Stimmfälschungen sind weit verbreitet und das erste Problem ist die Verletzung der Privatsphäre. Gemäß Artikel 1019 des Bürgerlichen Gesetzbuchs: „Keine Organisation oder Einzelperson darf die Porträtrechte anderer durch Verleumdung, Verunstaltung oder den Einsatz von Mitteln der Informationstechnologie zur Fälschung verletzen. Ohne die Zustimmung des Inhabers der Porträtrechte darf keine Organisation oder Einzelperson produzieren.“ oder die Porträtrechte anderer verletzen und offenlegen, sofern das Gesetz nichts anderes vorsieht Bestimmungen zum Schutz von Porträtrechten.“ Was die Menschen noch mehr beunruhigt, ist die Tatsache, dass die Informationen gefälscht werden. Wenn sie nicht in den Händen von Elementen sind, kann das Vertrauen weiter ausgenutzt werden, um die Eigentumsrechte der Menschen und sogar ihre Gesundheitsrechte zu verletzen.

Neben den Persönlichkeitsrechten hat auch das Problem der Urheberrechtsverletzung von Audio- und Videomaterialien im Zusammenhang mit gefälschten KI-Inhalten große Aufmerksamkeit erregt. Kürzlich veröffentlichte die Sängerin Stefanie Sun einen Artikel, in dem sie erklärte, dass ihr die „KI Stefanie“ gleichgültig sei, aber mehr Menschen, die gefälscht wurden, hätten sich entschieden, zu legalen Waffen zu greifen, um sich zu schützen, so Medienberichte von Shanghai Houttuynia Information Technology Co., Ltd. war am Austausch einer bestimmten Face-Mobile-App beteiligt und wurde von vielen prominenten Internet-Bloggern verklagt.

You Yunting, Seniorpartner und Anwalt für geistiges Eigentum bei der Anwaltskanzlei Shanghai Dabang, schrieb, dass die Verwendung der Stimmen echter Menschen zum Trainieren künstlicher Intelligenz und zum Generieren von Liedern gemäß den Gesetzen zum Schutz des geistigen Eigentums höchstwahrscheinlich keinen Verstoß darstellt, wenn sie nicht verwendet wird Kommerzielle Zwecke, aber wenn es online veröffentlicht wird, müssen weiterhin entsprechende Urheberrechte für Texte und Musik, Begleitmusik und die Genehmigung zur Verwendung von Videomaterial eingeholt werden. Durch künstliche Intelligenz generierte Werke weisen inhärente Urheberrechtsmängel auf und sollten nicht urheberrechtlich geschützt sein und keine Lizenzgebühren erheben. Wenn die von Nutzern mithilfe künstlicher Intelligenz erstellten Werke von anderen verletzt werden, können sie ihre Rechte nach dem Gesetz gegen unlauteren Wettbewerb schützen.

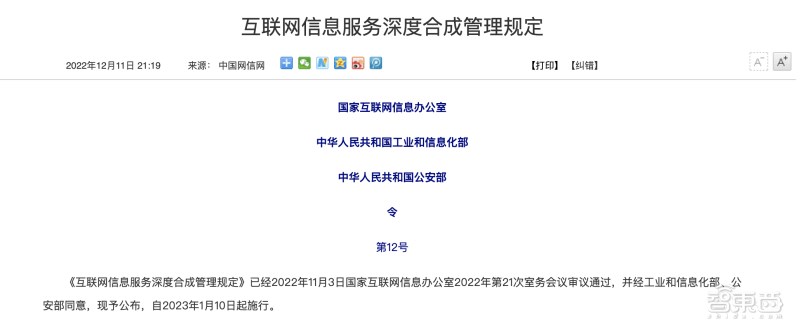

Tatsächlich wurden auch in unserem Land einige Sonderregelungen im Bereich der künstlichen Intelligenz festgelegt. Die Cyberspace Administration of China und andere Ministerien haben im Dezember 2022 die „Regulations on the Management of Deep Synthesis of Internet Information Services“ erlassen und dabei 25 Vorschriften verwendet, um die Spezifikationen für den Einsatz der Deep Synthesis-Technologie festzulegen, darunter Gesetze und Anwendungen wie die Verbot der Nutzung von Deep-Synthese-Diensten zur Verletzung der legitimen Rechte und Interessen anderer. Vertriebsplattformen sollten Vorschriften wie Regalüberprüfung, Servicebereitstellung und technische Supporter umsetzen, um das technische Management zu stärken.

Am 11. April hat die Cyberspace Administration of China schnell den „Generative Artificial Intelligence Service Management Measures (Entwurf für Kommentare)“ entworfen Für Bilder, Töne, Videos, Codes und andere Inhalte gelten umfassende Regelungen zur aktuellen KI-Fälschung. („Breaking News! Das erste nationale AIGC-Regulierungsdokument, Generative AI Service Management Measures zur Kommentierung freigegeben“)

Darüber hinaus gelten das „Netzwerksicherheitsgesetz der Volksrepublik meines Landes“, das „Datensicherheitsgesetz der Volksrepublik China“, das „Gesetz zum Schutz personenbezogener Daten der Volksrepublik China“, das „ „Maßnahmen zur Verwaltung von Internet-Informationsdiensten“ und andere von unserem Land erlassene Gesetze und Verwaltungsgesetze. Alle enthalten diesbezügliche Bestimmungen, die als relevante Grundlage für die Wahrung legitimer Rechte und Interessen dienen können.

4. Gewöhnliche Menschen verfügen über „Verteidigungsfähigkeiten“ zur Erkennung von KI-Inhalten, und Plattformen müssen Verantwortung übernehmen

„Counterfeiting“ und „Anti-Counterfeiting“ sind nicht auf die KI zurückzuführen, aber die heutige KI-Technologie macht es einfacher und schwieriger, „Counterfeiting“ zu unterscheiden. Verfügen die Menschen angesichts der auf den Markt kommenden KI-gefälschten Inhalte über die Fähigkeit, diese selbst zu identifizieren?

Xiao Zihao, Mitbegründer und Algorithmenwissenschaftler von RealAI, einem bekannten Sicherheitsunternehmen, sagte gegenüber Zhidongzhi, dass sich die Deepfakes-Technologie ständig weiterentwickelt und die erzeugten Töne und Videos immer realistischer werden, was es sehr schwierig macht normale Menschen können sich mit bloßem Auge identifizieren.

"Wenn normale Menschen auf eine solche Situation stoßen, können sie die andere Partei während des Videos bewusst dazu anleiten, einige Aktionen auszuführen, z. B. den Kopf zu schütteln oder den Mund zu öffnen. Wenn die technischen Mittel des Betrügers schwach sind, können wir das tun Das Finden von Gesichtskanten- oder Zahnfehlern kann zur Erkennung von Gesichtsveränderungen durch KI verwendet werden. Diese Methode ist jedoch immer noch schwierig, um „hochrangige“ Betrüger zu identifizieren Der Kreditnehmer kennt Informationen zur Überprüfung der Identität der anderen Partei.“

"Während Sie sich davor schützen, getäuscht zu werden, sollten Sie auch auf den Schutz Ihrer persönlichen Bilder achten und vermeiden, eine große Anzahl Ihrer Fotos und Videos auf öffentlichen Plattformen zu veröffentlichen, um Kriminellen Bequemlichkeit zu bieten. Denn die Rohstoffe für die Herstellung Deep-Fake-Videos sind persönlich. Je mehr Bilder und Videos Sie haben, desto realistischer werden die Videos und desto schwieriger wird es, sie zu identifizieren“, fügte Xiao Zihao hinzu.

KI macht es schwieriger, Betrug und Fehlinformationen zu erkennen, was die Prüfung von Technologieunternehmen und Content-Verbreitungsplattformen noch wichtiger macht.

Apple-Mitbegründer Steve Wozniak warnte kürzlich in einem Interview, dass KI-Inhalte klar gekennzeichnet werden sollten und die Branche reguliert werden müsse. Alle durch KI generierten Inhalte sollten vom Herausgeber zur Verantwortung gezogen werden. Dies bedeutet jedoch nicht, dass große Technologieunternehmen rechtlichen Sanktionen entgehen können. Wozniak ist der Ansicht, dass Regulierungsbehörden große Technologieunternehmen zur Rechenschaft ziehen sollten.

Gemäß den von unserem Land erlassenen „Internet Information Services Deep Synthesis Management Regulations“ müssen Inhaltsanbieter die generierten Bilder, Videos und anderen Inhalte gemäß den Vorschriften kennzeichnen. Tatsächlich haben wir bereits gesehen, dass inländische soziale Plattformen wie Xiaohongshu verdächtige KI-generierte Inhalte melden, die eine gewisse präventive Rolle spielen können. Doch die letzte Hürde für KI-generierte Inhalte liegt bei den Nutzern selbst, und Medienplattformen können nur eine filternde Rolle spielen.

Fazit: Negativen Anwendungen widerstehen, KI-Offensiv- und Defensivkampf beginnt

Die sich weiterentwickelnde KI-Technologie hat die Generierung von Texten, Bildern und Videos einfacher und realistischer gemacht. Gleichzeitig sind auch Deep-Fake-Inhalte weit verbreitet. Deep-Fake-Inhalte können Menschen zumindest verwirren und gewinnbringend nutzen oder im schlimmsten Fall von Kriminellen zur Begehung von Betrugs- oder sogar Erpressungsdelikten missbraucht werden, was bei der Überwachung von KI-generierten Inhalten dringende Aufmerksamkeit erregt hat.

Da neue Methoden des KI-Betrugs soziale Probleme verursachen, müssen Benutzer, Technologieanbieter und -betreiber, Plattformen zur Verbreitung von Inhalten und Produzenten von Inhalten in der Branche alle ihre Selbstdisziplin stärken. Tatsächlich hat unser Land im Voraus eine Reihe relevanter Gesetze und Vorschriften erlassen. Die Aufdeckung negativer KI-Anwendungsprobleme wird voraussichtlich zu einer landesweiten Popularisierungsbewegung für Technologiegesetze führen und dadurch eine gesündere Entwicklung der Branche fördern.

Das obige ist der detaillierte Inhalt vonSeien Sie vorsichtig vor den vier neuen KI-Betrügereien! Jemand wurde innerhalb von 10 Minuten um 4,3 Millionen betrogen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr