Heim >Technologie-Peripheriegeräte >KI >OpenAI nutzt GPT-4, um die 300.000 Neuronen von GPT-2 zu erklären: So sieht Weisheit aus

OpenAI nutzt GPT-4, um die 300.000 Neuronen von GPT-2 zu erklären: So sieht Weisheit aus

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-05-25 12:04:061265Durchsuche

Obwohl ChatGPT den Menschen der Wiederherstellung von Intelligenz näher zu bringen scheint, haben wir bisher nie vollständig verstanden, was Intelligenz ist, ob natürlich oder künstlich.

Es ist offensichtlich notwendig, die Prinzipien der Weisheit zu verstehen. Wie kann man die Intelligenz großer Sprachmodelle verstehen? Die von OpenAI gegebene Lösung lautet: Fragen Sie, was GPT-4 sagt.

Am 9. Mai veröffentlichte OpenAI seine neueste Forschung, die GPT-4 zur automatischen Interpretation des Verhaltens von Neuronen in großen Sprachmodellen verwendete und viele interessante Ergebnisse erzielte.

Ein einfacher Ansatz zur Interpretierbarkeitsforschung besteht darin, zunächst die KI zu verstehen Modell Was die verschiedenen Komponenten (Neuronen und Aufmerksamkeitsköpfe) tun. Bei herkömmlichen Methoden müssen Menschen Neuronen manuell untersuchen, um festzustellen, welche Merkmale der Daten sie darstellen. Dieser Prozess ist schwer zu skalieren und seine Anwendung auf neuronale Netze mit Hunderten oder Hunderten von Milliarden Parametern ist unerschwinglich teuer.

Also schlug OpenAI eine automatisierte Methode vor – mit GPT-4, um Erklärungen des Neuronenverhaltens in natürlicher Sprache zu generieren und zu bewerten und sie auf Neuronen in einem anderen Sprachmodell anzuwenden – hier sind sie wählte GPT-2 als experimentelle Probe und veröffentlichte einen Datensatz mit Interpretationen und Bewertungen dieser GPT-2-Neuronen.

- Papieradresse: https:/ /openaipublic.blob.core.windows.net/neuron-explainer/paper/index.html

- GPT-2 Neuronendiagramm : https://openaipublic.blob.core.windows.net/neuron-explainer/neuron-viewer/index.html

- Code und Datensatz: https://github.com/openai/automated-interpretability

Diese Technologie ermöglicht es Menschen, die Vorteile von GPT zu nutzen – 4 zur Definition und automatischen Messung des quantitativen Konzepts der Interpretierbarkeit von KI-Modellen: Es wird verwendet, um die Fähigkeit von Sprachmodellen zu messen, neuronale Aktivierungen mithilfe natürlicher Sprache zu komprimieren und zu rekonstruieren. Aufgrund ihrer quantitativen Natur können wir nun den Fortschritt beim Verständnis der Rechenziele neuronaler Netze messen.

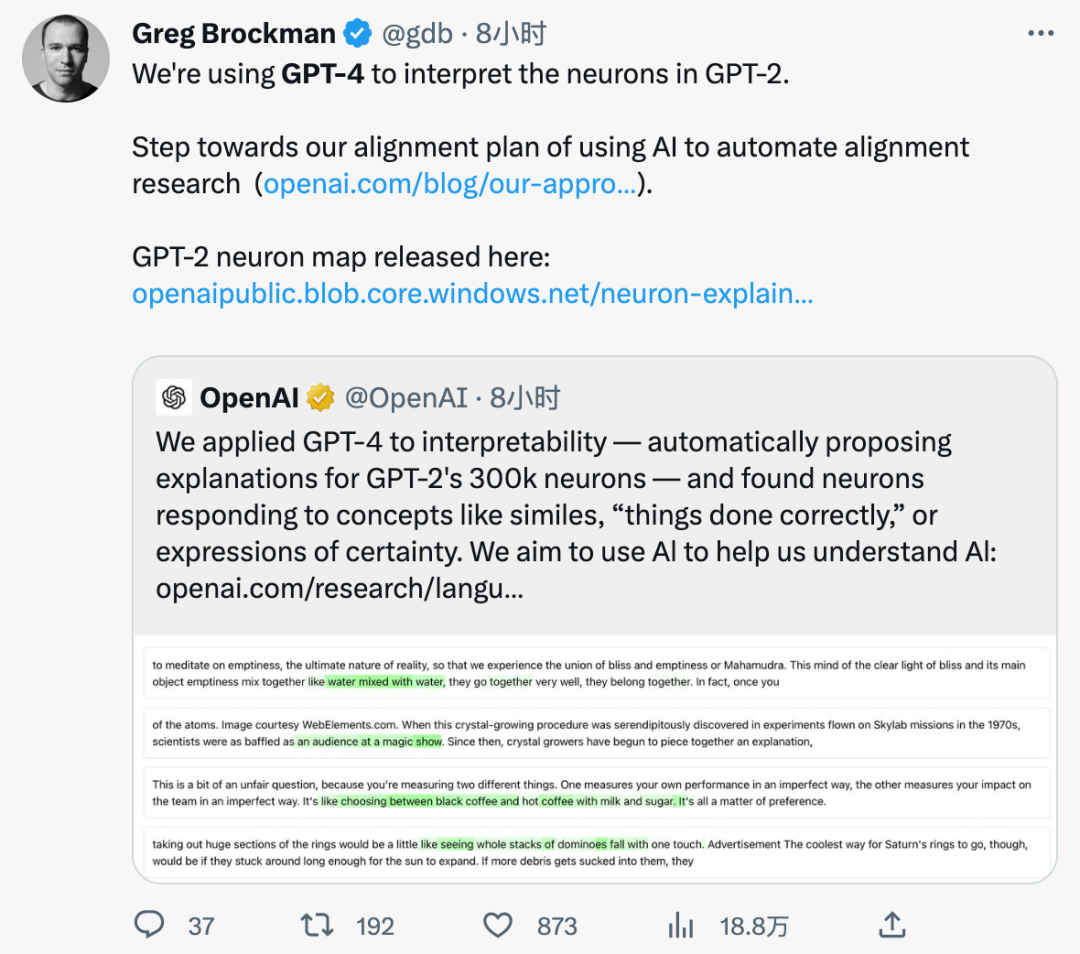

OpenAI sagte, dass mithilfe des von ihnen festgelegten Benchmarks und der Verwendung von KI zur Erklärung von KI Ergebnisse erzielt werden können, die nahe am menschlichen Niveau liegen. Greg Brockman, Mitbegründer von OpenAI, sagte auch, dass wir einen wichtigen Schritt in Richtung automatisierter Alignment-Forschung mit KI gemacht haben.

Spezifische Methode

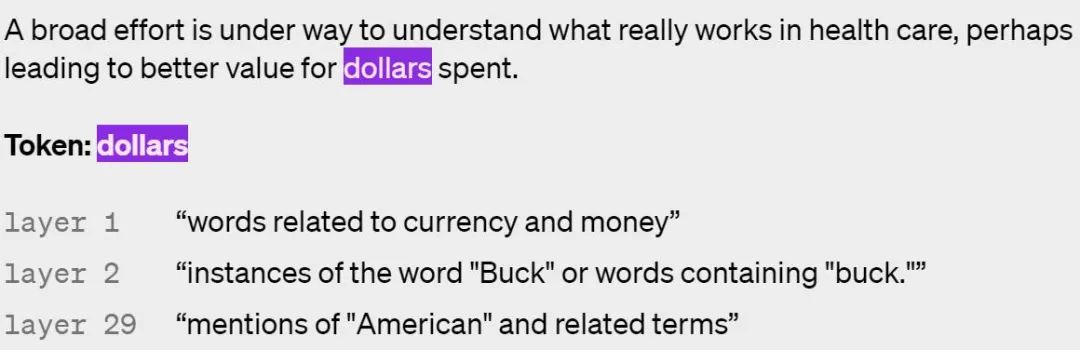

Schritt 1: Verwenden Sie GPT-4, um eine Erklärung zu generieren #

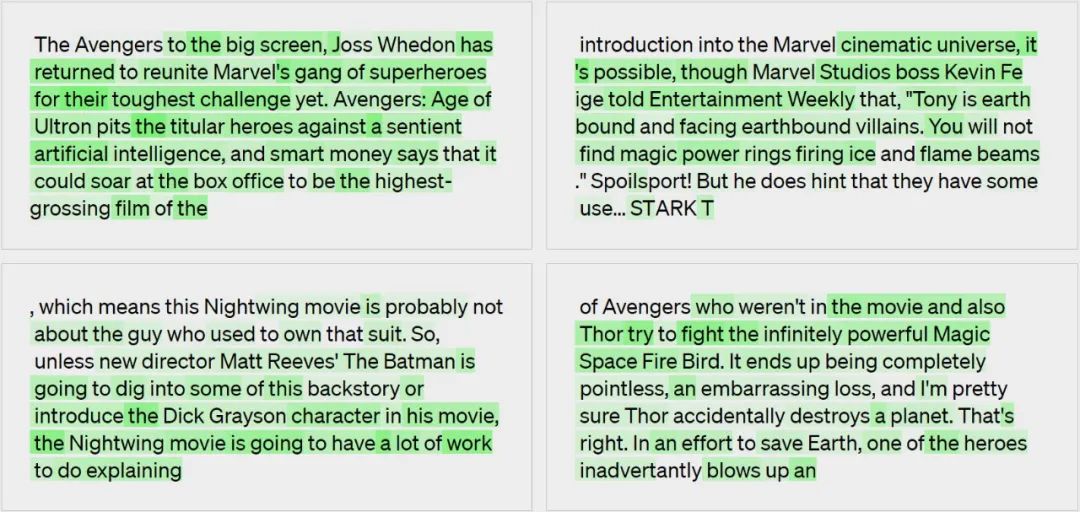

Generieren Sie bei einem gegebenen GPT-2-Neuron eine Erklärung seines Verhaltens durch Zeigt GPT-4-relevante Textsequenzen und Aktivierungen.Vom Modell generierte Erklärungen: Verweise auf Filme, Charaktere und Unterhaltung.

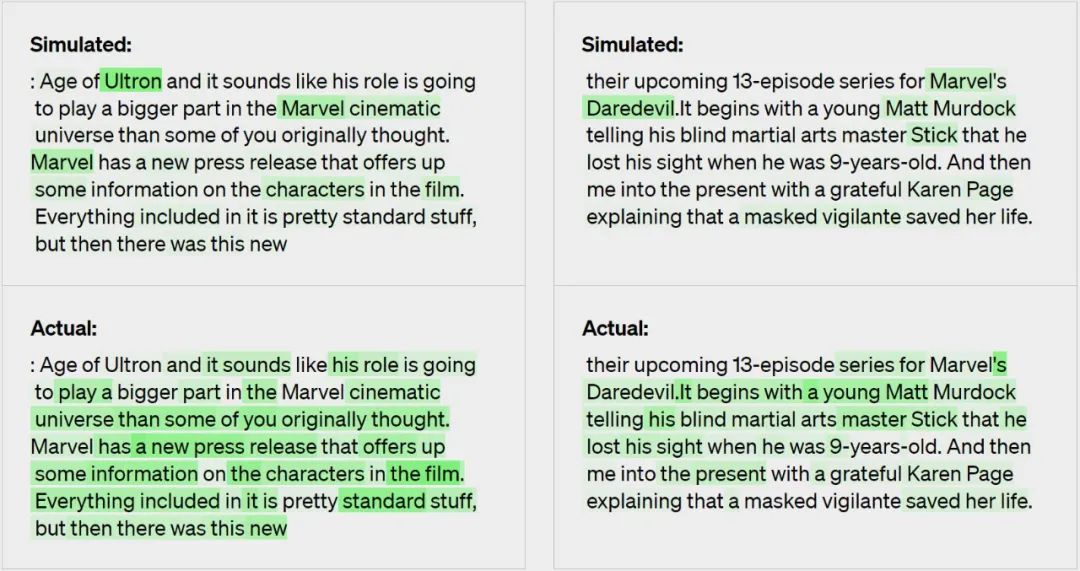

Schritt 2: Verwenden Sie GPT-4 für die Simulation

Schritt 3: Vergleich

Erklärungen werden basierend darauf bewertet, wie gut simulierte Aktivierungen mit echten Aktivierungen übereinstimmen – in diesem Fall erzielte GPT-4 einen Wert von 0,34.

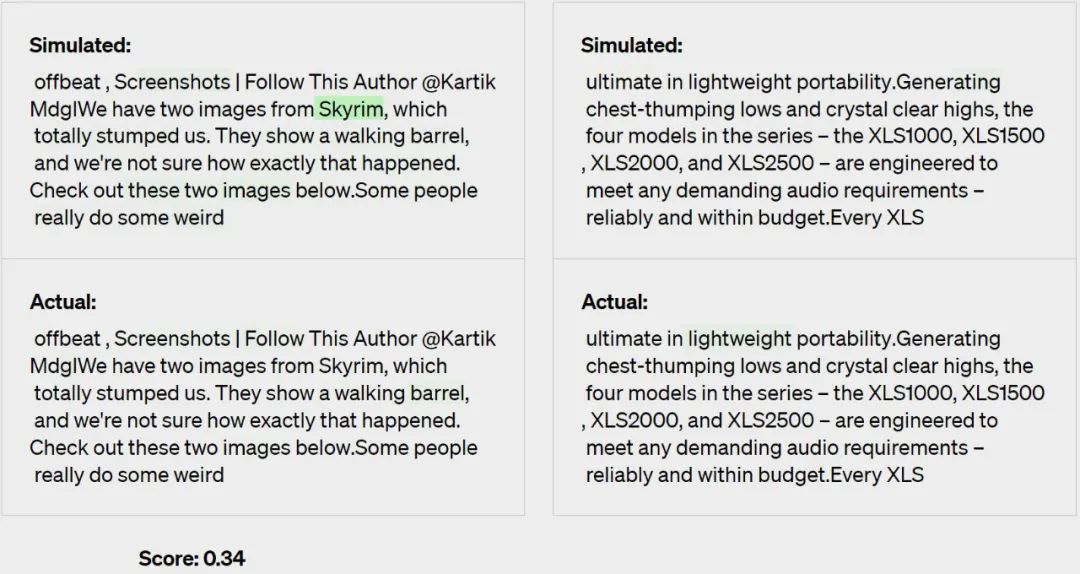

Mithilfe seiner eigenen Bewertungsmethode begann OpenAI, die Wirksamkeit seiner Technologie in verschiedenen Teilen des Netzwerks zu messen, und versuchte, die Technologie für Teile zu verbessern, die derzeit unklar waren. Beispielsweise funktioniert ihre Technik bei größeren Modellen nicht gut, möglicherweise weil spätere Schichten schwieriger zu interpretieren sind.

OpenAI sagte, dass die überwiegende Mehrheit ihrer Erklärungen zwar nicht besonders gut abgeschnitten habe Sie glauben jedoch, dass sie jetzt ML-Techniken nutzen können, um ihre Fähigkeit, Erklärungen zu generieren, weiter zu verbessern. Sie stellten beispielsweise fest, dass Folgendes zur Verbesserung ihrer Punktzahl beitrug:

- Iterative Erklärungen. Sie könnten ihre Ergebnisse verbessern, indem sie GPT-4 bitten, sich mögliche Gegenbeispiele auszudenken und dann die Erklärung basierend auf ihrer Aktivierung zu modifizieren.

- Verwenden Sie zur Erklärung ein größeres Modell. Wenn sich die Fähigkeiten des Erklärmodells verbessern, steigt auch die durchschnittliche Punktzahl. Allerdings lieferte selbst GPT-4 schlechtere Erklärungen als Menschen, was darauf hindeutet, dass es Raum für Verbesserungen gibt.

- Ändern Sie die Architektur des erklärten Modells. Das Training des Modells mit verschiedenen Aktivierungsfunktionen verbessert den Erklärungswert.

OpenAI sagte, dass sie einen von GPT-4 geschriebenen Datensatz und ein Visualisierungstool zusammenstellen, das alle 307.200 Neuronen in GPT-2 Open Source erklärt. Gleichzeitig stellen sie auch Code zur Interpretation und Bewertung mithilfe von Modellen bereit, die auf der OpenAI-API öffentlich verfügbar sind. Sie hoffen, dass die Forschungsgemeinschaft neue Techniken entwickeln wird, um Erklärungen mit höherer Punktzahl zu generieren, sowie bessere Werkzeuge zur Erforschung von GPT-2 durch Erklärungen.

Sie fanden heraus, dass es mehr als 1.000 Neuronen mit Erklärungswerten von mindestens 0,8 gab, was bedeutet, dass sie laut GPT-4 Activate die meisten Neuronen mit der höchsten Ränge ausmachten Verhalten. Die meisten dieser gut erklärten Neuronen sind nicht sehr interessant. Allerdings fanden sie auch viele interessante Neuronen, die GPT-4 nicht verstand. OpenAI hofft, dass mit der Verbesserung der Erklärungen schnell interessante qualitative Erkenntnisse zu Modellberechnungen gewonnen werden können.

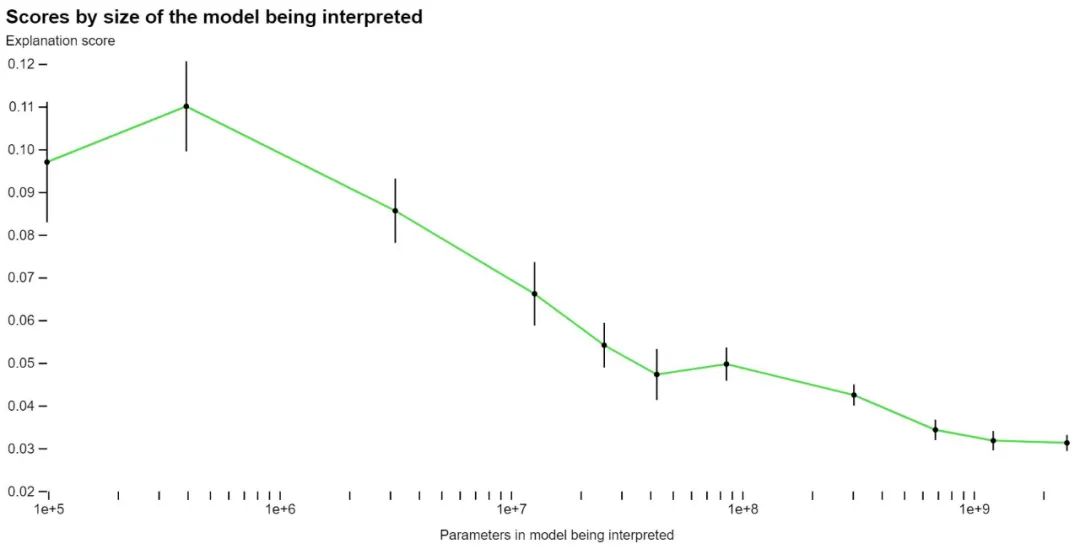

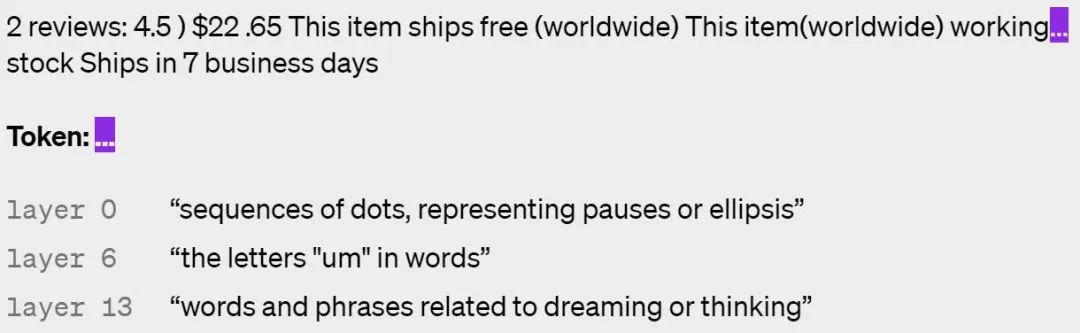

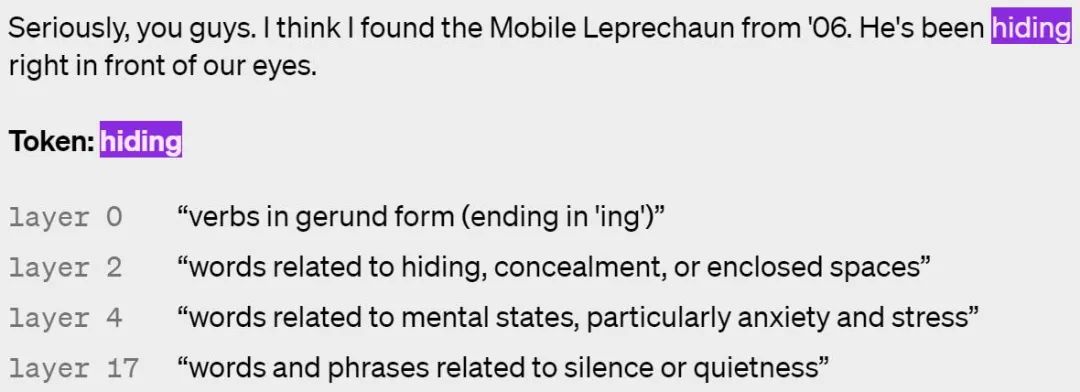

Hier sind einige Beispiele für die Aktivierung von Neuronen in verschiedenen Schichten, wobei höhere Schichten abstrakter sind:

#🎜🎜 #

# 🎜🎜#

OpenAI Future Work

Derzeit weist diese Methode noch einige Einschränkungen auf, und OpenAI hofft, diese Probleme in zukünftigen Arbeiten zu lösen:# 🎜🎜 #

- Diese Methode konzentriert sich auf kurze Erklärungen in natürlicher Sprache, aber Neuronen können sehr komplexe Verhaltensweisen aufweisen, die nicht prägnant beschrieben werden können; OpenAI hofft, irgendwann automatisch ganze neuronale Schaltkreise finden und erklären zu können, um komplexe Verhaltensweisen zu erreichen, wobei Neuronen und Aufmerksamkeitsköpfe zusammenarbeiten. Aktuelle Methoden interpretieren das Verhalten von Neuronen einfach als Funktion der Rohtexteingabe, ohne die nachgelagerten Auswirkungen zu berücksichtigen. Beispielsweise könnte ein Neuron, das über einen Zeitraum feuert, anzeigen, dass das nächste Wort mit einem Großbuchstaben beginnen sollte, oder einen Satzzähler erhöhen.

- OpenAI erklärt das Verhalten des Neurons ohne zu versuchen, den Mechanismus zu erklären, der es erzeugt. Das bedeutet, dass selbst hoch bewertete Erklärungen bei nicht verbreiteten Texten möglicherweise schlecht abschneiden, weil sie lediglich einen Zusammenhang beschreiben; . Letztendlich hofft OpenAI, mithilfe von Modellen völlig allgemeine Hypothesen aufzustellen, zu testen und zu iterieren, so wie es Erklärbarkeitsforscher tun. Darüber hinaus hofft OpenAI, seine größten Modelle als eine Möglichkeit zu interpretieren, Ausrichtungs- und Sicherheitsprobleme vor und nach der Bereitstellung zu erkennen. Bis es soweit ist, ist es allerdings noch ein weiter Weg.

Das obige ist der detaillierte Inhalt vonOpenAI nutzt GPT-4, um die 300.000 Neuronen von GPT-2 zu erklären: So sieht Weisheit aus. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr