Heim >Technologie-Peripheriegeräte >KI >Ist Nvidias Ära der Dominanz vorbei? ChatGPT löst einen Chip-Krieg zwischen Google und Microsoft aus, und auch Amazon beteiligt sich am Kampf

Ist Nvidias Ära der Dominanz vorbei? ChatGPT löst einen Chip-Krieg zwischen Google und Microsoft aus, und auch Amazon beteiligt sich am Kampf

- 王林nach vorne

- 2023-05-22 22:55:041161Durchsuche

Nachdem ChatGPT populär wurde, hat sich der KI-Krieg zwischen den beiden Giganten Google und Microsoft in neue Feld-Server-Chips eingebrannt.

Heutzutage sind KI und Cloud Computing zu Schlachtfeldern geworden, und Chips sind auch zum Schlüssel zur Kostensenkung und Gewinnung von Geschäftskunden geworden.

Ursprünglich waren große Unternehmen wie Amazon, Microsoft und Google für ihre Software berühmt, aber jetzt haben sie Milliarden von Dollar für die Entwicklung und Produktion von Chips ausgegeben.

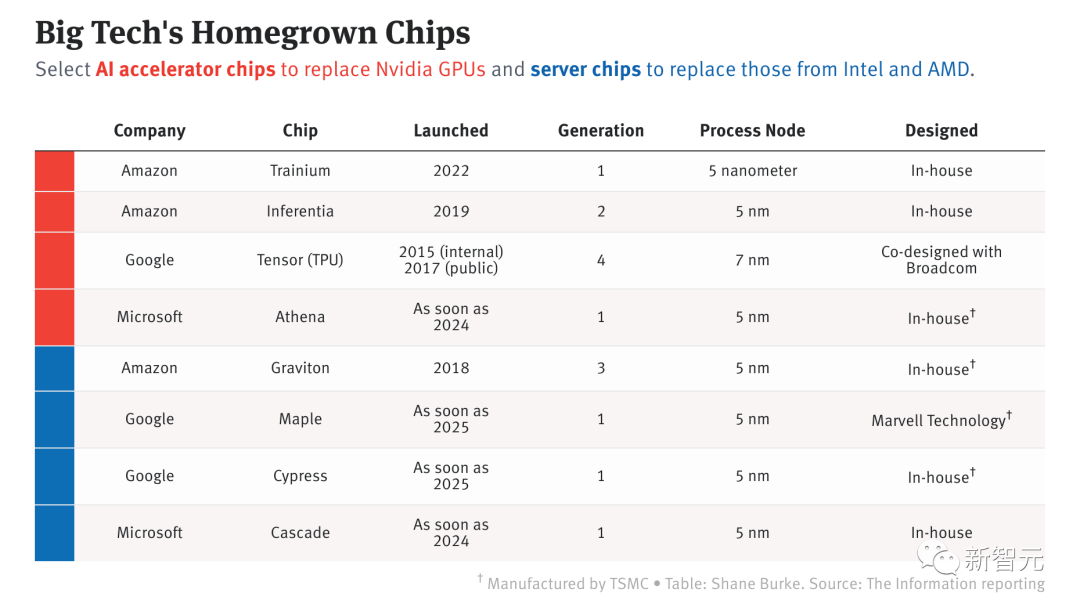

Von großen Technologiegiganten entwickelte KI-Chips

ChatGPT explodierte und große Hersteller starteten einen Chip-Wettbewerb

Berichten ausländischer Medien The Information und anderen Quellen zufolge sind diese drei großen Hersteller Das Unternehmen hat inzwischen acht Server und KI-Chips für die interne Produktentwicklung, die Cloud-Server-Vermietung oder beides auf den Markt gebracht oder plant deren Einführung.

„Wenn Sie Silizium herstellen können, das für KI optimiert ist, haben Sie einen großen Gewinn vor sich“, sagte Glenn O’Donnell, Direktor des Forschungsunternehmens Forrester.

Werden sich diese enormen Anstrengungen auf jeden Fall auszahlen?

Die Antwort lautet: Nicht unbedingt.

Intel, AMD und Nvidia können von Skaleneffekten profitieren, aber das ist bei den großen Technologieunternehmen bei weitem nicht der Fall.

Sie stehen auch vor vielen heiklen Herausforderungen, wie zum Beispiel der Einstellung von Chip-Designern und der Überzeugung von Entwicklern, Anwendungen mit ihren maßgeschneiderten Chips zu erstellen.

Allerdings haben große Hersteller auf diesem Gebiet beeindruckende Fortschritte gemacht.

Laut veröffentlichten Leistungsdaten sind die Graviton-Serverchips von Amazon sowie die von Amazon und Google veröffentlichten KI-spezifischen Chips bereits in der Leistung mit denen traditioneller Chiphersteller vergleichbar.

Es gibt zwei Haupttypen von Chips, die von Amazon, Microsoft und Google für ihre Rechenzentren entwickelt werden: Standard-Computerchips und Spezialchips, die zum Trainieren und Ausführen von Modellen für maschinelles Lernen verwendet werden. Letzteres ist die Grundlage großer Sprachmodelle wie ChatGPT.

Zuvor hat Apple erfolgreich Chips für iPhone, iPad und Mac entwickelt und damit die Verarbeitung einiger KI-Aufgaben verbessert. Diese großen Hersteller haben sich möglicherweise von Apple inspirieren lassen.

Unter den drei großen Herstellern ist Amazon der einzige Cloud-Dienstleister, der zwei Arten von Chips in Servern bereitstellt. Der 2015 übernommene israelische Chipdesigner Annapurna Labs legte den Grundstein für diese Bemühungen.

Google hat 2015 einen Chip für KI-Workloads auf den Markt gebracht und entwickelt einen Standard-Serverchip, um die Serverleistung in Google Cloud zu verbessern.

Im Gegensatz dazu begann die Chip-Forschung und -Entwicklung von Microsoft relativ spät, nämlich im Jahr 2019. Kürzlich hat Microsoft den Zeitplan für die Einführung von KI-Chips, die speziell für LLM entwickelt wurden, beschleunigt.

Die Popularität von ChatGPT hat die Begeisterung für KI bei Benutzern auf der ganzen Welt entfacht. Dadurch wurde die strategische Transformation der drei großen Hersteller weiter vorangetrieben.

ChatGPT läuft auf der Azure-Cloud von Microsoft und nutzt Zehntausende Nvidia A100. Sowohl ChatGPT als auch andere in Bing integrierte OpenAI-Software und verschiedene Programme erfordern so viel Rechenleistung, dass Microsoft Serverhardware internen Teams zugewiesen hat, die KI entwickeln.

Bei Amazon teilte Finanzvorstand Brian Olsavsky den Anlegern letzte Woche in einer Telefonkonferenz mit, dass Amazon plant, Ausgaben von seinem Einzelhandelsgeschäft auf AWS zu verlagern, unter anderem um in die Infrastruktur zu investieren, die zur Unterstützung von ChatGPT erforderlich ist.

Bei Google wurde das für den Aufbau der Tensor Processing Unit verantwortliche Ingenieurteam in die Google Cloud verlegt. Es wird berichtet, dass Cloud-Organisationen nun eine Roadmap für TPUs und die darauf laufende Software entwickeln können, in der Hoffnung, Cloud-Kunden mehr TPU-basierte Server mieten zu können.

Google: TPU V4 speziell auf KI abgestimmt

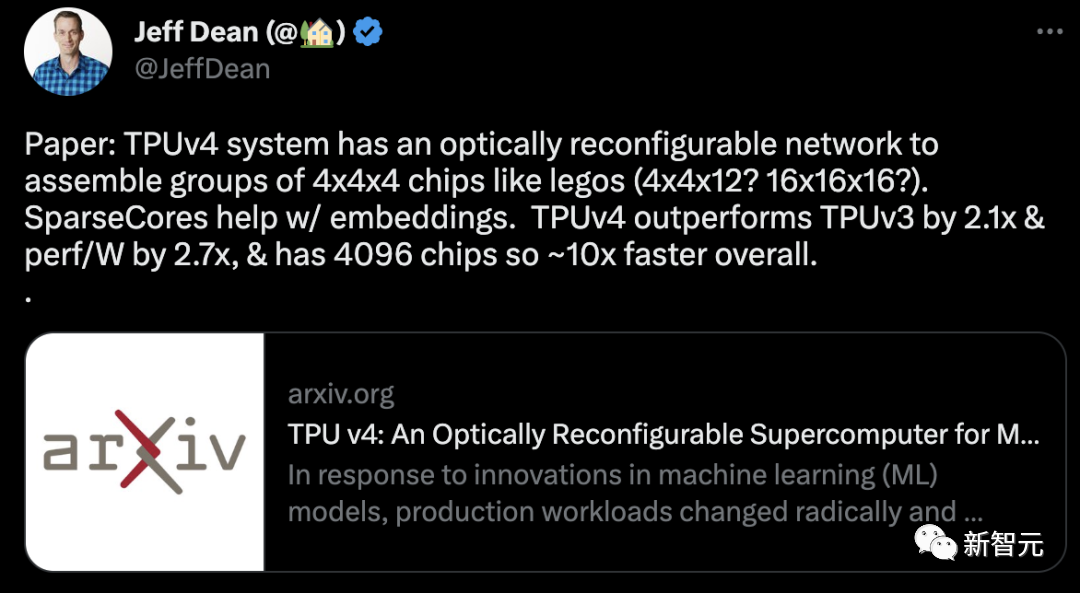

Bereits im Jahr 2020 setzte Google den damals leistungsstärksten KI-Chip – TPU v4 – im eigenen Rechenzentrum ein.

Allerdings gab Google erst am 4. April dieses Jahres erstmals die technischen Details dieses KI-Supercomputers bekannt.

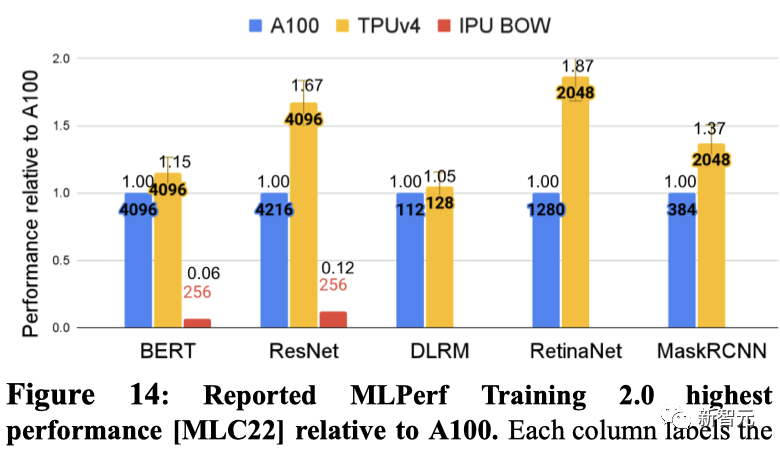

Im Vergleich zu TPU v3 ist die Leistung von TPU v4 2,1-mal höher, und nach der Integration von 4096 Chips wird die Leistung von Supercomputing um das Zehnfache verbessert.

Gleichzeitig behauptet Google auch, dass der eigene Chip schneller und energieeffizienter sei als NVIDIA A100. Bei Systemen vergleichbarer Größe kann TPU v4 eine 1,7-mal bessere Leistung als NVIDIA A100 bieten und gleichzeitig die Energieeffizienz um das 1,9-fache verbessern.

Bei Systemen ähnlicher Größe ist TPU v4 1,15-mal schneller als A100 auf BERT und etwa 4,3-mal schneller als IPU. Für ResNet ist TPU v4 1,67x bzw. etwa 4,5x schneller.

Unabhängig davon hat Google angedeutet, dass es an einer neuen TPU arbeitet, um mit dem Nvidia H100 zu konkurrieren. Google-Forscher Jouppi sagte in einem Interview mit Reuters, dass Google „eine Produktionslinie für zukünftige Chips“ habe.

Microsoft: Geheimwaffe Athena

Egal was passiert, Microsoft ist immer noch bestrebt, es in diesem Chip-Streit zu versuchen.

Zuvor wurde bekannt, dass ein 300-köpfiges Team, das heimlich von Microsoft gegründet wurde, 2019 mit der Entwicklung eines benutzerdefinierten Chips namens „Athena“ begann.

Nach dem ursprünglichen Plan wird „Athena“ im 5-nm-Prozess von TSMC gebaut, wodurch die Kosten für jeden Chip voraussichtlich um 1/3 gesenkt werden.

Wenn es nächstes Jahr in großem Maßstab implementiert werden kann, können die internen und OpenAI-Teams von Microsoft „Athena“ verwenden, um gleichzeitig Modelltraining und Inferenz durchzuführen.

Auf diese Weise kann der Mangel an dedizierten Computern erheblich gemildert werden.

Bloomberg berichtete letzte Woche, dass die Chipabteilung von Microsoft mit AMD bei der Entwicklung des Athena-Chips zusammengearbeitet hat, was am Donnerstag auch dazu führte, dass der Aktienkurs von AMD um 6,5 % stieg.

Aber ein Insider sagte, dass AMD nicht beteiligt ist, sondern eine eigene GPU entwickelt, um mit Nvidia zu konkurrieren, und AMD das Design des Chips mit Microsoft besprochen hat, da erwartet wird, dass Microsoft diese GPU kauft.

Amazon: Schon jetzt in Führung

Im Chipwettlauf mit Microsoft und Google scheint Amazon die Führung übernommen zu haben.

Im letzten Jahrzehnt hat Amazon durch die Bereitstellung fortschrittlicherer Technologie und niedrigerer Preise einen Wettbewerbsvorteil gegenüber Microsoft und Google bei Cloud-Computing-Diensten behauptet.

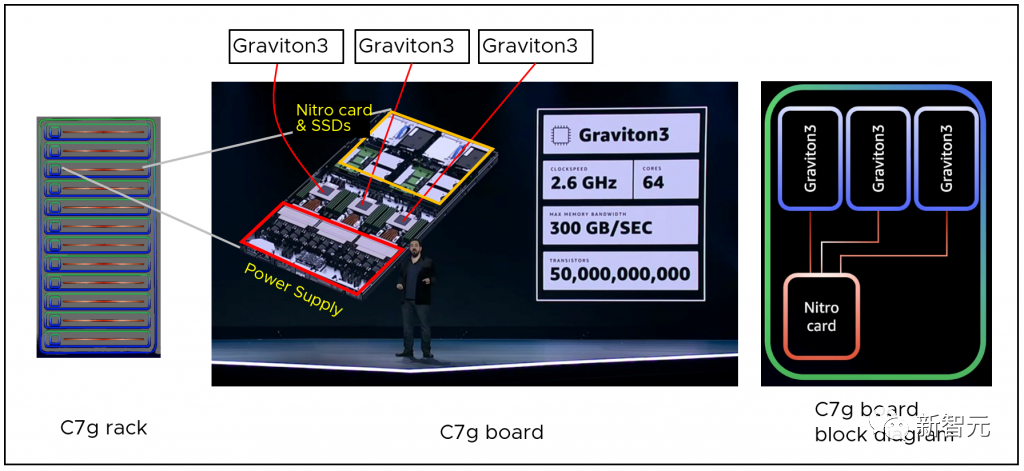

Amazon wird voraussichtlich auch in den nächsten zehn Jahren durch den intern entwickelten Serverchip Graviton weiterhin einen Wettbewerbsvorteil behaupten.

Als neueste Prozessorgeneration verbessert AWS Graviton3 die Rechenleistung im Vergleich zur Vorgängergeneration um bis zu 25 % und verbessert die Gleitkommaleistung um das bis zu Zweifache. Es unterstützt auch DDR5-Speicher, der im Vergleich zu DDR4-Speicher eine um 50 % höhere Bandbreite bietet.

Für Machine-Learning-Workloads bietet AWS Graviton3 eine bis zu dreimal bessere Leistung als die vorherige Generation und unterstützt bfloat16.

Cloud-Dienste auf Basis von Graviton-3-Chips erfreuen sich in manchen Gegenden großer Beliebtheit und haben sogar einen Angebotsstand erreicht, der die Nachfrage übersteigt.

Ein weiterer Vorteil von Amazon besteht darin, dass es derzeit der einzige Cloud-Anbieter ist, der Standard-Computing-Chips (Graviton) und KI-spezifische Chips (Inferentia und Trainium) in seinen Servern bereitstellt.

Bereits im Jahr 2019 brachte Amazon seinen eigenen KI-Inferenzchip auf den Markt – Inferentia.

Es ermöglicht Kunden, umfangreiche Inferenzanwendungen für maschinelles Lernen wie Bilderkennung, Spracherkennung, Verarbeitung natürlicher Sprache, Personalisierung und Betrugserkennung kostengünstig in der Cloud auszuführen.

Das neueste Inferentia 2 hat die Rechenleistung um das Dreifache verbessert, der gesamte Beschleunigerspeicher wurde um das Vierfache erweitert, der Durchsatz wurde um das Vierfache erhöht und die Latenz wurde auf 1/10 reduziert.

Nach der Einführung des ursprünglichen Inferentia veröffentlichte Amazon einen maßgeschneiderten Chip, der hauptsächlich für das KI-Training entwickelt wurde – Trainium.

Es ist für Deep-Learning-Trainingsarbeitslasten optimiert, einschließlich Bildklassifizierung, semantische Suche, Übersetzung, Spracherkennung, Verarbeitung natürlicher Sprache und Empfehlungsmaschinen usw.

In einigen Fällen können durch die Chipanpassung nicht nur die Kosten um eine Größenordnung gesenkt und der Energieverbrauch auf 1/10 gesenkt werden, sondern diese maßgeschneiderten Lösungen können den Kunden auch bessere Dienste mit geringerer Latenz bieten.

Es ist nicht so einfach, NVIDIAs Monopol zu erschüttern

Aber bisher laufen die meisten KI-Workloads immer noch auf GPUs und NVIDIA produziert die meisten Chips.

Laut früheren Berichten erreicht NVIDIAs unabhängiger GPU-Marktanteil 80 % und sein High-End-GPU-Marktanteil erreicht 90 %.

In 20 Jahren wurden 80,6 % der weltweiten Cloud-Computing- und Rechenzentren mit KI durch NVIDIA-GPUs angetrieben. Im Jahr 2021 gab NVIDIA an, dass etwa 70 % der 500 besten Supercomputer der Welt von eigenen Chips angetrieben würden.

Und jetzt verwendet sogar das Microsoft-Rechenzentrum, in dem ChatGPT ausgeführt wird, Zehntausende NVIDIA A100-GPUs.

Ob das Spitzenmodell ChatGPT, Bard, Stable Diffusion und andere Modelle: Dahinter steckt seit langem die Rechenleistung des NVIDIA A100-Chips im Wert von jeweils etwa 10.000 US-Dollar.

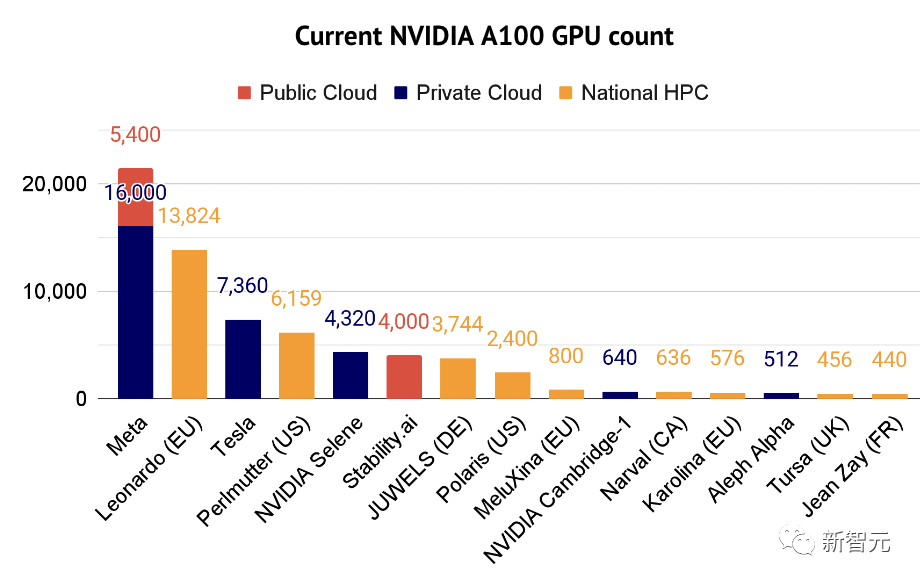

Darüber hinaus ist A100 mittlerweile zum „Hauptarbeitstier“ für Experten im Bereich der künstlichen Intelligenz geworden. Der Bericht „State of Artificial Intelligence 2022“ listet auch einige der Unternehmen auf, die den Supercomputer A100 nutzen.

Es ist offensichtlich, dass NVIDIA die globale Rechenleistung monopolisiert hat und mit seinen eigenen Chips die Welt dominiert.

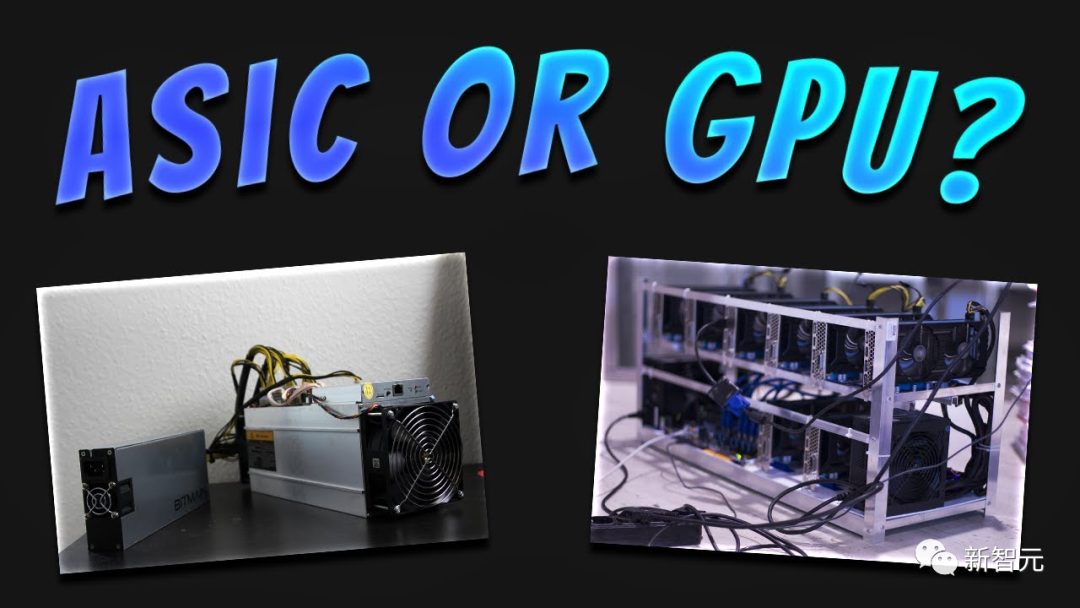

Laut Praktikern können die von Amazon, Google und Microsoft entwickelten anwendungsspezifischen integrierten Schaltkreise (ASIC) im Vergleich zu Allzweckchips maschinelle Lernaufgaben schneller ausführen und verbrauchen weniger Strom.

Direktor O'Donnell nutzte diesen Vergleich beim Vergleich von GPUs und ASICs: „Sie können einen Prius für die tägliche Fahrt verwenden, aber wenn Sie in den Bergen auf Allradantrieb zurückgreifen müssen, wäre ein Jeep Wrangler besser geeignet.“

Aber trotz ihrer Bemühungen stehen Amazon, Google und Microsoft alle vor Herausforderungen – wie wäre es, wenn Entwickler davon überzeugt würden, diese zu nutzen? KI-Chips?

Jetzt dominieren Nvidias GPUs und Entwickler sind bereits mit der proprietären Programmiersprache CUDA für die Erstellung GPU-gesteuerter Anwendungen vertraut.

Wenn sie auf einen benutzerdefinierten Chip von Amazon, Google oder Microsoft umsteigen, müssen sie eine neue Softwaresprache lernen.

Das obige ist der detaillierte Inhalt vonIst Nvidias Ära der Dominanz vorbei? ChatGPT löst einen Chip-Krieg zwischen Google und Microsoft aus, und auch Amazon beteiligt sich am Kampf. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr