Heim >Technologie-Peripheriegeräte >KI >Dieser Artikel hilft Ihnen zu verstehen, was ein Gradientenabstieg ist

Dieser Artikel hilft Ihnen zu verstehen, was ein Gradientenabstieg ist

- 王林nach vorne

- 2023-05-17 17:04:122901Durchsuche

Gradientenabstieg ist die Kraftquelle für maschinelles Lernen

Nach den beiden vorherigen Abschnitten können wir beginnen, über die Kraftquelle für maschinelles Lernen zu sprechen: Gradientenabstieg.

Der Gradientenabstieg ist kein sehr kompliziertes mathematisches Werkzeug. Seine Geschichte reicht mehr als 200 Jahre zurück. Allerdings haben die Menschen möglicherweise nicht erwartet, dass ein so relativ einfaches mathematisches Werkzeug die Grundlage vieler maschineller Lernalgorithmen werden wird mit neuronalen Netzen löste die Deep-Learning-Revolution aus.

1. Was ist ein Gradient? Finden Sie die partiellen Ableitungen jedes Parameters einer multivariaten Funktion und schreiben Sie dann die erhaltenen partiellen Ableitungen jedes Parameters in Form eines Vektors, der den Gradienten darstellt.

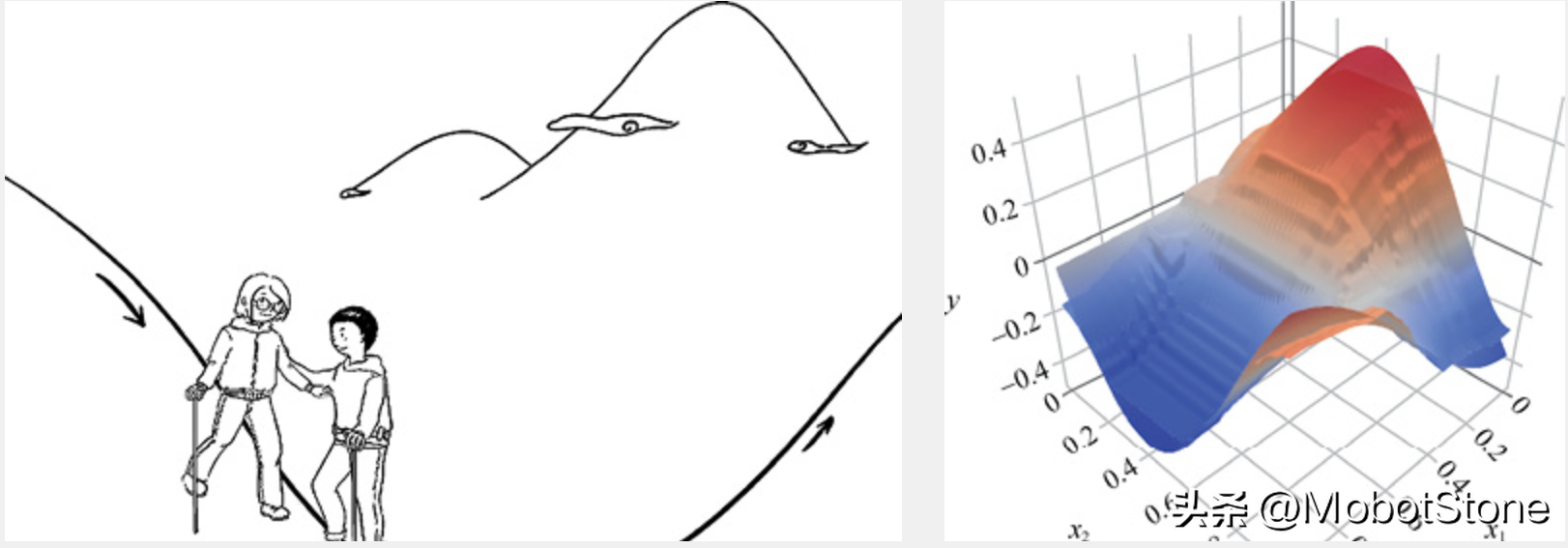

Konkret entspricht die Funktion f (x1, x2) der beiden unabhängigen Variablen den beiden Merkmalen im Datensatz des maschinellen Lernens. Wenn die partiellen Ableitungen für x1 bzw. x2 erhalten werden, ist der erhaltene Gradientenvektor (∂f /∂x1, ∂f/∂x2) T, was mathematisch als Δf (x1, x2) ausgedrückt werden kann. Was bringt es also, den Gradientenvektor zu berechnen? Seine geometrische Bedeutung ist die Richtung, in die sich die Funktion ändert, und es ist die sich am schnellsten ändernde Richtung. Für die Funktion f(x) ist am Punkt (x0, y0) die Richtung des Gradientenvektors die Richtung, in der der y-Wert am schnellsten ansteigt. Mit anderen Worten: Entlang der Richtung des Gradientenvektors Δf (x0) kann der Maximalwert der Funktion gefunden werden. Entlang der entgegengesetzten Richtung des Gradientenvektors, also der Richtung von -Δf (x0), nimmt der Gradient dagegen am schnellsten ab und der Minimalwert der Funktion kann gefunden werden. Wenn der Wert des Gradientenvektors an einem bestimmten Punkt 0 ist, dann hat er den niedrigsten Punkt (oder lokalen niedrigsten Punkt) der Funktion mit einer Ableitung von 0 erreicht.

2. Gefälleabstieg: Bergab-Metapher

Beim maschinellen Lernen wird der Bergabstieg häufig als Metapher für den Gefälleabstieg verwendet. Stellen Sie sich vor, Sie stehen irgendwo auf einem großen Berg, blicken auf das endlose Gelände in der Ferne und wissen nur, dass der Ort in der Ferne viel tiefer liegt als hier. Sie möchten wissen, wie man den Berg hinuntersteigt, aber Sie können nur Schritt für Schritt hinuntergehen, das heißt, jedes Mal, wenn Sie eine Position erreichen, ermitteln Sie die Steigung der aktuellen Position. Machen Sie dann einen Schritt nach unten entlang der negativen Richtung des Gradienten, dh gehen Sie an der steilsten Stelle nach unten, lösen Sie weiterhin den Gradienten der neuen Position und machen Sie an der neuen Position einen Schritt nach unten entlang der steilsten Stelle. Gehen Sie einfach Schritt für Schritt, bis Sie den Fuß des Berges erreichen, wie im Bild unten gezeigt.

Aus der obigen Erklärung ist es nicht schwer zu verstehen, warum wir gerade die Konkavität und Konvexität der Funktion erwähnt haben. Denn in einer nicht-konvexen Funktion erreicht es möglicherweise nicht den Fuß des Berges, sondern stoppt in einem bestimmten Tal. Mit anderen Worten: Der Gradientenabstieg für nicht konvexe Funktionen findet möglicherweise nicht immer die globale optimale Lösung, sondern nur eine lokale optimale Lösung. Wenn die Funktion jedoch konvex ist, kann die Gradientenabstiegsmethode theoretisch die globale optimale Lösung erhalten.

Aus der obigen Erklärung ist es nicht schwer zu verstehen, warum wir gerade die Konkavität und Konvexität der Funktion erwähnt haben. Denn in einer nicht-konvexen Funktion erreicht es möglicherweise nicht den Fuß des Berges, sondern stoppt in einem bestimmten Tal. Mit anderen Worten: Der Gradientenabstieg für nicht konvexe Funktionen findet möglicherweise nicht immer die globale optimale Lösung, sondern nur eine lokale optimale Lösung. Wenn die Funktion jedoch konvex ist, kann die Gradientenabstiegsmethode theoretisch die globale optimale Lösung erhalten.

3. Welchen Nutzen hat der Gradientenabstieg?

Der Gradientenabstieg ist beim maschinellen Lernen sehr nützlich. Vereinfacht gesagt können Sie auf die folgenden Punkte achten.

Die Essenz des maschinellen Lernens besteht darin, die optimale Funktion zu finden.

Wie misst man, ob eine Funktion optimal ist? Die Methode besteht darin, den Fehler zwischen dem vorhergesagten Wert und dem wahren Wert (im maschinellen Lernen auch Verlustwert genannt) zu minimieren.

Sie können eine Funktion zwischen Fehler- und Modellparametern festlegen (vorzugsweise eine konvexe Funktion).

Der Gradientenabstieg kann uns zum globalen Minimum der konvexen Funktion führen, dh zum Finden der Parameter mit dem kleinsten Fehler.

Das obige ist der detaillierte Inhalt vonDieser Artikel hilft Ihnen zu verstehen, was ein Gradientenabstieg ist. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Meinung: KI-gesteuerte Technologie schafft neue Wege

- [KI-Frontstation] Bitte beaufsichtigen Sie uns! Der CEO von OpenAI weist erneut auf die Risiken der Branche der künstlichen Intelligenz hin

- Unterstützt durch digitale Intelligenz dringt die intelligente iPurchase AI-Kollektion tief in die Yiwu Clothing Expo ein, Innovation führt zur intelligenten Schaffung einer neuen Zukunft

- Xiaomi veröffentlicht den Roboter CyberDog 2

- Das neue Altair HyperWorks 2023 beinhaltet KI-Technologie