Heim >Technologie-Peripheriegeräte >KI >Sehen Sie sich „Harry Potter' in einer Sitzung an: KI-Großmodell „Quantum Speed Reading', eine Minute entspricht fünf menschlichen Stunden

Sehen Sie sich „Harry Potter' in einer Sitzung an: KI-Großmodell „Quantum Speed Reading', eine Minute entspricht fünf menschlichen Stunden

- PHPznach vorne

- 2023-05-16 12:49:141317Durchsuche

In letzter Zeit war OpenAI mit seinen Modellen der GPT-Serie und ChatGPT die meistgesehene Forschungseinrichtung. Doch in den letzten zwei Jahren rückte ein KI-Start-up in alle Blicke. Dieses Unternehmen heißt Anthropic. Es konzentriert sich auf die Entwicklung allgemeiner KI-Systeme und Sprachmodelle und verfolgt das Konzept der verantwortungsvollen KI verwenden.

Ich frage mich, ob Sie sich noch an den kollektiven Rücktritt der Kernmitarbeiter von OpenAI Ende 2020 erinnern. Damals sorgte dieser Vorfall für großes Aufsehen im KI-Kreis. Anthropic wurde von diesen verstorbenen Mitarbeitern gegründet, darunter Dario Amodei, ehemaliger Vizepräsident für Forschung bei OpenAI, Tom Brown, der Erstautor des GPT-3-Papiers, und andere.

Im Januar dieses Jahres hatte Anthropic über 700 Millionen US-Dollar an Finanzmitteln eingesammelt, wobei die letzte Finanzierungsrunde einen Wert von 5 Milliarden US-Dollar hatte. Gleichzeitig entwickelte das Unternehmen zwei Monate nach der Veröffentlichung von ChatGPT schnell Claude, ein künstliches Intelligenzsystem, das seinen alten Club ChatGPT vergleicht.

Claude-Anwendungszugriffsadresse: https://www.anthropic.com/earlyaccess

Claude verwendet einen von Anthropic entwickelten Mechanismus namens „Constitutional AI“. „basierter“ Ansatz, um KI-Systeme an menschlichen Absichten auszurichten.

Claude kann Aufgaben wie Zusammenfassung, Suche, Unterstützung bei der Erstellung, Fragen und Antworten, Codierung usw. erledigen. Basierend auf dem Benutzer-Feedback ist die Wahrscheinlichkeit geringer, dass Claude schädliche Inhalte erzeugt, es ist einfacher, Gespräche zu führen und leichter zu kontrollieren. Darüber hinaus kann Claude anhand von Anweisungen seine Persönlichkeit, seinen Ton und sein Verhalten bestimmen.

Allerdings hat Anthropic nicht viele technische Details zu Claude bereitgestellt, aber die Technologie hinter Claude wird im Artikel „Constitutional AI: Harmlessness from AI Feedback“ beschrieben.

Papieradresse: https://arxiv.org/pdf/2212.08073.pdf

Bereits im Januar testeten Forscher die maximale Textmenge, die Claude auf einmal verarbeiten kann, und zeigten, dass Claude dies kann Informationen von 8k-Tokens abrufen.

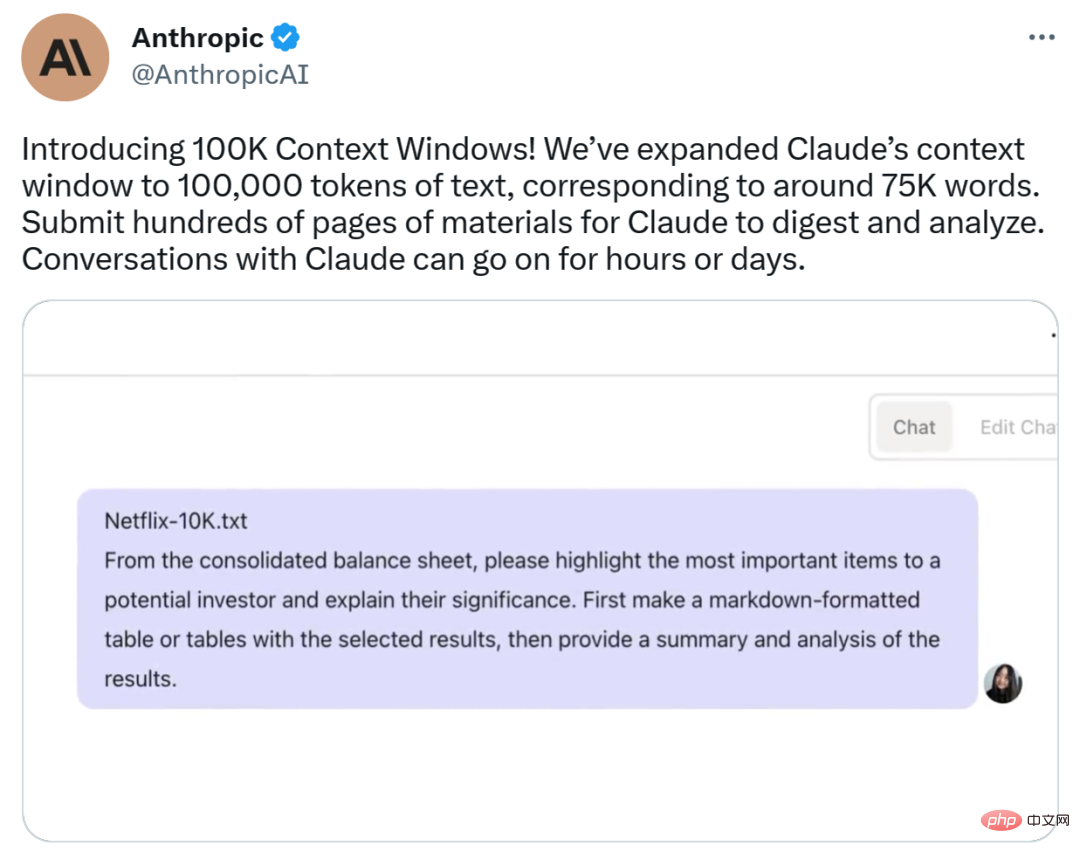

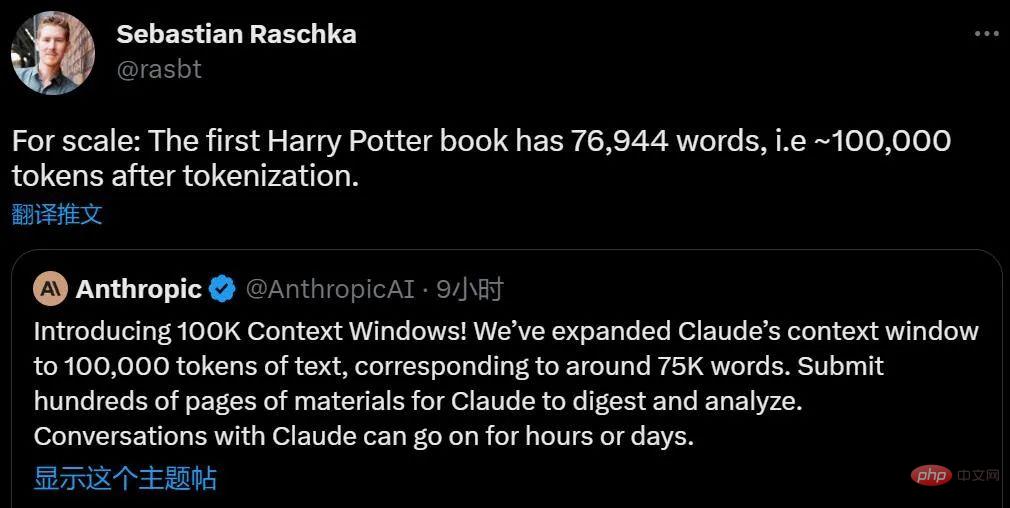

Vor nicht allzu langer Zeit, an diesem Donnerstag, hat Anthropic 100.000 Kontextfenster gestartet. Es erweitert Claudes Kontextfenster von 9.000 Token auf 100.000, was 75.000 Wörtern entspricht. Das bedeutet, dass Unternehmen Claude Hunderte von Seiten an Material zum Verarbeiten und Interpretieren übermitteln können und Gespräche mit ihm Stunden oder sogar Tage dauern können. 100.000 Kontextfenster sind jetzt über die Anthropic API zugänglich.

Claude Evolution: Echtes „KI-Quantengeschwindigkeitslesen“

Laut wissenschaftlicher Forschung können normale Menschen 100.000 Token in etwa 5 Stunden lesen und es kann länger dauern, diese Informationen zu verarbeiten, zu merken und zu analysieren.Jetzt kann Claude dies in weniger als 1 Minute erledigen.

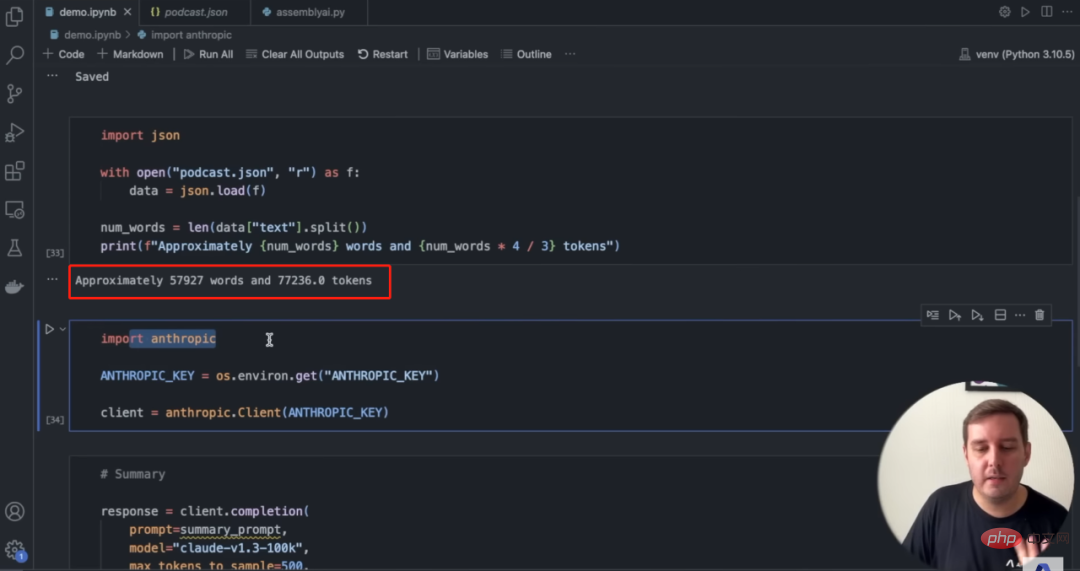

Allgemeine Berechnungen für Kontextfenster. Anthropic hat zunächst den gesamten Text von „The Great Gatsby“ in Claude-Instant geladen (72.000 Token, Claude hat zwei Versionen, Claude und Claude Instant, Claude ist das fortschrittlichste Hochleistungsmodell, während Claude Instant leichter, billiger, schnellere Option) und änderte die Zeile „Mr. Carraway ist ein Softwareentwickler, der bei Anthropic an maschinellem Lernen arbeitet.“ Als Anthropic das Modell aufforderte, Unterschiede zum Originaltext zu finden, gab es innerhalb von 22 Sekunden die richtige Antwort. Neben dem Lesen langer Texte hilft Claude auch beim Abrufen von Informationen aus Dokumenten und kommt so dem Geschäftsbetrieb zugute . Benutzer können mehrere Dokumente oder sogar ein Buch in die Eingabeaufforderung einfügen und Claude dann eine Frage stellen (was eine umfassende Wissensanalyse vieler Teile des Textes erfordert). Bei komplexen Problemen kann dies wesentlich effizienter sein als auf der Vektorsuche basierende Methoden. Claude kann den Anweisungen des Benutzers folgen und die gesuchten Informationen zurückgeben, genau wie ein menschlicher Assistent. Anthropic fügte dann die Entwicklerdokumentation des umfangreichen Sprachintegrationstools LangChain API (240 Seiten) in das Modell ein und gab dann als Antwort auf die gestellten Fragen eine LangChain-Demo unter Verwendung des Anthropic-Sprachmodells. Mittlerweile können 100.000 Token in etwa 6 Stunden Audio umgewandelt werden. AssemblyAI hat dies hervorragend demonstriert, indem es einen langen Podcast in fast 58.000 Wörter transkribiert und dann Claude für zusammenfassende Zusammenfassungen und Fragen und Antworten verwendet hat. Bildquelle: AssemblyAI Zusammengefasst können Benutzer mit 100.000 Kontextfenstern Folgendes tun: Forschungsarbeiten; Quelle: Twitter @nathanwchan Was den Preis angeht, sagte Anthropic-Techniker Ben Mann, dass der Millionen-Token-Preis von 100K Context Windows derselbe ist wie bei früheren Modellen.

Das obige ist der detaillierte Inhalt vonSehen Sie sich „Harry Potter' in einer Sitzung an: KI-Großmodell „Quantum Speed Reading', eine Minute entspricht fünf menschlichen Stunden. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr