Heim >Technologie-Peripheriegeräte >KI >NVIDIA veröffentlicht eine dedizierte ChatGPT-GPU, die die Inferenzgeschwindigkeit um das Zehnfache erhöht

NVIDIA veröffentlicht eine dedizierte ChatGPT-GPU, die die Inferenzgeschwindigkeit um das Zehnfache erhöht

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-05-13 23:04:041357Durchsuche

Es war einmal, als die künstliche Intelligenz aufgrund unzureichender Rechenleistung in einen jahrzehntelangen Engpass geriet und die GPU Deep Learning in Gang setzte. Im Zeitalter von ChatGPT steht die KI erneut vor dem Problem unzureichender Rechenleistung aufgrund großer Modelle. Hat NVIDIA dieses Mal eine Lösung?

Am 22. März fand die GTC-Konferenz offiziell statt. Bei der gerade abgehaltenen Keynote holte NVIDIA-CEO Jensen Huang die für ChatGPT vorbereiteten Chips heraus.

„Computing zu beschleunigen ist nicht einfach. Im Jahr 2012 nutzte das Computer-Vision-Modell AlexNet die GeForce GTX 580 und konnte 262 PetaFLOPS pro Sekunde verarbeiten. Dieses Modell löste eine Explosion der KI-Technologie aus“, sagte Huang. „Zehn Jahre später erschien Transformer. GPT-3 nutzte 323 ZettaFLOPS Rechenleistung, 1 Million Mal so viel wie AlexNet, um ChatGPT zu erstellen, eine KI, die die Welt schockierte. Eine neue Computerplattform erschien und die iPhone-Ära der KI ist angebrochen . „

Der Boom in der KI hat den Aktienkurs von Nvidia in diesem Jahr um 77 % steigen lassen. Derzeit beträgt der Marktwert von Nvidia 640 Milliarden US-Dollar, was fast dem Fünffachen von Intel entspricht. Die heutige Veröffentlichung zeigt uns jedoch, dass Nvidia noch nicht damit aufgehört hat.

Entwerfen dedizierter Rechenleistung für AIGC

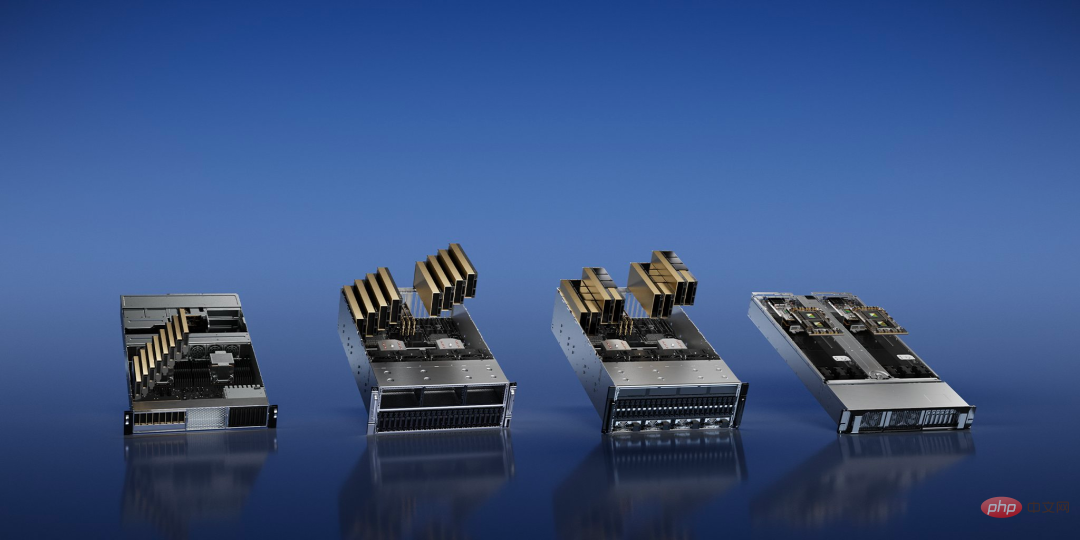

Die Entwicklung generativer KI (AIGC) verändert die Anforderungen von Technologieunternehmen an Rechenleistung. NVIDIA hat vier Inferenzplattformen für KI-Aufgaben gleichzeitig vorgestellt, die alle eine einheitliche Architektur verwenden.

Unter anderem bietet NVIDIA L4 „120-mal höhere KI-gesteuerte Videoleistung als CPU und 99 % Energieeffizienz“, die für Video-Streaming, Kodierung und Dekodierung sowie die Generierung von KI-Videos verwendet werden kann Leistung: Der leistungsstärkere NVIDIA L40 wird speziell für die 2D/3D-Bilderzeugung verwendet.

Als Reaktion auf ChatGPT, das enorme Rechenleistung erfordert, hat NVIDIA NVIDIA H100 NVL herausgebracht, eine dedizierte LLM-Lösung (Large Language Model) mit 94 GB Speicher und beschleunigter Transformer Engine, ausgestattet mit einer PCIE H100-GPU mit Dual-GPU-NVLINK .

„Derzeit ist die einzige GPU, die ChatGPT tatsächlich verarbeiten kann, die NVIDIA HGX A100. Im Vergleich zur ersteren ist ein Standardserver, der mit vier H100-Paaren und Dual-NVLINK ausgestattet ist, jetzt zehnmal schneller und kann große Mengen konvertieren Sprachmodelle Die Verarbeitungskosten werden um eine Größenordnung reduziert“, sagte Huang.

Schließlich gibt es NVIDIA Grace Hopper für Empfehlungsmodelle, das nicht nur für Empfehlungsaufgaben optimiert ist, sondern auch grafische neuronale Netze und Vektordatenbanken betreiben kann.

Lassen Sie Chips physikalische Grenzen durchbrechen

Derzeit stößt der Produktionsprozess von Halbleitern an die Grenzen, die die Physik erreichen kann. Was ist nach dem 2-nm-Prozess der Durchbruch? NVIDIA hat beschlossen, mit der primitivsten Phase der Chipherstellung zu beginnen – der Fotolithographie.

Grundsätzlich handelt es sich hierbei um ein Abbildungsproblem an den Grenzen der Physik. Bei fortschrittlichen Herstellungsprozessen sind viele Merkmale auf dem Chip kleiner als die Wellenlänge des im Druckprozess verwendeten Lichts, und das Design der Maske muss ständig geändert werden, ein Schritt, der als optische Proximity-Korrektur bezeichnet wird. Die Computerlithographie simuliert das Verhalten von Licht, wenn es mit dem Fotolack durch das Original interagiert. Dieses Verhalten wird anhand der Maxwell-Gleichungen beschrieben. Dies ist die rechenintensivste Aufgabe im Bereich Chip-Design und -Herstellung.

Jensen Huang kündigte auf der GTC eine neue Technologie namens CuLitho an, um das Design und die Herstellung von Halbleitern zu beschleunigen. Die Software nutzt Nvidia-Chips, um die Schritte zwischen dem softwarebasierten Chipdesign und der physischen Herstellung der Fotolithographiemasken zu beschleunigen, die zum Drucken des Designs auf den Chip verwendet werden.

CuLitho läuft auf GPUs und bietet 40-fache Leistungssteigerungen gegenüber aktuellen Lithografietechnologien, wodurch umfangreiche Rechenaufgaben beschleunigt werden, die derzeit Dutzende Milliarden CPU-Stunden pro Jahr verbrauchen. „Der Aufbau von H100 erfordert 89 Masken. Bei der Ausführung auf der CPU dauert eine Maske zwei Wochen, wenn H100 jedoch zur Ausführung auf CuLitho verwendet wird, dauert es nur 8 Stunden“, sagte Huang.

Das bedeutet, dass 500 NVIDIA DGX H100-Systeme die Arbeit von 40.000 CPU-Systemen ersetzen und alle Teile des rechnerischen Lithografieprozesses ausführen können, was dazu beiträgt, den Strombedarf und mögliche Auswirkungen auf die Umwelt zu reduzieren.

Dieser Fortschritt wird es ermöglichen, dass die Transistoren und Schaltkreise der Chips kleiner als heute sind, während gleichzeitig die Markteinführungszeit des Chips verkürzt und die Energieeffizienz in den riesigen Rechenzentren verbessert wird, die rund um die Uhr in Betrieb sind, um den Herstellungsprozess voranzutreiben.

Nvidia sagte, dass es mit ASML, Synopsys und TSMC zusammenarbeitet, um die Technologie auf den Markt zu bringen. Berichten zufolge wird TSMC im Juni mit den Vorbereitungen für die Testproduktion dieser Technologie beginnen.

„Die Chipindustrie ist die Grundlage für fast jede andere Industrie auf der Welt“, sagte Huang. „Mit Lithographietechnologie an den Grenzen der Physik können Fabs durch CuLitho und die Zusammenarbeit mit unseren Partnern TSMC, ASML und Synopsys die Produktion steigern, ihren CO2-Fußabdruck reduzieren und den Grundstein für 2 nm und mehr legen.“ Beschleunigtes Quantencomputersystem

Bei der heutigen Veranstaltung kündigte NVIDIA außerdem ein neues System an, das auf Quantenmaschinen basiert und Forschern, die an klassischem Quantencomputing mit hoher Leistung und geringer Latenz arbeiten, eine revolutionäre neue Architektur bietet.

Das Herzstück von DGX Quantum ist ein NVIDIA Grace Hopper-System, das über PCIe mit Quantum Machines OPX+ verbunden ist und eine Latenzzeit von weniger als einer Mikrosekunde zwischen der GPU und der Quantum Processing Unit (QPU) ermöglicht.

Tim Costa, Direktor für HPC und Quanten bei NVIDIA, sagte: „Quantenbeschleunigtes Supercomputing hat das Potenzial, Wissenschaft und Industrie neu zu gestalten, und NVIDIA DGX Quantum wird es Forschern ermöglichen, die Grenzen des klassischen Quantencomputings zu verschieben.“

Ja, deshalb hat NVIDIA die leistungsstarke Hopper-Architektur-GPU mit der neuen Grace-CPU des Unternehmens in „Grace Hopper“ integriert, um Superleistung für riesige KI- und HPC-Anwendungen bereitzustellen. Es bietet eine bis zu 10-fache Leistung für Anwendungen, die Terabytes an Daten verarbeiten, und gibt Forschern der Quantenklassik mehr Möglichkeiten, die komplexesten Probleme der Welt zu lösen.

DGX Quantum stattet Entwickler außerdem mit NVIDIA CUDA Quantum aus, einem leistungsstarken einheitlichen Software-Stack, der jetzt Open Source ist. CUDA Quantum ist eine hybride quantenklassische Computerplattform, die QPUs, GPUs und CPUs in einem System integriert und programmiert.

37.000 US-Dollar pro Monat, um Ihr eigenes ChatGPT auf der Webseite zu trainieren

Microsoft hat Hunderte Millionen Dollar ausgegeben, um Zehntausende A100 zu kaufen, um einen GPT-Supercomputer zu bauen. Vielleicht möchten Sie jetzt OpenAI und Microsoft mieten, um ChatGPT zu trainieren und müssen Sie sollten nach derselben GPU suchen, um Ihr eigenes großes Modell zu trainieren.Die von NVIDIA vorgeschlagene DGX Cloud bietet einen dedizierten NVIDIA DGX AI-Supercomputing-Cluster, gepaart mit NVIDIA AI-Software. Dieser Service ermöglicht jedem Unternehmen den Zugriff auf AI-Supercomputing über einen einfachen Webbrowser, wodurch die Notwendigkeit der Anschaffung, Bereitstellung und Verwaltung entfällt Komplexität der lokalen Infrastruktur.

Berichten zufolge verfügt jede DGX Cloud-Instanz über acht H100- oder A100-80-GB-Tensor-Core-GPUs mit insgesamt 640 GB GPU-Speicher pro Knoten. Eine leistungsstarke Fabric mit geringer Latenz, die mit NVIDIA Networking aufgebaut ist, stellt sicher, dass Arbeitslasten über Cluster miteinander verbundener Systeme skaliert werden können, sodass mehrere Instanzen als eine riesige GPU fungieren können, um die Leistungsanforderungen eines fortgeschrittenen KI-Trainings zu erfüllen.

Jetzt können Unternehmen einen DGX Cloud-Cluster auf monatlicher Basis mieten, um die Entwicklung großer Trainings-Workloads mit mehreren Knoten schnell und einfach zu skalieren, ohne auf beschleunigte Rechenressourcen warten zu müssen, die oft stark nachgefragt werden.

Der monatliche Mietpreis beginnt laut Huang Renxun bei 36.999 US-Dollar pro Instanz und Monat.

„Wir befinden uns im iPhone-Moment der künstlichen Intelligenz“, sagte Huang. „Startups versuchen, bahnbrechende Produkte und Geschäftsmodelle zu entwickeln, und etablierte Unternehmen wollen darauf reagieren. DGX Cloud bietet Kunden sofortigen Zugriff auf NVIDIA-KI-Supercomputing auf globaler Ebene.“ in der Cloud.“

Jetzt können Benutzer NVIDIA NeMo-Sprachdienste und NVIDIA Picasso-Bild-, Video- und 3D-Dienste nutzen, um proprietäre, domänenspezifische generative KI-Anwendungen für intelligente Konversation und Kundensupport, professionelle Inhaltserstellung, digitale Simulation usw. zu erstellen. Unabhängig davon kündigte NVIDIA neue Modelle des Biologie-Cloud-Dienstes NVIDIA BioNeMo an.

„Generative KI ist ein neuer Computertyp, der in natürlicher menschlicher Sprache programmiert werden kann. Diese Fähigkeit ist weitreichend – jeder kann Computer befehlen, Probleme zu lösen, was vor nicht allzu langer Zeit die Domäne von Programmierern war. Patent“, sagte Huang.

Der heutigen Veröffentlichung zufolge verbessert NVIDIA nicht nur kontinuierlich das Hardwaredesign für die KI-Workloads von Technologieunternehmen, sondern schlägt auch neue Geschäftsmodelle vor. In den Augen einiger möchte NVIDIA „TSMC im Bereich KI“ sein: fortschrittliche produktive Gießereidienstleistungen wie eine Waferfabrik bereitstellen und darüber hinaus anderen Unternehmen dabei helfen, KI-Algorithmen für ihre spezifischen Szenarien zu trainieren.

Wird dies die zukünftige Richtung der KI-Entwicklung sein, indem wir das Supercomputer-Training von NVIDIA nutzen, um die Notwendigkeit von Zwischenhändlern, die den Preisunterschied verdienen, direkt zu eliminieren?

Das obige ist der detaillierte Inhalt vonNVIDIA veröffentlicht eine dedizierte ChatGPT-GPU, die die Inferenzgeschwindigkeit um das Zehnfache erhöht. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr