Heim >Technologie-Peripheriegeräte >KI >Ist Transformers bahnbrechendes Papier schockierend? Das Bild stimmt nicht mit dem Code überein und der mysteriöse Fehler macht mich dumm

Ist Transformers bahnbrechendes Papier schockierend? Das Bild stimmt nicht mit dem Code überein und der mysteriöse Fehler macht mich dumm

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-05-11 12:46:131554Durchsuche

Heute wurde der KI-Kreis von einem schockierenden „Umsturz“ schockiert.

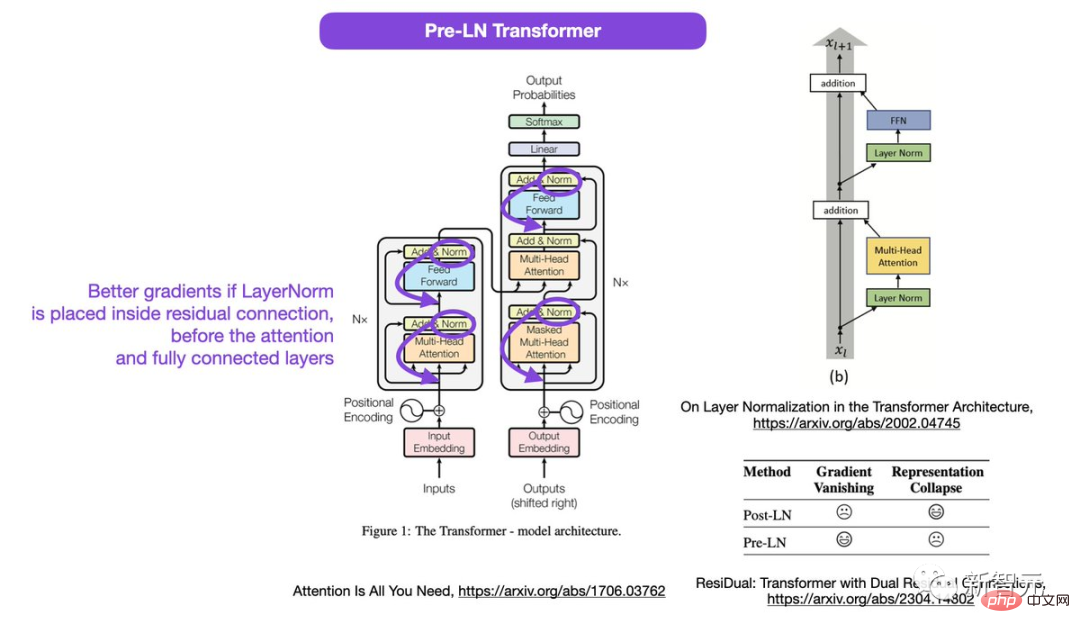

Das Diagramm in „Attention Is All Your Need“, der NLP-Grundlagenarbeit von Google Brain und Urheber der Transformer-Architektur, wurde von Internetnutzern herausgenommen und mit dem Code zusammengeführt . Inkonsistent.

Papieradresse: https://arxiv.org /abs/1706.03762

Seit seiner Einführung im Jahr 2017 hat sich Transformer zum Eckpfeiler im KI-Bereich entwickelt. Sogar der wahre Mastermind hinter dem beliebten ChatGPT ist er.

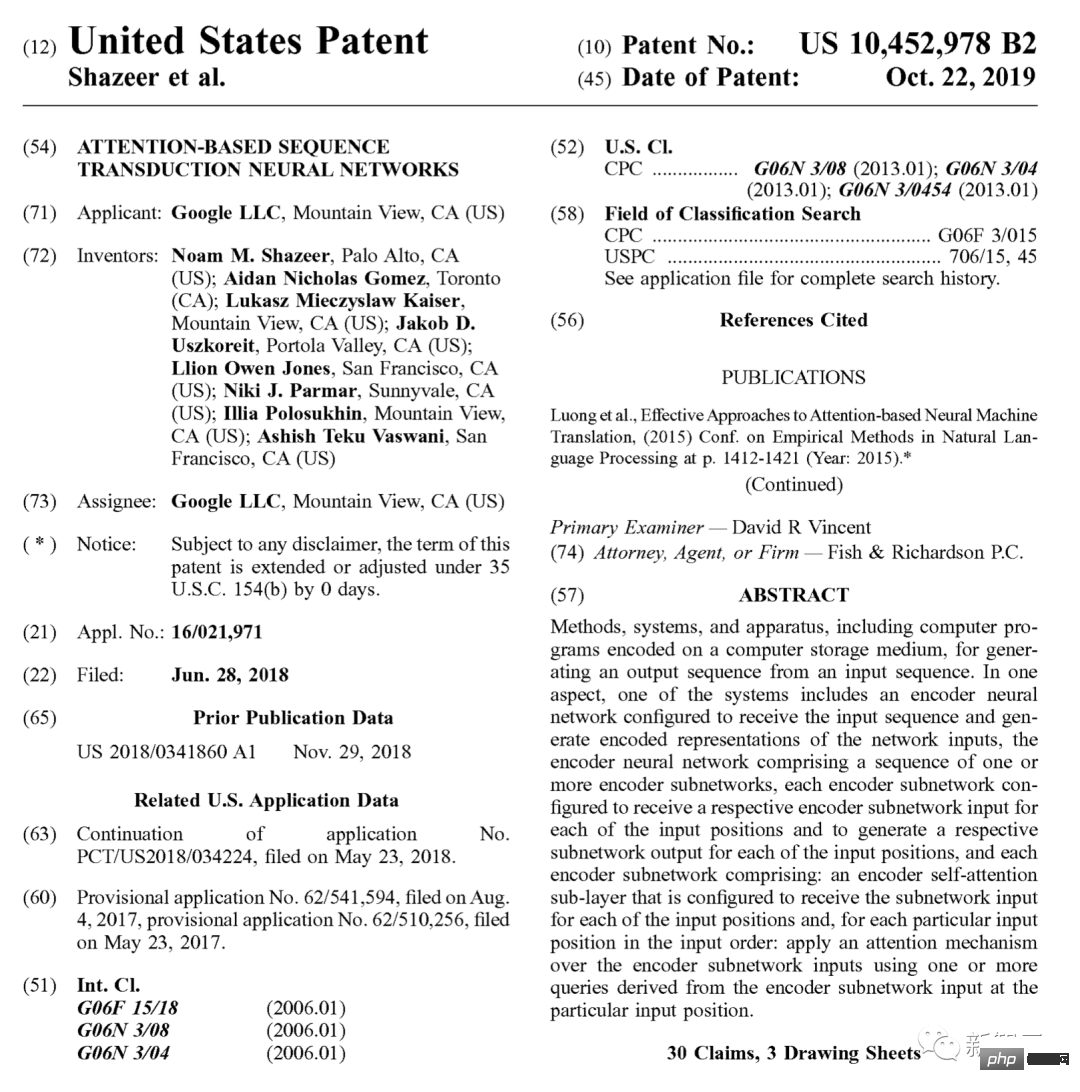

Auch Google hat 2019 eigens dafür ein Patent angemeldet.

geht auf den Ursprung zurück, und nun verschiedene GPTs (Generative Pre- gelernter Transformer), alle stammen aus dieser 17-jährigen Arbeit.

Laut Google Scholar wurde dieses grundlegende Werk bisher mehr als 70.000 Mal zitiert.

Der Grundstein von ChatGPT ist also nicht stabil?

Als „Urheber“ des Papiers ist das Strukturdiagramm tatsächlich falsch?

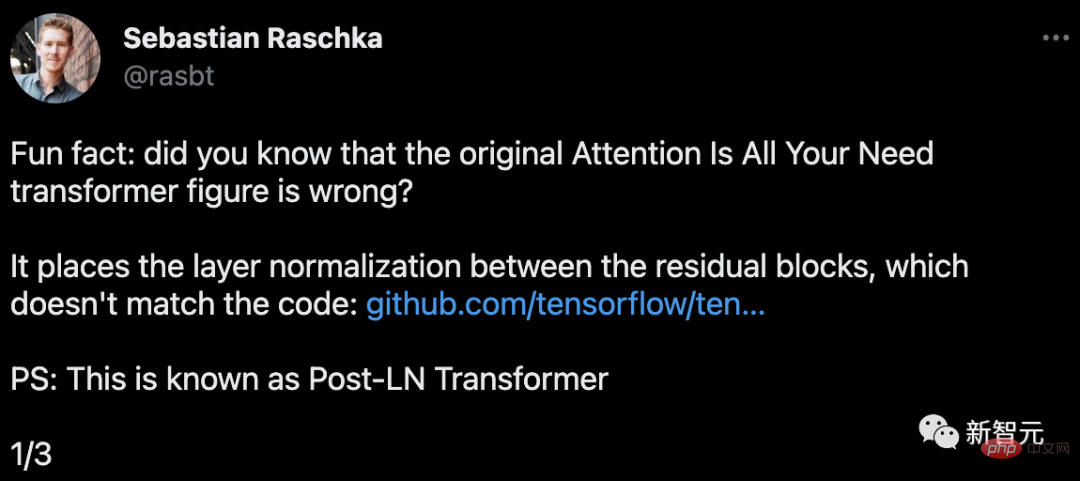

Sebastian Raschka, Gründer von Lightning AI und Forscher für maschinelles Lernen, hat herausgefunden, dass das Transformer-Diagramm in diesem Artikel falsch ist.

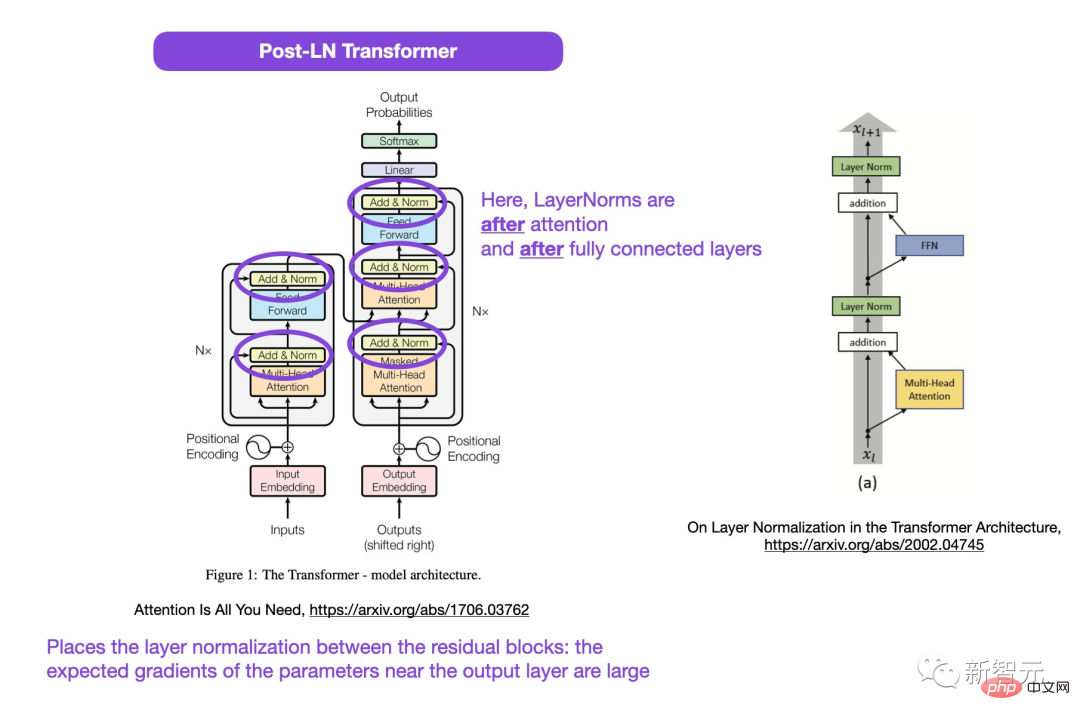

Der im Bild eingekreiste Bereich, LayerNorms, liegt hinter der Aufmerksamkeits- und vollständig verbundenen Ebene. Die Platzierung der Schichtnormalisierung zwischen Restblöcken führt zu großen erwarteten Gradienten für Parameter in der Nähe der Ausgabeschicht.

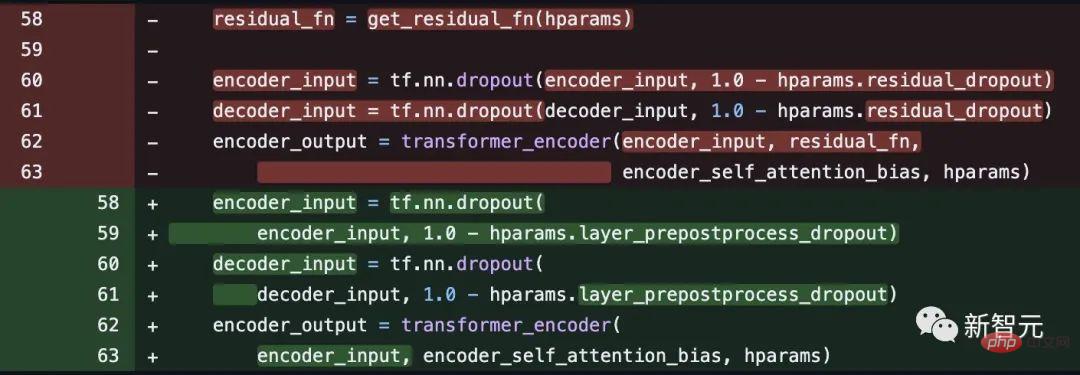

Außerdem steht dies im Widerspruch zum Code.

Codeadresse: https://github.com/tensorflow/tensor2tensor/commit/f5c9b17e617ea9179b7d84d36b1e8162cb369f25#diff-76e2b94ef16871bdbf46bf04dfe7f147 7bafb884748f08197c9cf1b10a4dd78e

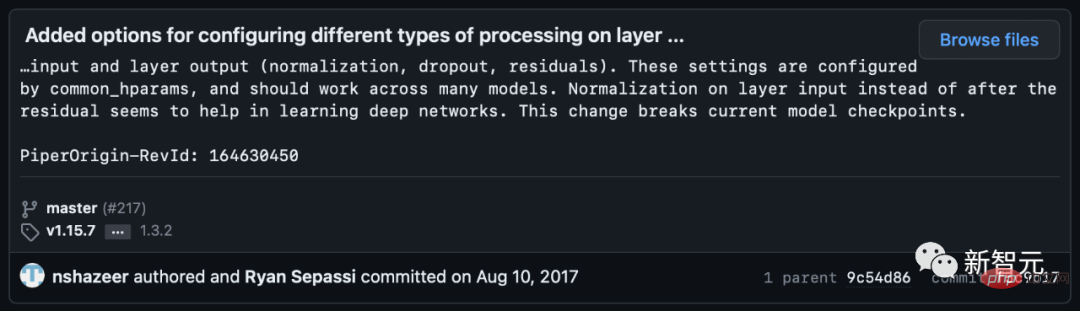

# 🎜 🎜# Einige Internetnutzer wiesen jedoch darauf hin, dass Noam Shazeer den Code einige Wochen später korrigierte.

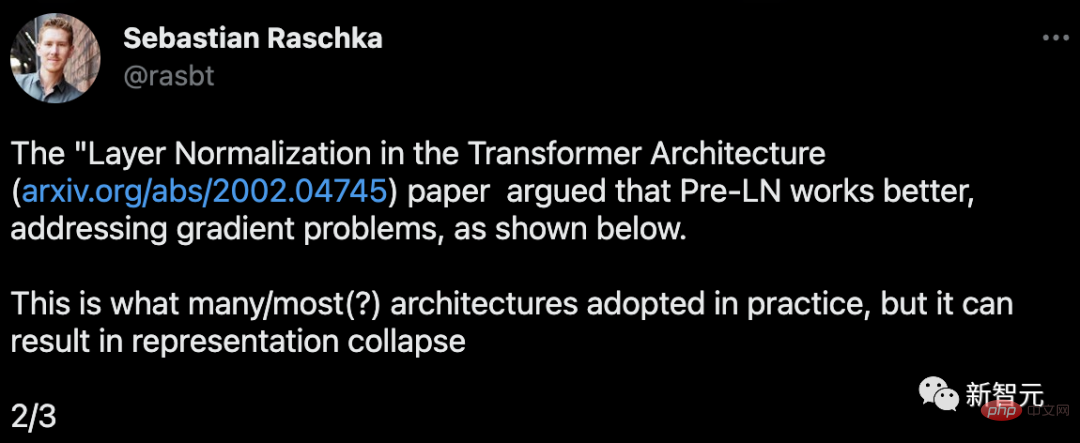

Dies ist, was viele oder die meisten Architekturen in der Praxis übernehmen, aber es kann zu einem Zusammenbruch der Repräsentation führen.

Wenn die Ebenennormalisierung in der Restverbindung vor den Aufmerksamkeits- und vollständig verbundenen Ebenen platziert wird, werden bessere Farbverläufe erzielt.

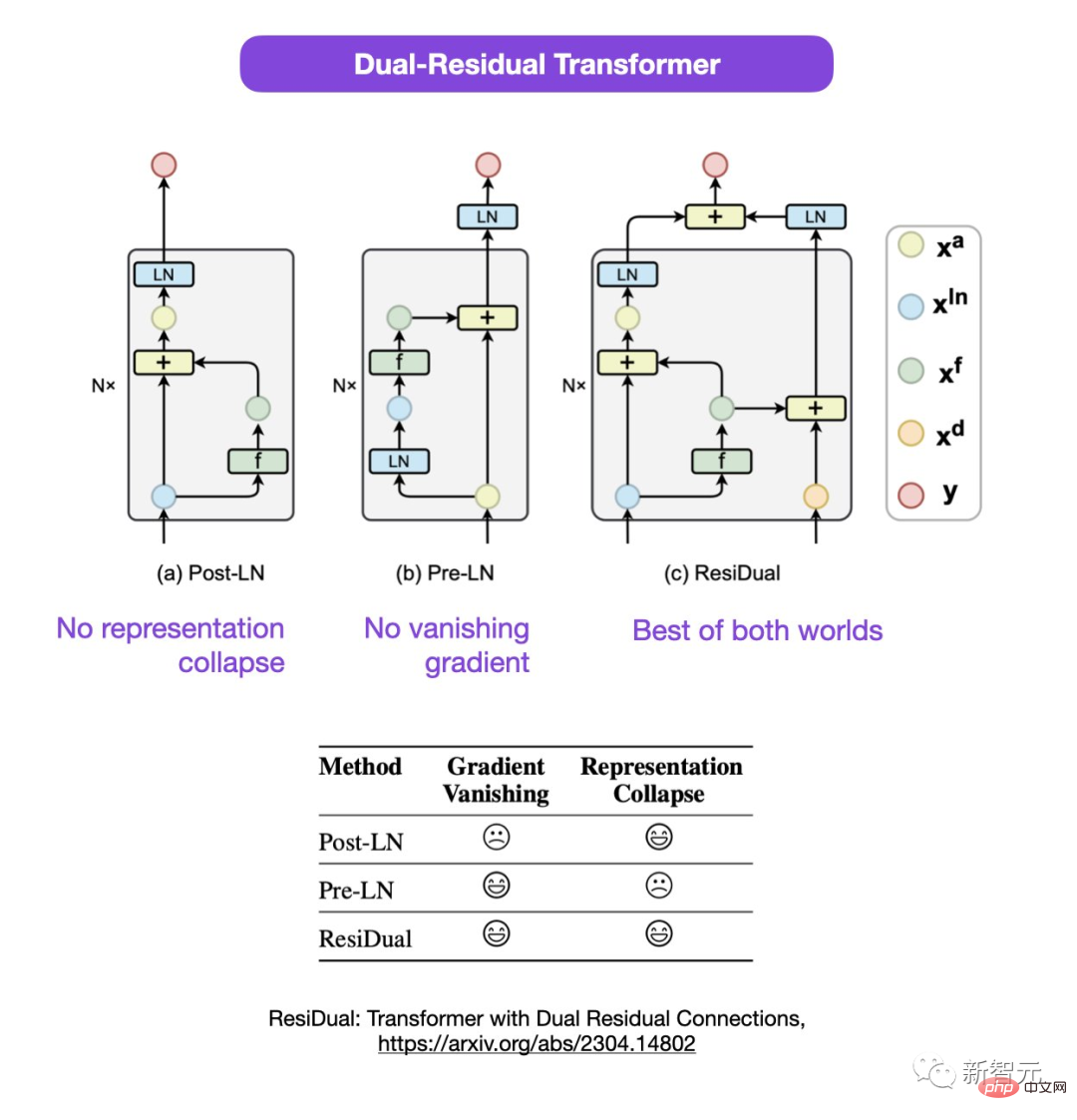

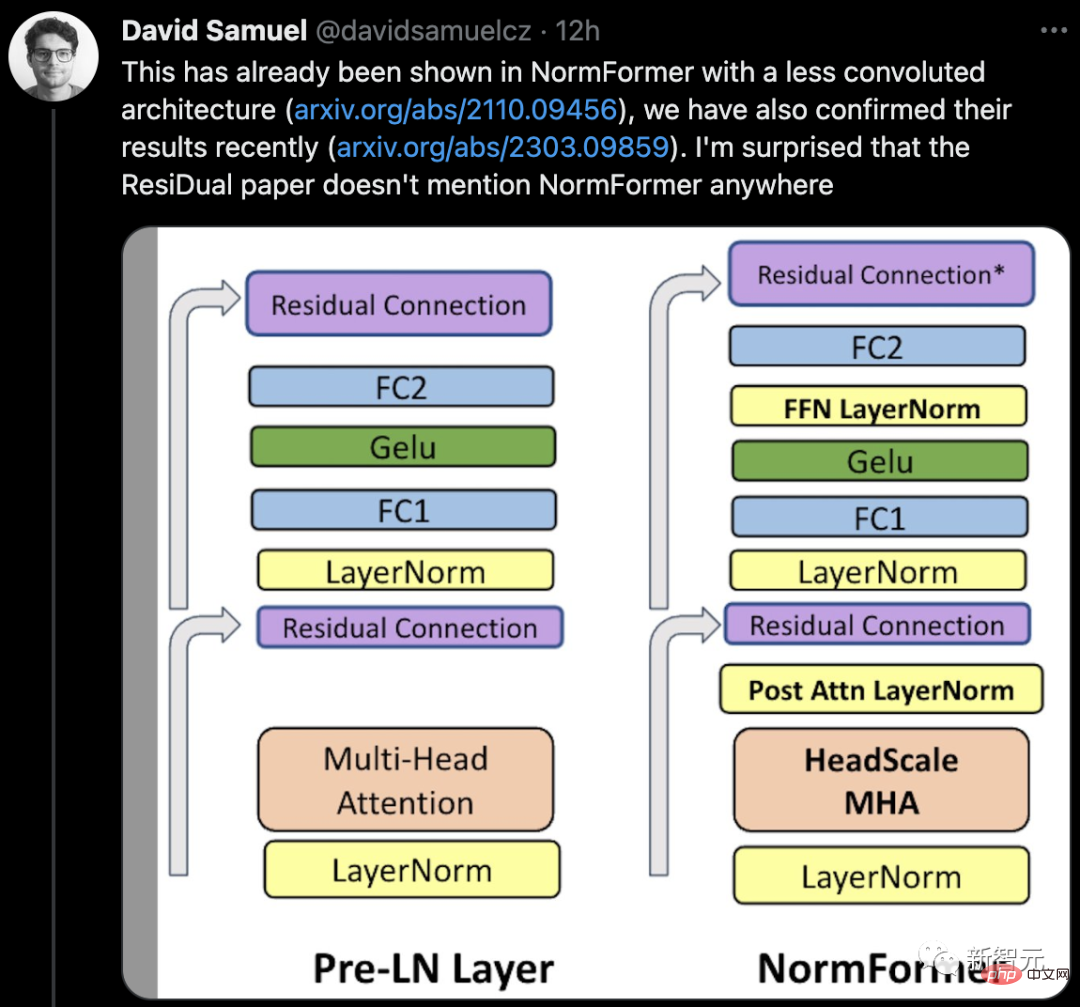

Sebastian schlug vor, dass die Diskussion über die Verwendung von Post-LN oder Pre-LN zwar noch andauert, es aber auch einen neuen Artikel gibt, der vorschlägt, beide zu kombinieren.

Papieradresse: https://arxiv.org/abs/2304.14802

In diesem doppelten Resttransformator werden die Probleme des Darstellungskollapses und des Gradientenverschwindens gelöst.

Heiße Netizen-Diskussion

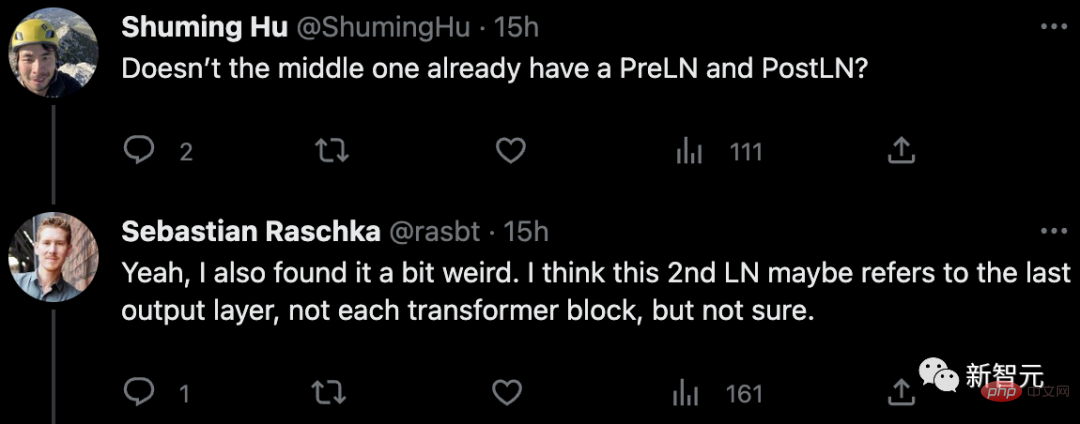

Als Antwort auf Die Zeitung In Bezug auf Zweifel wiesen einige Internetnutzer darauf hin: Gibt es nicht bereits PreLN und PostLN in der Mitte?

Sebastian antwortete, dass er sich auch etwas seltsam fühle. Vielleicht bezieht sich 2. LN eher auf die letzte Ausgangsschicht als auf jeden Transformatorblock, aber auch da ist er sich nicht sicher.

Einige Internetnutzer sagten: „Wir stoßen oft auf Inkonsistenzen mit dem Code oder den Ergebnissen.“ . Die meisten davon sind Fehler, aber manchmal ist es seltsam, dass diese Art von Frage noch nie aufgeworfen wurde #

# 🎜 🎜# Also, gibt es wirklich eine Lücke in dem Papier oder handelt es sich um einen eigenen Vorfall?

Also, gibt es wirklich eine Lücke in dem Papier oder handelt es sich um einen eigenen Vorfall?

Lasst uns abwarten, was als nächstes passiert.

Das obige ist der detaillierte Inhalt vonIst Transformers bahnbrechendes Papier schockierend? Das Bild stimmt nicht mit dem Code überein und der mysteriöse Fehler macht mich dumm. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr