Heim >Technologie-Peripheriegeräte >KI >Kritisieren Sie nicht nur Google Bard, auch Microsofts neues Bing powered by ChatGPT weist häufig Fehler auf

Kritisieren Sie nicht nur Google Bard, auch Microsofts neues Bing powered by ChatGPT weist häufig Fehler auf

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-05-10 11:07:071563Durchsuche

Am 8. Februar um 8:30 EST findet die Google-Pressekonferenz in Paris statt. Am Tag zuvor stellte Microsoft offiziell New Bing vor, eine neue Generation von KI-gesteuerten Suchmaschinen, die das generative Modell basierend auf der ChatGPT-Technologie in Bing integrieren. Microsoft-Vizepräsident Yusuf Mehdi lieferte eine perfekte Demonstration[0] und der Marktwert von Microsoft stieg an diesem Tag um 80 Milliarden US-Dollar. Sogar in China, wo OpenAI nicht zur Registrierung geöffnet ist, verbreiten sich Clips von Yusuf, die zeigen, wie das generative Modell das Erlebnis der Bing-Suchmaschine und des Edge-Browsers verbessern kann, in Moments- und WeChat-Gruppen viral. Was für Sie Honig ist, ist für andere Arsen. Jeder wartet darauf, wie der Suchriese Google reagiert.

Auf der Google-Pressekonferenz warteten alle auf den Auftritt von Bard, dem legendären Rivalen von New Bing. Als großes Sprachmodell, das von der Google-Suchmaschine unterstützt wird, ist jeder voller Tagträume über Bard. Allerdings gab es auf der Pressekonferenz nicht viel über Bard. Also richteten alle ihre Aufmerksamkeit auf das von Google auf Twitter gepostete Video von Bard. Nachdem sie es sorgfältig aufgegriffen hatten, stellten alle plötzlich fest, dass Bard bei der Beantwortung von Fragen sachliche Fehler gemacht hatte.

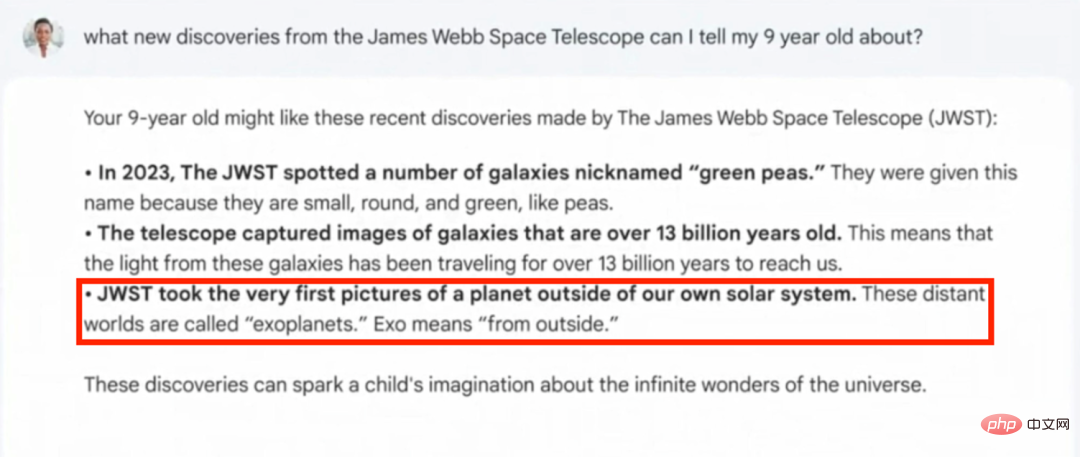

Auf die Frage: „Was kann ich meinem neunjährigen Kind über die neuen Entdeckungen des James Webb Telescope erzählen?“ antwortete Bard: „Das erste Foto eines Exoplaneten wurde vom James Webb Telescope aufgenommen.“ Aber die Tatsache wurde 2004 vom Very Large Telescope des European Southern Observatory aufgenommen, 18 Jahre vor dem Start des James Webb Telescope. Dieser Fehler wurde zum Auslöser dafür, dass der Aktienkurs von Google an diesem Tag einbrach.

Abbildung 1 Screenshot von Bards Demonstration am James Webb Telescope

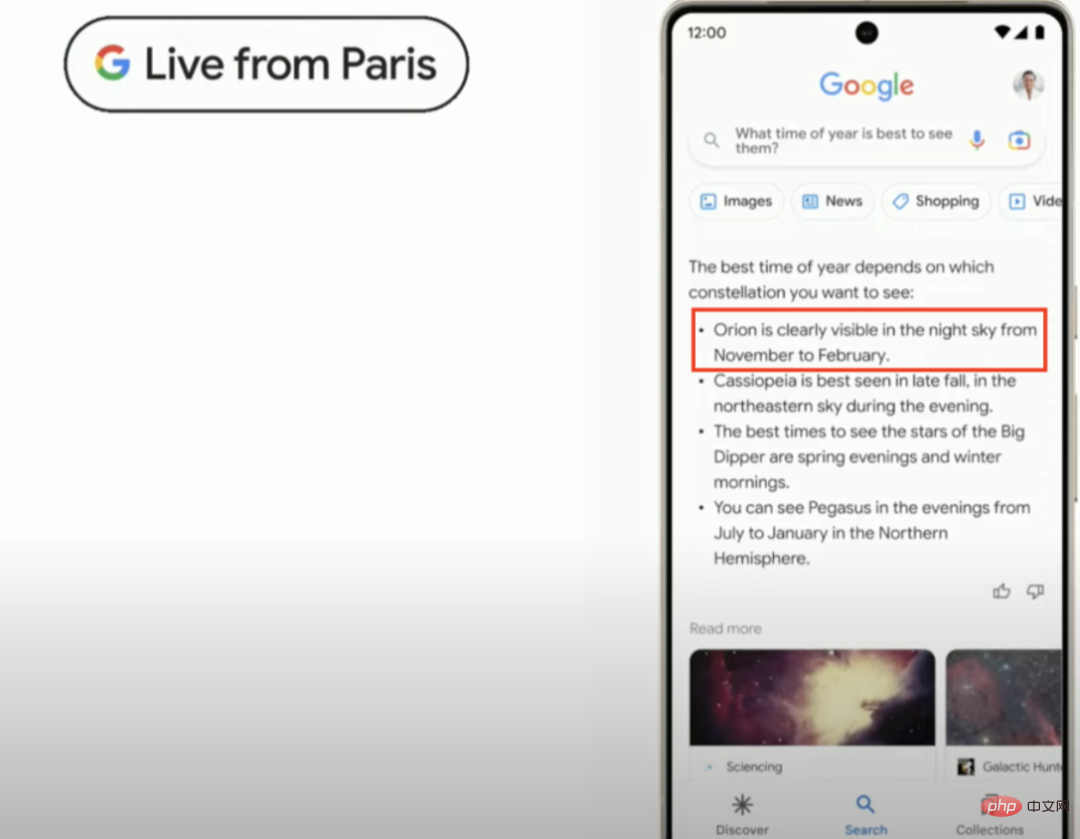

Auf der Pariser Pressekonferenz war Bards Vortrag zwar nur etwa 4 Minuten lang, sein Vortrag über die beste Beobachtungszeit von Die Konstellationen Es gibt auch offensichtliche sachliche Verzerrungen in den Antworten. Wie unten gezeigt, erwähnte Bard in seiner Antwort, dass die beste Zeit zur Beobachtung des Orion von November bis Februar sei.

Laut verschiedenen Informationsquellen ist die beste Beobachtungszeit für Orion unterschiedlich, aber sie alle zeigen es deutlich an dass die beste Zeit die beste ist. Der Beobachtungszeitraum beginnt jedes Jahr im Januar. Die Edtech-Website BYJU'S gibt die beste Zeit von Januar bis März an [1] und Wikipedia gibt die beste Zeit von Januar bis April an [2].

Abbildung 3 BYJUS Antwort zur besten Beobachtungszeit für Orion

Aufgrund der Lücke zwischen der Pressekonferenz von Bard und der Pressekonferenz von New Bing und der Enthüllung der Fakten aufgrund von Fälligkeit Aufgrund eines sexuellen Fehlers sank der Marktwert von Google an diesem Tag um fast 100 Milliarden US-Dollar und Bard wurde als die teuerste Konferenz der Geschichte bezeichnet. Wir kommen nicht umhin, uns zu fragen, ob in New Bings scheinbar perfekter Pressekonferenz irgendwelche sachlichen Fehler verborgen sind?

Faktische Fehler von New Bing

Wir haben festgestellt, dass die von New Bing generierten Inhalte viele sachliche Fehler enthielten, darunter Informationen zur Identität von Prominenten, Zahlen zu Finanzberichten, Öffnungszeiten von Nachtclubs usw.

Klassifizierung sachlicher Fehler in generativen Modellen

Für generative Modelle, die durch die GPT-Serie (einschließlich ChatGPT, InstructGPT usw.) und T5 dargestellt werden, können sachliche Fehler grob in die folgenden zwei Kategorien unterteilt werden:

- Der generierte Inhalt steht in Konflikt mit dem referenzierten Inhalt. Da die Sequenz während des Inhaltsgenerierungsprozesses zunimmt, neigen große Sprachmodelle dazu, vom Referenzinhalt abzuweichen, was dazu führt, dass der Originaltext hinzugefügt, gelöscht oder manipuliert wird.

- Der generierte Inhalt entbehrt jeder sachlichen Grundlage. Solche Fehler sind einfach Unsinn. Wenn Sie sich ohne sachliche Anleitung ausschließlich auf die beim Vortraining des Modells gespeicherten Informationen verlassen, kann das Modell während des Generierungsprozesses leicht verwirrt werden. Es besteht eine hohe Wahrscheinlichkeit, dass Inhalte generiert werden, die nicht den Tatsachen entsprechen oder für die Sache irrelevant sind.

Jetzt schauen wir uns die in der New Bing-Konferenz [3] und der New Bing-Demo [4] gezeigten Beispiele an, um zu sehen, ob es sachliche Fehler gibt und um welche Arten es sich handelt. Der Einfachheit halber bezeichnen wir New Bing und das in Edge integrierte New Bing-Plug-in als New Bing.

Fehler am Beispiel japanischer Dichter

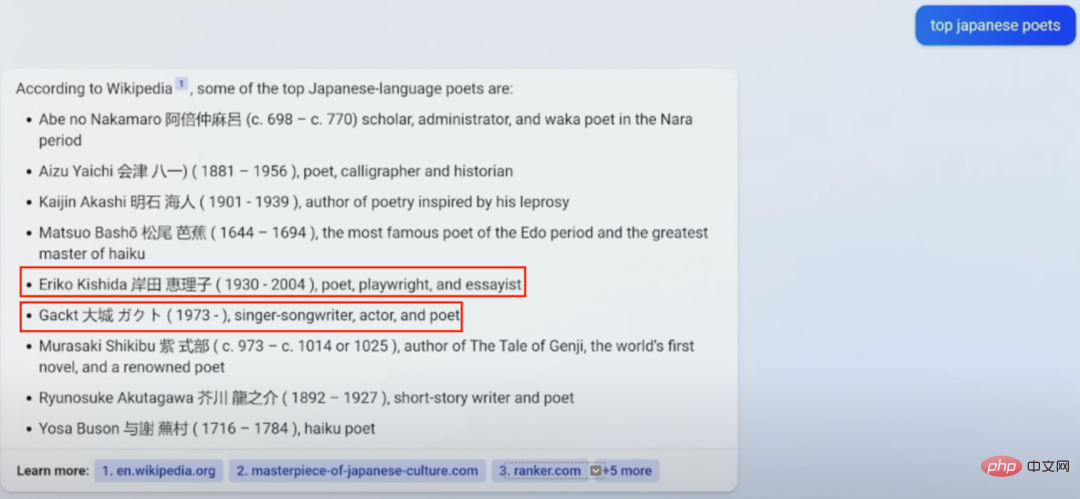

Als New Bing bei 29:57 im Video der New Bing-Pressekonferenz nach berühmten japanischen Dichtern gefragt wurde, lautete die Antwort: „Eriko Kishida Kishida Eriko (1930). - 2004), Dichter, Dramatiker und Essayist.

Allerdings ist nach den Angaben von Wikipedia und IMDB [5, 6, 7] die Geburt Das Todesjahr von Eriko Kishida ist 1929 bzw. 2011. Dabei ist sie keine Dramatikerin oder Essayistin, sondern Dichterin, Übersetzerin und Märchenautorin. Kishidas Familie kann möglicherweise nicht akzeptieren, dass er nach New Bing verlegt wurde und acht Jahre seines Lebens verloren hat. Gleichzeitig wurde leider auch Mitschüler Gackt versetzt. Nach Angaben von Wikipedia [8] spielte Gackt Musik, sang, komponierte und schauspielerte, schrieb jedoch nie Gedichte.

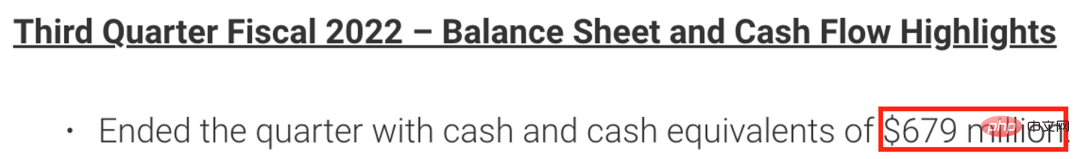

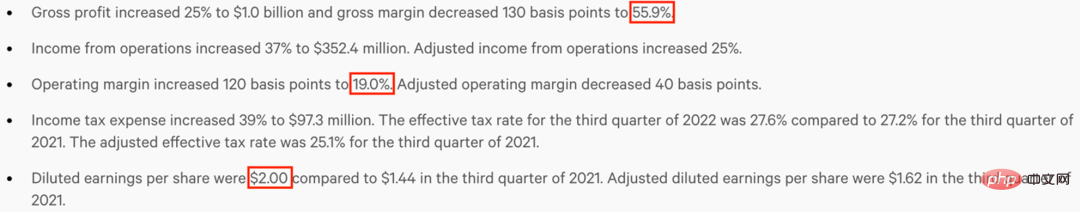

Fehler in Finanzberichtsbeispielen

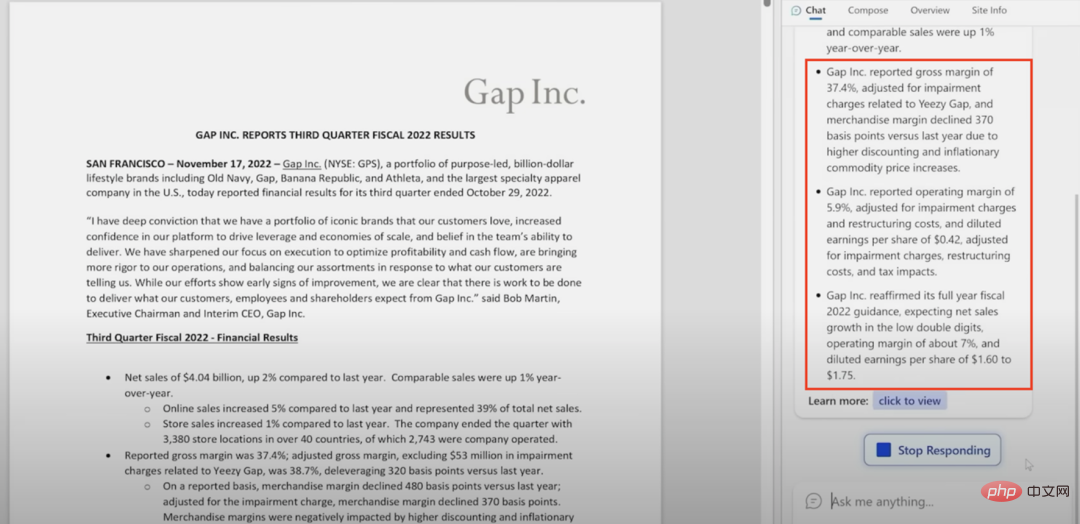

Bei 35:49 im New Bing-Konferenzvideo zeigte Yusuf, dass der in New Bing integrierte Edge-Browser das dritte Quartal 2022 für das Bekleidungsunternehmen Gap generierte Kernpunkte für vierteljährliche Finanzberichte. Auf den ersten Blick ist die Zusammenfassung von New Bing sehr praktisch. Sie zeigt die wichtigsten Punkte von Gap's Bericht zum dritten Quartal und könnte „schockiert“ sein, wenn er dies sieht. Als wir jedoch Gaps Bericht zum dritten Quartal 2022 [9] fanden und sorgfältig lasen, stellten wir fest, dass die Zusammenfassung von New Bing voller Fehler und Auslassungen war, was unerträglich war.

Abbildung 7 Screenshot des Finanzberichts 2022 von Gap für das dritte Quartal

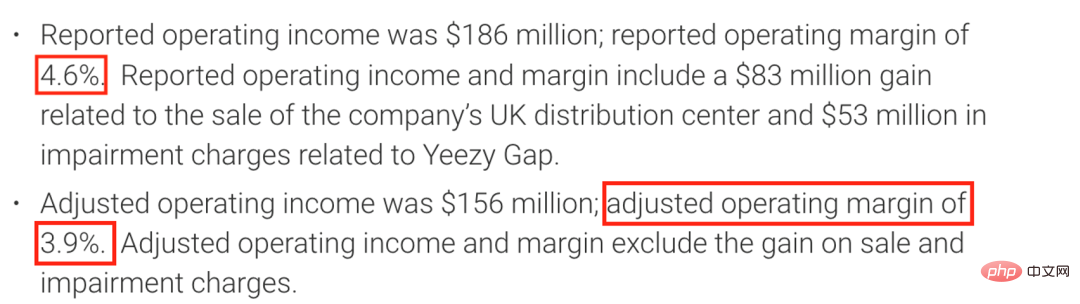

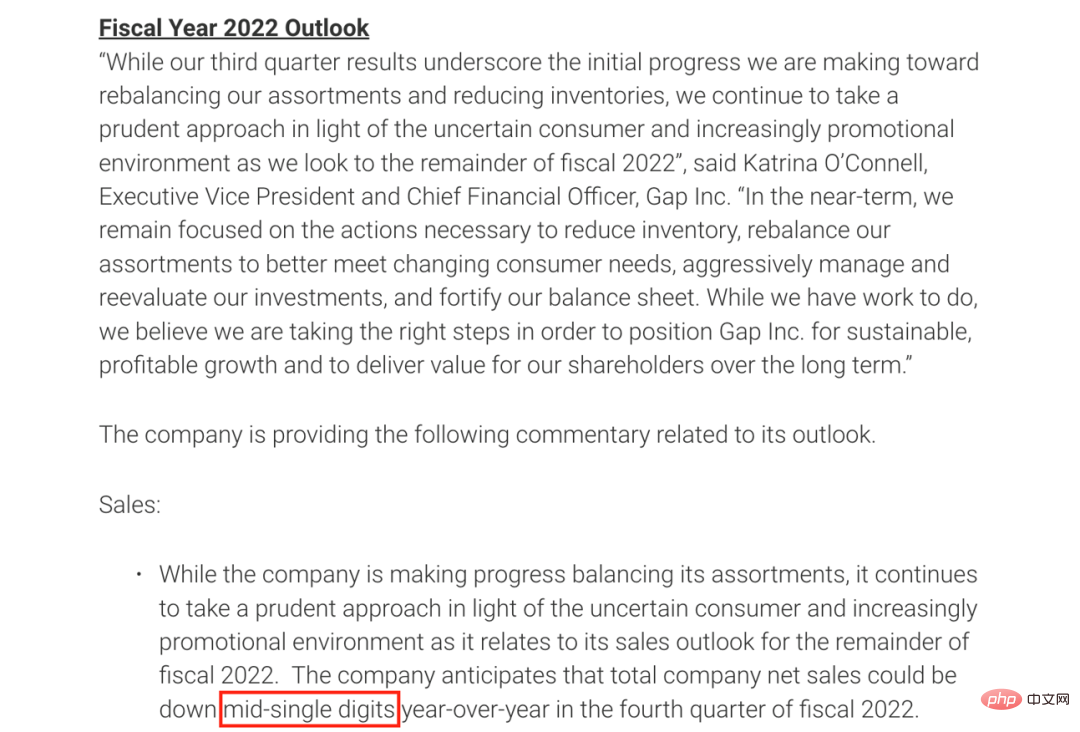

Sogar New Bing gab die Umsatzprognose von Gap für das Gesamtjahr als „die Wachstumsrate des Nettoumsatzes wird voraussichtlich im niedrigen zweistelligen Bereich liegen“, tatsächlich wird sie jedoch „im Jahr wahrscheinlich im mittleren einstelligen Bereich zurückgehen“. das vierte Viertel. Es handelt sich eher um einen Rückgang als um einen Anstieg. Der Unterschied zwischen den beiden Wörtern wird das Anlageverhalten der Nutzer ernsthaft irreführen. New Bing kam sogar aus dem Nichts und gab weitere Finanzprognosen für das Gesamtjahr ab: „Der Bruttogewinn liegt bei 7 % und der verwässerte Gewinn pro Aktie liegt zwischen 1,6 und 1,75 US-Dollar.“ Diese Zahlen wurden im Finanzbericht von Gap für das dritte Quartal nicht erwähnt . #🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜##Abbildung 8 Lücke 2022 Screenshot von der Finanzbericht für das dritte Quartal

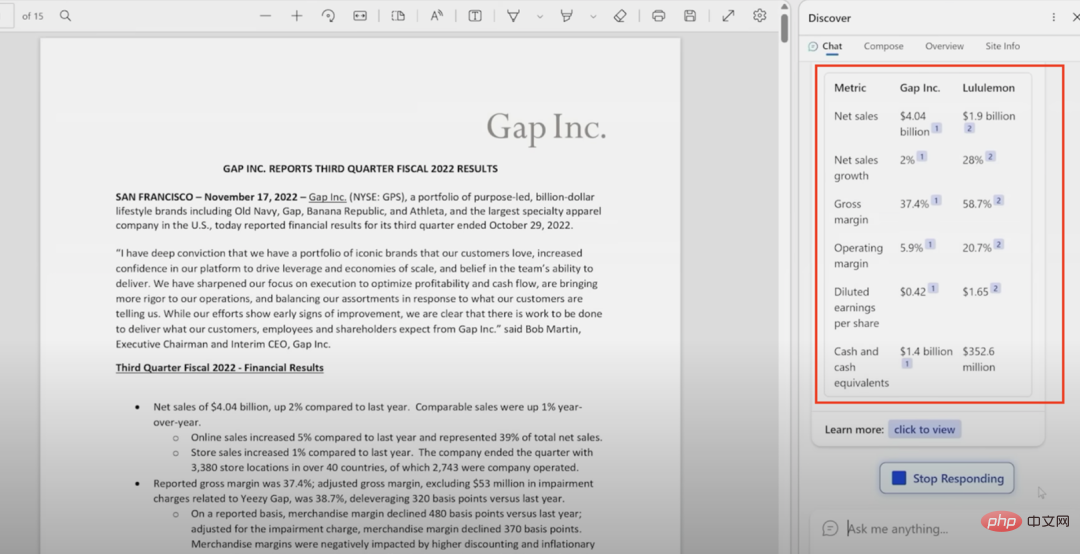

Abbildung 9 New Bing vs Gap Vergleichsfunktion mit dem Finanzbericht von Lululemon

Abbildung 10 Lululemon. 202 2 Nr. Screenshot des Finanzberichts für das dritte Quartal

Die gleiche Situation zeigt sich auch in den Lululemon-Daten von New Bing. Laut Daten aus Lululemons Bericht zum dritten Quartal 2022 [10] gab New Bing die Bruttogewinnmarge von Lululemon mit 58,7 % an, was eigentlich 55,9 % betragen sollte. New Bing nennt die Betriebsbruttomarge von Lululemon mit 20,6 %, was eigentlich 19,0 % betragen sollte. New Bing beziffert den verwässerten Gewinn je Aktie von Lululemon auf 1,65 US-Dollar, was eigentlich 2,00 US-Dollar betragen sollte.

Abbildung 11 Lululemon. 202 2 Nr. Screenshot des Finanzberichts für das dritte Quartal

Eine vernünftige Schlussfolgerung ist, dass die generierten fehlerhaften Daten wahrscheinlich aus den Finanzberichtsanalysedaten stammen, die während der Vortrainingsphase gesehen wurden. Bei der Generierung groß angelegter Sprachmodelle wie ChatGPT gilt: Je länger die generierte Sequenz, desto einfacher wird es, sich von den gegebenen Finanzberichtsdaten von Gap und Lululemon zu lösen, sich gehen zu lassen und irrelevante falsche Informationen zu generieren.

Fehler im Nachtclub-Beispielim neuen Bing-Startvideo Bei 29:17 lieferte New Bing „unkonstruktive“ Vorschläge zur Bereicherung des Nachtlebens von Touristen in Mexiko-Stadt. Für mehrere der empfohlenen Nachtclubs, wie den Primer Nivel Night Club, El Almacen und El Marra, erwähnte New Bing, dass diese Bars keine Kundenbewertungen, keine Kontaktinformationen und keine Ladenvorstellung haben. Diese Informationen finden Sie jedoch auf Google Maps oder auf der Facebook-Seite des Geschäfts. Es scheint, dass das Surfen in New Bing nicht genug ist

. Die Geschäftszeiten von El Almacen in New Bing sind dienstags bis sonntags von 17:00 bis 23:00 Uhr, die tatsächlichen Geschäftszeiten sind jedoch außer montags 19:00 bis 3:00 Uhr[11]. Dadurch bleiben Touristen, die um fünf Uhr zum Abendessen gehen, zwei Stunden lang hungrig. Guadalajara de Noche hingegen ist täglich von 17:30 Uhr bis 13:30 Uhr bzw. 12:30 Uhr geöffnet [12], während die von New Bing angegebenen Geschäftszeiten ab 20:00 Uhr gelten. Offenbar verlassen sich Touristen auf die Empfehlungen von New Bing, um Restaurants zu finden, und ob sie eine Mahlzeit bekommen, hängt von ihrem Glück ab.

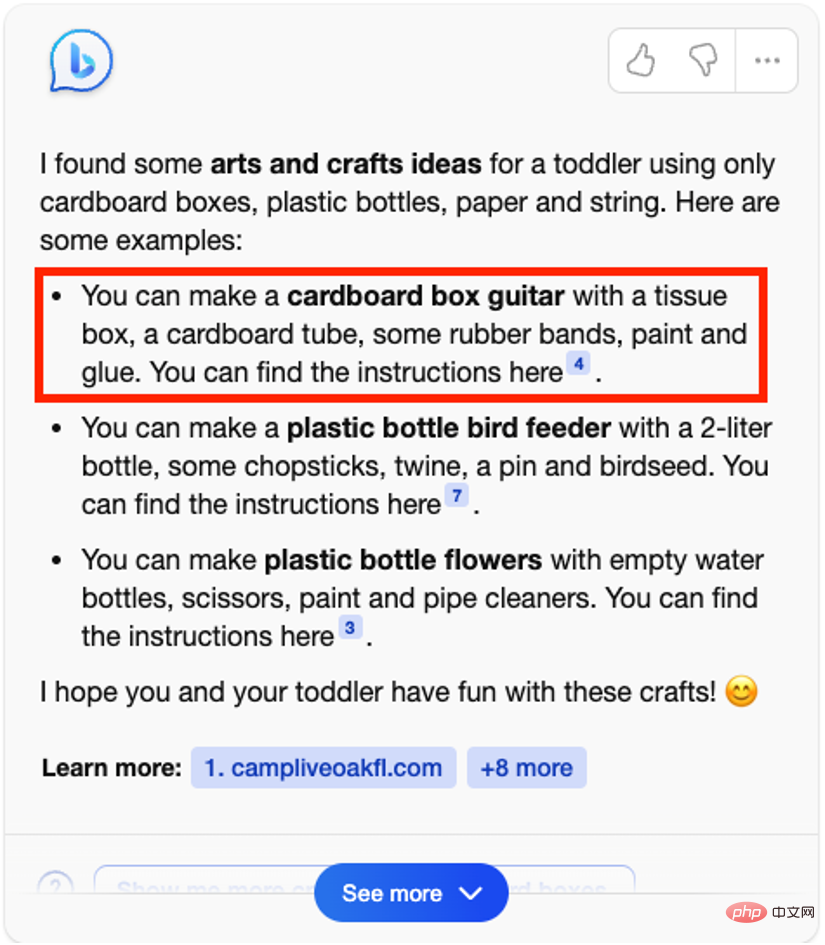

Abbildung 12 Screenshot des Nachtclub-Beispiels in der New Bing-Demo 🎜🎜#Andere Fehler Produktpreisfehler, Filialadressenfehler, Zeitfehler #🎜 🎜# usw. Da New Bing noch nicht vollständig geöffnet ist, können wir die Pressekonferenz nicht direkt in den Suchergebnissen von New Bing abrufen , aber Microsoft stellt den Benutzern mehrere Beispieldemonstrationen [13] zur Verfügung. Im Sinne der Suche nach Antworten haben wir diese Demonstrationen auch zum Studium unter die Lupe genommen. Wir haben festgestellt, dass selbst in diesen sorgfältig ausgewählten Beispielen immer noch viele falsche Botschaften enthalten sind. In „Welche Kunstideen kann ich mit meinem Kind machen?“ gibt New Bing viele Anregungen zum Basteln. Für jedes Handwerk fasst New Bing die für die Herstellung benötigten Materialien zusammen. Allerdings ist die Zusammenfassung der Materialien für jedes Handwerk unvollständig. New Bing fasst beispielsweise auf der zitierten Website [14] zusammen, dass für die Herstellung einer Papiergitarre Pappkartons, Gummibänder, Farbe und Kleber erforderlich sind. Aber die im Zitat erwähnte Schwammbürste, das Klebeband und die Holzperlen wurden weggelassen. Abbildung 13 Neue Bing-Beispieldemonstration „Welche Bastelarbeiten kann ich mit meinen Kindern machen?“ 🎜# Abbildung 14 Screenshot der Materialien, die zur Herstellung einer Papiergitarre von der zitierten Website benötigt werden #🎜 🎜#Es gibt auch einen sehr offensichtlichen und häufigen Fehler in der Beispieldemonstration von New Bing, Das heißt, der angegebene Referenzlink hat nichts mit dem zu tun generierte Inhalte, die völlig falsch sind #🎜🎜 #.

Zum Beispiel erscheint im folgenden Beispiel von „Ich brauche ein großes, schnelles Auto“ der 2022 Kia Telluride nicht in der angegebenen Zitierung 10 [15]. Gleichzeitig ist das Problem der „Zeitreise“ in diesem Beispiel immer noch unvermeidlich. Bing behauptete, dass die 2022-Version des Kia Telluride den Preis für das Weltauto des Jahres 2020 gewonnen habe in diesem Jahr. Der Gewinner des World Car of the Year Award 2022 ist der Hyundai IONIQ 5, und auch das Zitat 7 [16] ist ein Artikel, der nichts mit dem „2020 World Car of the Year Award“ zu tun hat. Wir haben in allen Instanzdemos bis zu 21 ähnliche Fehler gefunden. Abbildung 15 Neues Bing-Demo-Beispiel „Ich brauche einen großen Schnellzug“ Screenshot Zusammenfassung: Das Finden von Fehlern wird uns voranbringen#🎜🎜 #

Aus der obigen Analyse geht hervor, dass ihre Antworten unabhängig davon, ob es sich um New Bing oder Bard handelt, anfällig für sachliche Fehler sind. Wenn die ganze Welt von den Fähigkeiten groß angelegter Sprachmodelle wie ChatGPT begeistert ist und wenn ChatGPT die schnellste Anwendung in der Geschichte wird, die 100 Millionen Benutzer erreicht, jubeln wir einerseits über den Fortschritt der KI, andererseits aber auch Andererseits müssen wir auch in Ruhe darüber nachdenken, wie wir die vielen Probleme lösen können, die die KI derzeit hat.

Allerdings Wenn wir zulassen, dass KI eine große Menge unwahrer Informationen generiert, wird es nicht lange dauern, bis das Vertrauen der Öffentlichkeit in KI zerstört wird und alle Arten von falschen Informationen das Internet überschwemmen. Wir weisen auf die Fehler großer Modelle hin, kein Unternehmen oder Modell zu kritisieren. Im Gegenteil, wir wollen KI besser machen.

Wie der argentinische Dichter Borges einmal sagte: Jedes Schicksal, egal wie kompliziert und langwierig, spiegelt sich eigentlich nur in einem Moment wider, nämlich in dem Moment, in dem die Menschen völlig erkennen, wer sie sind. Wenn große Modelle wie ChatGPT bereits über mit Menschen vergleichbare Schreibfähigkeiten verfügen, wissen wir ganz klar, dass der nächste Schritt darin besteht, reales Wissen vollständiger und genauer in große Modelle zu integrieren, damit KI-Modelle sicher, zuverlässig und umfassend angewendet werden können Alltag der Menschen. Noch nie haben wir uns so sehr auf diesen Moment gefreut und noch nie waren wir diesem Moment so nahe.

Das obige ist der detaillierte Inhalt vonKritisieren Sie nicht nur Google Bard, auch Microsofts neues Bing powered by ChatGPT weist häufig Fehler auf. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr