Heim >Technologie-Peripheriegeräte >KI >Beschleunigung der Entwicklung und Verifizierung autonomer Fahrzeuge: Ein genauerer Blick auf die synthetische Datengenerierungstechnologie DRIVE Replicator

Beschleunigung der Entwicklung und Verifizierung autonomer Fahrzeuge: Ein genauerer Blick auf die synthetische Datengenerierungstechnologie DRIVE Replicator

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-05-07 16:40:091519Durchsuche

Auf der GTC-Konferenz im September gab NVIDIA-Produktmanager Gautham Sholingar mit dem Titel „Synthetic Data Generation: Accelerating the Development and Verification of Self-Driving“ eine vollständige Einführung in NVIDIAs Training in Long-Tail-Szenarien im vergangenen Jahr „Fahrzeuge“: Die neuesten Fortschritte und damit verbundenen Erfahrungen, insbesondere die Untersuchung, wie Entwickler den DRIVE Replicator verwenden können, um verschiedene synthetische Datensätze und genaue Datenetiketten der Bodenwahrheit zu generieren, um die Entwicklung und Verifizierung autonomer Fahrzeuge zu beschleunigen. Der Vortrag war voller nützlicher Informationen und erregte große Aufmerksamkeit und Diskussion in der Branche. Dieser Artikel fasst die Essenz dieser Weitergabe zusammen und organisiert sie, um jedem ein besseres Verständnis von DRIVE Replicator und der synthetischen Datengenerierung von Wahrnehmungsalgorithmen für autonomes Fahren zu ermöglichen.

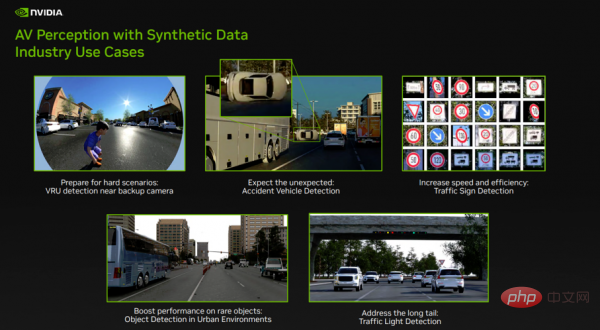

Abbildung 1

Im vergangenen Jahr hat NVIDIA DRIVE Replicator Positive verwendet Fortschritte wurden bei der Generierung synthetischer Datensätze für das Training von Wahrnehmungsalgorithmen für autonomes Fahren erzielt. Abbildung 1 zeigt einige der Long-Tail-Szenario-Herausforderungen, die NVIDIA derzeit löst:

- Die erste Zeile links zeigt gefährdete Verkehrsteilnehmer (VRUs) in der Nähe der Rückfahrkamera. VRU ist eine wichtige Objektklasse für jeden Wahrnehmungsalgorithmus für autonomes Fahren. In diesem Fall konzentrieren wir uns auf die Erkennung von Kindern in der Nähe der Rückfahrkamera. Da die Datenerfassung und Datenkennzeichnung in der realen Welt eine große Herausforderung darstellt, handelt es sich hier um einen wichtigen Anwendungsfall für die Sicherheit.

- Das mittlere Bild in der ersten Reihe zeigt die Unfallfahrzeugerkennung. Wahrnehmungsalgorithmen für autonomes Fahren müssen seltenen und ungewöhnlichen Szenen ausgesetzt sein, um Objekterkennungsalgorithmen zuverlässig zu machen. In realen Datensätzen gibt es nur sehr wenige Unfallfahrzeuge. DRIVE Replicator hilft beim Trainieren solcher Netzwerke, indem es Entwicklern dabei hilft, unerwartete Ereignisse (z. B. Autoüberschläge) unter verschiedenen Umgebungsbedingungen zu erzeugen.

- Das Bild auf der rechten Seite der ersten Zeile zeigt die Verkehrszeichenerkennung. In anderen Fällen ist die manuelle Kennzeichnung von Daten zeitaufwändig und fehleranfällig. DRIVE Replicator hilft Entwicklern, Datensätze von Hunderten von Verkehrszeichen und Ampeln unter verschiedenen Umgebungsbedingungen zu erstellen und Netzwerke schnell zu trainieren, um verschiedene reale Probleme zu lösen.

- Schließlich gibt es viele Objekte, die in städtischen Umgebungen nicht üblich sind, wie zum Beispiel bestimmte Verkehrsstützen und bestimmte Fahrzeugtypen. DRIVE Replicator hilft Entwicklern, die Häufigkeit dieser seltenen Objekte in Datensätzen zu erhöhen und die reale Datenerfassung durch gezielte synthetische Daten zu erweitern.

Die oben genannten Funktionen werden über NVIDIA DRIVE Replicator implementiert.

Verstehen Sie DRIVE Replicator und das zugehörige Ökosystem.

DRIVE Replicator ist Teil der DRIVE Sim-Tool-Suite und kann für die autonome Fahrsimulation verwendet werden.

DRIVE Sim ist ein sehr führender selbstfahrender Autosimulator, der von NVIDIA auf Basis von Omniverse entwickelt wurde und physikalisch genaue Sensorsimulationen in großem Maßstab durchführen kann. Entwickler können wiederholbare Simulationen auf einer Workstation ausführen und dann im Rechenzentrum oder in der Cloud auf den Batch-Modus skalieren. DRIVE Sim ist eine modulare Plattform, die auf leistungsstarken offenen Standards wie USD basiert und es Benutzern ermöglicht, ihre eigenen Funktionen durch Omniverse-Erweiterungen einzuführen.

DRIVE Sim enthält mehrere Apps, einschließlich DRIVE Replicator. DRIVE Replicator bietet hauptsächlich eine Reihe von Funktionen, die sich auf die Generierung synthetischer Daten für das Training und die Algorithmusüberprüfung autonomer Fahrzeuge konzentrieren. DRIVE Sim und DRIVE Constellation unterstützen auch vollständige autonome Fahrsimulationen auf allen Ebenen, einschließlich Software-in-the-Loop, Hardware-in-the-Loop und anderen In-the-Loop-Simulationstests (Modelle, Anlagen, Menschen, und mehr).

Der Unterschied zwischen DRIVE Sim und herkömmlichen Simulationstools für autonomes Fahren besteht darin, dass bei der Erstellung synthetischer Datensätze herkömmliche Simulationstools für autonomes Fahren häufig mit professionellen Game-Engines kombiniert werden, um ausreichend realistische Szenen wiederherzustellen. Für die Simulation autonomen Fahrens reicht dies jedoch bei weitem nicht aus und es müssen Kernanforderungen wie physikalische Genauigkeit, Wiederholbarkeit und Skalierung erfüllt werden.

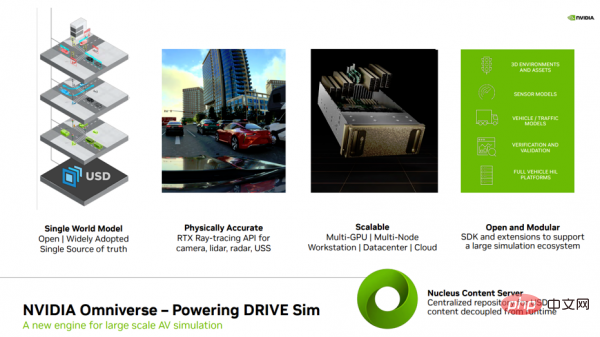

Bild 2

Bevor ich DRIVE Replicator weiter vorstelle, möchte ich einige verwandte Themen vorstellen Konzepte (Abbildung 2), insbesondere Omniverse, um allen zu helfen, den zugrunde liegenden technischen Support im Zusammenhang mit DRIVE Replicator besser zu verstehen.

Erfahren Sie zunächst mehr über Omniverse, NVIDIAs Engine für groß angelegte Simulationen. Omniverse basiert auf USD (Universal Scene Description, eine erweiterbare universelle Sprache zur Beschreibung virtueller Welten), die von Pixar entwickelt wurde. USD ist eine einzige Quelle von Wahrheitswertdaten für die gesamte Simulation und alle Aspekte der Simulation (einschließlich Sensoren, 3D-Umgebung). Diese vollständig über USD erstellten Szenen ermöglichen Entwicklern einen hierarchischen Zugriff auf jedes Element in der Simulation und generieren vielfältige Legen Sie den Grundstein für einen speziellen synthetischen Datensatz.

Zweitens bietet Omniverse Echtzeit-Raytracing-Effekte zur Unterstützung von Sensoren in DRIVE Sim. RTX ist einer von NVIDIAs wichtigen Fortschritten in der Computergrafik und nutzt eine optimierte Raytracing-API, die sich auf physikalische Genauigkeit konzentriert, um komplexes Verhalten von Kameras, Lidar, Millimeterwellenradar und Ultraschallsensoren wie Mehrfachreflexionen, Mehrwegeeffekte, Rolling Shutter usw. sicherzustellen Linsenverzerrung) werden nativ modelliert.

Drittens ist NVIDIA Omniverse eine leicht skalierbare offene Plattform, die für virtuelle Zusammenarbeit und physikalisch genaue Echtzeitsimulation entwickelt wurde. Sie kann Arbeitsabläufe in der Cloud oder im Rechenzentrum ausführen und ein paralleles Rendern und Generieren von Daten auf mehreren GPUs und Knoten ermöglichen.

Viertens übernehmen Omniverse und DRIVE Sim offene und modulare Designs, und rund um diese Plattform hat sich ein riesiges Partner-Ökosystem gebildet. Diese Partner können 3D-Materialien, Sensoren, Fahrzeug- und Verkehrsmodelle, Verifizierungstools usw. bereitstellen.

Fünftens ist Nucleus der Kern der Omniverse-Zusammenarbeit und verfügt über Datenspeicher- und Zugriffskontrollfunktionen und kann als zentralisiertes Content-Warehouse fungieren mehrere Benutzer, unterstützt DRIVE Sim, um die Laufzeit vom Inhalt zu entkoppeln, die Versionskontrolle zu verbessern und einen einzigen Referenzpunkt für alle Aufnahmen, Szenen und Metadaten zu erstellen.

DRIVE Sim ist eine Plattform. NVIDIA verfolgt beim Aufbau der Plattform einen ökologischen Kooperationsansatz, der es Partnern ermöglicht, zu dieser universellen Plattform beizutragen. Derzeit hat DRIVE Sim ein riesiges Partner-Ökosystem aufgebaut, das 3D-Assets, Umgebungssensormodelle, Verifizierung und andere Bereiche abdeckt. Mit dem DRIVE Sim SDK können Partner ganz einfach ihre eigenen Sensor-, Verkehrs- und Fahrzeugdynamikmodelle einführen und ihre Kernsimulationsfähigkeiten erweitern. Entwickler können nicht nur Erweiterungen in Omniverse schreiben und problemlos neue Funktionen hinzufügen, sondern auch die Vorteile der Entwicklung auf einer gemeinsamen Plattform genießen – Omniverse hat mehrere wichtige Partner zusammengebracht, die wichtige Arbeit im Zusammenhang mit dem Entwicklungsablauf für autonomes Fahren leisten.

So verwenden Sie DRIVE Replicator zum Generieren synthetischer Datensätze und Ground-Truth-Daten

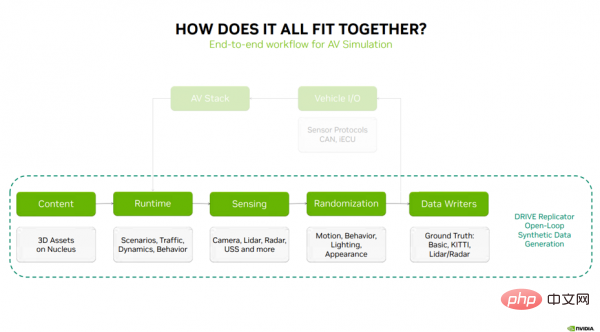

Als nächstes erkläre ich, wie die oben genannten Inhalte kombiniert werden und welche fünf Hauptarbeitsschritte DRIVE Replicator zum Generieren synthetischer Daten durchführt (Abbildung 3): Inhalt ( Inhalt) – DRIVE Sim Runtime – Sensing – Randomisierung – Datenschreiber.

Abbildung 3

Der erste Schritt im Simulationsprozess sind die auf dem Nucleus-Server gespeicherten 3D-Inhalte und -Materialien. Diese Assets werden an DRIVE Sim Runtime übergeben, die Kerntechnologie zur Ausführung von Szenarien, Verkehrsmodellen, Fahrzeugdynamik und -verhalten. DRIVE Sim Runtime kann mit RTX-Raytracing-basierten Kameras, Lidar, Millimeterwellenradar und Wahrnehmungstechnologie der USS verwendet werden. Der nächste Schritt besteht darin, durch Randomisierung von Bewegung, Verhalten, Beleuchtung und Erscheinungsbild Abwechslung in die Daten zu bringen. Bei der Closed-Loop-Simulation besteht der nächste Schritt darin, die Simulation über Fahrzeug-I/O mit dem Stack für autonomes Fahren zu verbinden, der typischerweise aus Sensorprotokollen, CAN-Nachrichten und einem virtuellen Steuergerät (das wichtige Informationen an den Stack für autonomes Fahren sendet) besteht den Kreis schließen).

Bei der Generierung synthetischer Daten handelt es sich um einen Prozess mit offenem Regelkreis, der zufällige Sensordaten an Datenschreiber sendet, die Grundwahrheiten für das Training von Wahrnehmungsalgorithmen für autonomes Fahren ausgeben können. Die oben genannten Schritte stellen einen vollständigen Arbeitsablauf für die Generierung synthetischer Daten dar.

- Inhalt (Inhalt)

Wie oben erwähnt, sind der erste Schritt im Simulationsprozess die auf dem Nucleus-Server gespeicherten 3D-Inhalte und -Materialien. Woher kommt dieser Inhalt? Wie bekomme ich es? Was sind die Standards oder Anforderungen?

In den letzten Jahren hat NVIDIA mit mehreren Content-Partnern zusammengearbeitet, um ein riesiges Ökosystem von 3D-Asset-Anbietern aufzubauen, darunter Fahrzeuge, Requisiten, Fußgänger, Vegetation und 3D-Umgebungen, die für den Einsatz in DRIVE Sim bereit sind.

Zu beachten ist, dass selbst wenn Sie diese Assets vom Markt beziehen, dies nicht bedeutet, dass Sie mit der Simulationsarbeit beginnen können. Sie müssen diese Assets auch für die Simulation vorbereiten, und hier kommt SimReady ins Spiel.

Ein wichtiger Teil der Erweiterung besteht darin, mit 3D-Asset-Anbietern zusammenzuarbeiten und ihnen die Tools zur Verfügung zu stellen, die sie benötigen, um sicherzustellen, dass bestimmte Konventionen, Benennungen, Asset-Rigging und semantisches Tagging eingehalten werden, wenn Assets in DRIVE Sim (semantische Labels) und physische Eigenschaften eingebracht werden.

SimReady Studio hilft Inhaltsanbietern, ihre vorhandenen Assets in simulationsbereite USD-Assets umzuwandeln, die auf DRIVE Sim geladen werden können, einschließlich 3D-Umgebungen, dynamischer Assets und statischer Requisiten.

Also, was ist SimReady? Sie können es sich als einen Konverter vorstellen, der dabei hilft, sicherzustellen, dass 3D-Assets in DRIVE Sim und Replicator bereit sind, End-to-End-Simulationsworkflows zu unterstützen. SimReady verfügt über mehrere Schlüsselelemente, darunter:

- Jedes Asset muss einer Reihe von Spezifikationen hinsichtlich Ausrichtung, Benennung, Geometrie usw. folgen, um Konsistenz zu gewährleisten.

- Semantische Tags und eine klar definierte Ontologie, die für jedes Element der Anmerkung verwendet werden Vermögenswert. Dies ist entscheidend für die Generierung von Grundwahrheitsbezeichnungen für die Wahrnehmung.

- Unterstützt die Physik und Dynamik starrer Körper, sodass die generierten Datensätze realistisch aussehen und die Lücke zwischen Simulation und Realität aus kinematischer Sicht geschlossen werden.

- Der nächste Schritt besteht darin, sicherzustellen, dass die Assets bestimmten Materialien folgen und Namenskonventionen, um sicherzustellen, dass Assets für RTX-Raytracing bereit sind und realistische Reaktionen auf aktive Sensoren wie Lidar, Millimeterwellenradar und Ultraschallsensoren erzeugen.

- Ein weiterer gemeinsamer Aspekt ist die Montage von 3D-Assets, um Beleuchtungsänderungen, Türbetätigung und Fußgängervorgänge zu ermöglichen und mehr;

- Der letzte Teil ist die Leistungsoptimierung für die Echtzeit-High-Fidelity-Sensorsimulation.

Basierend auf dem obigen Verständnis werfen wir einen Blick auf den Prozess der Verwendung von SimReady Studio, um Assets zu erhalten, die in DRIVE Sim verwendet werden können.

Angenommen, dieser Prozess beginnt mit dem Kauf von Vermögenswerten auf dem 3D-Markt. Der erste Schritt besteht darin, dieses Asset in SimReady Studio zu importieren. Dies kann auch in großen Mengen oder durch den Batch-Import mehrerer Assets erfolgen, um diesen Schritt abzuschließen.

Nach dem Import werden die Materialnamen dieser Inhaltselemente aktualisiert und ihre Materialeigenschaften werden ebenfalls aktualisiert und um Attribute wie Reflexionsvermögen und Rauheit erweitert.

Dies ist wichtig, um eine physikalisch realistische Qualität der Rendering-Daten sicherzustellen und um sicherzustellen, dass das Materialsystem mit allen RTX-Sensortypen interagiert, nicht nur mit denen, die im sichtbaren Spektrum arbeiten.

Der nächste Schritt besteht darin, semantische Tags und Tags zu aktualisieren. Warum ist dieser Schritt wichtig? Mit den richtigen Bezeichnungen können die mit dem Asset generierten Daten zum Trainieren von AV-Algorithmen verwendet werden. Darüber hinaus nutzen DRIVE Sim und Omniverse Nucleus als zentrales Asset-Repository. Es gibt Tausende von Inhaltsressourcen auf Nucleus, und durchsuchbare Tags mit zugehörigen Miniaturansichten helfen neuen Benutzern, ein Asset leichter zu finden.

Als nächstes beginnen Sie mit der Definition des Kollisionsvolumens und der Geometrie des Objekts und beobachten, wie sich dieses Inhaltselement aus physikalischer Sicht verhält. Anschließend werden die physikalischen und Masseneigenschaften des Objekts geändert, um das gewünschte Verhalten zu erzeugen.

Der letzte Schritt im gesamten Prozess besteht in der Validierung der Assets, um sicherzustellen, dass diese Content-Assets den richtigen Konventionen entsprechen. Simulationsbereite USD-Assets können jetzt gespeichert und erneut in NVIDIA Omniverse und DRIVE Sim importiert werden. Der größte Vorteil beim Erstellen einer Szene über USD besteht darin, dass alle in den vorherigen Schritten erstellten Metadaten mit dem endgültigen Asset übertragen und hierarchisch mit dem USD des Hauptobjekts verknüpft werden, wodurch die Grundlage für die anschließende Generierung verschiedener synthetischer Datensätze gelegt wird.

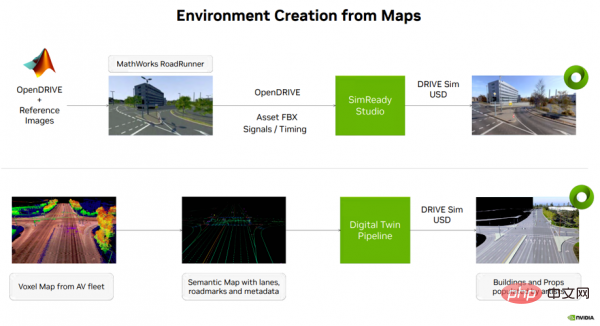

Abbildung 4

Zurück zur Erstellung von Inhalten für die Simulation selbstfahrender Autos: Es gibt normalerweise mehrere Möglichkeiten, eine Umgebung aus Kartendaten zu erstellen (siehe Abbildung 4). Eine Möglichkeit besteht darin, mit dem Roadrunner-Tool von MathWorks eine 3D-Umgebung auf einer offenen NVIDIA DRIVE-Karte (multimodale Kartenplattform) zu erstellen. Die Ausgabe dieses Schritts wird dann zusammen mit semantischen Karteninformationen, Signal-Timing usw. an SimReady Studio übertragen und die 3D-Umgebung in ein USD-Asset umgewandelt, das auf DRIVE Sim geladen werden kann.

Eine weitere Option besteht darin, Voxel-Kartendaten einer selbstfahrenden Flotte zu verwenden und semantische Karteninformationen wie Fahrspuren, Verkehrszeichen und andere Metadaten zu extrahieren. Diese Informationen werden über einen digitalen Zwilling erstellt, wodurch ein USD-Asset entsteht, das auf DRIVE Sim geladen werden kann.

Die beiden oben genannten Arten von USD-Umgebungen werden verwendet, um End-to-End-Simulationstests (E2E) autonomer Fahrzeuge und Arbeitsabläufe zur Generierung synthetischer Daten zu unterstützen.

- DRIVE Sim Runtime

Als nächstes stelle ich Ihnen den zweiten Schritt der Simulation vor – DRIVE Sim Runtime, der den Grundstein für alle Funktionen legt, die wir im DRIVE Replicator zur Generierung synthetischer Datensätze verwenden.

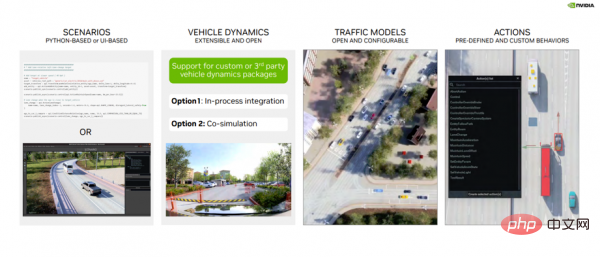

DRIVE Sim Runtime ist eine offene, modulare und erweiterbare Komponente. Was bedeutet das in der Praxis (siehe Abbildung 5)?

Erstens basiert es auf Szenen, in denen Entwickler die spezifische Position, Bewegung und Interaktion von Objekten in der Szene definieren können. Diese Szenarien können in Python oder über die Benutzeroberfläche des Szenario-Editors definiert und zur späteren Verwendung gespeichert werden.

Zweitens unterstützt es die Integration mit benutzerdefinierten Fahrzeugdynamikpaketen über das DRIVE Sim SDK, entweder als Schritt im Prozess oder als Co-Simulation mit DRIVE Sim 2.0.

Drittens Verkehrsmodell. DRIVE Sim verfügt über eine umfangreiche Fahrzeugmodellschnittstelle und mit Hilfe der Runtime können Entwickler ihre eigene Fahrzeugdynamik einführen oder bestehende regelbasierte Verkehrsmodelle konfigurieren.

Viertens das Aktionssystem, das eine umfangreiche vordefinierte Aktionsbibliothek (z. B. Spurwechsel), Zeitauslöser, mit denen Szenen verschiedener miteinander interagierender Objekte usw. erstellt werden können, enthält.

Bild 5

Sehen wir uns hier kurz den vorherigen Inhalt an: Simulationsprozess Kapitel 5 Im ersten Schritt werden die von SimReady konvertierten, simulationsfertigen 3D-Inhalte und Materialien auf dem Nucleus-Server gespeichert. Im zweiten Schritt werden diese Materialien an DRIVE Sim Runtime übergeben, die Kerntechnologie zur Ausführung von Szenarien, Verkehrsmodellen, Fahrzeugdynamik und -verhalten, und legen den Grundstein für alle nachfolgenden Funktionen zur Generierung synthetischer Datensätze.

- Sensierung (Wahrnehmung)

Vor der Datengenerierung müssen Sensoren zum Einrichten des Ziels verwendet werden Testfahrzeug. Mit dem Ego Configurator-Tool können Entwickler bestimmte Fahrzeuge auswählen und der Szene hinzufügen.

Darüber hinaus können Entwickler auch Fahrzeuge in der Szene bewegen und Sensoren an den Fahrzeugen anbringen. Das Ego-Konfiguratortool unterstützt Universal- und Hyperion 8-Sensoren.

Nach dem Hinzufügen des Sensors zum Fahrzeug können Entwickler auch Parameter wie Sichtfeld, Auflösung, Sensorname ändern und Sensorpositionen am Fahrzeug intuitiv konfigurieren.

Benutzer können auch Vorschauen vom Sensor-POV anzeigen und das Sichtfeld in einer 3D-Umgebung visualisieren, bevor sie Datengenerierungsszenen erstellen.

Dieses Tool kann Entwicklern dabei helfen, schnell Prototypen verschiedener Konfigurationen zu erstellen und die durch Sensoraufgaben erreichte Abdeckung zu visualisieren.

- Randomisierung

Lassen Sie uns nun kurz den vierten Schritt des Simulationsprozesses, die Domänen-Randomisierung, vorstellen Bringen Sie Abwechslung in Ihre Daten, indem Sie Bewegung, Verhalten, Beleuchtung und Erscheinungsbild randomisieren.

Dies beinhaltet eine andere Möglichkeit, Szenen mit Python zu erstellen. Mit der Python-API von DRIVE Replicator können Entwickler die offene NVIDIA DRIVE Map abfragen und eine Reihe statischer und dynamischer Assets kontextbewusst platzieren. Einige Randomizer werden sich darauf konzentrieren, wie man ein autonomes Fahrzeug von einem Punkt zum nächsten teleportiert, wie man Objekte um das autonome Fahrzeug herum generiert und daraus verschiedene synthetische Datensätze generiert. Diese komplex klingenden Vorgänge lassen sich leicht durchführen, da der Benutzer die direkte Kontrolle über die USD-Szene und alle Objekte in dieser Umgebung hat.

Ein weiterer wichtiger Schritt beim Erstellen synthetischer Datensätze für das Training ist die Möglichkeit, Änderungen am Erscheinungsbild der 3D-Szene vorzunehmen. Die leistungsstarken Funktionen von USD wurden ebenfalls oben erwähnt. Beispielsweise ermöglichen mit USD erstellte Szenarien Entwicklern einen hierarchischen Zugriff auf jedes Element in der Simulation. Die API von SimReady verwendet USD, um Funktionen in einer Szene schnell einzurichten.

Sehen wir uns ein Beispiel an (siehe Abbildung 6): Die Straßenoberfläche ist etwas nass, aber wenn wir andere Parameter einstellen, ändert sich der Nässegrad der Straßenoberfläche. Wir können ähnliche Änderungen an Aspekten wie Sonnenazimut und Sonnenhöhe vornehmen, um realistische Datensätze unter verschiedenen Umgebungsbedingungen zu erstellen.

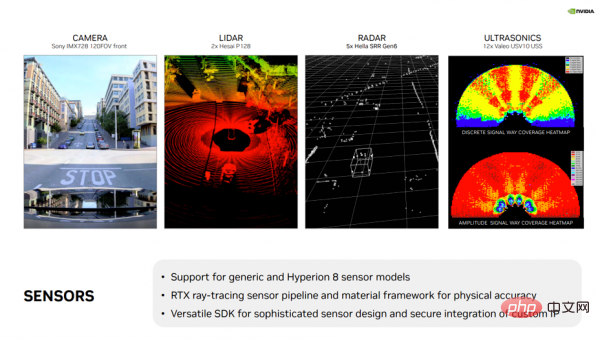

Ein weiteres Highlight ist die Möglichkeit, Beleuchtungs- und Erscheinungsbildänderungen zu ermöglichen, die alle über die SimReady-API und USD verfügbar sind. Einer der Hauptvorteile von DRIVE Sim ist der RTX-Sensor-Workflow. Er unterstützt eine Vielzahl von Sensoren (siehe Abbildung 7), darunter generische und handelsübliche Modelle für Kameras, Lidar, konventionelles Radar und USS. Darüber hinaus bietet DRIVE Sim volle Unterstützung für die NVIDIA DRIVE Hyperion-Sensorsuite, sodass Benutzer mit der Algorithmenentwicklung und Validierungsarbeit in einer virtuellen Umgebung beginnen können.

Darüber hinaus verfügt DRIVE Sim über ein leistungsstarkes und vielseitiges SDK, das es Partnern ermöglicht, die Raytracing-API von NVIDIA zu nutzen, um komplexe Sensormodelle zu implementieren und gleichzeitig ihr geistiges Eigentum und ihre proprietären Algorithmen zu schützen. Dieses Ökosystem ist im Laufe der Jahre gewachsen und NVIDIA arbeitet mit Partnern zusammen, um neue Arten von Sensoren wie bildgebendes Radar, FMCW-Lidar und mehr in DRIVE Sim zu integrieren.

Bild 7

- Data Writers Writer)

Jetzt verlagert sich der Fokus auf die Generierung von Ground-Truth-Daten und die Visualisierung dieser Informationen. Dabei handelt es sich um den letzten Schritt im Simulationsprozess, den Datenschreiber. In diesem Prozess werden zufällige Sensordaten an Datenschreiber gesendet, die Ground-Truth-Labels ausgeben, die zum Trainieren von Wahrnehmungsalgorithmen für autonomes Fahren verwendet werden.

Der Datenschreiber ist ein Python-Skript, das zum Generieren von Ground-Truth-Labels verwendet wird, die zum Trainieren von Wahrnehmungsalgorithmen für autonomes Fahren erforderlich sind.

NVIDIA DRIVE Replicator wird mit Vorlagenschreibern wie Base Writer und KITTI Writer geliefert.

Der Basis-Writer deckt ein breites Spektrum realer Datenbezeichnungen ab, darunter Objektklassen, enge und lose Begrenzungsrahmen in 2D und 3D, Semantik- und Instanzmasken, Tiefenausgabe, Verdeckungen, Normalenwartezeit.

In ähnlicher Weise gibt es Lidar-/Normalradar-Writer, mit denen Laserpunktwolkendaten in Numpy-Arrays oder in jede relevante Anpassung zusammen mit Begrenzungsrahmen, Semantik und Objektbeschriftungen exportiert werden können. Definieren Sie das Format.

Diese Autoren bieten Entwicklern Beispiele für die Konfiguration ihrer eigenen Autoren auf der Grundlage benutzerdefinierter Markup-Formate und zur Erweiterung ihrer Datengenerierungsbemühungen.

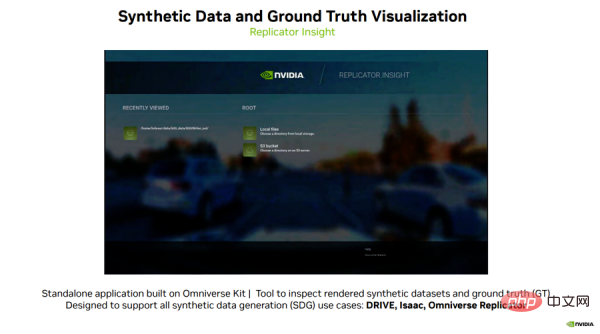

Abschließend möchte ich Ihnen eine spannende Software vorstellen, Replicator Insight, die vom Omniverse-Team entwickelt wurde.

Replicator Insight ist eine eigenständige Anwendung, die auf dem Omniverse Kit basiert und zur Überprüfung gerenderter synthetischer Datensätze und zur Überlagerung verschiedener Ground-Truth-Labels für das Training verwendet werden kann.

Replicator Insight unterstützt alle Anwendungsfälle der synthetischen Datengenerierung, einschließlich DRIVE, Isaac und Omniverse Replicator.

Sehen wir uns ein Beispiel an (siehe Abbildung 8): Benutzer können die von DRIVE Replicator generierten Daten in dieses Visualisierungstool laden und verschiedene Wahrheitsbezeichnungen für verschiedene Objektkategorien in der Szene aktivieren und deaktivieren.

Bild 8

Mit diesem Visualisierungstool können Benutzer Videos abspielen und sortieren Datensätze können sogar zwischen verschiedenen Ansichten wie Tiefen- und RGB-Daten verglichen werden.

Benutzer können auch Parameter wie die Wiedergabebildrate und den Tiefenbereich ändern oder Datensätze vor dem Training für selbstfahrende Autos schnell visualisieren.

Dies wird Entwicklern helfen, neue Ground-Truth-Label-Typen leicht zu verstehen und komplexe Datensätze zu analysieren.

Insgesamt handelt es sich um ein leistungsstarkes Tool, mit dem Benutzer jedes Mal neue Erkenntnisse gewinnen können, wenn sie sich Daten ansehen, unabhängig davon, ob es sich um reale oder synthetische Daten handelt.

Zusammenfassung

Das Obige fasst die neueste Entwicklung von DRIVE Replicator im vergangenen Jahr zusammen und zeigt, wie Entwickler DRIVE Replicator verwenden können, um verschiedene synthetische Datensätze zu generieren und präzise zu ermitteln. Wahrheitsdatenetiketten zur Beschleunigung der Entwicklung und Verifizierung autonomer Fahrzeuge. NVIDIA hat aufregende Fortschritte bei der Generierung hochwertiger Sensordatensätze für eine Vielzahl realer Anwendungsfälle gemacht und wir freuen uns auf die weitere Kommunikation mit Ihnen!

Das obige ist der detaillierte Inhalt vonBeschleunigung der Entwicklung und Verifizierung autonomer Fahrzeuge: Ein genauerer Blick auf die synthetische Datengenerierungstechnologie DRIVE Replicator. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr