Heim >Technologie-Peripheriegeräte >KI >Welche Beziehung besteht zwischen Quantencomputing und künstlicher Intelligenz?

Welche Beziehung besteht zwischen Quantencomputing und künstlicher Intelligenz?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-05-05 08:37:061328Durchsuche

Nach jahrzehntelanger Forschung entwickelt sich künstliche Intelligenz (KI) zu einem der großen Branchentrends. Von Gesprächen mit Alexa und Siri über die selbstfahrenden Autos von Waymo und Tesla bis hin zu OpenAIs GPT-3, der Prosa wie ein Mensch schreibt, und DeepMinds AlphaZero, der den menschlichen Go-Großmeister schlägt – künstliche Intelligenz ist jetzt ausgereift genug. Lösen Sie reale Probleme, oft schneller und besser als Menschen.

Andernorts in der Technologiebranche arbeiten einige Visionäre hart an der Entwicklung von Quantencomputern, die versuchen, die Eigenschaften der Quantenphysik zu nutzen, um Berechnungen schneller als heutige Computer durchzuführen.

An diesem Punkt fragen sich viele von Ihnen vielleicht: Was genau hat Quantencomputing mit künstlicher Intelligenz zu tun? Arbeit von Pionieren im Quantencomputing.

Die Theorie der rechnerischen Komplexität ist ein Bereich, der Mathematik und Informatik umfasst und sich auf die Klassifizierung von Rechenproblemen basierend auf der Ressourcennutzung wie Raum (Speicher) und Zeit konzentriert. Ein Rechenproblem ist im Wesentlichen eine Aufgabe, die von einem Computer mechanisch gelöst werden kann, indem er mathematische Schritte befolgt, die in einem Algorithmus definiert sind.

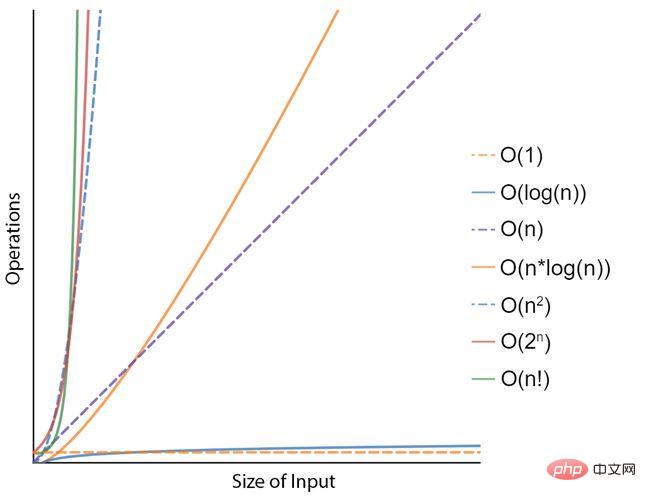

Betrachten Sie zum Beispiel das Problem, Zahlen in einer Liste zu sortieren. Ein möglicher Algorithmus namens „selection sort“ besteht darin, aus dem unsortierten Teil der Liste (zunächst alle) immer wieder das kleinste Element (in aufsteigender Reihenfolge) zu finden und an den Anfang zu stellen. Der Algorithmus verwaltet während seiner Ausführung effektiv zwei Unterlisten der ursprünglichen Liste: den bereits sortierten Teil und den verbleibenden unsortierten Teil. Nachdem dieser Vorgang mehrere Male durchlaufen wurde, ist das Ergebnis eine vom kleinsten zum größten sortierte Liste. In Bezug auf die zeitliche Komplexität wird dies durch eine Komplexität von N 2 dargestellt, wobei N die Größe oder Anzahl der Elemente in der Liste darstellt. Mathematiker haben effizientere, aber komplexere Sortieralgorithmen wie „Cube Sort“ oder „Tim Sort“ vorgeschlagen, die beide eine Komplexität von N x log(N) haben. Das Sortieren einer Liste mit 100 Elementen ist für heutige Computer eine einfache Aufgabe, das Sortieren einer Liste mit einer Milliarde Datensätzen ist jedoch möglicherweise nicht so einfach. Daher ist die zeitliche Komplexität (oder die Anzahl der Schritte in einem Algorithmus im Verhältnis zur Größe des Eingabeproblems) sehr wichtig.

Um ein Problem schneller zu lösen, können Sie einen schnelleren Computer verwenden oder einen effizienteren Algorithmus finden, der weniger Operationen erfordert. Das bedeutet geringere Zeitkomplexität. Es ist jedoch klar, dass bei Problemen mit exponentieller Komplexität (z. B. N 2 oder 2 N) die Mathematik gegen Sie arbeitet und bei größeren Problemgrößen die einfache Verwendung eines schnelleren Computers nicht praktikabel ist. Und genau das ist im Bereich der künstlichen Intelligenz der Fall. Künstliche Intelligenz ist ein hochkomplexes Problem, das es zu lösen gilt.

Künstliche Intelligenz ist ein hochkomplexes Problem, das es zu lösen gilt.

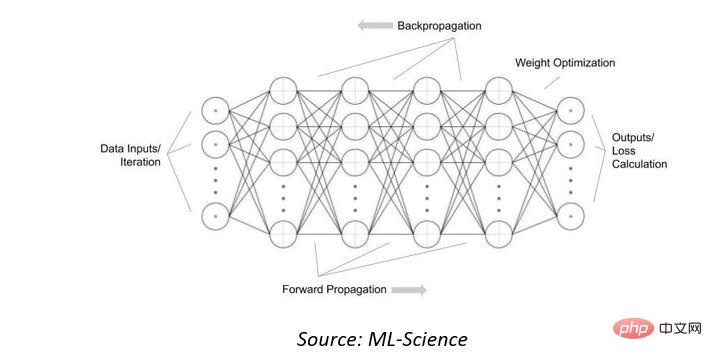

Zuerst werden wir uns die Rechenkomplexität künstlicher neuronaler Netze ansehen, die in heutigen Systemen der künstlichen Intelligenz (KI) verwendet werden. Diese mathematischen Modelle sind von den biologischen neuronalen Netzwerken inspiriert, aus denen tierische Gehirne bestehen. Sie „lernen“, Eingabedaten zu erkennen oder zu klassifizieren, indem sie viele Beispiele sehen. Dabei handelt es sich um Ansammlungen miteinander verbundener Knoten oder Neuronen, kombiniert mit einer Aktivierungsfunktion, die die Ausgabe basierend auf den in einer „Eingabeschicht“ präsentierten Daten und den Gewichtungen in den Verbindungen bestimmt.

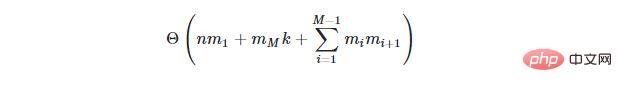

Um die Gewichte in den Verbindungen so anzupassen, dass die „Ausgabe“ nützlich oder korrekt ist, kann das Netzwerk „trainiert“ werden, indem es vielen Datenbeispielen ausgesetzt wird und der Ausgabeverlust „rückwärts propagiert“ wird. Für ein neuronales Netzwerk mit N Eingängen und M verborgenen Schichten, wobei die i-te verborgene Schicht m, i verborgene Neuronen und k Ausgangsneuronen enthält, wird ein Algorithmus, der die Gewichte aller Neuronen anpasst (Backpropagation-Algorithmus genannt), eine zeitliche Komplexität von haben:

Für ein neuronales Netzwerk mit N Eingängen und M verborgenen Schichten, wobei die i-te verborgene Schicht m, i verborgene Neuronen und k Ausgangsneuronen enthält, wird ein Algorithmus, der die Gewichte aller Neuronen anpasst (Backpropagation-Algorithmus genannt), eine zeitliche Komplexität von haben:

Quantencomputing zur Rettung?

Quantencomputing zur Rettung?

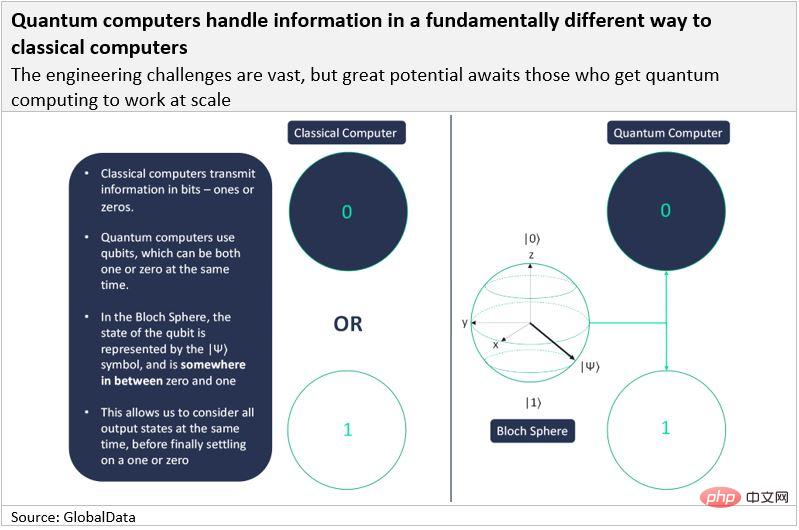

Quantencomputer sind Maschinen, die die Eigenschaften der Quantenphysik, insbesondere Superposition und Verschränkung, nutzen, um Daten zu speichern und Berechnungen durchzuführen. Es wird erwartet, dass sie Milliarden von Operationen gleichzeitig ausführen und so hochkomplexe Probleme, einschließlich künstlicher Intelligenz, erheblich beschleunigen.

Klassische Computer übertragen Informationen in Bits (kurz für „Binärziffern“), während Quantencomputer Qubits (kurz für „Qubits“) verwenden. Wie klassische Bits müssen Qubits letztlich Informationen entweder in Form einer 1 oder einer 0 übertragen, das Besondere ist jedoch, dass sie sowohl eine 1 als auch eine 0 gleichzeitig darstellen können. Man sagt, dass ein Qubit eine Wahrscheinlichkeitsverteilung hat, bei der es mit einer Wahrscheinlichkeit von 70 % eine 1 und mit einer Wahrscheinlichkeit von 30 % eine 0 ist. Das macht Quantencomputer so besonders.

Quantencomputer machen sich zwei grundlegende Eigenschaften der Quantenmechanik zunutze: Superposition und Verschränkung.

Wenn ein Qubit gleichzeitig 1 und 0 ist, spricht man von einem Überlagerungszustand. Superposition ist ein allgemeiner Begriff für Zustände, bei denen sich ein System gleichzeitig in mehreren Zuständen befindet und zum Zeitpunkt der Messung nur ein einziger Zustand angenommen wird. Wenn wir davon ausgehen, dass eine Münze ein Quantenobjekt ist, dann ergibt sich beim Werfen der Münze eine Überlagerung: Die Münze hat nur eine Wahrscheinlichkeit für Kopf oder Zahl. Sobald die Münze den Boden berührt und wir sie messen, wissen wir, ob die Münze Kopf oder Zahl ist. Ebenso wissen wir erst, wenn wir den Spin des Elektrons messen (ähnlich wie bei einer zu Boden fallenden Münze), in welchem Zustand sich das Elektron befindet und ob es eine 1 oder eine 0 ist.

Quantenteilchen in Überlagerung sind nur dann nützlich, wenn wir mehrere Teilchen haben. Dies bringt uns zum zweiten Grundprinzip der Quantenmechanik: der Verschränkung. Zwei (oder mehr) verschränkte Teilchen können nicht einzeln beschrieben werden; ihre Eigenschaften sind vollständig voneinander abhängig. Somit können sich verschränkte Qubits gegenseitig beeinflussen. Die Wahrscheinlichkeitsverteilung eines Qubits (eins oder null) hängt von der Wahrscheinlichkeitsverteilung aller anderen Qubits im System ab.

Aus diesem Grund verdoppelt jedes neue Qubit, das dem System hinzugefügt wird, die Anzahl der Zustände, die der Computer analysieren kann. Dieser exponentielle Anstieg der Computerleistung steht im Gegensatz zum klassischen Rechnen, das nur linear mit jedem neuen Bit skaliert.

Theoretisch können verschränkte Qubits Milliarden von Operationen gleichzeitig ausführen. Es ist klar, dass diese Fähigkeit jedem Algorithmus mit einer Komplexität im Bereich von N2, 2N oder N eine erhebliche Beschleunigung verleihen wird.

Machen Sie sich bereit für quantengesteuerte künstliche Intelligenz

Aufgrund des enormen Potenzials des Quantencomputings arbeiten die Hardware-Teams weiterhin daran, diese Systeme Wirklichkeit werden zu lassen (das bisher größte ist das 127-Qubit-Eagle-System von IBM), Softwareforscher Neu Algorithmen, die diese Fähigkeit des „Simultaneous Computing“ nutzen können, werden bereits in Bereichen wie Kryptographie, Chemie, Materialwissenschaften, Systemoptimierung und maschinellem Lernen/künstliche Intelligenz erforscht. Man geht davon aus, dass der faktorisierte Quantenalgorithmus von Shor im Vergleich zu klassischen Computern zu exponentiellen Beschleunigungen führen wird, was ein Risiko für aktuelle kryptografische Algorithmen darstellt.

Am interessantesten ist, dass angenommen wird, dass die lineare Quantenalgebra eine Polynombeschleunigung bewirken wird, was die Leistung unserer künstlichen neuronalen Netze erheblich verbessern wird. Google hat TensorFlow Quantum auf den Markt gebracht, ein Software-Framework für quantenmaschinelles Lernen, das ein schnelles Prototyping hybrider quantenklassischer maschineller Lernmodelle ermöglicht. IBM, ebenfalls führend im Bereich Quantencomputing, gab kürzlich bekannt, dass es einen „mathematischen Beweis“ für die Quantenüberlegenheit des quantenmechanischen Lernens gefunden hat. Allerdings sind Unternehmen wie IBM und Google zwar vertikal integriert (und entwickeln daher gleichzeitig Hardwaresysteme und Softwarealgorithmen). Es gibt auch eine Reihe sehr interessanter Quantensoftware-Startups, darunter Zapata, Riverlane, 1Qbit und in gewissem Maße auch Quantinuum (das seit der Fusion von Cambridge Quantum Computing mit Honeywell und der Namensänderung kein reines Softwareunternehmen mehr ist). wenige Beispiele.

Da Quantenhardware immer leistungsfähiger wird und Algorithmen für Quantenmaschinenlernen verfeinert werden, wird Quantencomputing wahrscheinlich einen erheblichen Anteil des KI-Chipmarktes erobern.

Das obige ist der detaillierte Inhalt vonWelche Beziehung besteht zwischen Quantencomputing und künstlicher Intelligenz?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr