Heim >Technologie-Peripheriegeräte >KI >Wenn Sie etwas zu sagen haben, sprechen Sie bitte! Der Google-Roboter kann selbstständig lernen und denken, nachdem er ein großes Sprachmodell „gefressen' hat

Wenn Sie etwas zu sagen haben, sprechen Sie bitte! Der Google-Roboter kann selbstständig lernen und denken, nachdem er ein großes Sprachmodell „gefressen' hat

- 王林nach vorne

- 2023-05-04 14:13:061097Durchsuche

„Du kannst in den Flur gehen, du kannst in die Küche gehen“, das ist ein Kompliment an die idealgütige Ehefrau, und ich werde es wahrscheinlich in Zukunft auch den Robotern von Google sagen.

Haben Sie schon einmal einen Roboter gesehen, der über ein großes Sprachmodell verfügt und selbstständig lernen kann? Sie wissen nicht, wie es geht? Du kannst es lernen! Es macht nichts, wenn Sie es jetzt noch nicht wissen, nach einer Weile werden Sie es schaffen.

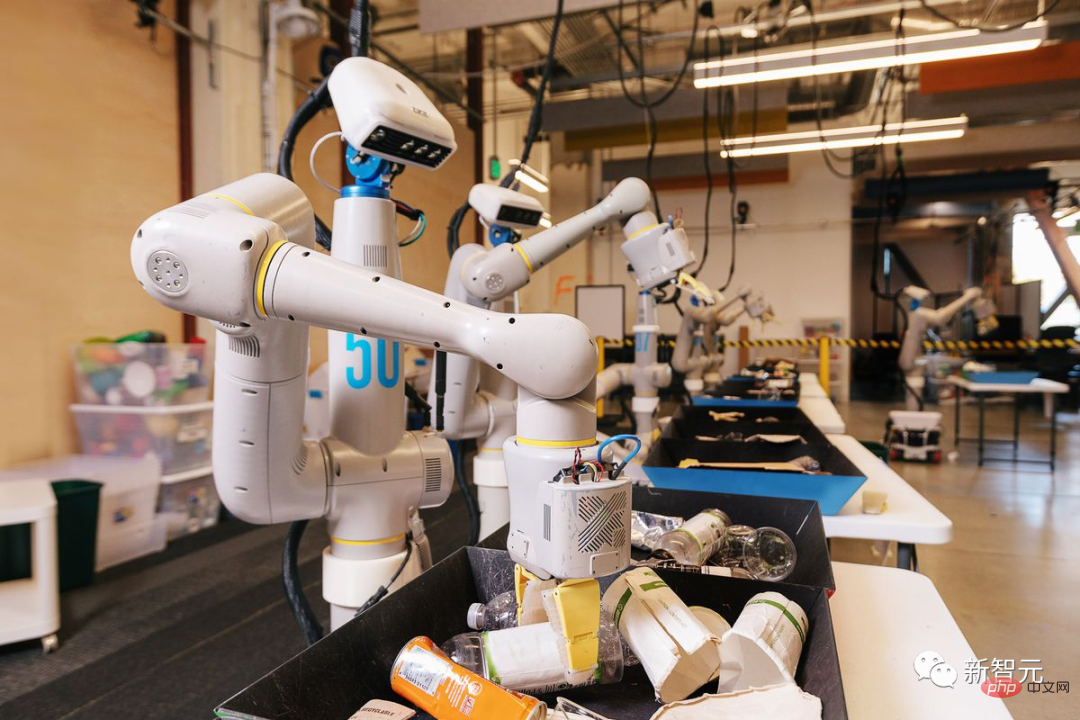

Im Vergleich zu Boston Dynamics‘ extrem coolem „Iron Masked King Kong“, der Berge von Messern erklimmt, in Meere aus Feuer hinabsteigt und Berge und Bergrücken erklimmt, als würde er auf flachem Boden gehen, ist dieses Mal Googles „ „Lernender Roboter“ ist eher wie ein fürsorglicher kleiner Assistent um Sie herum. Was ich sage und was Sie tun, sind die allgemeinen Routinen für Roboter, um Anweisungen auszuführen. Die neue Forschung von Google ermöglicht es Robotern dieses Mal, nicht nur Anweisungen zu befolgen, sondern es auch selbst zu tun.

Dies ist das erste Mal, dass Google ein großes Sprachmodell mit einem Roboter kombiniert, um dem Roboter beizubringen, die gleichen Dinge wie Menschen zu tun.

Adresse des Beitrags: https://arxiv.org/pdf/2204.01691.pdfVerwendung des Titels des Google-Artikels: „Tu, was ich kann, nicht, was ich sage.“

Bedeutet wahrscheinlich Folgendes: „Du bist bereits ein ausgereifter Roboter. Du kannst tun, was ich tue. Wenn du es nicht weißt, kannst du es lernen. Wenn du damit nicht vertraut bist, kannst du es üben!“ Google hat diesen Roboter PaLM-SayCan genannt. Im Bericht der „Washington Post“ sah der Reporter, wie Forscher Roboter aufforderten, Burger aus Plastikspielzeugzutaten herzustellen. Es scheint, dass dieser Roboterarm weiß, dass er nach dem Einlegen des Fleisches und vor dem Einlegen des Salats etwas Ketchup hinzufügen muss, aber der Koch glaubt derzeit, dass „Ketchup hinzufügen“ bedeutet, die gesamte Ketchup-Flasche in den Burger zu geben.

Obwohl dieser Roboterkoch noch nicht qualifiziert ist, glaubt Google, dass es mit dem Training eines großen Sprachmodells nur eine Frage der Zeit sein wird, bis er lernt, Burger zu kochen. Der Roboter kann auch 7-Up- und Coca-Cola-Dosen erkennen, Schubladen öffnen und eine Tüte Kartoffelchips finden. Mit den Abstraktionsfähigkeiten von PaLM kann es sogar verstehen, dass gelbe, grüne und blaue Schalen mit Wüsten, Dschungeln bzw. Ozeanen verglichen werden können.

Im Gegensatz zu früheren Robotern gab es in der Vergangenheit Roboter, die Burger, gebratene Nudeln und Pizza zubereiteten, aber tatsächlich führten sie eine Kombination aus klaren Anweisungen für eine einzelne Aktion aus, wie zum Beispiel „Bewegen“. rechter Arm drei Felder nach links.“ , „umdrehen“ usw. Googles aktuelles Ziel besteht darin, Roboter in die Lage zu versetzen, Befehle wie „Komm und mach mir einen Burger“, „Ich habe Hunger, geh mir ein Brötchen kaufen“ und „Geh raus und spiel mit mir Ball“ zu verstehen und auszuführen. Es ist, als würde man mit jemandem reden.

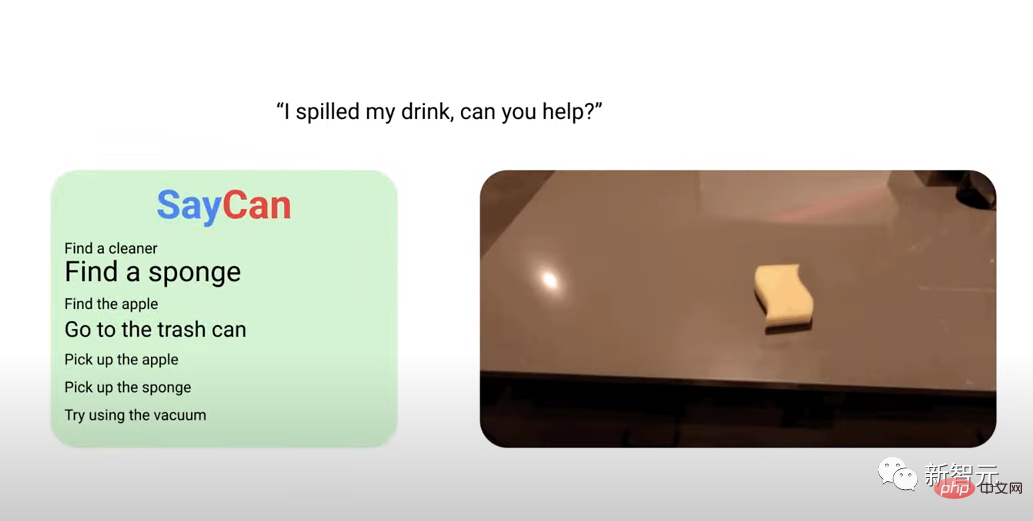

Als zum Beispiel ein Google-Forscher für künstliche Intelligenz zum PaLM-SayCan-Roboter sagte: „Mein Getränk ist verschüttet, können Sie helfen?“ Er glitt auf Rädern in der Küche des Google-Bürogebäudes und nutzte dabei die Vision eines Mit der Digitalkamera entdecken Sie den Schwamm auf der Theke, greifen ihn mit dem elektrischen Arm und bringen ihn zurück.

Brian Ichter von Google sagte: „Das ist grundsätzlich ein anderes Modell.“ Er ist einer der Autoren eines kürzlich veröffentlichten Artikels, der neue Fortschritte bei solchen Robotern beschreibt.

Derzeit sind Roboter keine Seltenheit mehr. Millionen von Robotern arbeiten in Fabriken auf der ganzen Welt, aber sie befolgen spezifische Anweisungen und konzentrieren sich oft nur auf eine oder zwei Aufgaben. Der Bau eines Roboters, der eine Reihe von Aufgaben erledigen und dabei lernen kann, ist jedoch viel komplizierter. Seit Jahren arbeiten große und kleine Technologieunternehmen hart daran, solche „universellen Roboter“ zu bauen.

Das große Sprachmodell, das in den letzten Jahren populär geworden ist, hat es Google ermöglicht, Inspiration für die Entwicklung von „universellen Robotern“ zu finden. Große Sprachmodelle nutzen große Textmengen aus dem Internet, um KI-Software zu trainieren, die Art von Antworten zu erraten, die auf bestimmte Fragen oder Kommentare folgen könnten.

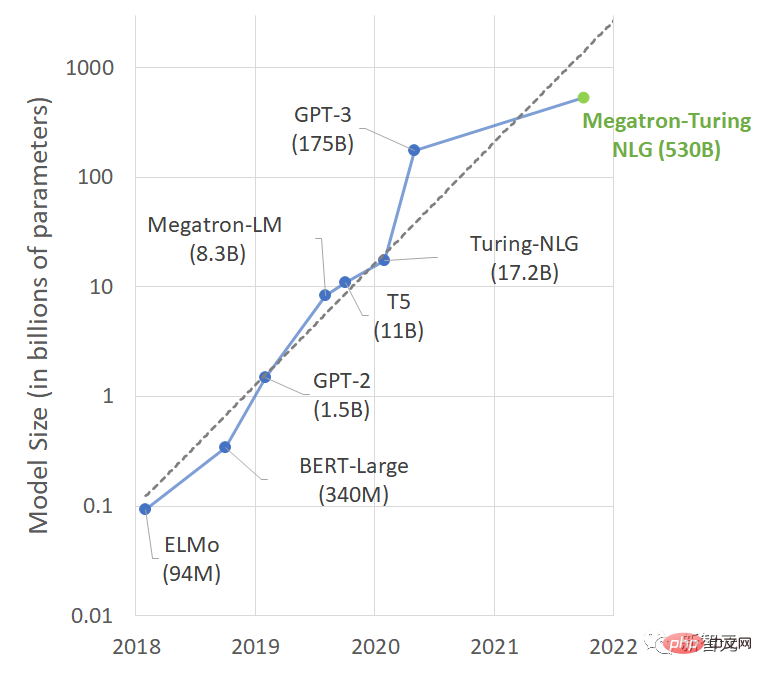

Von BERT über GPT-3 und später MT-NLP sind diese Modelle so gut darin geworden, die richtige Reaktion vorherzusagen, dass sie oft nur mit einem Modell zu tun haben, da die Anzahl der Parameter sprunghaft zugenommen hat Es fühlt sich an, als wäre es ein Gespräch mit einer sachkundigen Person. Wäre es bei so viel Wissen nicht schade, den ganzen Tag nur mit anderen zu plaudern? Wer sprechen kann, kann arbeiten. Von Chatbots bis hin zu Assistenzrobotern kann man sagen, dass die Forschungsideen von Google ganz natürlich entstanden sind.

Was ist das Tolle an diesem PaLM-SayCan?

Dieses Mal arbeitete Google AI mit dem Everyday Robot-Projekt zusammen, das vom Moonshot-X-Team des Google-Mutterkonzerns Alphabet ins Leben gerufen wurde, um eine Methode vorzuschlagen. Das heißt, durch Vortraining wird Wissen aus einem großen Sprachmodell (LLM) extrahiert, sodass der Roboter Textanweisungen auf hoher Ebene befolgen kann, um physische Aufgaben auszuführen.

Das Everyday Robot-Projekt ist seit vielen Jahren in Arbeit und viele der Teammitglieder, die mit Google AI arbeiten, kamen 2015 oder 2016 zu Alphabet. Die Idee besteht darin, dass Roboter Kameras und hochentwickelte Algorithmen für maschinelles Lernen verwenden, um die Welt um sie herum zu sehen und daraus zu lernen, ohne ihnen jede mögliche Situation beibringen zu müssen, mit der sie konfrontiert werden könnten.

Googles Idee ist: Große Sprachmodelle können reichhaltiges semantisches Wissen über die Welt kodieren, was für Roboter, die für die Ausführung natürlicher Sprachaufgaben konzipiert sind, sehr nützlich ist. Das offensichtliche Manko von LLM ist „der Mangel an Erfahrung in der Praxis“. Im Labor funktioniert es zwar perfekt, im wirklichen Leben ist es jedoch möglicherweise nutzlos.

Daher empfehlen die Forscher „die Bereitstellung einer realen Grundlage durch Fähigkeiten vor dem Training“, um das Modell darauf zu beschränken, Aktionen in natürlicher Sprache auszuführen, die der Umgebung entsprechen.

Der Roboter kann als „Hände und Augen“ des Sprachmodells fungieren, während das Sprachmodell hochgradiges semantisches Wissen/reale Erfahrung über die Aufgabe bereitstellt.

Google nutzte eine riesige 6144-Prozessormaschine, um PaLM (Pathways Language Model) zu trainieren. Zu den Schulungsressourcen gehören eine große Sammlung mehrsprachiger Webdokumente auf der GitHub-Website von Microsoft, Bücher, Wikipedia-Artikel, Konversationen und Programmiercode. Der so trainierte KI-Agent kann Witze erklären, Sätze vervollständigen, Fragen beantworten und gemäß seiner eigenen Denkkette argumentieren.

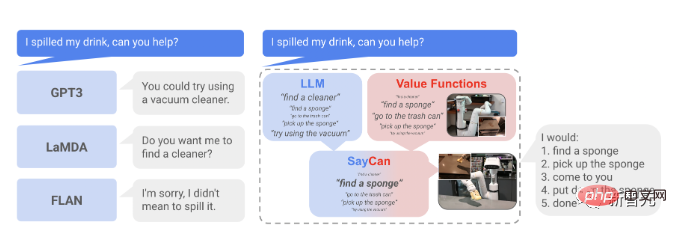

Die nächste Frage ist: Wenn dieser Agent in einem Roboter verwendet wird, wie kann dann das Wissen eines großen Sprachmodells (LLM) extrahiert und genutzt werden, um physische Aufgaben zu erledigen? Wenn zum Beispiel mein Getränk verschüttet wird, sagt GPT-3, dass Sie einen Staubsauger verwenden können, und LaMDA sagt: Muss ich einen Reiniger für Sie finden? (Es ist sehr verwirrend)

Das große Sprachmodell kann auf diesen Vorgang nicht reagieren, da es nicht mit der realen Umgebung interagiert. Die durch das LLM-basierte SayCan durch das vorab trainierte Modell gebildete Werturteilsfähigkeit kann Anweisungen in komplexen und realen Umgebungen verarbeiten.

Inspiriert von diesem Beispiel untersuchten wir das Problem, wie man in LLM Wissen extrahieren kann, um Robotern die Befolgung von Textanweisungen auf hoher Ebene zu ermöglichen. Der Roboter ist mit einer Reihe von Lernfähigkeiten für „atomare“ Verhaltensweisen ausgestattet, die eine visuomotorische Kontrolle auf niedrigem Niveau ermöglichen. Wir können den LLM nicht nur bitten, Anweisungen einfach zu erläutern, sondern können ihn auch verwenden, um die Wahrscheinlichkeit einzuschätzen, dass die Fähigkeiten einer Person Fortschritte bei der Bewältigung anspruchsvoller Anweisungen machen.

Unter der Annahme, dass jede Fertigkeit eine Affordanzfunktion hat, kann die Wahrscheinlichkeit ihres Erfolgs aus dem aktuellen Zustand quantifiziert werden (z. B. durch Erlernen der Wertfunktion), und dieser Wert kann die Wahrscheinlichkeit der Fertigkeit messen. Auf diese Weise vervollständigt LLM die Beschreibung der Wahrscheinlichkeit, dass jede Fertigkeit zum Vervollständigen von Anweisungen beiträgt.

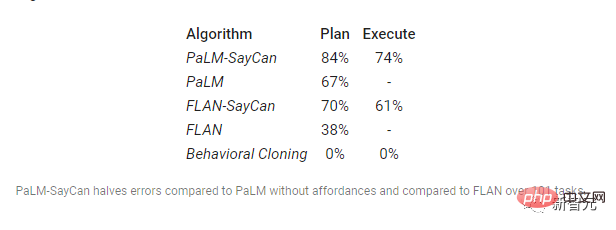

Die Forscher verwendeten zwei Metriken, um die Leistung des Systems zu bewerten:

(1) Planerfolgsrate, die angibt, ob der Roboter die richtige Fähigkeit für die Anweisung ausgewählt hat; 2) Ausführungserfolgsrate, die angibt, ob die Anweisung erfolgreich ausgeführt wurde.

Die Daten zeigen, dass die Befehlsausführungsrate von PaLM-SayCan auch die höchste unter allen Modellen ist.

Risiko: Was soll ich tun, wenn ich in der Robotik versage?

Die Idee ist großartig, aber diese Arbeit ist nicht ohne Risiken. Der Trainingskorpus großer Sprachmodelle stammt aus dem Internet, und einige Sprachmodelle weisen negative Tendenzen wie Rassismus oder Sexismus auf und werden manchmal dazu veranlasst, Hassreden oder Lügen zu veröffentlichen. Wenn dieses Modell verwendet wird, um einen Chatbot zu trainieren, wird das Ergebnis ein Sprachassistent sein, der fluchen und tratschen kann. Aber was wäre, wenn es verwendet würde, um einem Roboter beizubringen, der Hände und Füße hat, schlechte Dinge zu tun?Und was noch gefährlicher ist, ist, dass die Dinge außer Kontrolle geraten können, wenn der auf diese Weise trainierte Roboter das Bewusstsein erlangt (es gibt viele ähnliche Science-Fiction-Filme).

Im Juli dieses Jahres behauptete ein Google-Mitarbeiter, dass Software ein lebender Mitarbeiter sei. KI-Experten sind sich einig, dass diese Modelle nicht lebendig sind, aber viele befürchten, dass sie voreingenommen sein könnten, weil sie auf großen Mengen ungefilterten, von Menschen erstellten Texts trainiert werden.

Trotzdem arbeitet Google weiter hart und nun müssen Forscher nicht mehr für jede Aufgabe der Roboter spezifische technische Anweisungen codieren, sondern können einfacher in der Alltagssprache mit ihnen sprechen. Darüber hinaus kann die neue Software Roboter dabei unterstützen, komplexe mehrstufige Anweisungen selbstständig zu analysieren.

Jetzt können Roboter Anweisungen interpretieren, die sie noch nie zuvor gehört haben, und selbstständig sinnvolle Reaktionen und Aktionen entwickeln.

Vielleicht hat sich für Roboter gerade eine neue Tür geöffnet, und die Zukunft könnte noch ein langer Prozess sein. Techniken der künstlichen Intelligenz wie neuronale Netze und Reinforcement Learning werden seit Jahren zum Trainieren von Robotern eingesetzt. Es gab einige Durchbrüche, aber die Fortschritte sind immer noch langsam.

Der Roboter von Google ist noch lange nicht bereit für den realen Einsatz. Forscher haben wiederholt erklärt, dass sich der Roboter noch im Laborstadium befindet und keine Pläne hat, ihn zu kommerzialisieren.

Das obige ist der detaillierte Inhalt vonWenn Sie etwas zu sagen haben, sprechen Sie bitte! Der Google-Roboter kann selbstständig lernen und denken, nachdem er ein großes Sprachmodell „gefressen' hat. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr