Heim >häufiges Problem >TPU vs. GPU: Vergleichende Unterschiede in Leistung und Geschwindigkeit in tatsächlichen Szenarien

TPU vs. GPU: Vergleichende Unterschiede in Leistung und Geschwindigkeit in tatsächlichen Szenarien

- 王林nach vorne

- 2023-04-25 16:34:086245Durchsuche

In diesem Artikel werden wir einen Vergleich zwischen TPU und GPU durchführen. Aber bevor wir eintauchen, erfahren Sie hier, was Sie wissen müssen.

Maschinelles Lernen und künstliche Intelligenz beschleunigen die Entwicklung intelligenter Anwendungen. Zu diesem Zweck entwickeln Halbleiterunternehmen weiterhin Beschleuniger und Prozessoren, einschließlich TPUs und CPUs, um komplexere Anwendungen zu bewältigen.

Einige Benutzer haben Schwierigkeiten zu verstehen, wann eine TPU empfohlen wird und wann sie eine GPU zur Erledigung ihrer Computeraufgaben verwenden sollten.

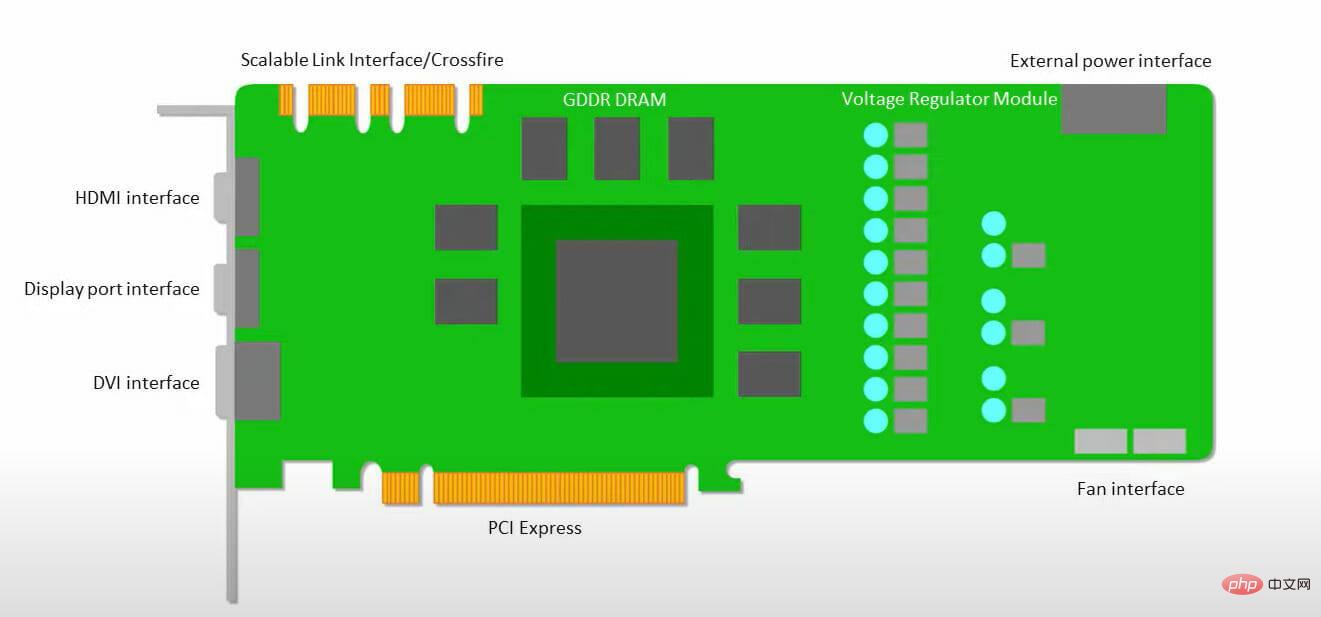

GPU, auch bekannt als Graphics Processing Unit, ist die Grafikkarte Ihres PCs, die Ihnen ein visuelles und immersives PC-Erlebnis bietet. Wenn Ihr PC beispielsweise die GPU nicht erkennt, können Sie einfache Schritte befolgen.

Um diese Situationen besser zu verstehen, müssen wir auch klären, was eine TPU ist und wie sie im Vergleich zu einer GPU abschneidet.

Was ist TPU?

Eine TPU oder Tensor Processing Unit ist ein anwendungsspezifischer integrierter Schaltkreis (IC), auch ASIC (Application Specific Integrated Circuit) genannt, der für eine bestimmte Anwendung verwendet wird. Google hat TPU von Grund auf entwickelt, 2015 mit der Nutzung begonnen und es 2018 der Öffentlichkeit zugänglich gemacht.

TPU verfügbar als Sekundärchip oder Cloud-Version. Um das maschinelle Lernen neuronaler Netze mithilfe der TensorFlow-Software zu beschleunigen, lösen Cloud-TPUs komplexe Matrix- und Vektoroperationen mit rasender Geschwindigkeit.

Mit TensorFlow hat das Google Brain-Team eine Open-Source-Plattform für maschinelles Lernen entwickelt, die es Forschern, Entwicklern und Unternehmen ermöglicht, KI-Modelle mithilfe von Cloud-TPU-Hardware zu erstellen und zu betreiben.

Beim Training komplexer und robuster neuronaler Netzwerkmodelle verkürzt TPU die Zeit, um genaue Werte zu erreichen. Das bedeutet, dass das Training eines Deep-Learning-Modells, das Wochen dauern kann, mit GPUs nur einen Bruchteil dieser Zeit in Anspruch nimmt.

Sind TPU und GPU gleich?

Sie sind architektonisch sehr unterschiedlich. Die Grafikverarbeitungseinheit ist ein eigenständiger Prozessor, obwohl sie in die vektorisierte numerische Programmierung eingebunden ist. GPUs sind eigentlich die nächste Generation von Cray-Supercomputern.

Die TPU ist ein Coprozessor, der keine Anweisungen selbst ausführt; der Code wird auf der CPU ausgeführt, was einen Fluss kleiner Operationen an die TPU ermöglicht.

Wann sollte ich TPU verwenden?

TPUs in der Cloud sind auf bestimmte Anwendungen zugeschnitten. In einigen Fällen bevorzugen Sie möglicherweise die Verwendung einer GPU oder CPU, um maschinelle Lernaufgaben auszuführen. Im Allgemeinen können Ihnen die folgenden Prinzipien dabei helfen, zu beurteilen, ob eine TPU die beste Wahl für Ihre Arbeitslast ist:

- Matrixberechnungen dominieren das Modell.

- Es gibt keine benutzerdefinierten TensorFlow-Operationen in der Haupttrainingsschleife des Modells.

- Es handelt sich um übertrainierte Modelle Wochen oder Monate

- Es handelt sich um große Modelle mit umfangreichen, effektiven Losgrößen.

Jetzt kommen wir direkt zum Vergleich zwischen TPU und GPU.

Was ist der Unterschied zwischen GPU und TPU?

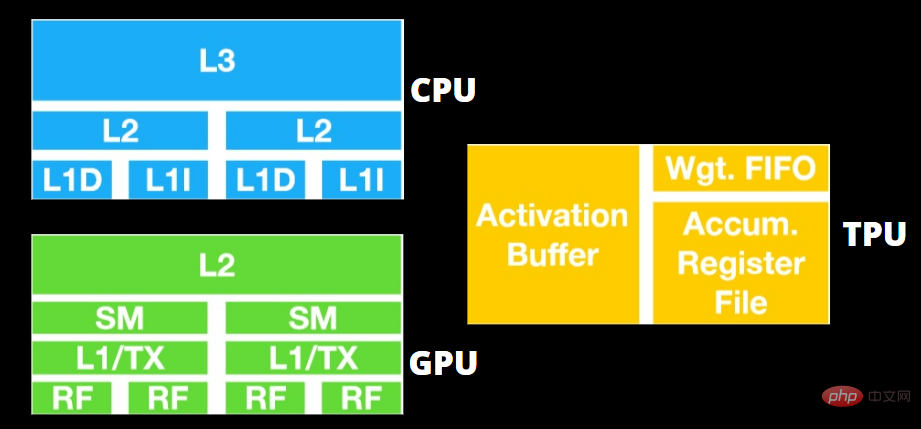

TPU vs. GPU-Architektur

TPU ist kein hochkomplexes Stück Hardware und fühlt sich eher wie eine Signalverarbeitungs-Engine für Radaranwendungen als wie eine traditionelle, von X86 abgeleitete Architektur an.

Obwohl es viele Matrixmultiplikationen und -divisionen gibt, ähnelt es eher einem Coprozessor als einer GPU; es führt nur vom Host empfangene Befehle aus.

Da so viele Gewichte in die Matrixmultiplikationskomponente eingegeben werden müssen, läuft der DRAM der TPU parallel als eine einzelne Einheit.

Da die TPU außerdem nur Matrixoperationen ausführen kann, ist die TPU-Karte mit dem CPU-basierten Hostsystem verbunden, um Aufgaben zu erledigen, die die TPU nicht bewältigen kann.

Der Host ist für die Datenübertragung an die TPU, die Vorverarbeitung und den Abruf detaillierter Informationen aus dem Cloud-Speicher verantwortlich.

Der GPU geht es mehr darum, verfügbare Kerne für die Anwendung zur Verfügung zu haben, als auf einen Cache mit geringer Latenz zuzugreifen.

Viele PCs (Prozessorcluster) mit mehreren SMs (Streaming-Multiprozessoren) werden zu einzelnen GPU-Geräten, wobei jeder SM eine Anweisungs-Cache-Schicht der ersten Ebene und zugehörige Kerne enthält.

Ein SM verwendet normalerweise zwei zwischengespeicherte gemeinsame Schichten und eine zwischengespeicherte private Schicht, bevor er Daten aus dem globalen GDDR-5-Speicher abruft. Die GPU-Architektur kann Speicherlatenz tolerieren.

GPU läuft mit einer minimalen Anzahl von Speicher-Cache-Ebenen. Da die GPU jedoch über mehr Transistoren für die Verarbeitung verfügt, ist die Zeit, die für den Zugriff auf Daten im Speicher benötigt wird, weniger wichtig.

Da die GPU immer mit genügend Berechnungen belegt ist, bleiben mögliche Verzögerungen beim Speicherzugriff verborgen.

TPU vs. GPU-Geschwindigkeit

Diese Original-TPU generiert gezielte Schlussfolgerungen mithilfe eines erlernten Modells anstelle eines trainierten Modells.

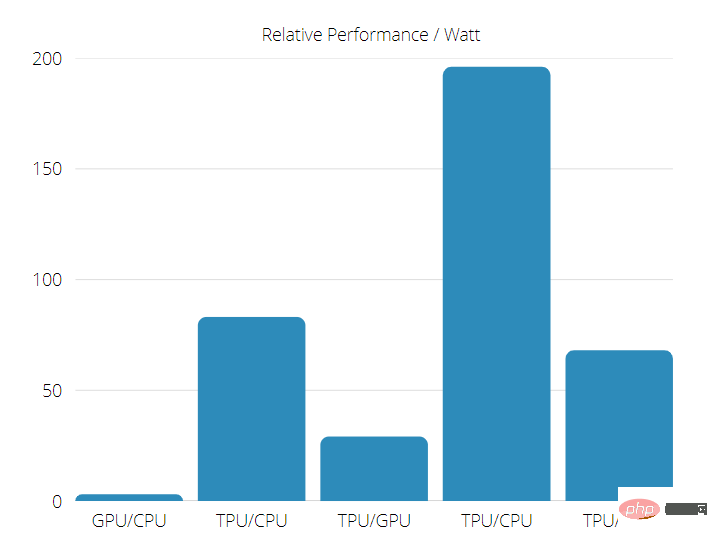

TPUs sind 15 bis 30 Mal schneller als aktuelle GPUs und CPUs in kommerziellen KI-Anwendungen, die neuronale Netzwerkinferenz verwenden.

Darüber hinaus ist TPU sehr energieeffizient, mit um das 30- bis 80-fache erhöhten TOPS/Watt-Werten.

Wenn man also einen Geschwindigkeitsvergleich zwischen TPU und GPU durchführt, stehen die Chancen zugunsten der Tensor Processing Unit.

TPU vs. GPU-Leistung

Die TPU ist eine Tensorverarbeitungsmaschine, die zur Beschleunigung von Tensorflow-Graphberechnungen entwickelt wurde.

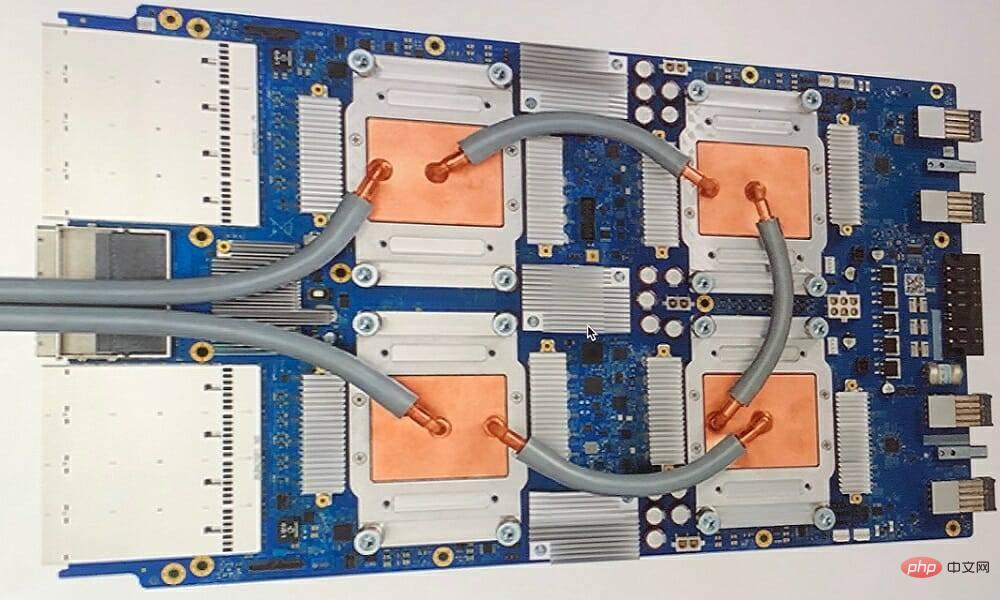

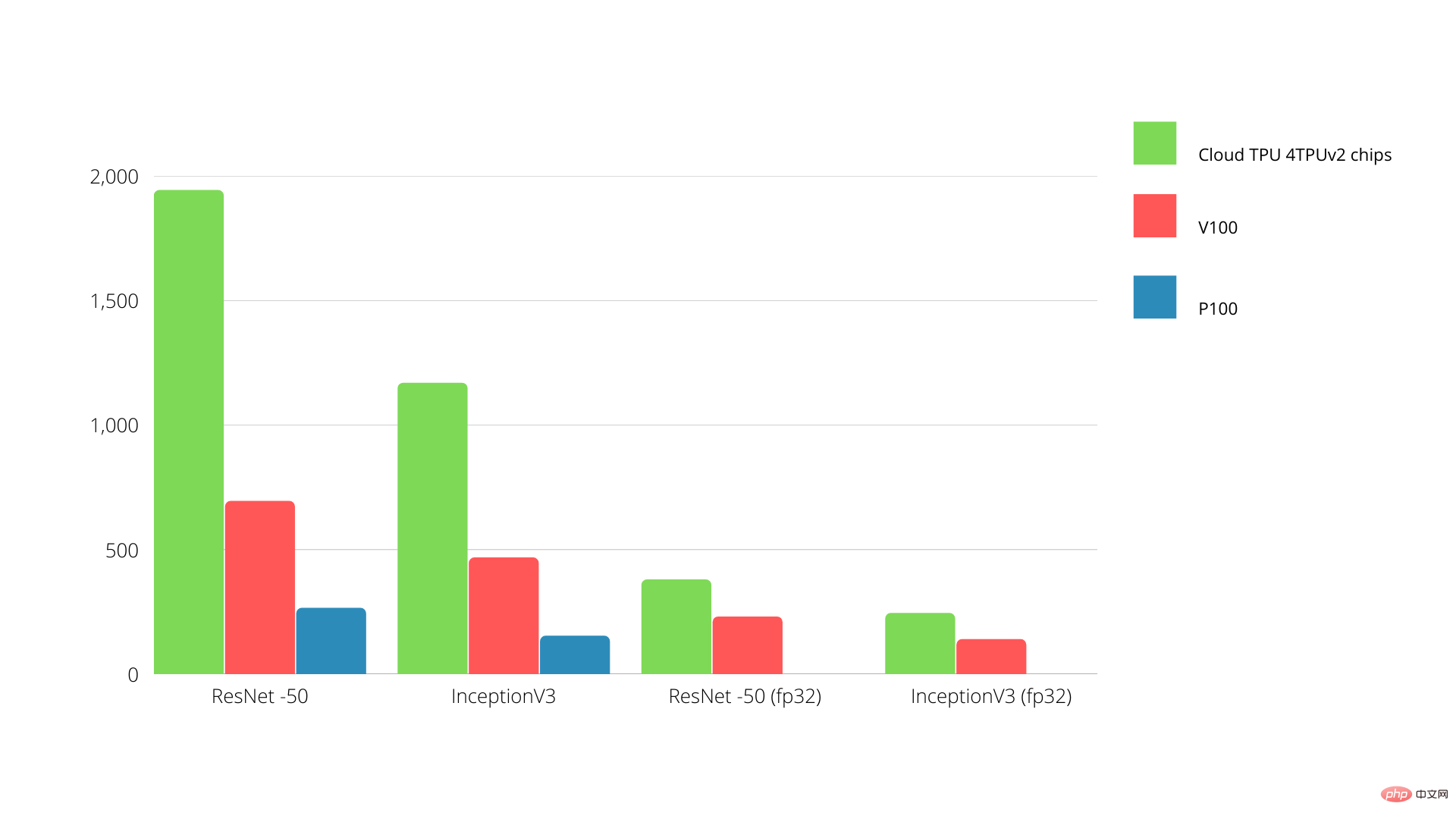

Jede TPU bietet bis zu 64 GB Speicher mit hoher Bandbreite und 180 Teraflops Gleitkommaleistung auf einer einzigen Platine.

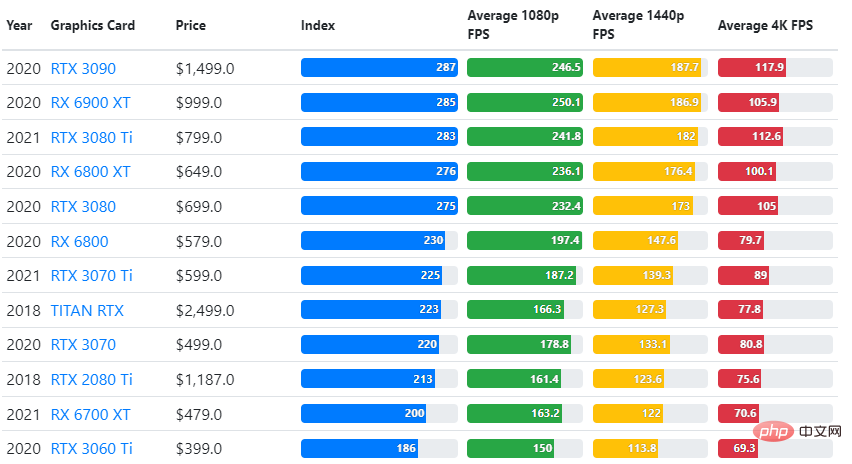

Der Vergleich zwischen Nvidia GPU und TPU ist unten dargestellt. Die Y-Achse stellt die Anzahl der Fotos pro Sekunde dar, während die X-Achse die verschiedenen Modelle darstellt.

TPU vs. GPU Machine Learning

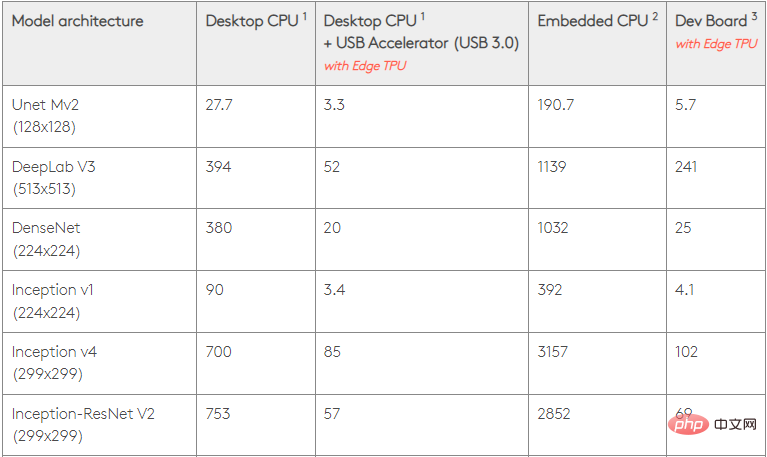

Hier sind die Trainingszeiten für CPU und GPU mit unterschiedlichen Batchgrößen und Iterationen pro Epoche:

- Anzahl der Iterationen/Epochen: 100, Batchgröße: 1000, Epochen insgesamt: 25, Parameter: 1,84 M, Modelltyp: Keras Mobilenet V1 (Alpha 0,75).

| Beschleuniger | GPU (NVIDIA K80) | Thermoplastisches Polyurethan |

| Trainingsgenauigkeit (%) | 96,5 | 94,1 |

| Überprüfungsgenauigkeit (%) | 65,1 | 68,6 |

| Zeit pro Iteration (ms) | 69 | 173 |

| Zeit pro Epoche (s) | 69 | 173 |

| Gesamtzeit (Minuten) | 3 072 |

- Iterationen/Epoche: 1000, Stapelgröße: 100, Gesamtepochen: 25, Parameter: 1,84 M und Modelltyp: Keras Mobilenet V1 (Alpha 0,75)

| GPU (NVIDIA K 80) | Thermoplastisches Polyurethan | |

| 97,4 | 96,9 | |

| 45,2 | 45,3. | |

| 185 | 252 |

Das obige ist der detaillierte Inhalt vonTPU vs. GPU: Vergleichende Unterschiede in Leistung und Geschwindigkeit in tatsächlichen Szenarien. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!