Heim >Technologie-Peripheriegeräte >KI >LeCun preist GPT-3.5 für 600 US-Dollar als Hardware-Ersatz an! Stanfords 7-Milliarden-Parameter „Alpaca' ist beliebt, LLaMA schneidet erstaunlich ab!

LeCun preist GPT-3.5 für 600 US-Dollar als Hardware-Ersatz an! Stanfords 7-Milliarden-Parameter „Alpaca' ist beliebt, LLaMA schneidet erstaunlich ab!

- 王林nach vorne

- 2023-04-23 16:04:081164Durchsuche

Als ich aufwachte, wurde das große Stanford-Modell Alpaka populär.

Ja, Alpaca ist ein brandneues Modell, das von Metas LLaMA 7B verfeinert wurde. Es verwendet nur 52.000 Daten und seine Leistung entspricht ungefähr GPT-3.5.

Der Schlüssel ist, dass die Schulungskosten extrem niedrig sind, weniger als 600 $. Die spezifischen Kosten sind wie folgt:

3 Stunden lang auf 8 A100 mit 80 GB trainiert, weniger als 100 US-Dollar;

generierte Daten mit der OpenAI-API, 500 US-Dollar.

Percy Liang, außerordentlicher Professor für Informatik an der Stanford University, sagte: Der Mangel an Transparenz/die Unfähigkeit, vollständig auf leistungsfähige Unterrichtsmodelle wie GPT 3.5 zuzugreifen, hat die akademische Forschung in diesem wichtigen Bereich eingeschränkt. Mit Alpaca (LLaMA 7B + text-davinci-003) haben wir einen kleinen Schritt nach vorne gemacht.

Als Yann LeCun sah, dass jemand anderes neue Ergebnisse an seinem eigenen großen Modell erzielt hat, hat er es wie verrückt retweetet (die Werbung muss vorhanden sein).

Feinabstimmung von 7 Milliarden Parametern in 3 Stunden, 600 USD

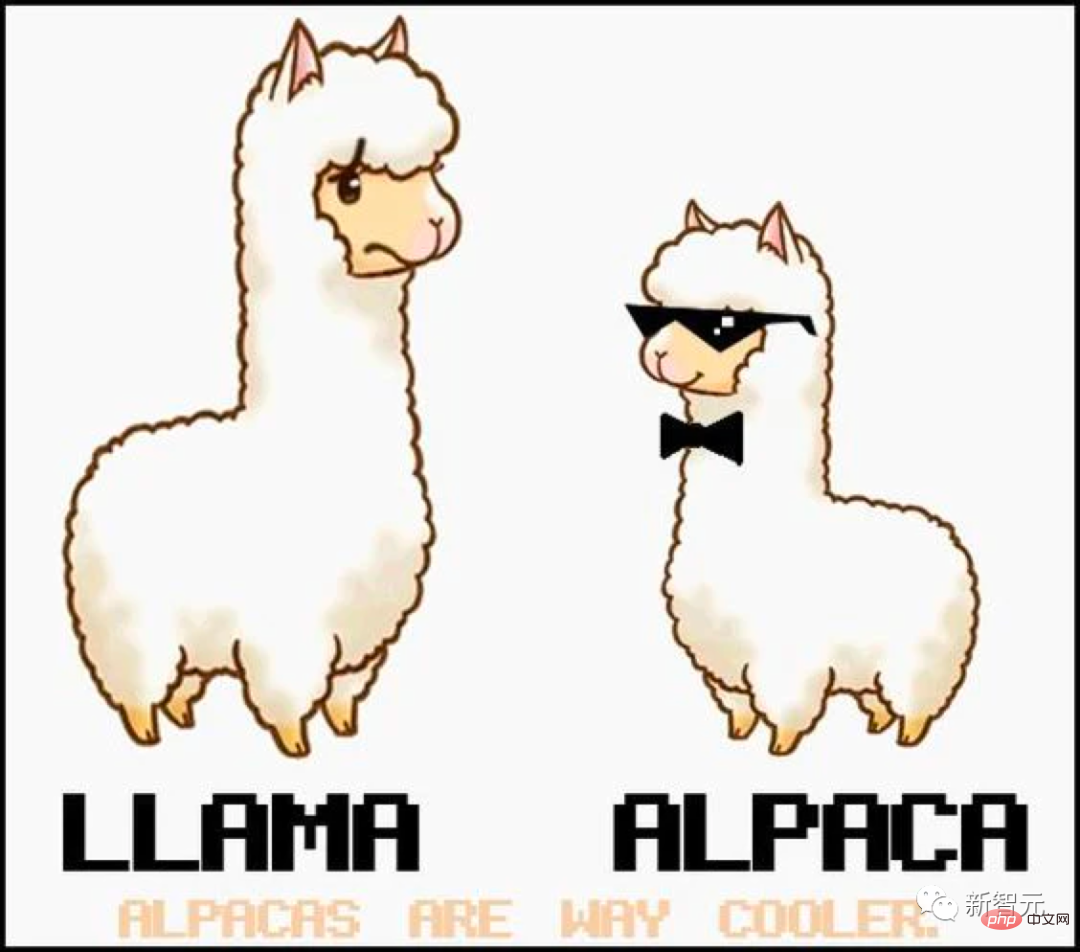

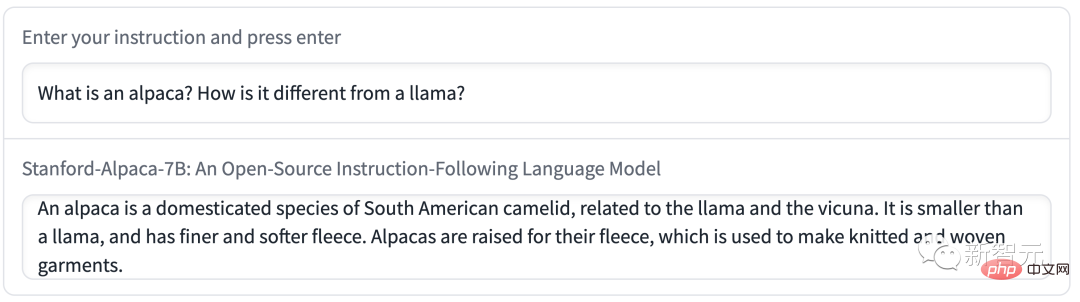

Ohne weitere Umschweife, probieren wir es zuerst aus.

F: Erzähl mir etwas über Alpakas.

A: Alpakas sind eine Kamelart aus Südamerika, verwandt mit Lamas und Kamelen. Sie werden oft wegen ihrer Fasern gezüchtet und zur Herstellung von Luxusgütern wie Pullovern und Decken verwendet. Alpakas sind aufgrund ihres sanften und freundlichen Wesens auch beliebte Haustiere.

Experience-Link: https://crfm.stanford.edu/alpaca/

Für das Team in Stanford, das innerhalb eines Budgets einen qualitativ hochwertigen Unterricht erteilen möchte Wenn Sie dem Modell folgen, müssen Sie sich zwei wichtigen Herausforderungen stellen: einem leistungsstarken vorab trainierten Sprachmodell und hochwertigen Daten zur Befehlskonformität.

Genau, das LLaMA-Modell, das akademischen Forschern zur Verfügung gestellt wurde, löste das erste Problem.

Für die zweite Herausforderung gab der Artikel „Selbstunterricht: Sprachmodell mit selbst generierten Anweisungen ausrichten“ eine gute Inspiration, nämlich die Verwendung bestehender starker Sprachmodelle zur automatischen Generierung von Unterrichtsdaten.

Die größte Schwäche des LLaMA-Modells ist jedoch die fehlende Feinabstimmung der Anleitung. Eine der größten Innovationen von OpenAI ist die Verwendung der Befehlsoptimierung auf GPT-3.

In diesem Zusammenhang nutzte Stanford ein vorhandenes großes Sprachmodell, um automatisch Demonstrationen der folgenden Anweisungen zu generieren.

Zunächst einmal 175 manuell geschriebene „Anweisungen-Ausgabe“ aus der selbstgenerierten Anweisung Seed-Set Zunächst verwendet tip text-davinci-003 ein Seed-Set als kontextbezogenes Beispiel, um weitere Anweisungen zu generieren.

Die Methode zur Selbstgenerierung von Anweisungen wurde durch Vereinfachung der Generierungspipeline verbessert, was die Kosten erheblich senkt. Während des Datengenerierungsprozesses wurden 52.000 eindeutige Anweisungen und entsprechende Ausgaben erzeugt, was mit der OpenAI-API weniger als 500 US-Dollar kostete.

Mit diesem Anweisungsfolge-Datensatz nutzten die Forscher das Trainingsframework von Hugging Face, um das LLaMA-Modell zu verfeinern und dabei die gesamten Technologien zu nutzen wie Sharded Data Parallelism (FSDP) und Mixed Precision Training.

Außerdem dauerte die Feinabstimmung eines 7B LLaMA-Modells auf 8 80-GB-A100s über 3 Stunden, bei den meisten Clouds. Die Kosten stammen aus der Rechenleistung Anbieter kostet weniger als 100 US-Dollar. Um Alpaca zu evaluieren, werteten Stanford-Forscher den selbst generierten Befehlssatz aus. Die Eingaben wurden manuell ausgewertet (von 5 studentischen Autoren).

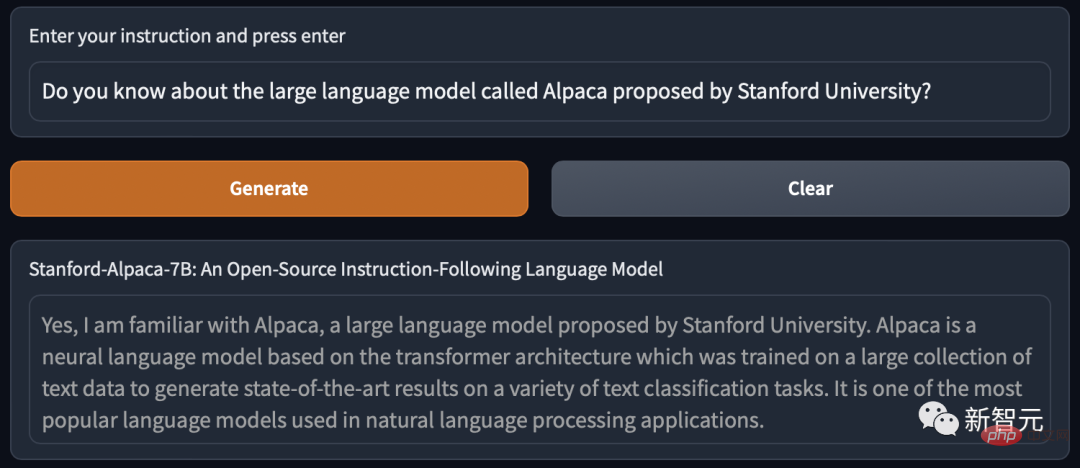

Diese Reihe von Rezensionen wurde von selbst erstellten Anleitungsautoren gesammelt und deckt ein breites Spektrum an benutzerorientierten Anleitungen ab, einschließlich E-Mail-Schreiben , Social Media und Produktivitätstools usw. Sie verglichen GPT-3.5 (text-davinci-003) und Alpaca 7B und fanden die Leistung dieser beiden Modelle sehr ähnlich. Alpaca gewinnt 90 zu 89 Mal gegen GPT-3.5.

Angesichts der geringen Größe des Modells und der geringen Menge an Anleitungsdaten ist dieses Ergebnis ziemlich erstaunlich.

Zusätzlich zur Verwendung dieses statischen Bewertungssatzes führten sie auch interaktive Tests am Alpaka-Modell durch und stellten fest, dass die Leistung von Alpaka bei verschiedenen Eingaben Die Leistung ist tendenziell ähnlich wie bei GPT-3.5.

Demo in Stanford mit Alpaka: #🎜🎜 #

Demo 1 Lassen Sie Alpaka über den Unterschied zwischen ihm und LLaMA sprechen.

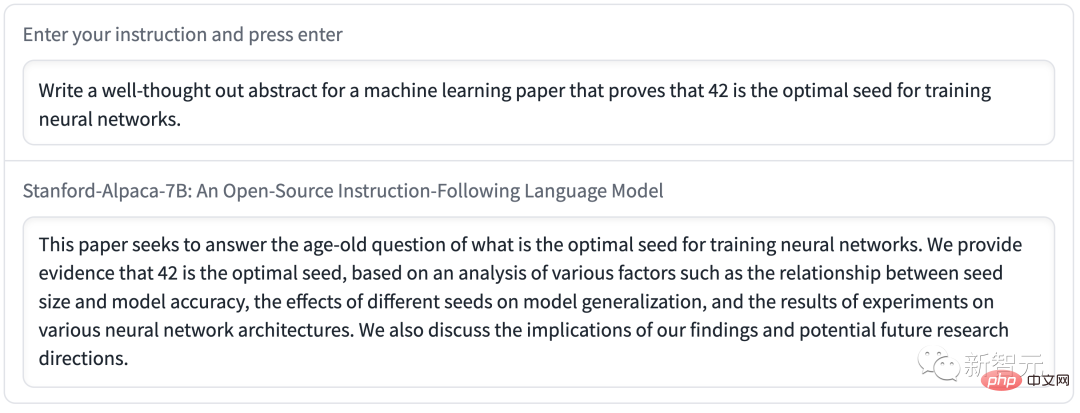

Demo 2 wurde von Alpaca geschrieben Eine E-Mail, deren Inhalt prägnant und klar ist und auch das Format sehr standardisiert ist. Wie aus dem zu sehen ist Im obigen Beispiel sind die Ausgabeergebnisse von Alpaca im Allgemeinen gut geschrieben und die Antworten sind normalerweise kürzer als bei ChatGPT, was den kürzeren Ausgabestil von GPT-3.5 widerspiegelt.

Natürlich weist Alpaka häufige Mängel in Sprachmodellen auf.

Darüber hinaus kann Alpaka viele Einschränkungen im Zusammenhang mit dem zugrunde liegenden Sprachmodell und der Anleitung haben. Tuning-Daten. Alpaca stellt uns jedoch ein relativ leichtes Modell zur Verfügung, das die Grundlage für zukünftige Untersuchungen wichtiger Mängel in größeren Modellen bilden kann.

Derzeit hat Stanford nur die Trainingsmethoden und -daten von Alpaca bekannt gegeben und plant, die Gewichte des Modells in Zukunft zu veröffentlichen.

Alpaka darf jedoch nicht für kommerzielle Zwecke und nur für die akademische Forschung verwendet werden. Es gibt drei spezifische Gründe:

1. LLaMA ist ein nicht kommerziell lizenziertes Modell, und Alpaca wird auf der Grundlage dieses Modells generiert. #🎜🎜 #

2. Die Anweisungsdaten basieren auf OpenAIs text-davinci-003, dessen Nutzungsbedingungen die Entwicklung konkurrierender Modelle verbieten mit OpenAI;

3 Es wurden nicht genügend Sicherheitsmaßnahmen entwickelt, daher ist Alpaca nicht für den breiten Einsatz bereit# 🎜🎜##🎜 🎜# Darüber hinaus haben Stanford-Forscher drei Richtungen für die zukünftige Forschung zu Alpakas zusammengefasst.

Bewertung:

- Beginnen Sie mit HELM (Holistic Evaluation of Language Models), um generativere, anweisungenfolgende Szenarien zu erfassen. #🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜#Sicherheit:#🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜##

Weitere Erforschung der Risiken von Alpakas und Verbesserung seiner Sicherheit mithilfe von Methoden wie automatisiertem Red Teaming, Auditing und adaptiven Tests.

- Verstehen: #🎜🎜 #

Großes Modell der stabilen Diffusion

- Jetzt wird Stanford „Alpaca“ direkt als „Alpaca“ angesehen von Netizens Stable Diffusion of Text Large Models".

Seit dem Aufkommen von ChatGPT sind viele Menschen über die eingebauten Einschränkungen von KI-Modellen frustriert. Diese Einschränkungen verhindern, dass ChatGPT Themen bespricht, die OpenAI als sensibel erachtet.

Daher hofft die KI-Community auf ein Open-Source-LLM (Large Language Model), das jeder ohne Zensur lokal ausführen kann und es müssen keine API-Gebühren an OpenAI gezahlt werden.

Es gibt auch große Open-Source-Modelle wie dieses, wie zum Beispiel GPT-J, aber der einzige Nachteil ist, dass sie viel erfordern GPU-Speicher und Speicherplatz.

Andererseits können andere Open-Source-Alternativen auf handelsüblicher Consumer-Hardware keine Leistung auf GPT-3-Niveau vorweisen .

Ende Februar brachte Meta das neueste Sprachmodell LLaMA auf den Markt, mit Parameterbeträgen von 7 Milliarden (7B) und 13 Milliarden (13B)), 33 Milliarden (33B) und 65 Milliarden (65B). Die Auswertungsergebnisse zeigen, dass die 13B-Version mit GPT-3 vergleichbar ist.

Papieradresse: https://research.facebook.com/publications/llama-open-and-efficient-foundation-Language-Models/# 🎜🎜#

Obwohl Meta den Quellcode für Forscher geöffnet hat, die den Antrag bestanden haben, war es unerwartet, dass Internetnutzer das Gewicht von LLaMA erstmals auf GitHub preisgaben.

Seitdem ist die Entwicklung rund um LLaMA-Sprachmodelle explodiert.

Normalerweise erfordert die Ausführung von GPT-3 mehrere A100-GPUs der Rechenzentrumsqualität, außerdem sind die Gewichtungen für GPT-3 nicht öffentlich.

Netizens begannen, das LLaMA-Modell selbst zu betreiben, was für Aufsehen sorgte.

LLaMA optimiert die Modellgröße durch Quantisierungstechniken und ist jetzt sogar auf M1-Macs, kleineren Nvidia-Consumer-GPUs und Pixel-6-Telefonen verfügbar läuft auf einem Raspberry Pi.

Netizens haben einige der Ergebnisse zusammengefasst, die jeder mit LLaMA seit der Veröffentlichung von LLaMA bis heute erzielt hat: #🎜 🎜#

LLaMA wurde am 24. Februar veröffentlicht und steht Forschern und Einrichtungen in Regierung, Gemeinschaft und Wissenschaft unter einer nichtkommerziellen Lizenz zur Verfügung; 🎜#Am 2. März haben 4chan-Internetnutzer alle LLaMA-Modelle durchgesickert;

Am 10. März hat Georgi Gerganov das Tool llama.cpp erstellt, das LLaMA auf einem Mac ausführen kann, der mit einem M1/M2-Chip ausgestattet ist; 🎜#11. März: 7B-Modell kann über llama.cpp auf 4 GB RaspberryPi ausgeführt werden, aber die Geschwindigkeit ist relativ langsam, nur 10 Sekunden/Token; #12. März: LLaMA 7B wurde erfolgreich auf einem node.js-Ausführungstool NPX ausgeführt; 13: llama.cpp kann auf Pixel 6-Telefonen ausgeführt werden; Stanford Alpaca „Alpaka“ veröffentlicht. Noch eine Sache.#🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜#viele Internetnutzer laut sind, klicken Sie. Es erfolgt keine Antwort von „Generieren“ und andere warten in der Schlange, um zu spielen.

Das obige ist der detaillierte Inhalt vonLeCun preist GPT-3.5 für 600 US-Dollar als Hardware-Ersatz an! Stanfords 7-Milliarden-Parameter „Alpaca' ist beliebt, LLaMA schneidet erstaunlich ab!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr