Heim >Technologie-Peripheriegeräte >KI >Das weltweit erste wirklich Open-Source-ChatGPT-Großmodell Dolly 2.0, das nach Belieben für die kommerzielle Nutzung modifiziert werden kann

Das weltweit erste wirklich Open-Source-ChatGPT-Großmodell Dolly 2.0, das nach Belieben für die kommerzielle Nutzung modifiziert werden kann

- WBOYnach vorne

- 2023-04-22 12:28:081614Durchsuche

Wie wir alle wissen, ist OpenAI nicht offen, wenn es um ChatGPT geht. Die Open-Source-Modelle der Alpaca-Serie sind aufgrund von Problemen wie Datensätzen auch „auf akademische Forschungsanwendungen beschränkt“. Um Einschränkungen zu umgehen, ist hier ein großes Modell, das sich auf 100 % Open Source konzentriert.

Am 12. April veröffentlichte Databricks Dolly 2.0, eine weitere neue Version des ChatGPT-ähnlichen Large Language Model (LLM), das der menschlichen Interaktivität (Anweisungen folgt) ähnelt und vor zwei Wochen veröffentlicht wurde.

Databricks sagt, dass Dolly 2.0 das erste richtlinienkonforme Open-Source-LLM der Branche ist, das auf einem transparenten und frei verfügbaren Datensatz basiert, der ebenfalls Open Source ist und für kommerzielle Zwecke verfügbar ist. Dies bedeutet, dass Dolly 2.0 zum Erstellen kommerzieller Anwendungen verwendet werden kann, ohne für den API-Zugriff bezahlen oder Daten mit Dritten teilen zu müssen.

- Projektlink: https://huggingface.co/databricks/dolly-v2-12b

- Datensatz: https://github.com/databrickslabs/dolly/tree/ master /data

Laut Ali Ghodsi, CEO von Databricks, gibt es zwar andere große Modelle, die für kommerzielle Zwecke genutzt werden können, „sie sprechen jedoch nicht wie Dolly 2.0 mit Ihnen.“ Und basierend auf dem Dolly 2.0-Modell: Benutzer können die Trainingsdaten ändern und verbessern, da sie unter einer Open-Source-Lizenz frei verfügbar sind. So können Sie Ihre eigene Version von Dolly erstellen.

Databricks hat auch den Datensatz veröffentlicht, an dem Dolly 2.0 verfeinert wurde, mit dem Namen databricks-dolly-15k. Dabei handelt es sich um einen Korpus aus mehr als 15.000 Datensätzen, der von Tausenden von Databricks-Mitarbeitern generiert wurde. Databricks nennt ihn „den ersten von Menschen erstellten Open-Source-Anweisungskorpus, der speziell entwickelt wurde, um großen Sprachen die Demonstration der magischen Interaktivität von ChatGPT zu ermöglichen“

Wie Dolly 2.0 geboren wurde

In den letzten zwei Monaten haben Industrie und Wissenschaft OpenAI eingeholt und eine Welle von ChatGPT-ähnlichen großen Modellen vorgeschlagen, die Anweisungen befolgen. Diese Versionen werden von vielen Definitionen als Open Source (bzw Sorgen Sie für ein gewisses Maß an Offenheit oder eingeschränkten Zugang. Unter ihnen hat Metas LLaMA die meiste Aufmerksamkeit auf sich gezogen, was zu einer großen Anzahl weiter verbesserter Modelle geführt hat, wie zum Beispiel Alpaca, Koala, Vicuna und Databricks‘ Dolly 1.0.

Aber andererseits unterliegen viele dieser „offenen“ Modelle „industriellen Zwängen“, weil sie auf Datensätzen trainiert werden, deren Begriffe darauf ausgelegt sind, die kommerzielle Nutzung einzuschränken – wie etwa die 52.000 Frage- und Antwortdaten des StanfordAlpaca-Projekts set wird basierend auf der Ausgabe von OpenAIs ChatGPT trainiert. Und die Nutzungsbedingungen von OpenAI enthalten eine Regel, die besagt, dass Sie die Dienste von OpenAI nicht nutzen dürfen, um mit ihnen zu konkurrieren.

Databricks dachte über einen Weg nach, dieses Problem zu lösen: Der neu vorgeschlagene Dolly 2.0 ist ein 12-Milliarden-Parameter-Sprachmodell, das auf der Open-Source-Pythia-Modellreihe EleutherAI basiert und speziell für eine kleine Open-Source-Anweisung optimiert ist Datensatzkorpus (databricks-dolly- 15k), dieser Datensatz wurde von Databricks-Mitarbeitern erstellt und die Lizenzbedingungen erlauben die Nutzung, Änderung und Erweiterung für jeden Zweck, einschließlich akademischer oder kommerzieller Anwendungen.

Bisher befanden sich Modelle, die auf die Ausgabe von ChatGPT trainiert wurden, in einer rechtlichen Grauzone. „Die gesamte Community ist um dieses Problem herumgeschlichen und jeder bringt diese Modelle auf den Markt, aber keines davon ist im Handel erhältlich“, sagte Ghodsi. „Deshalb sind wir so aufgeregt.“

„Alle anderen wollen größer werden, aber wir sind eigentlich an etwas Kleinerem interessiert“, sagte Ghodsi über Dollys Miniaturwaage. „Zweitens haben wir alle Antworten durchgesehen und sie waren von hoher Qualität.“

Ghodsi sagte, er glaube, dass Dolly 2.0 einen „Schneeball“-Effekt auslösen werde, der es anderen im Bereich der künstlichen Intelligenz ermöglichen würde, mitzumachen und andere Alternativen vorzuschlagen . Er erklärte, dass Beschränkungen der kommerziellen Nutzung eine große Hürde seien, die es zu überwinden gilt: „Wir sind jetzt begeistert, weil wir endlich einen Weg gefunden haben, das Problem zu umgehen. Ich garantiere Ihnen, dass Sie Leute sehen werden, die diese 15.000 Probleme auf die reale Welt anwenden. Jedes Modell da.“ Das heißt, sie werden sehen, wie viele dieser Modelle plötzlich ein wenig magisch werden und man mit ihnen interagieren kann.“

Hand-Rubbing-Datensatz

Um die Gewichte für das Dolly 2.0-Modell herunterzuladen, besuchen Sie einfach die Databricks Hugging Face-Seite und besuchen Sie das Dolly-Repo von databricks-labs, um den Datensatz databricks-dolly-15k herunterzuladen.

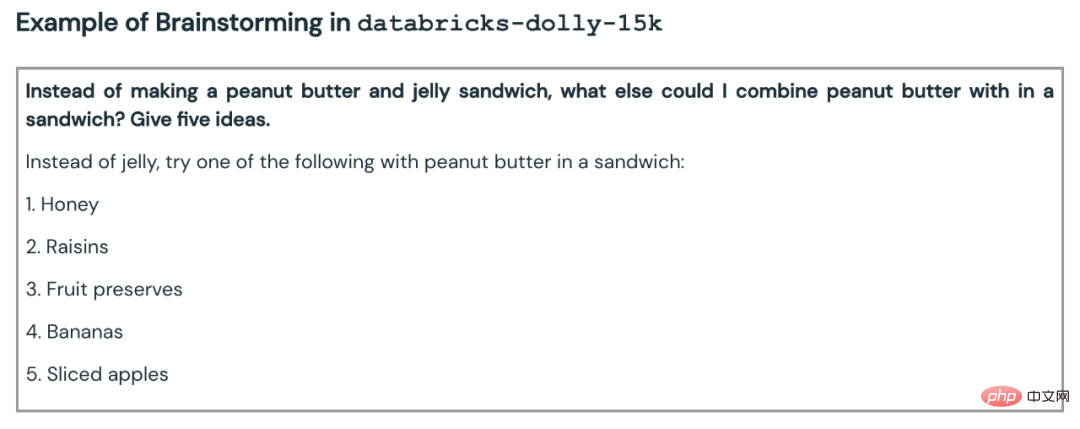

Der Datensatz „databricks-dolly-15k“ enthält 15.000 hochwertige, von Menschen generierte Eingabeaufforderungs-/Antwortpaare, geschrieben von mehr als 5.000 Databricks-Mitarbeitern im März und April 2023, speziell entwickelte Anweisungen zum Optimieren großer Sprachmodelle . Diese Trainingsaufzeichnungen sind natürlich, ausdrucksstark und so konzipiert, dass sie ein breites Spektrum an Verhaltensweisen abbilden, vom Brainstorming und der Inhaltserstellung bis hin zur Informationsextraktion und -zusammenfassung.

Gemäß den Lizenzbedingungen dieses Datensatzes (Creative Commons Attribution-ShareAlike 3.0 Unported License) kann jeder diesen Datensatz für jeden Zweck, einschließlich kommerzieller Anwendungen, nutzen, ändern oder erweitern.

Derzeit ist dieser Datensatz der erste von Menschen erstellte Open-Source-Anweisungsdatensatz .

Warum so einen Datensatz erstellen? Das Team erklärte in einem Blogbeitrag auch, warum.

Ein wichtiger Schritt bei der Erstellung von Dolly 1.0 oder jeder Direktive, die LLM folgt, besteht darin, das Modell anhand eines Datensatzes aus Direktiven- und Antwortpaaren zu trainieren. Das Training von Dolly 1.0 kostet 30 US-Dollar und verwendet einen Datensatz, der vom Alpaca-Team der Stanford University mithilfe der OpenAI-API erstellt wurde.

Nachdem Dolly 1.0 veröffentlicht wurde, wollten viele Leute es ausprobieren, und einige Benutzer wollten dieses Modell auch kommerziell nutzen.

Aber der Trainingsdatensatz enthält die Ausgabe von ChatGPT, und wie das Stanford-Team betont, versuchen die Nutzungsbedingungen zu verhindern, dass irgendjemand ein Modell erstellt, das mit OpenAI konkurriert.

Bisher unterlagen alle bekannten Richtlinienkonformitätsmodelle (Alpaca, Koala, GPT4All, Vicuna) dieser Einschränkung: Die kommerzielle Nutzung war verboten. Um dieses Problem zu lösen, begann Dollys Team nach Möglichkeiten zu suchen, einen neuen Datensatz ohne Einschränkungen bei der kommerziellen Nutzung zu erstellen.

Konkret erfuhr das Team aus einem von OpenAI veröffentlichten Forschungspapier, dass das ursprüngliche InstructGPT-Modell anhand eines Datensatzes trainiert wurde, der aus 13.000 Verhaltensdemonstrationen bei der Befolgung von Anweisungen bestand. Davon inspiriert machten sie sich unter der Leitung von Databricks-Mitarbeitern daran, ähnliche Ergebnisse zu erzielen.

Es stellt sich heraus, dass das Generieren von 13.000 Fragen und Antworten schwieriger ist als gedacht. Denn jede Antwort muss original sein und darf nicht von ChatGPT oder irgendwo im Web kopiert werden, da sonst der Datensatz „verschmutzt“ wird. Aber Databricks hat mehr als 5.000 Mitarbeiter und sie waren sehr an LLM interessiert. Deshalb führte das Team ein Crowdsourcing-Experiment durch, bei dem ein Datensatz mit höherer Qualität erstellt wurde als der, den 40 Annotatoren für OpenAI erstellt hatten.

Natürlich ist diese Arbeit zeit- und arbeitsintensiv. Um alle zu motivieren, hat das Team einen Wettbewerb ins Leben gerufen, bei dem die besten 20 Kommentatoren Überraschungspreise erhalten. Gleichzeitig listeten sie auch 7 ganz konkrete Aufgaben auf:

- Offene Fragen und Antworten: Zum Beispiel: „Warum mögen die Leute Comedy-Filme?“ oder „Was ist die Hauptstadt Frankreichs?“ andere müssen auf das Wissen der ganzen Welt zurückgreifen;

- Geschlossene Fragen und Antworten: Diese Fragen können mit nur einem Absatz an Informationen aus der Referenz beantwortet werden. Wenn man beispielsweise einen Wikipedia-Absatz über Atome betrachtet, könnte man fragen: „Wie ist das Verhältnis von Protonen zu Neutronen im Kern?“; : Hier kopiert der Annotator einen Absatz aus Wikipedia und extrahiert Entitäten oder andere sachliche Informationen aus dem Absatz, wie z. B. Gewicht oder Maße; #Informationen auf Wikipedia zusammenfassend: Dazu wurde den Annotatoren eine Passage aus Wikipedia zur Verfügung gestellt und gebeten, diese zu destillieren eine kurze Zusammenfassung;

- #🎜🎜 #Brainstorming: Diese Aufgabe erfordert eine offene Ideenfindung und eine Liste möglicher Optionen. Zum Beispiel: „Welche lustigen Aktivitäten kann ich dieses Wochenende mit meinen Freunden unternehmen?“; Treffen Sie Urteile (z. B. ob es sich bei den Elementen in einer Liste um Tiere, Mineralien oder Gemüse handelt) oder beurteilen Sie die Attribute einer Passage, z. B. die Stimmung eines Filmrezension;

- Kreatives Schreiben: Zu den Aufgaben gehört das Schreiben von etwas wie einem Gedicht oder einem Liebesbrief.

- Hier einige Beispiele:

- # 🎜🎜#

- Das Team war zunächst skeptisch, 10.000 Ergebnisse zu erreichen. Aber mit dem nächtlichen Bestenlistenspiel gelang es, in einer Woche 15.000 Ergebnisse zu erzielen.

Dann brach das Team das Spiel ab, weil es Bedenken hatte, „die Produktivität der Mitarbeiter zu binden“ (was Sinn macht).

Kommerzielle Machbarkeit

Nachdem der Datensatz schnell erstellt war, begann das Team, über kommerzielle Anwendungen nachzudenken.

Sie wollen ein Open-Source-Modell erstellen, das kommerziell genutzt werden kann. Obwohl databricks-dolly-15k viel kleiner ist als Alpaca (der Datensatz, auf dem Dolly 1.0 trainiert wurde), weist das auf EleutherAI pythia-12b basierende Dolly 2.0-Modell ein qualitativ hochwertiges Befehlsfolgeverhalten auf.

Im Nachhinein ist das nicht überraschend. Schließlich enthalten viele in den letzten Monaten veröffentlichte Datensätze zur Befehlsoptimierung synthetische Daten, die häufig Halluzinationen und sachliche Fehler enthalten.

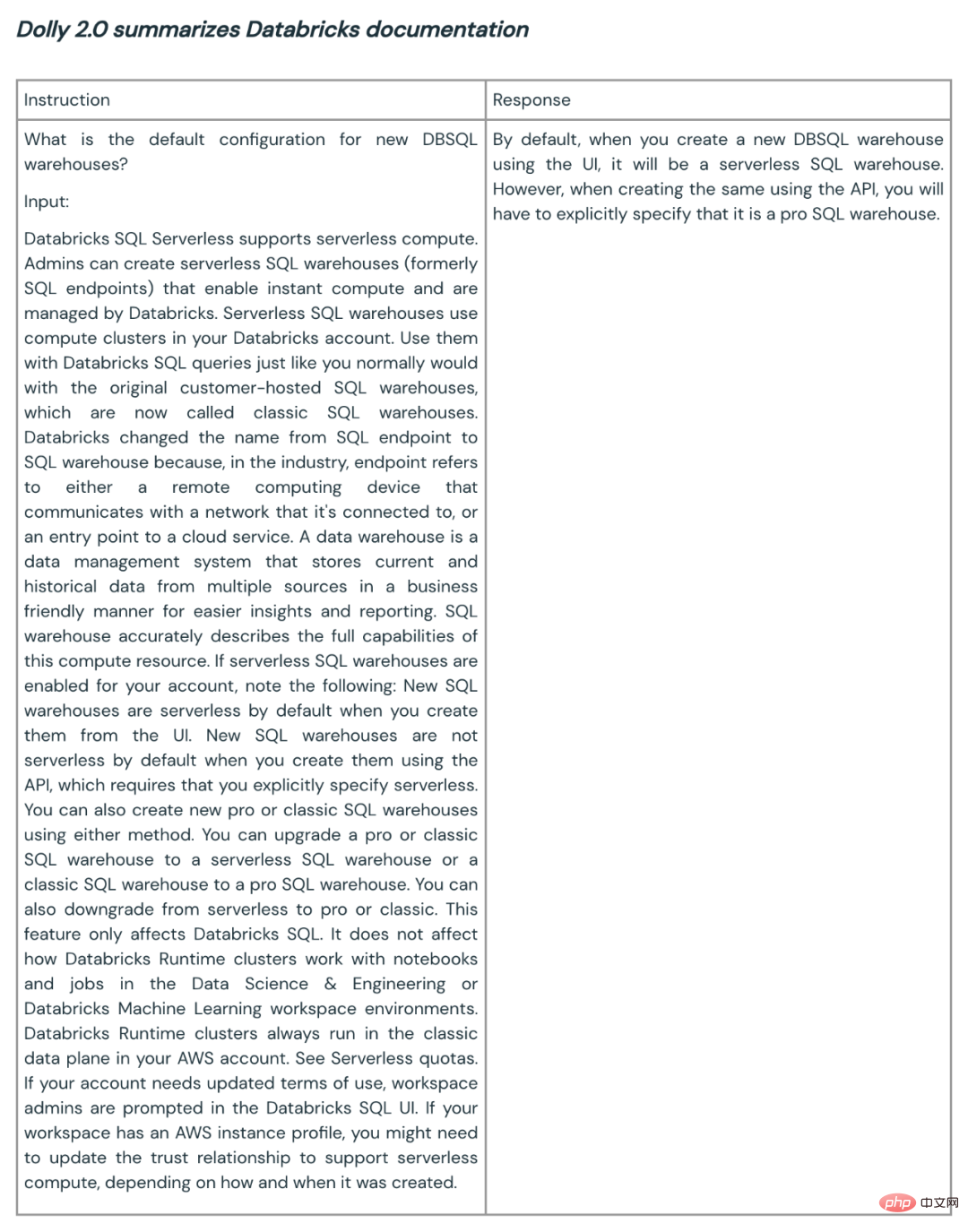

databricks-dolly-15k hingegen wird von Profis erstellt, ist von hoher Qualität und enthält ausführliche Antworten auf die meisten Aufgaben.Hier sind einige Beispiele für die Verwendung von Dolly 2.0 zur Zusammenfassung und Inhaltserstellung:

#🎜🎜 #

Dolly Das Team sagt, dass basierend auf dem ersten Kundenfeedback solche Funktionen verfügbar sein könnten im gesamten Unternehmen für eine Vielzahl von Anwendungen. Denn viele Unternehmen hoffen, über eigene Modelle zu verfügen, um qualitativ hochwertigere Modelle für ihre eigenen spezifischen Domänenanwendungen zu erstellen, anstatt ihre sensiblen Daten an Dritte weiterzugeben.

Die Open Source von Dolly 2 ist ein guter Anfang für den Aufbau eines besseren Ökosystems für große Modelle. Open-Source-Datensätze und -Modelle fördern Kommentare, Forschung und Innovation und tragen dazu bei, dass jeder von den Fortschritten in der KI-Technologie profitiert. Das Dolly-Team geht davon aus, dass das neue Modell und der Open-Source-Datensatz als Grundlage für zahlreiche Folgearbeiten dienen und zu leistungsfähigeren Sprachmodellen führen werden.

Das obige ist der detaillierte Inhalt vonDas weltweit erste wirklich Open-Source-ChatGPT-Großmodell Dolly 2.0, das nach Belieben für die kommerzielle Nutzung modifiziert werden kann. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr