Heim >Technologie-Peripheriegeräte >KI >Spärliche und dichte Merkmale

Spärliche und dichte Merkmale

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-21 11:19:081884Durchsuche

Beim maschinellen Lernen beziehen sich Merkmale auf messbare und quantifizierbare Attribute oder Eigenschaften eines Objekts, einer Person oder eines Phänomens. Features können grob in zwei Kategorien unterteilt werden: spärliche Features und dichte Features.

Sparse Features

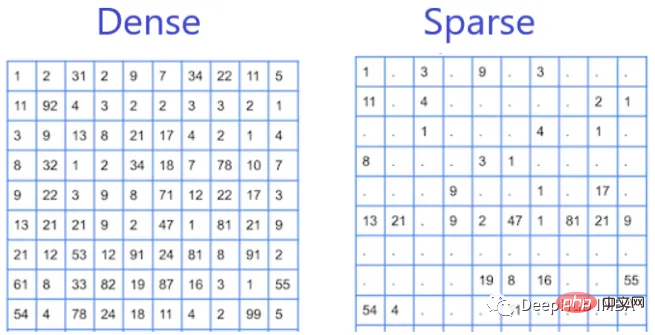

Sparse Features sind solche Features, die diskontinuierlich im Datensatz erscheinen und deren Werte größtenteils Null sind. Beispiele für spärliche Merkmale sind das Vorhandensein oder Fehlen bestimmter Wörter in einem Textdokument oder das Vorkommen bestimmter Elemente in einem Transaktionsdatensatz. Sie werden als spärliche Features bezeichnet, da sie im Datensatz nur wenige Werte ungleich Null aufweisen und die meisten Werte Null sind.

Sparse-Funktionen sind in Natural Language Processing (NLP) und Empfehlungssystemen üblich, wo Daten oft als spärliche Matrizen dargestellt werden. Das Arbeiten mit spärlichen Features kann eine größere Herausforderung darstellen, da diese oft viele Null- oder Nahe-Null-Werte aufweisen, was sie rechenintensiv macht und den Trainingsprozess verlangsamt. Sparse-Features sind effektiv, wenn der Feature-Bereich groß ist und die meisten Features irrelevant oder redundant sind. In diesen Fällen tragen spärliche Funktionen dazu bei, die Dimensionalität der Daten zu reduzieren, was ein schnelleres und effizienteres Training und Inferenz ermöglicht.

Dense Features

Dense Features sind solche Features, die häufig oder regelmäßig in einem Datensatz vorkommen, und die meisten Werte sind ungleich Null. Beispiele für dichte Merkmale sind Alter, Geschlecht und Einkommen von Personen in einem demografischen Datensatz. Sie werden als dichte Merkmale bezeichnet, da sie im Datensatz viele Werte ungleich Null aufweisen.

Dichte Merkmale kommen häufig bei der Bild- und Spracherkennung vor, wo Daten häufig als dichte Vektoren dargestellt werden. Dichte Merkmale sind im Allgemeinen einfacher zu handhaben, da sie eine höhere Dichte an Werten ungleich Null aufweisen und die meisten Algorithmen für maschinelles Lernen für die Verarbeitung dichter Merkmalsvektoren ausgelegt sind. Dichte Features sind möglicherweise besser geeignet, wenn der Feature-Raum relativ klein ist und jedes Feature für die jeweilige Aufgabe wichtig ist.

Unterschied

Der Unterschied zwischen spärlichen Features und dichten Features liegt in der Verteilung ihrer Werte im Datensatz. Sparse-Features haben wenige Werte ungleich Null, wohingegen dichte Features viele Werte ungleich Null haben. Dieser Verteilungsunterschied hat Auswirkungen auf Algorithmen für maschinelles Lernen, da Algorithmen bei spärlichen Features eine andere Leistung erbringen können als bei dichten Features.

Algorithmusauswahl

Da wir nun die Feature-Typen eines bestimmten Datensatzes kennen, welchen Algorithmus sollten wir verwenden, wenn der Datensatz spärliche Features enthält oder wenn der Datensatz dichte Features enthält?

Einige Algorithmen eignen sich besser für spärliche Daten, während andere besser für dichte Daten geeignet sind.

- Für spärliche Daten gehören zu den beliebten Algorithmen logistische Regression, Support Vector Machines (SVM) und Entscheidungsbäume.

- Für dichte Daten umfassen beliebte Algorithmen neuronale Netze wie Feedforward-Netze und Faltungs-Neuronale Netze.

Aber es sollte beachtet werden, dass die Wahl des Algorithmus nicht nur von der Sparsität oder Dichte der Daten abhängt, sondern auch von anderen Faktoren wie der Größe des Datensatzes, dem Feature-Typ, der Komplexität des Problems usw. Seien Sie sicher verschiedene Algorithmen auszuprobieren und ihre Leistung bei einem bestimmten Problem zu vergleichen.

Das obige ist der detaillierte Inhalt vonSpärliche und dichte Merkmale. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr