Heim >Technologie-Peripheriegeräte >KI >ChatGPT hat Nature gebeten, zwei Artikel pro Woche zu veröffentlichen, um zu diskutieren: „Es ist unvermeidlich, es in akademischen Kreisen zu verwenden, und es ist an der Zeit, die Verwendungsspezifikationen zu klären.'

ChatGPT hat Nature gebeten, zwei Artikel pro Woche zu veröffentlichen, um zu diskutieren: „Es ist unvermeidlich, es in akademischen Kreisen zu verwenden, und es ist an der Zeit, die Verwendungsspezifikationen zu klären.'

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-18 21:07:011667Durchsuche

Während Technologiegiganten für ChatGPT kämpfen, schenken auch akademische Kreise ChatGPT zunehmend Aufmerksamkeit.

Innerhalb einer Woche veröffentlichte Nature zwei Artikel über ChatGPT und generative KI.

Schließlich hat ChatGPT erstmals in der akademischen Welt für Aufsehen gesorgt und es zum Verfassen von Abstracts und zum Überarbeiten von Arbeiten genutzt.

Nature hat hierfür ein besonderes Verbot ausgesprochen: ChatGPT kann nicht der Autor des Papiers sein. Die Wissenschaft verbietet ausdrücklich die Verwendung von ChatGPT zur Texterstellung bei Einreichungen.

Aber der Trend ist bereits da.

Was wir jetzt tun sollten, ist vielleicht zu klären, welche Bedeutung ChatGPT für die wissenschaftliche Gemeinschaft hat und welchen Platz es einnehmen sollte.

Wie die Natur sagte:

Generative KI und die Technologie dahinter entwickeln sich so schnell, und jeden Monat erscheinen Innovationen. Wie Forscher sie nutzen, wird die Zukunft von Technologie und Wissenschaft bestimmen.

ChatGPT ändert die Regeln des akademischen Kreises

Im Artikel „ChatGPT: Fünf vorrangige Forschungsthemen“ schlugen die Forscher vor:

Es gibt keine Möglichkeit, ChatGPT daran zu hindern, in den akademischen Kreis einzudringen. Die oberste Priorität sollte sein um die möglichen Auswirkungen zu untersuchen und zu erforschen.

Wenn ChatGPT später verwendet wird, um Experimente zu entwerfen, Peer-Reviews durchzuführen, bei der Veröffentlichung zu helfen und Redakteuren bei der Entscheidung über die Annahme von Artikeln zu helfen ... Auf welche Aspekte sollten wir bei diesen Anwendungen achten? Welche Grenzen muss der Mensch jetzt klären?

Die Forscher glauben, dass es 5 Aspekte gibt, die priorisiert und erläutert werden müssen.

Bestehen Sie auf einer menschlichen Überprüfung

Eines der Merkmale von Konversations-KI wie ChatGPT ist, dass die Richtigkeit des Antwortinhalts nicht garantiert werden kann. Darüber hinaus sind die erfundenen Lügen sehr natürlich und können Menschen leicht in die Irre führen.

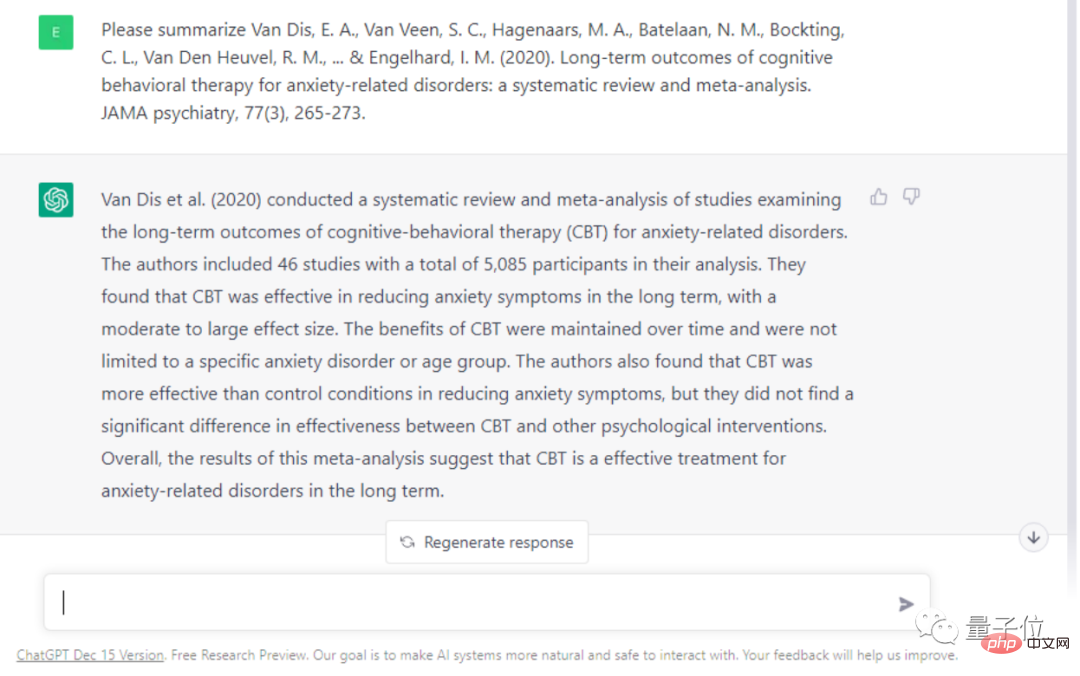

Zum Beispiel haben Forscher ChatGPT gebeten, einen Artikel darüber zusammenzufassen und zusammenzufassen, ob kognitive Verhaltenstherapie (CBT) bei der Behandlung von Angstzuständen und anderen Symptomen wirksam ist.

Die Antworten von ChatGPT enthalten viele sachliche Fehler. Beispielsweise heißt es, dass diese Überprüfung auf 46 Studien basiert, tatsächlich sind es jedoch 69, und die Wirksamkeit der kognitiven Verhaltenstherapie wird übertrieben.

Die Forscher glauben, dass einige Wissenschaftler durch falsche Informationen in die Irre geführt werden könnten, wenn sie ChatGPT zur Unterstützung bei der Forschung nutzen. Es kann sogar dazu führen, dass Wissenschaftler die Arbeit anderer plagiieren, ohne es zu wissen.

Daher glauben die Forscher, dass Menschen sich bei der Begutachtung von Arbeiten nicht zu sehr auf automatisierte Systeme verlassen können und dass die Menschen letztendlich selbst für die wissenschaftliche Praxis verantwortlich sein müssen.

Entwickeln Sie Verantwortlichkeitsregeln

Um dem Missbrauch generativer KI entgegenzuwirken, wurden viele Tools zur KI-Textidentifizierung entwickelt. Sie können leicht unterscheiden, ob ein Text von einem Menschen geschrieben wurde.

Die Forscher glauben jedoch, dass dieses „Wettrüsten“ unnötig ist. Was wirklich getan werden muss, ist, dass akademische Kreise und Verlage KI-Tools offener und transparenter nutzen können.

Papierautoren sollten klar angeben, welche Aufgaben von KI übernommen werden, und Zeitschriften sollten auch öffentlich offenlegen, ob sie KI zur Begutachtung nutzen.

Gerade jetzt, wo generative KI Diskussionen über Patentfragen ausgelöst hat. Wie soll das Urheberrecht von durch KI generierten Bildern berechnet werden?

Bei Problemen, die durch KI erzeugt werden, sollte das Urheberrecht also bei der Person liegen, die die Trainingsdaten für die KI bereitstellt? Die Produktionsfirma hinter KI? Oder ein Wissenschaftler, der KI zum Schreiben von Artikeln nutzt? Auch die Frage der Urheberschaft muss klar definiert werden.

Investieren Sie in ein wirklich offenes LLM

Derzeit wird fast die gesamte fortschrittliche Konversations-KI von Technologieriesen bereitgestellt.

Vieles über die Funktionsprinzipien der Algorithmen hinter KI-Tools ist noch unbekannt.

Dies hat auch in allen Lebensbereichen Besorgnis geweckt, denn das monopolistische Verhalten der Giganten verstößt ernsthaft gegen den Grundsatz der Offenheit in der wissenschaftlichen Gemeinschaft.

Dies wird den akademischen Kreis dazu bewegen, die Mängel und zugrunde liegenden Prinzipien der Konversations-KI zu untersuchen, was sich weiter auf den Fortschritt von Wissenschaft und Technologie auswirkt.

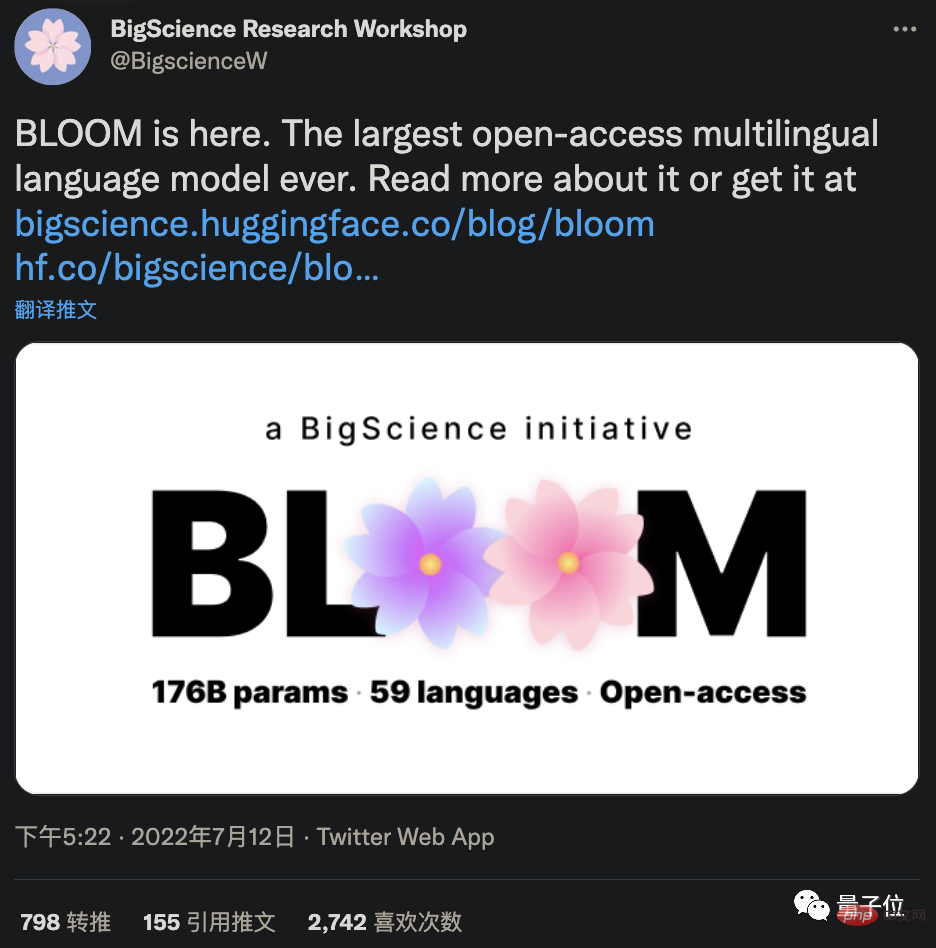

Um diese Undurchsichtigkeit zu überwinden, sollten Forscher nach Ansicht der Forscher derzeit der Entwicklung und Anwendung von Open-Source-KI-Algorithmen Priorität einräumen. Beispielsweise wurde das Open-Source-Großmodell BLOOM von 1.000 Wissenschaftlern gemeinsam initiiert und kann in puncto Leistung mit GPT-3 mithalten.

Erkennen Sie die Vorteile der KI

Obwohl es viele Aspekte gibt, die eingeschränkt werden müssen, ist es unbestreitbar, dass KI tatsächlich die Effizienz des akademischen Kreises verbessern kann.

Zum Beispiel kann KI einige Überprüfungsarbeiten schnell erledigen, und Wissenschaftler können sich mehr auf das Experiment selbst konzentrieren und die Ergebnisse können schneller veröffentlicht werden, was den gesamten akademischen Kreis dazu drängt, schneller voranzukommen.

Selbst bei manchen kreativen Arbeiten glauben Forscher, dass KI auch nützlich sein kann.

In einer bahnbrechenden Arbeit aus dem Jahr 1991 wurde vorgeschlagen, dass eine „intelligente Partnerschaft“ zwischen Menschen und KI die Intelligenz und Fähigkeiten von Menschen allein übertreffen kann.

Diese Beziehung kann Innovationen auf ein unvorstellbares Niveau beschleunigen. Aber die Frage ist: Wie weit kann diese Automatisierung gehen? Wie weit solltest du gehen?

Daher fordern Forscher auch Wissenschaftler, darunter auch Ethiker, auf, die Grenzen der heutigen KI bei der Generierung von Wissensinhalten zu diskutieren.

Starten Sie eine große Debatte

Angesichts der aktuellen Auswirkungen von LLM sind Forscher der Meinung, dass die akademische Gemeinschaft dringend eine große Debatte organisieren sollte.

Sie forderten jede Forschungsgruppe auf, sofort ein Gruppentreffen abzuhalten, um ChatGPT zu besprechen und selbst auszuprobieren. Hochschullehrer sollten die Initiative ergreifen, die Nutzung und ethische Fragen von ChatGPT mit Studierenden zu diskutieren.

In der frühen Phase, in der die Regeln noch nicht klar sind, ist es für den Leiter des Forschungsteams wichtig, alle dazu aufzufordern, ChatGPT offener und transparenter zu nutzen und mit der Formulierung einiger Regeln zu beginnen. Und alle Forscher sollten daran erinnert werden, die Verantwortung für ihre eigene Arbeit zu übernehmen, unabhängig davon, ob sie von ChatGPT erstellt wurde oder nicht.

Denn darüber hinaus sind die Forscher der Meinung, dass umgehend ein internationales Forum abgehalten werden sollte, um die Forschung und den Einsatz von LLM zu diskutieren.

Zu den Mitgliedern sollten Wissenschaftler aus verschiedenen Bereichen, Technologieunternehmen, Investoren in Forschungseinrichtungen, Wissenschaftsakademien, Verlage, NGOs und Experten für Recht und Datenschutz gehören.

Natur: Was ChatGPT und AIGC für die Wissenschaft bedeuten

Aufgeregt und besorgt – so denken wahrscheinlich viele Forscher über ChatGPT.

ChatGPT ist bisher für viele Wissenschaftler zum digitalen Assistenten geworden.

Der Computerbiologe Casey Greene und andere nutzten ChatGPT, um das Papier zu überarbeiten. In 5 Minuten kann die KI ein Manuskript überprüfen und sogar Probleme im Referenzteil finden.

Hafsteinn Einarsson, ein Gelehrter aus Island, nutzt ChatGPT fast täglich, um PPT zu erstellen und die Hausaufgaben seiner Schüler zu überprüfen.

Auch die Neurobiologin Almira Osmanovic Thunström glaubt, dass große Sprachmodelle verwendet werden können, um Wissenschaftlern beim Verfassen von Förderanträgen zu helfen, und dass Wissenschaftler mehr Zeit sparen können.

Nature hat jedoch eine brillante Zusammenfassung der Ausgabe von ChatGPT erstellt:

Glatt, aber ungenau.

Sie müssen wissen, dass ein großer Mangel von ChatGPT darin besteht, dass die von ihm generierten Inhalte möglicherweise nicht wahr und genau sind, was sich auf seine Verwendung in akademischen Kreisen auswirken wird.

Kann es gelöst werden?

Ab jetzt ist die Antwort etwas verwirrend.

Der Konkurrent von OpenAI, Anthroic, behauptet, einige Probleme mit ChatGPT gelöst zu haben, lehnte jedoch ein Interview mit Nature ab.

Meta hat ein großes Sprachmodell namens Galactica veröffentlicht, das aus 48 Millionen wissenschaftlichen Arbeiten und Arbeiten besteht und angeblich gut darin ist, akademische Inhalte zu generieren und Forschungsprobleme besser zu verstehen. Die Demo ist jedoch nicht mehr geöffnet (der Code ist noch verfügbar), da Benutzer sie während der Verwendung als rassistisch empfanden.

Sogar ChatGPT, das darauf trainiert wurde, sich „brav“ zu benehmen, kann absichtlich dazu verleitet werden, gefährliche Bemerkungen auszugeben.

OpenAIs Methode, ChatGPT harmloser zu machen, ist auch sehr einfach und grob. Es besteht darin, viele manuelle Mitarbeiter zu finden, die das Korpus mit Anmerkungen versehen. Einige Leute denken, dass diese Art der Einstellung von Leuten zum Lesen toxischer Korpus auch eine Art Ausbeutung ist.

Aber auf jeden Fall haben ChatGPT und generative KI eine neue Tür der menschlichen Vorstellungskraft geöffnet.

Der Medizinwissenschaftler Eric Topol sagte, er hoffe, dass es in Zukunft künstliche Intelligenz geben werde, die LLM einschließt, die Texte und Bilder in der wissenschaftlichen Literatur gegenprüfen und so Menschen helfen kann, Krebs zu diagnostizieren und Krankheiten zu verstehen. Natürlich muss dies alles von Experten überwacht werden.

Er sagte: Ich hätte wirklich nicht erwartet, dass wir Anfang 2023 einen solchen Trend sehen würden.

Und das ist erst der Anfang.

Referenzlink:

[1]https://www.php.cn/link/492284833481ed2fd377c50abdedf9f1

[2]https://www.php.cn/link/ 04f19115dfa286fb61ab634a2717ed37

Das obige ist der detaillierte Inhalt vonChatGPT hat Nature gebeten, zwei Artikel pro Woche zu veröffentlichen, um zu diskutieren: „Es ist unvermeidlich, es in akademischen Kreisen zu verwenden, und es ist an der Zeit, die Verwendungsspezifikationen zu klären.'. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr