Heim >Technologie-Peripheriegeräte >KI >Einzelmaschinentraining eines großen Modells mit 20 Milliarden Parametern: Cerebras bricht neuen Rekord

Einzelmaschinentraining eines großen Modells mit 20 Milliarden Parametern: Cerebras bricht neuen Rekord

- 王林nach vorne

- 2023-04-18 12:37:03877Durchsuche

Diese Woche kündigte das Chip-Startup Cerebras einen neuen Meilenstein an: das Training eines NLP-Modells (Natural Language Processing) für künstliche Intelligenz mit mehr als 10 Milliarden Parametern in einem einzigen Computergerät.

Das von Cerebras trainierte KI-Modellvolumen erreicht beispiellose 20 Milliarden Parameter, und das alles ohne Skalierung der Arbeitslast über mehrere Beschleuniger hinweg. Diese Arbeit reicht aus, um das beliebteste Text-zu-Bild-KI-Generierungsmodell im Internet zu erfüllen – das 12 Milliarden Parameter große Modell DALL-E von OpenAI.

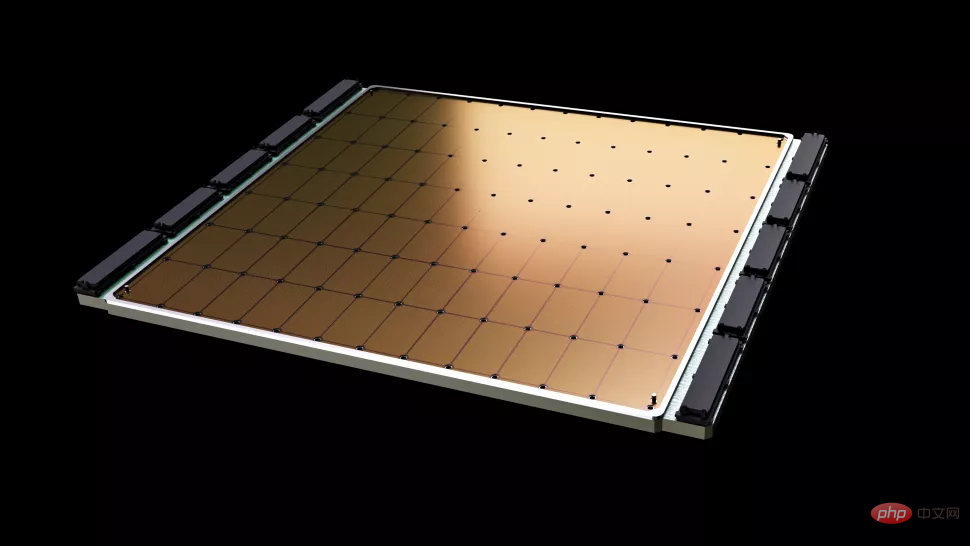

Cerebras Das Wichtigste am neuen Job sind die geringeren Anforderungen an Infrastruktur und Softwarekomplexität. Der von diesem Unternehmen bereitgestellte Chip, Wafer Scale Engine-2 (WSE2), wird, wie der Name schon sagt, im 7-nm-Prozess von TSMC auf einen einzigen Wafer geätzt. Dieser Bereich ist normalerweise groß genug, um Hunderte von Mainstream-Chips aufzunehmen – und zwar mit einer atemberaubenden Geschwindigkeit 2,6 Billionen Transistoren, 850.000 KI-Rechenkerne und 40 GB integrierter Cache, und der Stromverbrauch nach der Verpackung beträgt bis zu 15 kW.

Die Wafer Scale Engine-2 kommt der Größe eines Wafers nahe und ist größer als ein iPad.

Obwohl die einzelne Maschine von Cerebras in ihrer Größe bereits einem Supercomputer ähnelt, reduziert die Beibehaltung von bis zu 20 Milliarden Parametern des NLP-Modells in einem einzigen Chip die Trainingskosten Tausender GPUs und die damit verbundenen Hardware- und Erweiterungsanforderungen dennoch erheblich , während die technischen Schwierigkeiten bei der Aufteilung der Modelle zwischen ihnen beseitigt werden. Letzteres ist „einer der schmerzhaftesten Aspekte der NLP-Arbeitsbelastung“ und dauert manchmal „Monate bis zur Fertigstellung“, sagte Cerebras.

Dies ist ein individuelles Problem, das nicht nur für jedes verarbeitete neuronale Netzwerk einzigartig ist, sondern auch für die Spezifikationen jeder GPU und des Netzwerks, das sie miteinander verbindet – diese Elemente müssen beim ersten Einrichten im Voraus trainiert werden bevor Sie beginnen, und es ist nicht systemübergreifend portierbar.

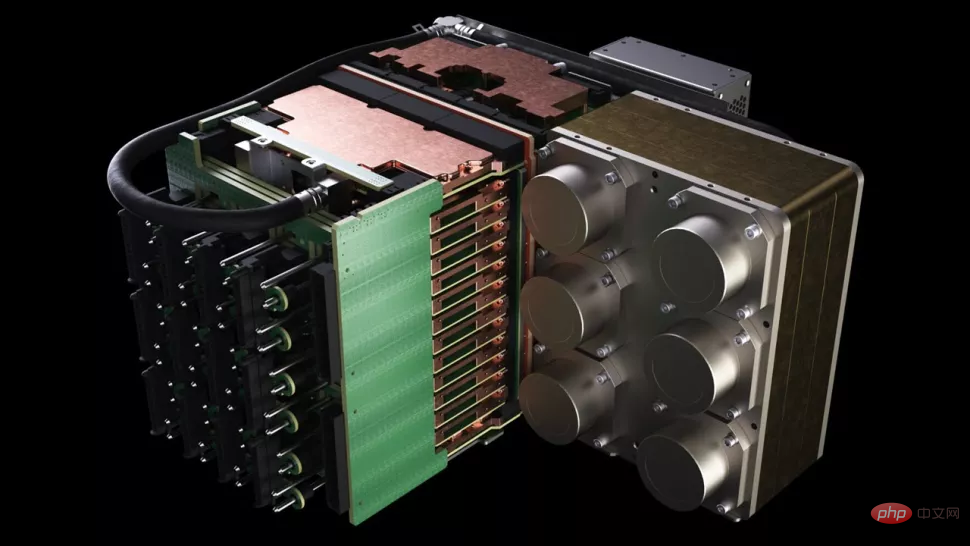

CS-2 von Cerebras ist ein eigenständiger Supercomputing-Cluster, der den Wafer Scale Engine-2-Chip mit allen zugehörigen Stromversorgungs-, Speicher- und Speichersubsystemen umfasst.

Was ist das ungefähre Niveau von 20 Milliarden Parametern? Im Bereich der künstlichen Intelligenz arbeiten verschiedene Technologieunternehmen und -institutionen in letzter Zeit intensiv an groß angelegten Pre-Training-Modellen. Das GPT-3 von OpenAI ist ein NLP-Modell, das ganze Artikel schreiben und Dinge tun kann, die ausreichen täuschen menschliche Leser. Mathematische Operationen und Übersetzungen mit unglaublichen 175 Milliarden Parametern. Gopher von DeepMind, das Ende letzten Jahres eingeführt wurde, erhöhte die Rekordzahl an Parametern auf 280 Milliarden.

Kürzlich gab Google Brain sogar bekannt, dass es ein Modell mit mehr als einer Billion Parametern trainiert hat: Switch Transformer.

„Im NLP-Bereich haben größere Modelle nachweislich eine bessere Leistung. Aber traditionell verfügen nur wenige Unternehmen über die Ressourcen und das Fachwissen, um die Zerlegung dieser großen Modelle abzuschließen und sie in Hunderte von Einheiten zu verteilen Arbeit von Tausenden von Grafikprozessoren", sagte Andrew Feldman, CEO und Mitbegründer von Cerebras. „Es gibt daher nur sehr wenige Unternehmen, die große NLP-Modelle trainieren können – es ist zu teuer, zeitaufwendig und unbrauchbar für den Rest der Branche.“

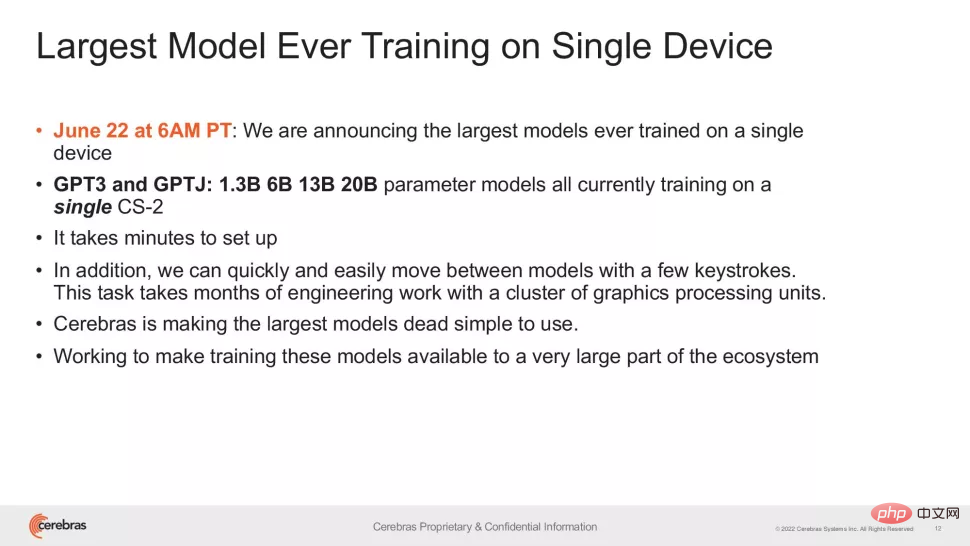

Jetzt kann die Methode von Cerebras GPT-3XL 1.3B reduzieren Die Verfügbarkeit der Modelle GPT-J 6B, GPT-3 13B und GPT-NeoX 20B ermöglicht es dem gesamten KI-Ökosystem, große Modelle in wenigen Minuten zu erstellen und sie auf einem einzigen CS-2-System zu trainieren.

Doch genau wie die Taktrate einer Flaggschiff-CPU ist die Anzahl der Parameter nur ein Indikator für die Leistung großer Modelle. Kürzlich haben einige Untersuchungen unter der Prämisse der Reduzierung von Parametern bessere Ergebnisse erzielt, wie beispielsweise Chinchilla, das von DeepMind im April dieses Jahres vorgeschlagen wurde und GPT-3 und Gopher in herkömmlichen Fällen mit nur 70 Milliarden Parametern übertraf.

Das Ziel dieser Art von Forschung ist natürlich, intelligenter und nicht härter zu arbeiten. Daher sind die Errungenschaften von Cerebras wichtiger als das, was die Leute zunächst sehen – diese Forschung gibt uns Zuversicht, dass sich das aktuelle Niveau der Chipherstellung an immer komplexere Modelle anpassen kann, und das Unternehmen sagte, dass Systeme mit speziellen Chips als Kern die Fähigkeit haben, „die Fähigkeit“ zu unterstützen von Modellen mit Hunderten Milliarden oder sogar Billionen Parametern.

Das explosionsartige Wachstum der Anzahl trainierbarer Parameter auf einem einzigen Chip beruht auf der Weight Streaming-Technologie von Cerebras. Diese Technologie entkoppelt Rechenleistung und Speicherbedarf und ermöglicht so die Skalierung des Speichers in jeder Größenordnung, basierend auf der schnell wachsenden Anzahl von Parametern in KI-Workloads. Dies reduziert die Einrichtungszeit von Monaten auf Minuten und ermöglicht den Wechsel zwischen Modellen wie GPT-J und GPT-Neo. Wie die Forscher sagten: „Es sind nur wenige Tastendrücke erforderlich.“

„Cerebras bietet Menschen die Möglichkeit, große Sprachmodelle auf kostengünstige und bequeme Weise auszuführen, und läutet damit eine aufregende neue Ära der künstlichen Intelligenz ein.“ bietet Organisationen, die nicht mehrere Dutzend Millionen Dollar ausgeben können, eine einfache und kostengünstige Möglichkeit, in großen Modellen zu konkurrieren“, sagte Dan Olds, Chief Research Officer bei Intersect360 Research. „Wir freuen uns auf neue Anwendungen und Entdeckungen von CS-2-Kunden, während sie GPT-3- und GPT-J-Level-Modelle auf riesigen Datensätzen trainieren.“

Das obige ist der detaillierte Inhalt vonEinzelmaschinentraining eines großen Modells mit 20 Milliarden Parametern: Cerebras bricht neuen Rekord. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr