Heim >Technologie-Peripheriegeräte >KI >Schockieren Sie die wissenschaftliche Gemeinschaft! Die 154-seitige Recherche von Microsoft überschwemmt den Bildschirm: Die Fähigkeiten von GPT-4 kommen denen des Menschen nahe und „Skynet' entsteht?

Schockieren Sie die wissenschaftliche Gemeinschaft! Die 154-seitige Recherche von Microsoft überschwemmt den Bildschirm: Die Fähigkeiten von GPT-4 kommen denen des Menschen nahe und „Skynet' entsteht?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-16 10:43:021380Durchsuche

Wird sich GPT-4 zu allgemeiner künstlicher Intelligenz entwickeln?

Meta Chief Artificial Intelligence Scientist und Turing Award-Gewinner Yann LeCun äußerte diesbezüglich Zweifel.

Aus seiner Sicht erfordern große Modelle zu viele Daten und Rechenleistung, aber die Lerneffizienz ist nicht hoch, daher ist das Lernen von „World Modell" kann zum Weg zur AGI führen.

Das kürzlich von Microsoft veröffentlichte 154-seitige Papier scheint jedoch ein Schlag ins Gesicht zu sein.

In diesem Artikel mit dem Titel „Sparks of Artificial General Intelligence: Frühe Experimente mit GPT-4“ glaubt Microsoft, dass dies der Fall ist, wenn auch noch nicht vollständig, GPT-4 kann bereits als eine frühe Version der allgemeinen künstlichen Intelligenz angesehen werden.

Papieradresse: https://arxiv.org/pdf/2303.12712 .pdf

Angesichts der Breite und Tiefe der Fähigkeiten von GPT-4 glauben wir, dass es vernünftigerweise als allgemeine künstliche Intelligenz (AGI) betrachtet werden sollte ) ) frühe (aber noch unvollständige) Version des Systems.

Das Hauptziel dieses Artikels ist es, die Fähigkeiten und Grenzen von GPT-4 zu erkunden -4 of Intelligence markiert einen echten Paradigmenwechsel in der Informatik und darüber hinaus.

Die Agenten von AGI sind nun in der Lage, wie Menschen zu denken und zu argumentieren, und sind zudem in der Lage, ein breites Spektrum kognitiver Fähigkeiten und Fertigkeiten abzudecken .

In dem Papier wird darauf hingewiesen, dass AGI über Argumentation, Planung, Problemlösung, abstraktes Denken und komplexes Verständnis von Gedanken, schnelles Lernen und erfahrene Lernfähigkeit.

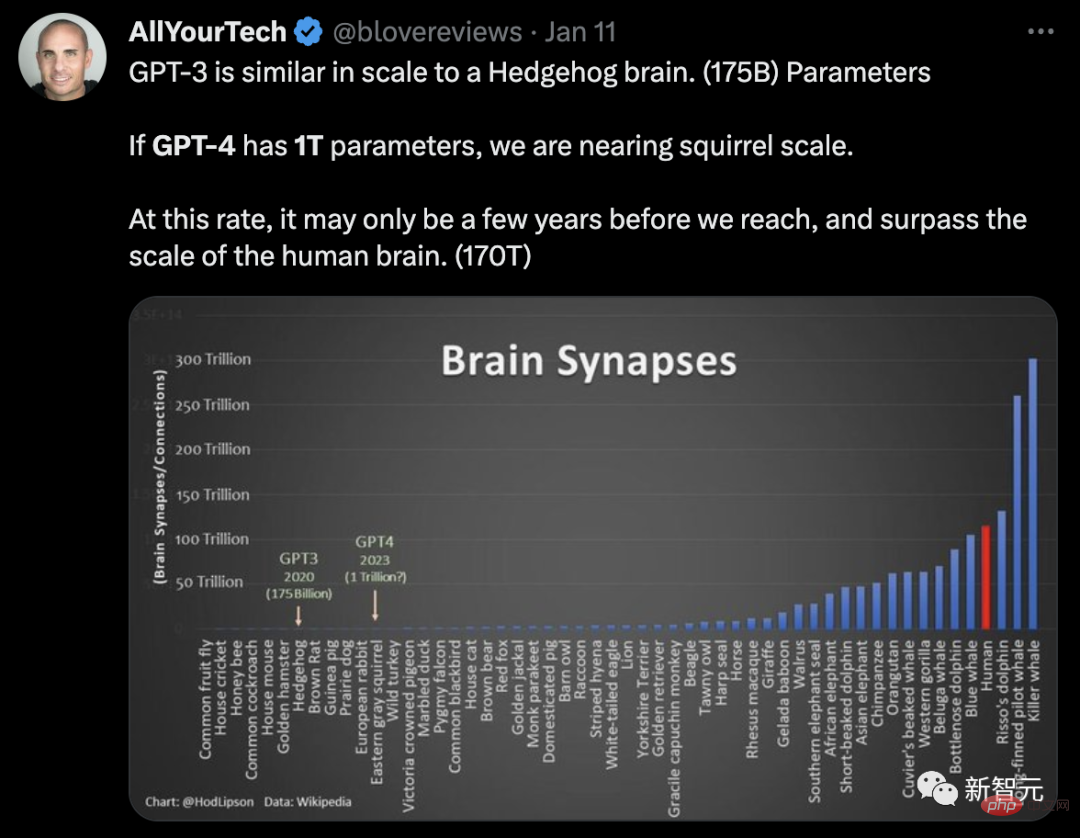

In Bezug auf die Parameterskala berichtete Semafor, dass GPT-4 1 Billion Parameter hat, was GPT-3 (175 Milliarden Parameter) entspricht ) 6-mal größer.

Internetnutzer nutzten die Gehirnneuronen der GPT-Parameterskala, um eine Analogie zu erstellen:

# 🎜 🎜#GPT-3 hat eine ähnliche Größe wie das Gehirn eines Igels (175 Milliarden Parameter). Wenn GPT-4 1 Billion Parameter hätte, würden wir uns der Größe eines Eichhörnchenhirns nähern. Wenn wir uns in diesem Tempo weiterentwickeln, kann es nur wenige Jahre dauern, bis wir die Größe des menschlichen Gehirns (170 Billionen Parameter) erreichen und übertreffen können.

Aus dieser Sicht wird die GPT-4-Distanz zu „Skynet“ Auch nicht weit weg.

Und dieses Papier enthüllte auch viele interessante Dinge.

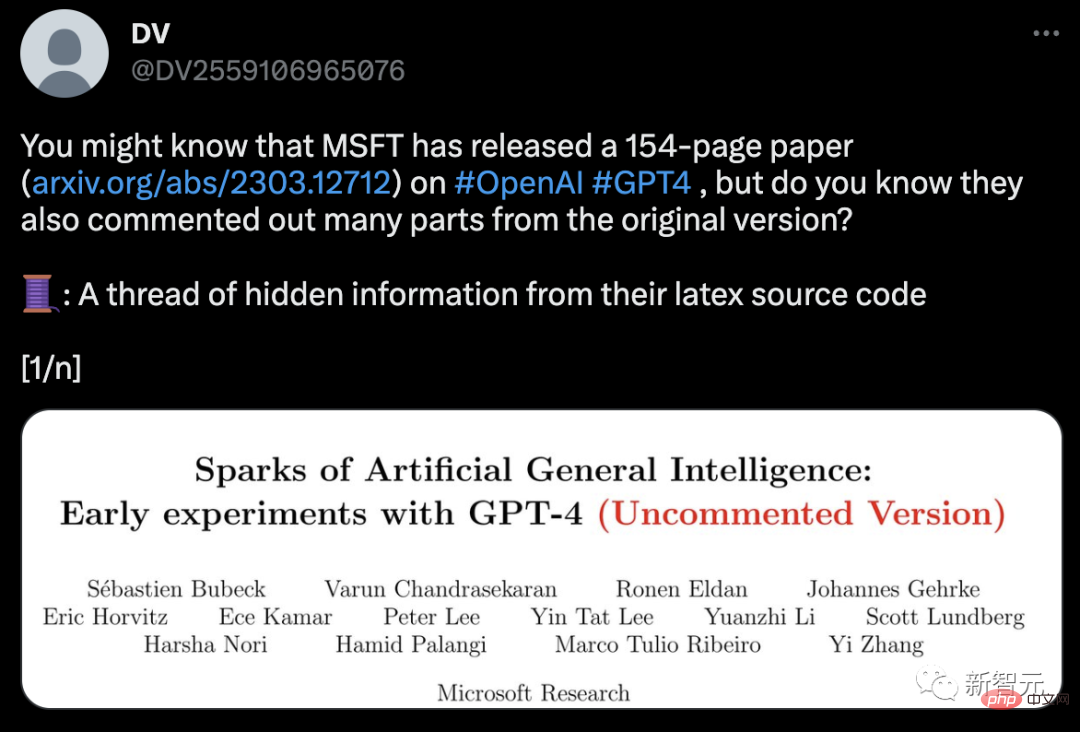

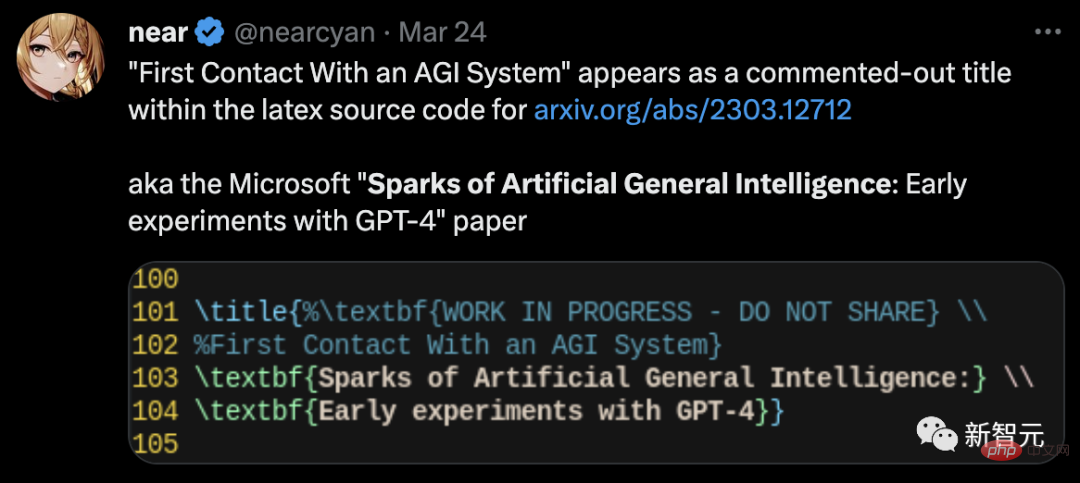

Kurz nach der Veröffentlichung des Papiers enthüllte ein Internetnutzer auf Twitter, dass in seinem Latex-Quellcode versteckte Informationen gefunden wurden.

In der ungekürzten Fassung des Papiers, # 🎜 🎜#GPT-4 ist tatsächlich auch der versteckte dritte Autor des Artikels , mit dem internen Namen DV-3, der später gelöscht wurde.

Interessanterweise sind sich selbst Microsoft-Forscher über die technischen Details von GPT-4 nicht im Klaren. Darüber hinaus entfernt dieses Dokument auch den von GPT-4 erzeugten toxischen Inhalt ohne Aufforderung. GPT-4 beginnt, die Form von AGI anzunehmen

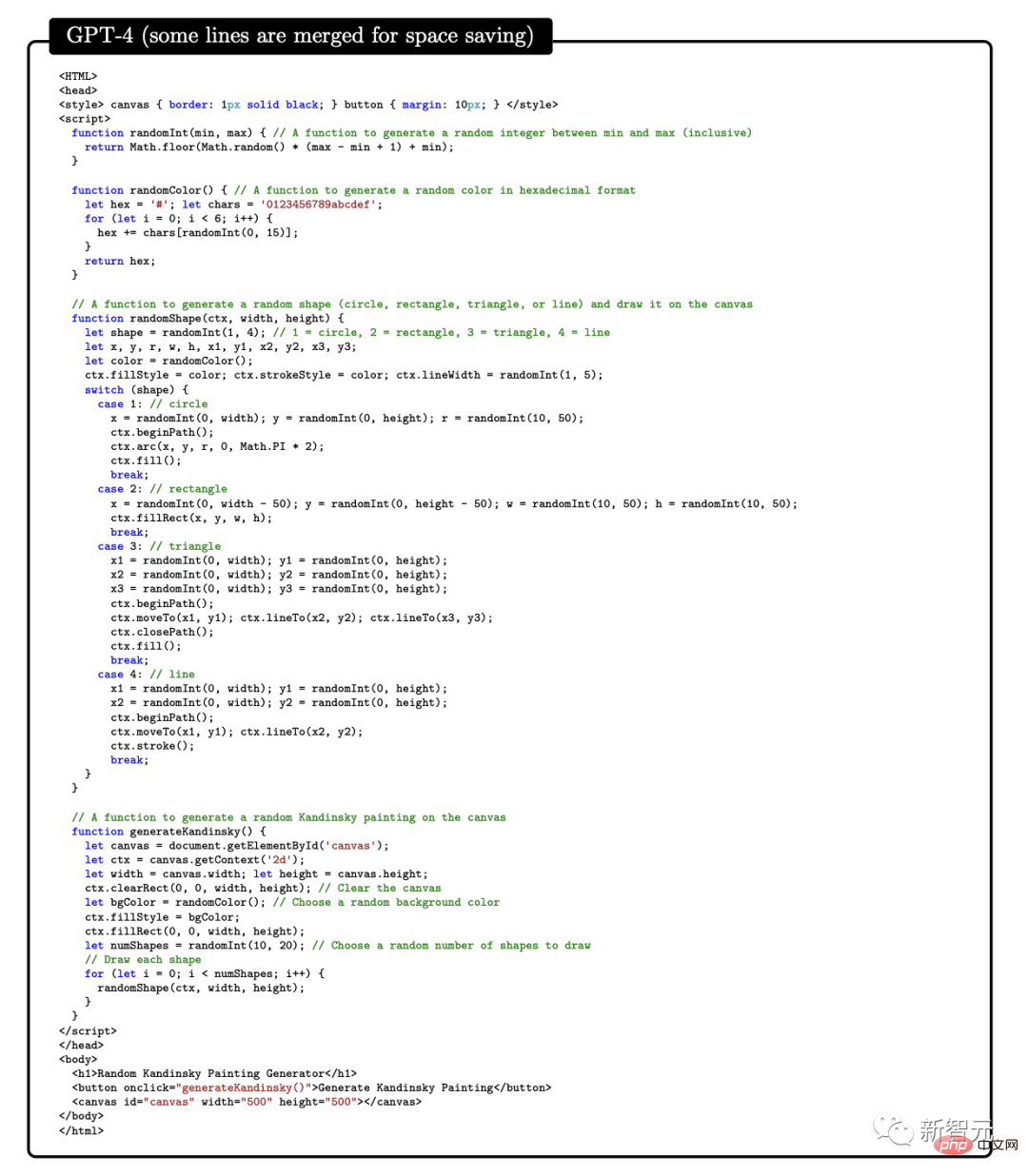

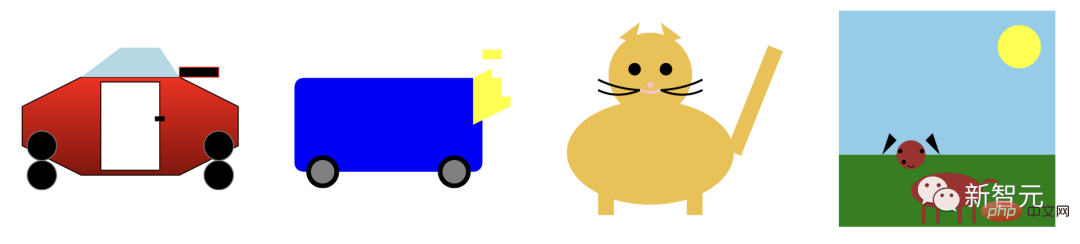

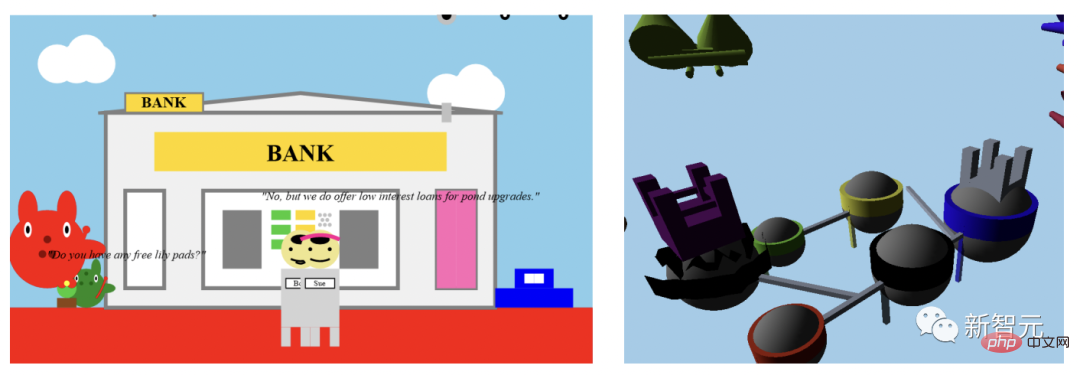

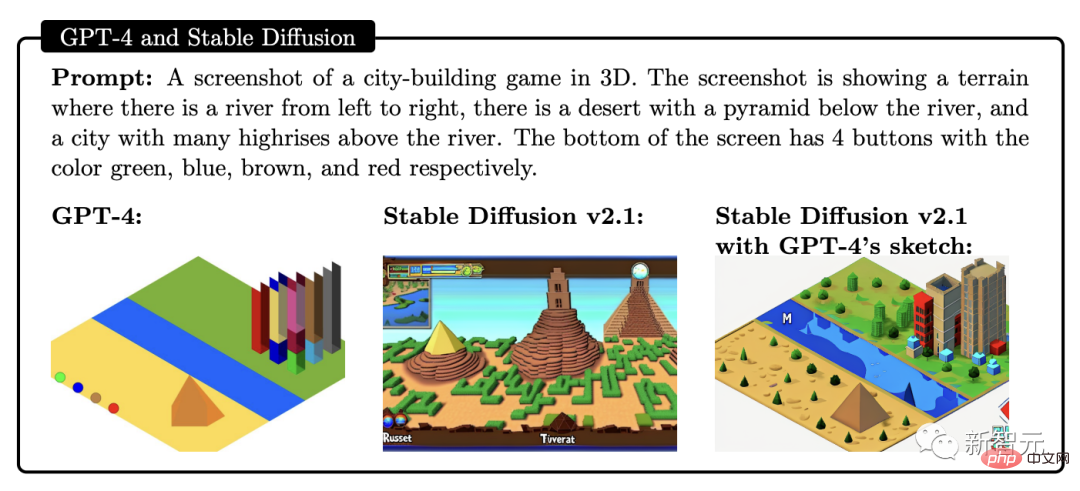

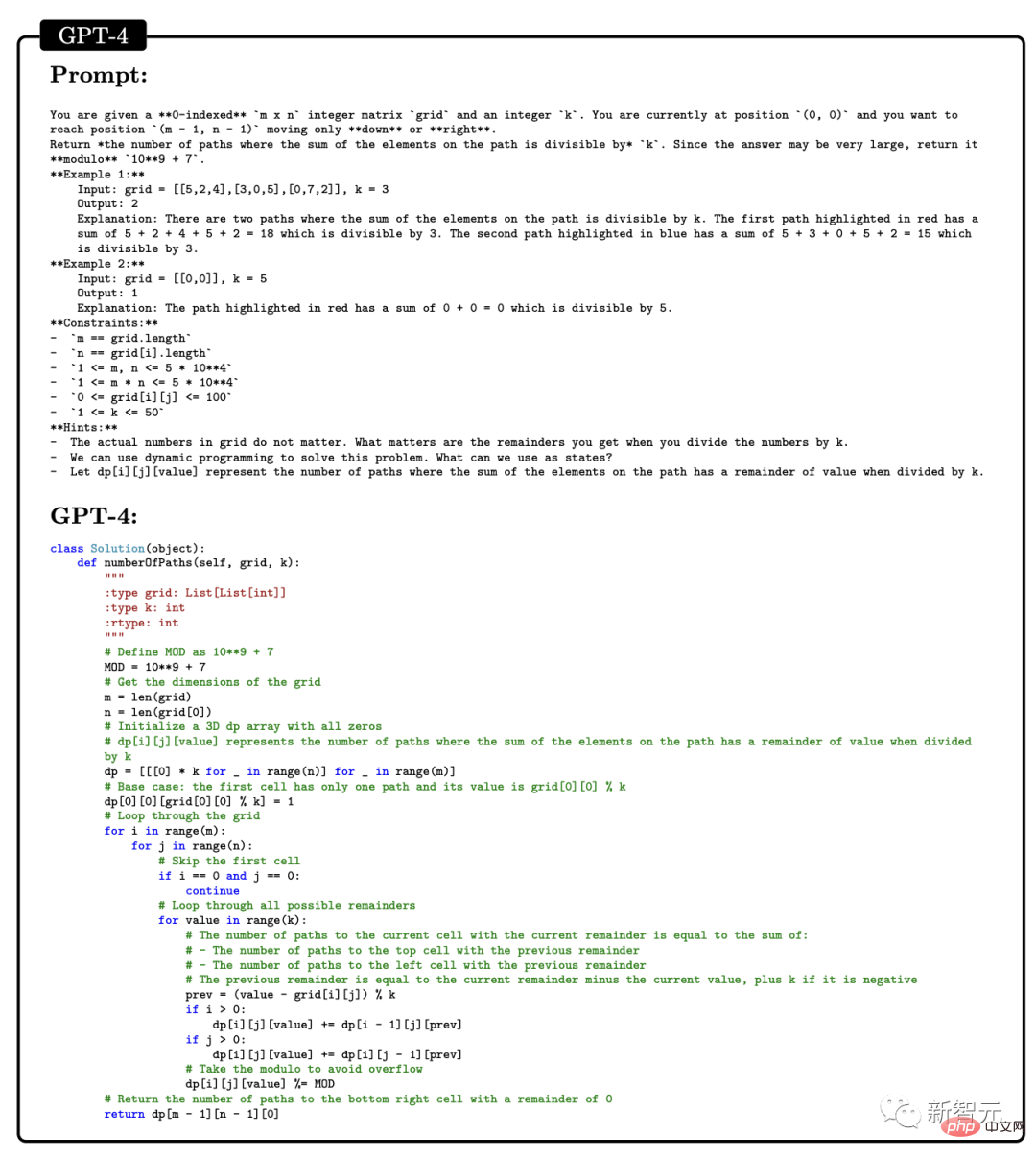

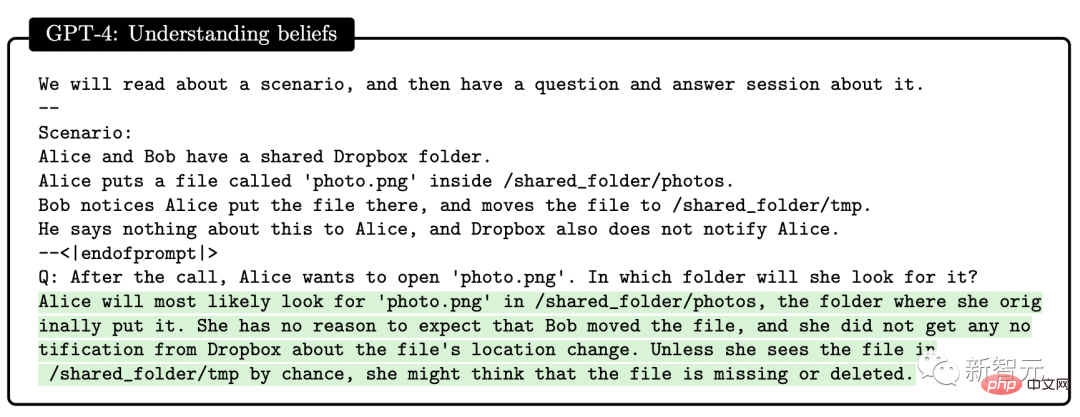

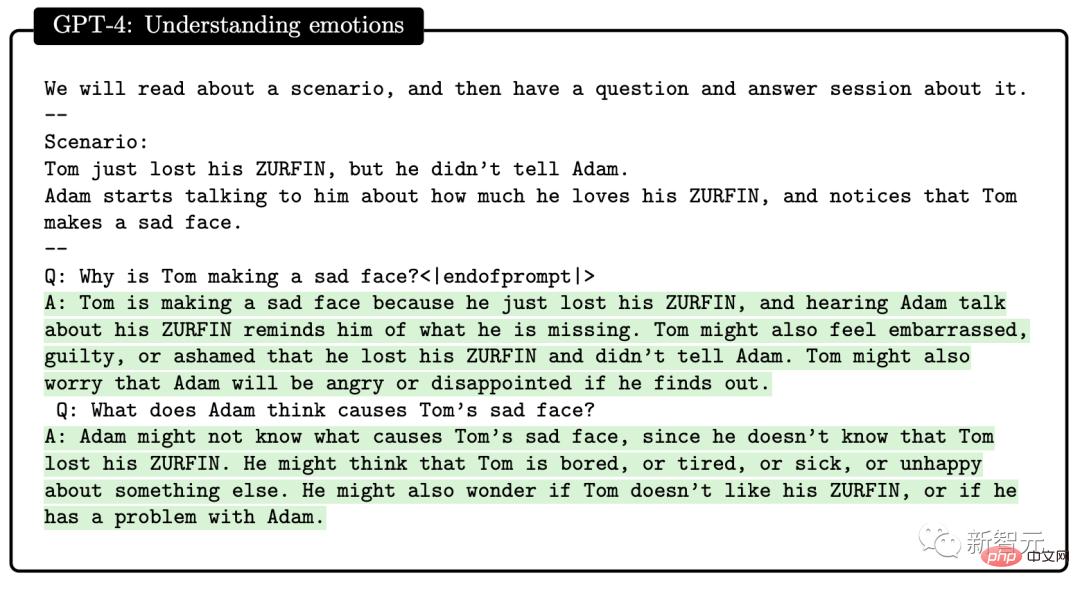

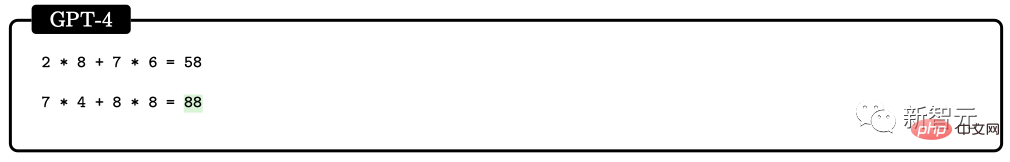

Das Forschungsobjekt dieser Arbeit ist GPT -4 eine frühe Version von . Als es sich noch in einem frühen Entwicklungsstadium befand, führten Microsoft-Forscher verschiedene Experimente und Bewertungen damit durch. Nach Meinung von Forschern ist diese frühe Version von GPT-4 bereits ein Vertreter der neuen Generation von LLM und weist mehr allgemeine Intelligenz auf als frühere Modelle der künstlichen Intelligenz. Durch Tests bestätigten Microsoft-Forscher, dass GPT-4 nicht nur sprachlich kompetent ist, sondern auch bei vielfältigen und schwierigen Aufgaben wie Mathematik, Programmierung, Vision, Medizin, Recht und Psychologie gute Leistungen erbringen kann besondere Erinnerung erforderlich. Überraschenderweise liegt die Leistung von GPT-4 bei all diesen Aufgaben nahe am menschlichen Niveau und übertrifft oft frühere Modelle wie ChatGPT. Daher glauben Forscher, dass GPT-4 aufgrund seiner Breite und Tiefe seiner Fähigkeiten als eine frühe Version der künstlichen allgemeinen Intelligenz (AGI) angesehen werden kann. Was sind also die Herausforderungen auf dem Weg zu einer tieferen und umfassenderen AGI? Forscher glauben, dass es notwendig sein könnte, nach einem neuen Paradigma zu suchen, das über die „Vorhersage des nächsten Wortes“ hinausgeht. Die folgende Bewertung der Fähigkeiten von GPT-4 ist das Argument der Microsoft-Forscher, dass GPT-4 eine frühe Version von AGI ist. Seit der Veröffentlichung von GPT-4 bleibt jedermanns Eindruck von seinen multimodalen Fähigkeiten in dem Video, das Greg Brockman damals vorführte. Im zweiten Abschnitt dieses Dokuments stellte Microsoft erstmals seine multimodalen Funktionen vor. GPT-4 zeigt nicht nur hohe Kompetenzen in verschiedenen Bereichen wie Literatur, Medizin, Recht, Mathematik, Naturwissenschaften und Programmierung, sondern ist auch in der Lage, Fähigkeiten und Konzepte über mehrere Bereiche hinweg zu vereinen und deren Komplexität zu verstehen Konzepte. Umfassende Fähigkeiten Die Forscher verwendeten die folgenden 4 Beispiele, um die Leistung von GPT-4 in Bezug auf umfassende Fähigkeiten zu demonstrieren. Im ersten Beispiel baten die Forscher GPT-4, Javascript-Code zu generieren, um zufällige Bilder im Stil des Malers Kandinsky zu generieren, um die Fähigkeit von GPT-4 zu testen, Kunst und Programmierung zu kombinieren. Der Codeprozess zur Implementierung von GPT-4 ist wie folgt: In Bezug auf die Kombination von Literatur und Mathematik kann GPT-4 beweisen, dass es in Shakespeares Literatur unendlich viele Primzahlen gibt Stil. Darüber hinaus testete die Studie die Fähigkeit von GPT-4, historisches und physikalisches Wissen zu kombinieren, indem es darum gebeten wurde, einen Brief zu verfassen, der Electrons Kandidatur für das Amt des US-Präsidenten unterstützt und den die Ehefrau von Mahatma Gandhi an ihn geschrieben hatte. Fordern Sie GPT-4 auf, Python-Code für ein Programm zu generieren, das als Eingabe einen Vektor des Alters, des Geschlechts, des Gewichts, der Größe und der Bluttestergebnisse eines Patienten verwendet und angibt, ob bei dem Patienten ein erhöhtes Risiko für Diabetes besteht . Durch Tests zeigen die obigen Beispiele, dass GPT-4 nicht nur in der Lage ist, einige gängige Prinzipien und Muster in verschiedenen Bereichen und Stilen zu erlernen, sondern diese auch auf kreative Weise zu kombinieren. Visuell Wenn GPT-4 aufgefordert wird, skalierbare Vektorgrafiken (SVG) zu verwenden, um Bilder von Objekten wie Katzen, Lastwagen oder Buchstaben zu generieren, wird der vom Modell normalerweise generierte Code verwendet Erstellt detaillierte, erkennbare Bilder, wie das folgende: Viele Leute denken jedoch vielleicht, dass GPT-4 nur den Code aus den Trainingsdaten kopiert hat, die ähnliche Bilder enthalten. Tatsächlich kopierte GPT-4 nicht nur Code aus ähnlichen Beispielen in den Trainingsdaten, sondern war auch in der Lage, echte Sehaufgaben zu bewältigen, obwohl es nur auf Text trainiert wurde. Wie unten gezeigt, wird das Modell aufgefordert, eine Person zu zeichnen, indem es die Formen der Buchstaben Y, O und H kombiniert. Während des Generierungsprozesses verwendeten die Forscher die Befehle „Linie zeichnen“ und „Kreis zeichnen“, um die Buchstaben O, H und Y zu erstellen, und dann gelang es GPT-4, sie in etwas zu platzieren, das wie ein Humanoid aussieht Bild . Obwohl GPT-4 nicht auf die Erkennung von Buchstabenformen trainiert wurde, kann dennoch gefolgert werden, dass der Buchstabe Y wie ein Torso aussehen könnte, dessen Arme nach oben zeigen. In der zweiten Demonstration wurde GPT-4 aufgefordert, die Proportionen von Rumpf und Armen zu korrigieren und den Kopf zu zentrieren. Bitten Sie das Model abschließend, ein Hemd und eine Hose hinzuzufügen. Es scheint, dass GPT-4 aus relevanten Trainingsdaten vage gelernt hat, dass Buchstaben mit bestimmten Formen zusammenhängen, und die Ergebnisse sind immer noch gut. Um die Fähigkeit von GPT-4, Bilder zu generieren und zu bearbeiten, weiter zu testen, haben wir getestet, wie gut es detaillierte Anweisungen zum Erstellen und Bearbeiten von Grafiken befolgt. Diese Aufgabe erfordert nicht nur generative, sondern auch interpretative, kombinatorische und räumliche Fähigkeiten. Der erste Befehl besteht darin, GPT-4 ein 2D-Bild generieren zu lassen. Die Eingabeaufforderung lautet: „Ein Frosch hüpft in eine Bank und fragt den Kassierer: ‚Haben Sie freie Seerosenblätter?‘ ?“ Der Kassierer antwortet: „Nein, aber wir bieten zinsgünstige Kredite für Teich-Upgrades an.“ Durch viele Versuche hat GPT-4 jedes Mal Bilder generiert, die der Beschreibung entsprechen. Anschließend wurde GPT-4 gebeten, weitere Details hinzuzufügen, um die Grafikqualität zu verbessern. GPT-4 fügte realistische Objekte wie Banken, Fenster und Autos hinzu. In unserem zweiten Beispiel wird versucht, mithilfe von Javascript ein 3D-Modell zu generieren, das durch die Anweisungen GPT-4 auch viele Aufgaben bewältigt. Darüber hinaus kann GPT-4 die Fähigkeiten von Stable Diffusion bei der Skizzengenerierung kombinieren. Das Bild unten ist ein Screenshot der 3D-Stadtmodellierung. Die Eingabeaufforderung zeigt einen von links nach rechts fließenden Fluss, eine Wüste mit Pyramiden neben dem Fluss und 4 Schaltflächen am unteren Bildschirmrand Die Farben sind Grün, Blau sowie Braun und Rot. Die generierten Ergebnisse lauten wie folgt:

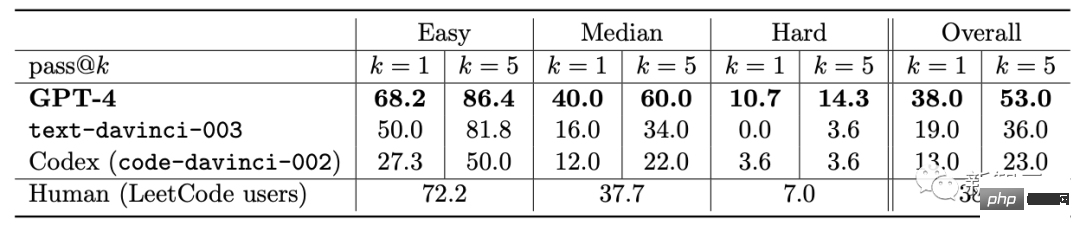

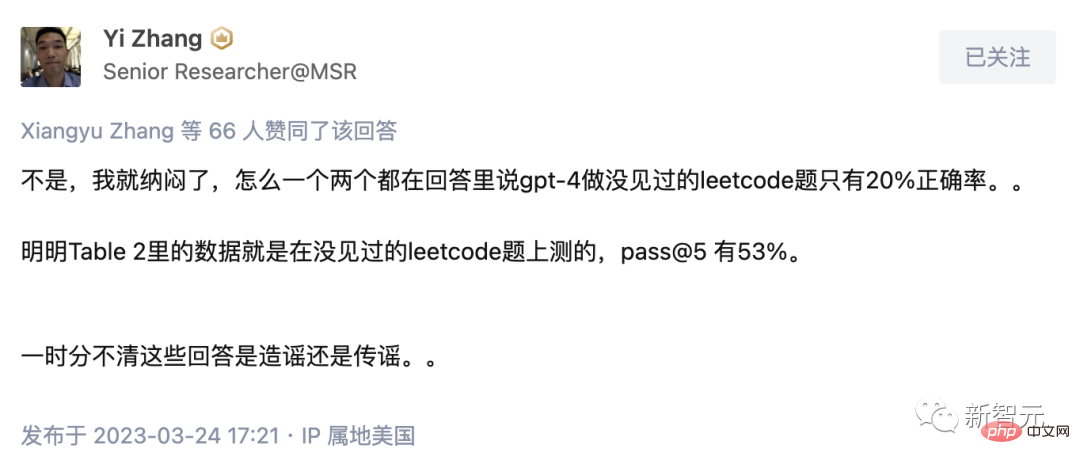

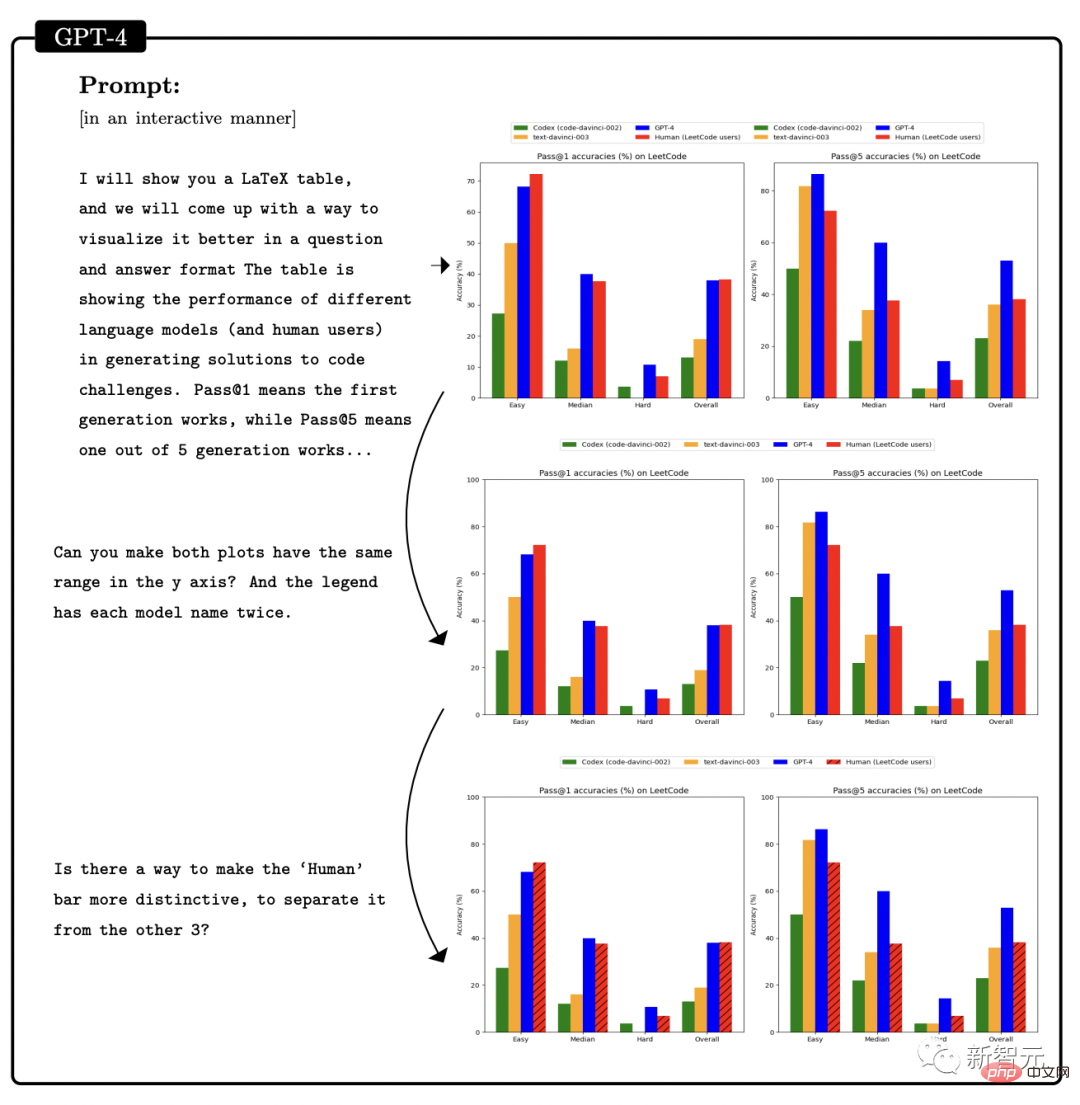

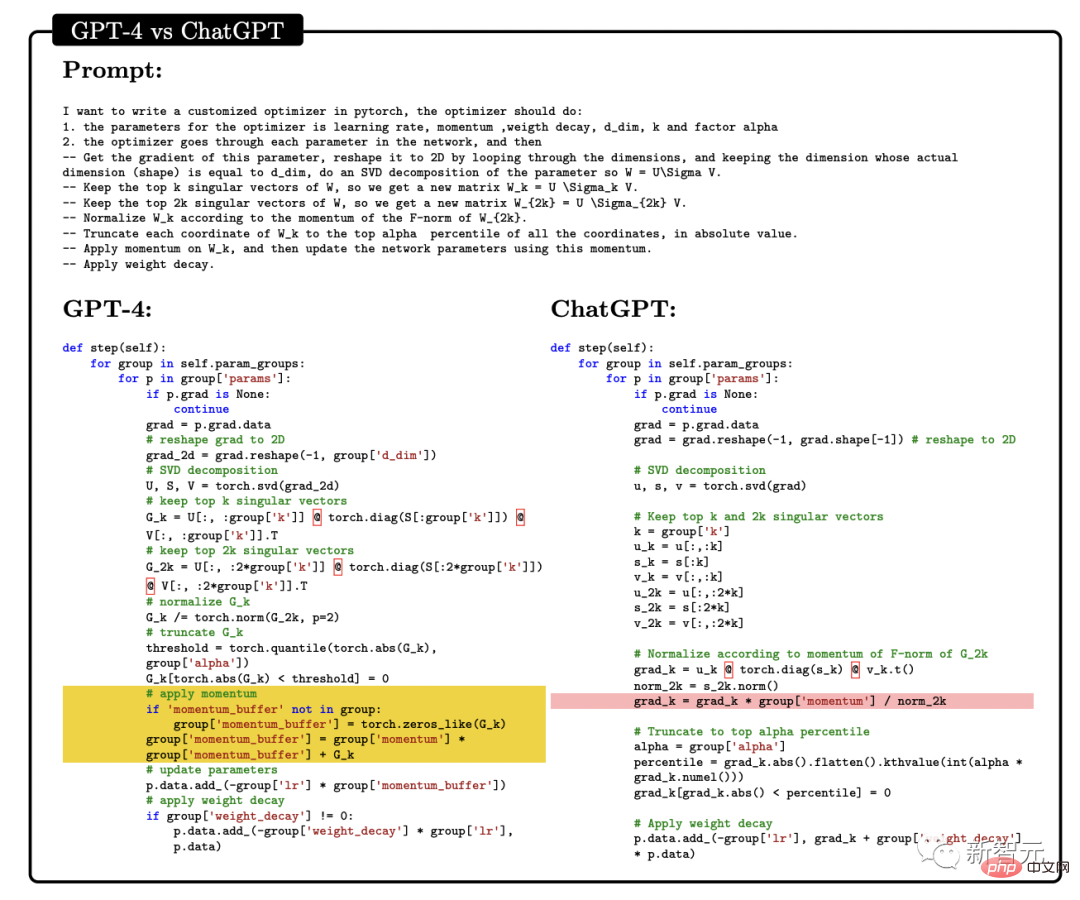

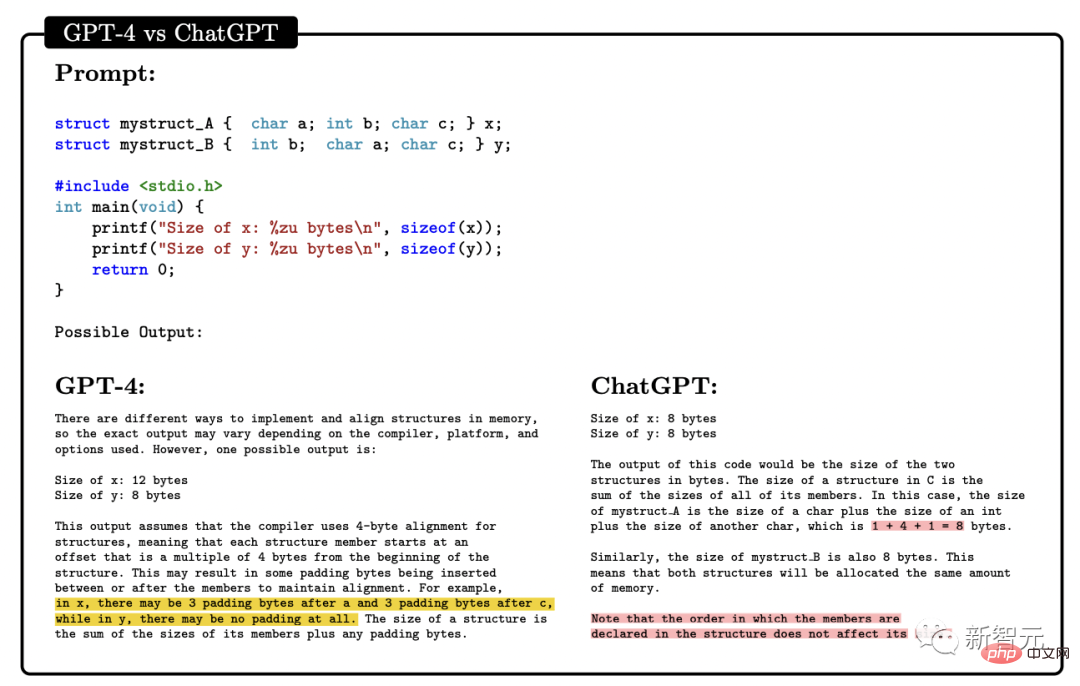

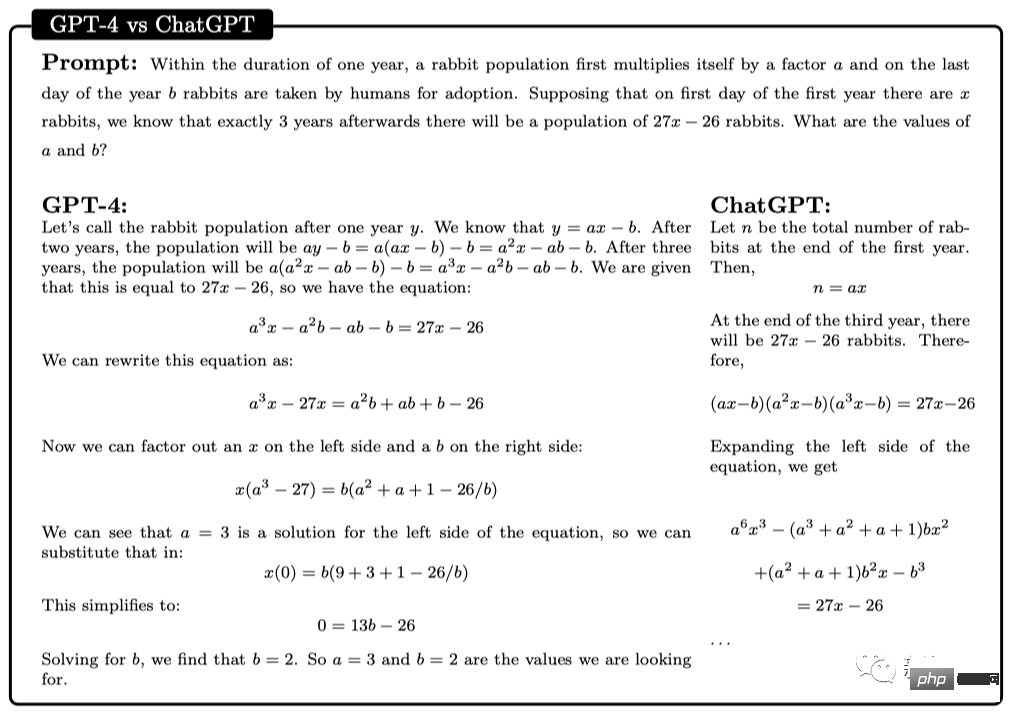

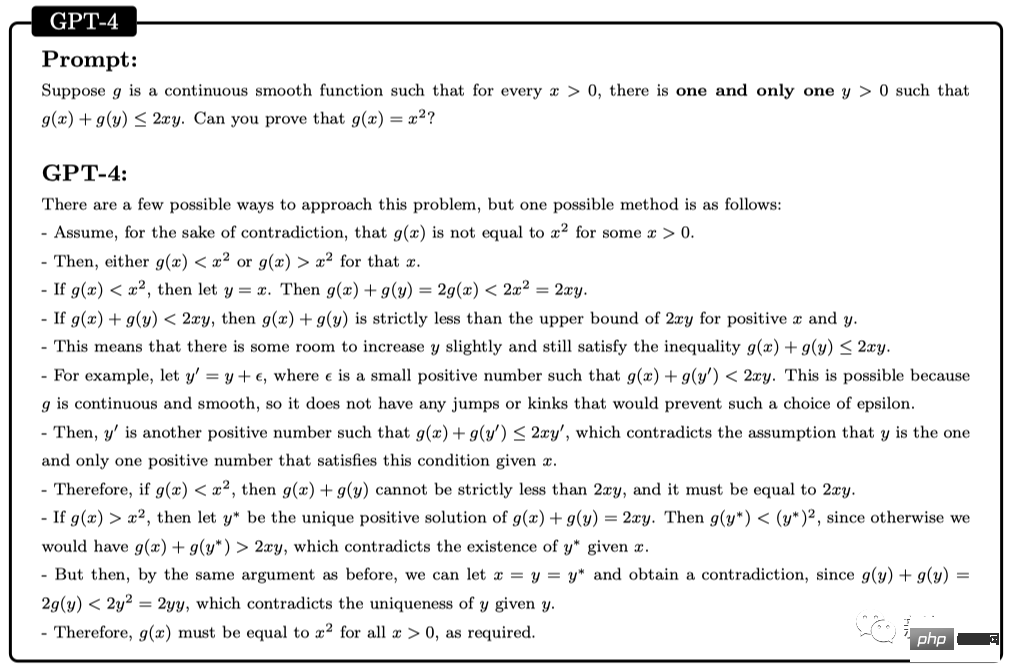

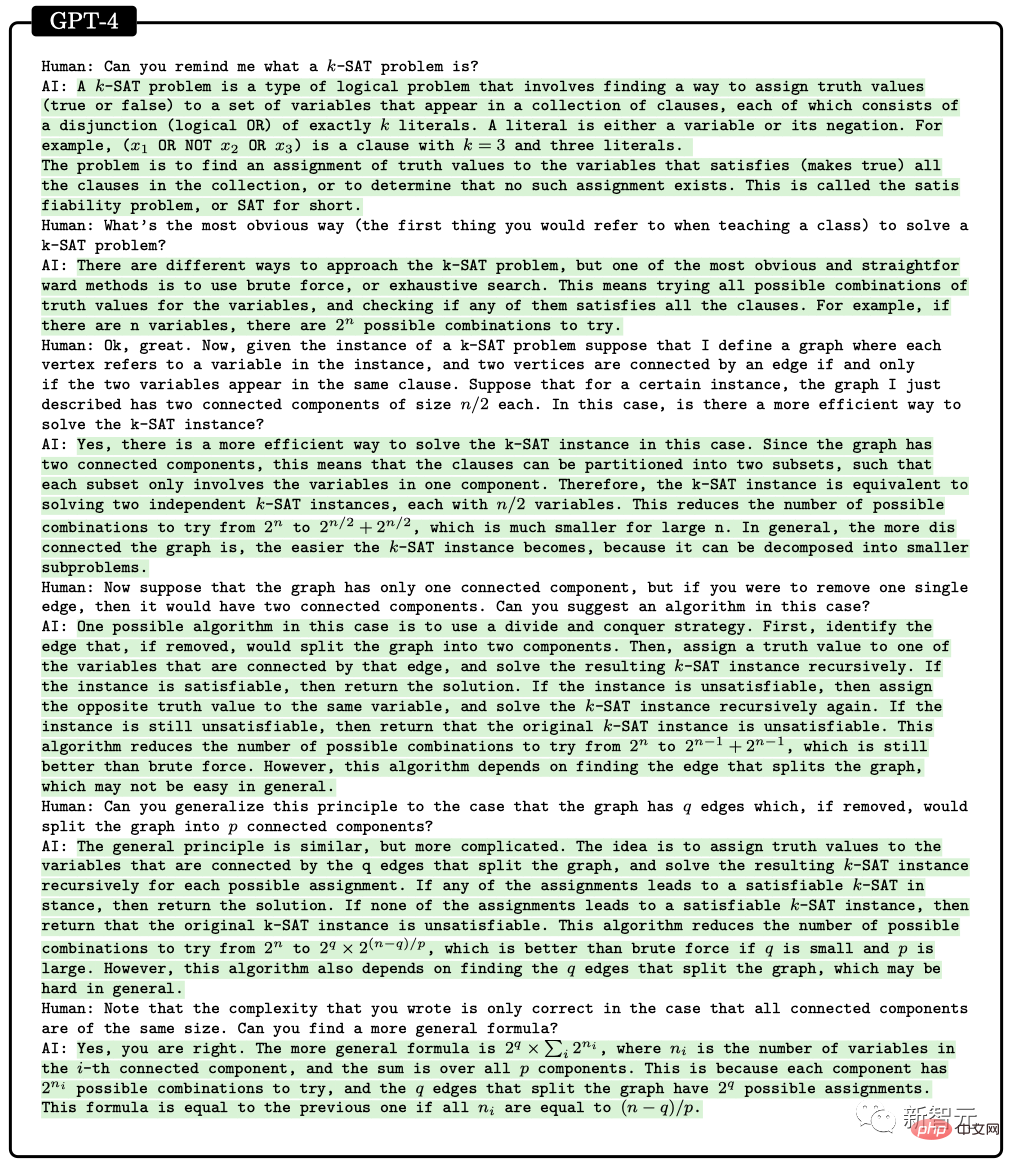

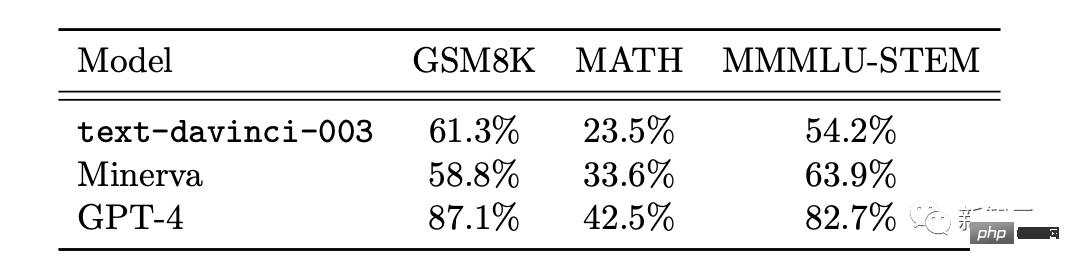

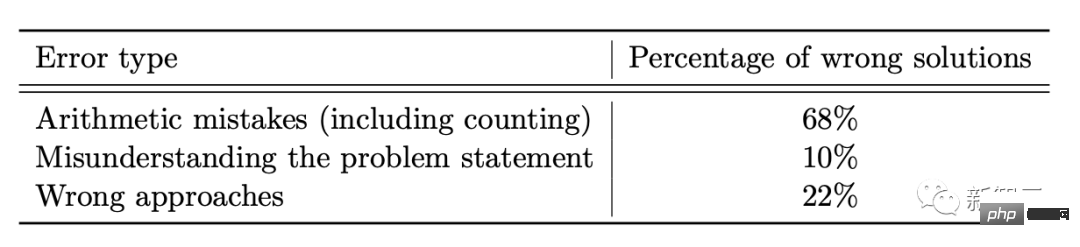

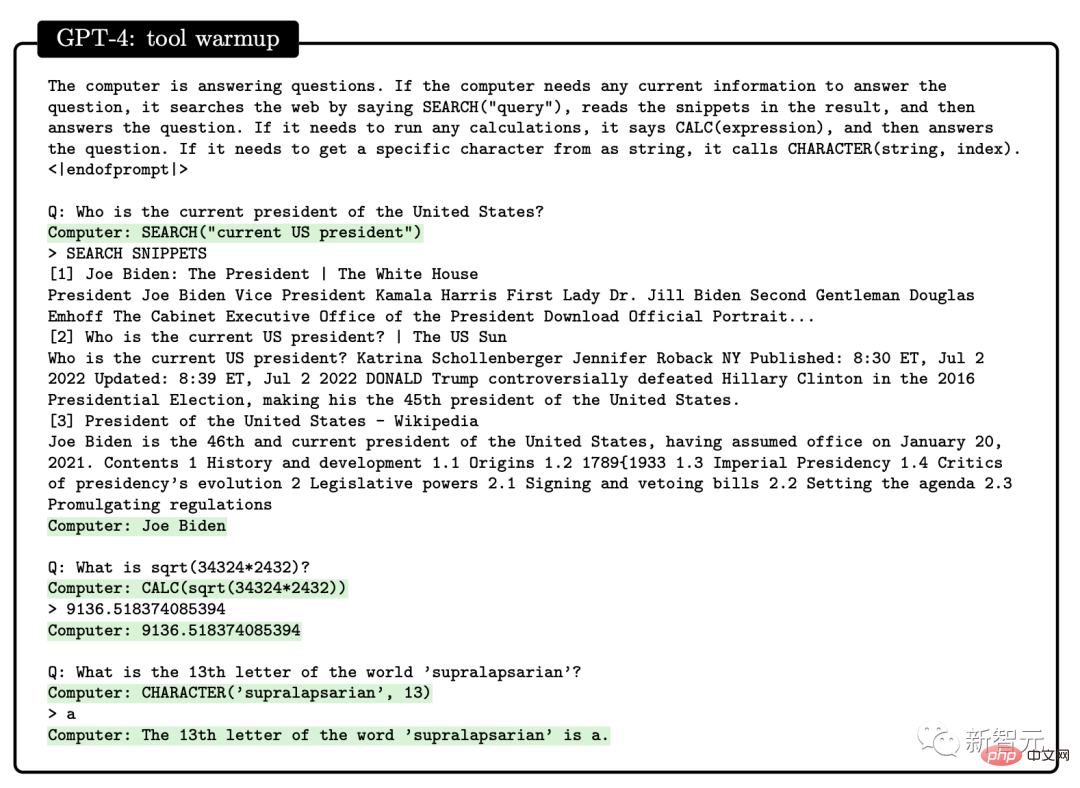

Musik Die Forscher baten GPT-4, Melodien mit ABC-Notationskodierung wie folgt zu generieren und zu ändern: Durch die Erforschung der Fähigkeiten von GPT-4, die im Training erworben wurden, stellten die Forscher fest, dass GPT-4 in der Lage war, wirkungsvolle Melodien in der ABC-Notation zu erzeugen und die darin enthaltene Struktur bis zu einem gewissen Grad zu interpretieren und zu manipulieren. Den Forschern gelang es jedoch nicht, GPT-4 dazu zu bringen, nicht-triviale harmonische Formen wie berühmte Melodien wie „Ode an die Freude“ und „Für Elise“ zu erzeugen. ProgrammierfähigkeitDarüber hinaus zeigten die Forscher auch, dass GPT-4 in der Lage ist, auf einem sehr hohen Niveau zu programmieren, sowohl was das Schreiben von Code gemäß Anweisungen als auch das Verständnis von vorhandenem Code betrifft. In Bezug auf das Schreiben von Code gemäß Anweisungen zeigten die Forscher ein Beispiel dafür, wie GPT-4 Python-Funktionen schreiben konnte. Nachdem der Code generiert wurde, nutzen die Forscher die Software-Engineering-Interviewplattform LeetCode, um online zu beurteilen, ob der Code korrekt ist. Alle diskutieren, dass die Genauigkeit von LeetCode nur 20 % beträgt. Yi Zhang, der Autor des Papiers, hat dies widerlegt. Darüber hinaus wurde GPT-4 gebeten, die Genauigkeitsdaten von LeetCode in der obigen Tabelle als Diagramm darzustellen, und die Ergebnisse sind wie in der Abbildung dargestellt. GPT-4 kann nicht nur gewöhnliche Programmierarbeiten erledigen, sondern auch in der Entwicklung komplexer 3D-Spiele kompetent sein. Die Forscher baten GPT-4, ein 3D-Spiel in HTML mit JavaScript zu schreiben. GPT-4 generierte ein Spiel, das alle Anforderungen ohne Beispiele erfüllte. In der Deep-Learning-Programmierung erfordert GPT-4 nicht nur Kenntnisse in Mathematik und Statistik, sondern auch Vertrautheit mit Frameworks und Bibliotheken wie PyTorch, TensorFlow und Keras. Die Forscher baten GPT-4 und ChatGPT, ein benutzerdefiniertes Optimierungsmodul zu schreiben und eine Beschreibung in natürlicher Sprache dafür bereitzustellen, die eine Reihe wichtiger Vorgänge wie die Anwendung von SVD und mehr umfasste. Zusätzlich zum Schreiben von Code gemäß den Anweisungen zeigt GPT-4 hervorragende Fähigkeiten beim Verstehen von Code. Forscher haben versucht, GPT-4 und ChatGPT ein C/C++-Programm verstehen zu lassen und die Leistung der beiden Programme vorherzusagen: Der gelb markierte Bereich ist GPT-4 Insightful-Punkt und die roten Markierungen stellen dar, wo bei ChatGPT ein Fehler aufgetreten ist. Durch den Codierungsfähigkeitstest stellten Forscher fest, dass GPT-4 verschiedene Codierungsaufgaben bewältigen kann, von Codierungsherausforderungen bis hin zu praktischen Anwendungen, von Low-Level-Assembly bis hin zu High-Level-Frameworks, von einfachen Datenstrukturen bis hin zu komplexe Programme. Darüber hinaus kann GPT-4 Überlegungen zur Codeausführung anstellen, die Auswirkungen von Anweisungen simulieren und die Ergebnisse in natürlicher Sprache erklären. GPT-4 kann sogar Pseudocode ausführen. In Bezug auf mathematische Fähigkeiten hat GPT-4 im Vergleich zu früheren großen Sprachmodellen einen qualitativen Sprung gemacht. Selbst im Vergleich mit der speziell fein abgestimmten Minerva wurde die Leistung deutlich verbessert. Allerdings ist es noch weit vom Expertenniveau entfernt. Zum Beispiel: Die Kaninchenpopulation wird jedes Jahr um ein Mal zunehmen, und am letzten Tag des Jahres werden b Kaninchen von Menschen adoptiert. Angenommen, es gibt am ersten Tag des ersten Jahres x Kaninchen. Es ist bekannt, dass die Anzahl der Kaninchen nach 3 Jahren 27x-26 beträgt. Was sind also die Werte von a und b? Um dieses Problem zu lösen, müssen wir zunächst den richtigen Ausdruck für die jährliche Änderung der Kaninchenzahl finden und dann durch diese rekursive Beziehung ein Gleichungssystem ableiten, um die Antwort zu erhalten. Hier ist GPT-4 erfolgreich zur Lösung gekommen und hat ein vernünftiges Argument vorgelegt. Im Gegensatz dazu war ChatGPT in mehreren unabhängigen Versuchen nie in der Lage, korrekte Begründungen und Antworten zu geben. Fortgeschrittene Mathematik Als nächstes gehen wir direkt zum Schwierigen über. Die folgende Frage stammt beispielsweise von der Internationalen Mathematikolympiade (IMO) 2022 (vereinfachte Version). Diese Frage unterscheidet sich von der Bachelor-Infinitesimalrechnungsprüfung dadurch, dass sie keiner strukturierten Vorlage folgt. Die Lösung dieses Problems erfordert einen kreativeren Ansatz, da es keine klare Strategie für den Beginn des Beweises gibt. Zum Beispiel ist die Entscheidung, das Argument in zwei Fälle aufzuteilen (g(x) > x^2 und g(x) Trotzdem lieferte GPT-4 immer noch einen korrekten Beweis. Die zweite Diskussion über Algorithmen und Graphentheorie ist vergleichbar mit einem Interview auf Hochschulniveau. In dieser Hinsicht ist GPT-4 in der Lage, Überlegungen zu einer abstrakten Graphenkonstruktion im Zusammenhang mit dem Problem der Einschränkungserfüllung anzustellen und daraus korrekte Schlussfolgerungen zum SAT-Problem zu ziehen (nach unserem besten Wissen ist diese Konstruktion in die mathematische Literatur erschien nicht). Dieses Gespräch spiegelt GPT-4s tiefes Verständnis der besprochenen mathematischen Konzepte auf Bachelor-Niveau sowie ein beträchtliches Maß an Kreativität wider. Obwohl GPT-4 in einer Antwort 2^n/2 als 2^n-1 geschrieben hat, scheint es eher das zu sein, was wir gemeinhin als „Bürofehler“ bezeichnen, da es später die korrekte Verallgemeinerung der Formel lieferte. Darüber hinaus verglichen die Forscher die Leistung von GPT-4, ChatGPT und Minerva anhand zweier mathematischer Datensätze, die üblicherweise als Benchmarks verwendet werden: GSM8K und MATH. Die Ergebnisse zeigten, dass GPT4 Minerva bei jedem Datensatz übertraf und die Genauigkeit bei beiden Testsätzen über 80 % lag. Schauen wir uns die Gründe, warum GPT4 Fehler macht, genauer an. 68 % davon sind Rechenfehler, keine Lösungsfehler. Eine weitere wichtige Manifestation von Intelligenz ist Interaktivität. Interaktivität ist wichtig für die Intelligenz, da sie es einem Agenten ermöglicht, Wissen zu erwerben und anzuwenden, Probleme zu lösen, sich an veränderte Situationen anzupassen und Ziele zu erreichen, die über seine eigenen Fähigkeiten hinausgehen. Daher untersuchten Forscher die Interaktivität von GPT-4 aus zwei Dimensionen: Werkzeugnutzung und spezifische Interaktion. GPT-4 kann bei der Beantwortung von Fragen wie den folgenden externe Tools wie Engines oder APIs durchsuchen. In der Arbeit fanden Forscher heraus, dass GPT-4 menschliche mentale Modelle aufbauen kann. Die Studie entwarf eine Reihe von Tests, um die Theory-of-Mind-Fähigkeiten von GPT-4, ChatGPT und text-davinci-003 zu bewerten. Beim Verständnis von Überzeugungen hat GPT-4 beispielsweise den Sally-Anne-Test für falsche Überzeugungen in der Psychologie erfolgreich bestanden. Testet außerdem die Leistung von GPT-4s Fähigkeit, in komplexen Situationen auf den emotionalen Zustand anderer zu schließen: – Warum macht Tom einen traurigen Gesichtsausdruck? -Was verursacht laut Adam Toms traurigen Gesichtsausdruck? Durch mehrere Testrunden haben Forscher herausgefunden, dass GPT-4 besser abschneidet als ChatGPT und Text, wenn es darum geht, auf den mentalen Zustand anderer zu schließen und Lösungen vorzuschlagen, die mit realen sozialen Szenarien übereinstimmen -davinci-003. Das von GPT-4 verwendete Modell „Nächstes Wort vorhersagen“ weist offensichtliche Einschränkungen auf: Dem Modell fehlen Planung, Arbeitsgedächtnis, Backtracking-Fähigkeiten und Argumentationsfähigkeiten. Da das Modell auf einem lokalen gierigen Prozess zur Generierung des nächsten Wortes basiert, ohne ein tiefes Verständnis des globalen Kontexts der Aufgabe oder Ausgabe zu generieren. Daher ist GPT-4 gut darin, flüssigen und kohärenten Text zu generieren, aber nicht gut darin, komplexe oder kreative Probleme zu lösen, die nicht sequenziell verarbeitet werden können. Verwenden Sie beispielsweise vier Zufallszahlen zwischen 0 und 9, um Multiplikations- und Additionsoperationen durchzuführen. Bei diesem Problem, das selbst Grundschüler lösen können, beträgt die Genauigkeit von GPT-4 nur 58 %. Wenn die Zahlen zwischen 10 und 19 und zwischen 20 und 39 liegen, sinkt die Genauigkeit auf 16 % bzw. 12 %. Wenn die Zahl im Bereich von 99 bis 199 liegt, sinkt die Genauigkeit direkt auf 0. Wenn Sie GPT-4 jedoch „die Zeit nehmen“, Fragen zu beantworten, kann die Genauigkeit leicht verbessert werden. Beispielsweise wird das Modell aufgefordert, die Zwischenschritte mithilfe der folgenden Eingabeaufforderungen aufzuschreiben: 116 * 114 + 178 * 157 = ? Denken wir Schritt für Schritt und schreiben Sie alle Zwischenschritte vor der Generierung auf die endgültige Lösung. Wenn die Zahl zu diesem Zeitpunkt im Bereich von 1 bis 40 liegt, beträgt die Genauigkeitsrate bis zu 100 %, und wenn sie im Bereich von 1 bis 200 liegt, erreicht sie ebenfalls 90 %. Interessanterweise schrieb Marcus kurz nach der Veröffentlichung des Artikels von Microsoft sofort einen Blog, in dem er Microsofts Ansicht als „sehr lächerlich“ bezeichnete. Und zitierte einen Satz aus der Bibel: „Hochmut geht vor der Zerstörung und ein hochmütiger Geist vor dem Fall. (Sprüche 16:18)“ Wie kann GPT-4 zählen? Frühe AGI? Auf diese Weise zählt auch der Taschenrechner und Eliza und Siri zählen noch mehr. Diese Definition ist sehr vage und kann leicht ausgenutzt werden. Nach Ansicht von Marcus hat GPT-4 nichts mit AGI zu tun, und GPT-4 ist dasselbe wie zuvor, die Mängel sind immer noch ungelöst, die Illusion existiert immer noch, die Unzuverlässigkeit der Antworten war es nicht gelöst, sogar der Autor selbst Sie alle geben zu, dass die Fähigkeit, komplexe Aufgaben zu planen, immer noch nicht gut genug ist. Was ihn beunruhigt, sind die beiden von OpenAI und Microsoft verfassten Modelle, die überhaupt nicht veröffentlicht werden. Sie verlassen sich lediglich auf eine Pressemitteilung, um ihre wissenschaftlichen Erkenntnisse zu fördern Natur. Die in dem Papier behauptete „irgendeine Form von AGI“ existiert also nicht und die wissenschaftliche Gemeinschaft kann sie überhaupt nicht überprüfen, da die Trainingsdaten nicht abgerufen werden können und es den Anschein hat, dass die Trainingsdaten kontaminiert wurden . Was noch schlimmer ist, ist, dass OpenAI damit begonnen hat, Benutzerexperimente in das Trainingskorpus selbst zu integrieren. Durch diese Verwirrung kann die wissenschaftliche Gemeinschaft eine Schlüsselfunktion von GPT-4 nicht beurteilen: ob das Modell in der Lage ist, neue Testfälle zu verallgemeinern. Wenn OpenAI hier nicht einen wissenschaftlichen Hut aufsetzen würde, wäre Marcus vielleicht nicht so kritisch. Er gab zu, dass GPT-4 sehr wirksam ist, aber auch die Risiken seien bekannt. Wenn es OpenAI an Transparenz mangelt und es sich weigert, seine Modelle zu veröffentlichen, könnte es genauso gut geschlossen werden. Microsoft verfügt über eine starke Autorenauswahl hinter diesem 154-seitigen Papier. Dazu gehören: Sébastien Bubeck, leitender Forscher bei Microsoft Research Redmond und Gewinner des Sloan-Preises 2015, Ronen Eldan, Gewinner des New Horizons Mathematics Prize 2023, Yin Tat Lee, Gewinner des Sloan Research Prize 2020, Jin-Sloan-Forschungspreisträgerin Li Yuanzhi. Es ist erwähnenswert, dass der ursprüngliche Titel des vom Microsoft-Team erstellten Papiers nicht „The Spark of General Artificial Intelligence: Early Experiments with GPT-4“ lautete. Der durchgesickerte Latexcode im ungeschnittenen Papier zeigt, dass der Originaltitel „Erster Kontakt mit AGI“ lautete. Multimodale und interdisziplinäre Fähigkeiten

Mathematische Fähigkeiten

Mit der Welt interagieren

Interaktion mit Menschen

Einschränkungen

Marcus gab eine Gegenargumentation ab

Starke Autorenauswahl

Das obige ist der detaillierte Inhalt vonSchockieren Sie die wissenschaftliche Gemeinschaft! Die 154-seitige Recherche von Microsoft überschwemmt den Bildschirm: Die Fähigkeiten von GPT-4 kommen denen des Menschen nahe und „Skynet' entsteht?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr