Heim >Technologie-Peripheriegeräte >KI >Der Vater von LSTM forderte LeCun erneut heraus: Ihre fünf Punkte der „Innovation' wurden alle von mir abgeschaut! Aber leider: „Ich kann es nicht zurücklesen'

Der Vater von LSTM forderte LeCun erneut heraus: Ihre fünf Punkte der „Innovation' wurden alle von mir abgeschaut! Aber leider: „Ich kann es nicht zurücklesen'

- 王林nach vorne

- 2023-04-16 10:04:021102Durchsuche

Kürzlich hatte Jürgen Schmidhuber, der Vater von LSTM, erneut eine Meinungsverschiedenheit mit LeCun!

Tatsächlich wissen Studierende, die mit diesem mürrischen Mann schon einmal ein wenig vertraut waren, dass es eine enge Beziehung zwischen dem Außenseiter Jürgen Schmidhuber und mehreren großen Figuren des maschinellen Lernens gibt Gemeinschaft. Es gab unangenehme Erfahrungen.

Besonders als „diese drei Leute“ gemeinsam den Turing Award gewannen, Schmidhuber jedoch nicht, wurde der alte Mann noch wütender...#🎜🎜 ##🎜 🎜#

Schmidhuber hat immer geglaubt, dass diese aktuellen ML-Führer, wie Bengio, Hinton, LeCun, darunter der Vater von „GAN“ Goodfellow und andere, viele ihrer sogenannten „ Seine bahnbrechenden „sexuellen Errungenschaften“ wurden alle zuerst von ihm selbst erwähnt, aber diese Leute erwähnten ihn in ihren Arbeiten überhaupt nicht.Zu diesem Zweck hat Schmidhuber einmal einen Sonderartikel geschrieben, um den 2015 von Bengio, Hinton und LeCun in Nature veröffentlichten Rezensionsartikel „Deep Learning“ zu kritisieren. Fan.

Ich spreche hauptsächlich über die Ergebnisse in diesem Artikel, welche Dinge von ihm zuerst erwähnt wurden und welche Dinge von anderen Senioren zuerst erwähnt wurden. Diese drei waren es jedenfalls nicht Autoren zuerst erwähnt.

Warum streiten sie schon wieder?

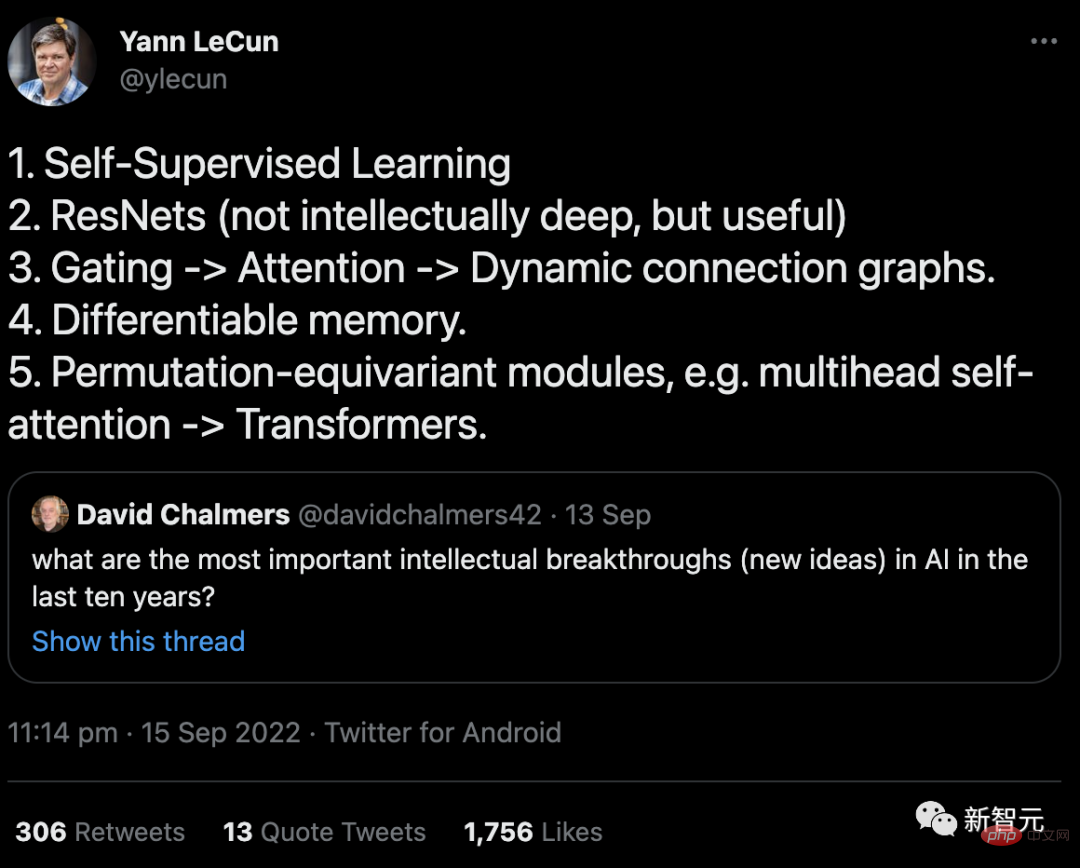

Zurück zur Ursache dieses Vorfalls: Es handelte sich tatsächlich um einen Tweet, den LeCun im September gesendet hatte.

Der Inhalt ist eine Antwort auf die Frage von Professor David Chalmers: „Was ist der wichtigste intellektuelle Durchbruch (neue Idee) in der KI in den letzten zehn Jahren?“ 🎜🎜 #

Am 4. Oktober schrieb Schmidhuber wütend einen Artikel auf seinem Blog: Die meisten dieser 5 „besten Ideen“ stammen von In meinem Labor liegt der vorgeschlagene Zeitpunkt viel früher als der Zeitpunkt „10 Jahre“.

Am 4. Oktober schrieb Schmidhuber wütend einen Artikel auf seinem Blog: Die meisten dieser 5 „besten Ideen“ stammen von In meinem Labor liegt der vorgeschlagene Zeitpunkt viel früher als der Zeitpunkt „10 Jahre“.

In dem Artikel führte Schmidhuber sechs Beweise im Detail auf, die seine Argumentation untermauern sollten.

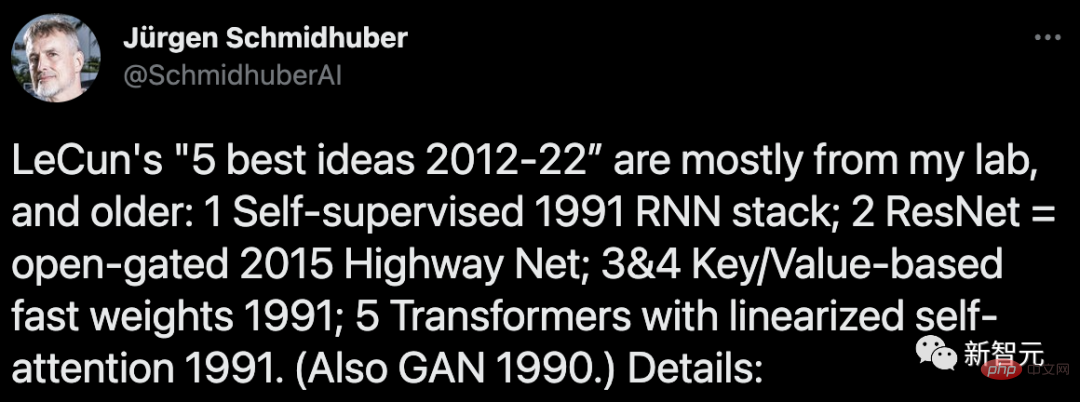

Aber wahrscheinlich weil es zu wenige Leute gesehen haben, hat Schmidhuber am 22. November erneut getwittert. Braten Sie diesen „kalten Reis“ wieder.

Aber wahrscheinlich weil es zu wenige Leute gesehen haben, hat Schmidhuber am 22. November erneut getwittert. Braten Sie diesen „kalten Reis“ wieder.

Aber im Vergleich zum letzten Mal, das ein ziemlich hitziger Streit war, hat LeCun dieses Mal nicht einmal darauf geachtet ...

# 🎜🎜#

Der Vater von LSTM legte „sechs wichtige Beweise“ vor

# 🎜🎜#1. Durch Nerven „Selbstüberwachtes Lernen“, bei dem das Netzwerk (NN) automatisch Anmerkungen generiert: lässt sich zumindest auf meine Arbeit in den Jahren 1990-91 zurückführen.

(I) Selbstüberwachte Objektgenerierung in einem wiederkehrenden neuronalen Netzwerk (RNN) mittels prädiktiver Codierung, um zu lernen, Datensequenzen auf mehreren Zeitskalen und Abstraktionsebenen zu komprimieren.

Hier lernt ein „Automat“-RNN die Voraufgabe der „Vorhersage der nächsten Eingabe“ und zielt auf unerwartete Beobachtungen im eingehenden Datenstrom ab. Wird an einen „Chunker“ gesendet. RNN, das Regelmäßigkeiten auf höherer Ebene lernt und dann sein erworbenes Vorhersagewissen wieder in einen Automaten mit entsprechenden Trainingszielen verfeinert.

Dies erleichtert die nachgelagerte Deep-Learning-Aufgabe der Sequenzklassifizierung, die zuvor unlösbar war, erheblich.

(II) Selbstüberwachte Annotationsgenerierung über intrinsische Motivation vom GAN-Typ, bei der ein Weltmodell NN das Vorhersagen lernt die Verhaltenskonsequenzen gegnerischer, annotationsgenerierter, experimentell erfundener Controller-NNs.

Darüber hinaus tauchte der Begriff „Selbstüberwachung“ bereits im Titel der von mir 1990 veröffentlichten Arbeit auf .

Aber in einer früheren Arbeit (1978) wurde dieses Wort auch verwendet...

# 🎜🎜#2. „ResNets“: Tatsächlich habe ich Highway Nets schon früh vorgeschlagen. Aber LeCun ist der Meinung, dass die Intelligenz von ResNets „nicht tiefgreifend“ ist, was mich sehr traurig macht.

Bevor ich Highway Nets vorschlug, hatten Feedforward-Netzwerke höchstens ein paar Dutzend Schichten (20–30 Schichten), während Highway Nets das erste wirklich tiefe Feedforward-Neuronale Netzwerk mit Hunderten von Schichten war.

In den 1990er Jahren brachte mein LSTM überwachten rekursiven NNs im Wesentlichen unendliche Tiefe. In den 2000er Jahren brachten LSTM-inspirierte Highway Nets den Feedforward-NNs Tiefe.

Infolgedessen ist LSTM das am häufigsten zitierte NN im 20. Jahrhundert und Highway Nets (ResNet) das am häufigsten zitierte NN im 21. Jahrhundert.

Man kann sagen, dass sie die Essenz des tiefen Lernens darstellen, und beim tiefen Lernen geht es um die Tiefe von NN.

3. „Gating->Attention->Dynamic Connected Graph“: Es kann zumindest auf meine Fast Weight Programmers und Key-Value Memory Networks von 1991-93 zurückgeführt werden (der „Key-Value“ genannt). „VON-BIS“).

1993 habe ich den Begriff „Aufmerksamkeit“ eingeführt, wie wir ihn heute verwenden.

Es ist jedoch erwähnenswert, dass das erste Multiplikationsgatter in NN auf die Deep-Learning-Maschine von Ivakhnenko & Lapa aus dem Jahr 1965 zurückgeführt werden kann.

4. „Differenzierbares Gedächtnis“: Es kann auch auf meine Fast Weight Programmers oder Key-Value Memory Networks aus dem Jahr 1991 zurückgeführt werden.

Getrennte Speicherung und Steuerung wie bei herkömmlichen Computern, jedoch auf durchgängig differenzielle, adaptive, vollständig neuronale Weise (nicht auf hybride Weise).

5. „Äquivalente Ersatzmodule wie Multi-Head-Selbstaufmerksamkeit->Transformer“: Ich habe 1991 einen Transformer mit linearisierter Selbstaufmerksamkeit veröffentlicht. Der entsprechende Begriff „interne Scheinwerfer der Aufmerksamkeit“ stammt aus dem Jahr 1993.

6. „GAN ist das beste maschinelle Lernkonzept der letzten 10 Jahre“

Das von Ihnen erwähnte GAN-Prinzip (2014) ist tatsächlich das Prinzip, das ich 1990 mit künstlicher Intelligenz entwickelt habe im Namen der Neugier.

Das letzte Mal war vor ein paar Monaten

Tatsächlich ist es nicht das erste Mal, dass Schmidhuber und LeCun dieses Jahr Streit haben.

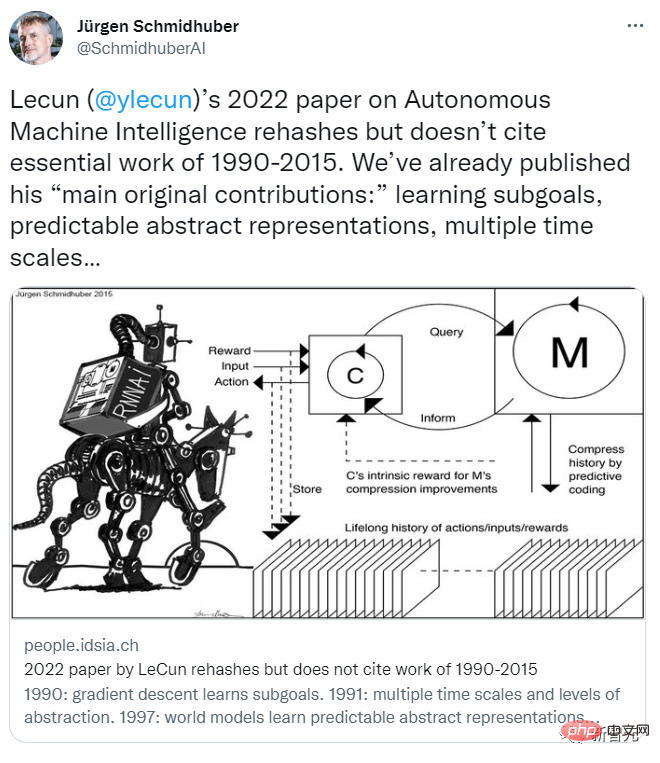

Im Juni und Juli stritten sich die beiden hin und her über einen von LeCun veröffentlichten Ausblickbericht zur „Zukünftigen Ausrichtung der autonomen Maschinenintelligenz“.

Am 27. Juni veröffentlichte Yann LeCun den Artikel „A Path Towards Autonomous Machine Intelligence“, den er mehrere Jahre lang gespeichert hatte, und nannte ihn „ein Werk, das die zukünftige Entwicklungsrichtung der KI aufzeigt“.

Dieser Aufsatz befasst sich systematisch mit der Frage „Wie können Maschinen wie Tiere und Menschen lernen?“ und ist mehr als 60 Seiten lang.

LeCun sagte, dass dieser Artikel nicht nur seine Gedanken zur allgemeinen Richtung der KI-Entwicklung in den nächsten 5 bis 10 Jahren widerspiegelt, sondern auch, was er in den nächsten Jahren erforschen will, und hofft, mehr Menschen in diesem Bereich zu inspirieren KI-Feld zum gemeinsamen Lernen.

Und Schmidhuber erfuhr etwa zehn Tage im Voraus von der Nachricht, bekam die Zeitung und schrieb sofort einen Artikel, um sie zu widerlegen.

Laut Schmidhubers eigenem Blogbeitrag geschah damals Folgendes:

Am 14. Juni 2022 veröffentlichte ein Wissenschaftsmedium die Nachricht, dass LeCun am 27. Juni einen Bericht veröffentlichen würde. Er schickte mir einen Entwurf des Berichts (der zu diesem Zeitpunkt noch vertraulich war) und bat mich um einen Kommentar.

Ich habe eine Rezension geschrieben, in der ich ihnen sagte, dass dies im Grunde eine Nachbildung unserer vorherigen Arbeit sei, die in LeCuns Artikel nicht erwähnt wurde.

Meine Meinung stieß jedoch auf taube Ohren.

Tatsächlich hatten wir lange vor der Veröffentlichung seines Artikels die meisten von LeCuns sogenannten „ursprünglichen Hauptbeiträgen“ in diesem Artikel vorgeschlagen, darunter hauptsächlich:

(1) „Kognitive Architektur, in der „Alle Module sind trennbar und viele Module sind trainierbar“ (von uns 1990 vorgeschlagen).

(2) „Vorhersage hierarchischer Strukturen von Weltmodellen, Lernen von Darstellungen auf mehreren Abstraktionsebenen und mehreren Zeitskalen“ (wir haben 1991 vorgeschlagen).

(3) „Selbstüberwachtes Lernparadigma, das Darstellungen erzeugt, die sowohl informativ als auch vorhersehbar sind“ (Unser Modell wird seit 1997 beim Reinforcement Learning und der Weltmodellierung verwendet)

( 4) Vorhersagemodelle „für hierarchische „Planung unter Unsicherheit“, einschließlich Gradienten-basierter neuronaler Teilzielgeneratoren (1990), Argumentation in abstrakten Konzepträumen (1997) und „Lernhandlungen hauptsächlich durch Beobachtung“. Neuronale Netze (2015) und Denken lernen (2015) wurden beide vorgeschlagen von Wir zuerst.

Am 14. Juli antwortete Yann LeCun, dass die Diskussion konstruktiv sein sollte:

Ich möchte nicht in eine bedeutungslose Debatte darüber geraten, „Wer hat ein bestimmtes Konzept erfunden?“ Ich möchte mich nicht mit den 160 Referenzen befassen, die in Ihrem Antwortartikel aufgeführt sind. Ich denke, ein konstruktiverer Ansatz wäre es, vier Veröffentlichungen zu identifizieren, von denen Sie glauben, dass sie Ideen und Methoden aus den vier von mir aufgelisteten Beiträgen enthalten könnten.

Wie ich zu Beginn des Beitrags sagte, gibt es viele Konzepte, die es schon lange gibt, und weder Sie noch ich sind die Erfinder dieser Konzepte: zum Beispiel das Konzept der feinabstimmbaren Weltmodelle , die bis in die Anfänge der Optimierungskontrollarbeit zurückverfolgt werden kann.

Das Training des Weltmodells nutzt neuronale Netze, um die Systemidentifikation des Weltmodells zu erlernen. Diese Idee geht auf die späten 1980er Jahre zurück, mit Arbeiten von Michael Jordan, Bernie Widrow, Robinson & Fallside, Kumpathi Narendra und Paul Werbos als bei Ihnen. Arbeiten Sie früh.

Meiner Meinung nach scheint diese Strohmann-Antwort darin zu liegen, dass LeCun das Thema wechselt und die Frage vermeidet, in seinem sogenannten „hauptsächlichen Originalbeitrag“ die Anerkennung für andere in Anspruch zu nehmen.

Ich habe am 14. Juli geantwortet:

Zu dem, was Sie über „etwas, das weder Sie noch ich erfunden haben“ gesagt haben: In Ihrem Artikel wird behauptet, dass die Verwendung neuronaler Netze zur Systemidentifikation bis in die frühen 1990er Jahre zurückreicht. In Ihrer vorherigen Antwort schienen Sie mir jedoch zuzustimmen, dass die ersten Veröffentlichungen zu diesem Thema in den 1980er Jahren erschienen sind.

Was Ihren „hauptsächlichen Originalbeitrag“ betrifft, so haben sie tatsächlich die Ergebnisse meiner frühen Arbeiten verwendet.

(1) Bezüglich der von Ihnen vorgeschlagenen „kognitiven Architektur“, in der alle Module differenzierbar und viele Module trainierbar sind“ und „Verhalten durch intrinsische Motivation gesteuert wird“:

Ich habe eine differenzierbare Architektur vorgeschlagen für Online-Lernen und -Planen im Jahr 1990. Dies war der erste Controller mit „intrinsischer Motivation“ zur Verbesserung des Weltmodells. Es war sowohl generativ als auch kontradiktorisch. Das im Artikel zitierte GAN von 2014 ist eine abgeleitete Version dieses Modells.

(2) Bezüglich Ihrer vorgeschlagenen „hierarchischen Struktur prädiktiver Weltmodelle, die Darstellungen auf mehreren Abstraktionsebenen und Zeitskalen lernen“:

Dies stammt aus meiner Neurohistorie von 1991, erreicht durch Kompressor. Es verwendet prädiktive Codierung, um hierarchische interne Darstellungen langer Sequenzdaten selbstüberwacht zu lernen, was das nachgelagerte Lernen erheblich erleichtert. Mit meinem Verfahren zur Verfeinerung neuronaler Netze aus dem Jahr 1991 können diese Darstellungen zu einem einzigen rekurrenten neuronalen Netz (RNN) zusammengefasst werden.

(3) Bezüglich Ihres „selbstüberwachten Lernparadigmas zur Erzeugung von Darstellungen, die sowohl informativ als auch vorhersehbar sind“ im Hinblick auf die Kontrolle:

Dies wurde bereits in dem System vorgeschlagen, das ich 1997 aufbauen wollte. Anstatt alle Details zukünftiger Eingaben vorherzusagen, kann es beliebige abstrakte Fragen stellen und berechenbare Antworten in einem sogenannten „Darstellungsraum“ geben. In diesem System wählen zwei Lernmodelle namens „linke Gehirnhälfte“ und „rechte Gehirnhälfte“ Gegner mit maximalen Belohnungen aus, um an Nullsummenspielen teilzunehmen, und setzen gelegentlich auf die Ergebnisse solcher Computerexperimente.

(4) In Bezug auf Ihr prädiktives differenzierbares Modell für die hierarchische Planung, das unter Unsicherheit verwendet werden kann, heißt es in Ihrem Artikel:

„Eine unbeantwortete Frage ist: Wie der Konfigurator lernt, eine komplexe Aufgabe in eine zu zerlegen Eine Reihe von Teilzielen, die der Agent allein erfüllen kann. Diese Frage überlasse ich der zukünftigen Untersuchung. „

Sagen Sie nichts über die Zukunft, eigentlich bin ich 30. Dieser Artikel wurde vor vielen Jahren veröffentlicht:

Ein Controller-Neuronales Netzwerk ist dafür verantwortlich, zusätzliche Befehlseingaben in der Form (Start, Ziel) zu erhalten. Ein schätzendes neuronales Netzwerk ist dafür verantwortlich, zu lernen, die erwarteten Kosten vom Start bis zum Ziel vorherzusagen. Ein Unterzielgenerator, der auf einem feinabstimmbaren rekurrenten neuronalen Netzwerk basiert, sieht diese Eingabe (Start, Ziel) und lernt eine Folge von Zwischenzielen mit minimalen Kosten über einen Gradientenabstieg unter Verwendung eines schätzenden neuronalen Netzwerks.

(5) Sie haben auch das neuronale Netzwerk hervorgehoben, das „Verhalten hauptsächlich durch Beobachtung lernt“. Wir haben dieses Problem tatsächlich schon sehr früh gelöst, nämlich im Jahr 2015 mit diesem Artikel, in dem wir das allgemeine Problem des Reinforcement Learning (RL) in teilweise beobachtbaren Umgebungen diskutieren.

Ein Weltmodell M kann manche Dinge gut vorhersagen, ist sich aber bei anderen unsicher. Controller C maximiert seine Zielfunktion, indem er lernt, Antworten (mehr Aktivierungsmuster) durch eine Folge selbst erfundener Fragen (Aktivierungsmuster) abzufragen und zu interpretieren.

C kann davon profitieren, zu lernen, jede Art von algorithmischen Informationen aus M zu extrahieren, z. B. für hierarchische Planung und Argumentation, die Nutzung passiver, in M codierter Beobachtungen usw.

Das obige ist der detaillierte Inhalt vonDer Vater von LSTM forderte LeCun erneut heraus: Ihre fünf Punkte der „Innovation' wurden alle von mir abgeschaut! Aber leider: „Ich kann es nicht zurücklesen'. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr