Heim >Technologie-Peripheriegeräte >KI >Eine GPU kann 3D-Modelle in Sekundenschnelle erstellen! Das neue Werk von OpenAI: Point-E kann mithilfe von Text 3D-Punktwolkenmodelle generieren

Eine GPU kann 3D-Modelle in Sekundenschnelle erstellen! Das neue Werk von OpenAI: Point-E kann mithilfe von Text 3D-Punktwolkenmodelle generieren

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-15 08:58:02948Durchsuche

Wo ist der nächste Durchbruch, der die KI-Welt im Sturm erobern wird?

Viele Leute gehen davon aus, dass es sich um einen 3D-Modellgenerator handelt.

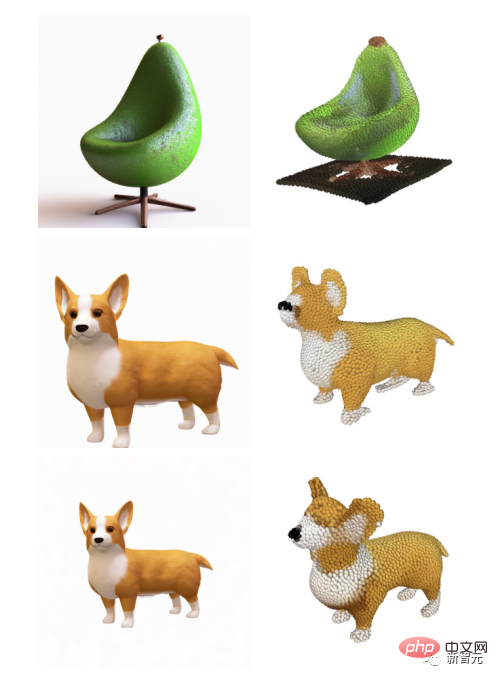

Nachdem DALL-E 2 zu Beginn des Jahres alle mit seinem genialen Pinsel überraschte, veröffentlichte OpenAI am Dienstag sein neuestes Bildgenerierungsmodell „POINT-E“, das direkt 3D-Modelle aus Text generieren kann.

Link zum Papier: https://arxiv.org/pdf/2212.08751.pdf

Im Vergleich zu Konkurrenten (wie Googles DreamFusion), die mehrere GPUs benötigen, um mehrere Stunden lang zu arbeiten, PUNKT - E generiert 3D-Bilder in wenigen Minuten mit nur einer einzigen GPU.

Nach dem eigentlichen Test durch den Editor kann POINT-E 3D-Bilder grundsätzlich in Sekunden nach der Eingabeaufforderung ausgeben. Darüber hinaus unterstützt das Ausgabebild auch benutzerdefinierte Bearbeitung, Speicherung und andere Funktionen.

Adresse: https://huggingface.co/spaces/openai/point-e

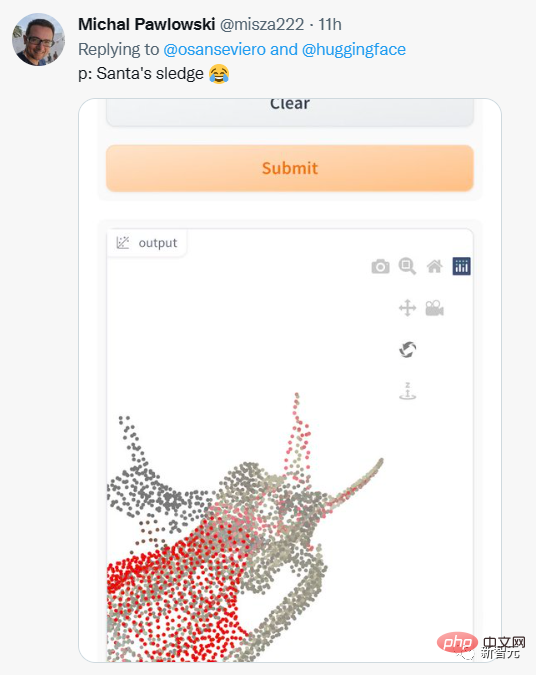

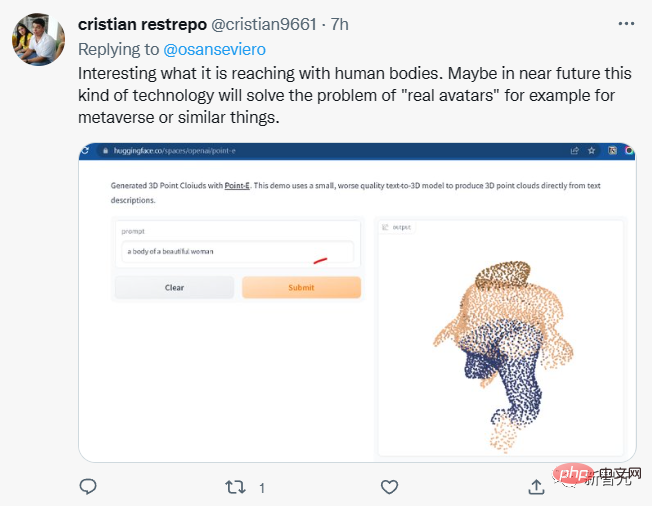

Internetnutzer begannen auch, verschiedene Eingabeaufforderungen auszuprobieren.

Aber die Ausgabeergebnisse sind nicht immer zufriedenstellend.

Einige Internetnutzer sagten, dass POINT-E möglicherweise in der Lage sein könnte, Metas Metaversum-Vision zu verwirklichen?

Es ist zu beachten, dass POINT-E 3D-Bilder durch eine Punktwolke (Punktwolke) generiert, bei der es sich um einen Datensatz von Punkten im Raum handelt.

Einfach ausgedrückt geht es darum, Daten über ein dreidimensionales Modell zu sammeln, um Punktwolkendaten zu erhalten, die eine 3D-Form im Raum darstellen.

Punktwolken sind aus rechnerischer Sicht einfacher zu synthetisieren, sie können jedoch nicht die empfindliche Form oder Textur von Objekten erfassen, was derzeit ein Manko von Point-E ist.

Um diese Einschränkung zu beheben, trainierte das Point-E-Team ein zusätzliches künstliches Intelligenzsystem, um die Punktwolken von Point-E in Netze umzuwandeln.

Point-E-Punktwolke in Netz umwandeln

Über das unabhängige Netzgenerierungsmodell hinaus besteht Point-E aus zwei Modellen:

Ein Text-zu-Bild-Konvertierungsmodell (Text -zu-Bild-Modell) und Bildkonvertierung 3D-Modell (Bild-zu-3D-Modell).

Das Text-zu-Bild-Konvertierungsmodell ähnelt DALL-E 2 und Stable Diffusion von OpenAI und wird auf beschrifteten Bildern trainiert, um den Zusammenhang zwischen Wörtern und visuellen Konzepten zu verstehen.

Dann wird ein Satz gepaarter Bilder mit 3D-Objekten in das 3D-Transformationsmodell eingespeist, damit das Modell lernt, effizient zwischen den beiden zu transformieren.

Wenn eine Eingabeaufforderung eingegeben wird, generiert das Text-Bild-Konvertierungsmodell ein synthetisches Renderobjekt, das dem Bildkonvertierungs-3D-Modell zugeführt wird, das dann eine Punktwolke generiert.

OpenAI-Forscher sagen, dass Point-E anhand eines Datensatzes von Millionen von 3D-Objekten und zugehörigen Metadaten trainiert wurde.

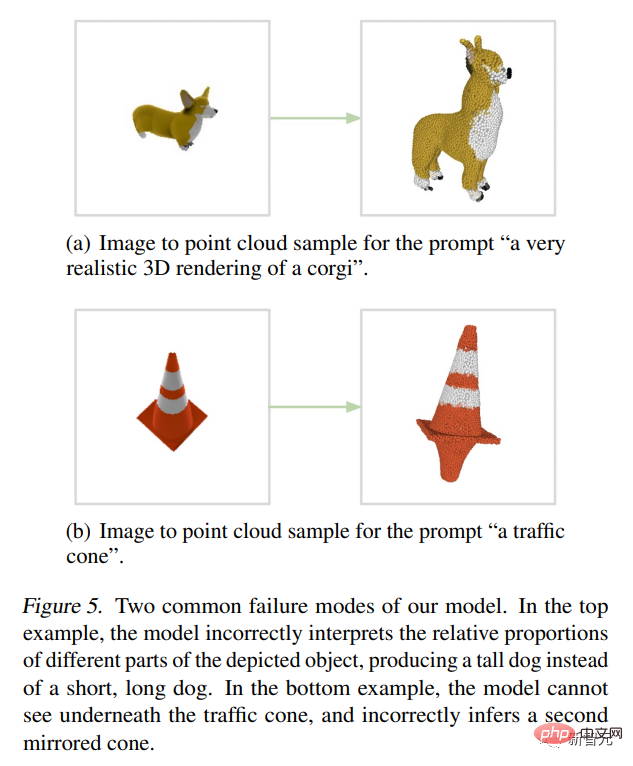

Aber es ist nicht perfekt. Das Bild-zu-3D-Modell von Point-E kann manchmal Bilder im Text-zu-Bild-Modell nicht verstehen, was zu Formen führt, die nicht mit dem Texthinweis übereinstimmen. Dennoch ist es um Größenordnungen schneller als frühere, hochmoderne Technologien.

Sie schrieben in der Arbeit:

Obwohl unsere Methode bei der Auswertung schlechter abschneidet als der Stand der Technik, generiert sie Proben in einem Bruchteil der Zeit. Dies kann es für bestimmte Anwendungen praktischer machen und qualitativ hochwertigere 3D-Objekte entdecken.

Point-E-Architektur und Betriebsmechanismus

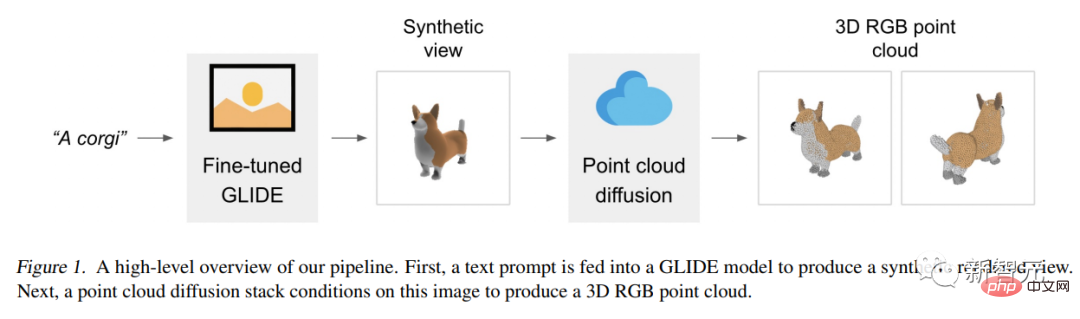

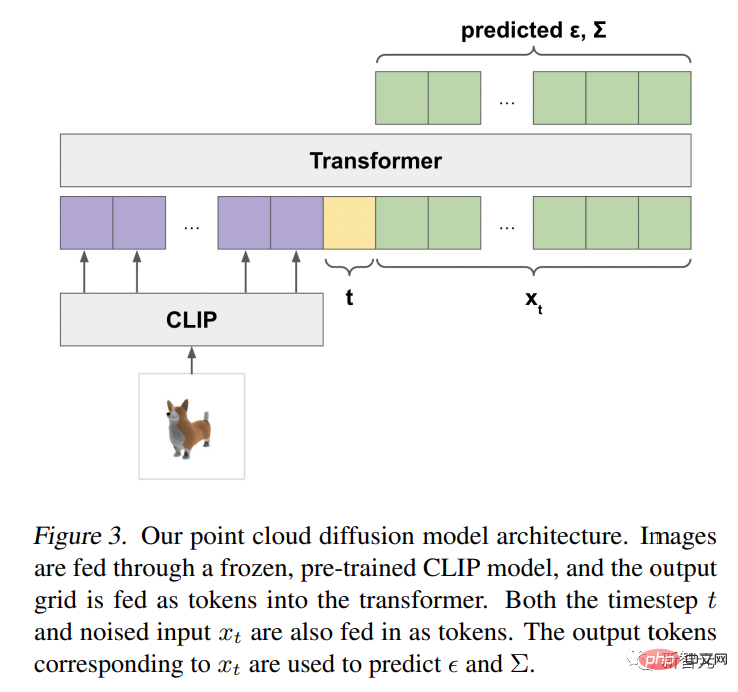

Das Point-E-Modell verwendet zunächst ein Text-zu-Bild-Diffusionsmodell, um eine einzelne synthetische Ansicht zu generieren, und verwendet dann ein zweites Diffusionsmodell, um eine 3D-Punktwolke zu generieren wird generiert von Bilder sind bedingt.

Obwohl diese Methode in Bezug auf die Qualität der Stichproben immer noch nicht auf dem neuesten Stand ist, ist sie ein bis zwei Größenordnungen schneller, was für einige Anwendungsfälle einen praktischen Kompromiss darstellt.

Die folgende Abbildung ist ein High-Level-Pipeline-Diagramm des Modells:

Anstatt ein einzelnes Generationsmodell zu trainieren und Punktwolken basierend auf dem Text direkt zu generieren, unterteilen wir den Generierungsprozess in drei Schritte.

Erstellen Sie zunächst eine umfassende Ansicht basierend auf dem Texttitel.

Als nächstes generieren Sie eine grobe Punktwolke (1.024 Punkte) basierend auf der synthetischen Ansicht.

Abschließend wurde eine feine Punktwolke (4.096 Punkte) generiert, die auf der Punktwolke mit niedriger Auflösung und der synthetischen Ansicht basiert.

Nachdem wir Modelle an Millionen von 3D-Modellen trainiert hatten, stellten wir fest, dass das Datenformat und die Qualität der Datensätze stark variierten, was uns dazu veranlasste, verschiedene Nachbearbeitungsschritte zu entwickeln, um eine höhere Datenqualität sicherzustellen.

Um alle Daten in ein gemeinsames Format zu konvertieren, haben wir Blender verwendet, um jedes 3D-Modell aus 20 zufälligen Kamerawinkeln in RGBAD-Bilder zu rendern (Blender unterstützt mehrere 3D-Formate und verfügt über eine optimierte Rendering-Engine).

Für jedes Modell normalisiert ein Blender-Skript das Modell in einen Begrenzungswürfel, konfiguriert Standardbeleuchtungseinstellungen und exportiert schließlich ein RGBAD-Bild mithilfe der integrierten Echtzeit-Rendering-Engine von Blender.

Verwenden Sie dann „Rendern“, um jedes Objekt in eine farbige Punktwolke umzuwandeln. Zunächst wird für jedes Objekt eine dichte Punktwolke erstellt, indem die Punkte für jedes Pixel in jedem RGBAD-Bild gezählt werden. Diese Punktwolken enthalten in der Regel Hunderttausende ungleichmäßig verteilter Punkte. Daher verwenden wir auch die Stichprobe der am weitesten entfernten Punkte, um eine einheitliche 4K-Punktwolke zu erstellen.

Durch die direkte Erstellung von Punktwolken aus Renderings können wir verschiedene Probleme vermeiden, die beim direkten Abtasten aus einem 3D-Netz, beim Abtasten von in einem Modell enthaltenen Punkten oder bei der Verarbeitung von 3D-Modellen, die in ungewöhnlichen Dateiformaten gespeichert sind, auftreten können.

Schließlich verwenden wir verschiedene Heuristiken, um die Häufigkeit minderwertiger Modelle in unserem Datensatz zu reduzieren.

Zuerst eliminieren wir planare Objekte, indem wir die SVD jeder Punktwolke berechnen und behalten nur die Objekte bei, deren minimaler Singulärwert höher als ein bestimmter Schwellenwert ist.

Als nächstes gruppieren wir den Datensatz nach CLIP-Features (für jedes Objekt mitteln wir die Features über alle Renderings).

Wir haben festgestellt, dass einige Cluster viele Modellkategorien von geringer Qualität enthielten, während andere Cluster vielfältiger oder interpretierbarer zu sein schienen.

Wir teilen diese Cluster in mehrere Buckets unterschiedlicher Qualität auf und verwenden eine gewichtete Mischung der resultierenden Buckets als unseren endgültigen Datensatz.

Anwendungsaussichten

OpenAI-Forscher wiesen darauf hin, dass die Punktwolke von Point-E auch zur Erstellung realer Objekte verwendet werden kann, beispielsweise für den 3D-Druck.

Mit zusätzlichen Mesh-Konvertierungsmodellen kann das System auch in Spiel- und Animationsentwicklungs-Workflows einsteigen.

Während alle Augen derzeit auf 2D-Kunstgeneratoren gerichtet sind, könnte die Modellsynthese-KI der nächste große Umbruch in der Branche sein.

3D-Modelle werden häufig in Film und Fernsehen, Innenarchitektur, Architektur und verschiedenen wissenschaftlichen Bereichen verwendet.

Derzeit dauert die Herstellung von 3D-Modellen in der Regel mehrere Stunden, und das Aufkommen von Point-E gleicht dieses Manko einfach aus.

Forscher sagen, dass Point-E zum jetzigen Zeitpunkt noch viele Mängel aufweist, wie etwa aus Trainingsdaten geerbte Vorurteile und fehlende Schutzmaßnahmen für Modelle, die zur Erstellung gefährlicher Objekte verwendet werden könnten.

Point-E ist nur ein Ausgangspunkt, sie hoffen, dass es „weitere Arbeiten“ im Bereich der Text-zu-3D-Synthese inspirieren wird.

Das obige ist der detaillierte Inhalt vonEine GPU kann 3D-Modelle in Sekundenschnelle erstellen! Das neue Werk von OpenAI: Point-E kann mithilfe von Text 3D-Punktwolkenmodelle generieren. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr