Heim >Technologie-Peripheriegeräte >KI >Um mehrstufige Benutzerabsichten effektiv zu nutzen, haben die Hong Kong University of Science and Technology, die Peking University usw. ein neues Sitzungsempfehlungsmodell Atten-Mixer vorgeschlagen

Um mehrstufige Benutzerabsichten effektiv zu nutzen, haben die Hong Kong University of Science and Technology, die Peking University usw. ein neues Sitzungsempfehlungsmodell Atten-Mixer vorgeschlagen

- 王林nach vorne

- 2023-04-15 08:28:05920Durchsuche

Als intelligente Informationsfiltertechnologie wird das Empfehlungssystem häufig in tatsächlichen Szenarien eingesetzt. Der Erfolg von Empfehlungssystemen basiert jedoch häufig auf einer großen Menge an Benutzerdaten, bei denen es sich möglicherweise um private und sensible Informationen der Benutzer handelt. In Szenarien, in denen Benutzerinformationen durch den Datenschutz eingeschränkt sind oder nicht abgerufen werden können, versagen herkömmliche Empfehlungssysteme oft. Daher ist der Aufbau eines vertrauenswürdigen Empfehlungssystems bei gleichzeitiger Gewährleistung von Datenschutz und Sicherheit ein dringend zu lösendes Problem.

Da Nutzer in den letzten Jahren immer mehr auf ihre eigene Privatsphäre achten, tendieren immer mehr Nutzer dazu, Online-Plattformen ohne Anmeldung zu nutzen, was auch anonyme sitzungsbasierte Empfehlungen zu einer wichtigen Forschungsrichtung macht. Kürzlich haben Forscher der Hong Kong University of Science and Technology, der Peking University, Microsoft Asia Research und anderen Institutionen ein neues Atten-Mixer-Modell vorgeschlagen, das mehrstufige Benutzerabsichten effizient nutzt. Die Forschungsarbeit erhielt beim WSDM2023 eine lobende Erwähnung als bestes Papier.

... Forschungshintergrund

Sitzungsbasierte Empfehlung (SBR) ist eine Empfehlungsmethode, die auf der kurzen und dynamischen Sitzung des Benutzers (dh der Verhaltenssequenz des Benutzers) basiert.

Im Vergleich zu herkömmlichen benutzer- oder artikelbasierten Empfehlungssystemen konzentriert sich SBR mehr auf die Erfassung der unmittelbaren Bedürfnisse des Benutzers in der aktuellen Sitzung und kann sich effektiver an die Herausforderungen der schnellen Entwicklung von Benutzerinteressen und Long-Tail anpassen Effekte.

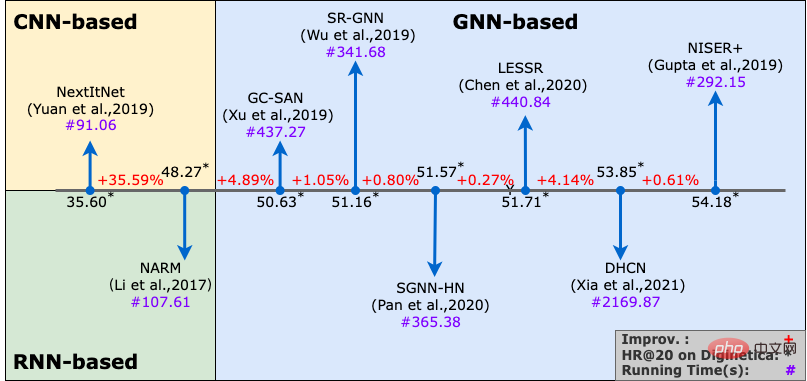

In der Entwicklung des SBR-Modells, von Modellen, die auf Recurrent Neural Network (RNN) basieren, zu Modellen, die auf Convolutional Neural Network (CNN) basieren, und dann zu den neueren Modellen, die auf Graph Neural Network (GNN) basieren. werden in der SBR-Forschung häufig verwendet, um komplexe Übertragungsbeziehungen zwischen Elementen besser zu untersuchen.

Vorläufige Analyse

Um diese Frage zu beantworten, versuchte der Autor, bestehende GNN-basierte SBR-Modelle zu dekonstruieren und ihre Rolle bei SBR-Aufgaben zu analysieren.

Im Allgemeinen kann ein typisches GNN-basiertes SBR-Modell in zwei Teile zerlegt werden:

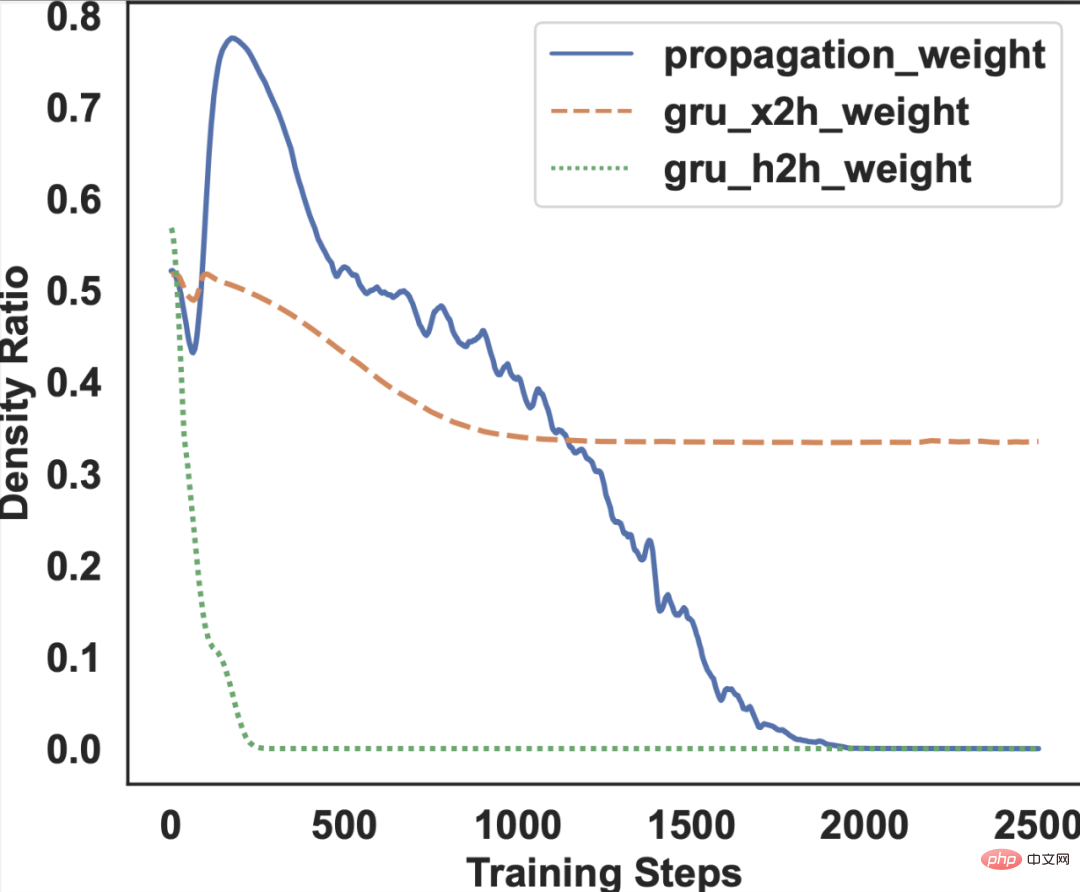

(1) GNN-Modul. Die Parameter können in Ausbreitungsgewichte für die Graphfaltung und GRU-Gewichte für die Fusion der ursprünglichen Einbettungs- und Graphfaltungsausgabe unterteilt werden.

Als nächstes verwendet der Autor Sparse Variational Dropout (SparseVD), eine häufig verwendete Sparsifizierungstechnologie für neuronale Netze, für diese beiden Teile und berechnet die Parameter beim Training des Modells .

Das Dichteverhältnis eines Parameters bezieht sich auf das Verhältnis der Anzahl der Elemente, die einen bestimmten Schwellenwert überschreiten, zur Gesamtzahl der Elemente im Gewicht des Parameters. Sein Wert kann zur Messung der Bedeutung des Parameters verwendet werden.

GNN-Modul.

Da GNN viele Parameter hat und zufällig initialisiert wird, muss zu Beginn viel Wissen aktualisiert werden. Daher können wir sehen, dass das Dichteverhältnis des Faltungsausbreitungsgewichts des Graphen in den ersten Datenstapeln schwanken wird. Wenn sich das Training stabilisiert, tendiert das Dichteverhältnis gegen 0.

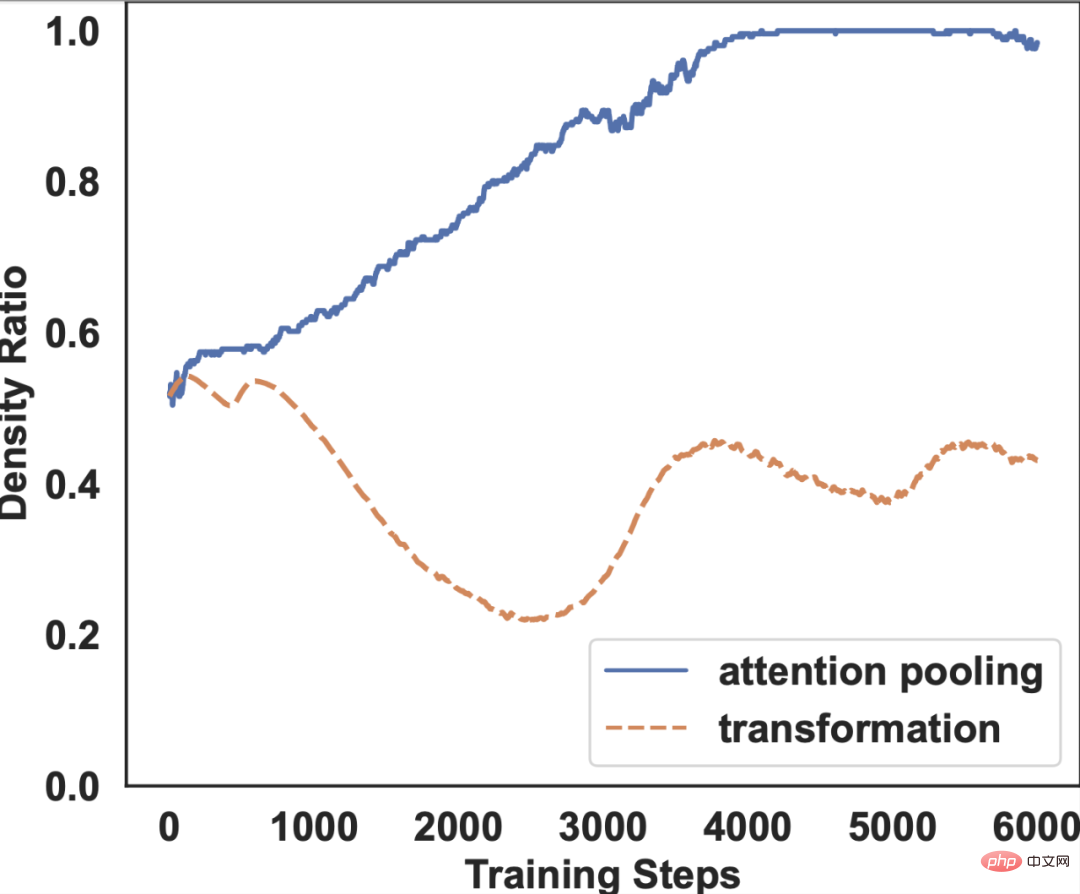

Auslesemodul.

Wir können feststellen, dass mit fortschreitendem Training das Dichteverhältnis der Aufmerksamkeitsbündelungsgewichte auf einem hohen Niveau gehalten werden kann. Den gleichen Trend können wir auch bei anderen Datensätzen und anderen GNN-basierten SBR-Modellen beobachten.

den GNN-Ausbreitungsteil zu löschen und nur beizubehalten die anfängliche Einbettungsschicht ;

(2) Modelldesigner sollten dem aufmerksamkeitsbasierten Auslesemodul mehrAufmerksamkeit schenken .

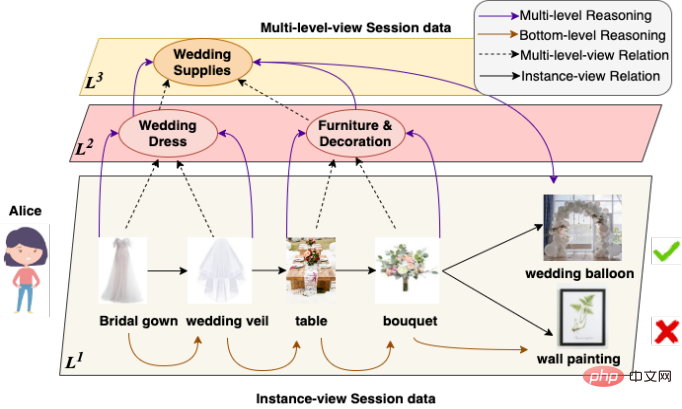

in das Design des Readout-Moduls eingeführt werden.

Allerdings ist es keine leichte Aufgabe, diese übergeordneten Konzepte zu erhalten, da die bloße Aufzählung dieser übergeordneten Konzepte nicht realistisch ist und wahrscheinlich irrelevante Konzepte einführt und die Leistung des Modells beeinträchtigt.

Um dieser Herausforderung zu begegnen, werden in diesem Artikel zwei SBR-bezogene induktive Vorurteile übernommen: lokale Invarianz und inhärente Priorität zur Reduzierung des Suchraums .

- Inhärente Priorität bedeutet, dass die letzten Elemente in der Sitzung die aktuellen Interessen des Benutzers besser widerspiegeln können.

- Lokale Invarianz bedeutet, dass die relative Reihenfolge der letzten Elemente in der Sitzung das Interesse des Benutzers nicht beeinflusst. Daher können in der Praxis Gruppen aus einer unterschiedlichen Anzahl von Endelementen gebildet werden, und über diese Gruppen können verwandte Konzepte auf hoher Ebene erstellt werden.

Hier entspricht das Endelement der inhärenten Priorität, die Gruppe entspricht der lokalen Invarianz und die verschiedenen Zahlen repräsentieren die vielschichtigen Konzepte auf hoher Ebene, die in diesem Artikel betrachtet werden.

Vorgeschlagenes Modell

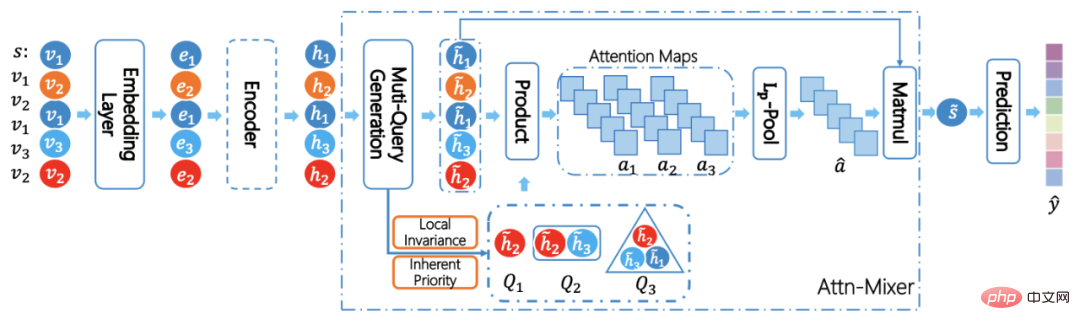

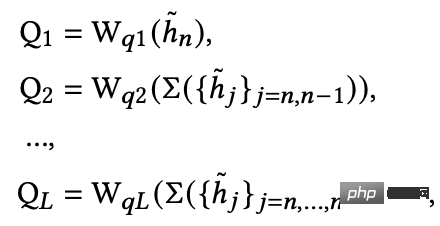

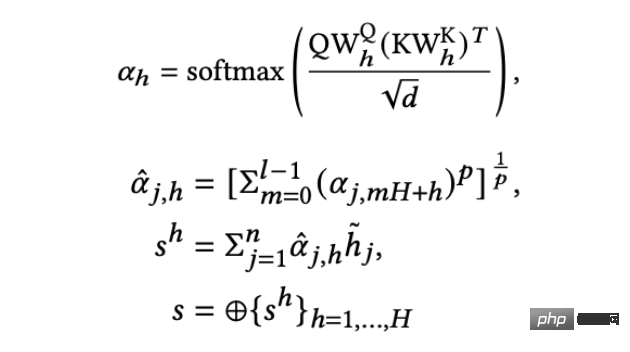

Daher wird in diesem Artikel ein Modell namens Atten-Mixer vorgeschlagen. Das Modell kann mit verschiedenen Encodern integriert werden. Für die Eingabesitzung erhält das Modell die Einbettung jedes Elements aus der Einbettungsebene. Das Modell wendet dann eine lineare Transformation auf die resultierende Gruppendarstellung an, um mehrstufige Benutzerabsichtsabfragen zu generieren.

wobei Q1 die Aufmerksamkeitsabfrage in Instanzansicht ist, während die anderen Aufmerksamkeitsabfragen auf höherer Ebene mit unterschiedlichen Empfangsfeldern und lokal invarianten Informationen sind. Als nächstes verwendet das Modell die generierten Aufmerksamkeitsabfragen, um den verborgenen Zustand jedes Elements in der Sitzung zu überwachen und die endgültige Sitzungsdarstellung zu erhalten.

Experimente und Ergebnisse

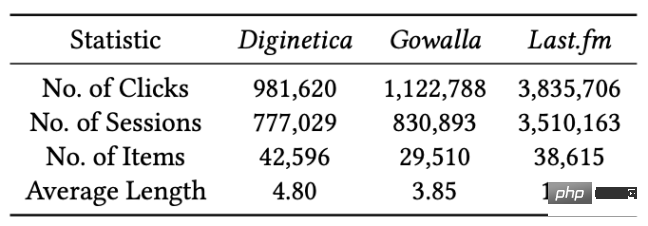

Im Offline-Experiment verwendet dieser Artikel Datensätze aus drei verschiedenen Bereichen: Digitalica ist ein Datensatz für E-Commerce-Transaktionen, Gowalla ist ein Datensatz für soziale Netzwerke und Last.fm Es handelt sich um einen Datensatz zur Musikempfehlung.

Offline-Versuchsergebnisse

(1) Gesamtvergleich

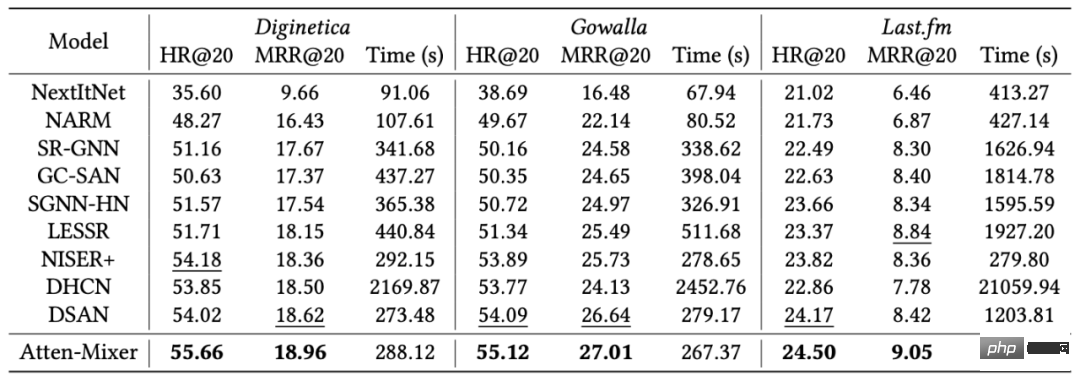

Der Autor verglich Atten-Mixer mit vier Basismethoden basierend auf CNN, RNN-basiert, GNN-basiert und auslesebasiert .

Experimentelle Ergebnisse zeigen, dass Atten-Mixer die Basismethoden in Bezug auf Genauigkeit und Effizienz bei drei Datensätzen übertrifft.

(2) Analyse der Leistungsverbesserung

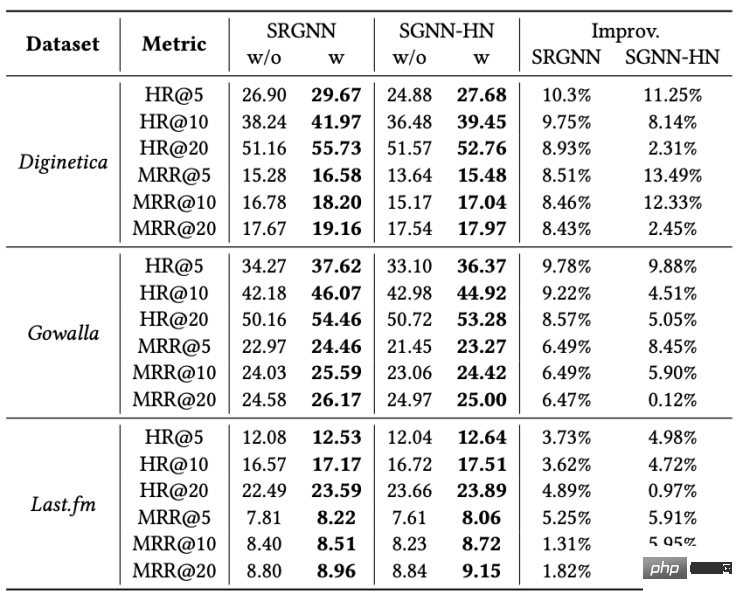

Darüber hinaus hat der Autor das Atten-Mixer-Modul auch in SR-GNN und SGNN-HN eingebettet, um den Leistungsverbesserungseffekt dieser Methode auf das Originalmodell zu überprüfen .

Offline-Versuchsergebnisse zeigen, dass Atten-Mixer die Modellleistung bei allen Datensätzen erheblich verbessert, insbesondere wenn der K-Wert im Bewertungsindex klein ist, was darauf hindeutet, dass Atten-Mixer dazu beitragen kann, dass das Originalmodell genauer und benutzerfreundlicher ist. freundliche Empfehlung.

Online-Experimentergebnisse

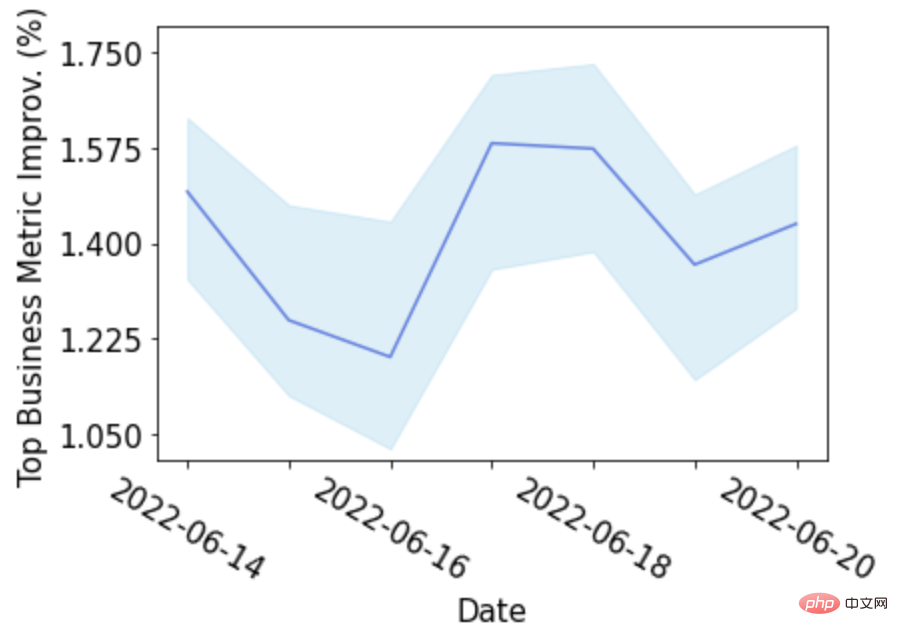

Der Autor hat Atten-Mixer im April 2021 auch in großen E-Commerce-Onlinediensten eingesetzt. Online-Experimente zeigen, dass das mehrstufige Aufmerksamkeitsmischungsnetzwerk (Atten-Mixer) bei verschiedenen Online-Geschäftsindikatoren erhebliche Ergebnisse erzielt hat .

Experimentelle Schlussfolgerung

Zusammenfassend lässt sich sagen, dass Atten-Mixer über mehrstufige Argumentationsfunktionen verfügt und eine hervorragende Online- und Offline-Leistung in Bezug auf Genauigkeit und Effizienz zeigt. Hier sind einige der wichtigsten Beiträge:

- Eine komplexe Modellarchitektur ist keine notwendige Voraussetzung für SBR, und das innovative Architekturdesign der aufmerksamkeitsbasierten Auslesemethode ist eine effektive Lösung.

- Die mehrstufige Konzeptkorrelation hilft dabei, die Interessen der Benutzer zu erfassen, und die Verwendung induktiver Voreingenommenheit ist eine effektive Möglichkeit, informationsreiche Konzepte höherer Ordnung zu entdecken.

Forschungsprozess

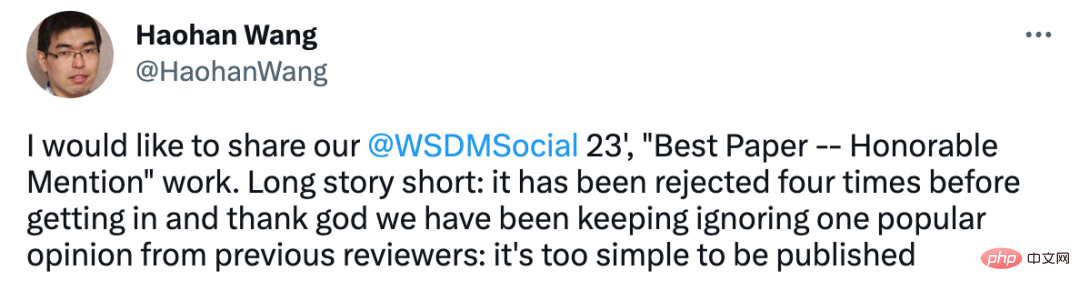

Abschließend ist zu erwähnen, dass dieser Artikel hinter seiner Ehrennominierung für den besten Artikel im WSDM2023 eine schwierige Entwicklungserfahrung hat, wie Haohan Wang von der UIUC, einer der Autoren des Artikels, vorstellte In diesem Fall wurde dieser Artikel während des Einreichungsprozesses tatsächlich mehrmals abgelehnt, weil er zu einfach war. Glücklicherweise ging der Autor des Artikels nicht auf den Geschmack der Rezensenten ein, nur um den Artikel aus dem Weg zu räumen, sondern bestand auf seinem eigene Einfachheitsmethode und führte letztendlich zur Auszeichnung dieses Artikels.

Das obige ist der detaillierte Inhalt vonUm mehrstufige Benutzerabsichten effektiv zu nutzen, haben die Hong Kong University of Science and Technology, die Peking University usw. ein neues Sitzungsempfehlungsmodell Atten-Mixer vorgeschlagen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr