Heim >Technologie-Peripheriegeräte >KI >Zum ersten Mal wird „Teaching Director' in die Modelldestillation eingeführt, und die groß angelegte Komprimierung ist besser als 24 SOTA-Methoden.

Zum ersten Mal wird „Teaching Director' in die Modelldestillation eingeführt, und die groß angelegte Komprimierung ist besser als 24 SOTA-Methoden.

- PHPznach vorne

- 2023-04-14 15:46:031035Durchsuche

Angesichts immer tieferer Lernmodelle und massiver Video-Big Data sind Algorithmen der künstlichen Intelligenz zunehmend auf Rechenressourcen angewiesen. Um die Leistung und Effizienz tiefer Modelle effektiv zu verbessern, indem die Destillierbarkeit und Sparsamkeit des Modells untersucht wird, schlägt dieser Artikel eine einheitliche Modellkomprimierung vor, die auf der Modelltechnologie „Lehrer-Lehrer-Schüler“ basiert .

Diese Leistung wurde von einem gemeinsamen Forschungsteam des People's Institute of Science and Technology und des Institute of Automation der Chinese Academy of erreicht Der entsprechende Artikel wurde in der führenden internationalen Fachzeitschrift für künstliche Intelligenz, IEEE Transactions on Pattern Analysis and Machine Intelligence (TPAMI), veröffentlicht. Diese Errungenschaft ist das erste Mal, dass die Rolle des „Lehrleiters“ in die Modelldestillationstechnologie eingeführt wurde, wodurch die Destillation und Anpassung tiefer Modelle vereinheitlicht wird.

Papieradresse: https://ieeexplore.ieee.org/abstract/document/9804342

Derzeit wurde dieses Ergebnis auf die von People's Zhongke unabhängig entwickelte modalübergreifende intelligente Suchmaschine „Baize“ angewendet. „Baize“ durchbricht die Barrieren des Informationsausdrucks zwischen verschiedenen Modalitäten wie Grafiken, Text, Audio und Video und ordnet verschiedene modale Informationen wie Text, Bilder, Sprache und Video in einem einheitlichen Feature-Repräsentationsraum zu, wobei Video den Kern des Lernens darstellt Mehrere Modalitäten Eine einheitliche Distanzmessung kann verwendet werden, um die semantische Lücke multimodaler Inhalte wie Text, Sprache und Video zu schließen und einheitliche Suchfunktionen zu erreichen.

Angesichts der massiven Internetdaten, insbesondere Video-Big Data, nimmt jedoch der Verbrauch von Rechenressourcen durch modalübergreifende Tiefenmodelle allmählich zu. Basierend auf diesem Forschungsergebnis kann „Baize“ die Modellgröße in großem Maßstab komprimieren und gleichzeitig die Algorithmusleistung sicherstellen, wodurch modalübergreifende intelligente Verständnis- und Suchfunktionen mit hohem Durchsatz und geringem Stromverbrauch erreicht werden. Vorläufigen praktischen Anwendungen zufolge kann diese Technologie die Parameterskala großer Modelle im Durchschnitt um mehr als das Vierfache komprimieren. Einerseits kann dadurch der Verbrauch von Hochleistungs-Rechenressourcen wie GPU-Servern durch das Modell erheblich reduziert werden. Andererseits können große Modelle, die nicht am Rand bereitgestellt werden können, destilliert und komprimiert werden, um eine Bereitstellung mit geringem Stromverbrauch zu erreichen Rand.

Föderiertes Lernframework für die Modellkomprimierung

Komprimierung und Beschleunigung tiefer algorithmischer Modelle können durch Destillation erreicht werden Lernen oder strukturiertes Sparse-Clipping sind implementiert, es gibt jedoch in beiden Bereichen einige Einschränkungen. Ziel der Destillationslernmethode ist es, ein leichtes Modell (d. h. ein Schülernetzwerk) zu trainieren, um ein komplexes und großes Modell (d. h. ein Lehrernetzwerk) zu simulieren. Unter der Anleitung des Lehrernetzwerks kann das Schülernetzwerk bessere Leistungen erzielen als alleiniges Training.

Destillationslernalgorithmen konzentrieren sich jedoch nur auf die Verbesserung der Leistung von Studentennetzwerken und ignorieren häufig die Bedeutung der Netzwerkstruktur. Die Struktur des Studierendennetzwerks wird in der Regel im Ausbildungsprozess vordefiniert und festgelegt.

Für strukturiertes Sparse-Clipping oder Filter-Clipping zielen diese Methoden darauf ab, ein redundantes und komplexes Netzwerk in ein spärliches und kompaktes Netzwerk zu schneiden. Allerdings wird das Zuschneiden des Modells nur verwendet, um eine kompakte Struktur zu erhalten. Keine der vorhandenen Methoden nutzt das im ursprünglichen komplexen Modell enthaltene „Wissen“ vollständig aus. Neuere Forschungen kombinieren Destillationslernen mit strukturiertem Sparse-Pruning, um Modellleistung und -größe in Einklang zu bringen. Diese Methoden beschränken sich jedoch auf einfache Kombinationen von Verlustfunktionen.

Um die oben genannten Probleme eingehend zu analysieren, wurde in dieser Studie zunächst das Modell basierend auf Compressed Sensing trainiert. Durch die Analyse der Modellleistung und -struktur wurde festgestellt, dass dies der Fall ist sind zwei wichtige Aspekte für tiefe Algorithmusmodelle: Destillierbarkeit und Sparfähigkeit.

Insbesondere bezieht sich Destillierbarkeit auf die Dichte, die effektives Wissen aus dem Lehrernetzwerk destillieren kann. Sie kann anhand der Leistungssteigerungen gemessen werden, die ein Schülernetzwerk unter der Anleitung eines Lehrernetzwerks erzielt. Beispielsweise können Studentennetzwerke mit höherer Destillierbarkeit eine höhere Leistung erzielen. Die Destillierbarkeit kann auch auf der Ebene der Netzwerkschicht quantitativ analysiert werden.

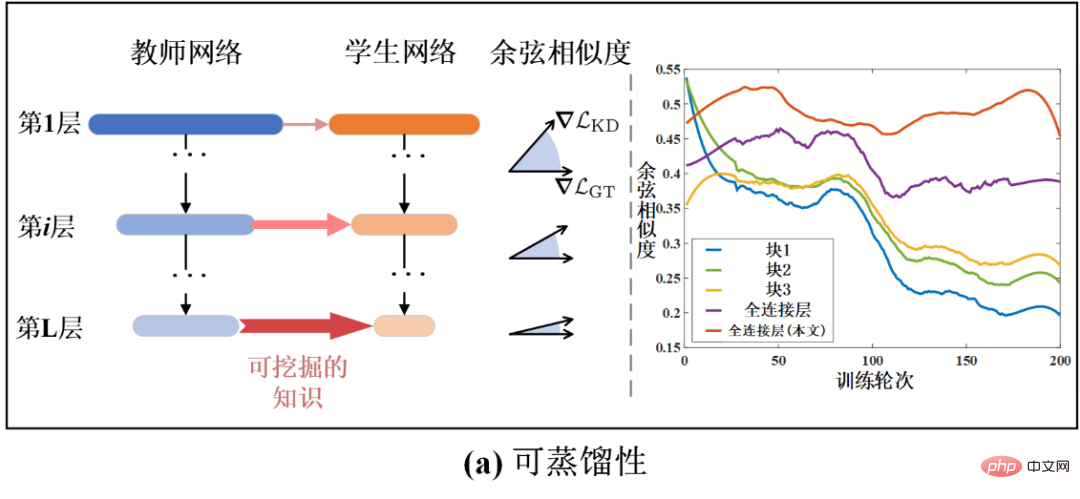

Wie in Abbildung 1-(a) dargestellt, stellt das Balkendiagramm die Kosinusähnlichkeit (Kosinusähnlichkeit) zwischen dem Lernverlustgradienten der Destillation und dem Verlustgradienten der wahren Wertklassifizierung dar. Eine größere Kosinusähnlichkeit weist darauf hin, dass die Kenntnis der aktuellen Destillation für die Modellleistung hilfreicher ist. Auf diese Weise kann die Kosinusähnlichkeit auch ein Maß für die Destillierbarkeit sein. Aus Abbildung 1-(a) ist ersichtlich, dass die Destillierbarkeit mit zunehmender Anzahl der Modellschichten allmählich zunimmt. Dies erklärt auch, warum die beim Destillationslernen üblicherweise verwendete Supervision in den letzten Schichten des Modells angewendet wird. Darüber hinaus weist das Studentenmodell in verschiedenen Trainingsrunden auch eine unterschiedliche Destillierbarkeit auf, da sich auch die Kosinusähnlichkeit ändert, wenn sich die Trainingszeit ändert. Daher ist es notwendig, die Destillierbarkeit verschiedener Schichten während des Trainingsprozesses dynamisch zu analysieren.

Andererseits bezieht sich Sparsity auf die Zuschneiderate (oder Komprimierungsrate), die das Modell unter begrenztem Präzisionsverlust erreichen kann. Eine höhere Sparfähigkeit entspricht dem Potenzial für höhere Erntemengen. Wie in Abbildung 1-(b) dargestellt, weisen verschiedene Schichten oder Module des Netzwerks unterschiedliche Sparsibilität auf. Ähnlich wie die Destillierbarkeit kann auch die Sparsibilität auf der Ebene der Netzwerkschicht und in der Zeitdimension analysiert werden. Allerdings gibt es derzeit keine Methoden zur Untersuchung und Analyse der Destillierbarkeit und Verdünnung. Bestehende Methoden verwenden oft einen festen Trainingsmechanismus, was es schwierig macht, ein optimales Ergebnis zu erzielen.

Abbildung 1 Schematische Darstellung der Destillierbarkeit und Sparsamkeit tiefer neuronaler Netze

Um die oben genannten Probleme zu lösen, analysierte diese Studie den Trainingsprozess der Modellkomprimierung, um Informationen über die Destillierbarkeit zu erhalten und Sparsability-bezogene Entdeckungen. Inspiriert von diesen Erkenntnissen schlägt diese Studie eine Modellkomprimierungsmethode vor, die auf dem gemeinsamen Lernen von dynamischer Destillierbarkeit und Sparsity basiert. Es kann Destillationslernen und strukturiertes Sparse-Clipping dynamisch kombinieren und den gemeinsamen Trainingsmechanismus durch Lernen von Destillierbarkeit und Sparsity adaptiv anpassen. Im Gegensatz zum herkömmlichen „Lehrer-Schüler“-Rahmen kann die in diesem Artikel vorgeschlagene Methode als „Lernen-in-Schule“-Rahmen beschrieben werden, da sie drei Hauptmodule enthält: Lehrernetzwerk, Schülernetzwerk und Dekanatsnetzwerk.

Konkret unterrichtet das Lehrernetzwerk das Schülernetzwerk wie zuvor. Das Lehrleiternetzwerk ist für die Steuerung der Intensität des Online-Lernens der Studierenden und der Art und Weise, wie sie lernen, verantwortlich. Durch den Erhalt des Status des aktuellen Lehrernetzwerks und des Studentennetzwerks kann das Dekannetzwerk die Destillierbarkeit und Sparbarkeit des aktuellen Studentennetzwerks bewerten und dann die Stärke der Destillations-Lernüberwachung und der strukturierten, spärlichen Clipping-Überwachung dynamisch ausgleichen und steuern.

Um die Methode in diesem Artikel zu optimieren, schlägt diese Forschung auch einen gemeinsamen Optimierungsalgorithmus für Destillationslernen und Clipping vor, der auf der Methode des Wechselrichtungsmultiplikators basiert, um das Studentennetzwerk zu aktualisieren. Um das Lehrleiternetzwerk zu optimieren und zu aktualisieren, wird in diesem Artikel ein auf Meta-Lernen basierender Optimierungsalgorithmus für Lehrleiter vorgeschlagen. Die Destillierbarkeit kann wiederum durch dynamische Anpassung des Überwachungssignals beeinflusst werden. Wie in Abbildung 1-(a) gezeigt, erweist sich die Methode in diesem Artikel als in der Lage, den Abwärtstrend der Destillierbarkeit zu verzögern und die Destillierbarkeit insgesamt zu verbessern, indem das Wissen über die Destillation rational genutzt wird.

Das allgemeine Algorithmus-Framework und das Flussdiagramm der Methode dieses Artikels sind in der folgenden Abbildung dargestellt. Das Framework umfasst drei Hauptmodule: Lehrernetzwerk, Studentennetzwerk und Lehrleiternetzwerk. Unter diesen wird das anfängliche komplexe redundante Netzwerk, das komprimiert und gekürzt werden soll, als Lehrernetzwerk betrachtet, und im nachfolgenden Trainingsprozess wird das ursprüngliche Netzwerk, das nach und nach dünner wird, als Schülernetzwerk betrachtet. Das Dekannetzwerk ist ein Metanetzwerk, das die Informationen des Lehrernetzwerks und des Schülernetzwerks eingibt, um die aktuelle Destillierbarkeit und Sparsamkeit zu messen und so die Überwachungsintensität des Destillationslernens und der Sparsamkeit zu steuern.

Auf diese Weise kann das Studentennetzwerk jederzeit durch dynamisch destilliertes Wissen geleitet und bereichert werden. Wenn das Studentennetzwerk beispielsweise eine höhere Destillierbarkeit aufweist, lässt der Dekan das Studentennetzwerk von einem stärkeren Destillationsüberwachungssignal leiten (siehe das rosa Pfeilsignal in Abbildung 2). Der Dekan wird ein stärkeres, spärliches Aufsichtssignal auf das Studentennetzwerk ausüben (siehe das orangefarbene Pfeilsignal in Abbildung 2).

Abbildung 2 Schematische Darstellung des Modellkomprimierungsalgorithmus basierend auf dem gemeinsamen Lernen von Destillierbarkeit und Sparsity

Experimentelle Ergebnisse

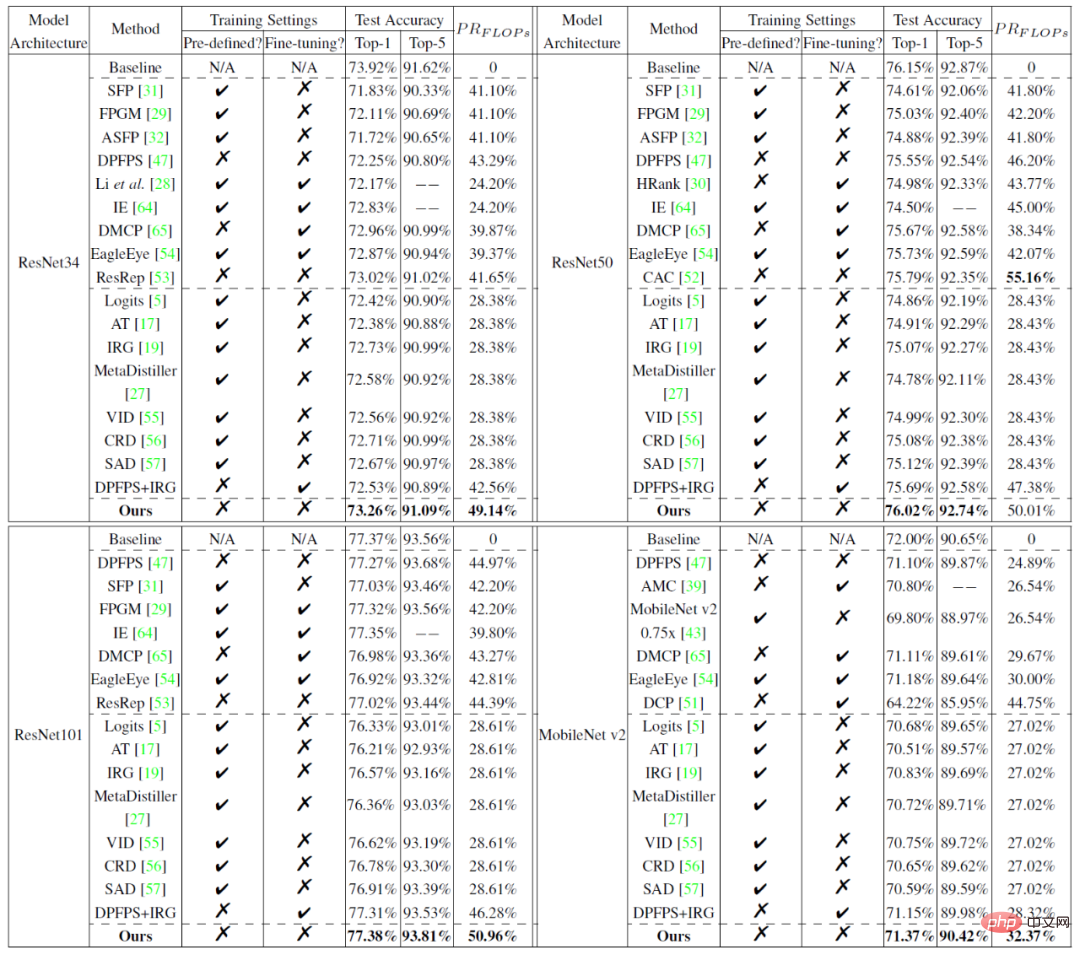

Experimente vergleichen die in diesem Artikel vorgeschlagene Methode mit 24 gängigen Modellkomprimierungsmethoden (einschließlich Sparse-Clipping-Methoden). ) und Destillationslernmethoden) werden auf dem kleinen Datensatz CIFAR und dem großen Datensatz ImageNet verglichen. Die experimentellen Ergebnisse sind in der folgenden Abbildung dargestellt und belegen die Überlegenheit der in diesem Artikel vorgeschlagenen Methode.

Tabelle 1 Leistungsvergleich der Modellzuschneideergebnisse auf CIFAR10:

Tabelle 2 Leistungsvergleich der Modellzuschneideergebnisse auf ImageNet:

Weitere Forschungsdetails finden Sie im Original Papier.

Das obige ist der detaillierte Inhalt vonZum ersten Mal wird „Teaching Director' in die Modelldestillation eingeführt, und die groß angelegte Komprimierung ist besser als 24 SOTA-Methoden.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr